Сьогодні ми раді повідомити, що Мікстраль-8х7Б велика мовна модель (LLM), розроблена Mistral AI, доступна для клієнтів через Amazon SageMaker JumpStart щоб розгорнути одним клацанням миші для запуску висновку. Mixtral-8x7B LLM — це попередньо підготовлена розріджена суміш експертної моделі, заснована на магістралі з 7 мільярдів параметрів із вісьмома експертами на рівень прямого зв’язку. Ви можете випробувати цю модель за допомогою SageMaker JumpStart, центру машинного навчання (ML), який надає доступ до алгоритмів і моделей, щоб ви могли швидко розпочати роботу з ML. У цій публікації ми розглянемо, як виявити та розгорнути модель Mixtral-8x7B.

Що таке Мікстраль-8х7Б

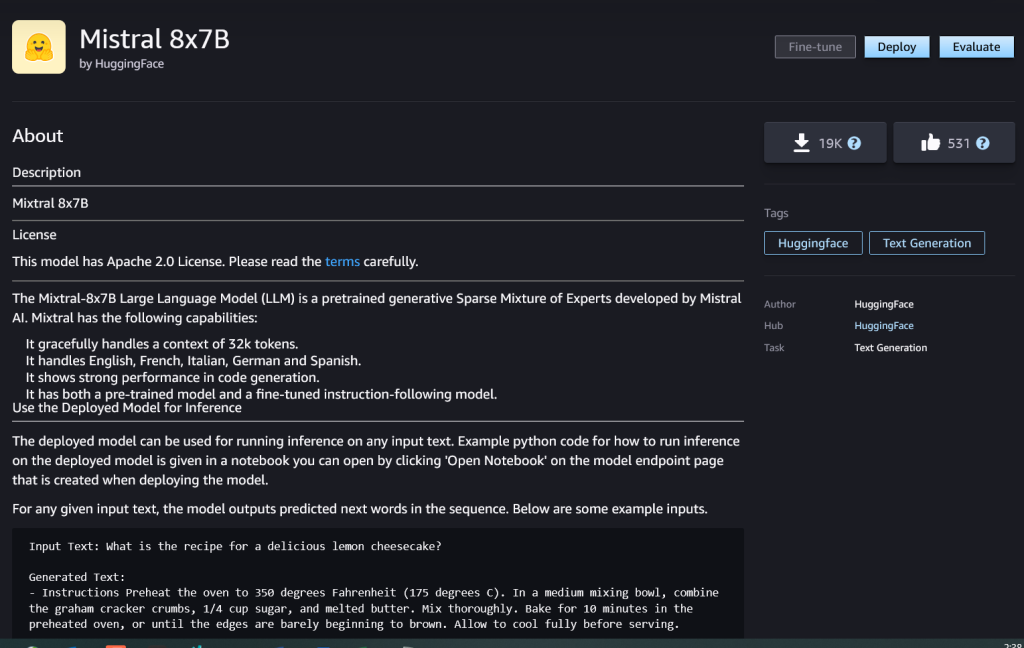

Mixtral-8x7B — це базова модель, розроблена Mistral AI, яка підтримує текст англійською, французькою, німецькою, італійською та іспанською мовами з можливістю генерації коду. Він підтримує різноманітні варіанти використання, такі як узагальнення тексту, класифікація, доповнення тексту та доповнення коду. Добре поводиться в режимі чату. Щоб продемонструвати просту настроюваність моделі, Mistral AI також випустив модель інструкцій Mixtral-8x7B для випадків використання чату, налаштовану за допомогою різноманітних загальнодоступних наборів даних розмов. Моделі Mixtral мають велику довжину контексту до 32,000 XNUMX токенів.

Mixtral-8x7B забезпечує значні покращення продуктивності в порівнянні з попередніми найсучаснішими моделями. Його розріджена суміш експертної архітектури дозволяє досягти кращого результату продуктивності в 9 із 12 тестів обробки природної мови (NLP), протестованих Містраль А.І. Mixtral відповідає або перевищує продуктивність моделей до 10 разів більшого розміру. Використовуючи лише частину параметрів на токен, він досягає швидшої швидкості висновку та нижчих обчислювальних витрат порівняно з щільними моделями еквівалентних розмірів — наприклад, із загальною кількістю 46.7 мільярдів параметрів, але лише 12.9 мільярдів, що використовуються на токен. Це поєднання високої продуктивності, багатомовної підтримки та обчислювальної ефективності робить Mixtral-8x7B привабливим вибором для програм NLP.

Модель доступна за дозвільною ліцензією Apache 2.0 для використання без обмежень.

Що таке SageMaker JumpStart

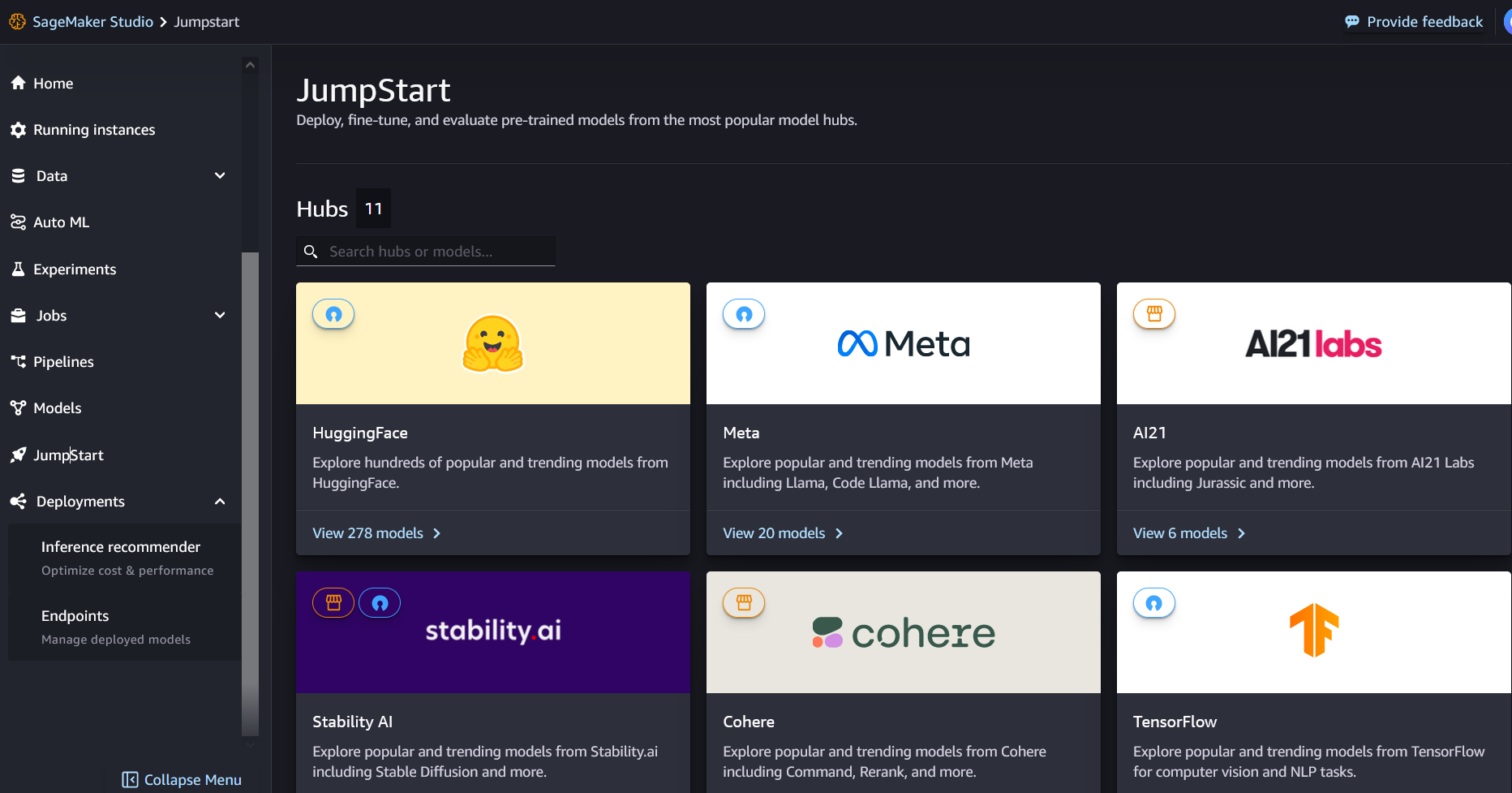

За допомогою SageMaker JumpStart фахівці з машинного навчання можуть вибирати зі списку найефективніших моделей основи, що постійно зростає. Практикуючі ML можуть розгортати базові моделі на спеціальному Amazon SageMaker екземпляри в ізольованому мережевому середовищі та налаштовувати моделі за допомогою SageMaker для навчання та розгортання моделей.

Тепер ви можете знайти та розгорнути Mixtral-8x7B кількома клацаннями миші Студія Amazon SageMaker або програмно за допомогою SDK SageMaker Python, що дає змогу отримувати продуктивність моделі та елементи керування MLOps за допомогою таких функцій SageMaker, як Трубопроводи Amazon SageMaker, Налагоджувач Amazon SageMaker, або контейнерні журнали. Модель розгортається в захищеному середовищі AWS і під керуванням вашого VPC, що допомагає забезпечити безпеку даних.

Відкрийте для себе моделі

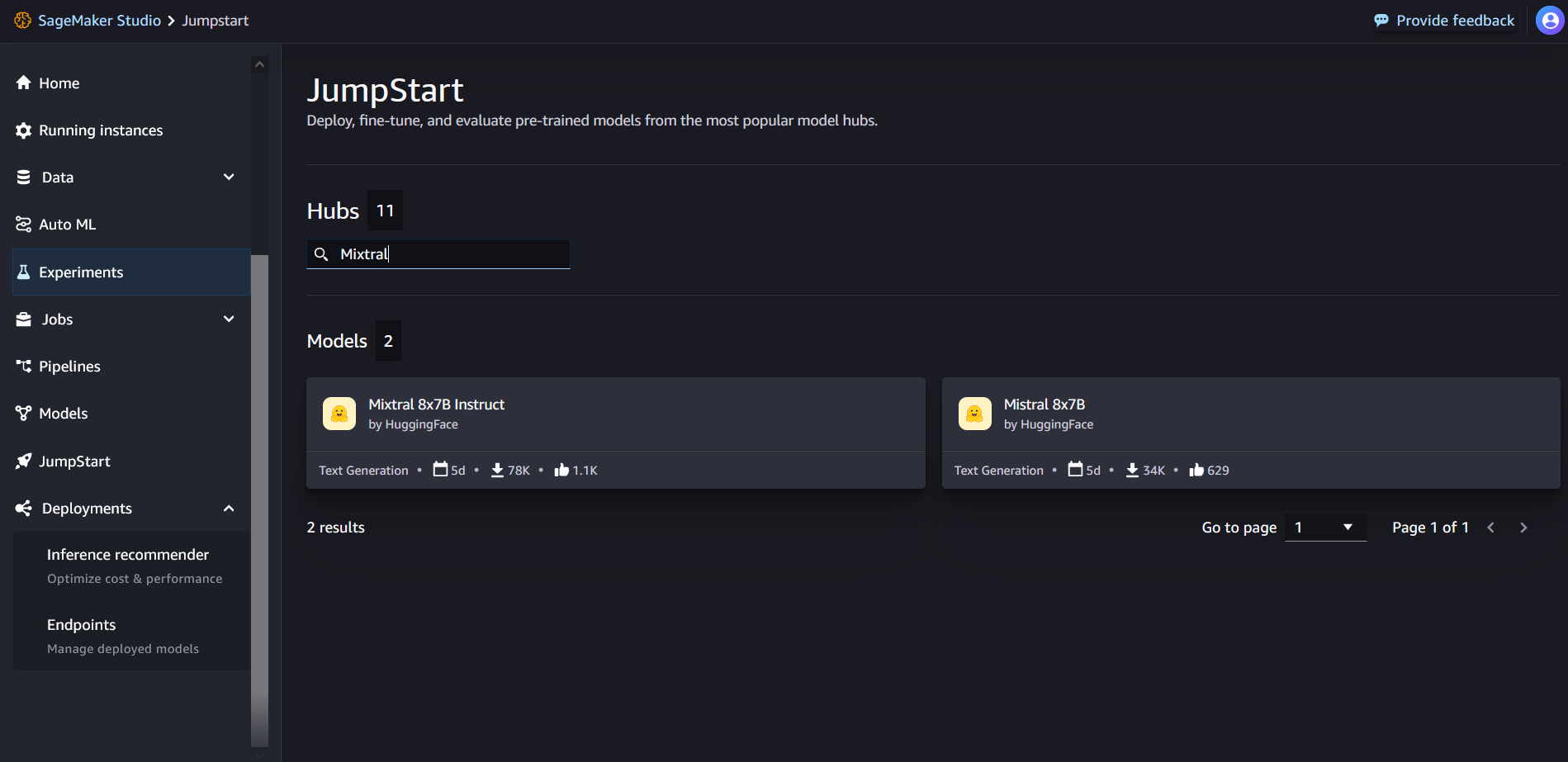

Ви можете отримати доступ до моделей основи Mixtral-8x7B через SageMaker JumpStart в інтерфейсі користувача SageMaker Studio та SageMaker Python SDK. У цьому розділі ми розглянемо, як знайти моделі в SageMaker Studio.

SageMaker Studio — це інтегроване середовище розробки (IDE), яке забезпечує єдиний візуальний веб-інтерфейс, де ви можете отримати доступ до спеціально створених інструментів для виконання всіх етапів розробки ML, від підготовки даних до створення, навчання та розгортання ваших моделей ML. Докладніше про те, як розпочати роботу та налаштувати SageMaker Studio, див Студія Amazon SageMaker.

У SageMaker Studio ви можете отримати доступ до SageMaker JumpStart, вибравши Поштовх у навігаційній панелі.

На цільовій сторінці SageMaker JumpStart ви можете знайти «Mixtral» у полі пошуку. Ви побачите результати пошуку з Mixtral 8x7B і Mixtral 8x7B Instruct.

Ви можете вибрати картку моделі, щоб переглянути деталі моделі, наприклад ліцензію, дані, які використовуються для навчання, і спосіб використання. Ви також знайдете Розгортання кнопку, яку можна використовувати для розгортання моделі та створення кінцевої точки.

Розгорнути модель

Розгортання починається, коли ви виберете Розгортання. Після завершення розгортання буде створено кінцеву точку. Ви можете протестувати кінцеву точку, передавши приклад корисного навантаження запиту на висновок або вибравши параметр тестування за допомогою SDK. Коли ви виберете параметр використання SDK, ви побачите приклад коду, який можна використовувати у бажаному редакторі блокнотів у SageMaker Studio.

Для розгортання за допомогою SDK ми починаємо з вибору моделі Mixtral-8x7B, визначеної model_id with value huggingface-llm-mixtral-8x7b. Ви можете розгорнути будь-яку з вибраних моделей на SageMaker за допомогою наступного коду. Так само ви можете розгорнути Mixtral-8x7B instruct, використовуючи його власний ідентифікатор моделі:

Це розгортає модель на SageMaker із конфігураціями за замовчуванням, включаючи тип екземпляра за замовчуванням і конфігурації VPC за замовчуванням. Ви можете змінити ці конфігурації, вказавши значення, відмінні від замовчування JumpStartModel.

Після розгортання ви можете запустити висновок щодо розгорнутої кінцевої точки за допомогою предиктора SageMaker:

Приклад підказує

Ви можете взаємодіяти з моделлю Mixtral-8x7B, як із будь-якою стандартною моделлю генерації тексту, де модель обробляє вхідну послідовність і виводить передбачені наступні слова в послідовності. У цьому розділі ми надаємо приклади підказок.

Генерація коду

Використовуючи попередній приклад, ми можемо використовувати такі підказки для створення коду:

Ви отримуєте наступний результат:

Підказка аналізу настроїв

За допомогою Mixtral 8x7B можна виконати аналіз настрою за допомогою підказки, подібної до наведеної нижче:

Ви отримуєте наступний результат:

Підказки з відповідями на запитання

З Mixtral-8x7B ви можете використовувати підказку відповіді на запитання, подібну до наступної:

Ви отримуєте наступний результат:

Мікстраль-8х7Б Інструкт

Версія Mixtral-8x7B, налаштована на інструкції, приймає форматовані інструкції, де ролі розмови мають починатися з підказки користувача та чергуватися між інструкцією користувача та помічником (модель відповіді). Необхідно суворо дотримуватися формату інструкцій, інакше модель генеруватиме неоптимальні результати. Шаблон, який використовується для створення підказки для моделі Instruct, визначається наступним чином:

Зверніть увагу, що <s> та </s> є спеціальними маркерами для початку рядка (BOS) і кінця рядка (EOS), тоді як [INST] та [/INST] є регулярними рядками.

Наступний код показує, як можна відформатувати запит у форматі інструкції:

Відновлення знань

Ви можете використовувати наступний код для запиту на отримання знань:

Ви отримуєте наступний результат:

Кодування

Моделі Mixtral можуть продемонструвати сильні сторони тестів для завдань кодування, як показано в наступному коді:

Математика і міркування

Моделі Mixtral також повідомляють про переваги в математичній точності:

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- : має

- :є

- : ні

- :де

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26%

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- здібності

- МЕНЮ

- вище

- прискорення

- Приймає

- доступ

- Рахунки

- точність

- Achieve

- Досягає

- через

- активний

- доданий

- додати

- після

- проти

- AI

- AI / ML

- алгоритми

- ВСІ

- Також

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- кількість

- an

- аналіз

- та

- та інфраструктури

- Оголосити

- відповідь

- будь-який

- Apache

- привабливий

- застосування

- прикладної

- Застосування

- архітектура

- ЕСТЬ

- аргумент

- стаття

- AS

- Помічник

- At

- доступний

- AWS

- назад

- Хребет

- заснований

- бити

- акумулятор

- Байєсівський

- BE

- оскільки

- було

- перед тим

- початок

- вважає,

- Дзвін

- орієнтир

- тести

- Краще

- між

- Білл

- біллінг

- Мільярд

- сміливий

- куплений

- Box

- Перерва

- приносити

- будувати

- Створюємо

- вбудований

- бізнес

- але

- by

- обчислювати

- call

- званий

- Виклики

- CAN

- карта

- випадок

- випадків

- зміна

- чат

- вибір

- Вибирати

- Вибираючи

- Кріс

- класифікація

- клацання

- код

- Кодування

- поєднання

- порівняний

- скомпільований

- завершення

- обчислювальна

- обчислення

- комп'ютер

- Комп'ютерне бачення

- конференції

- постійно

- Контейнер

- зміст

- контекст

- триває

- постійно

- управління

- Розмова

- Коштувати

- витрати

- може

- створювати

- створений

- вирішальне значення

- Чашка

- Поточний

- Клієнти

- настройка

- налаштувати

- дані

- безпеку даних

- набори даних

- день

- Днів

- присвячених

- дефолт

- певний

- Демократизувати

- демонструвати

- розгортання

- розгорнути

- розгортання

- розгортання

- розгортає

- дрейф

- деталі

- розвивати

- розвиненою

- Розробник

- розробка

- DICT

- DID

- відкрити

- do

- робить

- доларів

- домени

- зроблений

- вниз

- Падіння

- Герцог

- герцогський університет

- кожен

- Економічний

- редактор

- ефективність

- Яйця

- ще

- включіть

- дозволяє

- дозволяє

- кінець

- Кінцева точка

- Машинобудування

- англійська

- забезпечувати

- Навколишнє середовище

- EOS

- рівним

- Еквівалент

- етичний

- приклад

- перевищує

- збуджений

- виключення

- експерт

- experts

- Пояснювати

- пояснення

- розширення

- сім'я

- швидше

- риси

- кілька

- Файли

- Фільтри

- знайти

- Перший

- після

- слідує

- для

- формат

- фонд

- фракція

- французька

- від

- функція

- майбутнє

- Головна мета

- породжувати

- генерується

- покоління

- генеративний

- Генеративний ШІ

- німецька

- отримати

- Go

- добре

- є

- Зростання

- ненавидіти

- Мати

- he

- допомога

- допомогу

- допомагає

- її

- тут

- Високий

- Пагорби

- його

- Як

- How To

- HTML

- HTTPS

- Концентратор

- i

- ICE

- морозиво

- ID

- if

- Іллінойс

- хвороба

- імпорт

- важливо

- удосконалювати

- поліпшення

- in

- включати

- У тому числі

- Зареєстрований

- Інфраструктура

- вхід

- витрати

- екземпляр

- інструкції

- інтегрувати

- інтегрований

- взаємодіяти

- інтереси

- інтерфейс

- Винайдений

- ізольований

- IT

- італійський

- ЙОГО

- сам

- JPG

- Діти

- знання

- затока

- Labs

- посадка

- мова

- великий

- останній

- шар

- Веде за собою

- вивчення

- довжина

- дозволяти

- ліцензія

- як

- Сподобалося

- рамки

- LINK

- список

- Прослуховування

- трохи

- LLM

- логіка

- шукати

- знизити

- машина

- навчання за допомогою машини

- made

- РОБОТИ

- Робить

- менеджер

- багато

- сірники

- математики

- математика

- me

- середа

- суміш

- ML

- MLOps

- режим

- модель

- Моделі

- модифікований

- місяць

- більше

- мотоцикл

- багато

- помножене

- музика

- повинен

- my

- Природний

- Обробка природних мов

- навігація

- негативний

- мережу

- Нейтральний

- Нові

- наступний

- nlp

- ніхто

- увагу

- ноутбук

- зараз

- номер

- of

- Нафта

- on

- один раз

- ONE

- тільки

- операційний

- операційна система

- варіант

- or

- Інше

- інакше

- з

- вихід

- виходи

- поза

- над

- власний

- сторінка

- оплачувану

- pane

- документи

- параметр

- параметри

- Проходження

- пристрасть

- пристрасний

- стежки

- для

- Виконувати

- продуктивність

- Вчений ступінь

- телефон

- plato

- Інформація про дані Платона

- PlatoData

- точка

- портативний

- позитивний

- пошта

- попередній

- передвіщений

- Прогноз

- переважним

- підготовка

- попередній

- Головний

- друк

- процедурні

- процес

- процеси

- обробка

- Product

- програма

- Програмування

- підказок

- процвітання

- забезпечувати

- провайдери

- забезпечує

- публічно

- опублікований

- Python

- Квартал

- питання

- швидко

- RE

- читання

- рецепт

- Рекурсивний

- зменшити

- послатися

- регулярний

- випущений

- звітом

- запросити

- дослідження

- дослідник

- ресурси

- поважають

- відповідь

- відповідальний

- Обмеження

- результат

- результати

- повертати

- Умови повернення

- верхова їзда

- Risk

- Роль

- ролі

- Кімната

- прогін

- біг

- s

- SA

- мудрець

- сіль

- масштабовані

- шкала

- наука

- вчений

- Sdk

- Пошук

- розділ

- безпечний

- безпеку

- побачити

- вибрати

- обраний

- вибирає

- вибір

- старший

- настрій

- окремий

- Послідовність

- Серія

- Послуги

- комплект

- показав

- показаний

- Шоу

- значний

- Аналогічно

- простий

- з

- один

- Розмір

- So

- соціальна

- суспільство

- Софтвер

- рішення

- іспанська

- спеціальний

- спеціаліст

- зазначений

- швидкість

- Витрати

- standard

- старт

- почалася

- починається

- впроваджений

- статистичний

- Крок

- заходи

- Як і раніше

- зупинений

- зберігати

- просто

- Стратегічний

- потік

- сильні сторони

- рядок

- структурований

- студія

- такі

- підтримка

- Підтримуючий

- Опори

- система

- приймає

- завдання

- ключі

- команда

- Технологія

- шаблон

- тест

- перевірений

- Тестування

- текст

- Що

- Команда

- Майбутнє

- потім

- Ці

- вони

- це

- через

- час

- Часовий ряд

- times

- до

- разом

- знак

- Жетони

- занадто

- інструменти

- Усього:

- поїзд

- Навчання

- правда

- намагатися

- чірікать

- тип

- ui

- при

- університет

- UNIX

- відімкнути

- до

- використання

- використання випадку

- використовуваний

- користувач

- використовує

- використання

- використовує

- Долина

- значення

- Цінності

- різноманітність

- версія

- Відео

- вид

- бачення

- візит

- візуальний

- ходити

- було

- вода

- we

- Web

- веб-сервіси

- Web-Based

- ДОБРЕ

- Що

- Що таке

- коли

- в той час як

- який

- білий

- ВООЗ

- волі

- з

- в

- без

- слова

- Work

- б

- запис

- письмовий

- Ти

- вашу

- зефірнет

Рачна Чадха є головним архітектором рішень AI/ML у Strategic Accounts в AWS. Рахна — оптиміст, який вірить, що етичне та відповідальне використання ШІ може покращити суспільство в майбутньому та принести економічне та соціальне процвітання. У вільний час Рачна любить проводити час з сім'єю, гуляти в походах і слухати музику.

Рачна Чадха є головним архітектором рішень AI/ML у Strategic Accounts в AWS. Рахна — оптиміст, який вірить, що етичне та відповідальне використання ШІ може покращити суспільство в майбутньому та принести економічне та соціальне процвітання. У вільний час Рачна любить проводити час з сім'єю, гуляти в походах і слухати музику. Доктор Кайл Ульріх є прикладним науковцем з

Доктор Кайл Ульріх є прикладним науковцем з  Крістофер Віттен є розробником програмного забезпечення в команді JumpStart. Він допомагає масштабувати вибір моделей та інтегрувати моделі з іншими службами SageMaker. Кріс захоплений прискоренням повсюдного поширення ШІ в різних сферах бізнесу.

Крістофер Віттен є розробником програмного забезпечення в команді JumpStart. Він допомагає масштабувати вибір моделей та інтегрувати моделі з іншими службами SageMaker. Кріс захоплений прискоренням повсюдного поширення ШІ в різних сферах бізнесу. Доктор Фабіо Нонато де Паула є старшим менеджером спеціаліста GenAI SA, який допомагає постачальникам моделей і клієнтам масштабувати генеративний ШІ в AWS. Фабіо має пристрасть до демократизації доступу до генеративної технології ШІ. Поза роботою ви можете знайти Фабіо, який катається на своєму мотоциклі пагорбами долини Сонома або читає ComiXology.

Доктор Фабіо Нонато де Паула є старшим менеджером спеціаліста GenAI SA, який допомагає постачальникам моделей і клієнтам масштабувати генеративний ШІ в AWS. Фабіо має пристрасть до демократизації доступу до генеративної технології ШІ. Поза роботою ви можете знайти Фабіо, який катається на своєму мотоциклі пагорбами долини Сонома або читає ComiXology. Доктор Ашиш Хетан є старшим прикладним науковим співробітником із вбудованими алгоритмами Amazon SageMaker і допомагає розробляти алгоритми машинного навчання. Він отримав ступінь доктора філософії в Іллінойському університеті Урбана-Шампейн. Він активно досліджує машинне навчання та статистичні висновки та опублікував багато статей на конференціях NeurIPS, ICML, ICLR, JMLR, ACL та EMNLP.

Доктор Ашиш Хетан є старшим прикладним науковим співробітником із вбудованими алгоритмами Amazon SageMaker і допомагає розробляти алгоритми машинного навчання. Він отримав ступінь доктора філософії в Іллінойському університеті Урбана-Шампейн. Він активно досліджує машинне навчання та статистичні висновки та опублікував багато статей на конференціях NeurIPS, ICML, ICLR, JMLR, ACL та EMNLP. Карл Альбертсен очолює продукт, розробку та науку для Amazon SageMaker Algorithms і JumpStart, центру машинного навчання SageMaker. Він захоплений застосуванням машинного навчання для розкриття цінності бізнесу.

Карл Альбертсен очолює продукт, розробку та науку для Amazon SageMaker Algorithms і JumpStart, центру машинного навчання SageMaker. Він захоплений застосуванням машинного навчання для розкриття цінності бізнесу.