У світі, що все більше орієнтується на дані, підприємства повинні зосередитися на зборі як цінної фізичної інформації, так і на генеруванні інформації, яка їм потрібна, але яку нелегко отримати. Доступ до даних, регулювання та відповідність вимогам стають дедалі більшим джерелом суперечок щодо інновацій у аналітиці та штучному інтелекті (ШІ).

Для сильно регульованих секторів, таких як фінансові послуги, охорона здоров’я, біологія, автомобілебудування, робототехніка та виробництво, проблема ще більша. Це створює перешкоди для розробки системи, обміну даними (внутрішніми та зовнішніми), монетизації, аналітиці та машинному навчанню (ML).

Синтетичні дані – це інструмент, який вирішує багато проблем з даними, зокрема проблеми штучного інтелекту та аналітики, як-от захист конфіденційності, відповідність нормативним вимогам, доступність, дефіцит даних і упередженість. Це також включає обмін даними та час отримання даних (і, отже, час виходу на ринок).

Синтетичні дані генеруються алгоритмом. Він відображає статистичні властивості та шаблони з вихідних даних. Але важливо, що він не містить конфіденційних, приватних або особистих даних.

Ви ставите запитання щодо синтетичних даних і отримуєте ті самі відповіді, що й із реальних даних.

У нашій попередній пост, ми продемонстрували, як використовувати змагальні мережі, такі як Generative Adversarial Networks (GANS), для створення табличних наборів даних для покращення навчання моделі кредитного шахрайства.

Для того, щоб бізнес-стейкхолдери використовували синтетичні дані для своїх проектів ML та аналітики, важливо не лише переконатися, що згенеровані синтетичні дані відповідатимуть меті та очікуваним додаткам, а й мати можливість виміряти та продемонструвати якість згенеровані дані.

Зі збільшенням юридичних та етичних зобов’язань щодо збереження конфіденційності однією з сильних сторін синтетичних даних є здатність видаляти конфіденційну та оригінальну інформацію під час її синтезу. Тому, окрім якості, нам потрібні показники, щоб оцінити ризик витоку приватної інформації, якщо такий є, і оцінити, чи процес генерації не є «запам’ятовуванням» або копіюванням вихідних даних.

Щоб досягти всього цього, ми можемо відобразити якість синтетичних даних у параметрах, які допоможуть користувачам, зацікавленим сторонам і нам краще зрозуміти згенеровані дані.

Три виміри оцінки якості синтетичних даних

Згенеровані синтетичні дані вимірюються за трьома ключовими параметрами:

- Вірність

- Утиліта

- Конфіденційність

Ось деякі із запитань щодо будь-яких згенерованих синтетичних даних, на які слід відповісти у звіті про якість синтетичних даних:

- Наскільки ці синтетичні дані схожі на оригінальний навчальний набір?

- Наскільки ці синтетичні дані корисні для наших подальших програм?

- Чи стався витік будь-якої інформації з вихідних даних навчання в синтетичні дані?

- Чи були якісь дані, які вважаються конфіденційними в реальному світі (з інших наборів даних, які не використовуються для навчання моделі), випадково синтезовані нашою моделлю?

Показники, які передають кожен із цих вимірів для кінцевих користувачів, є дещо гнучкими. Зрештою, дані, які мають бути згенеровані, можуть відрізнятися з точки зору розподілу, розміру та поведінки. Вони також повинні бути легкими для розуміння та тлумачення.

Зрештою, метрики мають бути повністю керовані даними, і не вимагають жодних попередніх знань або інформації, що стосується конкретної області. Однак, якщо користувач бажає застосувати певні правила та обмеження, застосовні до конкретного бізнес-домену, він повинен мати можливість визначити їх під час процесу синтезу, щоб переконатися, що точність для конкретного домену виконується.

Ми розглянемо кожен із цих показників більш детально в наступних розділах.

Показники для розуміння вірності

У будь-якому науковому проекті даних ми повинні розуміти, чи певна вибіркова сукупність має відношення до проблеми, яку ми вирішуємо. Подібним чином, для процесу оцінки релевантності згенерованих синтетичних даних ми повинні оцінити їх з точки зору вірність порівняно з оригіналом.

Візуальне представлення цих показників полегшує їх розуміння. Ми могли б проілюструвати, чи були дотримані кардинальність і співвідношення категорій, чи зберігалися кореляції між різними змінними тощо.

Візуалізація даних не тільки допомагає оцінити якість синтетичних даних, але й є одним із початкових кроків життєвого циклу науки про дані для кращого розуміння даних.

Розглянемо деякі показники вірності більш детально.

Пошукові статистичні порівняння

У дослідницьких статистичних порівняннях особливості вихідних і синтетичних наборів даних досліджуються за допомогою ключових статистичних показників, таких як середнє значення, медіана, стандартне відхилення, чіткі значення, відсутні значення, мінімуми, максимуми, діапазони квартилів для безперервних функцій і число записів на категорію, відсутні значення на категорію та символи, які найчастіше зустрічаються для категоріальних атрибутів.

Це порівняння має проводитися між оригінальним набором даних, що не встановлюється, і синтетичними даними. Ця оцінка виявить, чи порівнювані набори даних статистично подібні. Якщо ні, тоді ми матимемо розуміння того, які функції та заходи відрізняються. Вам слід розглянути можливість повторного навчання та відновлення синтетичних даних з іншими параметрами, якщо помічена значна різниця.

Цей тест діє як початковий скринінг, щоб переконатися, що синтетичні дані мають достатню точність вихідного набору даних і, отже, можуть пройти більш суворе тестування.

Оцінка подібності гістограми

Оцінка подібності гістограми вимірює граничні розподіли синтетичних і оригінальних наборів даних для кожної функції.

Оцінка подібності обмежена між нулем і одиницею, причому оцінка один вказує на те, що розподіли синтетичних даних повністю перекривають розподіли вихідних даних.

Оцінка, близька до одиниці, дасть користувачам впевненість у тому, що набір даних, що не використовується, і синтетичний набір даних статистично подібні.

Оцінка взаємоінформації

Оцінка взаємної інформації вимірює взаємну залежність двох ознак, числову чи категоріальну, вказуючи, скільки інформації можна отримати з однієї ознаки, спостерігаючи за іншою.

Взаємна інформація може вимірювати нелінійні зв’язки, забезпечуючи більш повне розуміння якості синтетичних даних, оскільки це дозволяє зрозуміти ступінь збереження зв’язків змінної.

Оцінка один вказує на те, що взаємна залежність між функціями була ідеально відображена в синтетичних даних.

Оцінка кореляції

Оцінка кореляції вимірює, наскільки добре кореляції в оригінальному наборі даних були відображені в синтетичних даних.

Кореляції між двома або більше стовпцями надзвичайно важливі для додатків ML, які допомагають виявити зв’язки між функціями та цільовою змінною та допомагають створити добре навчену модель.

Оцінка кореляції обмежена між нулем і одиницею, при цьому оцінка один вказує на те, що кореляції ідеально узгоджені.

На відміну від структурованих табличних даних, з якими ми зазвичай стикаємось у проблемах із даними, деякі типи структурованих даних мають певну поведінку, коли минулі спостереження можуть вплинути на наступні спостереження. Вони відомі як часові ряди або послідовні дані – наприклад, набір даних із щогодинними вимірюваннями кімнатної температури.

Така поведінка означає, що існує вимога визначити певні показники, які можуть конкретно виміряти якість цих наборів даних часових рядів

Автокореляція та часткова автокореляція

Незважаючи на те, що автокореляція подібна до кореляції, вона показує зв’язок часового ряду за його теперішньою вартістю та її попередніми значеннями. Усунення ефектів попередніх часових затримок дає часткову автокореляцію. Тому оцінка автокореляції вимірює, наскільки добре синтетичні дані зафіксували значні автокореляції або часткові кореляції з вихідного набору даних.

Показники для розуміння корисності

Тепер ми, можливо, статистично зрозуміли, що синтетичні дані схожі на вихідний набір даних. Крім того, ми також повинні оцінити, наскільки добре синтезований набір даних справляється зі звичайними проблемами науки про дані, коли навчається на кількох алгоритмах ML.

Використовуючи наступне утиліта метрик, ми прагнемо створити впевненість у тому, що ми дійсно можемо досягти продуктивності подальших програм щодо того, як працюють вихідні дані.

Оцінка прогнозу

Вимірювання продуктивності синтетичних даних порівняно з вихідними реальними даними можна виконати за допомогою моделей ML. Оцінка моделі нижче за течією фіксує якість синтетичних даних шляхом порівняння продуктивності моделей ML, навчених як на синтетичних, так і на оригінальних наборах даних і підтверджених на прихованих даних тестування з вихідного набору даних. Це забезпечує a Train Synthetic Test Real (TSTR) бал і Train Real Test Real (TRTR) бал відповідно.

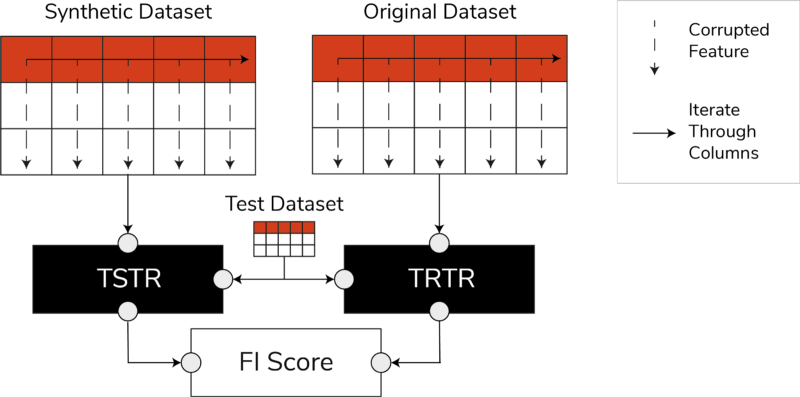

Оцінки TSTR, TRTR і оцінка важливості функції (зображення автора)

Оцінка включає широкий спектр найнадійніших алгоритмів машинного навчання для завдань регресії чи класифікації. Використання кількох класифікаторів і регресорів гарантує, що оцінка є більш узагальненою для більшості алгоритмів, тому синтетичні дані можуть вважатися корисними в майбутньому.

Зрештою, якщо оцінка TSTR і оцінка TRTR порівнюються, це вказує на те, що синтетичні дані мають якість, щоб використовувати її для підготовки ефективних моделей ML для реальних програм.

Оцінка важливості функції

Тесно пов’язаний із оцінкою прогнозу, оцінка важливості ознаки (FI) розширює її, додаючи можливість інтерпретації до оцінок TSTR і TRTR.

Оцінка F1 порівнює зміни та стабільність порядку важливості ознак, отриманих із оцінкою прогнозу. Синтетичний набір даних вважається висококорисним, якщо він дає такий самий порядок важливості ознак, як вихідні реальні дані.

QScore

Щоб переконатися, що модель, навчена на наших щойно згенерованих даних, дасть ті самі відповіді на ті самі запитання, що й модель, навчена на вихідних даних, ми використовуємо Qscore. Це вимірює низхідну продуктивність синтетичних даних, запускаючи багато випадкових запитів на основі агрегації як до синтетичних, так і до вихідних (і залишкових) наборів даних.

Ідея полягає в тому, що обидва ці запити повинні повертати однакові результати.

Високий показник QScore гарантує, що подальші програми, які використовують запити та операції агрегації, можуть надавати майже однакову цінність, ніж вихідний набір даних.

Показники для розуміння конфіденційності

з недоторканність приватного життя У зв’язку з уже діючими нормативними актами, захист конфіденційної інформації є етичним зобов’язанням і вимогою законодавства.

Перш ніж ці синтетичні дані можна буде вільно ділитися та використовувати для подальших програм, ми повинні розглянути показники конфіденційності, які можуть допомогти зацікавленій стороні зрозуміти, де згенеровані синтетичні дані порівняно з вихідними даними з точки зору обсягу витоку інформації. Крім того, ми повинні прийняти важливі рішення щодо того, як синтетичні дані можна використовувати та обмінювати.

Точний рахунок відповідності

Пряма та інтуїтивна оцінка конфіденційності полягає в пошуку копій справжніх даних серед синтетичних записів. Оцінка точного збігу враховує кількість реальних записів, які можна знайти серед синтетичного набору.

Оцінка має бути нульовою, що свідчить про те, що в синтетичних даних немає реальної інформації. Цей показник діє як механізм перевірки, перш ніж ми оцінюємо подальші показники конфіденційності.

Оцінка конфіденційності сусідів

Крім того, оцінка конфіденційності сусідів вимірює співвідношення синтетичних записів, які можуть бути занадто близькими за схожістю до реальних. Це означає, що, хоча вони і не є прямими копіями, вони є потенційними точками витоку конфіденційності та джерелом корисної інформації для атак на логічні висновки.

Оцінка обчислюється шляхом проведення високорозмірного пошуку найближчих сусідів на синтетичних даних, які перекриваються вихідними даними.

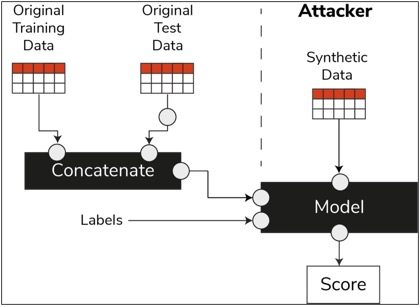

Оцінка висновку про членство

У життєвому циклі науки про дані, коли модель пройшла навчання, вона більше не потребує доступу до навчальних зразків і може робити прогнози на невидимих даних. Подібним чином, у нашому випадку, коли модель синтезатора навчена, зразки синтетичних даних можуть бути згенеровані без потреби у вихідних даних.

Через тип нападу, який називається «атака з висновком про членство», зловмисники можуть спробувати відкрити дані, які використовувалися для створення синтетичних даних, не маючи доступу до вихідних даних. Це призводить до порушення конфіденційності.

Оцінка висновку про членство вимірює ймовірність успішної атаки з висновком про членство.

Низький бал свідчить про доцільність висновку про те, що певний запис був членом навчального набору даних, який призвів до створення синтетичних даних. Іншими словами, атаки можуть отримати деталі індивідуального запису, тим самим порушуючи конфіденційність.

Висока оцінка членства вказує на те, що зловмисник навряд чи зможе визначити, чи був окремий запис частиною вихідного набору даних, використаного для створення синтетичних даних. Це також означає, що інформація жодної особи не була скомпрометована через синтетичні дані.

Концепція затримки

Важлива найкраща практика, якої ми повинні дотримуватися, полягає в тому, щоб переконатися, що синтетичні дані є достатньо загальними та не переповнюють вихідні дані, на яких їх було навчено. У типовому потоці науки про дані під час створення моделей ML, таких як класифікатор Random Forest, ми відкладаємо тестові дані, навчаємо моделі за допомогою навчальних даних і оцінюємо показники на невидимих тестових даних.

Подібним чином для синтетичних даних ми залишаємо осторонь зразок вихідних даних (зазвичай їх називають невідомим набором даних або невидимими прихованими тестовими даними) і порівнюємо згенеровані синтетичні дані з невідомим набором даних.

Очікується, що затриманий набір даних буде представленням вихідних даних, але не видно під час створення синтетичних даних. Тому дуже важливо мати однакові оцінки для всіх показників під час порівняння оригіналу з утриманими та синтетичними наборами даних.

Коли отримано подібні бали, ми можемо встановити, що синтетичні точки даних не є результатом запам’ятовування вихідних точок даних, зберігаючи ту саму точність і корисність.

Заключні думки

Світ починає розуміти стратегічну важливість синтетичних даних. Як науковці та генератори даних, наш обов’язок — зміцнювати довіру до синтетичних даних, які ми створюємо, і переконатися, що вони призначені для певної мети.

Синтетичні дані стають обов’язковим елементом інструментарію для розробки даних. MIT Technology Review має зазначив, синтетичних даних як однієї з проривних технологій 2022 року. Ми не можемо уявити створення чудових моделей ШІ без синтетичних даних, стверджує Gartner.

За оцінками McKinsey, синтетичні дані мінімізують витрати та бар’єри, які б виникли під час розробки алгоритмів або отримання доступу до даних.

Генерація синтетичних даних полягає у знанні подальших програм і розумінні компромісів між різними параметрами якості синтетичних даних.

Підсумки

Як користувачу синтетичних даних важливо визначити контекст варіанта використання, для якого кожен зразок синтетичних даних буде використовуватися в майбутньому. Як і у випадку з реальними даними, якість синтетичних даних залежить від передбачуваного варіанту використання, а також параметрів, вибраних для синтезу.

Наприклад, збереження викидів у синтетичних даних, як і в вихідних даних, корисно для виявлення шахрайства. Однак це не корисно в медичних цілях із проблемами конфіденційності, оскільки викиди зазвичай можуть бути витоком інформації.

Крім того, існує компроміс між точністю, корисністю та конфіденційністю. Дані не можна оптимізувати для всіх трьох одночасно. Ці показники дозволяють зацікавленим сторонам визначати пріоритети того, що важливо для кожного випадку використання, і керувати очікуваннями від згенерованих синтетичних даних.

Зрештою, коли ми бачимо значення кожного показника та коли вони відповідають очікуванням, зацікавлені сторони можуть бути впевнені в рішеннях, які вони створюють на основі синтетичних даних.

Варіанти використання структурованих синтетичних даних охоплюють широкий спектр застосування від тестових даних для розробки програмного забезпечення до створення синтетичних контрольних груп у клінічних випробуваннях.

Зверніться, щоб вивчити ці можливості, або створіть PoC, щоб продемонструвати цінність.

Фаріс Хаддад є провідним спеціалістом із обробки даних та аналізу в команді стратегічних пошуків AABG. Він допомагає підприємствам успішно стати керованими даними.

Фаріс Хаддад є провідним спеціалістом із обробки даних та аналізу в команді стратегічних пошуків AABG. Він допомагає підприємствам успішно стати керованими даними.

- Розширений (300)

- AI

- ai мистецтво

- AI арт генератор

- ai робот

- Амазонське машинне навчання

- штучний інтелект

- сертифікація штучного інтелекту

- штучний інтелект у банківській справі

- робот зі штучним інтелектом

- роботи зі штучним інтелектом

- програмне забезпечення для штучного інтелекту

- AWS Машинне навчання

- blockchain

- блокчейн конференція AI

- coingenius

- розмовний штучний інтелект

- крипто конференція ai

- dall's

- глибоке навчання

- у вас є гугл

- навчання за допомогою машини

- plato

- платон ai

- Інформація про дані Платона

- Гра Платон

- PlatoData

- platogaming

- масштаб ai

- синтаксис

- Технічні інструкції

- зефірнет