تعارف

اپنی تمام تر خوبیوں کے لیے، مصنوعی عصبی نیٹ ورک ہمیشہ کی طرح ناقابل تسخیر رہتے ہیں۔ جیسے جیسے یہ نیٹ ورک بڑے ہوتے جاتے ہیں، ان کی صلاحیتیں پھٹ جاتی ہیں، لیکن ان کے اندرونی کاموں کو سمجھنا ہمیشہ سے تقریباً ناممکن رہا ہے۔ محققین مسلسل کسی بھی ایسی بصیرت کی تلاش میں رہتے ہیں جو وہ ان ماڈلز میں تلاش کر سکیں۔

کچھ سال پہلے، انہوں نے ایک نیا دریافت کیا.

جنوری 2022 میں، اوپن اے آئی کے محققین، چیٹ جی پی ٹی کے پیچھے کمپنی، رپورٹ کے مطابق کہ ان سسٹمز نے، جب غلطی سے ڈیٹا کو معمول سے کہیں زیادہ لمبا کرنے کی اجازت دے دی، تو مسائل کو حل کرنے کے منفرد طریقے تیار کیے۔ عام طور پر، جب انجینئرز نیورل نیٹ ورکس سے مشین لرننگ ماڈلز بناتے ہیں - جو کہ مصنوعی نیورون کہلانے والے کمپیوٹیشن کی اکائیوں پر مشتمل ہوتے ہیں - وہ تربیت کو ایک خاص مقام پر روک دیتے ہیں، جسے اوور فٹنگ رجیم کہا جاتا ہے۔ یہ تب ہوتا ہے جب نیٹ ورک بنیادی طور پر اپنے تربیتی ڈیٹا کو حفظ کرنا شروع کر دیتا ہے اور اکثر نئی، غیر دیکھی ہوئی معلومات کو عام نہیں کرتا ہے۔ لیکن جب OpenAI ٹیم نے غلطی سے اس نقطہ سے آگے ایک چھوٹے نیٹ ورک کی تربیت کی، تو ایسا لگتا ہے کہ اس مسئلے کی سمجھ پیدا ہوتی ہے جو صرف یاد رکھنے سے آگے بڑھ گئی ہے - یہ اچانک کسی بھی ٹیسٹ ڈیٹا کو اکٹھا کر سکتا ہے۔

محققین نے اس رجحان کو "گروکنگ" کا نام دیا، ایک اصطلاح جو سائنس فکشن کے مصنف رابرٹ اے ہینلین نے تیار کی ہے جس کا مطلب ہے کسی چیز کو سمجھنا "اتنی اچھی طرح سے کہ مبصر مشاہدہ کیے جانے والے عمل کا حصہ بن جائے۔" زیادہ تربیت یافتہ نیورل نیٹ ورک، جو کہ کچھ ریاضی کی کارروائیوں کو انجام دینے کے لیے ڈیزائن کیا گیا تھا، نے اعداد کی عمومی ساخت کو سیکھ لیا تھا اور نتیجہ کو اندرونی بنا دیا تھا۔ یہ گرا اور حل بن گیا تھا.

"یہ [تھا] بہت پرجوش اور فکر انگیز،" کہا میخائل بیلکن یونیورسٹی آف کیلیفورنیا، سان ڈیاگو، جو نیورل نیٹ ورکس کی نظریاتی اور تجرباتی خصوصیات کا مطالعہ کرتی ہے۔ "اس نے بہت سارے فالو اپ کام کی حوصلہ افزائی کی۔"

درحقیقت، دوسروں نے نتائج کو نقل کیا ہے اور یہاں تک کہ ان کو ریورس انجینئر کیا ہے۔ تازہ ترین کاغذات نے نہ صرف یہ واضح کیا کہ جب یہ عصبی نیٹ ورک بڑھتے ہیں تو کیا کر رہے ہیں بلکہ ایک نئی عینک بھی فراہم کی گئی ہے جس کے ذریعے ان کے اندرونی حصوں کی جانچ کی جا سکتی ہے۔ "گروکنگ سیٹ اپ گہری سیکھنے کے بہت سے مختلف پہلوؤں کو سمجھنے کے لیے ایک اچھے ماڈل آرگنزم کی طرح ہے،" کہا ایرک مائکاؤڈ میساچوسٹس انسٹی ٹیوٹ آف ٹیکنالوجی کے۔

اس جاندار کے اندر جھانکنا بعض اوقات کافی ظاہر ہوتا ہے۔ "آپ کو نہ صرف خوبصورت ڈھانچہ مل سکتا ہے، بلکہ یہ خوبصورت ڈھانچہ یہ سمجھنے کے لیے اہم ہے کہ اندرونی طور پر کیا ہو رہا ہے،" کہا۔ نیل نندا، اب لندن میں گوگل ڈیپ مائنڈ میں۔

حد سے پرے

بنیادی طور پر، مشین لرننگ ماڈل کا کام آسان لگتا ہے: دیے گئے ان پٹ کو مطلوبہ آؤٹ پٹ میں تبدیل کریں۔ یہ سیکھنے کے الگورتھم کا کام ہے کہ وہ بہترین ممکنہ فنکشن کو تلاش کرے جو ایسا کر سکے۔ کوئی بھی دیا ہوا ماڈل صرف فنکشنز کے ایک محدود سیٹ تک رسائی حاصل کر سکتا ہے، اور وہ سیٹ اکثر ماڈل میں موجود پیرامیٹرز کی تعداد سے طے ہوتا ہے، جو کہ عصبی نیٹ ورکس کے معاملے میں مصنوعی نیوران کے درمیان رابطوں کی تعداد کے تقریباً برابر ہوتا ہے۔

تعارف

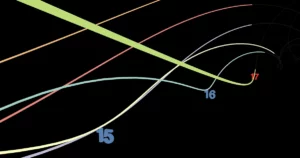

جیسا کہ نیٹ ورک ٹریننگ کرتا ہے، یہ زیادہ پیچیدہ فنکشنز سیکھنے کا رجحان رکھتا ہے، اور متوقع آؤٹ پٹ اور اصل کے درمیان فرق ٹریننگ ڈیٹا کے لیے گرنا شروع ہو جاتا ہے۔ اس سے بھی بہتر، یہ تفاوت، جسے نقصان کے نام سے جانا جاتا ہے، ٹیسٹ ڈیٹا کے لیے بھی نیچے جانا شروع ہو جاتا ہے، جو کہ نیا ڈیٹا ہے جو تربیت میں استعمال نہیں ہوتا ہے۔ لیکن کسی وقت، ماڈل اوور فٹ ہونا شروع ہو جاتا ہے، اور جب کہ ٹریننگ ڈیٹا کا نقصان گرتا رہتا ہے، ٹیسٹ ڈیٹا کا نقصان بڑھنا شروع ہو جاتا ہے۔ لہذا، عام طور پر، اس وقت جب محققین نیٹ ورک کی تربیت بند کر دیتے ہیں۔

یہی وہ مروجہ حکمت تھی جب OpenAI کی ٹیم نے یہ دریافت کرنا شروع کیا کہ نیورل نیٹ ورک ریاضی کیسے کرسکتا ہے۔ وہ ایک چھوٹا سا استعمال کر رہے تھے۔ ٹرانسفارمر — ایک نیٹ ورک فن تعمیر جس نے حال ہی میں بڑے لینگویج ماڈلز میں انقلاب برپا کیا ہے — مختلف قسم کے ماڈیولر ریاضی کرنے کے لیے، جس میں آپ ایک محدود سیٹ نمبر کے ساتھ کام کرتے ہیں جو خود پر واپس لوٹ جاتے ہیں۔ Modulo 12، مثال کے طور پر، گھڑی کے چہرے پر کیا جا سکتا ہے: 11 + 2 = 1۔ ٹیم نے دو نمبروں کو شامل کرنے کے نیٹ ورک کی مثالیں دکھائیں، a اور bایک آؤٹ پٹ پیدا کرنے کے لیے، c, ماڈیولو 97 میں (97 نمبروں والی گھڑی کے چہرے کے برابر)۔ اس کے بعد انہوں نے ٹرانسفارمر کا نادیدہ امتزاج پر تجربہ کیا۔ a اور b یہ دیکھنے کے لیے کہ آیا یہ صحیح طور پر پیش گوئی کر سکتا ہے۔ c.

جیسا کہ توقع کی گئی تھی، جب نیٹ ورک اوور فٹنگ نظام میں داخل ہوا، تربیتی ڈیٹا کا نقصان صفر کے قریب آ گیا (اس نے جو کچھ دیکھا تھا اسے یاد کرنا شروع کر دیا تھا)، اور ٹیسٹ ڈیٹا کا نقصان بڑھنا شروع ہو گیا۔ یہ عام نہیں تھا۔ "اور پھر ایک دن، ہم خوش قسمت ہو گئے،" ٹیم لیڈر الیتھیا پاور نے کہا، ستمبر 2022 میں بات کرتے ہوئے۔ سان فرانسسکو میں ایک کانفرنس میں "اور خوش قسمتی سے، میرا مطلب ہے بھولنے والا۔"

ٹیم ممبر جو نیٹ ورک کو ٹریننگ دے رہا تھا چھٹی پر چلا گیا اور ٹریننگ روکنا بھول گیا۔ جیسا کہ نیٹ ورک کا یہ ورژن تربیت دیتا رہا، یہ اچانک غیر دیکھے ڈیٹا پر درست ہو گیا۔ خودکار جانچ نے باقی ٹیم کو یہ غیر متوقع درستگی ظاہر کر دی، اور انہیں جلد ہی احساس ہو گیا کہ نیٹ ورک نے نمبروں کو ترتیب دینے کے ہوشیار طریقے تلاش کر لیے ہیں۔ a اور b. اندرونی طور پر، نیٹ ورک کچھ اعلی جہتی جگہ میں نمبروں کی نمائندگی کرتا ہے، لیکن جب محققین نے ان نمبروں کو 2D جگہ پر پیش کیا اور ان کا نقشہ بنایا، تو اعداد نے ایک دائرہ تشکیل دیا۔

یہ حیران کن تھا۔ ٹیم نے کبھی بھی اس ماڈل کو نہیں بتایا کہ وہ ماڈیولو 97 ریاضی کر رہی ہے، یا یہاں تک کہ ماڈیولو کا کیا مطلب ہے — انہوں نے اسے صرف ریاضی کی مثالیں دکھائیں۔ ایسا لگتا ہے کہ ماڈل نے کچھ گہرے، تجزیاتی حل پر ٹھوکر کھائی ہے - ایک ایسی مساوات جو کہ کے تمام مجموعوں کو عام کرتی ہے۔ a اور bیہاں تک کہ تربیت کے اعداد و شمار سے باہر۔ نیٹ ورک گر گیا تھا، اور ٹیسٹ ڈیٹا کی درستگی 100% تک پہنچ گئی۔ "یہ عجیب ہے،" پاور نے اپنے سامعین کو بتایا۔

ٹیم نے مختلف کاموں اور مختلف نیٹ ورکس کا استعمال کرتے ہوئے نتائج کی تصدیق کی۔ دریافت روک دی گئی۔

گھڑیوں اور پیزا کی

لیکن نیٹ ورک کو کیا مساوات ملی تھی؟ اوپن اے آئی پیپر نے کچھ نہیں بتایا، لیکن نتیجہ نے نندا کی توجہ حاصل کی۔ "نیورل نیٹ ورکس کے بارے میں ایک بنیادی راز اور پریشان کن چیزوں میں سے ایک یہ ہے کہ وہ جو کچھ کرتے ہیں اس میں وہ بہت اچھے ہیں، لیکن یہ کہ پہلے سے طے شدہ طور پر، ہمیں یہ نہیں معلوم کہ وہ کیسے کام کرتے ہیں،" نندا نے کہا، جن کا کام ریورس انجینئرنگ پر مرکوز ہے۔ نیٹ ورک یہ معلوم کرنے کے لیے کہ اس نے کون سے الگورتھم سیکھے ہیں۔

نندا اوپن اے آئی کی دریافت سے متوجہ ہوئے، اور انہوں نے ایک ایسے نیورل نیٹ ورک کو الگ کرنے کا فیصلہ کیا جس نے گراوٹ کر رکھی تھی۔ اس نے اوپن اے آئی نیورل نیٹ ورک کا ایک اور بھی آسان ورژن ڈیزائن کیا تاکہ وہ ماڈل کے پیرامیٹرز کا قریب سے جائزہ لے سکے جیسا کہ اس نے ماڈیولر ریاضی کرنا سیکھا۔ اس نے وہی رویہ دیکھا: اوور فٹنگ جس نے عام کرنے کا راستہ دیا اور ٹیسٹ کی درستگی میں اچانک بہتری۔ اس کا نیٹ ورک بھی ایک دائرے میں نمبر ترتیب دے رہا تھا۔ اس میں کچھ کوشش کی گئی، لیکن نندا نے آخر کار اس کی وجہ سمجھی۔

جب یہ ایک دائرے پر نمبروں کی نمائندگی کر رہا تھا، نیٹ ورک محض ہندسوں کو نہیں گن رہا تھا جیسے ایک کنڈرگارٹنر گھڑی دیکھ رہا تھا: یہ کچھ نفیس ریاضیاتی ہیرا پھیری کر رہا تھا۔ نیٹ ورک کے پیرامیٹرز کی اقدار کا مطالعہ کرکے، نندا اور ساتھیوں نے انکشاف کیا۔ کہ یہ گھڑی کے نمبروں کو ان پر "مجرد فوئیر ٹرانسفارمز" انجام دے کر شامل کر رہا تھا - مثلثی افعال جیسے سائنز اور کوزائنز کا استعمال کرتے ہوئے نمبروں کو تبدیل کرنا اور پھر حل تک پہنچنے کے لیے مثلثی شناختوں کا استعمال کرتے ہوئے ان اقدار کو جوڑ رہا ہے۔ کم از کم، یہ وہی تھا جو اس کا خاص نیٹ ورک کر رہا تھا۔

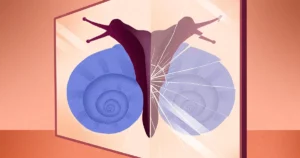

جب MIT میں ایک ٹیم پیچھا کیا نندا کے کام پر، انہوں نے ظاہر کیا کہ گرکنگ نیورل نیٹ ورک ہمیشہ اس "گھڑی" الگورتھم کو دریافت نہیں کرتے ہیں۔ بعض اوقات، نیٹ ورک اس کے بجائے ڈھونڈتے ہیں جسے محققین "پیزا" الگورتھم کہتے ہیں۔ یہ نقطہ نظر ایک پیزا کا تصور کرتا ہے جسے ٹکڑوں میں تقسیم کیا گیا ہے اور ترتیب میں نمبر دیا گیا ہے۔ دو نمبروں کو شامل کرنے کے لیے، تصور کریں کہ پیزا کے مرکز سے زیر سوال نمبروں تک تیر کھینچیں، پھر اس لکیر کا حساب لگائیں جو پہلے دو تیروں سے بننے والے زاویہ کو دو حصوں میں تقسیم کرتی ہے۔ یہ لائن پیزا کے کچھ سلائس کے درمیان سے گزرتی ہے: سلائس کی تعداد دو نمبروں کا مجموعہ ہے۔ ان کارروائیوں کو ٹگنومیٹرک اور الجبری ہیرا پھیری کے لحاظ سے بھی لکھا جا سکتا ہے a اور b، اور وہ نظریاتی طور پر اتنے ہی درست ہیں جتنا کہ گھڑی کا نقطہ نظر۔

تعارف

"دونوں [دی] گھڑی اور پیزا الگورتھم میں یہ سرکلر نمائندگی ہے،" کہا زیمنگ لیو، MIT ٹیم کا ایک رکن۔ لیکن … وہ کس طرح ان سائنز اور کوزائنز کا فائدہ اٹھاتے ہیں مختلف ہیں۔ اسی لیے ہم انہیں مختلف الگورتھم کہتے ہیں۔

اور یہ سب اب بھی نہیں تھا۔ ماڈیولو ریاضی کرنے کے لیے متعدد نیٹ ورکس کو تربیت دینے کے بعد، لیو اور ساتھیوں نے دریافت کیا کہ ان نیٹ ورکس کے ذریعے دریافت کیے گئے تقریباً 40% الگورتھم پیزا یا گھڑی کے الگورتھم کی اقسام ہیں۔ ٹیم یہ سمجھنے میں کامیاب نہیں ہو سکی کہ نیٹ ورک باقی وقت میں کیا کر رہے ہیں۔ لیو نے کہا کہ پیزا اور گھڑی کے الگورتھم کے لیے، "یہ صرف ایسا ہوتا ہے کہ اسے کچھ ایسا مل جاتا ہے جس کی ہم انسان تشریح کر سکتے ہیں۔"

اور جو بھی الگورتھم ایک نیٹ ورک سیکھتا ہے جب وہ کسی مسئلے کو حل کرتا ہے، یہ عام کرنے میں اس سے بھی زیادہ طاقتور ہوتا ہے جتنا کہ محققین کو شبہ ہے۔ جب میری لینڈ یونیورسٹی میں ایک ٹیم ایک سادہ عصبی نیٹ ورک کھلایا بے ترتیب غلطیوں کے ساتھ تربیتی ڈیٹا، نیٹ ورک نے پہلے توقع کے مطابق برتاؤ کیا: تربیتی ڈیٹا، غلطیوں اور سبھی کو اوور فٹ کریں، اور غیر کرپٹ ٹیسٹ ڈیٹا پر خراب کارکردگی کا مظاہرہ کریں۔ تاہم، ایک بار جب نیٹ ورک گھمبیر ہو جاتا ہے اور ٹیسٹ کے سوالات کے صحیح جواب دینا شروع کر دیتا ہے، تو یہ غلط اندراجات کے لیے بھی صحیح جوابات دے سکتا ہے، یاد رکھے ہوئے غلط جوابات کو بھول کر اور یہاں تک کہ اس کے تربیتی ڈیٹا کو عام کر سکتا ہے۔ "گروکنگ کا کام دراصل اس قسم کی بدعنوانی کے لیے کافی مضبوط ہے،" کہا درشل دوشی، کاغذ کے مصنفین میں سے ایک۔

کنٹرول کے لیے جنگ

نتیجے کے طور پر، محققین اب اس عمل کو سمجھنا شروع کر رہے ہیں جو ایک نیٹ ورک کو اپنے ڈیٹا کو گرانے تک لے جاتا ہے۔ نندا گروکنگ کی ظاہری ظاہری اچانک کو یادداشت سے جنرلائزیشن کی طرف بتدریج داخلی منتقلی کے نتیجے کے طور پر دیکھتی ہے، جو نیورل نیٹ ورک کے اندر دو مختلف الگورتھم استعمال کرتی ہے۔ جب کوئی نیٹ ورک سیکھنا شروع کرتا ہے، تو اس نے کہا، یہ سب سے پہلے یاد کرنے کے آسان الگورتھم کا پتہ لگاتا ہے۔ تاہم، اگرچہ الگورتھم آسان ہے، اس کے لیے کافی وسائل کی ضرورت ہوتی ہے، کیونکہ نیٹ ورک کو تربیتی ڈیٹا کی ہر مثال کو یاد کرنے کی ضرورت ہوتی ہے۔ لیکن یہاں تک کہ جب یہ حفظ کر رہا ہے، اعصابی نیٹ ورک کے کچھ حصے سرکٹس بنانا شروع کر دیتے ہیں جو عمومی حل کو نافذ کرتے ہیں۔ دو الگورتھم ٹریننگ کے دوران وسائل کے لیے مقابلہ کرتے ہیں، لیکن اگر نیٹ ورک کو ریگولرائزیشن نامی ایک اضافی جزو کے ساتھ تربیت دی جاتی ہے تو بالآخر جنرلائزیشن جیت جاتی ہے۔

"ریگولرائزیشن آہستہ آہستہ حل کو عام کرنے کے حل کی طرف لے جاتی ہے،" لیو نے کہا۔ یہ ایک ایسا عمل ہے جو ماڈل کی فنکشنل صلاحیت کو کم کرتا ہے — فنکشن کی پیچیدگی جسے ماڈل سیکھ سکتا ہے۔ جیسا کہ ریگولرائزیشن ماڈل کی پیچیدگی کو کم کرتی ہے، عام کرنے والا الگورتھم، جو کہ کم پیچیدہ ہے، آخر کار فتح حاصل کرتا ہے۔ "عمومی کارکردگی اسی [سطح کی] کارکردگی کے لیے آسان ہے،" نندا نے کہا۔ آخر میں، نیورل نیٹ ورک حفظ کرنے والے الگورتھم کو ضائع کر دیتا ہے۔

لہذا، جب کہ عام کرنے میں تاخیر کی صلاحیت اچانک ابھرتی نظر آتی ہے، اندرونی طور پر نیٹ ورک کے پیرامیٹرز مستقل طور پر عام کرنے والے الگورتھم کو سیکھ رہے ہیں۔ یہ صرف اس صورت میں ہے جب نیٹ ورک نے دونوں کو عام کرنے کا الگورتھم سیکھ لیا ہو اور یاد رکھنے والے الگورتھم کو مکمل طور پر ہٹا دیا ہو جس سے آپ کو گڑبڑ ہو جاتی ہے۔ "یہ ممکن ہے کہ ایسی چیزیں جو اچانک لگتی ہوں وہ سطح کے نیچے بتدریج ہو،" نندا نے کہا - ایک مسئلہ جو اس میں بھی سامنے آیا ہے۔ دوسری مشین لرننگ ریسرچ.

ان کامیابیوں کے باوجود، یہ یاد رکھنا ضروری ہے کہ گروکنگ ریسرچ ابھی بھی ابتدائی دور میں ہے۔ اب تک، محققین نے صرف انتہائی چھوٹے نیٹ ورکس کا مطالعہ کیا ہے، اور یہ واضح نہیں ہے کہ آیا یہ نتائج بڑے، زیادہ طاقتور نیٹ ورکس کے ساتھ ہوں گے۔ بیلکن نے یہ بھی خبردار کیا ہے کہ ماڈیولر ریاضی آج کے عصبی نیٹ ورکس کے ذریعہ کئے جانے والے تمام مختلف کاموں کے مقابلے میں "سمندر میں ایک قطرہ" ہے۔ اس طرح کی ریاضی کے لیے ایک نیورل نیٹ ورک کے حل کو ریورس انجینئرنگ کرنا ان عمومی اصولوں کو سمجھنے کے لیے کافی نہیں ہو سکتا جو ان نیٹ ورکس کو عام کرنے کی طرف لے جاتے ہیں۔ بیلکن نے کہا کہ درختوں کا مطالعہ کرنا بہت اچھا ہے۔ "لیکن ہمیں جنگل کا بھی مطالعہ کرنا ہے۔"

بہر حال، ان نیٹ ورکس کے اندر جھانکنے اور انہیں تجزیاتی طور پر سمجھنے کی صلاحیت کے بہت بڑے مضمرات ہیں۔ ہم میں سے اکثر کے لیے، فوئیر کی تبدیلیاں اور دائروں کو دو طرفہ کرنے والے آرکس ماڈیولو میں اضافہ کرنے کا ایک بہت ہی عجیب طریقہ ہے — انسانی نیوران صرف ایسا نہیں سوچتے۔ "لیکن اگر آپ لکیری الجبرا سے بنائے گئے ہیں، تو درحقیقت اس طرح کرنا بہت معنی رکھتا ہے،" نندا نے کہا۔

"یہ عجیب [مصنوعی] دماغ ہمارے اپنے سے مختلف طریقے سے کام کرتے ہیں،" انہوں نے کہا۔ "[ان کے] اپنے اصول اور ڈھانچہ ہیں۔ ہمیں یہ سوچنا سیکھنا ہوگا کہ نیورل نیٹ ورک کیسے سوچتا ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://www.quantamagazine.org/how-do-machines-grok-data-20240412/

- : ہے

- : ہے

- : نہیں

- ][p

- $UP

- 1

- 11

- 12

- 2022

- 2D

- 97

- a

- صلاحیتوں

- کی صلاحیت

- قابلیت

- ہمارے بارے میں

- تک رسائی حاصل

- درستگی

- درست

- اصل

- اصل میں

- شامل کریں

- انہوں نے مزید کہا

- اس کے علاوہ

- ایڈیشنل

- کے بعد

- پہلے

- یلگورتم

- یلگوردمز

- تمام

- کی اجازت

- بھی

- ہمیشہ

- an

- تجزیاتی

- اور

- زاویہ

- جواب

- جواب

- کوئی بھی

- علاوہ

- واضح

- نقطہ نظر

- فن تعمیر

- کیا

- مصنوعی

- AS

- پہلوؤں

- At

- توجہ

- سامعین

- مصنف

- مصنفین

- خودکار

- واپس

- بنیادی طور پر

- BE

- خوبصورت

- بن گیا

- بن

- ہو جاتا ہے

- رہا

- شروع ہوا

- شروع

- شروع ہوتا ہے

- شروع

- رویے

- پیچھے

- کیا جا رہا ہے

- BEST

- بہتر

- کے درمیان

- سے پرے

- بڑا

- دونوں

- کامیابیاں

- تعمیر

- تعمیر

- لیکن

- by

- حساب

- کیلی فورنیا

- فون

- کہا جاتا ہے

- آیا

- کر سکتے ہیں

- اہلیت

- کیس

- پکڑے

- احتیاطی تدابیر

- سینٹر

- کچھ

- چیٹ جی پی ٹی

- سرکل

- حلقوں

- سرکلر

- واضح

- واضح

- چڑھنا

- گھڑی

- گھڑیوں

- کلوز

- قریب سے

- سنبھالا

- ساتھیوں

- کے مجموعے

- کس طرح

- کمپنی کے

- مقابلے میں

- مقابلہ

- مکمل طور پر

- پیچیدہ

- پیچیدگی

- پر مشتمل

- حساب

- کانفرنس

- کنکشن

- کافی

- مسلسل

- جاری رہی

- کور

- درست

- صحیح طریقے سے

- سکتا ہے

- گنتی

- اعداد و شمار

- دن

- فیصلہ کیا

- فیصلہ کرنا

- گہری

- گہری سیکھنے

- گہرے

- Deepmind

- پہلے سے طے شدہ

- تاخیر

- ڈیزائن

- مطلوبہ

- ترقی

- ترقی یافتہ

- مسلط

- ڈیاگو

- مختلف

- مختلف

- ہندسے

- دریافت

- دریافت

- دریافت

- تضاد

- تقسیم

- do

- کر

- کیا

- نہیں

- نیچے

- ڈرائنگ

- ڈرائیو

- چھوڑ

- کے دوران

- ہر ایک

- آسان

- کوشش

- ابھر کر سامنے آئے

- انجینئرز

- کافی

- داخل ہوا

- مساوی

- نقائص

- بھی

- آخر میں

- کبھی نہیں

- جانچ پڑتال

- مثال کے طور پر

- مثال کے طور پر

- دلچسپ

- توقع

- ایکسپلور

- انتہائی

- چہرہ

- نیچےگرانا

- دور

- چند

- اعداد و شمار

- سمجھا

- اعداد و شمار

- آخر

- مل

- نتائج

- پتہ ہے

- پہلا

- توجہ مرکوز

- کے لئے

- جنگل

- تشکیل

- ملا

- فرانسسکو

- سے

- تقریب

- فنکشنل

- افعال

- دی

- جنرل

- عمومی

- حاصل

- GitHub کے

- دی

- جا

- اچھا

- گوگل

- ملا

- بتدریج

- عظیم

- تھا

- ہوتا ہے

- ہے

- he

- Held

- اس کی

- ان

- پکڑو

- کس طرح

- تاہم

- HTML

- HTTP

- HTTPS

- بھاری

- انسانی

- انسان

- i

- خیال

- شناخت

- if

- تصور

- تصورات

- پر عملدرآمد

- اثرات

- اہم

- ناممکن

- بہتری

- in

- غلط

- معلومات

- اندرونی

- ان پٹ

- کے اندر

- بصیرت

- مثال کے طور پر

- کے بجائے

- انسٹی ٹیوٹ

- اندرونی

- اندرونی طور پر

- تشریح

- میں

- مسئلہ

- IT

- میں

- جنوری

- ایوب

- صرف

- رہتا ہے

- قسم

- جانا جاتا ہے

- زبان

- بڑے

- رہنما

- لیڈز

- جانیں

- سیکھا ہے

- سیکھنے

- سیکھتا ہے

- کم سے کم

- لینس

- کم

- سطح

- لیوریج

- کی طرح

- لمیٹڈ

- لائن

- لکیری

- لندن

- اب

- دیکھو

- تلاش

- بند

- بہت

- لاٹوں

- مشین

- مشین لرننگ

- مشینیں

- میگزین

- بناتا ہے

- جوڑ توڑ

- ہراساں کرنا

- میری لینڈ

- میسا چوسٹس

- ماشسٹس انسٹیٹیوٹ آف ٹیکنالوجی

- ریاضی

- ریاضیاتی

- مطلب

- مراد

- رکن

- مشرق

- شاید

- ایم ائی ٹی

- ماڈل

- ماڈل

- ماڈیولر

- زیادہ

- سب سے زیادہ

- بہت

- نامزد

- قریب

- ضرورت ہے

- ضروریات

- نیٹ ورک

- نیٹ ورک

- عصبی

- عصبی نیٹ ورک

- نیند نیٹ ورک

- نیورسن

- کبھی نہیں

- نئی

- نہیں

- اب

- تعداد

- نمبر

- تعداد

- متعدد

- of

- بند

- اکثر

- on

- ایک بار

- ایک

- صرف

- اوپنائی

- آپریشنز

- or

- حکم

- دیگر

- ہمارے

- باہر

- نتائج

- پیداوار

- خود

- کاغذ.

- کاغذات

- پیرامیٹرز

- حصہ

- خاص طور پر

- حصے

- گزرتا ہے

- ساتھی

- انجام دیں

- کارکردگی

- کارکردگی کا مظاہرہ

- رجحان

- لینے

- پزا

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پوائنٹ

- ممکن

- طاقت

- طاقتور

- پیشن گوئی

- اصولوں پر

- مسئلہ

- مسائل

- عمل

- پیدا

- متوقع

- خصوصیات

- فراہم

- کوانٹا میگزین

- سوال

- سوالات

- بہت

- بے ترتیب

- احساس ہوا

- حال ہی میں

- حال ہی میں

- کم

- حکومت

- رہے

- یاد

- ہٹا دیا گیا

- نقل تیار

- نمائندگی

- نمائندگی

- کی نمائندگی کرتا ہے

- کی ضرورت ہے

- تحقیق

- محققین

- وسائل

- باقی

- نتیجہ

- نتائج کی نمائش

- انکشاف

- انکشاف

- انقلاب آگیا

- اضافہ

- ROBERT

- مضبوط

- تقریبا

- قوانین

- کہا

- اسی

- سان

- سان ڈیاگو

- سان فرانسسکو

- دیکھا

- کا کہنا ہے کہ

- دیکھنا

- لگتا ہے

- لگ رہا تھا

- لگتا ہے

- دیکھا

- دیکھتا

- احساس

- ستمبر

- مقرر

- سیٹ اپ

- شاٹ

- سے ظاہر ہوا

- سادہ

- سادہ

- صرف

- سلائس

- آہستہ آہستہ

- چھوٹے

- So

- اب تک

- حل

- حل کرنا۔

- کچھ

- کچھ

- کبھی کبھی

- جلد ہی

- بہتر

- خلا

- شروع کریں

- شروع ہوتا ہے

- مسلسل

- ابھی تک

- بند کرو

- ساخت

- تعلیم حاصل کی

- مطالعہ

- مطالعہ

- مطالعہ

- اس طرح

- اچانک

- سطح

- سسٹمز

- ٹاسک

- کاموں

- ٹیم

- ٹیکنالوجی

- کیا کرتے ہیں

- رجحان

- اصطلاح

- شرائط

- ٹیسٹ

- تجربہ

- ٹیسٹنگ

- سے

- کہ

- ۔

- لکیر

- ان

- ان

- خود

- تو

- نظریاتی

- یہ

- وہ

- چیزیں

- لگتا ہے کہ

- سوچتا ہے

- اس

- اچھی طرح سے

- اگرچہ؟

- سوچا

- کے ذریعے

- وقت

- اوقات

- کرنے کے لئے

- آج کا

- بتایا

- لیا

- کی طرف

- ٹرین

- تربیت یافتہ

- ٹریننگ

- ٹرینوں

- تبدیل

- ٹرانسفارمر

- تبدیل

- تبادلوں

- منتقلی

- درخت

- فتوحات

- دو

- عام طور پر

- کے تحت

- سمجھ

- افہام و تفہیم

- غیر متوقع

- منفرد

- یونٹس

- یونیورسٹی

- یونیورسٹی آف کیلی فورنیا

- صلی اللہ علیہ وسلم

- us

- استعمال کی شرائط

- استعمال کیا جاتا ہے

- کا استعمال کرتے ہوئے

- ہمیشہ کی طرح

- چھٹی

- اقدار

- تصدیق

- ورژن

- بہت

- تھا

- دیکھ

- راستہ..

- طریقوں

- we

- ویبپی

- چلا گیا

- تھے

- کیا

- جو کچھ بھی

- جب

- جس

- جبکہ

- ڈبلیو

- کس کی

- کیوں

- گے

- جیت

- حکمت

- ساتھ

- کام

- کام

- لکھا

- غلط

- سال

- تم

- زیفیرنیٹ

- صفر