At AWS re: Invent 2023 annoncerede vi den generelle tilgængelighed af Vidensbaser for Amazon Bedrock. Med Knowledge Bases for Amazon Bedrock kan du sikkert forbinde fundamentmodeller (FM'er) ind Amazonas grundfjeld til din virksomheds data for fuldt administreret Retrieval Augmented Generation (RAG).

I tidligere indlæg dækkede vi nye funktioner som hybrid søgeunderstøttelse, metadatafiltrering for at forbedre genfindingsnøjagtigheden, og hvor Knowledge Bases for Amazon Bedrock styrer end-to-end RAG-arbejdsgangen.

I dag introducerer vi den nye mulighed for at chatte med dit dokument uden opsætning i Knowledge Bases for Amazon Bedrock. Med denne nye funktion kan du sikkert stille spørgsmål til enkelte dokumenter, uden at det skal betale sig at oprette en vektordatabase eller indlæse data, hvilket gør det nemt for virksomheder at bruge deres virksomhedsdata. Du behøver kun at angive en relevant datafil som input og vælge din FM for at komme i gang.

Men før vi hopper ind i detaljerne i denne funktion, lad os starte med det grundlæggende og forstå, hvad RAG er, dets fordele, og hvordan denne nye funktion muliggør genfinding og generering af indhold til tidsmæssige behov.

Hvad er Retrieval Augmented Generation?

FM-drevne kunstig intelligens (AI) assistenter har begrænsninger, såsom at give forældede oplysninger eller kæmpe med kontekst uden for deres træningsdata. RAG løser disse problemer ved at tillade FM'er at krydshenvise autoritative videnkilder, før de genererer svar.

Med RAG, når en bruger stiller et spørgsmål, henter systemet relevant kontekst fra en kureret videnbase, såsom virksomhedsdokumentation. Det giver denne kontekst til FM, som bruger den til at generere et mere informeret og præcist svar. RAG hjælper med at overvinde FM-begrænsninger ved at udvide dens muligheder med en organisations proprietære viden, hvilket gør det muligt for chatbots og AI-assistenter at levere opdaterede, kontekstspecifikke informationer skræddersyet til forretningsbehov uden at omskole hele FM. Hos AWS anerkender vi RAG's potentiale og har arbejdet på at forenkle implementeringen af det gennem Knowledge Bases for Amazon Bedrock, hvilket giver en fuldt administreret RAG-oplevelse.

Kortsigtede og øjeblikkelige informationsbehov

Selvom en videnbase gør alt det tunge løft og fungerer som et vedvarende stort lager af virksomhedsviden, kan du kræve midlertidig adgang til data til specifikke opgaver eller analyser inden for isolerede brugersessioner. Traditionelle RAG-tilgange er ikke optimeret til disse kortsigtede, sessionsbaserede dataadgangsscenarier.

Virksomheder pådrager sig gebyrer for datalagring og administration. Dette kan gøre RAG mindre omkostningseffektiv for organisationer med meget dynamiske eller flygtige informationskrav, især når data kun er nødvendige til specifikke, isolerede opgaver eller analyser.

Stil spørgsmål om et enkelt dokument uden opsætning

Denne nye mulighed for at chatte med dit dokument i Knowledge Bases for Amazon Bedrock løser de førnævnte udfordringer. Det giver en nul-opsætningsmetode til at bruge dit enkelt dokument til indholdshentning og generationsrelaterede opgaver sammen med FM'erne leveret af Amazon Bedrock. Med denne nye funktion kan du stille spørgsmål til dine data uden at skulle opsætte en vektordatabase eller indlæse data, hvilket gør det nemt at bruge dine virksomhedsdata.

Du kan nu interagere med dine dokumenter i realtid uden forudgående dataindtagelse eller databasekonfiguration. Du behøver ikke tage yderligere databeredskabstrin, før du forespørger dataene.

Denne nul-opsætningstilgang gør det ligetil at bruge dine virksomhedsinformationsaktiver med generativ AI ved hjælp af Amazon Bedrock.

Brug cases og fordele

Overvej et rekrutteringsfirma, der skal analysere CV'er og matche kandidater med passende jobmuligheder baseret på deres erfaring og færdigheder. Tidligere skulle du oprette en vidensbase, der påberåber dig en arbejdsgang for dataindtagelse for at sikre, at kun autoriserede rekrutterere kan få adgang til dataene. Derudover skal du administrere oprydning, når dataene ikke længere var nødvendige for en session eller kandidat. I sidste ende ville du betale mere for vektordatabaselagring og -styring end for den faktiske FM-brug. Denne nye funktion i Knowledge Bases for Amazon Bedrock gør det muligt for rekrutterere hurtigt og flygtigt at analysere CV'er og matche kandidater med passende jobmuligheder baseret på kandidatens erfaring og færdigheder.

For et andet eksempel kan du overveje en produktchef hos en teknologivirksomhed, som hurtigt skal analysere kundefeedback og supportbilletter for at identificere almindelige problemer og forbedringsområder. Med denne nye funktion kan du blot uploade et dokument for at udtrække indsigt på ingen tid. For eksempel kan du spørge "Hvad er kravene til mobilappen?" eller "Hvad er de almindelige smertepunkter, som kunderne nævner i forbindelse med vores onboarding-proces?" Denne funktion giver dig mulighed for hurtigt at syntetisere denne information uden besværet med dataforberedelse eller administrationsomkostninger. Du kan også anmode om resuméer eller vigtige takeaways, såsom "Hvad er højdepunkterne fra dette kravdokument?"

Fordelene ved denne funktion rækker ud over omkostningsbesparelser og driftseffektivitet. Ved at eliminere behovet for vektordatabaser og dataindtagelse hjælper denne nye funktion i Knowledge Bases for Amazon Bedrock med at sikre dine proprietære data, hvilket gør dem kun tilgængelige i sammenhæng med isolerede brugersessioner.

Nu hvor vi har dækket funktionsfordelene og de use cases, det muliggør, lad os dykke ned i, hvordan du kan begynde at bruge denne nye funktion fra Knowledge Bases for Amazon Bedrock.

Chat med dit dokument i Knowledge Bases for Amazon Bedrock

Du har flere muligheder for at begynde at bruge denne funktion:

- Amazon Bedrock-konsollen

- Amazonas grundfjeld

RetrieveAndGenerateAPI (SDK)

Lad os se, hvordan vi kan komme i gang med at bruge Amazon Bedrock-konsollen:

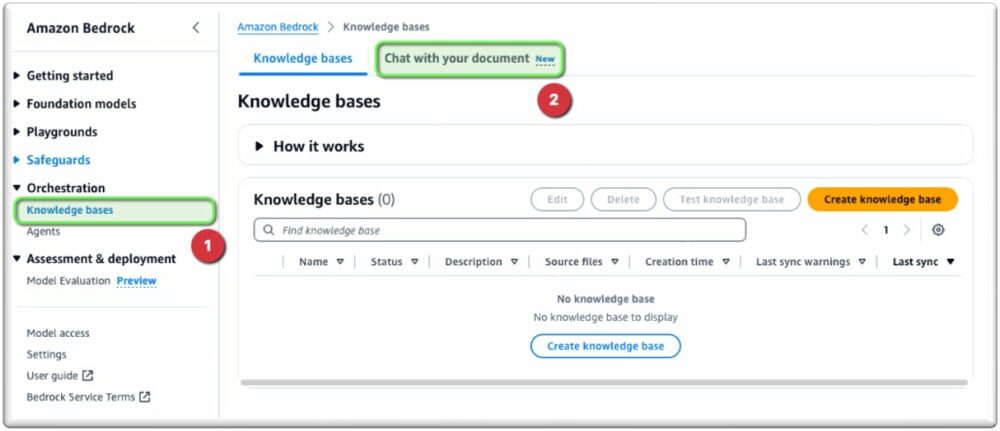

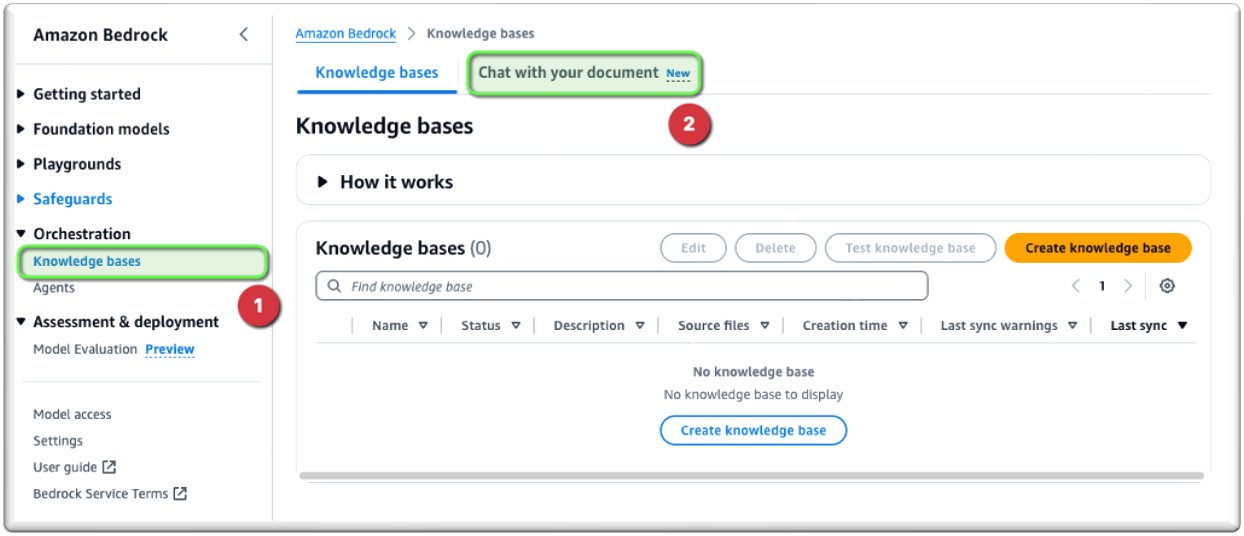

- På Amazon Bedrock-konsollen, under Orchestration i navigationsruden skal du vælge Vidensgrundlag.

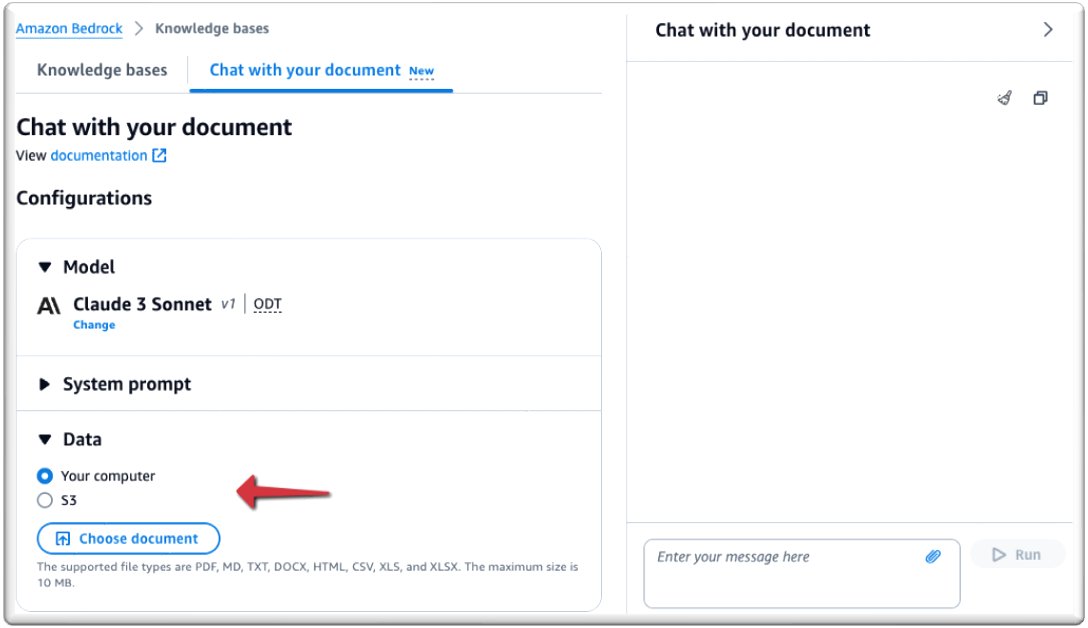

- Vælg Chat med dit dokument.

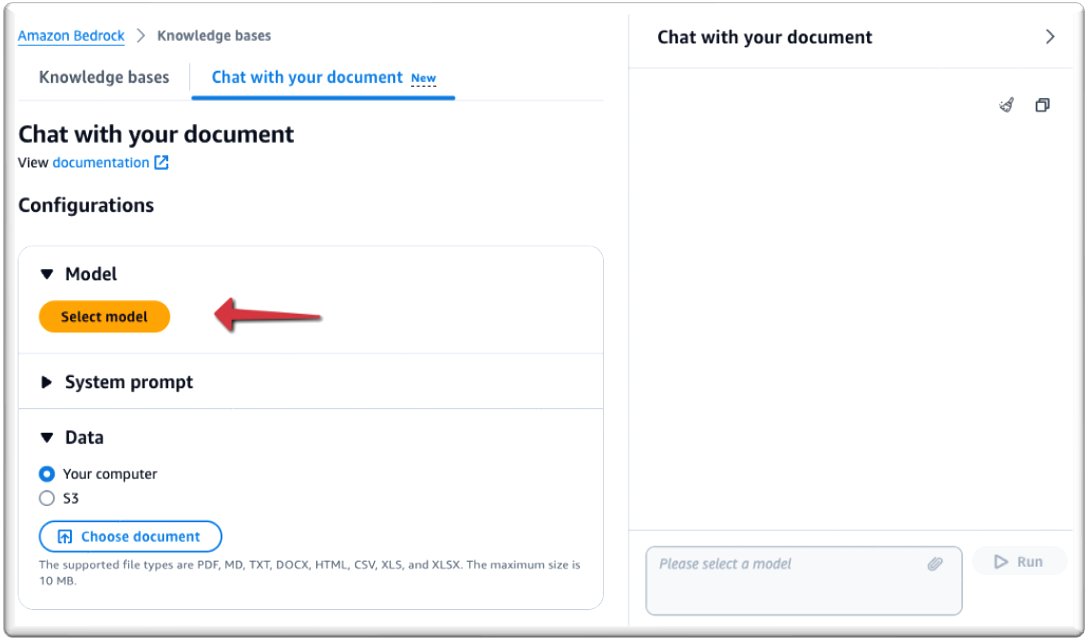

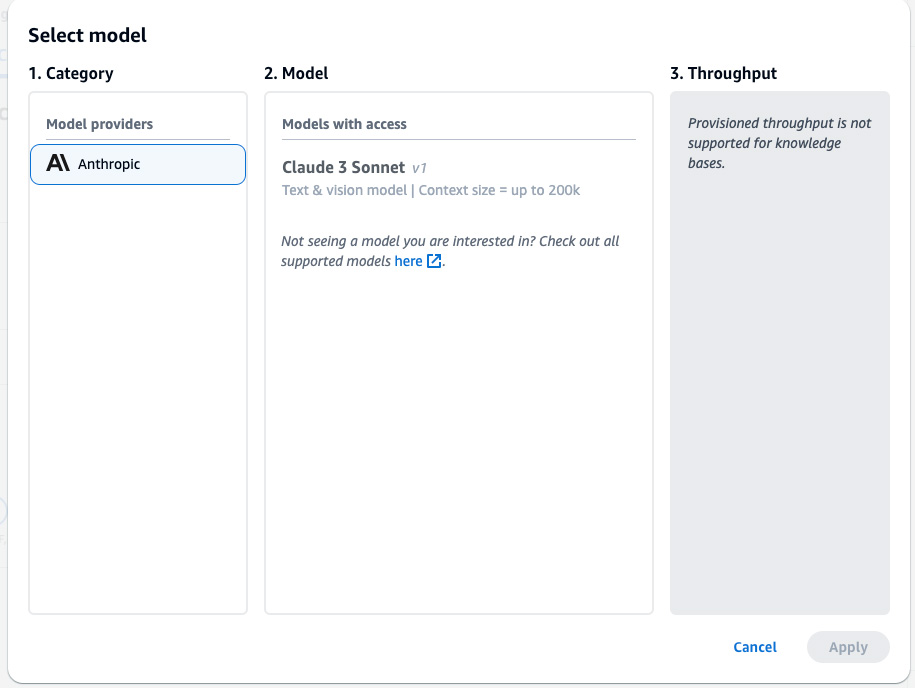

- Under Model, vælg Vælg model.

- Vælg din model. Til dette eksempel bruger vi Claude 3 Sonnet-modellen (vi understøtter kun Sonnet på tidspunktet for lanceringen).

- Vælg Indløs.

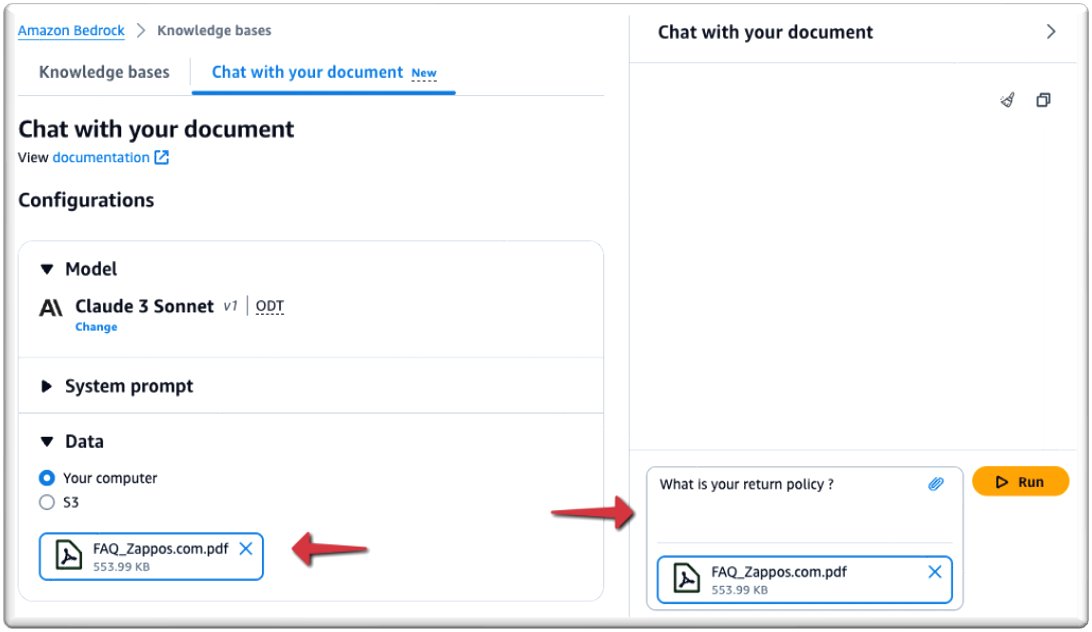

- Under data, kan du uploade det dokument, du vil chatte med, eller pege på Amazon Simple Storage Service (Amazon S3) bucket-placering, der indeholder din fil. Til dette indlæg uploader vi et dokument fra vores computer.

De understøttede filformater er PDF, MD (Markdown), TXT, DOCX, HTML, CSV, XLS og XLSX. Sørg for, at filstørrelsen ikke overstiger 10 MB og ikke indeholder mere end 20,000 tokens. EN token anses for at være en tekstenhed, såsom et ord, underord, tal eller symbol, der behandles som en enkelt enhed. På grund af den forudindstillede grænse for indtagelsestoken anbefales det at bruge en fil under 10 MB. En teksttung fil, der er meget mindre end 10 MB, kan dog potentielt overtræde token-grænsen.

Du er nu klar til at chatte med dit dokument.

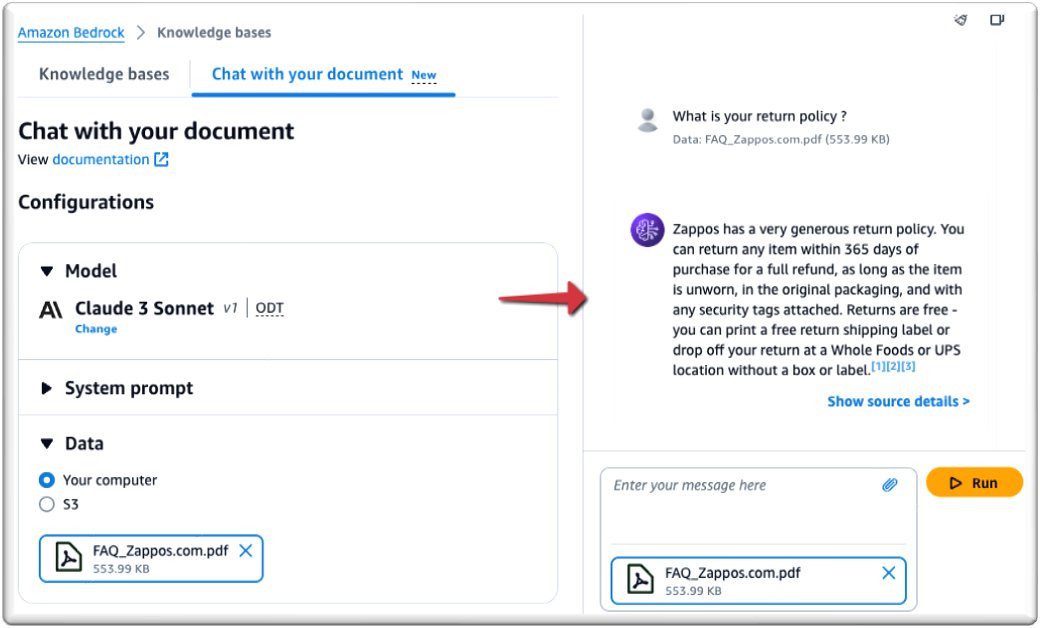

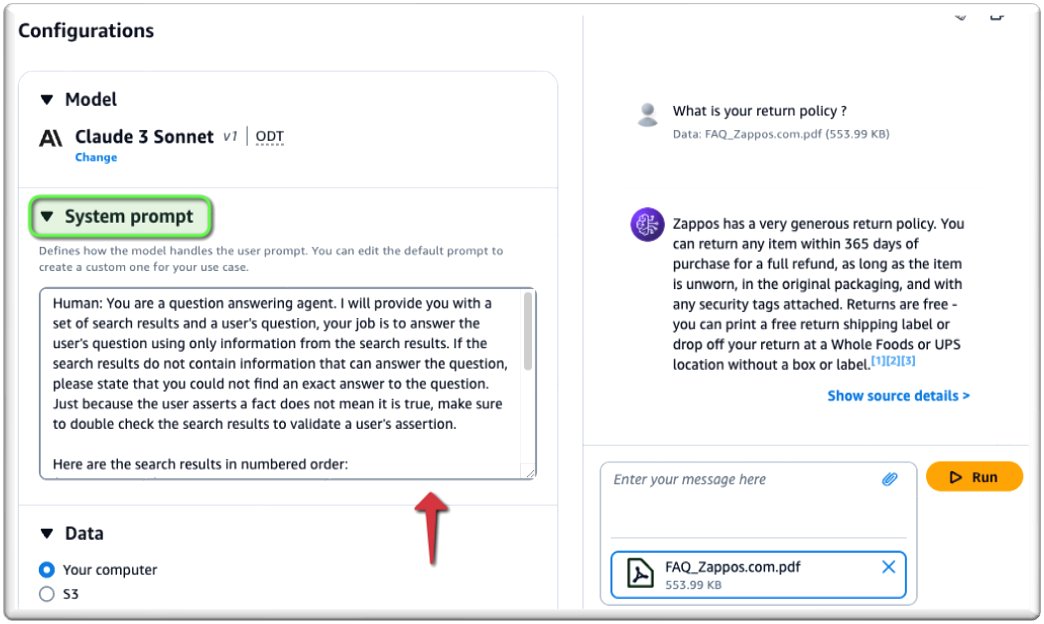

Som vist på det følgende skærmbillede kan du chatte med dit dokument i realtid.

For at tilpasse din prompt skal du indtaste din prompt under Systemkrav prompt.

På samme måde kan du bruge AWS SDK gennem retrieve_and_generate API på de vigtigste kodningssprog. I det følgende eksempel bruger vi AWS SDK til Python (Boto3):

Konklusion

I dette indlæg dækkede vi, hvordan Knowledge Bases for Amazon Bedrock nu forenkler at stille spørgsmål til et enkelt dokument. Vi udforskede kernekoncepterne bag RAG, de udfordringer, denne nye funktion adresserer, og de forskellige use cases, den muliggør på tværs af forskellige roller og brancher. Vi demonstrerede også, hvordan man konfigurerer og bruger denne funktion gennem Amazon Bedrock-konsollen og AWS SDK, hvilket viser enkelheden og fleksibiliteten af denne funktion, som giver en nul-setup-løsning til at indsamle information fra et enkelt dokument uden at oprette en vektordatabase. .

For yderligere at udforske mulighederne for vidensbaser til Amazon Bedrock, se følgende ressourcer:

Del og lær med vores generative AI-fællesskab på community.aws.

Om forfatterne

Suman Debnath er en Principal Developer Advocate for Machine Learning hos Amazon Web Services. Han taler ofte ved AI/ML-konferencer, events og møder rundt om i verden. Han er passioneret omkring distribuerede systemer i stor skala og er en ivrig fan af Python.

Sebastian Munera er softwareingeniør i Amazon Bedrock Knowledge Bases-teamet hos AWS, hvor han fokuserer på at bygge kundeløsninger, der udnytter Generative AI- og RAG-applikationer. Han har tidligere arbejdet på at bygge Generative AI-baserede løsninger til kunder for at strømline deres processer og Low code/No code-applikationer. I sin fritid nyder han at løbe, løfte og pille ved teknologi.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/knowledge-bases-in-amazon-bedrock-now-simplifies-asking-questions-on-a-single-document/

- :har

- :er

- :ikke

- :hvor

- $OP

- 000

- 10

- 100

- 1040

- 20

- 2023

- 27

- 628

- 7

- 97

- a

- Om

- adgang

- Adgang til data

- tilgængelig

- tværs

- faktiske

- Derudover

- adresser

- Vedtagelse

- fortaler

- AI

- AI / ML

- Alle

- tillade

- sammen

- også

- Amazon

- Amazon Web Services

- an

- Analyser

- analyse

- analysere

- ,

- annoncerede

- En anden

- enhver

- api

- app

- applikationer

- tilgang

- tilgange

- ER

- områder

- omkring

- kunstig

- kunstig intelligens

- Kunstig intelligens (AI)

- AS

- spørg

- spørge

- Aktiver

- assistenter

- At

- augmented

- autoriseret

- tilgængelighed

- AWS

- bund

- baseret

- Grundlæggende

- BE

- før

- begynde

- bag

- fordele

- Beyond

- brud

- Bygning

- virksomhed

- virksomheder

- by

- CAN

- Kan få

- kandidat

- kandidater

- kapaciteter

- kapacitet

- tilfælde

- udfordringer

- afgifter

- chatte

- chatbots

- Vælg

- kode

- Kodning

- Fælles

- samfund

- selskab

- computer

- begreber

- konferencer

- Konfiguration

- Tilslut

- Overvej

- betragtes

- Konsol

- indeholder

- indhold

- sammenhæng

- Core

- Koste

- omkostningsbesparelser

- omkostningseffektiv

- kunne

- dækket

- kurateret

- kunde

- Kundeløsninger

- Kunder

- tilpasse

- data

- dataadgang

- Dataforberedelse

- data opbevaring

- Database

- databaser

- demonstreret

- detaljer

- Udvikler

- forskellige

- distribueret

- distribuerede systemer

- dyk

- dokumentet

- dokumentation

- dokumenter

- gør

- Dont

- grund

- dynamisk

- effektivitet

- nemt

- eliminere

- andet

- bemyndiger

- muliggør

- muliggør

- ende

- ende til ende

- ingeniør

- Indtast

- Enterprise

- Hele

- enhed

- især

- begivenheder

- eksempel

- overstige

- erfaring

- udforske

- udforsket

- udvide

- ekstrakt

- ventilator

- Feature

- tilbagemeldinger

- File (Felt)

- filtrering

- Firm

- Fleksibilitet

- fokuserer

- efter

- Til

- Foundation

- hyppigt

- fra

- fuldt ud

- yderligere

- samle

- Generelt

- generere

- generere

- generation

- generative

- Generativ AI

- få

- Have

- he

- tunge

- tunge løft

- hjælper

- højdepunkter

- stærkt

- hans

- Hvordan

- How To

- Men

- HTML

- http

- HTTPS

- identifikator

- identificere

- if

- Forbedre

- in

- industrier

- oplysninger

- informeret

- indgang

- indsigt

- øjeblikkelig

- Intelligens

- interagere

- ind

- indføre

- isolerede

- spørgsmål

- IT

- ITS

- Job

- jpg

- hoppe

- Nøgle

- viden

- Sprog

- stor

- storstilet

- lancere

- LÆR

- læring

- mindre

- Leverage

- løft

- ligesom

- GRÆNSE

- begrænsninger

- placering

- længere

- Lav

- maskine

- machine learning

- Main

- større

- lave

- maerker

- Making

- administrere

- lykkedes

- ledelse

- leder

- administrerer

- Match

- Kan..

- Meetups

- nævnte

- metode

- måske

- Mobil

- Mobil app

- model

- modeller

- mere

- meget

- flere

- Navigation

- Behov

- behov

- behov

- Ny

- ingen

- nu

- nummer

- of

- on

- onboarding

- kun

- operationelle

- Muligheder

- optimeret

- Indstillinger

- or

- organisationer

- vores

- forældet

- output

- uden for

- Overvind

- overliggende

- Smerte

- brød

- lidenskabelige

- Betal

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- punkter

- Indlæg

- Indlæg

- potentiale

- potentielt

- brug

- forberedelse

- tidligere

- tidligere

- Main

- Forud

- behandle

- Behandlet

- Processer

- Produkt

- produktchef

- proprietære

- give

- forudsat

- giver

- leverer

- Python

- spørgsmål

- Spørgsmål

- hurtigt

- klud

- hurtigt

- RE

- Readiness

- klar

- ægte

- realtid

- genkende

- anbefales

- rekruttering

- henvise

- om

- region

- relevant

- erstatte

- anmode

- kræver

- påkrævet

- Krav

- Ressourcer

- svar

- reaktioner

- hentning

- afkast

- roller

- kører

- Besparelser

- scenarier

- SDK

- Søg

- sikker

- sikkert

- se

- tjener

- Tjenester

- Session

- sessioner

- sæt

- indstilling

- setup

- kort sigt

- fremvisning

- vist

- Simpelt

- enkelhed

- forenkler

- forenkle

- ganske enkelt

- enkelt

- Størrelse

- dygtighed

- færdigheder

- mindre

- Software

- Software Engineer

- løsninger

- Løsninger

- Kilder

- Taler

- specifikke

- starte

- påbegyndt

- Steps

- opbevaring

- butik

- ligetil

- strømline

- Kæmper

- sådan

- egnede

- support

- Understøttet

- Støtte

- sikker

- symbol

- syntetisere

- systemet

- Systemer

- skræddersyet

- Tag

- Takeaways

- opgaver

- hold

- Teknologier

- midlertidig

- tekst

- end

- at

- Grundlæggende

- verdenen

- deres

- Disse

- denne

- Gennem

- billetter

- tid

- til

- token

- Tokens

- emne

- traditionelle

- Kurser

- typen

- under

- forstå

- enhed

- up-to-date

- Brug

- brug

- Bruger

- bruger

- ved brug af

- forskellige

- ønsker

- var

- we

- web

- webservices

- Hvad

- Hvad er

- hvornår

- som

- WHO

- med

- inden for

- uden

- ord

- arbejdede

- workflow

- world

- ville

- Du

- Din

- zephyrnet

- nul