Prompt Engineering ist zu einer unverzichtbaren Fähigkeit für jeden geworden, der mit großen Sprachmodellen (LLMs) arbeitet, um qualitativ hochwertige und relevante Texte zu generieren. Obwohl Text-Prompt-Engineering ausführlich diskutiert wurde, ist Visual-Prompt-Engineering ein aufstrebendes Gebiet, das Aufmerksamkeit erfordert. Visuelle Eingabeaufforderungen können Begrenzungsrahmen oder Masken umfassen, die Sehmodelle bei der Generierung relevanter und genauer Ausgaben unterstützen. In diesem Beitrag untersuchen wir die Grundlagen des Visual Prompt Engineering, seine Vorteile und wie es zur Lösung eines bestimmten Anwendungsfalls eingesetzt werden kann: Bildsegmentierung für autonomes Fahren.

In den letzten Jahren hat der Bereich Computer Vision bedeutende Fortschritte im Bereich der Bildsegmentierung erlebt. Ein solcher Durchbruch ist der Segment-Anything-Modell (SAM) von Meta AI, das das Potenzial hat, die Segmentierung auf Objektebene mit Zero-Shot- oder Fence-Shot-Training zu revolutionieren. In diesem Beitrag verwenden wir das SAM-Modell als Beispiel für ein Foundation-Vision-Modell und untersuchen seine Anwendung auf das BDD100K-Datensatz, ein vielfältiger Datensatz zum autonomen Fahren für heterogenes Multitasking-Lernen. Durch die Kombination der Stärken von SAM mit den umfangreichen Daten von BDD100K zeigen wir das Potenzial des Visual Prompt Engineering mit verschiedenen Versionen von SAM. Inspiriert von der LangChain Als Framework für Sprachmodelle schlagen wir eine visuelle Kette zur Durchführung visueller Eingabeaufforderungen vor, indem wir Objekterkennungsmodelle mit SAM kombinieren.

Obwohl sich dieser Beitrag auf autonomes Fahren konzentriert, sind die besprochenen Konzepte allgemein auf Bereiche anwendbar, die umfangreiche visionsbasierte Anwendungen haben, wie z. B. Gesundheitswesen und Biowissenschaften sowie Medien und Unterhaltung. Beginnen wir damit, etwas mehr darüber zu erfahren, was sich unter der Haube eines grundlegenden Visionsmodells wie SAM verbirgt. Wir verwendeten Amazon SageMaker-Studio auf einer ml.g5.16xlarge-Instanz für diesen Beitrag.

Segment-Anything-Modell (SAM)

Foundation-Modelle sind große Modelle für maschinelles Lernen (ML), die auf großen Datenmengen trainiert werden und für aufgabenspezifische Anwendungsfälle angeregt oder verfeinert werden können. Hier untersuchen wir das Segment Anything Model (SAM), ein grundlegendes Modell für das Sehen, insbesondere für die Bildsegmentierung. Es basiert auf einem riesigen Datensatz von 11 Millionen Bildern und 1.1 Milliarden Masken und ist damit zum Zeitpunkt des Schreibens der größte Segmentierungsdatensatz. Dieser umfangreiche Datensatz deckt ein breites Spektrum an Objekten und Kategorien ab und bietet SAM eine vielfältige und umfangreiche Trainingsdatenquelle.

Das SAM-Modell ist darauf trainiert, Objekte zu verstehen und kann Segmentierungsmasken für jedes Objekt in Bildern oder Videobildern ausgeben. Das Modell ermöglicht die Entwicklung visueller Eingabeaufforderungen, sodass Sie Eingaben wie Text, Punkte, Begrenzungsrahmen oder Masken bereitstellen können, um Beschriftungen zu generieren, ohne das Originalbild zu verändern. SAM ist in drei Größen erhältlich: Basis (ViT-B, 91 Millionen Parameter), groß (ViT-L, 308 Millionen Parameter) und riesig (ViT-H, 636 Millionen Parameter) und deckt unterschiedliche Rechenanforderungen und Anwendungsfälle ab.

Die Hauptmotivation von SAM besteht darin, die Segmentierung auf Objektebene mit minimalen Trainingsbeispielen und Epochen für alle interessierenden Objekte zu verbessern. Die Stärke von SAM liegt in seiner Fähigkeit, sich ohne Vorkenntnisse an neue Bildverteilungen und Aufgaben anzupassen, eine Funktion, die als bekannt ist Zero-Shot-Übertragung. Diese Anpassungsfähigkeit wird durch das Training auf dem umfangreichen SA-1B-Datensatz erreicht, der eine beeindruckende Null-Schuss-Leistung gezeigt hat und viele frühere vollständig überwachte Ergebnisse übertrifft.

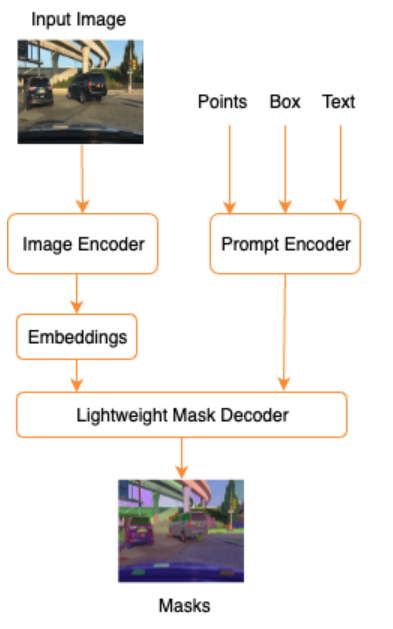

Wie in der folgenden Architektur für SAM dargestellt, umfasst der Prozess der Generierung von Segmentierungsmasken drei Schritte:

- Ein Bildencoder erzeugt eine einmalige Einbettung für das Bild.

- Ein Prompt-Encoder wandelt jeden Prompt in einen Einbettungsvektor für den Prompt um.

- Der Lightweight-Decoder kombiniert die Informationen vom Bild-Encoder und vom Prompt-Encoder, um Segmentierungsmasken vorherzusagen.

Als Beispiel können wir eine Eingabe mit einem Bild und einem Begrenzungsrahmen um ein interessierendes Objekt in diesem Bild (z. B. ein silbernes Auto oder eine Fahrspur) bereitstellen und das SAM-Modell würde Segmentierungsmasken für dieses Objekt erstellen.

Visuelles Prompt-Engineering

Unter Prompt Engineering versteht man die Strukturierung von Eingaben in ein Modell, die dafür sorgen, dass das Modell die Absicht versteht und das gewünschte Ergebnis liefert. Mit Text-Prompt-Engineering können Sie den Eingabetext durch Modifikationen wie Wortwahl, Formatierung, Reihenfolge usw. strukturieren, um die gewünschte Ausgabe zu erhalten. Visual Prompt Engineering geht davon aus, dass der Benutzer in einer visuellen Modalität (Bild oder Video) arbeitet und Eingaben bereitstellt. Im Folgenden finden Sie eine nicht erschöpfende Liste möglicher Möglichkeiten, Eingaben für das generative KI-Modell im visuellen Bereich bereitzustellen:

- Punkt – Ein einzelner (x, y) Koordinatenpunkt in der Bildebene

- Punkte – Mehrere (x, y) Koordinatenpunkte, die nicht unbedingt miteinander in Beziehung stehen

- Begrenzungsrahmen – Ein Satz von vier Werten (x, y, w, h), die einen rechteckigen Bereich in der Bildebene definieren

- Kontur – Eine Reihe von (x, y)-Koordinatenpunkten in der Bildebene, die eine geschlossene Form bilden

- Maske – Ein Array in der gleichen Größe wie das Bild mit einer Teilmaske des interessierenden Objekts

Lassen Sie uns unter Berücksichtigung der Visual-Prompt-Engineering-Techniken untersuchen, wie diese auf das vorab trainierte SAM-Modell angewendet werden können. Wir haben die Basisversion des vorab trainierten Modells verwendet.

Zero-Shot-Prompt mit dem vorab trainierten SAM-Modell

Lassen Sie uns zunächst den Zero-Shot-Ansatz untersuchen. Das Folgende ist ein Beispielbild aus dem Trainingsdatensatz, der von der Frontkamera eines Fahrzeugs aufgenommen wurde.

Wir können Segmentierungsmasken für alle Objekte aus dem Bild erhalten, ohne dass eine explizite visuelle Aufforderung erforderlich ist Automatische Generierung von Masken mit nur einem Eingabebild. Im folgenden Bild sehen wir, wie Teile des Autos, der Straße, Verkehrszeichen, Nummernschilder, Überführung, Säulen, Schilder und mehr segmentiert sind.

Diese Ausgabe ist jedoch aus folgenden Gründen nicht sofort nützlich:

- Die Autos werden nicht als Ganzes, sondern in Teile segmentiert. Bei den meisten Wahrnehmungsmodellen ist es uns beispielsweise egal, dass jeder Reifen über separate Ausgabemasken verfügt. Dies gilt auch für die Suche nach anderen bekannten interessanten Objekten wie Straßen, Vegetation, Schildern usw.

- Teile des Bildes, die für nachgelagerte Aufgaben wie befahrbare Bereiche nützlich sind, werden ohne Erklärung aufgeteilt. Andererseits werden ähnliche Instanzen separat identifiziert, und wir könnten daran interessiert sein, ähnliche Objekte zu gruppieren (panoptische vs. Instanzsegmentierung).

Visuelles Prompt-Engineering mit dem vorab trainierten SAM-Modell

Glücklicherweise unterstützt SAM die Bereitstellung von Eingabeaufforderungen und wir können Punkte, Punktarrays und Begrenzungsrahmen als Eingaben verwenden. Mit diesen spezifischen Anweisungen gehen wir davon aus, dass SAM bei der Segmentierung, die sich auf bestimmte Punkte oder Bereiche konzentriert, bessere Ergebnisse erzielt. Dies kann mit der Sprachaufforderungsvorlage verglichen werden"What is a good name for a company that makes {product}?"

wobei die Eingabe zusammen mit dieser Eingabeaufforderungsvorlage vom Benutzer die ist {product}. {product} ist ein Eingabeslot. Bei der visuellen Eingabeaufforderung sind die Begrenzungsrahmen, Punkte oder Masken die Eingabefelder.

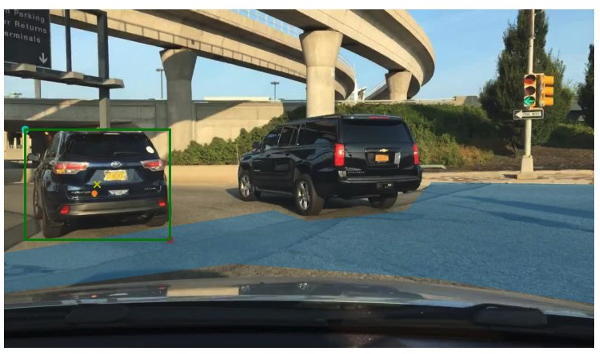

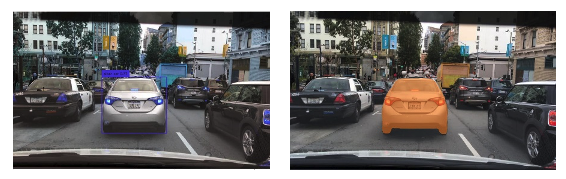

Das folgende Bild zeigt den ursprünglichen Ground-Truth-Begrenzungsrahmen um Fahrzeuge und den befahrbaren Flächenbereich aus BDD100K-Ground-Truth-Daten. Das Bild zeigt außerdem einen Eingabepunkt (ein gelbes X) in der Mitte des grünen Begrenzungsrahmens, auf den wir uns in den nächsten Abschnitten beziehen werden.

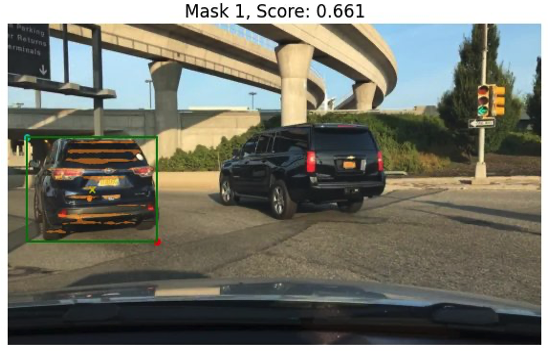

Versuchen wir, eine Maske für das Auto links mit dem grünen Begrenzungsrahmen als Eingabe für SAM zu generieren. Wie das folgende Beispiel zeigt, findet das Basismodell von SAM eigentlich nichts. Dies zeigt sich auch im niedrigen Segmentierungsscore. Wenn wir uns die Segmentierungsmasken genauer ansehen, sehen wir, dass es kleine Bereiche gibt, die als Masken zurückgegeben werden (auf die durch rote Pfeile hingewiesen wird), die für keine nachgelagerte Anwendung wirklich verwendbar sind.

Versuchen wir es mit einer Kombination aus einem Begrenzungsrahmen und einem Punkt als visuelle Eingabeaufforderung. Das gelbe Kreuz im vorherigen Bild ist die Mitte des Begrenzungsrahmens. Wenn wir die (x,y)-Koordinaten dieses Punkts als Eingabeaufforderung zusammen mit der Begrenzungsrahmenbeschränkung angeben, erhalten wir die folgende Maske und eine etwas höhere Punktzahl. Dies ist immer noch keineswegs nutzbar.

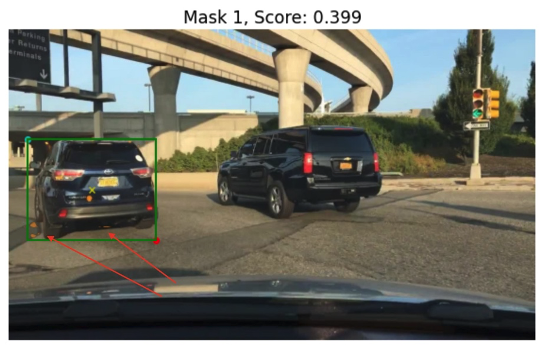

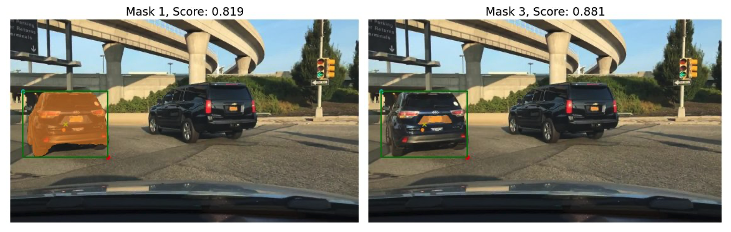

Schließlich können wir mit dem vorab trainierten Basismodell nur den Eingabepunkt als Eingabeaufforderung bereitstellen (ohne den Begrenzungsrahmen). Die folgenden Bilder zeigen zwei der drei besten Masken, die wir für interessant hielten.

Maske 1 segmentiert das gesamte Auto, während Maske 3 einen Bereich segmentiert, der das Nummernschild des Autos in der Nähe des gelben Kreuzes hält (Eingabeaufforderung). Maske 1 ist immer noch keine dichte, saubere Maske rund um das Auto; Dies weist auf die Qualität des Modells hin, von der wir annehmen können, dass sie mit der Modellgröße zunimmt.

Wir können größere vorab trainierte Modelle mit derselben Eingabeaufforderung ausprobieren. Die folgenden Bilder zeigen unsere Ergebnisse. Bei Verwendung des riesigen vorab trainierten SAM-Modells ist Maske 3 das gesamte Auto, während Maske 1 und 2 zum Extrahieren des Nummernschilds verwendet werden können.

Auch die große Version des SAM-Modells bietet ähnliche Leistungen.

Der Prozess, den wir hier durchlaufen haben, ähnelt dem manuellen Eingabeaufforderungs-Engineering für Texteingabeaufforderungen, mit denen Sie möglicherweise bereits vertraut sind. Beachten Sie, dass eine kürzlich erfolgte Verbesserung des SAM-Modells zur Segmentierung aller Elemente in hoher Qualität viel bessere objekt- und kontextspezifische Ausgaben liefert. In unserem Fall stellen wir fest, dass Zero-Shot-Eingabeaufforderungen mit Text- und visuellen Eingabeaufforderungen (Punkt-, Box- und Punkt- und Boxeingaben) die Ergebnisse nicht drastisch verbessern, wie wir oben gesehen haben.

Prompt-Vorlagen und visuelle Ketten

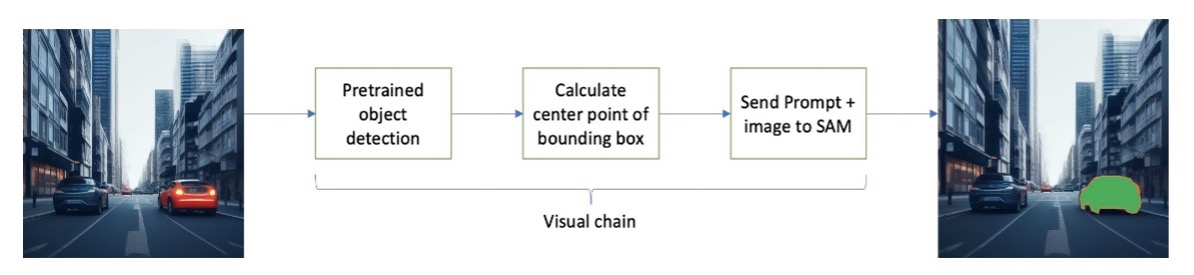

Wie wir anhand der vorangegangenen Zero-Shot-Beispiele sehen können, hat SAM Schwierigkeiten, alle Objekte in der Szene zu identifizieren. Dies ist ein gutes Beispiel dafür, wie wir Eingabeaufforderungsvorlagen und visuelle Ketten nutzen können. Die visuelle Kette ist vom Kettenkonzept im beliebten LangChain-Framework für Sprachanwendungen inspiriert. Es hilft dabei, die Datenquellen und ein LLM zu verketten, um die Ausgabe zu erzeugen. Beispielsweise können wir eine API-Kette verwenden, um eine API aufzurufen und ein LLM aufzurufen, um die Frage basierend auf der API-Antwort zu beantworten.

Inspiriert von LangChain schlagen wir eine sequentielle visuelle Kette vor, die wie in der folgenden Abbildung aussieht. Wir verwenden ein Tool (z. B. ein vorab trainiertes Objekterkennungsmodell), um anfängliche Begrenzungsrahmen zu erhalten, den Punkt in der Mitte des Begrenzungsrahmens zu berechnen und dies zu verwenden, um das SAM-Modell mit dem Eingabebild aufzufordern.

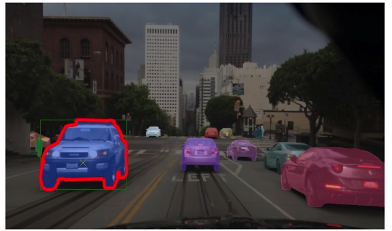

Das folgende Bild zeigt beispielsweise die Segmentierungsmasken als Ergebnis der Ausführung dieser Kette.

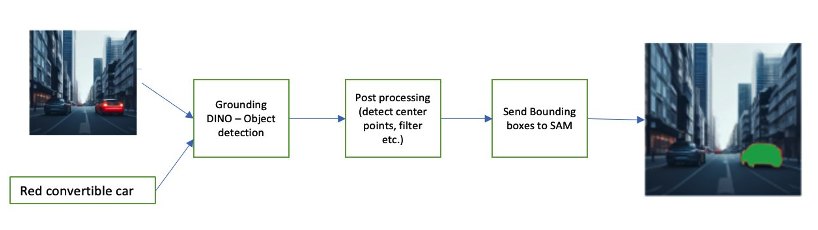

Eine weitere Beispielkette kann eine Texteingabe des Objekts beinhalten, das der Benutzer identifizieren möchte. Um dies umzusetzen, haben wir eine Pipeline mit erstellt Erdung DINO, ein Objekterkennungsmodell, das SAM zur Segmentierung auffordert.

Grounding DINO ist ein Zero-Shot-Objekterkennungsmodell, das eine Objekterkennung mit Text durchführen kann, der Kategorienamen (z. B. „Ampel“ oder „LKW“) und Ausdrücke (z. B. „Gelber LKW“) bereitstellt. Es akzeptiert Text- und Bildpaare, um die Objekterkennung durchzuführen. Es basiert auf einer Transformer-Architektur und ermöglicht Cross-Modalitäten mit Text- und Bilddaten. Weitere Informationen zur Erdung von DINO finden Sie unter Erdung von DINO: Verbindung von DINO mit geerdetem Vortraining für die Erkennung offener Objekte. Dadurch werden Begrenzungsrahmen und Beschriftungen generiert und können weiterverarbeitet werden, um Mittelpunkte zu generieren, auf Beschriftungen basierende Filter, Schwellenwerte und mehr zu erstellen. Dies wird (Boxen oder Punkte) als Eingabeaufforderung an SAM zur Segmentierung verwendet, das Masken ausgibt.

Im Folgenden finden Sie einige Beispiele, die den Eingabetext, die DINO-Ausgabe (Begrenzungsrahmen) und die endgültige SAM-Ausgabe (Segmentierungsmasken) zeigen.

Die folgenden Bilder zeigen die Ausgabe für „Gelber LKW“.

Die folgenden Bilder zeigen die Ausgabe für „Silberauto“.

Das folgende Bild zeigt die Ausgabe für „Fahrspur“.

Mit dieser Pipeline können wir eine visuelle Kette aufbauen. Der folgende Codeausschnitt erklärt dieses Konzept:

pipeline = [object_predictor, segment_predictor]

image_chain = ImageChain.from_visual_pipeline(pipeline, image_store, verbose=True)

image_chain.run('All silver cars', image_id='5X3349')Obwohl dies ein einfaches Beispiel ist, kann dieses Konzept auf die Verarbeitung von Feeds von Kameras in Fahrzeugen ausgeweitet werden, um Objektverfolgung, Schwärzung personenbezogener Daten (PII) und mehr durchzuführen. Wir können die Begrenzungsrahmen auch von kleineren Modellen erhalten oder in einigen Fällen mithilfe von Standard-Computer-Vision-Tools. Es ist ziemlich einfach, ein vorab trainiertes Modell oder einen Dienst wie Amazon Rekognition zu verwenden, um erste (visuelle) Beschriftungen für Ihre Eingabeaufforderung zu erhalten. Zum Zeitpunkt des Verfassens dieses Artikels sind auf Amazon SageMaker Jumpstart über 70 Modelle zur Objekterkennung verfügbar Amazon-Anerkennung identifiziert bereits mehrere nützliche Kategorien von Objekten in Bildern, darunter Autos, Fußgänger und andere Fahrzeuge.

Als Nächstes betrachten wir einige quantitative Ergebnisse im Zusammenhang mit der Leistung von SAM-Modellen mit einer Teilmenge von BDD100K-Daten.

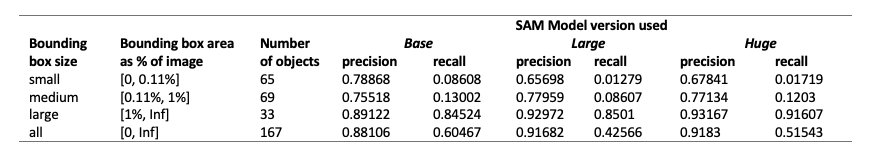

Quantitative Ergebnisse

Unser Ziel ist es, die Leistung von drei vorab trainierten Modellen zu vergleichen, wenn ihnen die gleiche visuelle Aufforderung gegeben wird. In diesem Fall verwenden wir den Mittelpunkt des Objektstandorts als visuelle Eingabe. Wir vergleichen die Leistung in Bezug auf die Objektgrößen (im Verhältnis zur Bildgröße) – klein (Fläche 0.11 %). Die Schwellenwerte für den Begrenzungsrahmenbereich werden durch die Common Objects in Context (COCO) definiert. Bewertungsmetriken [Lin et al., 2014].

Die Auswertung erfolgt auf Pixelebene und wir verwenden folgende Auswertungsmetriken:

- Präzision = (Anzahl relevanter und abgerufener Instanzen) / (Gesamtzahl der abgerufenen Instanzen)

- Rückruf = (Anzahl relevanter und abgerufener Instanzen) / (Gesamtzahl relevanter Instanzen)

- Instanzen sind hier jedes Pixel innerhalb des Begrenzungsrahmens des interessierenden Objekts

Die folgende Tabelle zeigt die Leistung von drei verschiedenen Versionen des SAM-Modells (Basis, groß und riesig). Diese Versionen verfügen über drei verschiedene Encoder: ViT-B (Basis), ViT-L (groß), ViT-H (riesig). Die Encoder haben unterschiedliche Parameterzahlen, wobei das Basismodell weniger Parameter als „groß“ hat und „groß“ kleiner als „riesig“ ist. Obwohl eine Erhöhung der Parameteranzahl bei größeren Objekten zu einer besseren Leistung führt, ist dies bei kleineren Objekten nicht der Fall.

Feinabstimmung von SAM für Ihren Anwendungsfall

In vielen Fällen ist die direkte Verwendung eines vorab trainierten SAM-Modells möglicherweise nicht sehr nützlich. Schauen wir uns zum Beispiel eine typische Szene im Verkehr an – das folgende Bild zeigt die Ausgabe des SAM-Modells mit zufällig ausgewählten Eingabeaufforderungspunkten als Eingabe auf der linken Seite und den tatsächlichen Beschriftungen aus der semantischen Segmentierungsaufgabe von BDD100K auf der rechten Seite. Diese sind offensichtlich sehr unterschiedlich.

Wahrnehmungsstapel in AVs können problemlos das zweite Bild verwenden, nicht jedoch das erste. Andererseits gibt es einige nützliche Ergebnisse aus dem ersten Bild, die verwendet werden können und auf die das Modell nicht explizit trainiert wurde, beispielsweise Fahrbahnmarkierungen, Gehwegsegmentierung, Nummernschildmasken usw. Wir können das SAM-Modell verfeinern, um die Segmentierungsergebnisse zu verbessern. Um diese Feinabstimmung durchzuführen, haben wir einen Trainingsdatensatz mithilfe einer Instanzsegmentierungsteilmenge (500 Bilder) aus dem BDD10K-Datensatz erstellt. Dies ist eine sehr kleine Teilmenge von Bildern, aber unser Ziel ist es zu beweisen, dass grundlegende Vision-Modelle (ähnlich wie LLMs) für Ihren Anwendungsfall mit einer überraschend kleinen Anzahl von Bildern eine gute Leistung erbringen können. Das folgende Bild zeigt das Eingabebild, die Ausgabemaske (in Blau, mit einem roten Rand für das Auto links) und mögliche Eingabeaufforderungen (Begrenzungsrahmen in Grün und Mittelpunkt X in Gelb).

Wir haben die Feinabstimmung mithilfe der Hugging Face-Bibliothek durchgeführt Amazon SageMaker-Studio. Wir haben die ml.g4dn.xlarge-Instanz für die SAM-Basismodelltests und die ml.g4dn.2xlarge für die SAM-Großmodelltests verwendet. In unseren ersten Experimenten haben wir festgestellt, dass die Feinabstimmung des Basismodells nur mit Begrenzungsrahmen nicht erfolgreich war. Die fein abgestimmten und vorab trainierten Modelle waren nicht in der Lage, fahrzeugspezifische Ground-Truth-Masken aus den Originaldatensätzen zu lernen. Auch das Hinzufügen von Abfragepunkten zur Feinabstimmung hat das Training nicht verbessert.

Als nächstes können wir versuchen, das SAM-Riesenmodell für 30 Epochen mit einem sehr kleinen Datensatz (500 Bilder) zu verfeinern. Die ursprüngliche Ground-Truth-Maske sieht für das Label-Typ-Auto wie im folgenden Bild aus.

Wie in den folgenden Bildern gezeigt, liefert die ursprüngliche vorab trainierte Version des riesigen Modells mit einer bestimmten Begrenzungsrahmen-Eingabeaufforderung (in Grün) keine Ausgabe, während die fein abgestimmte Version eine Ausgabe liefert (immer noch nicht genau, aber die Feinabstimmung wurde gestrichen). nach 40 Epochen und mit einem sehr kleinen Trainingsdatensatz von 500 Bildern). Das ursprüngliche, vorab trainierte Riesenmodell war nicht in der Lage, Masken für eines der von uns getesteten Bilder vorherzusagen. Als Beispiel für eine nachgelagerte Anwendung kann das fein abgestimmte Modell in Arbeitsabläufen vor der Etikettierung verwendet werden, wie sie in beschrieben sind Auto-Labeling-Modul für Deep-Learning-basierte fortschrittliche Fahrerassistenzsysteme auf AWS.

Zusammenfassung

In diesem Beitrag haben wir das grundlegende Visionsmodell namens Segment Anything Model (SAM) und seine Architektur besprochen. Wir haben das SAM-Modell verwendet, um visuelle Eingabeaufforderungen und die verschiedenen Eingaben für die visuelle Eingabeaufforderungstechnik zu diskutieren. Wir haben untersucht, wie verschiedene visuelle Eingabeaufforderungen funktionieren und welche Einschränkungen sie haben. Wir haben auch beschrieben, wie visuelle Ketten die Leistung gegenüber der Verwendung nur einer Eingabeaufforderung steigern, ähnlich wie bei der LangChain-API. Als nächstes lieferten wir eine quantitative Bewertung von drei vorab trainierten Modellen. Abschließend diskutierten wir das fein abgestimmte SAM-Modell und seine Ergebnisse im Vergleich zum ursprünglichen Basismodell. Die Feinabstimmung von Basismodellen trägt dazu bei, die Modellleistung für bestimmte Aufgaben wie die Segmentierung zu verbessern. Es ist zu beachten, dass das SAM-Modell aufgrund seiner Ressourcenanforderungen in seinem aktuellen Zustand die Nutzung für Echtzeit-Anwendungsfälle und Inferenzen am Edge einschränkt. Wir hoffen, dass zukünftige Iterationen und verbesserte Techniken den Rechenbedarf reduzieren und die Latenz verbessern werden.

Wir hoffen, dass dieser Beitrag Sie dazu ermutigt, visuelle Eingabeaufforderungen für Ihre Anwendungsfälle zu erkunden. Da es sich noch um eine neue Form des Prompt Engineering handelt, gibt es in Bezug auf visuelle Eingabeaufforderungen, visuelle Ketten und die Leistung dieser Tools noch viel zu entdecken. Amazon Sage Maker ist eine vollständig verwaltete ML-Plattform, die es Entwicklern ermöglicht, große Sprach- und visuelle Modelle zu erkunden und generative KI-Anwendungen zu erstellen. Beginnen Sie noch heute mit AWS die Zukunft zu gestalten.

Über die Autoren

Gopi Krishnamurthy ist Senior AI/ML Solutions Architect bei Amazon Web Services mit Sitz in New York City. Er arbeitet mit großen Automobilkunden als vertrauenswürdiger Berater zusammen, um ihre Workloads für maschinelles Lernen zu transformieren und in die Cloud zu migrieren. Seine Kerninteressen umfassen Deep Learning und serverlose Technologien. Außerhalb der Arbeit verbringt er gerne Zeit mit seiner Familie und erkundet ein breites Spektrum an Musik.

Gopi Krishnamurthy ist Senior AI/ML Solutions Architect bei Amazon Web Services mit Sitz in New York City. Er arbeitet mit großen Automobilkunden als vertrauenswürdiger Berater zusammen, um ihre Workloads für maschinelles Lernen zu transformieren und in die Cloud zu migrieren. Seine Kerninteressen umfassen Deep Learning und serverlose Technologien. Außerhalb der Arbeit verbringt er gerne Zeit mit seiner Familie und erkundet ein breites Spektrum an Musik.

Shreyas Subramanian ist ein Principal AI/ML-Spezialist für Lösungen und hilft Kunden durch den Einsatz von maschinellem Lernen bei der Lösung ihrer geschäftlichen Herausforderungen mit der AWS-Plattform. Shreyas hat einen Hintergrund in groß angelegter Optimierung und maschinellem Lernen sowie in der Verwendung von maschinellem Lernen und Reinforcement Learning zur Beschleunigung von Optimierungsaufgaben.

Shreyas Subramanian ist ein Principal AI/ML-Spezialist für Lösungen und hilft Kunden durch den Einsatz von maschinellem Lernen bei der Lösung ihrer geschäftlichen Herausforderungen mit der AWS-Plattform. Shreyas hat einen Hintergrund in groß angelegter Optimierung und maschinellem Lernen sowie in der Verwendung von maschinellem Lernen und Reinforcement Learning zur Beschleunigung von Optimierungsaufgaben.

Sujitha Martin ist angewandter Wissenschaftler im Generative AI Innovation Center (GAIIC). Ihre Expertise liegt in der Entwicklung von Lösungen für maschinelles Lernen mit Computer Vision und Verarbeitung natürlicher Sprache für verschiedene Branchen. Insbesondere verfügt sie über umfangreiche Erfahrung in der Arbeit mit menschenzentriertem Situationsbewusstsein und wissensbasiertem Lernen für hochautonome Systeme.

Sujitha Martin ist angewandter Wissenschaftler im Generative AI Innovation Center (GAIIC). Ihre Expertise liegt in der Entwicklung von Lösungen für maschinelles Lernen mit Computer Vision und Verarbeitung natürlicher Sprache für verschiedene Branchen. Insbesondere verfügt sie über umfangreiche Erfahrung in der Arbeit mit menschenzentriertem Situationsbewusstsein und wissensbasiertem Lernen für hochautonome Systeme.

Francisco Calderón ist Datenwissenschaftler im Generative AI Innovation Center (GAIIC). Als Mitglied der GAIIC hilft er AWS-Kunden dabei, mithilfe generativer KI-Technologien die Kunst des Möglichen zu entdecken. In seiner Freizeit spielt Francisco gerne Musik und Gitarre, spielt Fußball mit seinen Töchtern und genießt die Zeit mit seiner Familie.

Francisco Calderón ist Datenwissenschaftler im Generative AI Innovation Center (GAIIC). Als Mitglied der GAIIC hilft er AWS-Kunden dabei, mithilfe generativer KI-Technologien die Kunst des Möglichen zu entdecken. In seiner Freizeit spielt Francisco gerne Musik und Gitarre, spielt Fußball mit seinen Töchtern und genießt die Zeit mit seiner Familie.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/foundational-vision-models-and-visual-prompt-engineering-for-autonomous-driving-applications/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 1

- 100

- 11

- 179

- 2014

- 214

- 225

- 30

- 40

- 500

- 7

- 70

- 804

- 91

- 97

- a

- Fähigkeit

- Fähig

- LiveBuzz

- oben

- beschleunigend

- Akzeptiert

- genau

- erreicht

- präsentieren

- automatisch

- Hinzufügen

- advanced

- Fortschritte

- Vorteil

- Berater

- Nach der

- AI

- AI / ML

- AL

- Alle

- erlaubt

- entlang

- bereits

- ebenfalls

- Obwohl

- Amazon

- Amazon-Anerkennung

- Amazon Sage Maker

- Amazon SageMaker-JumpStart

- Amazon Web Services

- an

- und

- beantworten

- jedem

- jemand

- etwas

- Bienen

- anwendbar

- Anwendung

- Anwendungen

- angewandt

- Ansatz

- Architektur

- SIND

- Bereich

- Bereiche

- um

- Feld

- Kunst

- AS

- Hilfe

- annehmen

- übernimmt

- At

- Aufmerksamkeit

- Automobilindustrie

- Autonom

- verfügbar

- Bewusstsein

- AWS

- Hintergrund

- Base

- basierend

- Grundlagen

- BE

- weil

- werden

- war

- beginnen

- hinter

- Vorteile

- Besser

- Milliarde

- Blau

- Grenze

- Box

- Boxen

- Durchbruch

- allgemein

- bauen

- Bauherren

- Building

- erbaut

- Geschäft

- aber

- by

- Berechnen

- rufen Sie uns an!

- Kamera

- Kameras

- CAN

- Kann bekommen

- Auto

- österreichische Unternehmen

- Autos

- Häuser

- Fälle

- Kategorien

- Kategorie

- Catering

- Center

- Kette

- Ketten

- Herausforderungen

- Wahl

- Stadt

- reinigen

- Menu

- geschlossen

- eng

- Cloud

- Kokos

- Code

- Kombination

- vereint

- Vereinigung

- gemeinsam

- Unternehmen

- vergleichen

- verglichen

- rechnerisch

- Berechnen

- Computer

- Computer Vision

- konzept

- Konzepte

- Kontext

- Koordinate

- Kernbereich

- Covers

- erstellt

- Cross

- Strom

- Aktuellen Zustand

- Kunden

- Schneiden

- technische Daten

- Datenwissenschaftler

- Datensätze

- tief

- tiefe Lernen

- definieren

- definiert

- Synergie

- beschrieben

- erwünscht

- Entdeckung

- anders

- dino

- Direkt

- entdeckt,

- diskutieren

- diskutiert

- Ausschüttungen

- verschieden

- do

- Tut nicht

- Domain

- Domains

- Nicht

- drastisch

- Fahrer

- Fahren

- zwei

- e

- E & T

- jeder

- leicht

- Edge

- Einbettung

- aufstrebenden

- ermöglicht

- ermöglichen

- ermutigt

- Entwicklung

- Unterhaltung

- Ganz

- Epochen

- essential

- Auswertung

- Beispiel

- Beispiele

- expansiv

- erwarten

- ERFAHRUNGEN

- Experimente

- Expertise

- Erklärt

- Erklärung

- explizit

- ERKUNDEN

- Erkundet

- Ausdrücke

- umfangreiche

- Langjährige Erfahrung

- Extrakt

- Gesicht

- ziemlich

- vertraut

- Familie

- Merkmal

- wenige

- Feld

- Abbildung

- Filter

- Finale

- Finden Sie

- Vorname

- konzentriert

- Fokussierung

- Folgende

- Aussichten für

- unten stehende Formular

- Foundation

- Gründen

- vier

- Unser Ansatz

- Francisco cisco~~POS=HEADCOMP

- für

- Materials des

- voller

- voll

- weiter

- Zukunft

- erzeugen

- erzeugt

- Erzeugung

- generativ

- Generative KI

- bekommen

- gegeben

- gibt

- gut

- Grün

- Boden

- Guide

- Pflege

- Haben

- mit

- he

- Gesundheitswesen

- hilft

- hier (auf dänisch)

- hier

- GUTE

- hochwertige

- höher

- hoch

- seine

- hält

- Haube

- ein Geschenk

- Ultraschall

- HTML

- HTTPS

- riesig

- identifiziert

- identifiziert

- identifizieren

- Identifizierung

- Image

- Bilder

- sofort

- implementieren

- beeindruckend

- zu unterstützen,

- verbessert

- Verbesserung

- in

- das

- Einschließlich

- Erhöhung

- Steigert

- zunehmend

- Energiegewinnung

- Information

- infundiert

- Anfangs-

- Innovation

- Varianten des Eingangssignals:

- Eingänge

- inspirierte

- Instanz

- Instanzsegmentierung

- Anleitung

- Absicht

- Interesse

- interessiert

- interessant

- Interessen

- in

- beteiligen

- Beteiligung

- IT

- Iterationen

- SEINE

- jpg

- nur

- nur einer

- Wissen

- bekannt

- Label

- Etiketten

- Spur

- Sprache

- grosse

- großflächig

- größer

- höchste

- zuletzt

- Latency

- LERNEN

- lernen

- links

- weniger

- Niveau

- Bibliothek

- Lizenz

- liegt

- Lebensdauer

- Biowissenschaften

- leicht

- Gefällt mir

- Gleichen

- Einschränkungen

- Grenzen

- lin

- Liste

- wenig

- LLM

- Standorte

- aussehen

- suchen

- SIEHT AUS

- Sneaker

- Maschine

- Maschinelles Lernen

- MACHT

- Making

- verwaltet

- manuell

- viele

- heiraten

- Maske"

- Masken

- massiv

- Kann..

- Mittel

- Medien

- mittlere

- Mitglied

- Meta

- Metrik

- migriert

- Million

- Geist / Bewusstsein

- minimal

- ML

- Modell

- für

- Änderungen

- Modul

- mehr

- vor allem warme

- Motivation

- viel

- mehrere

- Musik

- Name

- Namen

- Natürliche

- Verarbeitung natürlicher Sprache

- Notwendig

- Neu

- New York

- New York City

- weiter

- nicht

- bekannt

- Anzahl

- Objekt

- Objekterkennung

- Ziel

- Objekte

- of

- WOW!

- on

- EINEM

- Optimierung

- or

- Original

- Andere

- UNSERE

- Ergebnis

- Möglichkeiten für das Ausgangssignal:

- Ausgänge

- aussen

- übrig

- Paare

- Parameter

- Parameter

- besondere

- Teile

- Patch

- Wahrnehmung

- Ausführen

- Leistung

- durchgeführt

- Persönlich

- ein Bild

- Säulen

- Pipeline

- Pixel

- Ebene

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- Play

- spielend

- Points

- Punkte

- Beliebt

- möglich

- Post

- Potenzial

- Werkzeuge

- vorhersagen

- primär

- Principal

- Vor

- Prozessdefinierung

- Verarbeitet

- Verarbeitung

- produziert

- produziert

- Anteil

- bietet

- Belegen

- die

- vorausgesetzt

- bietet

- Bereitstellung

- Zweck

- Qualität

- quantitativ

- Menge

- Frage

- Angebot

- Echtzeit

- wirklich

- Gründe

- kürzlich

- Rot

- Veteran

- siehe

- bezieht sich

- Region

- Regionen

- bezogene

- relevant

- Meldungen

- Voraussetzungen:

- erfordert

- Ressourcen

- Umwelt und Kunden

- Antwort

- Folge

- Die Ergebnisse

- revolutionieren

- Reiches

- Recht

- Straße

- Laufen

- sagemaker

- Sam

- gleich

- sah

- Skalieren

- Szene

- WISSENSCHAFTEN

- Wissenschaftler

- Ergebnis

- Zweite

- Abschnitte

- sehen

- gesehen

- Segment

- Segmentierung

- Segmente

- Senior

- getrennte

- Serverlos

- Lösungen

- kompensieren

- mehrere

- sie

- sollte

- erklären

- Vitrine

- gezeigt

- Konzerte

- Schild

- signifikant

- Schilder

- Silbermedaille

- ähnlich

- Einfacher

- Singular

- Größe

- Größen

- Geschicklichkeit

- Schloß

- Slots

- klein

- kleinere

- Schnipsel

- So

- Fußball

- Lösungen

- LÖSEN

- einige

- Quelle

- Quellen

- Spezialist

- spezifisch

- speziell

- verbringen

- gespalten

- Stacks

- Standard

- Anfang

- Bundesstaat

- Shritte

- Immer noch

- einfach

- Stärken

- Struktur

- Strukturierung

- Kämpft

- erfolgreich

- so

- Unterstützt

- übertreffen

- Systeme und Techniken

- Tabelle

- Nehmen

- gemacht

- Aufgabe

- und Aufgaben

- Techniken

- Technologies

- Vorlage

- Vorlagen

- AGB

- getestet

- Tests

- Text

- textuell

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Gegend

- Die Grundlagen

- Die Zukunft

- die Informationen

- ihr

- Dort.

- Diese

- fehlen uns die Worte.

- dachte

- nach drei

- Durch

- Zeit

- Reifen

- zu

- heute

- Werkzeug

- Werkzeuge

- Top

- Gesamt

- Tracking

- der Verkehr

- trainiert

- Ausbildung

- Transformieren

- Transformator

- LKW

- was immer dies auch sein sollte.

- vertraut

- Wahrheit

- versuchen

- XNUMX

- tippe

- typisch

- für

- verstehen

- us

- verwendbar

- Anwendungsbereich

- -

- Anwendungsfall

- Anwendungsfälle

- benutzt

- Mitglied

- Verwendung von

- Werte

- verschiedene

- riesig

- Vegetation

- Fahrzeuge

- Version

- Versionen

- Vertikalen

- sehr

- Video

- Seh-

- visuell

- vs

- W

- wurde

- Wege

- we

- Netz

- Web-Services

- GUT

- ging

- waren

- Was

- Was ist

- wann

- während

- welche

- ganze

- breit

- Große Auswahl

- weit

- werden wir

- mit

- .

- ohne

- Zeuge

- Worte

- Arbeiten

- Workflows

- arbeiten,

- Werk

- würde

- Schreiben

- X

- Jahr

- York

- Du

- Ihr

- Zephyrnet