Suuret kielimallit (LLM) ovat mullistaneet luonnollisen kielen käsittelyn (NLP) alan parantamalla tehtäviä, kuten kielen kääntämistä, tekstin yhteenvetoa ja tunteiden analysointia. Näiden mallien koon ja monimutkaisuuden kasvaessa kuitenkin niiden suorituskyvyn ja käyttäytymisen seuranta on muuttunut yhä haastavammaksi.

LLM:ien suorituskyvyn ja käyttäytymisen seuranta on kriittinen tehtävä heidän turvallisuutensa ja tehokkuutensa varmistamiseksi. Ehdottamamme arkkitehtuuri tarjoaa skaalautuvan ja muokattavissa olevan ratkaisun online-LLM-seurantaan, jonka avulla tiimit voivat räätälöidä valvontaratkaisusi erityisiin käyttötapauksiin ja vaatimuksiin. Käyttämällä AWS-palveluita arkkitehtuurimme tarjoaa reaaliaikaisen näkyvyyden LLM-käyttäytymiseen ja mahdollistaa ryhmien nopean tunnistamisen ja korjaamisen mahdolliset ongelmat tai poikkeamat.

Tässä viestissä esittelemme muutamia mittareita online-LLM-seurantaan ja niiden vastaavaa arkkitehtuuria mittakaavassa käyttämällä AWS-palveluita, kuten amazonin pilvikello ja AWS Lambda. Tämä tarjoaa räätälöitävän ratkaisun enemmän kuin mahdollista mallin arviointi kanssa Amazonin kallioperä.

Katsaus ratkaisuun

Ensimmäinen asia, joka on otettava huomioon, on, että erilaiset mittarit edellyttävät erilaisia laskentanäkökohtia. Modulaarinen arkkitehtuuri, jossa jokainen moduuli voi ottaa mallin päättelytietoa ja tuottaa omat metriikkansa, on välttämätön.

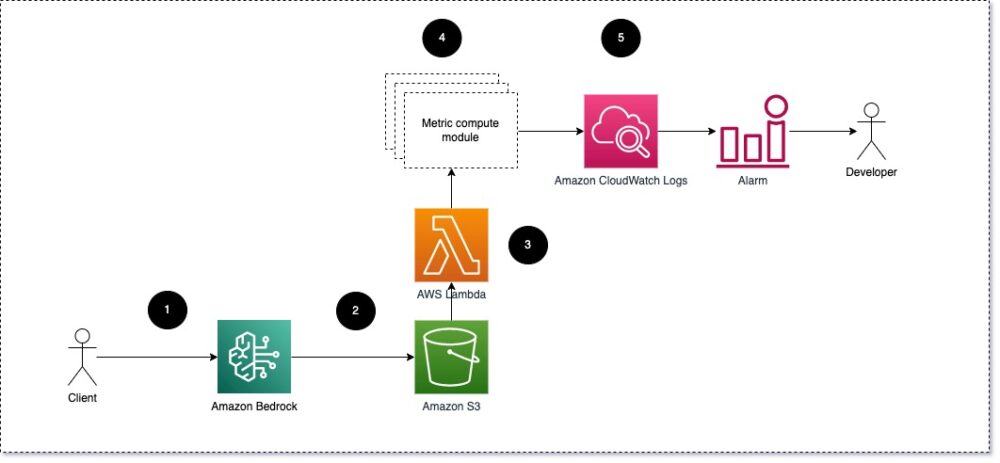

Suosittelemme, että jokainen moduuli ottaa saapuvat päättelypyynnöt LLM:lle ja välittää kehote- ja valmistumisparit metrijärjestelmän laskentamoduuleille. Jokainen moduuli on vastuussa omien mittareiden laskemisesta syöttökehotteen ja valmistumisen (vastauksen) suhteen. Nämä mittarit välitetään CloudWatchille, joka voi yhdistää ne ja lähettää ilmoituksia tietyissä olosuhteissa CloudWatch-hälytysten kanssa. Seuraava kaavio havainnollistaa tätä arkkitehtuuria.

Kuva 1: Metrinen laskentamoduuli – ratkaisun yleiskatsaus

Työnkulku sisältää seuraavat vaiheet:

- Käyttäjä tekee pyynnön Amazon Bedrockille osana sovellusta tai käyttöliittymää.

- Amazon Bedrock tallentaa pyynnön ja täydennyksen (vastauksen) sisään Amazonin yksinkertainen tallennuspalvelu (Amazon S3) kokoonpanon mukaan kutsujen kirjaaminen.

- Amazon S3:een tallennettu tiedosto luo tapahtuman, joka liipaisimet lambda-toiminto. Funktio kutsuu moduulit.

- Moduulit lähettävät vastaavat mittarinsa osoitteeseen CloudWatch-mittarit.

- Hälytykset: voi ilmoittaa kehitystiimille odottamattomista mittariarvoista.

Toinen asia, joka on otettava huomioon LLM-seurantaa toteutettaessa, on seurata oikeita mittareita. Vaikka on monia mahdollisia mittareita, joita voit käyttää LLM-suorituskyvyn seuraamiseen, selitämme joitain laajimmista tässä viestissä.

Seuraavissa osissa korostamme muutamia asiaankuuluvia moduulimittareita ja niiden vastaavaa metriikan laskentamoduuliarkkitehtuuria.

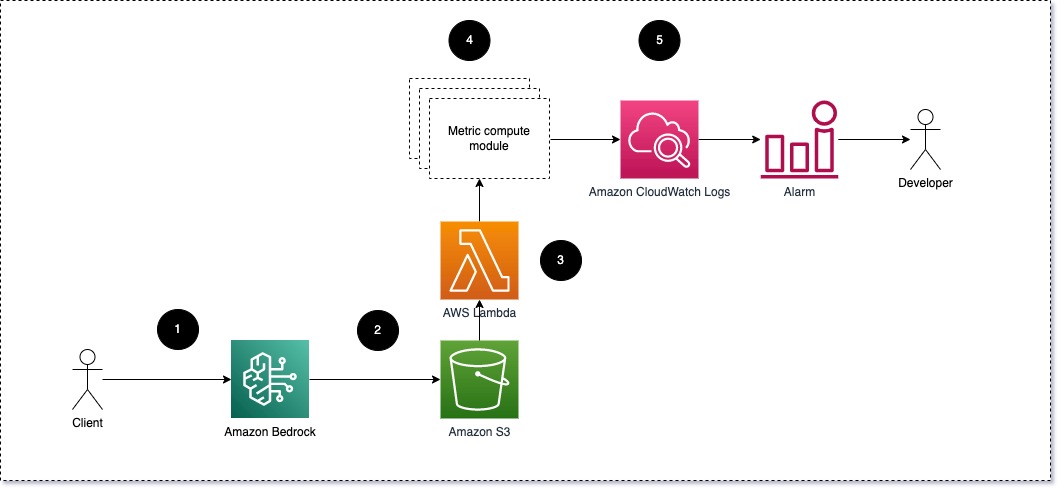

Semanttinen samankaltaisuus kehotteen ja täydennyksen välillä (vastaus)

Kun suoritat LLM:itä, voit siepata jokaisen pyynnön kehotteen ja täydennyksen (vastauksen) ja muuntaa ne upotuksiksi käyttämällä upotusmallia. Upotukset ovat suuriulotteisia vektoreita, jotka edustavat tekstin semanttista merkitystä. Amazon Titan tarjoaa tällaisia malleja Titan Embeddingsin kautta. Ottamalla näiden kahden vektorin välisen etäisyyden, kuten kosinin, voit määrittää, kuinka semanttisesti samankaltaisia kehote ja täydennys (vastaus) ovat. Voit käyttää SciPy or scikit opittava laskea vektorien välisen kosinietäisyyden. Seuraava kaavio havainnollistaa tämän metriikkalaskentamoduulin arkkitehtuuria.

Kuva 2: Metrinen laskentamoduuli – semanttinen samankaltaisuus

Tämä työnkulku sisältää seuraavat avainvaiheet:

- Lambda-toiminto vastaanottaa suoratoistettavan viestin kautta Amazon kinesis joka sisältää kehotteen ja täydennysparin (vastaus).

- Funktio saa upotuksen sekä kehotteeseen että loppuun (vastaukseen) ja laskee kosinietäisyyden näiden kahden vektorin välillä.

- Toiminto lähettää nämä tiedot CloudWatch-mittareihin.

Sentimentti ja myrkyllisyys

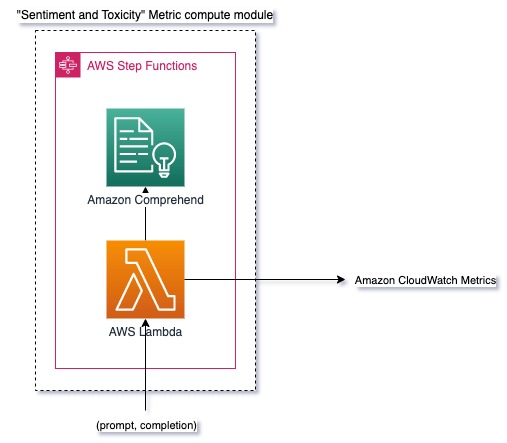

Sentimentin seuranta mahdollistaa vastausten yleisen sävyn ja emotionaalisen vaikutuksen mittaamisen, kun taas myrkyllisyysanalyysi tarjoaa tärkeän mittarin loukkaavan, epäkunnioittavan tai haitallisen kielen esiintymisestä LLM-tuloksissa. Kaikkia tunteiden tai myrkyllisyyden muutoksia tulee seurata tarkasti sen varmistamiseksi, että malli käyttäytyy odotetulla tavalla. Seuraava kaavio havainnollistaa metrijärjestelmän laskentamoduulia.

Kuva 3: Metrinen laskentamoduuli – tunne ja myrkyllisyys

Työnkulku sisältää seuraavat vaiheet:

- Lambda-toiminto vastaanottaa kehotteen ja täydennysparin (vastaus) Amazon Kinesiksen kautta.

- AWS Step Functions -orkestroinnin kautta funktio kutsuu Amazonin käsitys havaita näkemys ja myrkyllisyys.

- Toiminto tallentaa tiedot CloudWatch-mittareihin.

Lisätietoja tunteiden ja myrkyllisyyden havaitsemisesta Amazon Comprehendillä on kohdassa Rakenna vankka tekstipohjainen myrkyllisyyden ennustaja ja Ilmoita haitallisesta sisällöstä käyttämällä Amazon Comprehend myrkyllisyyden havaitsemista.

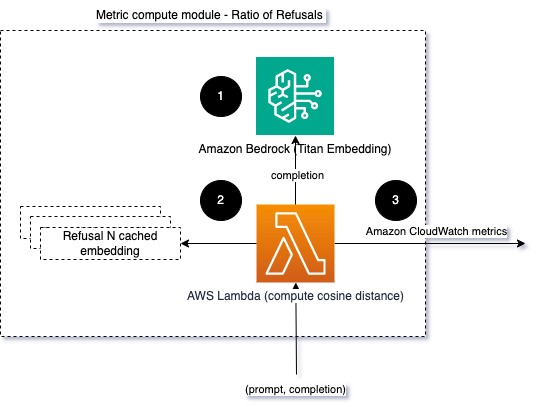

Kieltäytymissuhde

Kieltäytymisten lisääntyminen, kuten silloin, kun LLM kieltää suorittamisen tiedon puutteen vuoksi, voi tarkoittaa sitä, että joko pahantahtoiset käyttäjät yrittävät käyttää LLM:ää tavoilla, joilla on tarkoitus murtaa se, tai että käyttäjien odotukset eivät täyty ja he eivät täyty. saavat vähäarvoisia vastauksia. Yksi tapa mitata, kuinka usein näin tapahtuu, on verrata käytetyn LLM-mallin vakiokieltäytymistä LLM:n todellisiin vastauksiin. Esimerkiksi seuraavat ovat joitain Anthropicin Claude v2 LLM:n yleisiä kieltäytymislauseita:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

Kiinteillä kehotteilla näiden kieltäytymisten lisääntyminen voi olla merkki siitä, että mallista on tullut liian varovainen tai herkkä. Myös käänteinen tapaus on arvioitava. Se voi olla merkki siitä, että malli on nyt alttiimpi osallistumaan myrkyllisiin tai haitallisiin keskusteluihin.

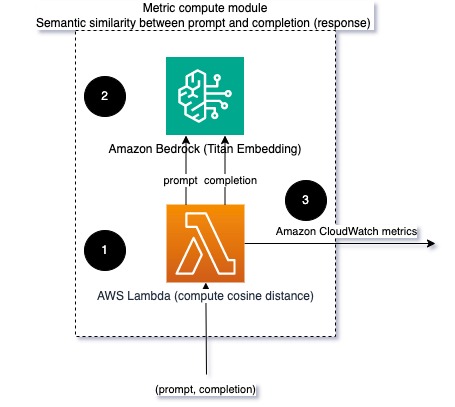

Eheyden ja kieltäytymissuhteen mallintamisen helpottamiseksi voimme verrata vastausta joukkoon LLM:n tunnettuja kieltäytymislauseita. Tämä voi olla todellinen luokitin, joka voi selittää, miksi malli hylkäsi pyynnön. Voit ottaa kosinietäisyyden vastauksen ja tunnettujen kieltäytymisvastausten välillä valvottavasta mallista. Seuraava kaavio havainnollistaa tätä metrijärjestelmän laskentamoduulia.

Kuva 4: Metrinen laskentamoduuli – kieltäytymisten suhde

Työnkulku koostuu seuraavista vaiheista:

- Lambda-toiminto vastaanottaa kehotteen ja täydennyksen (vastauksen) ja saa upotuksen vastauksesta Amazon Titanin avulla.

- Funktio laskee kosinin tai euklidiaanisen etäisyyden vastauksen ja muistiin tallennettujen olemassa olevien kieltäytymiskehotteiden välillä.

- Funktio lähettää tämän keskiarvon CloudWatch-mittareihin.

Toinen vaihtoehto on käyttää sumea vastaavuus yksinkertaista mutta vähemmän tehokasta lähestymistapaa verrata tunnettuja kieltäytymisiä LLM-tulokseen. Viittaavat Python-dokumentaatio esimerkki.

Yhteenveto

LLM-havainnointi on kriittinen käytäntö LLM:ien luotettavan ja luotettavan käytön varmistamiseksi. LLM:ien seuranta, ymmärtäminen ja tarkkuuden ja luotettavuuden varmistaminen voi auttaa sinua vähentämään näihin tekoälymalleihin liittyviä riskejä. Tarkkailemalla hallusinaatioita, huonoja täydennyksiä (vastauksia) ja kehotteita voit varmistaa, että LLM pysyy oikeilla jäljillä ja tuottaa arvon, jota sinä ja käyttäjäsi etsivät. Tässä viestissä keskustelimme muutamista mittareista esimerkkien esittelemiseksi.

Lisätietoja perustusmallien arvioinnista on kohdassa Käytä SageMaker Clarifyta perusmallien arvioimiseenja selaa lisää esimerkkimuistikirjoja saatavilla GitHub-arkistossamme. Voit myös tutkia tapoja toteuttaa LLM-arvioinnit laajassa mittakaavassa Käytä LLM-arviointia mittakaavassa käyttämällä Amazon SageMaker Clarify- ja MLOps-palveluita. Lopuksi suosittelemme viittaamaan Arvioi suuria kielimalleja laadun ja vastuullisuuden suhteen saadaksesi lisätietoja LLM:ien arvioinnista.

Tietoja Tekijät

Bruno Klein on vanhempi koneoppimisinsinööri, jolla on AWS Professional Services Analytics -käytäntö. Hän auttaa asiakkaita toteuttamaan big data- ja analytiikkaratkaisuja. Työn ulkopuolella hän viettää aikaa perheen kanssa, matkustaa ja kokeilla uusia ruokia.

Bruno Klein on vanhempi koneoppimisinsinööri, jolla on AWS Professional Services Analytics -käytäntö. Hän auttaa asiakkaita toteuttamaan big data- ja analytiikkaratkaisuja. Työn ulkopuolella hän viettää aikaa perheen kanssa, matkustaa ja kokeilla uusia ruokia.

Rushabh Lokhande on vanhempi tieto- ja ML-insinööri, jolla on AWS Professional Services Analytics -käytäntö. Hän auttaa asiakkaita toteuttamaan big data-, koneoppimis- ja analytiikkaratkaisuja. Työn ulkopuolella hän viettää aikaa perheen kanssa, lukee, juoksee ja pelaa golfia.

Rushabh Lokhande on vanhempi tieto- ja ML-insinööri, jolla on AWS Professional Services Analytics -käytäntö. Hän auttaa asiakkaita toteuttamaan big data-, koneoppimis- ja analytiikkaratkaisuja. Työn ulkopuolella hän viettää aikaa perheen kanssa, lukee, juoksee ja pelaa golfia.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- :on

- :On

- :ei

- :missä

- 1

- 100

- 143

- 32

- 455

- 7

- a

- Meistä

- tarkkuus

- todellinen

- lisä-

- osoite

- aggregaatti

- AI

- AI avustaja

- AI-mallit

- mahdollistaa

- Myös

- Vaikka

- am

- Amazon

- Amazonin käsitys

- Amazon kinesis

- Amazon Sage Maker

- Amazon Web Services

- an

- analyysi

- Analytics

- ja

- poikkeavuuksia

- Antropinen

- Kaikki

- Hakemus

- lähestymistapa

- lähestymistavat

- arkkitehtuuri

- OVAT

- AS

- Avustaja

- liittyvä

- At

- saatavissa

- keskimäärin

- AWS

- AWS-asiantuntijapalvelut

- AWS-vaihetoiminnot

- Huono

- BE

- tulevat

- käyttäytyminen

- ovat

- välillä

- Jälkeen

- Iso

- Big Data

- sekä

- mutta

- by

- Puhelut

- CAN

- ei voi

- tapaus

- tapauksissa

- varovainen

- haastava

- valita

- luokitella

- tarkasti

- Yhteinen

- verrata

- vertaamalla

- valmistuminen

- monimutkaisuus

- ymmärtää

- laskeminen

- Laskea

- tietojenkäsittely

- olosuhteet

- Konfigurointi

- Harkita

- näkökohdat

- muodostuu

- pitoisuus

- tausta

- jatkaa

- keskustelut

- voisi

- luotu

- luo

- kriittinen

- Asiakkaat

- muokattavissa

- tiedot

- Antaa

- osoittaa

- havaita

- Kehitys

- kehitystiimi

- kaavio

- eri

- keskusteltiin

- etäisyys

- do

- kaksi

- kukin

- tehokkuuden

- myöskään

- upottamisen

- mahdollistaa

- mahdollistaa

- sitoutua

- insinööri

- tarpeeksi

- varmistaa

- varmistamalla

- arvioida

- arvioitu

- arviointiin

- arviointi

- arvioinnit

- tapahtuma

- esimerkki

- Esimerkit

- olemassa

- odotukset

- odotettu

- Selittää

- tutkia

- perhe

- harvat

- ala

- kuva

- filee

- Vihdoin

- Etunimi

- kiinteä

- jälkeen

- ruoka

- varten

- perusta

- alkaen

- toiminto

- tehtävät

- arvioida

- saa

- saada

- GitHub

- golf

- Kasvaa

- Happening

- haitallinen

- Olla

- he

- auttaa

- hyödyllinen

- auttaa

- Korostaa

- rehellinen

- Miten

- Kuitenkin

- HTML

- http

- HTTPS

- i

- tunnistaa

- havainnollistaa

- Vaikutus

- toteuttaa

- täytäntöönpanosta

- tärkeä

- parantaminen

- in

- sisältää

- Saapuva

- Kasvaa

- yhä useammin

- tiedot

- panos

- eheys

- tarkoitettu

- liitäntä

- tulee

- käänteinen

- vedotaan

- kysymykset

- IT

- SEN

- karkaaminen

- Työpaikat

- jpg

- avain

- tunnettu

- Lack

- Kieli

- suuri

- OPPIA

- oppiminen

- vähemmän

- OTK

- näköinen

- kone

- koneoppiminen

- tehdä

- TEE

- ilkeä

- monet

- tarkoittaa

- merkitys

- mitata

- Muisti

- viesti

- tapasi

- metrinen

- Metrics

- lieventää

- ML

- MLOps

- malli

- mallit

- modulaarinen

- Moduulit

- Moduulit

- monitori

- seurataan

- seuranta

- lisää

- Luonnollinen

- Luonnollinen kielen käsittely

- välttämätön

- Uusi

- NLP

- ilmoitukset

- nyt

- of

- hyökkäys

- Tarjoukset

- usein

- on

- ONE

- yhdet

- verkossa

- Vaihtoehto

- or

- orkestrointi

- meidän

- ulostulo

- lähdöt

- ulkopuolella

- yleinen

- yleiskatsaus

- oma

- pari

- paria

- osa

- Hyväksytty

- Ohimenevä

- varten

- suorituskyky

- lausekkeet

- Platon

- Platonin tietotieto

- PlatonData

- pelaa

- mahdollinen

- Kirje

- mahdollinen

- voimakas

- harjoitusta.

- läsnäolo

- käsittely

- tuottaa

- ammatillinen

- ohjeita

- ehdotettu

- toimittaa

- tarjoaa

- Python

- laatu

- nopeasti

- suhde

- Lukeminen

- reaaliaikainen

- vastaanottaa

- suositella

- katso

- epääminen

- kieltäytyi

- merkityksellinen

- luotettavuus

- luotettava

- säilytyspaikka

- edustaa

- pyyntö

- pyynnöt

- edellyttää

- vaatimukset

- kunnioittaminen

- ne

- vastaus

- vasteet

- vastuullinen

- mullistanut

- oikein

- riskit

- luja

- juoksu

- Turvallisuus

- sagemaker

- tallennettu

- skaalautuva

- Asteikko

- Toinen

- osiot

- semanttinen

- lähettää

- lähettää

- vanhempi

- sensible

- näkemys

- Palvelut

- setti

- Vuorot

- shouldnt

- näyteikkuna

- signaali

- samankaltainen

- Yksinkertainen

- Koko

- ratkaisu

- Ratkaisumme

- jonkin verran

- tila-

- erityinen

- menot

- standardi

- Vaihe

- Askeleet

- Levytila

- suora

- virtasi

- niin

- ehdottaa

- varma

- räätälöidä

- ottaa

- ottaen

- Tehtävä

- tehtävät

- joukkue-

- tiimit

- tekniikat

- teksti

- että

- -

- tiedot

- heidän

- Niitä

- Siellä.

- Nämä

- ne

- asia

- tätä

- Kautta

- aika

- Titaani

- että

- TONE

- raita

- Muuttaa

- Kääntäminen

- Matkustaminen

- luotettava

- yrittää

- kaksi

- ymmärtäminen

- Odottamaton

- käyttää

- käytetty

- käyttäjä

- Käyttöliittymä

- Käyttäjät

- käyttämällä

- arvo

- arvot

- kautta

- näkyvyys

- Tapa..

- tavalla

- we

- verkko

- verkkopalvelut

- Mitä

- Mikä on

- kun

- taas

- joka

- miksi

- wikipedia

- with

- Referenssit

- työnkulku

- Voit

- Sinun

- zephyrnet