Avoimen lähdekoodin suurista kielimalleista (LLM) on tullut suosittuja, minkä ansiosta tutkijat, kehittäjät ja organisaatiot voivat käyttää näitä malleja innovaation ja kokeilun edistämiseksi. Tämä rohkaisee avoimen lähdekoodin yhteisöä tekemään yhteistyötä LLM:ien kehittämiseksi ja parantamiseksi. Avoimen lähdekoodin LLM:t tarjoavat läpinäkyvyyttä malliarkkitehtuurille, koulutusprosessille ja koulutusdatalle, mikä antaa tutkijoille mahdollisuuden ymmärtää mallin toimintaa ja tunnistaa mahdollisia harhoja ja käsitellä eettisiä huolenaiheita. Nämä avoimen lähdekoodin LLM:t demokratisoivat generatiivista tekoälyä tuomalla kehittyneen luonnollisen kielen käsittelytekniikan (NLP) useiden käyttäjien saataville kriittisten liiketoimintasovellusten rakentamiseen. GPT-NeoX, LLaMA, Alpaca, GPT4All, Vicuna, Dolly ja OpenAssistant ovat joitakin suosittuja avoimen lähdekoodin LLM:itä.

OpenChatKit on avoimen lähdekoodin LLM, jota käytetään yleiskäyttöisten ja erikoistuneiden chatbot-sovellusten rakentamiseen. Together Computer julkaisi maaliskuussa 2023 Apache-2.0-lisenssillä. Tämän mallin avulla kehittäjät voivat hallita chatbotin toimintaa paremmin ja räätälöidä sitä omiin sovelluksiinsa. OpenChatKit tarjoaa joukon työkaluja, perusbottia ja rakennuspalikoita täysin räätälöityjen, tehokkaiden chatbottien rakentamiseen. Tärkeimmät komponentit ovat seuraavat:

- Ohjeiden mukaan viritetty LLM, joka on hienosäädetty EleutherAI:n GPT-NeoX-20B:n chattiin ja sisältää yli 43 miljoonaa ohjetta 100 % hiilinegatiivisella laskennalla. The

GPT-NeoXT-Chat-Base-20Bmalli perustuu EleutherAI:n GPT-NeoX-malliin, ja se on hienosäädetty datalla, joka keskittyy dialogityyppisiin vuorovaikutuksiin. - Räätälöidyt reseptit mallin hienosäätämiseksi tehtävien suuren tarkkuuden saavuttamiseksi.

- Laajennettava hakujärjestelmä, jonka avulla voit täydentää bot-vastauksia dokumenttivaraston, API:n tai muun reaaliaikaisesti päivittyvän tietolähteen tiedoilla päättelyhetkellä.

- GPT-JT-6B:stä hienosäädetty moderointimalli, joka on suunniteltu suodattamaan, mihin kysymyksiin botti vastaa.

Syväoppimismallien kasvava laajuus ja koko muodostaa esteitä näiden mallien menestyksekkäälle käyttöönotolle generatiivisissa tekoälysovelluksissa. Matala latenssin ja suuren suorituskyvyn vaatimusten täyttämiseksi on välttämätöntä käyttää kehittyneitä menetelmiä, kuten mallin rinnakkaisuutta ja kvantisointia. Koska monet käyttäjät eivät osaa soveltaa näitä menetelmiä, he kohtaavat vaikeuksia aloittaa mittavien mallien isännöinti generatiivisia tekoälyn käyttötapauksia varten.

Tässä viestissä näytämme kuinka ottaa käyttöön OpenChatKit-malleja (GPT-NeoXT-Chat-Base-20B and GPT-JT-Moderation-6B) mallit päällä Amazon Sage Maker käyttämällä DJL Servingiä ja avoimen lähdekoodin mallin rinnakkaiskirjastoja, kuten DeepSpeed ja Hugging Face Accelerate. Käytämme DJL Servingiä, joka on korkean suorituskyvyn universaali mallinpalveluratkaisu, joka perustuu Deep Java Libraryyn (DJL), joka on ohjelmointikieltä agnostikko. Osoitamme, kuinka Hugging Face Accelerate -kirjasto yksinkertaistaa suurten mallien käyttöönottoa useisiin grafiikkasuorituksiin, mikä vähentää LLM:ien hajautetun käytön taakkaa. Aloitetaan!

Laajennettava hakujärjestelmä

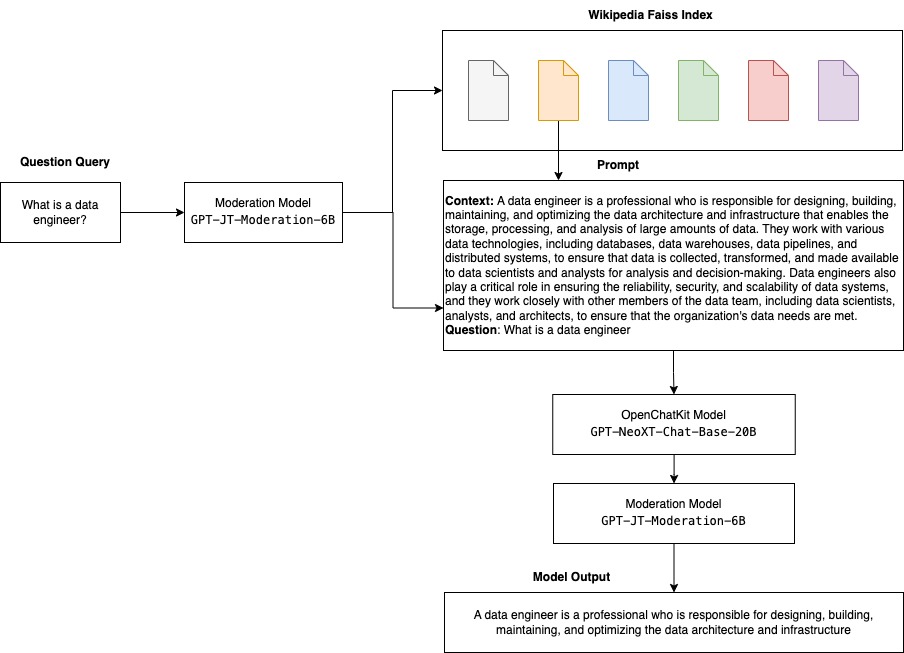

Laajennettava hakujärjestelmä on yksi OpenChatKitin avainkomponenteista. Sen avulla voit mukauttaa botin vastausta suljetun verkkotunnuksen tietokannan perusteella. Vaikka LLM:t pystyvät säilyttämään tosiasiatietonsa malliparametreissaan ja voivat saavuttaa huomattavan suorituskyvyn loppupään NLP-tehtävissä hienosäädettynä, heidän kykynsä käyttää ja ennustaa suljetun verkkoalueen tietämystä tarkasti on rajoitettu. Siksi, kun heille esitetään tietointensiivisiä tehtäviä, heidän suorituskykynsä kärsii tehtäväkohtaisten arkkitehtuurien suorituskyvystä. OpenChatKit-hakujärjestelmän avulla voit lisätä tietoa heidän vastauksissaan ulkoisista tietolähteistä, kuten Wikipediasta, asiakirjavarastoista, API:ista ja muista tietolähteistä.

Hakujärjestelmä mahdollistaa chatbotin pääsyn ajankohtaisiin tietoihin hankkimalla asiaankuuluvia yksityiskohtia vastauksena tiettyyn kyselyyn, mikä tarjoaa mallille tarvittavan kontekstin vastausten luomiseen. Havainnollistaaksemme tämän hakujärjestelmän toimivuutta tarjoamme tukea Wikipedia-artikkelien hakemistolle ja esimerkkikoodin, joka osoittaa, kuinka verkkohaun sovellusliittymä voidaan kutsua tiedonhakuun. Noudattamalla toimitettua dokumentaatiota voit integroida hakujärjestelmän mihin tahansa tietojoukkoon tai API:iin päättelyprosessin aikana, jolloin chatbot voi sisällyttää dynaamisesti päivitettyjä tietoja vastauksiinsa.

Maltillinen malli

Moderointimallit ovat tärkeitä chatbot-sovelluksissa sisällön suodatuksen, laadunvalvonnan, käyttäjien turvallisuuden sekä lakisääteisten ja vaatimustenmukaisuuden kannalta. Moderointi on vaikea ja subjektiivinen tehtävä, ja se riippuu paljon chatbot-sovelluksen toimialueesta. OpenChatKit tarjoaa työkaluja chatbot-sovelluksen moderointiin ja sopimattoman sisällön syöttötekstikehotteiden valvontaan. Moderointimalli tarjoaa hyvän lähtökohdan, jota voidaan mukauttaa ja räätälöidä erilaisiin tarpeisiin.

OpenChatKitissa on 6 miljardin parametrin valvontamalli, GPT-JT-Moderation-6B, joka voi valvoa chatbotia rajoittaakseen syötteet moderoituihin aiheisiin. Vaikka mallissa itsessään on jonkin verran sisäänrakennettua maltillisuutta, TogetherComputer koulutti a GPT-JT-Moderation-6B malli Ontocord.ai:n kanssa OIG-moderoinnin tietojoukko. Tämä malli toimii päächatbotin rinnalla varmistaakseen, että sekä käyttäjän syöte että botin vastaus eivät sisällä sopimattomia tuloksia. Tämän avulla voit myös havaita chatbotille toimialueen ulkopuoliset kysymykset ja ohittaa, kun kysymys ei kuulu chatbotin toimialueeseen.

Seuraava kaavio havainnollistaa OpenChatKit-työnkulkua.

Laajennettavat hakujärjestelmän käyttötapaukset

Vaikka voimme soveltaa tätä tekniikkaa useilla toimialoilla generatiivisten AI-sovellusten rakentamiseen, tässä postauksessa käsittelemme käyttötapauksia rahoitusalalla. Haun lisättyä sukupolvea voidaan käyttää taloustutkimuksessa luomaan automaattisesti tutkimusraportteja tietyistä yrityksistä, toimialoista tai rahoitustuotteista. Haemalla asiaankuuluvia tietoja sisäisistä tietokannoista, talousarkistoista, uutisartikkeleista ja tutkimuspapereista voit luoda kattavia raportteja, joissa on yhteenveto tärkeimmistä näkemyksistä, taloudellisista mittareista, markkinatrendeistä ja sijoitussuosituksista. Tämän ratkaisun avulla voit seurata ja analysoida talousuutisia, markkinatunnelmaa ja trendejä.

Ratkaisun yleiskatsaus

Seuraavat vaiheet liittyvät chatbotin rakentamiseen OpenChatKit-malleja käyttäen ja niiden käyttöönottoon SageMakerissa:

- Lataa chat-pohja

GPT-NeoXT-Chat-Base-20Bmallintaa ja pakata mallin artefaktit, joihin ladataan Amazonin yksinkertainen tallennuspalvelu (Amazon S3). - Käytä SageMaker Large Model Inference (LMI) -säilöä, määritä ominaisuudet ja määritä mukautettu päättelykoodi tämän mallin käyttöönottamiseksi.

- Määritä mallin rinnakkaistekniikat ja käytä päätelmien optimointikirjastoja DJL:n palveluominaisuuksissa. Käytämme Hugging Face Acceleratea DJL-tarjoilun moottorina. Lisäksi määrittelemme tensorin rinnakkaiskonfiguraatiot mallin osiointia varten.

- Luo SageMaker-malli ja päätepistemääritys ja ota SageMaker-päätepiste käyttöön.

Voit seurata mukana ajamalla muistikirjaa GitHub repo.

Lataa OpenChatKit-malli

Ensin lataamme OpenChatKit-perusmallin. Käytämme huggingface_hub Ja käyttää snapshot_download ladataksesi mallin, joka lataa koko arkiston tietyssä versiossa. Lataukset tehdään samanaikaisesti prosessin nopeuttamiseksi. Katso seuraava koodi:

DJL Tarjoiluominaisuudet

Voit käyttää SageMaker LMI -säilöjä isännöimään suuria generatiivisia tekoälymalleja mukautetulla päätelmäkoodilla antamatta omaa päättelykoodiasi. Tämä on erittäin hyödyllistä, kun syöttödatan mukautettua esikäsittelyä tai mallin ennusteiden jälkikäsittelyä ei ole. Voit myös ottaa mallin käyttöön mukautetun päättelykoodin avulla. Tässä viestissä näytämme, kuinka OpenChatKit-malleja otetaan käyttöön mukautetulla päättelykoodilla.

SageMaker odottaa mallin artefakteja tar-muodossa. Luomme jokaisen OpenChatKit-mallin seuraavilla tiedostoilla: serving.properties ja model.py.

- serving.properties konfiguraatiotiedosto ilmoittaa DJL Servingille, mitä mallin rinnakkais- ja päätelmien optimointikirjastoja haluat käyttää. Seuraavassa on luettelo asetuksista, joita käytämme tässä asetustiedostossa:

Tämä sisältää seuraavat parametrit:

- moottori – Moottori DJL:n käyttöön.

- option.entryPoint – Aloituspisteen Python-tiedosto tai -moduuli. Tämän pitäisi olla linjassa käytettävän moottorin kanssa.

- option.s3url – Aseta tämä mallin sisältävän S3-alueen URI:ksi.

- option.modelid – Jos haluat ladata mallin osoitteesta huggingface.co, voit asettaa

option.modelidesikoulutetun mallin mallitunnukseen, jota isännöi huggingface.co:n mallivarastossa (https://huggingface.co/models). Säilö käyttää tätä mallitunnusta vastaavan mallivaraston lataamiseen osoitteessa huggingface.co. - option.tensor_parallel_degree – Aseta tämä niiden GPU-laitteiden lukumääräksi, joille DeepSpeed tarvitsee mallin osioinnin. Tämä parametri ohjaa myös työntekijöiden määrää mallia kohti, jotka käynnistetään, kun DJL Serving toimii. Jos meillä on esimerkiksi 8 GPU-kone ja luomme kahdeksan osiota, meillä on yksi työntekijä mallia kohden palvelemaan pyyntöjä. On tarpeen virittää rinnakkaisuuden aste ja tunnistaa optimaalinen arvo tietylle malliarkkitehtuurille ja laitteistoalustalle. Kutsumme tätä kyvyksi päätelmiin mukautettu rinnakkaisuus.

Mainita Kokoonpanot ja asetukset kattavan luettelon vaihtoehdoista.

OpenChatKit-mallit

OpenChatKit-perusmallin toteutuksessa on seuraavat neljä tiedostoa:

- malli.py – Tämä tiedosto toteuttaa OpenChatKit GPT-NeoX -päämallin käsittelylogiikan. Se vastaanottaa päättelyn syöttöpyynnön, lataa mallin, lataa Wikipedia-hakemiston ja palvelee vastausta. Viitata

model.py(luotu osa muistikirjasta) saadaksesi lisätietoja.model.pykäyttää seuraavia avainluokkia:- OpenChatKitService – Tämä käsittelee tietojen välittämisen GPT-NeoX-mallin, Faiss-haun ja keskusteluobjektin välillä.

WikipediaIndexjaConversationobjektit alustetaan ja syötetyt chat-keskustelut lähetetään hakemistoon etsimään asiaankuuluvaa sisältöä Wikipediasta. Tämä luo myös yksilöllisen tunnuksen jokaiselle kutsulle, jos sellaista ei toimiteta kehotteiden tallentamista varten Amazon DynamoDB. - Chat-malli – Tämä luokka lataa mallin ja tokenisaattorin ja luo vastauksen. Se käsittelee mallin osioinnin useiden GPU:iden kesken

tensor_parallel_degree, ja määrittäädtypesjadevice_map. Kehotteet välitetään mallille vastausten luomiseksi. PysäytyskriteeriStopWordsCriteriaon määritetty generoimaan tuottamaan bottivastauksen vain päätelmän perusteella. - Moderaatiomalli – Meillä on käytössä kaksi moderointimallia

ModerationModelluokka: syöttömalli, joka ilmaisee chat-mallille, että syöte ei sovellu päättelytuloksen ohittamiseen, ja tulosmalli, joka ohittaa päättelytuloksen. Luokittelemme syöttökehotteen ja lähtövasteen seuraavilla mahdollisilla nimikkeillä:- rento

- vaatii varovaisuutta

- tarvitsee toimia (tämä on merkitty mallin valvottavaksi)

- vaatii ehkä varovaisuutta

- vaatii varmaan varovaisuutta

- OpenChatKitService – Tämä käsittelee tietojen välittämisen GPT-NeoX-mallin, Faiss-haun ja keskusteluobjektin välillä.

- wikipedia_prepare.py – Tämä tiedosto käsittelee Wikipedia-hakemiston lataamisen ja valmistelemisen. Tässä viestissä käytämme Hugging Face -tietojoukoissa olevaa Wikipedia-hakemistoa. Jotta Wikipedia-asiakirjoista voidaan etsiä asiaankuuluvaa tekstiä, hakemisto on ladattava Hugging Facesta, koska sitä ei ole pakattu muualle. The

wikipedia_prepare.pytiedosto on vastuussa latauksen käsittelystä tuonnin yhteydessä. Vain yksi prosessi useista, jotka ovat käynnissä päätelmiä varten, voi kloonata arkiston. Loput odottavat, kunnes tiedostot ovat paikallisessa tiedostojärjestelmässä. - wikipedia.py – Tätä tiedostoa käytetään asiayhteyteen liittyvien asiakirjojen etsimiseen Wikipedian hakemistosta. Syöttökysely tokenisoidaan ja upotukset luodaan käyttämällä

mean_pooling. Laskemme kosinin samankaltaisuusetäisyyden mittareita kyselyn upotuksen ja Wikipedia-hakemiston välillä kontekstuaalisesti relevanttien Wikipedia-lauseiden hakemiseksi. Viitatawikipedia.pytäytäntöönpanon yksityiskohtia varten.

- keskustelu.py – Tätä tiedostoa käytetään keskustelusäikeen tallentamiseen ja hakemiseen DynamoDB:ssä mallille ja käyttäjälle siirtämistä varten.

conversation.pyon mukautettu avoimen lähdekoodin OpenChatKit-arkistosta. Tämä tiedosto vastaa objektin määrittämisestä, joka tallentaa keskustelun käännökset ihmisen ja mallin välillä. Tämän avulla malli pystyy säilyttämään istunnon keskustelulle, jolloin käyttäjä voi viitata aikaisempiin viesteihin. Koska SageMaker-päätepistekutsut ovat tilattomia, tämä keskustelu on tallennettava päätepisteiden ulkopuoliseen sijaintiin. Käynnistyksen yhteydessä ilmentymä luo DynamoDB-taulukon, jos sitä ei ole olemassa. Kaikki keskustelun päivitykset tallennetaan sitten DynamoDB:hensession_idavain, jonka päätepiste luo. Kaikki kutsut, joissa on istuntotunnus, hakevat siihen liittyvän keskustelumerkkijonon ja päivittävät sen tarpeen mukaan.

Rakenna LMI-johtopäätössäilö mukautetuilla riippuvuuksilla

Hakemistohaku käyttää Facebookin hakua Faiss kirjasto samankaltaisuushaun suorittamista varten. Koska tämä ei sisälly perus-LMI-näköistiedostoon, säilöä on mukautettava tämän kirjaston asentamista varten. Seuraava koodi määrittelee Docker-tiedoston, joka asentaa Faissin lähteestä muiden botin päätepisteen tarvitsemien kirjastojen rinnalle. Käytämme sm-docker apuohjelma kuvan rakentamiseen ja työntämiseen Amazonin elastisten säiliörekisteri (Amazon ECR) alkaen Amazon SageMaker Studio. Viitata Amazon SageMaker Studio Image Build CLI: n avulla voit luoda säilökuvia Studio-muistikirjoistasi lisätietoja.

DJL-säilössä ei ole asennettuna Condaa, joten Faiss on kloonattava ja käännettävä lähteestä. Faissin asentaminen edellyttää, että BLAS-sovellusliittymien ja Python-tuen käytön riippuvuudet asennetaan. Kun nämä paketit on asennettu, Faiss konfiguroidaan käyttämään AVX2:ta ja CUDA:ta ennen kuin se käännetään asennettujen Python-laajennusten kanssa.

pandas, fastparquet, boto3ja git-lfs asennetaan myöhemmin, koska niitä tarvitaan hakemistotiedostojen lataamiseen ja lukemiseen.

Luo malli

Nyt kun meillä on Docker-kuva Amazon ECR:ssä, voimme jatkaa SageMaker-malliobjektin luomista OpenChatKit-malleille. Otamme käyttöön GPT-NeoXT-Chat-Base-20B tulon ja lähdön moderointimalleja käyttäen GPT-JT-Moderation-6B. Viitata luo_malli lisätietoja.

Määritä päätepiste

Seuraavaksi määritämme OpenChatKit-mallien päätepisteen kokoonpanot. Otamme mallit käyttöön käyttämällä ml.g5.12xlarge ilmentymätyyppiä. Viitata create_endpoint_config lisätietoja.

Ota päätepiste käyttöön

Lopuksi luomme päätepisteen käyttämällä mallia ja päätepistekokoonpanoa, jonka määritimme edellisissä vaiheissa:

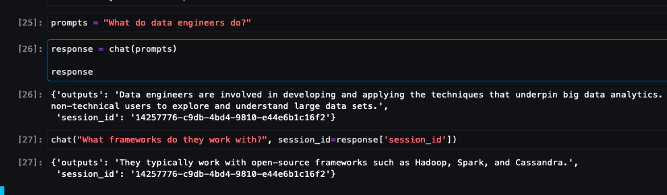

Tee johtopäätös OpenChatKit-malleista

Nyt on aika lähettää johtopäätöspyynnöt mallille ja saada vastaukset. Välitämme syöttötekstikehotteen ja malliparametrit, kuten temperature, top_kja max_new_tokens. Chatbotin vastausten laatu perustuu määritettyihin parametreihin, joten on suositeltavaa vertailla mallin suorituskykyä näihin parametreihin, jotta löydät käyttötapaukseesi optimaalisen asetuksen. Tulokehote lähetetään ensin syötteen moderointimalliin ja tuloste lähetetään osoitteeseen ChatModel vastausten luomiseen. Tämän vaiheen aikana malli käyttää Wikipedia-hakemistoa hakeakseen malliin kontekstuaalisesti relevantteja osia kehotteena saada verkkotunnuskohtaisia vastauksia mallista. Lopuksi mallivastaus lähetetään lähdön moderointimalliin luokituksen tarkistamiseksi, ja sitten vastaukset palautetaan. Katso seuraava koodi:

Katso esimerkki chat-vuorovaikutuksista alla.

Puhdistaa

Noudata julkaisun puhdistusosion ohjeita poistaaksesi osana tätä viestiä annetut resurssit tarpeettomien kulujen välttämiseksi. Viitata Amazon SageMaker -hinnoittelu saadaksesi lisätietoja päättelytapahtumien kustannuksista.

Yhteenveto

Tässä viestissä keskustelimme avoimen lähdekoodin LLM:ien tärkeydestä ja OpenChatKit-mallin käyttöönotosta SageMakerissa seuraavan sukupolven chatbot-sovellusten rakentamiseen. Keskustelimme OpenChatKit-mallien eri osista, moderointimalleista ja ulkoisen tietolähteen, kuten Wikipedian, käyttämisestä lisätyn sukupolven (RAG) työnkulkuihin. Löydät vaiheittaiset ohjeet kohdasta GitHub-muistikirja. Kerro meille upeista chatbot-sovelluksista, joita olet rakentamassa. Kippis!

Tietoja Tekijät

Dhawal Patel on AWS:n koneoppimisarkkitehti. Hän on työskennellyt organisaatioiden kanssa suurista yrityksistä keskikokoisiin startup-yrityksiin hajautettuun tietojenkäsittelyyn ja tekoälyyn liittyvien ongelmien parissa. Hän keskittyy syväoppimiseen, mukaan lukien NLP- ja Computer Vision -alueet. Hän auttaa asiakkaita tekemään korkean suorituskyvyn mallipäätelmiä SageMakerissa.

Dhawal Patel on AWS:n koneoppimisarkkitehti. Hän on työskennellyt organisaatioiden kanssa suurista yrityksistä keskikokoisiin startup-yrityksiin hajautettuun tietojenkäsittelyyn ja tekoälyyn liittyvien ongelmien parissa. Hän keskittyy syväoppimiseen, mukaan lukien NLP- ja Computer Vision -alueet. Hän auttaa asiakkaita tekemään korkean suorituskyvyn mallipäätelmiä SageMakerissa.

Vikram Elango on vanhempi AIML Specialist Solutions -arkkitehti AWS:ssä, joka sijaitsee Virginiassa, Yhdysvalloissa. Hän keskittyy tällä hetkellä generatiiviseen tekoälyyn, LLM:ihin, nopeaan suunnitteluun, suurten mallipäätelmien optimointiin ja ML:n skaalaamiseen eri yrityksissä. Vikram auttaa rahoitus- ja vakuutusalan asiakkaita suunnittelu- ja ajatusjohtajuudella rakentamaan ja ottamaan käyttöön koneoppimissovelluksia mittakaavassa. Vapaa-ajallaan hän nauttii matkustamisesta, vaeltamisesta, ruoanlaitosta ja telttailusta perheensä kanssa.

Vikram Elango on vanhempi AIML Specialist Solutions -arkkitehti AWS:ssä, joka sijaitsee Virginiassa, Yhdysvalloissa. Hän keskittyy tällä hetkellä generatiiviseen tekoälyyn, LLM:ihin, nopeaan suunnitteluun, suurten mallipäätelmien optimointiin ja ML:n skaalaamiseen eri yrityksissä. Vikram auttaa rahoitus- ja vakuutusalan asiakkaita suunnittelu- ja ajatusjohtajuudella rakentamaan ja ottamaan käyttöön koneoppimissovelluksia mittakaavassa. Vapaa-ajallaan hän nauttii matkustamisesta, vaeltamisesta, ruoanlaitosta ja telttailusta perheensä kanssa.

Andrew Smith on pilvituki-insinööri AWS:n SageMaker, Vision & Other -tiimissä Sydneyssä, Australiassa. Hän tukee asiakkaita, jotka käyttävät monia AI/ML-palveluita AWS:ssä, ja hänellä on asiantuntemusta työskennellä Amazon SageMakerin kanssa. Työn ulkopuolella hän viettää mielellään aikaa ystävien ja perheen kanssa sekä oppii eri tekniikoista.

Andrew Smith on pilvituki-insinööri AWS:n SageMaker, Vision & Other -tiimissä Sydneyssä, Australiassa. Hän tukee asiakkaita, jotka käyttävät monia AI/ML-palveluita AWS:ssä, ja hänellä on asiantuntemusta työskennellä Amazon SageMakerin kanssa. Työn ulkopuolella hän viettää mielellään aikaa ystävien ja perheen kanssa sekä oppii eri tekniikoista.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- EVM Finance. Hajautetun rahoituksen yhtenäinen käyttöliittymä. Pääsy tästä.

- Quantum Media Group. IR/PR vahvistettu. Pääsy tästä.

- PlatoAiStream. Web3 Data Intelligence. Tietoa laajennettu. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/build-custom-chatbot-applications-using-openchatkit-models-on-amazon-sagemaker/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 1

- 10

- 100

- 11

- 14

- 15%

- 17

- 195

- 20

- 2023

- 30

- 40

- 7

- 8

- a

- kyky

- pystyy

- Meistä

- kiihdyttää

- pääsy

- tarkkuus

- tarkasti

- Saavuttaa

- poikki

- lisä-

- Lisäksi

- osoite

- kehittynyt

- Jälkeen

- jälkeenpäin

- vastaan

- AI

- ai käyttötapauksia

- AI / ML

- AIML

- kohdista

- Kaikki

- Salliminen

- mahdollistaa

- pitkin

- rinnalla

- Myös

- Vaikka

- hämmästyttävä

- Amazon

- Amazon Sage Maker

- Amazon SageMaker Studio

- Amazon Web Services

- an

- analysoida

- ja

- vastaus

- vastauksia

- Kaikki

- api

- API

- Hakemus

- sovellukset

- käyttää

- APT

- arkkitehtuuri

- arkisto

- OVAT

- artikkelit

- keinotekoinen

- tekoäly

- AS

- liittyvä

- At

- täydennetty

- Australia

- automaattisesti

- saatavissa

- välttää

- AWS

- pohja

- perustua

- Lähtötilanne

- BE

- koska

- tulevat

- tulee

- ennen

- ovat

- alle

- benchmark

- välillä

- harhat

- BIN

- Blocks

- elin

- Bot

- sekä

- rakentaa

- Rakentaminen

- rakennettu

- taakka

- liiketoiminta

- Business Applications

- by

- soittaa

- CAN

- Koko

- hiili

- tapaus

- tapauksissa

- CD

- maksut

- chatbot

- chatbots

- tarkastaa

- luokka

- luokat

- luokittelu

- luokitella

- suljettu

- pilvi

- CO

- koodi

- yhteistyö

- yhteisö

- Yritykset

- noudattaminen

- osat

- kattava

- Laskea

- tietokone

- Tietokoneen visio

- tietojenkäsittely

- huolenaiheet

- Konfigurointi

- määritetty

- sisältää

- Kontti

- Kontit

- sisältää

- pitoisuus

- tausta

- edistävät

- ohjaus

- valvonta

- Keskustelu

- keskustelut

- vastaava

- Hinta

- luoda

- luotu

- luo

- Luominen

- kriteerit

- Nykyinen

- Tällä hetkellä

- asiakassuhde

- Asiakkaat

- räätälöidä

- räätälöityjä

- tiedot

- aineistot

- syvä

- syvä oppiminen

- määritelty

- määrittelee

- määrittelemällä

- Aste

- vaatii

- Democratizing

- osoittaa

- esittelyssä

- riippuu

- sijoittaa

- käyttöönotto

- Malli

- suunniteltu

- yksityiskohdat

- kehittäjille

- kehitys

- Laitteet

- eri

- vaikea

- vaikeudet

- pohtia

- keskusteltiin

- etäisyys

- jaettu

- hajautettu laskenta

- do

- Satamatyöläinen

- asiakirja

- dokumentointi

- asiakirjat

- ei

- ei

- verkkotunnuksen

- verkkotunnuksia

- Dont

- download

- lataukset

- aikana

- dynaamisesti

- kukin

- muu

- muualla

- upottamisen

- Työllisiä

- mahdollistaa

- mahdollistaa

- kannustaa

- päätepiste

- valvoa

- Moottori

- insinööri

- Tekniikka

- yrityksille

- Koko

- merkintä

- olennainen

- eettinen

- EVER

- esimerkki

- olla

- odottaa

- asiantuntemus

- laajennukset

- ulkoinen

- erittäin

- Kasvot

- perhe

- Muoti

- filee

- Asiakirjat

- suodattaa

- suodatus

- Vihdoin

- taloudellinen

- talousuutisia

- rahoitustuotteet

- Löytää

- Etunimi

- Merkityt

- keskityttiin

- keskittyy

- tarkennus

- seurata

- jälkeen

- seuraa

- varten

- muoto

- Edistää

- neljä

- ystäviä

- alkaen

- täysin

- toiminnallisuus

- yleinen tarkoitus

- tuottaa

- syntyy

- synnyttää

- sukupolvi

- generatiivinen

- Generatiivinen AI

- saada

- mennä

- tietty

- hyvä

- GPU

- GPU

- Vetimet

- Käsittely

- Palvelimet

- Olla

- he

- auttaa

- Korkea

- korkea suorituskyky

- hänen

- isäntä

- isännöi

- hotellit

- Miten

- Miten

- HTML

- http

- HTTPS

- HalaaKasvot

- ihmisen

- ID

- tunnistaa

- if

- havainnollistaa

- kuva

- kuvien

- täytäntöönpano

- työkoneet

- tuoda

- merkitys

- tärkeä

- parannus

- in

- mukana

- Mukaan lukien

- sisällyttää

- lisää

- indeksi

- osoittaa

- ilmaisee

- teollisuuden

- teollisuus

- tiedot

- Innovaatio

- panos

- tuloa

- sisällä

- oivalluksia

- asentaa

- asennetaan

- esimerkki

- ohjeet

- vakuutus

- yhdistää

- Älykkyys

- vuorovaikutukset

- sisäinen

- interventio

- tulee

- investointi

- sijoitussuosituksia

- osallistuva

- IT

- SEN

- itse

- Jaava

- jpg

- json

- avain

- Tietää

- tuntemus

- tarrat

- Kieli

- suuri

- Suuret yritykset

- Viive

- Johto

- oppiminen

- vähiten

- juridinen

- antaa

- Vaikutusvalta

- kirjastot

- Kirjasto

- Lisenssi

- pitää

- RAJOITA

- Lista

- liekki

- OTK

- kuormat

- paikallinen

- sijainti

- logiikka

- Erä

- Matala

- kone

- koneoppiminen

- tehty

- tärkein

- tehdä

- Tekeminen

- monet

- maaliskuu

- markkinat

- markkinoiden mielipide

- Markkinoiden trendit

- naamio

- matching

- Tavata

- viestien

- menetelmät

- Metrics

- miljoona

- ML

- malli

- mallit

- maltillisuus

- Moduulit

- monitori

- lisää

- moninkertainen

- nimi

- Luonnollinen

- Luonnollinen kielen käsittely

- välttämätön

- Tarve

- tarvitaan

- tarpeet

- negatiivinen

- uutiset

- seuraavan sukupolven

- NLP

- Nro

- muistikirja

- numero

- useat

- objekti

- esineet

- esteitä

- saada

- of

- kampanja

- on

- ONE

- vain

- avoimen lähdekoodin

- optimaalinen

- optimointi

- Vaihtoehto

- Vaihtoehdot

- or

- organisaatio

- organisaatioiden

- OS

- Muut

- ulos

- ulostulo

- ulkopuolella

- yli

- ohittaa

- oma

- paketti

- pakattu

- paketit

- pandas

- paperit

- Parallel

- parametri

- parametrit

- osa

- kulkea

- Hyväksytty

- Ohimenevä

- polku

- Kuvio

- suorituskyky

- esittävä

- foorumi

- Platon

- Platonin tietotieto

- PlatonData

- Kohta

- Suosittu

- mahdollinen

- Kirje

- mahdollinen

- powered

- voimakas

- ennustaa

- Ennusteet

- valmistelee

- esittää

- esitetty

- edellinen

- Pääasiallinen

- ongelmia

- prosessi

- käsittely

- tuottaa

- Tuotteemme

- Ohjelmointi

- ominaisuudet

- toimittaa

- mikäli

- tarjoaa

- tarjoamalla

- tarkoitus

- Työnnä

- Python

- pytorch

- laatu

- kysymys

- kysymykset

- alue

- alainen

- Lukeminen

- syistä

- vastaanottaa

- suosituksia

- suositeltu

- vähentämällä

- liittyvä

- julkaistu

- merkityksellinen

- jäännökset

- huomattava

- Raportit

- säilytyspaikka

- pyyntö

- pyynnöt

- tarvitaan

- tutkimus

- Tutkijat

- Esittelymateriaalit

- vastaus

- vasteet

- vastuullinen

- REST

- rajoitettu

- johtua

- tulokset

- säilyttää

- palata

- ajaa

- juoksu

- Turvallisuus

- sagemaker

- Asteikko

- skaalaus

- Haku

- haku

- Osa

- osiot

- nähdä

- lähettää

- lähetetty

- tuomita

- näkemys

- palvella

- palvelee

- Palvelut

- palvelevat

- Istunto

- setti

- asetus

- settings

- shouldnt

- näyttää

- Yksinkertainen

- koska

- single

- melkoinen

- Koko

- Kuva

- So

- ratkaisu

- Ratkaisumme

- jonkin verran

- hienostunut

- lähde

- Lähteet

- asiantuntija

- erikoistunut

- erityinen

- määritelty

- nopeus

- menot

- alkoi

- käynnistyksen

- Startups

- Vaihe

- Askeleet

- pysäyttäminen

- Levytila

- tallennettu

- varastot

- tallentamiseksi

- jono

- studio

- Onnistuneesti

- niin

- kärsii

- yhteenveto

- toimitetaan

- toimittaa

- tuki

- Tukee

- sydney

- järjestelmä

- taulukko

- Tehtävä

- tehtävät

- joukkue-

- tekniikat

- Technologies

- Elektroniikka

- että

- -

- Lähde

- heidän

- Niitä

- sitten

- Siellä.

- siten

- siksi

- Nämä

- tätä

- ajatus

- ajatusjohtajuus

- suoritusteho

- aika

- että

- yhdessä

- tokenized

- työkalut

- koulutettu

- koulutus

- Läpinäkyvyys

- Matkustaminen

- Trendit

- totta

- kääntyy

- kaksi

- tyyppi

- varten

- ymmärtää

- unique

- Yleismaailmallinen

- asti

- Päivitykset

- päivitetty

- Päivitykset

- ladattu

- us

- käyttää

- käyttölaukku

- käytetty

- käyttäjä

- Käyttäjät

- käyttötarkoituksiin

- käyttämällä

- hyödyllisyys

- arvo

- eri

- VICUNA

- virginia

- visio

- odottaa

- haluta

- we

- verkko

- verkkopalvelut

- HYVIN

- Mitä

- kun

- joka

- leveä

- Laaja valikoima

- wikipedia

- tulee

- with

- ilman

- Referenssit

- työskenteli

- työntekijä

- työntekijöitä

- työnkulku

- työnkulkuja

- työskentely

- toimii

- olisi

- X

- Voit

- Sinun

- zephyrnet