A mai napon örömmel jelentjük be, hogy a Meta által kifejlesztett Code Llama alapozó modellek elérhetőek az ügyfelek számára Amazon SageMaker JumpStart egyetlen kattintással üzembe helyezhető a következtetés futtatásához. A Code Llama egy korszerű nagynyelvi modell (LLM), amely képes kódot és természetes nyelvet generálni a kódról mind a kódból, mind a természetes nyelvi promptokból. Kipróbálhatja ezt a modellt a SageMaker JumpStarttal, egy gépi tanulási (ML) központtal, amely hozzáférést biztosít az algoritmusokhoz, modellekhez és ML-megoldásokhoz, így gyorsan elkezdheti az ML használatát. Ebben a bejegyzésben bemutatjuk, hogyan lehet felfedezni és telepíteni a Code Llama modellt a SageMaker JumpStart segítségével.

Code Llama

A Code Llama által kiadott modell meta Ez a csúcstechnológiás modell a fejlesztők programozási feladatainak termelékenységének javítására szolgál azáltal, hogy segíti őket a kiváló minőségű, jól dokumentált kód létrehozásában. A modellek a Python, a C++, a Java, a PHP, a C#, a TypeScript és a Bash nyelveken jeleskednek, és megtakaríthatják a fejlesztők idejét, és hatékonyabbá tehetik a szoftveres munkafolyamatokat.

Három változatban kapható, amelyeket úgy terveztek, hogy az alkalmazások széles skáláját lefedjék: az alapmodell (Code Llama), egy Python-specifikus modell (Code Llama Python) és egy utasításkövető modell a természetes nyelvi utasítások megértéséhez (Code Llama Instruct). Minden Code Llama változat négy méretben kapható: 7B, 13B, 34B és 70B paraméterekkel. A 7B és 13B alap- és utasításváltozatok támogatják a környező tartalom alapján történő kitöltést, így ideálisak kódsegéd alkalmazásokhoz. A modelleket a Llama 2 alapján tervezték, majd 500 milliárd kódadat tokenre tanították, a Python speciális verzióját pedig növekményes 100 milliárd tokenre. A Code Llama modellek stabil generációkat biztosítanak akár 100,000 16,000 kontextusjelzővel. Minden modell 100,000 XNUMX tokenből álló sorozatokra van kiképezve, és akár XNUMX XNUMX tokennel is javítottak a bemeneteken.

A modell ugyanezen cím alatt érhető el közösségi engedély, mint Llama 2.

Alapozó modellek a SageMakerben

A SageMaker JumpStart számos modellhez biztosít hozzáférést a népszerű modellközpontokból, beleértve a Hugging Face-t, a PyTorch Hub-ot és a TensorFlow Hub-ot, amelyeket a SageMaker ML-fejlesztési munkafolyamataiban használhat fel. Az ML közelmúltbeli fejlődése a modellek új osztályát eredményezte alapozó modellek, amelyek jellemzően több milliárd paraméterre vannak kiképezve, és a felhasználási esetek széles kategóriájához adaptálhatók, mint például a szövegösszegzés, a digitális művészet generálása és a nyelvi fordítás. Mivel ezeknek a modelleknek a betanítása költséges, az ügyfelek a meglévő, előre betanított alapozómodelleket szeretnék használni, és szükség szerint finomhangolni őket, ahelyett, hogy maguk képeznék ki ezeket a modelleket. A SageMaker a modellek válogatott listáját kínálja, amelyek közül választhat a SageMaker konzolon.

A SageMaker JumpStartban különböző modellszolgáltatóktól származó alapozó modelleket találhat, így gyorsan elkezdheti az alapozó modelleket. Különböző feladatokon vagy modellszolgáltatókon alapuló alapmodelleket találhat, és könnyen áttekintheti a modell jellemzőit és használati feltételeit. Ezeket a modelleket egy teszt UI widget segítségével is kipróbálhatja. Ha nagyszabású alapmodellt szeretne használni, a SageMaker elhagyása nélkül megteheti a modellszolgáltatók előre elkészített notebookjainak használatával. Mivel a modelleket az AWS-en tárolják és telepítik, biztos lehet benne, hogy adatait – akár a modell kiértékeléséhez, akár nagyszabású használatához használják – soha nem osztják meg harmadik felekkel.

Fedezze fel a Code Llama modellt a SageMaker JumpStartban

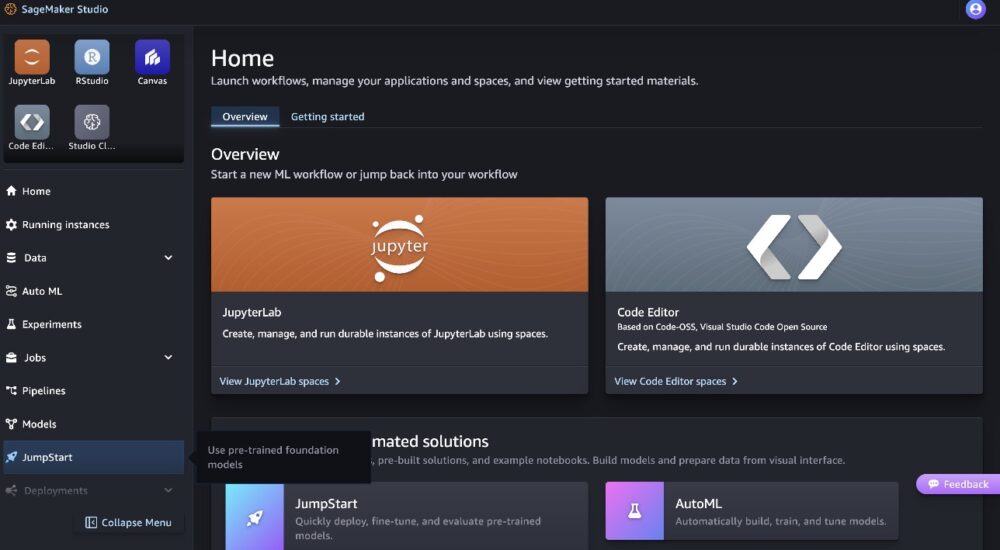

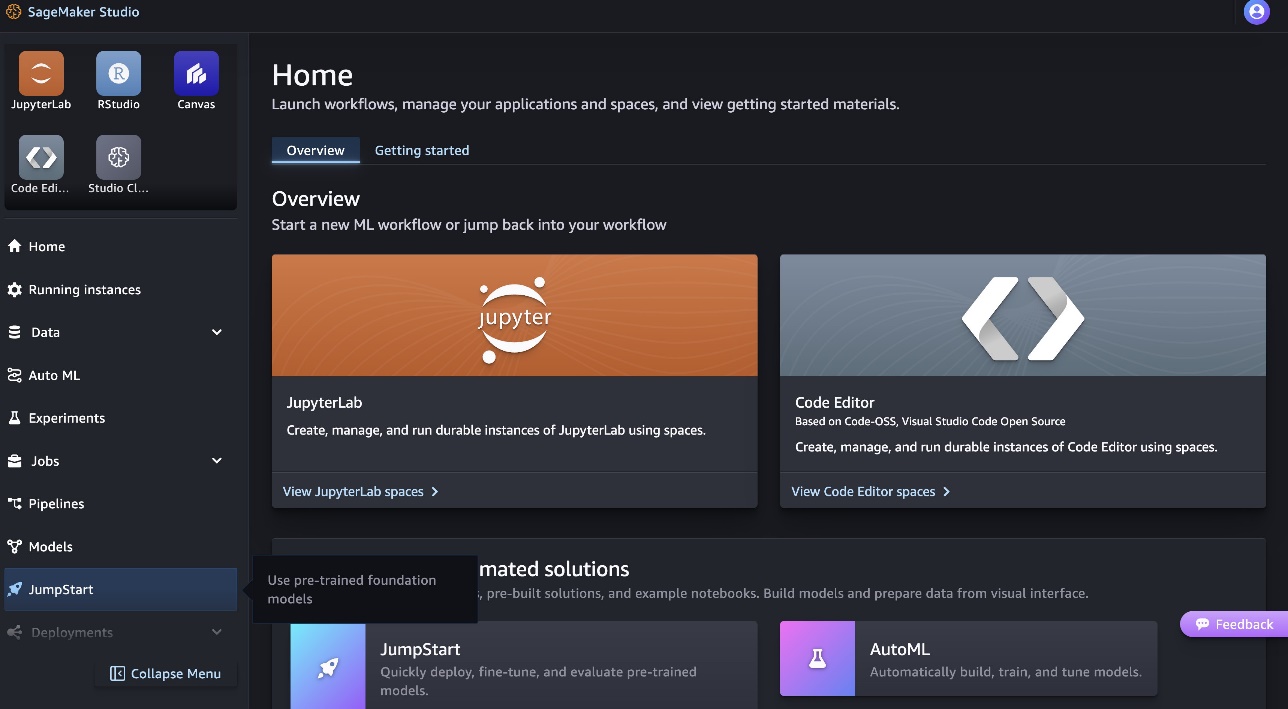

A Code Llama 70B modell üzembe helyezéséhez hajtsa végre a következő lépéseket Amazon SageMaker Studio:

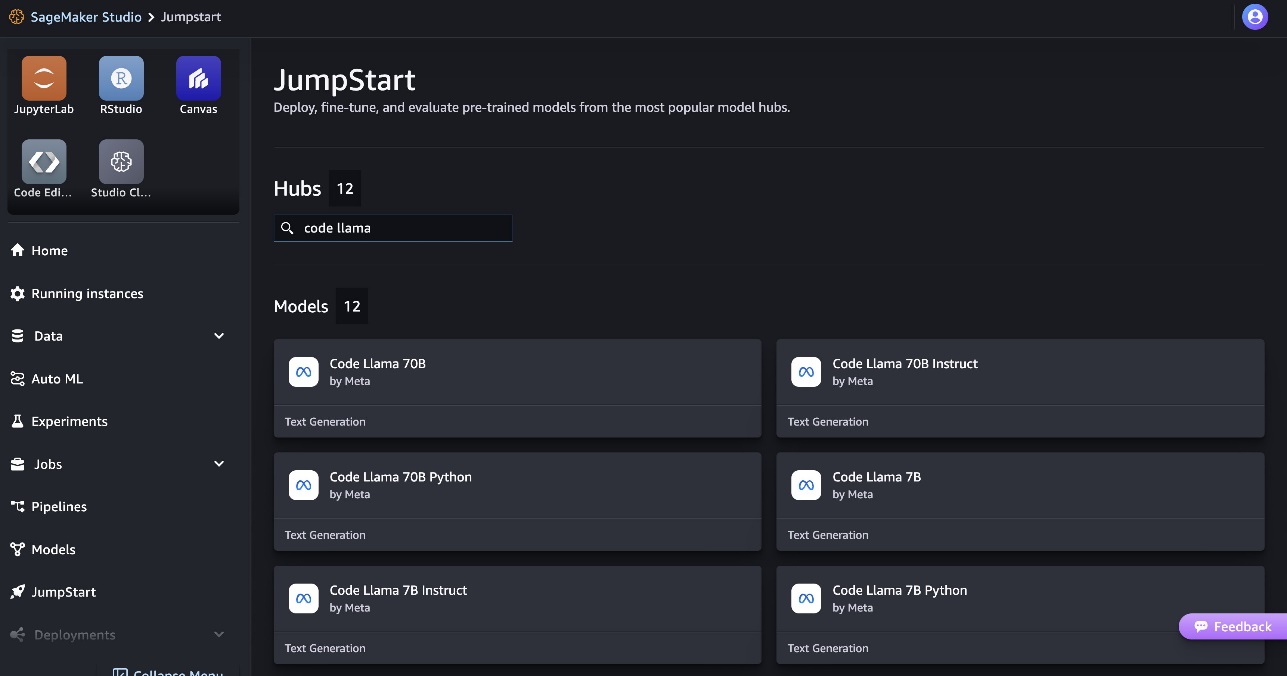

- A SageMaker Studio kezdőlapján válassza a lehetőséget ugrás indítás a navigációs ablaktáblában.

- Keressen Code Llama modelleket, és válassza ki a Code Llama 70B modellt a megjelenített modellek listájából.

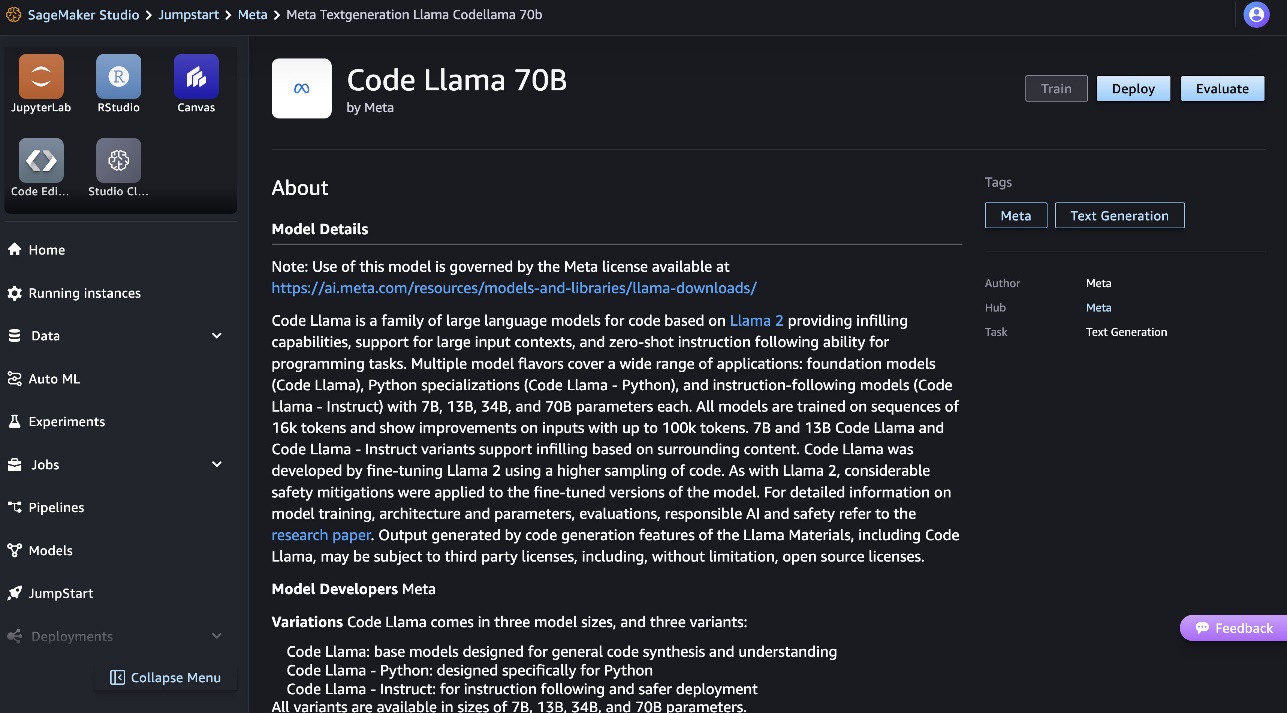

A modellről további információkat a Code Llama 70B modellkártyán talál.

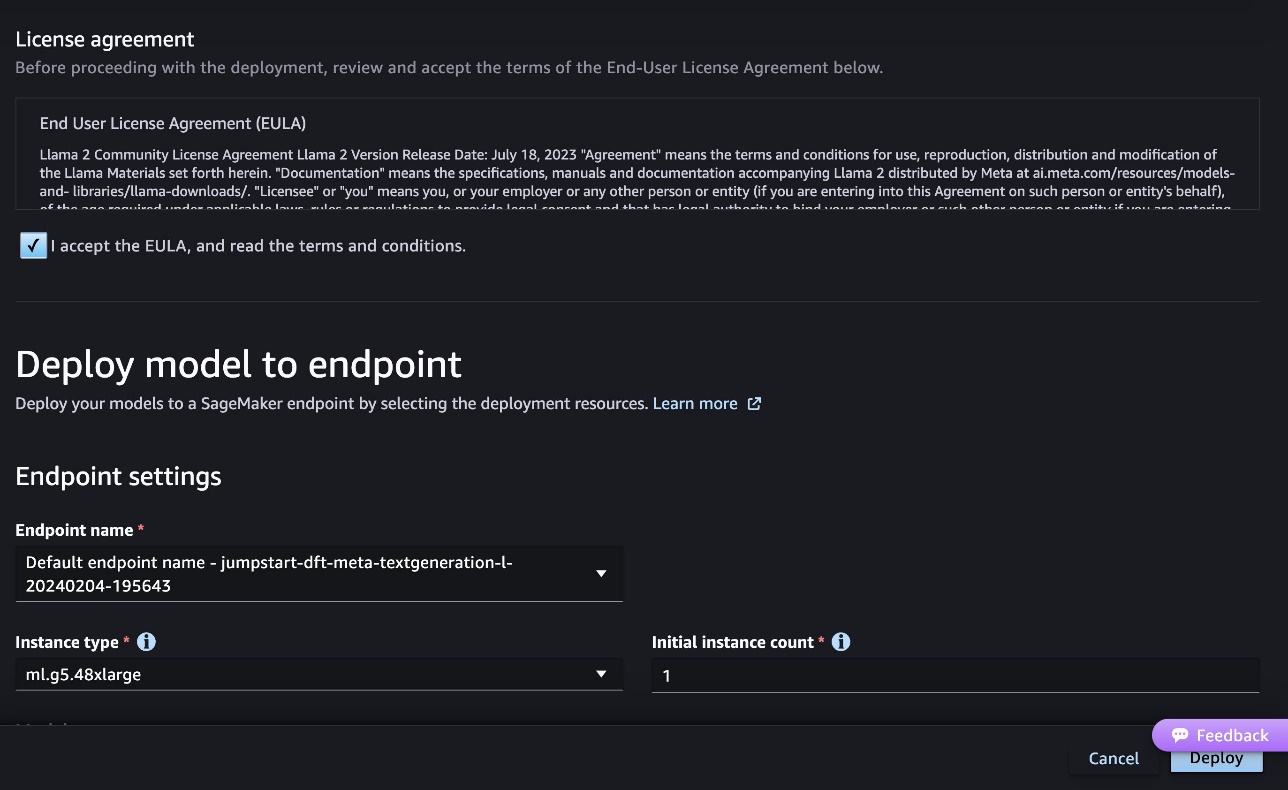

A következő képernyőkép a végpont beállításait mutatja. Módosíthatja a beállításokat, vagy használhatja az alapértelmezetteket.

- Fogadja el a végfelhasználói licencszerződést (EULA), és válassza ki Telepítése.

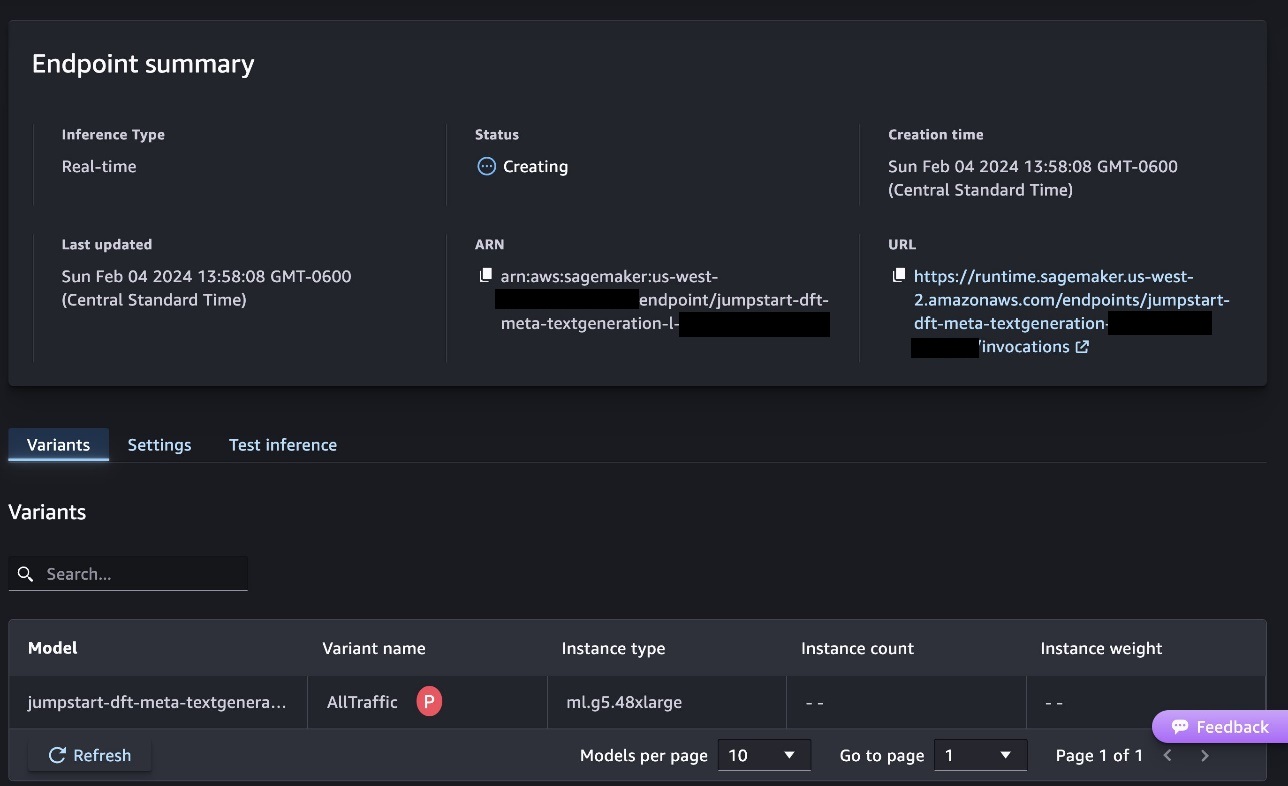

Ezzel elindul a végpont üzembe helyezési folyamata, amint az a következő képernyőképen látható.

Telepítse a modellt a SageMaker Python SDK-val

Alternatív megoldásként a példajegyzetfüzeten keresztül is telepítheti, ha kiválasztja Nyissa meg a Jegyzetfüzetet a Classic Studio modell részletes oldalán. A példajegyzetfüzet teljes körű útmutatást nyújt a modell telepítéséhez a következtetések levonásához és az erőforrások tisztításához.

A notebook használatával történő telepítéshez először kiválasztjuk a megfelelő modellt, amelyet a model_id. A kiválasztott modellek bármelyikét üzembe helyezheti a SageMakerben a következő kóddal:

Ez a SageMaker modellt alapértelmezett konfigurációkkal telepíti, beleértve az alapértelmezett példánytípust és az alapértelmezett VPC-konfigurációkat. Módosíthatja ezeket a konfigurációkat a nem alapértelmezett értékek megadásával JumpStartModel. Vegye figyelembe, hogy alapértelmezés szerint accept_eula be van állítva False. Be kell állítani accept_eula=True a végpont sikeres telepítéséhez. Ezzel elfogadja a felhasználói licencszerződést és a korábban említett elfogadható használati szabályzatot. Te is letöltés a licencszerződést.

Hívjon meg egy SageMaker végpontot

A végpont üzembe helyezése után következtetést vonhat le a Boto3 vagy a SageMaker Python SDK használatával. A következő kódban a SageMaker Python SDK-t használjuk a modell meghívására következtetés céljából, és kinyomtatjuk a választ:

A funkció print_response vesz egy hasznos terhet, amely a hasznos teherből és a modellválaszból áll, és kinyomtatja a kimenetet. A Code Llama számos paramétert támogat a következtetés végrehajtása során:

- max_length – A modell addig generál szöveget, amíg el nem éri a kimeneti hosszt (amely tartalmazza a bemeneti környezet hosszát).

max_length. Ha meg van adva, pozitív egész számnak kell lennie. - max_new_tokens – A modell addig generál szöveget, amíg el nem éri a kimeneti hosszt (a bemeneti kontextus hosszát kivéve).

max_new_tokens. Ha meg van adva, pozitív egész számnak kell lennie. - gerendák száma – Meghatározza a mohó keresésben használt sugarak számát. Ha meg van adva, akkor nagyobbnak vagy egyenlőnek kell lennie, mint

num_return_sequences. - no_repeat_ngram_size – A modell biztosítja, hogy egy szósorozat a

no_repeat_ngram_sizenem ismétlődik a kimeneti sorrendben. Ha meg van adva, akkor 1-nél nagyobb pozitív egész számnak kell lennie. - hőmérséklet – Ez szabályozza a kimenet véletlenszerűségét. Magasabb

temperaturekis valószínűségű szavakat tartalmazó kimeneti sorozatot eredményez, és alacsonyabbtemperaturenagy valószínűségű szavakat tartalmazó kimeneti sorozatot eredményez. Hatemperature0, ez mohó dekódolást eredményez. Ha meg van adva, pozitív lebegésnek kell lennie. - korai_megállás - Ha

True, a szöveggenerálás akkor fejeződik be, amikor az összes sugárhipotézis eléri a mondat token végét. Ha meg van adva, akkor logikai értéknek kell lennie. - do_sample - Ha

True, a modell a valószínűség szerint mintát vesz a következő szóból. Ha meg van adva, akkor logikai értéknek kell lennie. - top_k – A szöveggenerálás minden lépésében a modell csak a

top_klegvalószínűbb szavak. Ha meg van adva, pozitív egész számnak kell lennie. - top_p – A szöveggenerálás minden lépésében a modell a lehető legkisebb szókészletből vesz mintát halmozott valószínűséggel

top_p. Ha meg van adva, akkor 0 és 1 közötti úszónak kell lennie. - return_full_text - Ha

True, a bemeneti szöveg a kimenet által generált szöveg része lesz. Ha meg van adva, akkor logikai értéknek kell lennie. Ennek alapértelmezett értékeFalse. - megáll – Ha meg van adva, akkor karakterláncok listájának kell lennie. A szöveggenerálás leáll, ha a megadott karakterláncok bármelyike létrejön.

Ezeknek a paramétereknek bármely részhalmazát megadhatja egy végpont meghívása közben. Ezután egy példát mutatunk be arra, hogyan lehet végpontot meghívni ezekkel az argumentumokkal.

Kód kitöltése

A következő példák bemutatják, hogyan kell végrehajtani a kódbefejezést, ha a várt végponti válasz a prompt természetes folytatása.

Először a következő kódot futtatjuk:

A következő kimenetet kapjuk:

Következő példánkban a következő kódot futtatjuk:

A következő kimenetet kapjuk:

Kódgenerálás

A következő példák a Python kód létrehozását mutatják be Code Llama használatával.

Először a következő kódot futtatjuk:

A következő kimenetet kapjuk:

Következő példánkban a következő kódot futtatjuk:

A következő kimenetet kapjuk:

Íme néhány példa a Code Llama 70B kóddal kapcsolatos feladatokra. A modell segítségével még bonyolultabb kódokat generálhat. Javasoljuk, hogy próbálja ki saját kóddal kapcsolatos használati esetei és példái segítségével!

Tisztítsuk meg

A végpontok tesztelése után feltétlenül törölje a SageMaker következtetési végpontokat és a modellt, hogy elkerülje a költségeket. Használja a következő kódot:

Következtetés

Ebben a bejegyzésben bemutattuk a Code Llama 70B-t a SageMaker JumpStarton. A Code Llama 70B egy korszerű modell a természetes nyelvi promptokból és kódokból származó kód előállítására. A modellt néhány egyszerű lépéssel üzembe helyezheti a SageMaker JumpStartban, majd felhasználhatja a kóddal kapcsolatos feladatok végrehajtására, például kódgenerálásra és kódkitöltésre. Következő lépésként próbálja meg a modellt saját kóddal kapcsolatos használati eseteivel és adataival használni.

A szerzőkről

Dr. Kyle Ulrich az Amazon SageMaker JumpStart csapatának alkalmazott tudósa. Kutatási területei közé tartoznak a skálázható gépi tanulási algoritmusok, a számítógépes látás, az idősorok, a Bayes-féle nem-paraméterek és a Gauss-folyamatok. Doktori fokozatát a Duke Egyetemen szerezte, és publikációkat publikált a NeurIPS-ben, a Cell-ben és a Neuron-ban.

Dr. Kyle Ulrich az Amazon SageMaker JumpStart csapatának alkalmazott tudósa. Kutatási területei közé tartoznak a skálázható gépi tanulási algoritmusok, a számítógépes látás, az idősorok, a Bayes-féle nem-paraméterek és a Gauss-folyamatok. Doktori fokozatát a Duke Egyetemen szerezte, és publikációkat publikált a NeurIPS-ben, a Cell-ben és a Neuron-ban.

Dr. Farooq Sabir az AWS mesterséges intelligenciával és gépi tanulással foglalkozó megoldásokkal foglalkozó vezető építésze. Az austini Texasi Egyetemen szerzett PhD és MS fokozatot villamosmérnöki szakon, valamint MS fokozatot számítástechnikából a Georgia Institute of Technology-n. Több mint 15 éves munkatapasztalattal rendelkezik, és szeret főiskolai hallgatókat tanítani és mentorálni. Az AWS-nél segít az ügyfeleknek üzleti problémáik megfogalmazásában és megoldásában az adattudomány, a gépi tanulás, a számítógépes látás, a mesterséges intelligencia, a numerikus optimalizálás és a kapcsolódó területeken. A texasi Dallasban él, és családjával szeretnek utazni és hosszú utazásokra mennek.

Dr. Farooq Sabir az AWS mesterséges intelligenciával és gépi tanulással foglalkozó megoldásokkal foglalkozó vezető építésze. Az austini Texasi Egyetemen szerzett PhD és MS fokozatot villamosmérnöki szakon, valamint MS fokozatot számítástechnikából a Georgia Institute of Technology-n. Több mint 15 éves munkatapasztalattal rendelkezik, és szeret főiskolai hallgatókat tanítani és mentorálni. Az AWS-nél segít az ügyfeleknek üzleti problémáik megfogalmazásában és megoldásában az adattudomány, a gépi tanulás, a számítógépes látás, a mesterséges intelligencia, a numerikus optimalizálás és a kapcsolódó területeken. A texasi Dallasban él, és családjával szeretnek utazni és hosszú utazásokra mennek.

June nyert a SageMaker JumpStart termékmenedzsere. Arra összpontosít, hogy az alapmodelleket könnyen felfedezhetővé és használhatóvá tegye, hogy segítse az ügyfeleket generatív AI-alkalmazások létrehozásában. Az Amazonnál szerzett tapasztalatai közé tartozik a mobil vásárlási alkalmazás és az utolsó mérföldes szállítás is.

June nyert a SageMaker JumpStart termékmenedzsere. Arra összpontosít, hogy az alapmodelleket könnyen felfedezhetővé és használhatóvá tegye, hogy segítse az ügyfeleket generatív AI-alkalmazások létrehozásában. Az Amazonnál szerzett tapasztalatai közé tartozik a mobil vásárlási alkalmazás és az utolsó mérföldes szállítás is.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/code-llama-70b-is-now-available-in-amazon-sagemaker-jumpstart/

- :van

- :is

- :nem

- :ahol

- $ UP

- 000

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 15 év

- 15%

- 16

- 22

- 25

- 500

- 7

- 80

- 9

- a

- Rólunk

- Elfogad!

- elfogadható

- elfogadás

- hozzáférés

- előlegek

- Megállapodás

- AI

- algoritmusok

- Minden termék

- Is

- amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Az Amazon Web Services

- an

- és a

- bejelent

- bármilyen

- Alkalmazás

- alkalmazások

- alkalmazott

- megfelelő

- VANNAK

- érvek

- Művészet

- mesterséges

- mesterséges intelligencia

- Mesterséges intelligencia és gépi tanulás

- AS

- Helyettes

- biztosított

- At

- Austin

- elérhető

- elkerülése érdekében

- AWS

- bázis

- alapján

- horpadás

- bayesi

- BE

- Gerenda

- mert

- között

- Billió

- Milliárd token

- milliárd

- mindkét

- buborék

- épít

- épült

- üzleti

- by

- C + +

- hívás

- TUD

- képes

- kártya

- visz

- esetek

- Kategória

- sejt

- változik

- jellemzők

- díjak

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- választja

- osztály

- klasszikus

- ragadozó ölyv

- kettyenés

- kód

- Főiskola

- hogyan

- jön

- teljes

- befejezés

- bonyolult

- számítógép

- Computer Science

- Számítógépes látás

- Összeáll

- Konzol

- tartalom

- kontextus

- folytatás

- ellenőrzések

- terjed

- teremt

- a válogatott

- Ügyfelek

- Dallas

- dátum

- adat-tudomány

- Dekódolás

- alapértelmezett

- kézbesítés

- bizonyítani

- telepíteni

- telepített

- bevetés

- bevet

- tervezett

- részlet

- fejlett

- fejlesztők

- Fejlesztés

- különböző

- digitális

- digitális művészet

- felfedez

- do

- Ennek

- domainek

- Herceg

- herceg egyetem

- minden

- Korábban

- könnyen

- hatékony

- lehetővé téve

- ösztönzése

- végén

- végtől végig

- Endpoint

- manipulált

- Mérnöki

- biztosítja

- egyenlő

- hiba

- értékelő

- Még

- példa

- példák

- Excel

- Kivéve

- izgatott

- kizárás

- létező

- várható

- drága

- tapasztalat

- exponenciális

- Arc

- család

- kevés

- Találjon

- vezetéknév

- Úszó

- koncentrál

- következő

- A

- Alapítvány

- alapítványi

- négy

- ból ből

- funkció

- generál

- generált

- generál

- generáló

- generáció

- generációk

- nemző

- Generatív AI

- Grúzia

- kap

- adott

- Go

- nagyobb

- Kapzsi

- útmutatást

- Legyen

- he

- segít

- segít

- segít

- jó minőségű

- <p></p>

- övé

- tart

- Kezdőlap

- vendéglátó

- házigazdája

- Hogyan

- How To

- HTTPS

- Kerékagy

- csomópontok

- i

- ideális

- if

- importál

- javul

- fejlesztések

- in

- tartalmaz

- magában foglalja a

- Beleértve

- járulékos

- információ

- bemenet

- bemenet

- példa

- Intézet

- utasítás

- Intelligencia

- érdekek

- Bevezetett

- IT

- Jáva

- jpg

- ismert

- Kyle

- nyelv

- nagy

- keresztnév

- tanulás

- kilépő

- Hossz

- Engedély

- valószínűség

- Valószínű

- Kedvencek

- Lista

- Láma

- LLM

- Hosszú

- szerelem

- alacsonyabb

- gép

- gépi tanulás

- készült

- csinál

- Gyártás

- menedzser

- sok

- említett

- mentor

- meta

- mérföld

- ML

- Mobil

- modell

- modellek

- több

- hatékonyabb

- a legtöbb

- MS

- kell

- Természetes

- Navigáció

- Szükség

- szükséges

- soha

- Új

- következő

- megjegyezni

- jegyzetfüzet

- Most

- szám

- of

- on

- ONE

- azok

- csak

- optimalizálás

- Opciók

- or

- mi

- ki

- teljesítmény

- felett

- saját

- oldal

- üvegtábla

- papírok

- paraméterek

- rész

- fél

- mert

- Teljesít

- előadó

- phd

- PHP

- Plató

- Platón adatintelligencia

- PlatoData

- politika

- Népszerű

- pozitív

- lehetséges

- állás

- potenciális

- Predictor

- Plakátok

- problémák

- folyamat

- Folyamatok

- Termékek

- termék menedzser

- termelékenység

- Programozás

- utasításokat

- ad

- szolgáltatók

- biztosít

- közzétett

- Piton

- pytorch

- gyorsan

- véletlenszerűség

- hatótávolság

- Inkább

- el

- Elér

- új

- összefüggő

- felszabaduló

- megismételt

- kutatás

- Tudástár

- válasz

- REST

- Eredmények

- visszatérés

- fordított

- Kritika

- Emelkedik

- út

- futás

- futás

- sagemaker

- SageMaker következtetés

- azonos

- Megtakarítás

- skálázható

- Skála

- Tudomány

- Tudós

- sdk

- Keresés

- kiválasztott

- kiválasztása

- idősebb

- mondat

- Sorozat

- Series of

- Szolgáltatások

- készlet

- beállítások

- megosztott

- Bevásárlás

- előadás

- mutatott

- Műsorok

- Egyszerű

- méretek

- So

- szoftver

- Megoldások

- SOLVE

- néhány

- szakember

- specializált

- meghatározott

- specifikálva

- stabil

- kezdet

- kezdődött

- csúcs-

- Lépés

- Lépései

- Leállítja

- Húr

- Diákok

- stúdió

- sikeresen

- ilyen

- támogatás

- Támogatja

- biztos

- környező

- tart

- feladatok

- csapat

- Technológia

- tensorflow

- feltételek

- teszt

- kipróbált

- Texas

- szöveg

- mint

- hogy

- A

- azok

- Őket

- maguk

- akkor

- Ezek

- Harmadik

- harmadik felek

- ezt

- három

- Keresztül

- idő

- Idősorok

- nak nek

- jelképes

- tokenek

- felső

- Vonat

- kiképzett

- Fordítás

- utazás

- áthalad

- igaz

- megpróbál

- típus

- Gépelt

- jellemzően

- ui

- alatt

- megértés

- egyetemi

- -ig

- használható

- Használat

- használ

- használt

- használó

- segítségével

- érték

- Értékek

- fajta

- változat

- keresztül

- látomás

- séta

- akar

- we

- háló

- webes szolgáltatások

- JÓL

- voltak

- amikor

- vajon

- ami

- míg

- széles

- modul

- lesz

- val vel

- belül

- nélkül

- szó

- szavak

- Munka

- munkafolyamat

- munkafolyamatok

- ír

- év

- te

- A te

- zephyrnet