ダイナミックなストリーミングの世界で アマゾン・ミュージック、曲、ポッドキャスト、またはプレイリストを検索するたびに、明らかにされるのを待っているストーリー、ムード、または感情の洪水が含まれています。 これらの検索は、新しい発見、大切な経験、そして永続的な思い出への入り口として機能します。 検索バーは曲を見つけるだけではありません。 それは、Amazon Music が提供する豊かで多様な世界への個人的な旅を始める何百万ものアクティブユーザーについての物語です。

ユーザーが探している音楽を即座に見つける優れた顧客体験を提供するには、スマートで応答性の高いプラットフォームが必要です。 Amazon Music は AI の力を利用してこれを実現します。 ただし、リアルタイムのスペルチェックやベクトル検索などの検索バーの機能を強化する AI モデルのトレーニングと推論のコストを管理しながら、カスタマー エクスペリエンスを最適化することは、トラフィックのピーク時に困難です。

アマゾンセージメーカー は、最小限の労力で Amazon Music を AWS クラウド上で構築、トレーニング、デプロイできるようにするエンドツーエンドのサービス セットを提供します。 SageMaker を使用すると、未分化の重労働を引き受けることで、インフラストラクチャなどについて心配することなく、機械学習 (ML) モデルの作業に集中できるようになります。 責任共有モデルの一部として、SageMaker は、提供するサービスが信頼性があり、パフォーマンスが高く、スケーラブルであることを確認すると同時に、ML モデルのアプリケーションが SageMaker が提供する機能を最大限に活用できるようにします。

この投稿では、Amazon Music が SageMaker、NVIDIA Triton Inference Server、TensorRT を使用してパフォーマンスとコストを最適化するためにたどった道のりを説明します。 一見シンプルに見えて複雑な検索バーがどのように機能するのかを深く掘り下げて説明し、イライラするタイプミスによる遅延がほとんどなく、関連するリアルタイムの検索結果が表示されることで、Amazon Music の世界への途切れることのない旅を保証します。

Amazon SageMaker と NVIDIA: 高速かつ正確なベクトル検索とスペルチェック機能を提供

Amazon Music は、100 億曲を超える楽曲と数百万のポッドキャスト エピソードを含む膨大なライブラリを提供しています。 ただし、特に正確なタイトル、アーティスト、アルバム名がわからない場合、または検索クエリが「ニュース ポッドキャスト」など非常に広範囲にわたる場合、適切な曲やポッドキャストを見つけるのは困難になることがあります。

Amazon Music は、検索と取得のプロセスを改善するために XNUMX つの側面からのアプローチを採用しています。 最初のステップは、コンテンツのセマンティクスを使用して、ユーザーが探している最も関連性の高いコンテンツを見つけるのに役立つ ML 技術であるベクトル検索 (埋め込みベースの検索とも呼ばれます) を導入することです。 XNUMX 番目のステップでは、Transformer ベースの Spell Correction モデルを検索スタックに導入します。 ユーザーは曲のタイトルやアーティスト名の正確なスペルを常に知っているとは限らないため、これは音楽を検索する場合に特に役立ちます。 スペル修正を使用すると、ユーザーが検索クエリでスペルを間違えた場合でも、探している音楽を見つけることができます。

検索および取得パイプライン (ベクトル検索に必要なクエリ埋め込み生成や、スペル コレクションの生成 Seq2Seq Transformer モデル) に Transformer モデルを導入すると、全体的なレイテンシが大幅に増加し、カスタマー エクスペリエンスに悪影響を与える可能性があります。 したがって、ベクトル検索およびスペル修正モデルのリアルタイム推論レイテンシーを最適化することが私たちにとって最優先事項になりました。

Amazon Music と NVIDIA は、検索バーに可能な限り最高のカスタマー エクスペリエンスを提供するために協力し、SageMaker を使用して高速かつ正確なスペルチェック機能と、ベクトル検索ベースの技術を使用したリアルタイムのセマンティック検索提案の両方を実装しました。 このソリューションには、NVIDIA A5G Tensor コア GPU を使用する G10 インスタンスを利用した SageMaker ホスティング、SageMaker がサポートする NVIDIA Triton Inference Server コンテナ、および NVIDIA TensorRT モデル形式。 Amazon Music は、スペルチェック モデルの推論レイテンシーをトラフィックのピーク時に 25 ミリ秒に短縮し、CPU ベースの推論と比較して、検索クエリ埋め込み生成のレイテンシーを平均 63%、コストを 73% 削減することで、検索バーのパフォーマンスを向上させました。

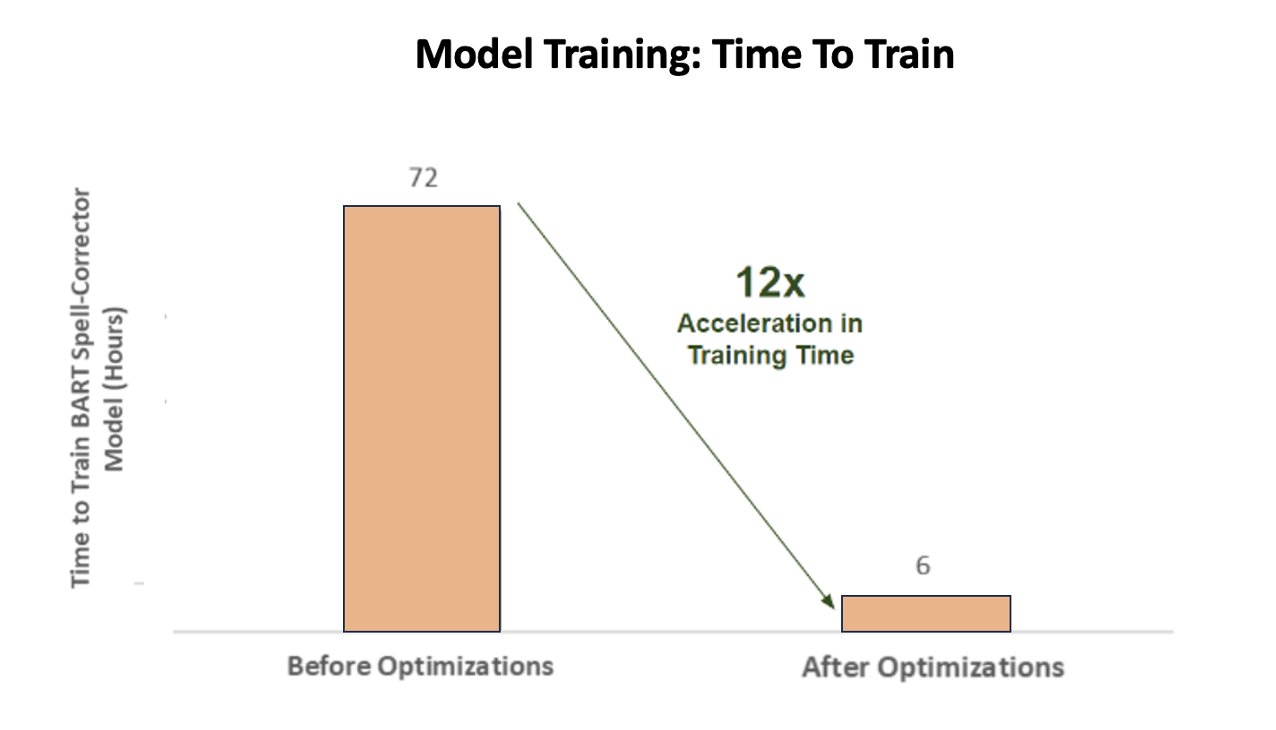

さらに、正確な結果を提供するために AI モデルをトレーニングする際、Amazon Music は、GPU 使用率を最適化することで、BART シーケンス間スペル修正トランスフォーマー モデルのトレーニング時間を 12 倍という驚異的な高速化を達成し、時間と費用の両方を節約しました。

Amazon Music は NVIDIA と提携して、顧客の検索エクスペリエンスを優先し、適切に最適化されたスペルチェックおよびベクター検索機能を備えた検索バーを作成しました。 次のセクションでは、これらの最適化がどのように調整されたかについて詳しく説明します。

NVIDIA Tensor Core GPU によるトレーニングの最適化

大規模言語モデルのトレーニングのために NVIDIA Tensor コア GPU にアクセスするだけでは、その真の可能性を引き出すには十分ではありません。 GPU の使用率を完全に最大化するには、トレーニング中に実行する必要がある重要な最適化手順があります。 ただし、GPU が十分に活用されていないと、間違いなくリソースの非効率な使用、トレーニング時間の延長、運用コストの増加につながります。

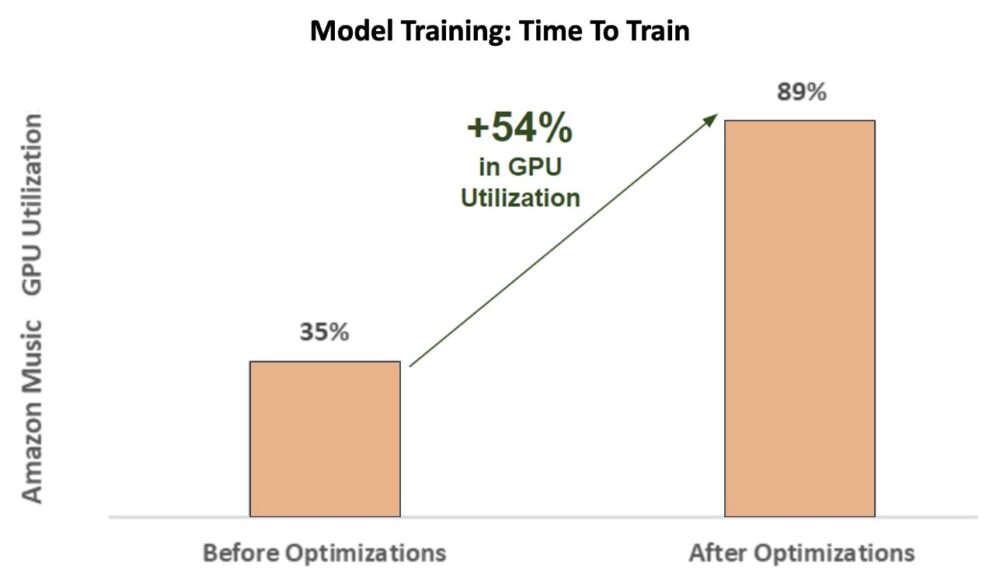

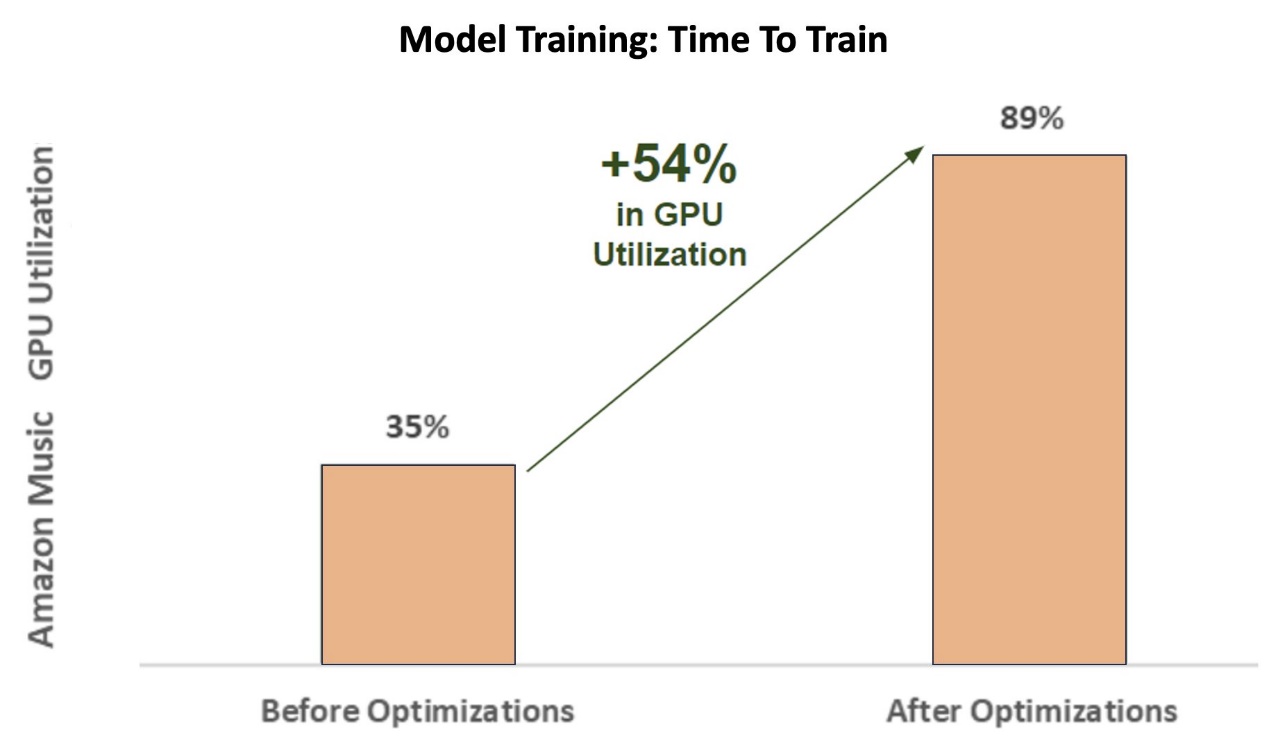

トレーニングの初期段階では、スペル コレクター BART (バートベース) SageMaker ml.p3.24xlarge インスタンス (NVIDIA V8 Tensor コア GPU 100 個) 上のトランスフォーマー モデルでは、Amazon Music の GPU 使用率は約 35% でした。 NVIDIA GPU アクセラレーション トレーニングの利点を最大限に活用するために、AWS と NVIDIA ソリューション アーキテクトは、特にバッチ サイズと精度パラメータ周りの最適化領域の特定において Amazon Music をサポートしました。 これら XNUMX つの重要なパラメーターは、深層学習モデルのトレーニングの効率、速度、精度に影響を与えます。

その結果、最適化が行われ、V100 GPU の使用率が新しく改善され、約 89% で安定し、Amazon Music のトレーニング時間が 3 日から 5 ~ 6 時間に大幅に短縮されました。 バッチ サイズを 32 から 256 に切り替え、実行などの最適化手法を使用することで、 自動混合精度トレーニング Amazon Music では、FP32 精度のみを使用するのではなく、時間とコストの両方を節約することができました。

次のグラフは、最適化後の GPU 使用率が 54% ポイント増加したことを示しています。

次の図は、トレーニング時間の加速を示しています。

このバッチ サイズの増加により、NVIDIA GPU は複数の Tensor コア間でより多くのデータを同時に処理できるようになり、トレーニング時間が短縮されました。 ただし、バッチ サイズが大きくなるとより多くのメモリが必要となるため、メモリとの微妙なバランスを維持することが重要です。 NVIDIA Tensor コア GPU の能力を最大限に引き出すには、バッチ サイズの増加と混合精度の採用の両方が重要です。

モデルが収束するようにトレーニングされた後、Amazon Music の検索バーでの推論展開を最適化します。

スペル修正: BART モデル推論

SageMaker G5 インスタンスと NVIDIA Triton Inference Server (オープンソースの推論提供ソフトウェア)、および推論オプティマイザーとランタイムを含む高性能ディープラーニング推論用の SDK である NVIDIA TensorRT の助けを借りて、Amazon Music はスペルチェック BART を制限します(バートベース) モデルサーバーの推論遅延をピークトラフィック時にわずか 25 ミリ秒に抑えます。 これには、負荷分散、前処理、モデル推論、後処理時間などのオーバーヘッドが含まれます。

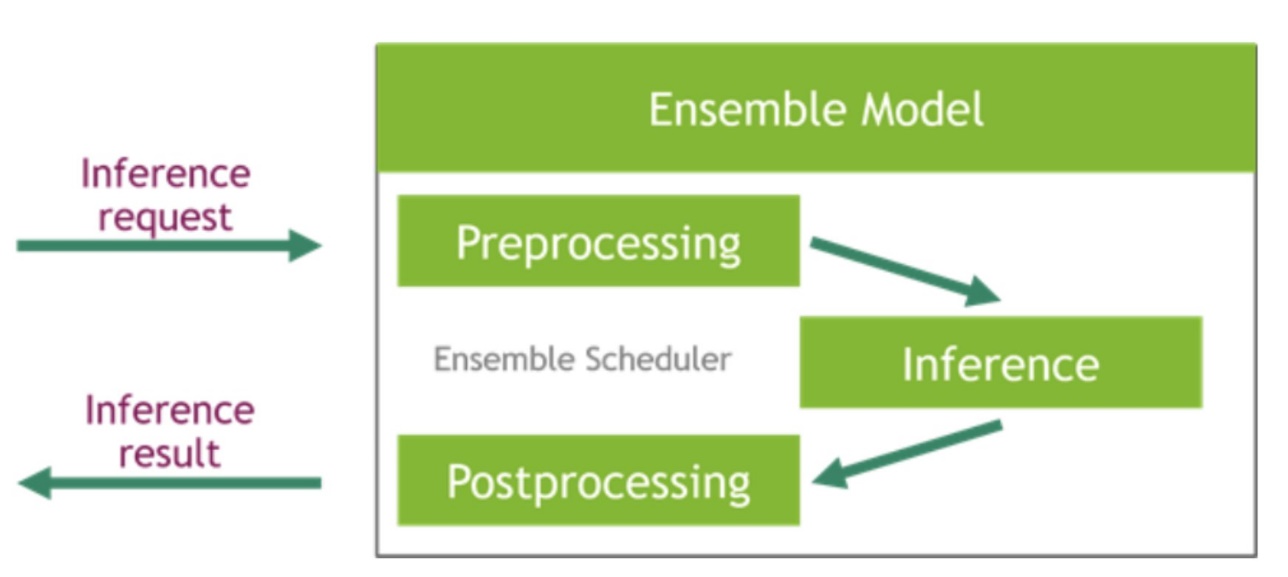

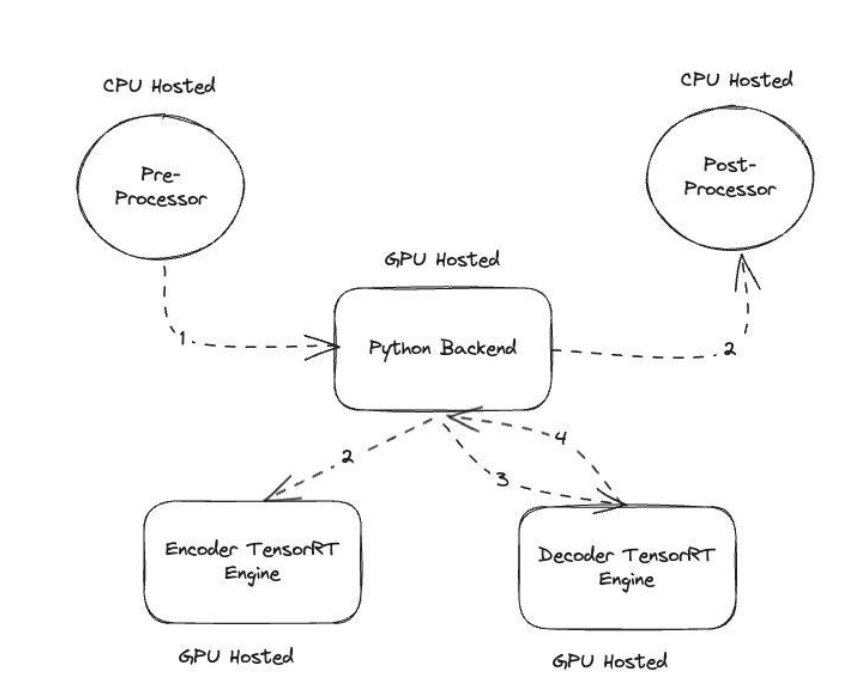

NVIDIA Triton Inference Server は XNUMX つの異なる種類のバックエンドを提供します。XNUMX つは GPU でモデルをホストするためのもので、もう XNUMX つは前処理および後処理ステップで使用する独自のカスタム コードを取り込むことができる Python バックエンドです。 次の図は、 モデルアンサンブルスキーム.

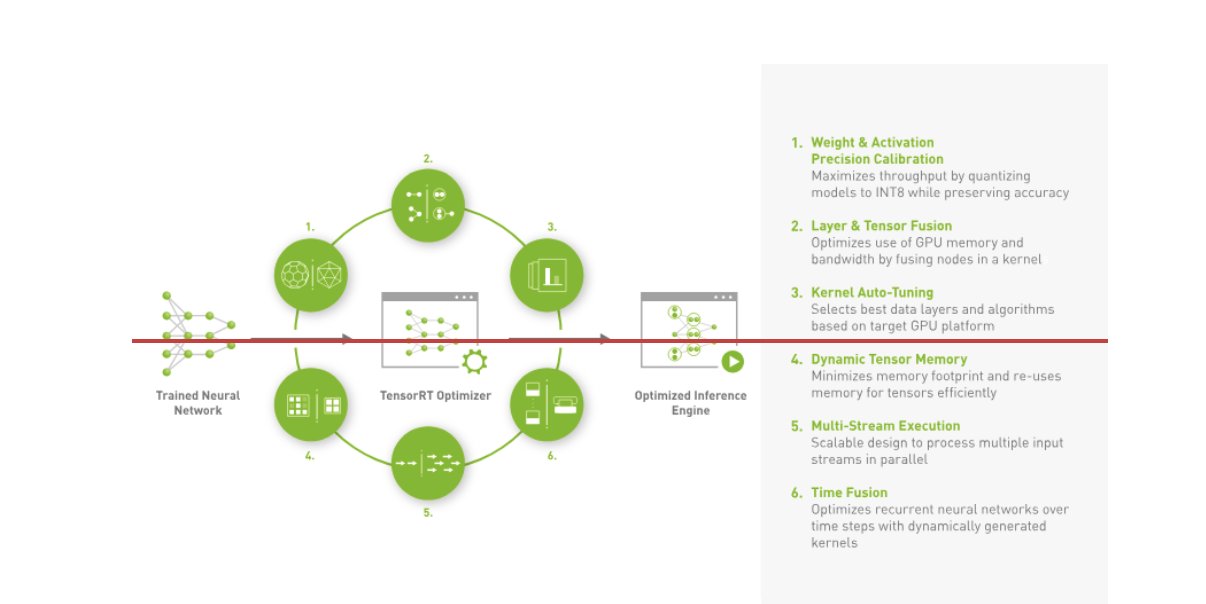

Amazon Music が BART を構築 推論パイプライン 前処理 (テキストのトークン化) と後処理 (トークンからテキストへ) の両方のステップを CPU 上で実行するのに対し、モデルの実行ステップは CPU 上で実行されます。 NVIDIA A10G Tensor コア GPU。 Python バックエンドは前処理ステップと後処理ステップの中間に位置し、TensorRT に変換された BART モデルおよびエンコーダー/デコーダー ネットワークとの通信を担当します。 TensorRT 精度のキャリブレーション、レイヤーとテンソルの融合、カーネルの自動チューニング、動的テンソル メモリ、マルチストリーム実行、時間融合により推論パフォーマンスを向上させます。

次の図は、スペル修正ツール BART モデル推論パイプラインを構成する主要モジュールの高レベル設計を示しています。

ベクトル探索:クエリ埋め込み生成文 BERTモデル推論

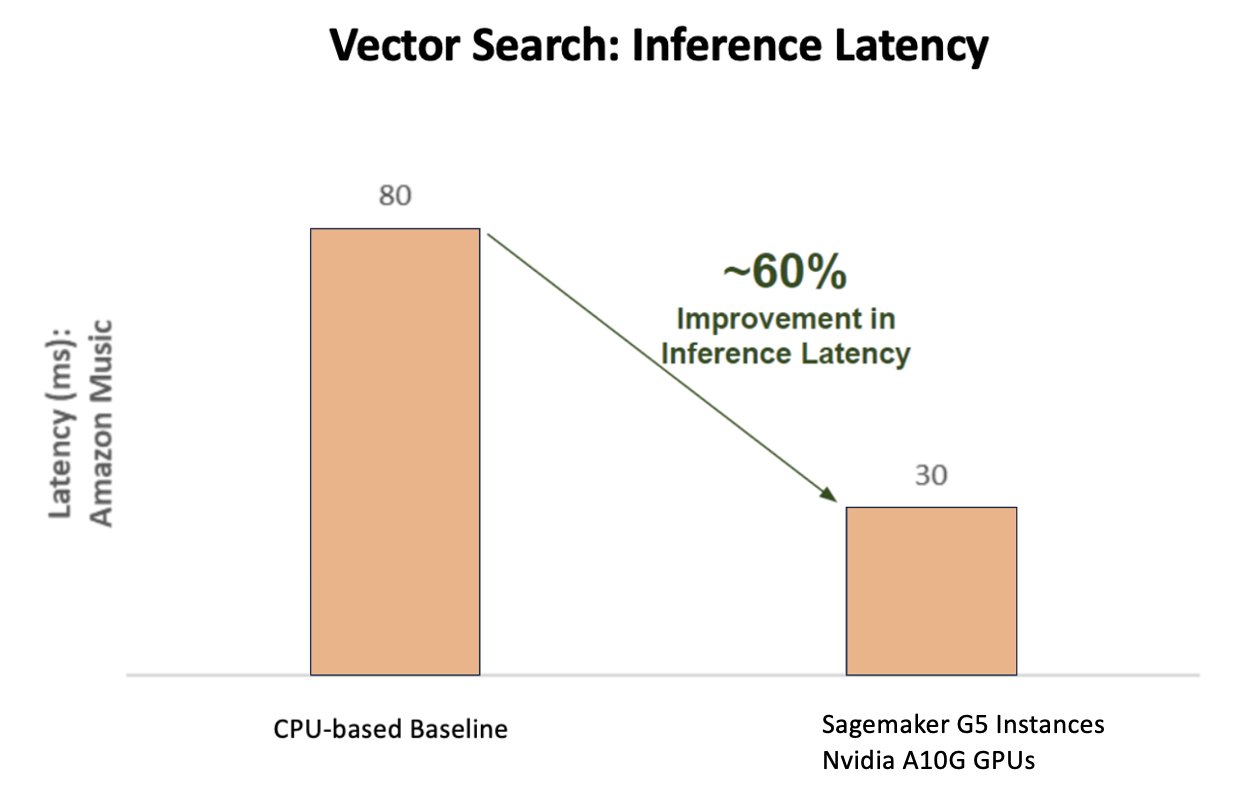

次のグラフは、CPU ベースのベースラインと比較して、NVIDIA AI 推論プラットフォームを使用した場合の遅延の 60% 改善 (p90 800 ~ 900 TPS を提供) を示しています。

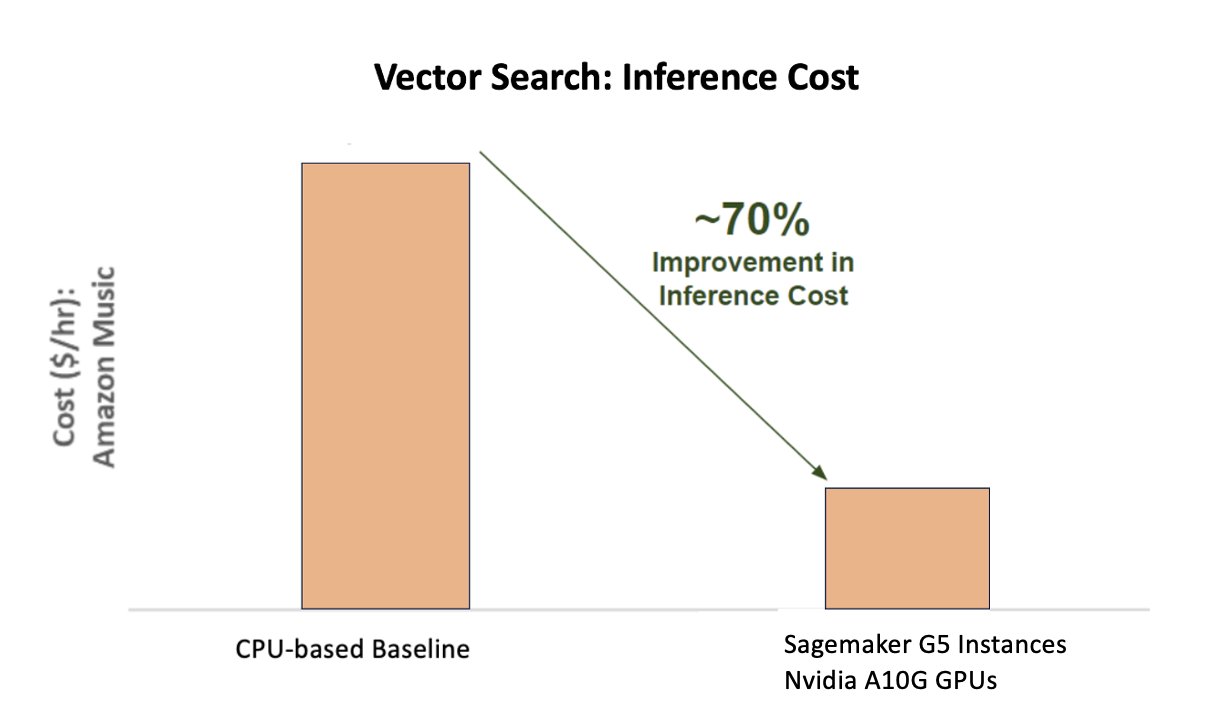

次のグラフは、CPU ベースのベースラインと比較して、NVIDIA AI 推論プラットフォームを使用するとコストが 70% 向上することを示しています。

次の図は、高性能ディープラーニング推論用の SDK を示しています。 これには、推論アプリケーションに低レイテンシーと高スループットを実現するディープラーニング推論オプティマイザーとランタイムが含まれています。

これらの結果を達成するために、Amazon Music は、以下を使用していくつかの異なる Triton 導入パラメータを実験しました。 トリトンモデルアナライザー、効率的な推論を展開するための最適な NVIDIA Triton モデル構成を見つけるのに役立つツールです。 モデル推論を最適化するために、Triton は動的バッチ処理やモデルの同時実行などの機能を提供し、その他の柔軟性機能をサポートするフレームワークを備えています。 動的バッチ処理は推論リクエストを収集し、スループットを最大化するためにそれらをシームレスにコホートにグループ化し、同時に Amazon Music ユーザーに対するリアルタイムの応答を保証します。 モデルの同時実行機能は、同じ GPU 上でモデルの複数のコピーをホストすることにより、推論パフォーマンスをさらに強化します。 最後に、それを活用することで、 トリトンモデルアナライザー, Amazon Music は、動的バッチ処理とモデル同時実行推論ホスティング パラメーターを慎重に微調整し、シミュレートされたトラフィックを使用して推論パフォーマンスを最大化する最適な設定を見つけることができました。

まとめ

SageMaker 上の Triton Inference Server と TensorRT を使用して構成を最適化することで、Amazon Music はトレーニングと推論パイプラインの両方で優れた結果を達成することができました。 SageMaker プラットフォームは、実稼働 AI のためのエンドツーエンドのオープン プラットフォームであり、価値を迅速に実現し、ハードウェアとソフトウェアの両方ですべての主要な AI ユースケースをサポートする多用途性を提供します。 NVIDIA A100G Tensor コア GPU を使用してトレーニングおよび CPU から G5 インスタンスへの切り替えのための V10 GPU の使用率を最適化し、さらに Triton Inference Server や TensorRT などの最適化された NVIDIA ソフトウェアを使用することにより、Amazon Music のような企業は時間とコストを節約しながら、両方のパフォーマンスを向上させることができます。トレーニングと推論は、顧客エクスペリエンスの向上と運用コストの削減に直接つながります。

SageMaker は、ML トレーニングとホスティングのための未分化の重労働を処理し、Amazon Music がハードウェアとソフトウェアの両方にわたって信頼性が高くスケーラブルな ML オペレーションを提供できるようにします。

ハードウェアとソフトウェアの選択を常に評価して、コストを削減しながらより良いパフォーマンスを達成できる方法があるかどうかを確認し、SageMaker を使用してワークロードが最適化されていることを確認することをお勧めします。

AWS の NVIDIA AI の詳細については、以下を参照してください。

著者について

シッダールタシャルマ Amazon Music のサイエンス & モデリング チームの機械学習技術リードです。 彼は、検索、取得、ランキング、および NLP 関連のモデリング問題を専門としています。 シッダールスは、広告のターゲティング、マルチモーダル検索、検索クエリの理解など、遅延に敏感な大規模な機械学習問題に取り組む豊富な経歴を持っています。アマゾン ミュージックで働く前は、メタ、ウォルマート ラボ、楽天などの企業で働いていました。電子商取引中心の ML 問題について。 シッダールスはキャリアの初期をベイエリアのアドテク新興企業で働いていました。

シッダールタシャルマ Amazon Music のサイエンス & モデリング チームの機械学習技術リードです。 彼は、検索、取得、ランキング、および NLP 関連のモデリング問題を専門としています。 シッダールスは、広告のターゲティング、マルチモーダル検索、検索クエリの理解など、遅延に敏感な大規模な機械学習問題に取り組む豊富な経歴を持っています。アマゾン ミュージックで働く前は、メタ、ウォルマート ラボ、楽天などの企業で働いていました。電子商取引中心の ML 問題について。 シッダールスはキャリアの初期をベイエリアのアドテク新興企業で働いていました。

タルンシャルマ Amazon Music 検索関連性を主導するソフトウェア開発マネージャーです。 彼の科学者と ML エンジニアのチームは、Amazon Music の顧客に文脈に応じてパーソナライズされた検索結果を提供する責任を負っています。

タルンシャルマ Amazon Music 検索関連性を主導するソフトウェア開発マネージャーです。 彼の科学者と ML エンジニアのチームは、Amazon Music の顧客に文脈に応じてパーソナライズされた検索結果を提供する責任を負っています。

ジェームズ・パーク アマゾン ウェブ サービスのソリューション アーキテクトです。 彼は Amazon.com と協力して AWS 上のテクノロジー ソリューションを設計、構築、デプロイしており、特に AI と機械学習に興味を持っています。 余暇には、新しい文化、新しい経験を探し、最新のテクノロジー トレンドを把握することを楽しんでいます。 LinkedIn.

ジェームズ・パーク アマゾン ウェブ サービスのソリューション アーキテクトです。 彼は Amazon.com と協力して AWS 上のテクノロジー ソリューションを設計、構築、デプロイしており、特に AI と機械学習に興味を持っています。 余暇には、新しい文化、新しい経験を探し、最新のテクノロジー トレンドを把握することを楽しんでいます。 LinkedIn.

クシチズ・グプタ NVIDIA のソリューション アーキテクトです。 彼は、NVIDIA が提供する GPU AI テクノロジについてクラウドの顧客を教育し、機械学習およびディープ ラーニング アプリケーションの高速化を支援することに喜びを感じています。 仕事以外では、ランニング、ハイキング、野生動物の観察を楽しんでいます。

クシチズ・グプタ NVIDIA のソリューション アーキテクトです。 彼は、NVIDIA が提供する GPU AI テクノロジについてクラウドの顧客を教育し、機械学習およびディープ ラーニング アプリケーションの高速化を支援することに喜びを感じています。 仕事以外では、ランニング、ハイキング、野生動物の観察を楽しんでいます。

ジャホン・リュウ NVIDIAのクラウドサービスプロバイダーチームのソリューションアーキテクトです。 彼は、クライアントがNVIDIAアクセラレーションコンピューティングを活用してトレーニングと推論の課題に対処する機械学習とAIソリューションを採用するのを支援しています。 余暇には、折り紙、DIYプロジェクト、バスケットボールを楽しんでいます。

ジャホン・リュウ NVIDIAのクラウドサービスプロバイダーチームのソリューションアーキテクトです。 彼は、クライアントがNVIDIAアクセラレーションコンピューティングを活用してトレーニングと推論の課題に対処する機械学習とAIソリューションを採用するのを支援しています。 余暇には、折り紙、DIYプロジェクト、バスケットボールを楽しんでいます。

トゥグルル コヌク NVIDIA のシニア ソリューション アーキテクトであり、大規模トレーニング、マルチモーダル ディープ ラーニング、高性能科学コンピューティングを専門としています。 NVIDIA に入社する前は、エネルギー業界で働き、コンピュテーショナル イメージングのアルゴリズムの開発に重点を置いていました。 博士号の一環として、大規模な数値シミュレーションのための物理ベースの深層学習に取り組みました。 余暇には、読書、ギター、ピアノの演奏を楽しんでいます。

トゥグルル コヌク NVIDIA のシニア ソリューション アーキテクトであり、大規模トレーニング、マルチモーダル ディープ ラーニング、高性能科学コンピューティングを専門としています。 NVIDIA に入社する前は、エネルギー業界で働き、コンピュテーショナル イメージングのアルゴリズムの開発に重点を置いていました。 博士号の一環として、大規模な数値シミュレーションのための物理ベースの深層学習に取り組みました。 余暇には、読書、ギター、ピアノの演奏を楽しんでいます。

ロヒル・バルガヴァ NVIDIA のプロダクト マーケティング マネージャーであり、特定の CSP プラットフォームでの NVIDIA アプリケーション フレームワークと SDK の展開に重点を置いています。

ロヒル・バルガヴァ NVIDIA のプロダクト マーケティング マネージャーであり、特定の CSP プラットフォームでの NVIDIA アプリケーション フレームワークと SDK の展開に重点を置いています。

エリュース・トリアナ・イサザ NVIDIA のデベロッパー リレーションズ マネージャーであり、Amazon の AI MLOps、DevOps、科学者、AWS 技術専門家が NVIDIA コンピューティング スタックを習得して、データ キュレーション、GPU トレーニング、モデル推論、AWS GPU インスタンスでの本番展開に及ぶ Generative AI Foundation モデルの高速化と最適化を支援しています。 。 さらに、Eliuth は情熱的なマウンテン バイカー、スキーヤー、テニス、ポーカー プレーヤーでもあります。

エリュース・トリアナ・イサザ NVIDIA のデベロッパー リレーションズ マネージャーであり、Amazon の AI MLOps、DevOps、科学者、AWS 技術専門家が NVIDIA コンピューティング スタックを習得して、データ キュレーション、GPU トレーニング、モデル推論、AWS GPU インスタンスでの本番展開に及ぶ Generative AI Foundation モデルの高速化と最適化を支援しています。 。 さらに、Eliuth は情熱的なマウンテン バイカー、スキーヤー、テニス、ポーカー プレーヤーでもあります。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :持っている

- :は

- :not

- :どこ

- $UP

- 100

- 12

- 25

- 32

- 視聴者の38%が

- 7

- 8

- a

- できる

- 私たちについて

- 加速された

- 加速している

- 加速

- アクセス

- こちらからお申し込みください。

- 精度

- 正確な

- 達成する

- 達成

- 越えて

- アクティブ

- 添加

- 住所

- 採用

- 広告

- 影響

- 後

- AI

- AIモデル

- aiのユースケース

- アルバム

- アルゴリズム

- すべて

- 許す

- 許可されて

- 許可

- ことができます

- また

- 常に

- Amazon

- Amazon Webサービス

- Amazon.com

- an

- および

- 申し込み

- アプローチ

- 建築家

- です

- AREA

- エリア

- 周りに

- アーティスト

- AS

- 支援する

- アシスト

- At

- 平均

- AWS

- バックエンド

- バランシング

- バー

- ベース

- ベースライン

- バスケットボール

- ベイ

- BE

- になりました

- なぜなら

- 利点

- BEST

- より良いです

- 後押し

- ブースト

- 両言語で

- 持って来る

- 広い

- ビルド

- 内蔵

- by

- 缶

- 機能

- 機能

- キャプチャー

- これ

- キャリア

- 慎重に

- 例

- 課題

- 挑戦

- チャート

- チェック

- 大事に

- 選択肢

- クライアント

- クラウド

- コード

- COM

- 来ます

- 通信中

- 企業

- 比べ

- 計算的

- コンピューティング

- 同時

- コンテナ

- コンテンツ

- 収束

- 基本

- 費用

- コスト

- クラフト

- 重大な

- 重大な

- CSP

- キュレーション

- カスタム

- 顧客

- 顧客満足体験

- Customers

- データ

- 日付

- 日

- 減少した

- 深いです

- 深い学習

- 遅延

- 配信する

- 配信する

- 提供します

- 需要

- 展開します

- 展開する

- 展開

- 設計

- Developer

- 開発

- 開発

- 異なります

- 難しい

- 直接に

- ダイビング

- 異なる

- Diy

- ドント

- 劇的に

- 間に

- ダイナミック

- e

- eコマース

- 早い

- 教育する

- 効率

- 効率的な

- 努力

- 高い

- 埋め込み

- 感情

- 採用

- エンパワーメント

- 使用可能

- 奨励する

- 端から端まで

- エネルギー

- エンジニア

- 強化

- 十分な

- 確保する

- 特に

- 等

- 評価します

- さらに

- あらゆる

- 実行

- 体験

- エクスペリエンス

- 専門家

- スピーディー

- 特徴

- フィギュア

- 最後に

- もう完成させ、ワークスペースに掲示しましたか?

- 発見

- 名

- 柔軟性

- 洪水

- フォーカス

- 焦点を当て

- 焦点

- フォロー中

- 形式でアーカイブしたプロジェクトを保存します.

- Foundation

- フレームワーク

- フレームワーク

- から

- 忍耐の要る事です。

- 完全に

- 機能性

- さらに

- 融合

- ゲートウェイ

- 世代

- 生々しい

- 生成AI

- GPU

- GPU

- ハンドル

- 起こる

- Hardware

- 持ってる

- he

- ヘビー

- 重いもの

- 助けます

- 役立つ

- ことができます

- ハイ

- ハイレベル

- ハイパフォーマンス

- 彼に

- 彼の

- 保持している

- ホスティング

- HOURS

- 認定条件

- しかしながら

- HTML

- HTTPS

- 識別

- if

- 説明する

- イメージング

- 実装する

- 重要

- 改善します

- 改善されました

- 改善

- in

- 含ま

- 増える

- 増加した

- の増加

- 産業を変えます

- 非効率的な

- 影響

- インフラ関連事業

- 初期

- 瞬時に

- を取得する必要がある者

- 関心

- に

- 紹介する

- 導入

- IT

- ITS

- 旅

- JPG

- ただ

- キー

- 種類

- 知っている

- 既知の

- ラボ

- 言語

- 大

- 大規模

- より大きい

- 持続する

- レイテンシ

- 最新の

- 層

- つながる

- 主要な

- LEARN

- 学習

- 活用します

- 図書館

- フェイスリフト

- ような

- 制限

- 負荷

- 探して

- ロー

- 下側

- 機械

- 機械学習

- 維持する

- 主要な

- make

- 作る

- マネージャー

- 管理する

- マーケティング

- マスター

- 最大化します

- 五月..

- 思い出

- メモリ

- Meta

- 真ん中

- 百万

- 何百万

- ミリ秒

- 最小限の

- ミス

- 混合

- ML

- MLOps

- モデリング

- モデル

- モジュール

- お金

- 他には?

- 最も

- 山

- マルチ

- の試合に

- 音楽を聴く際のスピーカーとして

- しなければなりません

- 名

- 必要とされる

- マイナスに

- ネットワーク

- 新作

- NLP

- Nvidia

- of

- 提供

- オファー

- on

- ONE

- の

- 開いた

- オープンソース

- オペレーティング

- オペレーショナル

- 業務執行統括

- 最適な

- 最適化

- 最適化

- 最適化

- 最適化

- or

- 調整された

- 注文

- その他

- でる

- 外側

- 傑出した

- が

- 全体

- 自分の

- パラメータ

- 部

- 特定の

- 特に

- 提携

- 情熱的な

- ピーク

- 割合

- パフォーマンス

- 個人的な

- カスタマイズ

- 博士号

- パイプライン

- プラットフォーム

- プラットフォーム

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- プレイヤー

- 再生

- ポッドキャスト

- ポッドキャスト

- ポイント

- ポーカー

- 可能

- ポスト

- 潜在的な

- 電力

- パワード

- 精度

- 事前の

- 優先順位をつける

- 優先順位

- 問題

- プロセス

- プロダクト

- 生産

- プロジェクト(実績作品)

- 提供します

- プロバイダー

- は、大阪で

- 提供

- Python

- クイック

- ランキング

- リーディング

- への

- 縮小

- 参照する

- 関連する

- 関係

- 関連性

- 関連した

- 信頼性のある

- リクエスト

- 必要

- リソース

- 回答

- 責任

- 責任

- 反応する

- 結果として

- 結果

- 富裕層

- 右

- ランニング

- runs

- ランタイム

- セージメーカー

- 同じ

- Save

- 節約

- ド電源のデ

- 規模

- 科学

- 科学的な

- 科学者たち

- SDDK

- SDK

- シームレス

- を検索

- 検索

- 検索

- 二番

- セクション

- を求める

- 一見

- 意味論

- シニア

- 敏感な

- 文

- 役立つ

- サービス

- サービスプロバイダー

- サービス

- サービング

- セッションに

- 設定

- いくつかの

- シェアする

- shared

- 作品

- 重要

- 著しく

- 簡単な拡張で

- 座っ

- サイズ

- サイズ

- スマート

- ソフトウェア

- ソフトウェア開発

- 溶液

- ソリューション

- 歌

- ソース

- 緊張

- 専門にする

- 特化

- 特定の

- スピード

- スペル

- 綴り

- 費やした

- スタック

- 起動

- スタートアップ

- 滞在

- 着実

- 手順

- ステップ

- ストーリー

- ストリーミング

- そのような

- 優れた

- サポート

- サポート

- 確か

- 撮影

- 取得

- ターゲット

- チーム

- テク

- 技術的

- 技術

- テクニック

- テクノロジー

- テクノロジー

- 클라우드 기반 AI/ML및 고성능 컴퓨팅을 통한 디지털 트윈의 기초 – Edward Hsu, Rescale CPO 많은 엔지니어링 중심 기업에게 클라우드는 R&D디지털 전환의 첫 단계일 뿐입니다. 클라우드 자원을 활용해 엔지니어링 팀의 제약을 해결하는 단계를 넘어, 시뮬레이션 운영을 통합하고 최적화하며, 궁극적으로는 모델 기반의 협업과 의사 결정을 지원하여 신제품을 결정할 때 데이터 기반 엔지니어링을 적용하고자 합니다. Rescale은 이러한 혁신을 돕기 위해 컴퓨팅 추천 엔진, 통합 데이터 패브릭, 메타데이터 관리 등을 개발하고 있습니다. 이번 자리를 빌려 비즈니스 경쟁력 제고를 위한 디지털 트윈 및 디지털 스레드 전략 개발 방법에 대한 인사이트를 나누고자 합니다.

- それ

- アプリ環境に合わせて

- それら

- そこ。

- したがって、

- ボーマン

- 彼ら

- 物事

- この

- 介して

- スループット

- 時間

- <font style="vertical-align: inherit;">回数</font>

- 役職

- 〜へ

- 一緒に

- トークン化

- トークン

- 取った

- ツール

- top

- TPS

- トラフィック

- トレーニング

- 訓練された

- トレーニング

- トランス

- トレンド

- トリトン

- true

- 2

- 理解する

- 間違いなく

- 宇宙

- ロック解除

- 発表

- us

- つかいます

- 中古

- users

- 使用されます

- 活用

- 値

- 広大な

- 汎用性

- 非常に

- 待っています

- 歩く

- Walmart

- ました

- 見ている

- 方法

- we

- ウェブ

- Webサービス

- WELL

- した

- いつ

- 一方

- while

- 意志

- 仕事

- 働いていました

- ワーキング

- 作品

- 世界

- 不安

- まだ

- 得られた

- You

- あなたの

- ゼファーネット