ジェネレーティブ AI は、エンターテインメント、広告、グラフィック デザインなど、さまざまな業界でクリエイティブ プロセスを強化および加速するための一般的なツールとなっています。 これにより、視聴者にとってよりパーソナライズされたエクスペリエンスが可能になり、最終製品の全体的な品質が向上します。

生成 AI の大きな利点の XNUMX つは、ユーザーにユニークでパーソナライズされたエクスペリエンスを作成できることです。 たとえば、ストリーミング サービスでは生成 AI を使用して、パーソナライズされた映画のタイトルとビジュアルを生成して視聴者のエンゲージメントを高め、ユーザーの視聴履歴や好みに基づいてタイトルのビジュアルを構築します。 次に、システムはタイトルのアートワークの何千ものバリエーションを生成し、それらをテストしてどのバージョンがユーザーの注意を最も引き付けるかを決定します。 場合によっては、テレビ シリーズのパーソナライズされたアートワークにより、パーソナライズされたアートワークのない番組と比較して、クリック率と視聴率が大幅に増加しました。

この投稿では、Stable Diffusion のような生成 AI モデルを使用して、パーソナライズされたアバター ソリューションを構築する方法を示します。 アマゾンセージメーカー マルチモデル エンドポイント (MME) による推論コストを同時に節約します。 このソリューションでは、次のスクリーンショットに示すように、自分の 10 ~ 12 枚の画像をアップロードすることで、任意のテキスト プロンプトに基づいてアバターを生成できるパーソナライズされたモデルを微調整する方法を示します。 この例ではパーソナライズされたアバターを生成しますが、特定のオブジェクトやスタイルを微調整することで、このテクニックをあらゆる創造的なアートの生成に適用できます。

ソリューションの概要

次のアーキテクチャ図は、アバター ジェネレーターのエンドツーエンド ソリューションの概要を示しています。

![]()

この投稿の範囲と例 GitHubコード モデルのトレーニングと推論オーケストレーション (上の図の緑色のセクション) のみに焦点を当てます。 完全なソリューション アーキテクチャを参照し、提供される例に基づいて構築することができます。

モデルのトレーニングと推論は、次の XNUMX つのステップに分類できます。

- 画像をアップロードする Amazon シンプル ストレージ サービス (アマゾンS3)。 このステップでは、ご自身の高解像度画像を少なくとも 10 枚提供するようお願いします。 画像が多いほど結果は良くなりますが、トレーニングにかかる時間は長くなります。

- SageMaker 非同期推論を使用して、Stable Diffusion 2.1 基本モデルを微調整します。 トレーニングに推論エンドポイントを使用する理論的根拠については、この投稿の後半で説明します。 微調整プロセスは、顔のトリミング、背景のバリエーション、モデルのサイズ変更などの画像の準備から始まります。 次に、大規模言語モデル (LLM) 向けのパラメーター効率の高い微調整手法である低ランク適応 (LoRA) を使用してモデルを微調整します。 最後に、後処理では、微調整された LoRA 重みを推論スクリプトおよび構成ファイル (tar.gz) とともにパッケージ化し、SageMaker MME の S3 バケットの場所にアップロードします。

- GPU を備えた SageMaker MME を使用して、微調整されたモデルをホストします。 SageMaker は、各モデルへの推論トラフィックに基づいて、Amazon S3 の場所からモデルを動的にロードしてキャッシュします。

- 微調整されたモデルを推論に使用します。 後に Amazon シンプル通知サービス 微調整が送信されたことを示す (Amazon SNS) 通知が送信されたら、

target_modelMME を呼び出してアバターを作成するときにパラメータを使用します。

次のセクションで各ステップを詳しく説明し、サンプル コード スニペットのいくつかを順に見ていきます。

画像を準備する

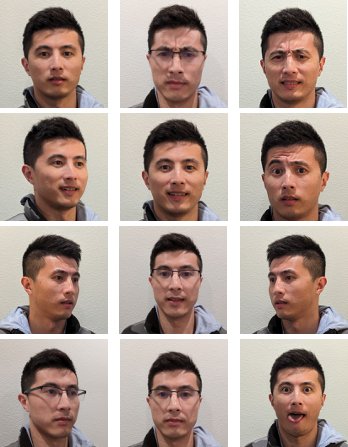

安定拡散を微調整して自分の画像を生成することで最良の結果を得るには、通常、さまざまな角度、さまざまな表情、さまざまな背景から撮った、大量かつ多様な自分の写真を提供する必要があります。 ただし、私たちの実装では、わずか 10 個の入力画像で高品質の結果を達成できるようになりました。 各写真から顔を抽出するための自動前処理も追加しました。 必要なのは、複数の視点から自分がどのように見えるかの本質を明確に捉えることだけです。 正面を向いた写真、両側から撮影した横顔、およびその間の角度から撮影した写真を含めます。 笑顔、しかめ面、無表情など、さまざまな表情の写真も含める必要があります。 表情を組み合わせることで、モデルがあなたのユニークな顔の特徴をよりよく再現できるようになります。 入力画像によって、生成できるアバターの品質が決まります。 これが適切に行われるように、画像のキャプチャとアップロードのプロセスをユーザーにガイドする直感的なフロントエンド UI エクスペリエンスをお勧めします。

以下は、さまざまな角度、さまざまな表情の自撮り画像の例です。

![]()

安定拡散モデルを微調整する

画像が Amazon S3 にアップロードされた後、 SageMaker 非同期推論 トレーニング プロセスを開始するためのエンドポイント。 非同期エンドポイントは、大きなペイロード (最大 1 GB) と長い処理時間 (最大 1 時間) を伴う推論のユースケースを対象としています。 また、自動スケーリングなどの SageMaker ホスティングの他のネイティブ機能に加えて、リクエストをキューに入れるための組み込みのキューイング メカニズムと、Amazon SNS を介したタスク完了通知メカニズムも提供します。

微調整は推論のユースケースではありませんが、組み込みのキューと通知メカニズムにより、ここでは SageMaker トレーニング ジョブの代わりに微調整を利用することにしました。 マネージドオートスケーリングこれには、サービスが使用されていないときにインスタンスを 0 にスケールダウンする機能が含まれます。 これにより、微調整サービスを多数の同時ユーザーに簡単に拡張できるようになり、追加のコンポーネントを実装して管理する必要がなくなります。 ただし、ペイロードが 1 GB、最大処理時間が 1 時間であるという欠点があります。 私たちのテストでは、ml.g20xlarge インスタンス上の約 10 個の入力イメージでかなり良好な結果を得るには 5.2 分で十分であることがわかりました。 ただし、大規模な微調整ジョブには SageMaker トレーニングが推奨されるアプローチです。

非同期エンドポイントをホストするには、いくつかの手順を完了する必要があります。 XNUMX つ目は、モデル サーバーを定義することです。 この投稿では、 大規模モデル推論コンテナ (LMI)。 LMI は、プログラミング言語に依存しない高性能なモデル サービング ソリューションである DJL Serving を利用しています。 SageMaker マネージド推論コンテナには、Hugging Face など、必要なトレーニング ライブラリの多くがすでに含まれているため、このオプションを選択しました。 ディフューザー および 加速する。 これにより、微調整ジョブのためにコンテナーをカスタマイズするために必要な作業量が大幅に削減されます。

次のコード スニペットは、この例で使用した LMI コンテナのバージョンを示しています。

それに加えて、 serving.properties 使用する推論エンジン、モデル アーティファクトの場所、動的バッチ処理などの提供プロパティを構成するファイル。 最後に、 model.py モデルを推論エンジンにロードし、モデルからのデータ入出力を準備するファイル。 この例では、 model.py ファイルを使用して微調整ジョブを起動します。これについては、後のセクションで詳しく説明します。 どちらも serving.properties および model.py ファイルは、 training_service フォルダにコピーします。

モデルサーバーを定義した後の次のステップは、非同期推論がどのように提供されるかを定義するエンドポイント構成を作成することです。 この例では、最大同時呼び出し制限と出力 S3 の場所を定義しているだけです。 とともに ml.g5.2xlarge たとえば、メモリ不足 (OOM) 例外が発生することなく、最大 XNUMX つのモデルを同時に微調整できることがわかったので、 max_concurrent_invocations_per_instance 異なるチューニング パラメーター セットまたはより小さいインスタンス タイプを使用している場合は、この数値を調整する必要がある場合があります。 最初にこれを 2 に設定し、GPU メモリ使用率を監視することをお勧めします。 アマゾンクラウドウォッチ.

最後に、コンテナ情報、モデル ファイル、および AWS IDおよびアクセス管理 (IAM) ロールを単一のオブジェクトに統合します。 モデルは、前に定義したエンドポイント構成を使用してデプロイされます。

エンドポイントの準備ができたら、次のサンプル コードを使用して非同期エンドポイントを呼び出し、微調整プロセスを開始します。

SageMaker の LMI の詳細については、以下を参照してください。 DJLServing と DeepSpeed モデルの並列推論を使用して、Amazon SageMaker に大規模なモデルをデプロイする.

呼び出し後、非同期エンドポイントは微調整ジョブのキューを開始します。 各ジョブは、イメージの準備、Dreambooth と LoRA の微調整の実行、モデル アーティファクトの準備という手順を実行します。 微調整プロセスをさらに詳しく見てみましょう。

画像を準備する

前述したように、入力画像の品質は、微調整されたモデルの品質に直接影響します。 アバターの使用例では、モデルの顔の特徴に焦点を当てたいと考えています。 ユーザーに正確なサイズと内容の慎重に厳選された画像の提供を要求する代わりに、コンピューター ビジョン技術を使用した前処理ステップを実装して、この負担を軽減します。 前処理ステップでは、まず顔検出モデルを使用して、各画像内の最大の顔を分離します。 次に、モデルに必要なサイズの 512 x 512 ピクセルに画像をトリミングしてパディングします。 最後に、背景から顔をセグメント化し、ランダムな背景のバリエーションを追加します。 これは顔の特徴を強調するのに役立ち、モデルが背景ではなく顔自体から学習できるようになります。 次の図は、このプロセスの XNUMX つのステップを示しています。

| ステップ1: コンピュータビジョンを使用した顔検出 | ステップ2: 画像をトリミングして 512 x 512 ピクセルにパディングします | ステップ3(オプション): セグメント化して背景のバリエーションを追加する |

Dreambooth と LoRA の微調整

微調整には、Dreambooth と LoRA の技術を組み合わせました。 Dreambooth を使用すると、一意の識別子を使用してモデルの出力ドメインに主題を埋め込み、モデルの言語ビジョン辞書を拡張して、安定拡散モデルをパーソナライズできます。 と呼ばれる方法を使用します 事前保存 被写体のクラス (この場合は人) に関するモデルの意味論的な知識を保持し、クラス内の他のオブジェクトを使用して最終的な画像出力を改善します。 これにより、Dreambooth は被写体のわずか数枚の入力画像で高品質の結果を達成できるようになります。

次のコード スニペットは、への入力を示しています。 trainer.py アバター ソリューションのクラス。 私たちが選んだことに注目してください <<TOK>> 一意の識別子として。 これは、モデルの辞書に既に存在する可能性のある名前の選択を避けるために意図的に行われます。 名前がすでに存在する場合、モデルは対象を学習解除してから再学習する必要があり、これにより微調整結果が不十分になる可能性があります。 対象クラスは次のように設定されています “a photo of person”これにより、微調整プロセス中に追加入力としてフィードする人物の写真を最初に生成することで、事前の保存が可能になります。 これは、モデルが以前の保存方法を使用して人の以前の知識を保存しようとするため、過剰適合を軽減するのに役立ちます。

設定では、次のような多くのメモリ節約オプションが有効になっています。 fp16, use_8bit_adam、および勾配累積。 これにより、メモリの設置面積が 12 GB 未満に削減され、XNUMX 台のマシンで最大 XNUMX つのモデルを同時に微調整できます。 ml.g5.2xlarge インスタンス。

LoRA は、ほとんどの重みをフリーズし、事前トレーニングされた LLM の特定のレイヤーに小さなアダプター ネットワークを接続する LLM の効率的な微調整手法であり、より高速なトレーニングと最適化されたストレージを可能にします。 安定した拡散のために、アダプターは推論パイプラインのテキスト エンコーダーと U-Net コンポーネントに接続されます。 テキスト エンコーダーは入力プロンプトを U-Net モデルが理解できる潜在空間に変換し、U-Net モデルはその潜在的な意味を使用して、後続の拡散プロセスで画像を生成します。 微調整の出力は、 text_encoder U-Net アダプターの重量。 推論時に、これらの重みをベースの安定拡散モデルに再接続して、微調整結果を再現できます。

以下の図は、原著者が提供した LoRA 微調整の詳細図です。 Cheng-Han Chiang、Yung-Sung Chuang、Hung-yi Lee、「AACL_2022_tutorial_PLMs」、2022

両方の方法を組み合わせることで、桁違いに少ないパラメータを調整しながら、パーソナライズされたモデルを生成することができました。 これにより、トレーニング時間が大幅に短縮され、GPU 使用率が削減されました。 さらに、完全な安定拡散モデルの 70 GB と比較して、アダプターの重量がわずか 6 MB になるようにストレージが最適化され、サイズが 99% 削減されました。

モデルアーティファクトを準備する

微調整が完了したら、後処理ステップで、NVIDIA Triton 用のファイルを提供するモデルの残りの部分を使用して LoRA 重みを TAR します。 Python バックエンドを使用します。つまり、推論に使用される Triton 構成ファイルと Python スクリプトが必要です。 Python スクリプトには名前を付ける必要があることに注意してください。 model.py。 最終モデル TAR ファイルは次のファイル構造になっている必要があります。

GPU を備えた SageMaker MME を使用して微調整されたモデルをホストする

モデルが微調整された後、SageMaker MME を使用してパーソナライズされた安定拡散モデルをホストします。 SageMaker MME は、単一のエンドポイントの背後にある単一のコンテナーで複数のモデルをホストできる強力なデプロイメント機能です。 トラフィックとモデルへのルーティングを自動的に管理して、リソース使用率を最適化し、コストを節約し、数千のエンドポイントを管理する運用負担を最小限に抑えます。 この例では、GPU インスタンス上で実行しており、SageMaker MME は Triton Server を使用して GPU をサポートしています。 これにより、単一の GPU デバイス上で複数のモデルを実行し、高速化されたコンピューティングを利用できるようになります。 SageMaker MME で Stable Diffusion をホストする方法の詳細については、以下を参照してください。 安定拡散モデルで高品質のイメージを作成し、Amazon SageMaker でコスト効率よくデプロイします。.

この例では、コールド スタート状況で微調整されたモデルをより速く読み込むために追加の最適化を行いました。 これは LoRA のアダプター設計により可能です。 基本モデルの重みと Conda 環境はすべての微調整モデルで同じであるため、これらの共通リソースをホスティング コンテナーに事前にロードすることで共有できます。 これにより、Triton 構成ファイル、Python バックエンド (model.py)、および LoRA アダプターの重みは、最初の呼び出し後に Amazon S3 から動的にロードされます。 次の図は、並べて比較したものです。

![]()

これにより、モデル TAR ファイルが約 6 GB から 70 MB に大幅に削減されるため、ロードと解凍が大幅に高速化されます。 この例でプリロードを行うために、ユーティリティ Python バックエンド モデルを作成しました。 models/model_setup。 スクリプトは、ベースの安定拡散モデルと Conda 環境を Amazon S3 から共通の場所にコピーするだけで、すべての微調整されたモデル間で共有されます。 以下は、タスクを実行するコード スニペットです。

その後、微調整された各モデルは、コンテナー上の共有場所を指します。 Conda 環境は以下で参照されています。 config.pbtxt.

安定拡散ベースモデルは、 initialize() それぞれの機能 model.py ファイル。 次に、パーソナライズされた LoRA 重みを unet に適用し、 text_encoder 微調整された各モデルを再現するためのモデル:

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 自動車/EV、 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- ブロックオフセット。 環境オフセット所有権の近代化。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/build-a-personalized-avatar-with-generative-ai-using-amazon-sagemaker/

- :持っている

- :は

- :not

- :どこ

- $UP

- 1

- 10

- 100

- 12

- 13

- 視聴者の38%が

- 17

- 20

- 32

- 7

- 70

- 700

- 8

- 9

- a

- 能力

- できる

- 私たちについて

- 加速された

- 加速している

- アクセス

- アクセス可能な

- 累積

- 達成する

- 越えて

- 適応

- 加えます

- 追加されました

- 添加

- NEW

- さらに

- 調整

- 利点

- 広告運用

- 後

- AI

- AIモデル

- AIサービス

- AI / ML

- すべて

- 緩和する

- 許す

- 許可

- ことができます

- 既に

- また

- しかし

- 素人

- Amazon

- アマゾンセージメーカー

- Amazon Webサービス

- 周囲の

- 量

- an

- 解剖学

- および

- どれか

- 申し込む

- アプローチ

- 約

- 建築

- です

- 宝品

- 芸術作品

- AS

- 資産

- 支援する

- At

- 注意

- 魅力

- ヒアリング

- 著者

- オート

- 自動化

- 自動的に

- 利用できます

- アバター

- アバター

- 避ける

- AWS

- バックエンド

- 背景

- 背景

- 悪い

- ベース

- ベース

- 基本

- BE

- なぜなら

- になる

- き

- 背後に

- さ

- 以下

- 恩恵

- BEST

- より良いです

- の間に

- ボディ

- 両言語で

- 壊れた

- ビルド

- 内蔵

- 負担

- ビジネス

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- キャッシュ

- 呼ばれます

- 缶

- 機能

- キャプチャー

- 慎重に

- 場合

- 例

- キャッチ

- 課題

- 課金

- 選んだ

- 映画の

- 街並み

- class

- はっきりと

- コード

- 冷たい

- 組み合わせた

- 結合

- 来ます

- コマンドと

- 比べ

- 比較

- コンプリート

- 完成

- 複雑な

- コンポーネント

- 構図

- 計算

- コンピュータ

- Computer Vision

- コンセプト

- 同時

- コンテナ

- コンテンツ

- 変換

- 基本

- 費用

- コスト

- カバー

- 作ります

- 作成した

- 作成

- 創作

- クリエイティブ

- 作物

- キュレーション

- 現在

- Customers

- カスタマイズ

- カスタマイズ

- カット

- データ

- 中

- 専用の

- 深いです

- 深い学習

- より深い

- 定義します

- 定義済みの

- 定義する

- 定義

- 民主化

- 実証します

- 実証

- 実証

- 展開します

- 展開

- 展開する

- 展開

- 設計

- 詳細

- 詳細な

- 細部

- 検出

- 決定する

- Developer

- デバイス

- 異なります

- 直接に

- 異なる

- Diy

- do

- ありません

- ドメイン

- 行われ

- ダウン

- ドラフト

- 描かれた

- 原因

- 間に

- ダイナミック

- 動的に

- e

- eコマース

- 各

- 前

- 簡単に

- 効率的な

- 排除

- 埋め込み

- 使用可能

- 可能

- 遭遇

- 奨励する

- 端から端まで

- エンドレス

- エンドポイント

- 婚約

- エンジン

- エンジニアリング

- 高めます

- 強化

- Enterprise

- エンターテインメント

- 環境

- 環境

- EPIC

- 本質

- 例

- 例

- 除く

- 例外

- 存在

- 拡大

- 体験

- エクスペリエンス

- 実験

- 専門知識

- 説明する

- 探る

- 露出した

- 表現

- 表現

- 余分な

- エキス

- 顔

- フェイシャル

- 不良解析

- 家族

- 速いです

- 特徴

- 特徴

- 足

- 少数の

- より少ない

- フィギュア

- File

- ファイナル

- 最後に

- ファイナンシャル

- 名

- フォーカス

- 焦点を当て

- 焦点を当てて

- フォロー中

- フットプリント

- 発見

- 4

- FRAME

- から

- フル

- function

- Games

- 賭博

- 生成する

- 生成

- 生成

- 世代

- 生々しい

- 生成AI

- ジェネレータ

- 取得する

- GIF

- GitHubの

- 目標

- 行く

- 良い

- GPU

- グラフィック

- 大きい

- 大いに

- グリーン

- 総

- ガイド

- ハンド

- 持ってる

- 持って

- he

- 助けます

- 助け

- ことができます

- 彼女の

- こちら

- ハイパフォーマンス

- 高品質

- 高解像度の

- 特徴

- 非常に

- 彼の

- history

- 希望

- host

- ホスティング

- 時間

- お家の掃除

- 認定条件

- How To

- しかしながら

- HTML

- HTTP

- HTTPS

- 識別子

- アイデンティティ

- if

- 画像

- 画像

- 直ちに

- 影響

- 実装する

- 実装

- 改善します

- in

- include

- 含めて

- 増える

- 増加した

- 個性

- 産業

- 産業を変えます

- 情報

- 有益な

- 当初

- 革新的な

- 革新的な技術

- 入力

- インスピレーション

- を取得する必要がある者

- 説明書

- 保険

- 意図された

- 関心

- に

- 直観的な

- IT

- ITS

- 自体

- ジェームズ

- ジョブ

- Jobs > Create New Job

- 参加

- JPG

- JSON

- ただ

- 一つだけ

- キー

- 知識

- ラベル

- 言語

- 大

- 最大の

- 後で

- 層

- つながる

- リーダー

- リーダーシップ

- LEARN

- 学習

- リー

- ライブラリ

- 照明

- ような

- LIMIT

- LLM

- 負荷

- 負荷

- 場所

- 長い

- より長いです

- 見て

- 愛

- ロー

- 機械

- 機械学習

- 製

- メイン

- make

- 作成

- 管理します

- マネージド

- マネージャー

- 管理する

- 管理する

- 多くの

- マーケティング

- マーケティングと広告

- 五月..

- 意味

- 手段

- メカニズム

- メカニズム

- メディア

- メモリ

- 言及した

- メッセージ

- 方法

- メソッド

- 最小

- 分

- ミックス

- ML

- モデル

- 節度

- モニタリング

- 他には?

- 最も

- やる気

- 映画

- ずっと

- の試合に

- しなければなりません

- 名

- 名前付き

- ネイティブ

- ナチュラル

- 自然言語処理

- 必要

- ネットワーク

- 普通

- 次の

- なし

- ノート

- 知らせ..

- 通知

- 今

- 数

- Nvidia

- オブジェクト

- オブジェクト

- of

- オフ

- 油

- on

- ONE

- の

- 〜に

- オペレーショナル

- 最適化

- 最適化

- 最適化

- オプション

- オプション

- or

- 編成

- オリジナル

- OS

- その他

- 私たちの

- でる

- 輪郭

- 出力

- が

- 全体

- パッケージ

- パッケージ

- パッド

- 並列シミュレーションの設定

- パラメーター

- パラメータ

- 部

- 渡された

- 情熱的な

- path

- のワークプ

- 完璧

- 実行する

- 実行する

- 人

- 人格

- 個人

- カスタマイズ

- 視点

- 写真

- 写真

- 画像

- パイプ

- パイプライン

- プラットフォーム

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- ポイント

- 貧しいです

- 肖像

- の可能性

- 可能

- ポスト

- 潜在的な

- パワード

- 強力な

- Predictor

- プ

- 準備

- 準備する

- 準備中

- 保全

- 前

- 主要な

- 印刷物

- 事前の

- プロセス

- 処理

- プロダクト

- プロダクトマネージャー

- 製品

- プロフィール

- プログラミング

- プロジェクト(実績作品)

- 推進

- 正しく

- プロパティ

- 提供します

- 提供

- は、大阪で

- Python

- 品質

- 量

- ランダム

- 範囲

- 価格表

- むしろ

- 根拠

- リーディング

- 準備

- 推奨する

- 推奨される

- 減らします

- 電話代などの費用を削減

- 軽減

- 削減

- 反映する

- に対する

- 関連する

- 表します

- 要求

- リクエスト

- の提出が必要です

- リソースを追加する。

- リソース

- 応答

- 責任

- REST

- 結果

- 結果

- ロックスター

- 職種

- 大体

- ルーティング

- ラン

- runs

- セージメーカー

- SageMaker の推論

- 同じ

- Save

- 規模

- スケーリング

- サイエンスフィクション

- スコープ

- スクリーンショット

- セクション

- セクション

- シード

- セグメント

- 自己

- 自分撮り

- シニア

- 送信

- シリーズ

- サービス

- サービス

- サービング

- セッションに

- 設定

- いくつかの

- 形状

- シェアする

- shared

- シャープ

- 彼女

- ショット

- すべき

- 示す

- 作品

- 側

- 重要

- 著しく

- サイモン

- 簡単な拡張で

- 単に

- 状況

- サイズ

- 小さい

- より小さい

- スニペット

- 社会

- ソーシャルメディア

- ソーシャルプラットフォーム

- 溶液

- ソリューション

- 一部

- スペース

- 専門家

- 特化

- 特定の

- 支出

- スピン

- 安定した

- start

- 開始

- 開始

- 手順

- ステップ

- ストレージ利用料

- 保存され

- ストリーミング

- ストリーミングサービス

- 文字列

- 構造

- テーマ

- それに続きます

- 成功した

- そのような

- 十分な

- 補給

- サポート

- 確か

- 取る

- 仕事

- チーム

- TechCrunchの

- テクニック

- テクノロジー

- テクノロジー

- テスト

- テスト

- より

- それ

- アプリ環境に合わせて

- それら

- その後

- したがって、

- ボーマン

- この

- しかし?

- 考え

- 思考リーダーシップ

- 数千

- 三

- 介して

- 時間

- <font style="vertical-align: inherit;">回数</font>

- タイトル

- 〜へ

- ツール

- top

- トラフィック

- トレーニング

- トレーニング

- 変換

- 旅行

- トリトン

- 試します

- tv

- 2

- type

- 一般的に

- ui

- 下

- 理解された

- ユニーク

- 不要

- アップロード

- アップロード

- us

- USA

- つかいます

- 使用事例

- 中古

- ユーザー

- users

- 使用されます

- ユーティリティ

- 活用する

- 値

- 多様

- さまざまな

- バージョン

- 、

- 詳しく見る

- 鑑賞

- バージニア州

- ビジョン

- ビジュアル

- 欲しいです

- ました

- 透かし

- we

- ウェブ

- Webサービス

- 重量

- した

- この試験は

- いつ

- which

- while

- その

- ワイド

- 広い範囲

- 意志

- 無し

- 仕事

- ワーキング

- 最悪

- でしょう

- X

- 年

- You

- あなたの

- あなた自身

- ゼファーネット