本日、大規模言語モデル (LLM) を使用した検索拡張生成 (RAG) ベースのアプローチを使用した質問応答タスクを示すサンプル ノートブックが利用可能になったことを発表します。 Amazon SageMaker ジャンプスタート。 RAG と LLM を使用したテキスト生成では、LLM に供給されるコンテキストの一部として特定の外部データを提供することで、ドメイン固有のテキスト出力を生成できます。

JumpStart は、機械学習 (ML) の取り組みを加速するのに役立つ機械学習 (ML) ハブです。 JumpStart は、事前トレーニングされた言語モデルを多数提供します。 基礎モデル 記事の要約、質問への回答、会話の生成や画像の生成などのタスクを実行するのに役立ちます。

この投稿では、RAG とその利点について説明し、ジャンプスタートで LLM を使用した RAG 実装を使用して質問応答タスクを解決するサンプル ノートブックを使用して、すぐに開始する方法を示します。 次の XNUMX つのアプローチを示します。

- オープンソースの問題を解決する方法 ラングチェーン ライブラリと アマゾンセージメーカー 数行のコードでエンドポイントを作成

- SageMaker KNN アルゴリズムを使用して、SageMaker エンドポイントを使用して大規模データのセマンティック検索を実行する方法

LLMS と制約

LLM は大量の非構造化データでトレーニングされており、一般的なテキスト生成に優れています。 LLM は、自然言語データの大規模なコーパスでパラメータをトレーニングすることにより、事実の知識を保存できます。

既製の事前トレーニング済み LLM の使用にはいくつかの制限があります。

- 通常、オフラインでトレーニングされるため、モデルは最新の情報に依存しません (たとえば、2011 年から 2018 年にトレーニングされたチャットボットには、新型コロナウイルス感染症 (COVID-19) に関する情報がありません)。

- パラメータに保存されている情報のみを参照して予測を行うため、解釈可能性が低くなります。

- 彼らは主に一般的なドメイン コーパスについてトレーニングされているため、ドメイン固有のタスクではあまり効果的ではありません。 モデルに一般的なデータではなく特定のデータに基づいてテキストを生成させたいシナリオがあります。 たとえば、健康保険会社は、回答が正確で、独自のビジネス ルールを反映できるように、企業ドキュメント リポジトリまたはデータベースに保存されている最新情報を使用して質問応答ボットが質問に回答できるようにしたい場合があります。

現在、LLM 内の特定のデータを参照するには XNUMX つの一般的な方法があります。

- 結果の作成中にモデルが使用できる情報を提供する方法として、モデル プロンプトにデータをコンテキストとして挿入します。

- プロンプトと補完のペアを含むファイルを提供してモデルを微調整する

コンテキストベースのアプローチの課題は、モデルのコンテキスト サイズが制限されており、すべてのドキュメントをコンテキストとして含めると、モデルの許容コンテキスト サイズに収まらない可能性があることです。 使用するモデルによっては、より大きなコンテキストに対して追加料金が発生する場合もあります。

微調整のアプローチでは、適切な形式の情報を生成するのに時間がかかり、コストもかかります。 さらに、微調整に使用される外部データが頻繁に変更される場合、正確な結果を作成するには頻繁な微調整と再トレーニングが必要であることを意味します。 頻繁なトレーニングは市場投入までの速度に影響し、ソリューション全体のコストが増加します。

これらの制約を実証するために、LLM Flan T5 XXL モデルを使用し、次の質問をしました。

次の応答があります。

ご覧のとおり、応答は正確ではありません。 正解は、すべての SageMaker インスタンスがマネージド スポット トレーニングをサポートしていることです。

同じ質問を試みましたが、追加のコンテキストが質問とともに渡されました。

今回は以下のような回答を頂きました。

応答は良くなりましたが、まだ正確ではありません。 ただし、実際の実稼働ユースケースでは、ユーザーがさまざまなクエリを送信する可能性があり、正確な応答を提供するために、利用可能な情報のすべてまたはほとんどを静的コンテキストの一部として含めて正確な応答を作成することが必要な場合があります。 したがって、このアプローチでは、質問された質問に関連しない情報もコンテキストの一部として送信されるため、コンテキスト サイズ制限の制約に遭遇する可能性があります。 ここで、RAG ベースのアプローチを使用して、ユーザーのクエリに対するスケーラブルで正確な応答を作成できます。

検索拡張生成

説明した制約を解決するには、LLM で検索拡張生成 (RAG) を使用できます。 RAG は、言語モデルの外部 (ノンパラメトリック) からデータを取得し、取得した関連データをコンテキスト内に追加することでプロンプトを拡張します。 RAG モデルは以下によって導入されました。 ルイスら。 2020年に パラメトリック メモリが事前トレーニングされた seq2seq モデルであり、ノンパラメトリック メモリがウィキペディアの密なベクトル インデックスであるモデルとして、事前トレーニングされたニューラル リトリーバーでアクセスします。

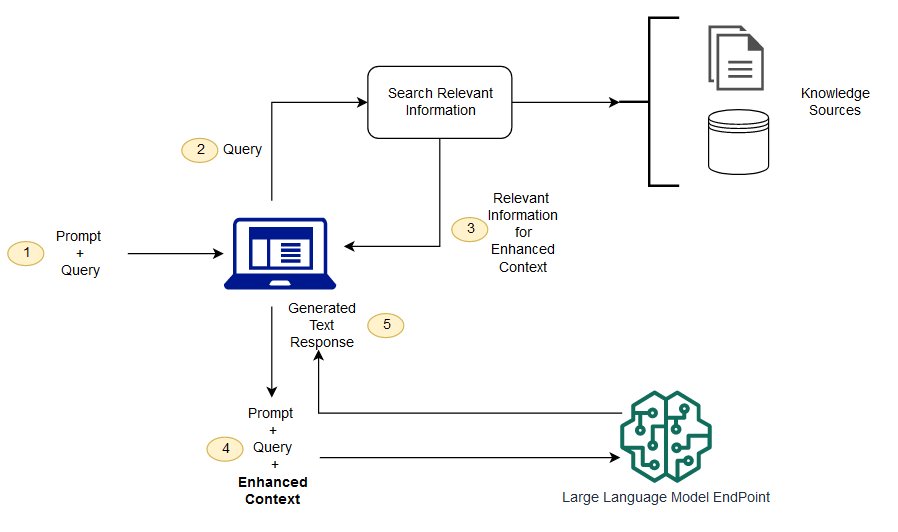

RAG では、ドキュメント リポジトリ、データベース、API などの複数のデータ ソースから外部データを取得できます。 最初のステップは、ドキュメントとユーザー クエリを比較して関連性検索を実行できる形式に変換することです。 関連性検索を実行するためにフォーマットを比較できるようにするために、文書コレクション (ナレッジ ライブラリ) とユーザーが送信したクエリは、埋め込み言語モデルを使用して数値表現に変換されます。 埋め込みは本質的に、テキスト内の概念を数値的に表現したものです。 次に、ユーザー クエリの埋め込みに基づいて、埋め込み空間での類似性検索によって、ドキュメント コレクション内でその関連テキストが特定されます。 次に、ユーザーが提供したプロンプトに、検索された関連テキストが追加され、コンテキストに追加されます。 プロンプトは LLM に送信され、コンテキストには元のプロンプトとともに関連する外部データが含まれるため、モデルの出力は関連性があり正確になります。

参照ドキュメントの最新情報を維持するには、ドキュメントを非同期的に更新し、ドキュメントの埋め込み表現を更新します。 このようにして、更新されたドキュメントを使用して今後の質問に対する回答が生成され、正確な回答が提供されます。

次の図は、LLM で RAG を使用する概念的なフローを示しています。

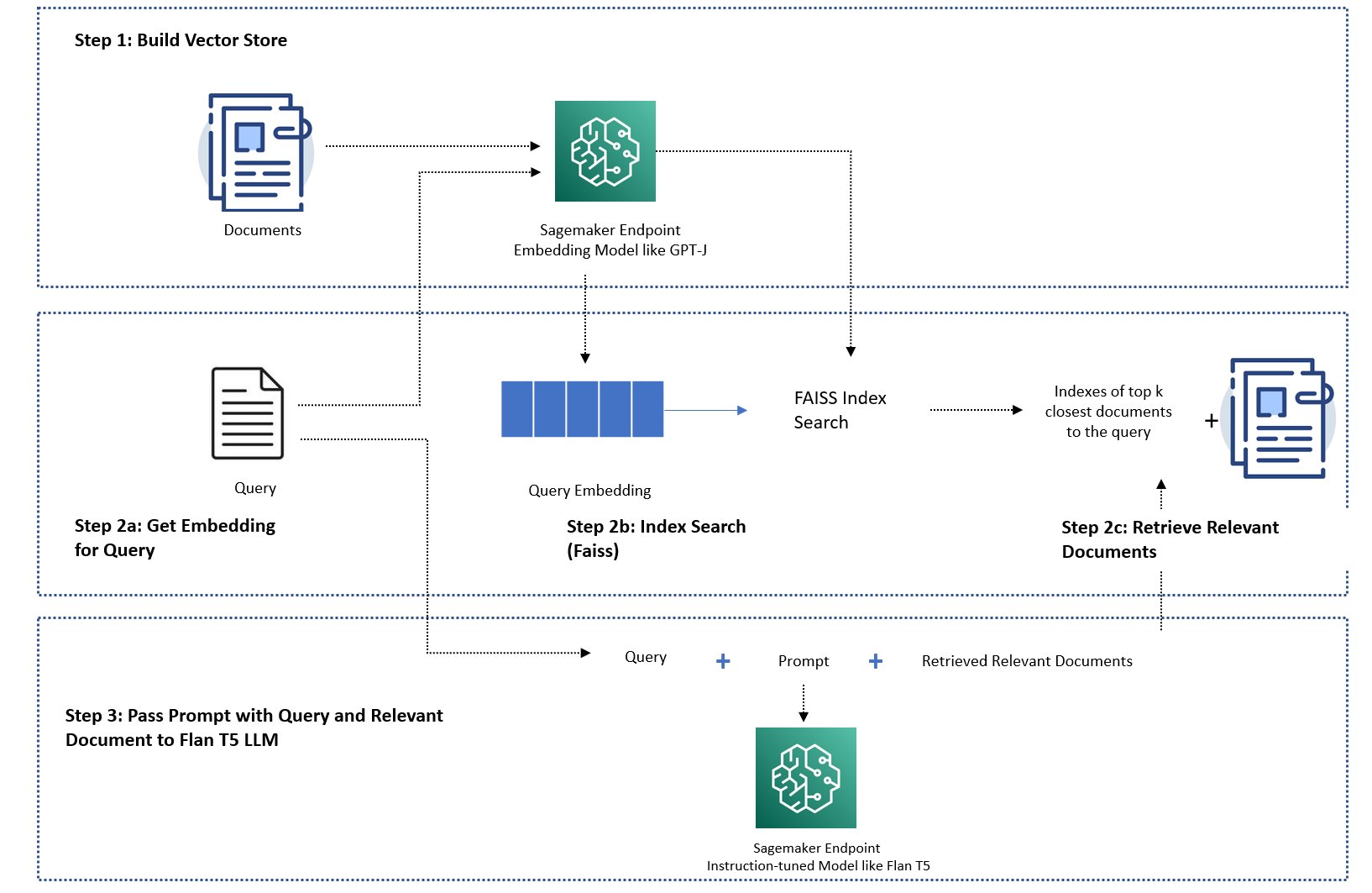

この投稿では、次の手順で質問応答アプリケーションを実装する方法を示します。

- SageMaker GPT-J-6B 埋め込みモデルを使用して、ナレッジ ライブラリ内の各ドキュメントの埋め込みを生成します。

- ユーザーのクエリに基づいて、最も関連性の高いドキュメントの上位 K 個を特定します。

- クエリに対して、同じ埋め込みモデルを使用してクエリの埋め込みを生成します。

- インメモリ FAISS 検索を使用して、埋め込みスペース内で最も関連性の高い上位 K 個のドキュメントのインデックスを検索します。

- インデックスを使用して、対応するドキュメントを取得します。

- 取得した関連ドキュメントをプロンプトと質問のコンテキストとして使用し、それらを SageMaker LLM に送信して応答を生成します。

次のアプローチを示します。

- SageMaker LLM を使用して質問応答タスクを解決し、エンドポイントとオープンソース ライブラリ LangChain を数行のコードで解決する方法。 特に、LLM (Flan T5 XXL) と埋め込みモデル (GPT-J 6B) に XNUMX つの SageMaker エンドポイントを使用し、使用されるベクター データベースはメモリ内にあります。 フェイス。 詳細については、「 GitHubレポ.

- インメモリ FAISS が大規模なデータセットに適合しない場合は、 SageMaker KNN アルゴリズム セマンティック検索を実行します。これも基礎となる検索アルゴリズムとして FAISS を使用します。 詳細については、 GitHubレポ.

次の図は、ソリューション アーキテクチャを示しています。

LangChain を使用した JumpStart RAG ベースの実装ノートブック

ラングチェーン は、言語モデルを利用してアプリケーションを開発するためのオープンソース フレームワークです。 LangChain は、さまざまな LLM に汎用インターフェイスを提供します。 また、開発者がさまざまな LLM をチェーンして強力なアプリケーションを構築することも容易になります。 LangChain は、エージェントまたはチェーンの呼び出し間で状態を保持するためのメモリの標準インターフェイスとメモリ実装のコレクションを提供します。

LangChain には、開発者の生産性を向上させる他の多くのユーティリティ機能があります。 これらの機能には、プロンプト テンプレート内の変数を使用してプロンプトをカスタマイズするのに役立つプロンプト テンプレート、エンドツーエンド アプリケーションを構築するエージェント、チェーンの検索および取得ステップのインデックスなどが含まれます。 LangChain の機能をさらに詳しく調べるには、以下を参照してください。 ラングチェーンのドキュメント.

LLM モデルの作成

最初のステップとして、選択した JumpStart LLM モデルをデプロイします。 このデモでは、Jumpstart Flan T5 XXL モデル エンドポイントを使用します。 導入手順については、以下を参照してください。 Amazon SageMaker JumpStart での Flan-T5 基盤モデルのゼロショット プロンプト。 ユースケースに基づいて、次のような他の命令調整モデルをデプロイすることもできます。 フラン T5 UL2 or ブルームズ 7B1。 詳細については、 サンプルノート.

LangChain で SageMaker LLM エンドポイントを使用するには、次を使用します。 langchain.llms.sagemaker_endpoint.SagemakerEndpoint、SageMaker LLM エンドポイントを抽象化します。 LangChain SageMaker 統合の次のコードに示すように、リクエストとレスポンスのペイロードの変換を実行する必要があります。 コードを調整する必要がある場合があることに注意してください。 ContentHandler に基づく content_type 使用することを選択した LLM モデルの形式を受け入れます。

埋め込みモデルを作成する

次に、埋め込みモデルを準備する必要があります。 私たちは、 GPT-J6B モデルを埋め込みモデルとして使用します。 JumpStart 埋め込みモデルを使用している場合は、LangChain SageMaker エンドポイント埋め込みクラスをカスタマイズし、モデルのリクエストとレスポンスを変換して LangChain と統合する必要があります。 詳細な実装については、を参照してください。 GitHubレポ.

LangChain ドキュメント ローダーを使用してドメイン固有のドキュメントをロードし、インデックスを作成する

私たちは、使用 CSVLoader CSV 形式のドキュメントをドキュメント ローダーにロードするには、LangChain のパッケージを使用します。

次に、TextSplitter を使用して埋め込み目的でデータを前処理し、SageMaker 埋め込みモデルを使用します。 GPT-J-6B 埋め込みを作成します。 インデックスを作成するために、FAISS ベクター ストアに埋め込みを保存します。 このインデックスを使用して、ユーザーのクエリと意味的に類似した関連ドキュメントを検索します。

次のコードは、これらすべてのステップがどのように実行されるかを示しています。 VectorstoreIndexCreator LangChain のわずか数行のコードでクラスを作成し、RAG を使用した質問応答の簡潔な実装を作成します。

インデックスを使用して関連するコンテキストを検索し、LLM モデルに渡します。

次に、作成したインデックスに対して query メソッドを使用し、ユーザーの質問と SageMaker エンドポイント LLM を渡します。 LangChain は、上位 4 つの最も近いドキュメント (K=XNUMX) を選択し、ドキュメントから抽出された関連コンテキストを渡して、正確な応答を生成します。 次のコードを参照してください。

Flan T5 XXL を使用した RAG ベースのアプローチを使用すると、クエリに対して次の応答が得られます。

この応答は、コンテキストがない、または必ずしも関連性があるとは限らない静的なコンテキストを持たない、以前に示した他のアプローチで得られた応答と比較して、より正確に見えます。

SageMaker と LangChain を使用してさらにカスタマイズした RAG を実装する代替アプローチ

このセクションでは、SageMaker と LangChain を使用して RAG を実装する別のアプローチを示します。 このアプローチでは、ドキュメント内の関連性検索用に上位 K パラメーターを構成する柔軟性が提供されます。 また、LangChain 機能を使用することもできます。 プロンプトテンプレートこれにより、プロンプトをハードコーディングする代わりに、プロンプトの作成を簡単にパラメータ化できます。

次のコードでは、FAISS を明示的に使用して、SageMaker GPT-J-6B 埋め込みモデルを使用してナレッジ ライブラリ内の各ドキュメントの埋め込みを生成します。 次に、ユーザーのクエリに基づいて、最も関連性の高い上位 K (K=3) ドキュメントを特定します。

次に、プロンプト テンプレートを使用し、それを SageMaker LLM とチェーンします。

LangChain チェーンを使用して、見つかった上位 3 つ (K=XNUMX) の関連ドキュメントをコンテキストとしてプロンプトに送信します。

RAG 実装のこのアプローチにより、LangChain プロンプト テンプレートのさらなる柔軟性を活用し、上位 K ハイパーパラメータを使用して関連性の一致を検索するドキュメントの数をカスタマイズすることができました。

SageMaker KNN を使用した JumpStart RAG ベースの実装ノートブック

このセクションでは、KNN アルゴリズムを使用して関連ドキュメントを検索し、強化されたコンテキストを作成する RAG ベースのアプローチを実装します。 このアプローチでは、LangChain は使用しませんが、同じデータセットを使用します。 Amazon SageMaker のよくある質問 以前の LangChain アプローチと同様に、モデル GPT-J-6B および LLM Flan T5 XXL をナレッジ ドキュメントとして埋め込みます。

大規模なデータセットがある場合、 SageMaker KNN アルゴリズム 効果的なセマンティック検索が提供される場合があります。 SageMaker KNN アルゴリズムは、基盤となる検索アルゴリズムとして FAISS も使用します。 このソリューションのノートブックは次の場所にあります。 GitHubの.

まず、前のセクションと同じ方法で、LLM Flan T5 XXL および GPT-J 6B 埋め込みモデルをデプロイします。 ナレッジ データベース内のレコードごとに、GPT-J 埋め込みモデルを使用して埋め込みベクトルを生成します。

次に、 セージメーカー KNN ナレッジ データの埋め込みにインデックスを付けるトレーニング ジョブ。 データのインデックス付けに使用される基礎となるアルゴリズムは次のとおりです。 フェイス。 最も関連性の高いドキュメントの上位 XNUMX つを見つけたいので、 TOP_K KNN アルゴリズムの推定器を作成し、トレーニング ジョブを実行し、KNN モデルをデプロイして、クエリに一致する上位 5 つのドキュメントのインデックスを見つけます。 次のコードを参照してください。

次に、ナレッジ ライブラリ ドキュメントの埋め込みを作成するために使用した GPT-J-6B 埋め込みモデルを使用して、クエリの埋め込み表現を作成します。

次に、KNN エンドポイントを使用し、クエリの埋め込みを KNN エンドポイントに渡し、最も関連性の高い上位 K 個のドキュメントのインデックスを取得します。 インデックスを使用して、対応するテキスト文書を取得します。 次に、コンテキストの最大許容長を超えないようにドキュメントを連結します。 次のコードを参照してください。

ここで、クエリ、プロンプト、および関連ドキュメントのテキストを含むコンテキストを結合し、それをテキスト生成 LLM Flan T5 XXL モデルに渡して回答を生成する最後のステップに進みます。

Flan T5 XXL を使用した RAG ベースのアプローチを使用すると、クエリに対して次の応答が得られます。

クリーンアップ

このノートブックで作成したエンドポイントを使用しない場合は、コストの再発を避けるために必ず削除してください。

まとめ

この投稿では、LangChain と組み込み KNN アルゴリズムという 5 つのアプローチを使用して、質問応答タスク用の LLM による RAG ベースのアプローチの実装を実証しました。 RAG ベースのアプローチは、ドキュメントのリストを検索して作成された関連コンテキストを動的に提供することで、Flan TXNUMX XXL を使用したテキスト生成の精度を最適化します。

これらのノートブックは SageMaker でそのまま使用することも、ニーズに合わせてカスタマイズすることもできます。 カスタマイズするには、ナレッジ ライブラリ内の独自のドキュメント セットを使用したり、OpenSearch などの他の関連性検索実装を使用したり、JumpStart で利用可能な他の埋め込みモデルやテキスト生成 LLM を使用したりできます。

RAG ベースのアプローチを使用して、JumpStart で何を構築するか楽しみにしています。

著者について

XinHuang博士 Amazon SageMaker JumpStart および Amazon SageMaker 組み込みアルゴリズムの上級応用科学者です。 スケーラブルな機械学習アルゴリズムの開発に注力しています。 彼の研究対象は、自然言語処理、表形式データの説明可能なディープ ラーニング、およびノンパラメトリック時空クラスタリングの堅牢な分析の分野です。 彼は、ACL、ICDM、KDD カンファレンス、Royal Statistical Society: Series A で多くの論文を発表しています。

XinHuang博士 Amazon SageMaker JumpStart および Amazon SageMaker 組み込みアルゴリズムの上級応用科学者です。 スケーラブルな機械学習アルゴリズムの開発に注力しています。 彼の研究対象は、自然言語処理、表形式データの説明可能なディープ ラーニング、およびノンパラメトリック時空クラスタリングの堅牢な分析の分野です。 彼は、ACL、ICDM、KDD カンファレンス、Royal Statistical Society: Series A で多くの論文を発表しています。

ラクナ チャダ は、AWS の戦略アカウントにおける AI/ML のプリンシパル ソリューション アーキテクトです。 Rachna は楽観主義者で、AI を倫理的かつ責任を持って使用することで将来の社会を改善し、経済的および社会的繁栄をもたらすことができると信じています。 余暇には、家族と一緒に時間を過ごしたり、ハイキングをしたり、音楽を聴いたりするのが好きです。

ラクナ チャダ は、AWS の戦略アカウントにおける AI/ML のプリンシパル ソリューション アーキテクトです。 Rachna は楽観主義者で、AI を倫理的かつ責任を持って使用することで将来の社会を改善し、経済的および社会的繁栄をもたらすことができると信じています。 余暇には、家族と一緒に時間を過ごしたり、ハイキングをしたり、音楽を聴いたりするのが好きです。

カイル・ウルリッヒ博士 Amazon SageMaker 組み込みアルゴリズムチームの応用科学者です。 彼の研究対象には、スケーラブルな機械学習アルゴリズム、コンピューター ビジョン、時系列、ベイジアン ノンパラメトリック、ガウス プロセスなどがあります。 彼はデューク大学で博士号を取得しており、NeurIPS、Cell、および Neuron で論文を発表しています。

カイル・ウルリッヒ博士 Amazon SageMaker 組み込みアルゴリズムチームの応用科学者です。 彼の研究対象には、スケーラブルな機械学習アルゴリズム、コンピューター ビジョン、時系列、ベイジアン ノンパラメトリック、ガウス プロセスなどがあります。 彼はデューク大学で博士号を取得しており、NeurIPS、Cell、および Neuron で論文を発表しています。

ヘマントシン Amazon SageMaker JumpStart および Amazon SageMaker 組み込みアルゴリズムの経験を持つ機械学習エンジニアです。 彼はクーラント数理科学研究所で修士号を取得し、デリー工科大学で学士号を取得しました。 彼は、自然言語処理、コンピューター ビジョン、時系列分析の分野でさまざまな機械学習の問題に取り組んだ経験があります。

ヘマントシン Amazon SageMaker JumpStart および Amazon SageMaker 組み込みアルゴリズムの経験を持つ機械学習エンジニアです。 彼はクーラント数理科学研究所で修士号を取得し、デリー工科大学で学士号を取得しました。 彼は、自然言語処理、コンピューター ビジョン、時系列分析の分野でさまざまな機械学習の問題に取り組んだ経験があります。

マナス・ダダルカール Amazon Forecast サービスのエンジニアリングを担当するソフトウェア開発マネージャーです。 彼は、機械学習のアプリケーションと、ML テクノロジを誰もが簡単に利用できるようにして、本番環境に導入してデプロイできるようにすることに情熱を注いでいます。 仕事以外では、旅行、読書、友人や家族と過ごす時間など、複数のことに興味を持っています。

マナス・ダダルカール Amazon Forecast サービスのエンジニアリングを担当するソフトウェア開発マネージャーです。 彼は、機械学習のアプリケーションと、ML テクノロジを誰もが簡単に利用できるようにして、本番環境に導入してデプロイできるようにすることに情熱を注いでいます。 仕事以外では、旅行、読書、友人や家族と過ごす時間など、複数のことに興味を持っています。

アシッシュ・ケタン博士 は、Amazon SageMaker 組み込みアルゴリズムを使用する上級応用科学者であり、機械学習アルゴリズムの開発を支援しています。 イリノイ大学アーバナシャンペーン校で博士号を取得。 彼は機械学習と統計的推論の活発な研究者であり、NeurIPS、ICML、ICLR、JMLR、ACL、および EMNLP カンファレンスで多くの論文を発表しています。

アシッシュ・ケタン博士 は、Amazon SageMaker 組み込みアルゴリズムを使用する上級応用科学者であり、機械学習アルゴリズムの開発を支援しています。 イリノイ大学アーバナシャンペーン校で博士号を取得。 彼は機械学習と統計的推論の活発な研究者であり、NeurIPS、ICML、ICLR、JMLR、ACL、および EMNLP カンファレンスで多くの論文を発表しています。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- プラトアイストリーム。 Web3 データ インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- 未来を鋳造する w エイドリエン・アシュリー。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/question-answering-using-retrieval-augmented-generation-with-foundation-models-in-amazon-sagemaker-jumpstart/

- :持っている

- :は

- :not

- :どこ

- $UP

- 1

- 10

- 100

- 11

- 12

- 13

- 視聴者の38%が

- 500

- 7

- 8

- 9

- a

- できる

- 私たちについて

- 抄録

- 加速する

- 受け入れる

- アクセス

- アカウント

- 精度

- 正確な

- アクティブ

- 加えます

- 追加されました

- 追加

- 添加

- NEW

- 追加

- 採用

- 利点

- 利点

- エージェント

- AI

- AI / ML

- AL

- アルゴリズム

- アルゴリズム

- すべて

- ことができます

- 沿って

- また

- 常に

- Amazon

- アマゾン予測

- アマゾンセージメーカー

- Amazon SageMaker ジャンプスタート

- 金額

- an

- 分析

- および

- アナウンス

- 別の

- 回答

- 回答

- API

- 申し込み

- 適用された

- 申し込む

- アプローチ

- アプローチ

- 建築

- です

- AREA

- 記事

- AS

- At

- 増強された

- 賃貸条件の詳細・契約費用のお見積り等について

- 利用できます

- 避ける

- AWS

- ベース

- ベイジアン

- BE

- なぜなら

- と考えています

- より良いです

- の間に

- ロボット

- 持って来る

- ビルド

- 内蔵

- ビジネス

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- 呼ばれます

- コール

- 缶

- 機能

- 場合

- 例

- チェーン

- チェーン

- 挑戦する

- 変更

- チャットボット

- 選択

- 選択する

- class

- クラスタリング

- コード

- コーディング

- コレクション

- 組み合わせる

- 来ます

- 会社

- 匹敵します

- 比べ

- 完成

- コンピュータ

- Computer Vision

- コンセプト

- 概念の

- 会議

- 制約

- 含まれています

- コンテキスト

- 会話

- 変換

- 変換

- 正しい

- 対応する

- 費用

- コロナ

- 作ります

- 作成した

- 作成

- 創造

- 現在

- カスタム化

- カスタマイズ

- データ

- データサイエンス

- データベース

- データベースを追加しました

- 深いです

- 深い学習

- デリー

- 実証します

- 実証

- によっては

- 展開します

- 展開

- 展開

- 説明する

- 詳細な

- 細部

- 開発する

- Developer

- 開発者

- 開発

- 開発

- DID

- 違い

- 異なります

- 議論する

- 異なる

- ドキュメント

- ドキュメント

- そうではありません

- すること

- ドメイン

- 行われ

- デューク

- デューク大学

- 動的に

- E&T

- 各

- 前

- 容易

- 簡単に

- 効果的な

- 埋め込まれた

- 埋め込み

- 可能

- 端から端まで

- エンドポイント

- エンジニア

- エンジニアリング

- 強化された

- 確保する

- Enterprise

- 本質的に

- 倫理的な

- さらに

- 誰も

- 例

- 超過

- 体験

- 探る

- 外部

- 家族

- 特徴

- 特徴

- FRBは

- 少数の

- File

- ファイナル

- もう完成させ、ワークスペースに掲示しましたか?

- 発見

- 名

- フィット

- 固定の

- 柔軟性

- フロー

- 焦点を当てて

- フォロー中

- 予想

- 形式でアーカイブしたプロジェクトを保存します.

- フォワード

- 発見

- Foundation

- 4

- フレームワーク

- 頻繁な

- 頻繁に

- 友達

- から

- さらに

- 未来

- 生成する

- 生成された

- 生成

- 世代

- 取得する

- 与えられた

- 素晴らしい

- 持っていました

- ハード

- 持ってる

- he

- 健康

- 健康保険

- 助けます

- ことができます

- 彼女の

- ハイ

- 彼の

- ヒット

- 認定条件

- How To

- しかしながら

- HTML

- HTTPS

- ハブ

- i

- 特定され

- 識別する

- if

- イリノイ州

- 画像

- 影響

- 実装する

- 実装

- import

- 改善します

- in

- include

- 含めて

- index

- インデックス

- 情報

- を取得する必要がある者

- 機関

- 説明書

- 保険

- 統合する

- 統合

- 利益

- インタフェース

- に

- 導入

- IT

- ITS

- ジョブ

- 旅

- JPG

- JSON

- ただ

- 知識

- 言語

- 大

- 大規模

- より大きい

- 最新の

- 主要な

- 学習

- 長さ

- 図書館

- ような

- 好き

- 制限

- 制限

- 限定的

- 制限

- ライン

- リスト

- 耳を傾ける

- LLM

- 負荷

- ローダ

- 場所

- 見て

- 探して

- LOOKS

- ロー

- 機械

- 機械学習

- 維持する

- make

- 作る

- 作成

- マネージド

- マネージャー

- 多くの

- 市場

- 一致

- マッチング

- 数学的

- 五月..

- メモリ

- 方法

- ML

- モデル

- 他には?

- 最も

- ずっと

- の試合に

- 音楽を聴く際のスピーカーとして

- ナチュラル

- 自然言語処理

- 必要

- 必要とされる

- ニーズ

- 次の

- いいえ

- ノート

- 今

- 数

- of

- オファー

- オンライン

- on

- の

- オープンソース

- 最適化

- or

- オリジナル

- その他

- 私たちの

- 出力

- 外側

- 全体

- 自分の

- パッケージ

- 論文

- パラメータ

- 部

- 特定の

- パス

- 渡された

- パス

- 情熱的な

- 実行する

- プラン

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 人気

- ポスト

- パワード

- 強力な

- 予測

- Predictor

- 前

- 校長

- 問題

- 問題

- ラボレーション

- 処理

- プロダクト

- 生産

- 生産性

- 繁栄

- 提供します

- 提供

- は、大阪で

- 提供

- 公表

- 目的

- クエリ

- 質問

- 質問

- すぐに

- 範囲

- むしろ

- リーディング

- 準備

- リアル

- 記録

- 反映する

- 地域

- 関連した

- 倉庫

- 表現

- 要求

- 研究

- 研究者

- 応答

- 回答

- 責任

- 結果

- return

- 堅牢な

- ロイヤル

- ルール

- ラン

- セージメーカー

- 同じ

- 貯蓄

- ド電源のデ

- シナリオ

- 科学

- 科学

- 科学者

- を検索

- 検索

- セクション

- セクション

- 見ること

- 選択

- 自己

- 送信

- シニア

- シーケンス

- シリーズ

- シリーズA

- サービス

- サービス

- セッションに

- すべき

- 表示する

- 示す

- 作品

- 同様の

- サイズ

- So

- 社会

- 社会

- ソフトウェア

- ソフトウェア開発

- 溶液

- 解決する

- ソース

- スペース

- 特定の

- スピード

- 支出

- Spot

- 標準

- 開始

- 都道府県

- 統計的

- 手順

- ステップ

- まだ

- 店舗

- 保存され

- 戦略的

- サブスクリプション

- そのような

- 補給

- サポート

- サポート

- 取る

- 仕事

- タスク

- チーム

- テク

- テクノロジー

- template

- テンプレート

- より

- それ

- エリア

- 情報

- ステート

- アプリ環境に合わせて

- それら

- その後

- そこ。

- したがって、

- ボーマン

- 彼ら

- この

- 三

- 時間

- 時系列

- 〜へ

- 一緒に

- top

- トレーニング

- 訓練された

- トレーニング

- 最適化の適用

- 変換

- 試み

- 2

- 根本的な

- ユニーク

- 大学

- 最新

- アップデイト

- 更新しました

- 使用法

- つかいます

- 使用事例

- 中古

- ユーザー

- users

- 通常

- ユーティリティ

- さまざまな

- バーチャル

- バーチャルマシン

- ビジョン

- 欲しいです

- ました

- 仕方..

- 方法

- we

- した

- この試験は

- いつ

- which

- while

- 誰

- Wikipedia

- 意志

- 以内

- 仕事

- ワーキング

- でしょう

- You

- あなたの

- ゼファーネット