産業機器のメンテナンス、貿易監視、フリート管理、ルート最適化を目的とした多くのアプリケーションは、オープンソースのCassandra APIとドライバーを使用して構築され、データを高速かつ低遅延で処理します。 Cassandraテーブルを自分で管理することは、時間と費用がかかる可能性があります。 Amazonキースペース(Apache Cassandra用) 追加のインフラストラクチャを管理することなく、AWSクラウドでCassandraテーブルをセットアップ、保護、スケーリングできます。

この投稿では、Amazon Keyspacesを使用した機械学習(ML)モデルのトレーニングに関連するAWSサービスを高レベルで説明し、AmazonKeyspacesからにデータを取り込むためのステップバイステップの手順を提供します。 アマゾンセージメーカー 特定の顧客セグメンテーションのユースケースに使用できるモデルをトレーニングします。

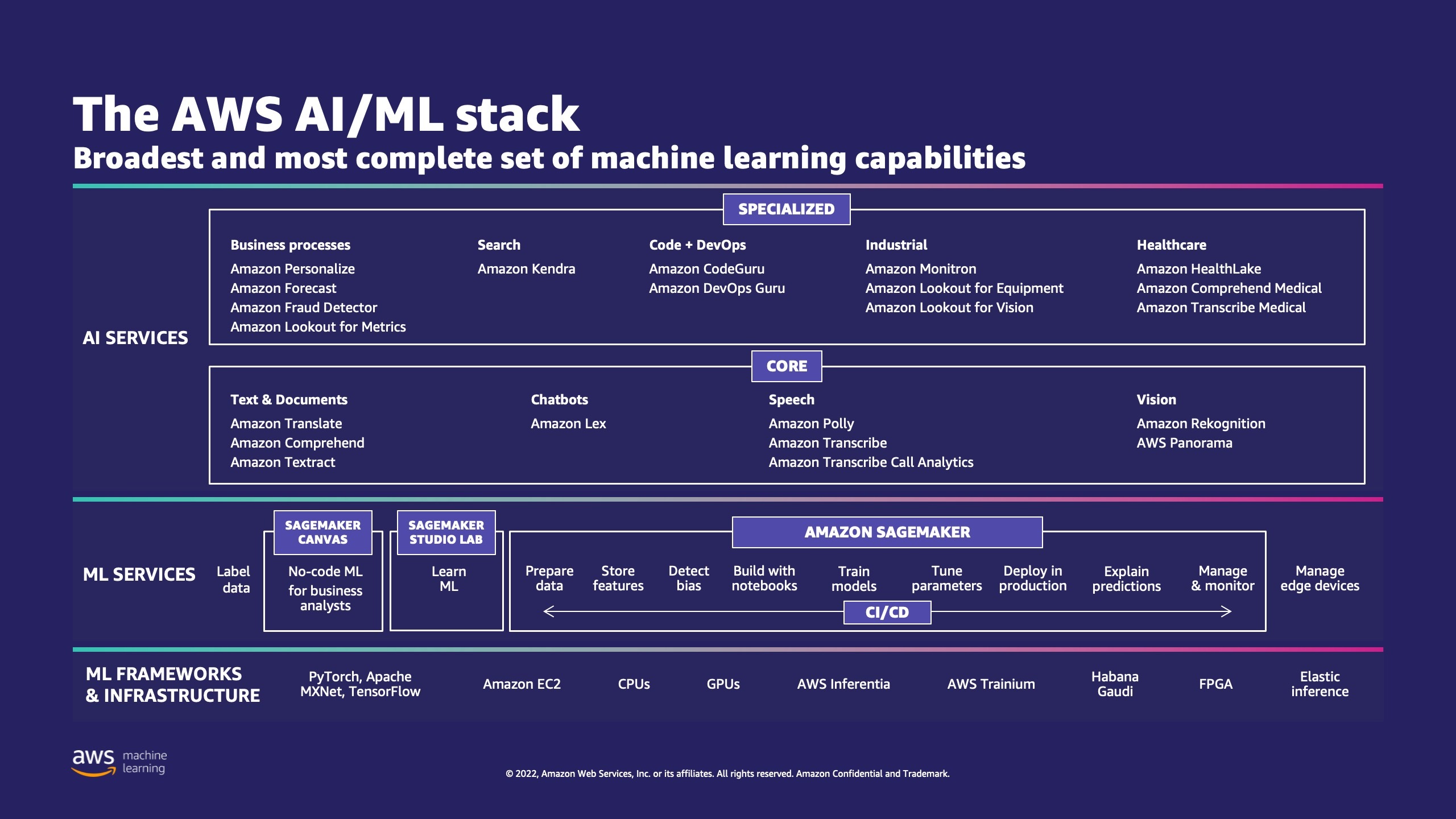

AWSには、企業がクラウドにMLプロセスを実装するのを支援する複数のサービスがあります。

AWSMLスタックにはXNUMXつのレイヤーがあります。 中間層には セージメーカー、開発者、データサイエンティスト、MLエンジニアに、MLモデルを大規模に構築、トレーニング、デプロイする機能を提供します。 MLワークフローの各ステップの複雑さが解消されるため、MLのユースケースをより簡単にデプロイできます。 これには、予知保全から顧客の行動を予測するためのコンピュータービジョンまであらゆるものが含まれます。 顧客は、SageMakerを使用してデータサイエンティストの生産性を最大10倍向上させることができます。

Apache Cassandraは、非構造化データまたは半構造化データを使用する読み取りの多いユースケースでよく使用されます。 たとえば、人気のある食品配達業者は配達時間を見積もり、小売顧客はApacheCassandraデータベースの製品カタログ情報を頻繁に使用し続ける可能性があります。 Amazonキースペース は、スケーラブルで可用性が高く、管理されたサーバーレスのApacheCassandra互換データベースサービスです。 サーバーのプロビジョニング、パッチ適用、または管理は必要ありません。また、ソフトウェアのインストール、保守、または操作も必要ありません。 テーブルは自動的にスケールアップおよびスケールダウンでき、使用したリソースに対してのみ料金を支払います。 Amazon Keyspacesを使用すると、現在使用しているものと同じCassandraアプリケーションコードと開発者ツールを使用して、AWSでCassandraワークロードを実行できます。

SageMakerは一連の 組み込みアルゴリズム データサイエンティストとML実践者が、MLモデルのトレーニングと展開を迅速に開始できるように支援します。 この投稿では、小売顧客がキースペースデータベースの顧客購入履歴を使用して、マーケティングキャンペーンのさまざまな顧客セグメントをターゲットにする方法を紹介します。

K平均 教師なし学習アルゴリズムです。 これは、データ内の個別のグループを見つけようとします。グループのメンバーは、互いに可能な限り類似しており、他のグループのメンバーとは可能な限り異なります。 類似性を判断するためにアルゴリズムで使用する属性を定義します。 SageMakerは、の修正バージョンを使用します Webスケールのk-meansクラスタリングアルゴリズム。 アルゴリズムの元のバージョンと比較して、SageMakerで使用されるバージョンはより正確です。 ただし、元のアルゴリズムと同様に、大規模なデータセットにスケーリングし、トレーニング時間の改善を実現します。

ソリューションの概要

手順は、SageMakerStudioを使用してコードを実行することを前提としています。 関連するコードはで共有されています AWSサンプルGitHub。 ラボの指示に従って、次のことを実行できます。

- 必要な依存関係をインストールします。

- Amazon Keyspacesに接続し、テーブルを作成して、サンプルデータを取り込みます。

- Amazon Keyspacesのデータを使用して、分類MLモデルを構築します。

- モデルの結果を調べます。

- 新しく作成されたリソースをクリーンアップします。

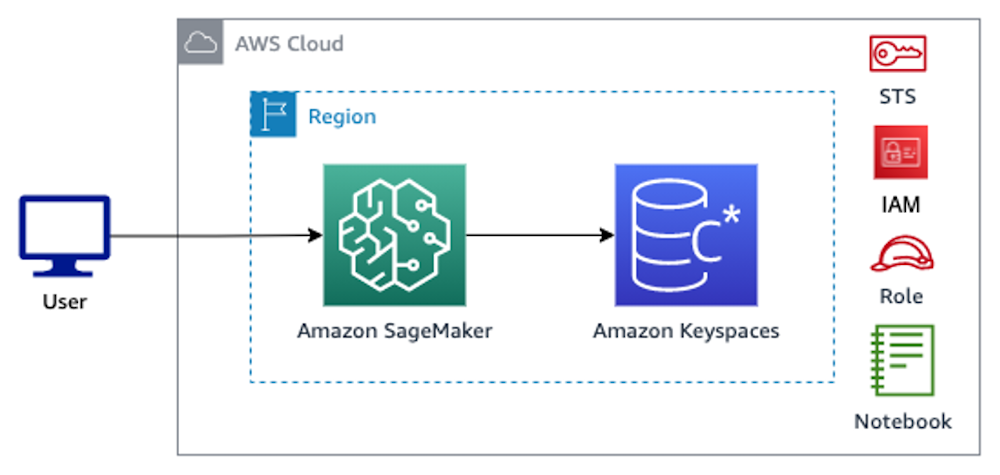

完了すると、次の画像に示すように、SageMakerをAmazon Keyspacesと統合して、MLモデルをトレーニングできるようになります。

今、あなたは従うことができます ステップバイステップの説明 この投稿では、SageMakerを使用してAmazon Keyspacesに保存されている生データと、ML処理のために取得されたデータを取り込みます。

前提条件

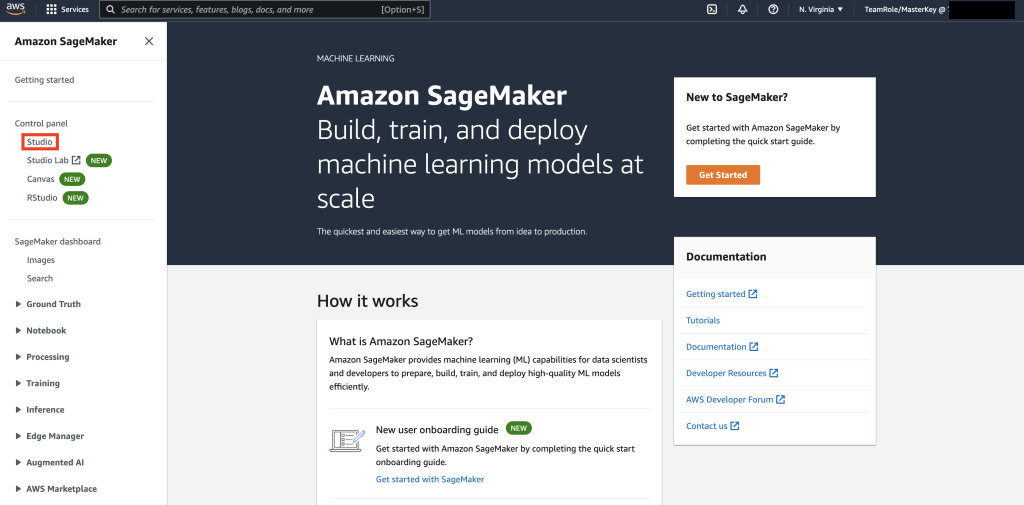

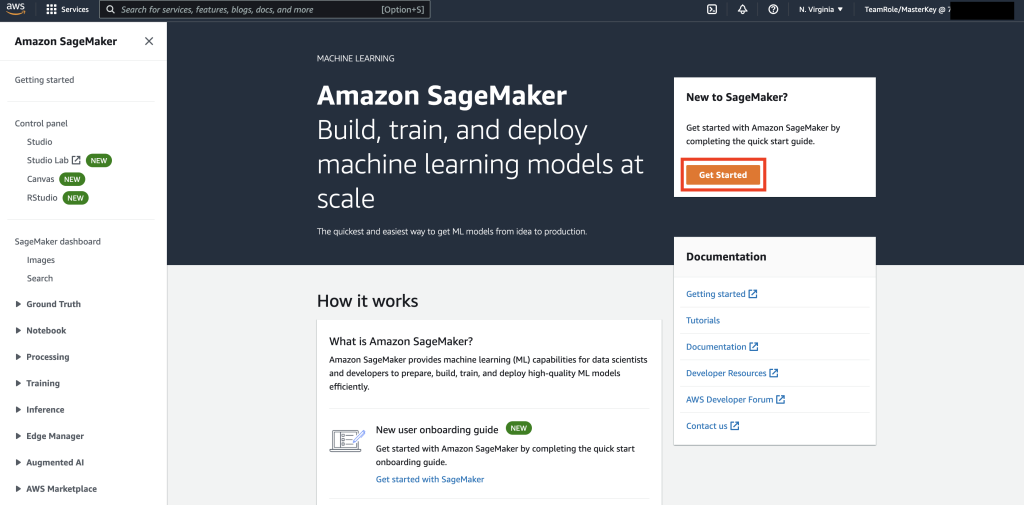

まず、SageMakerに移動します。

次に、SageMakerを初めて使用する場合は、[ 始める.

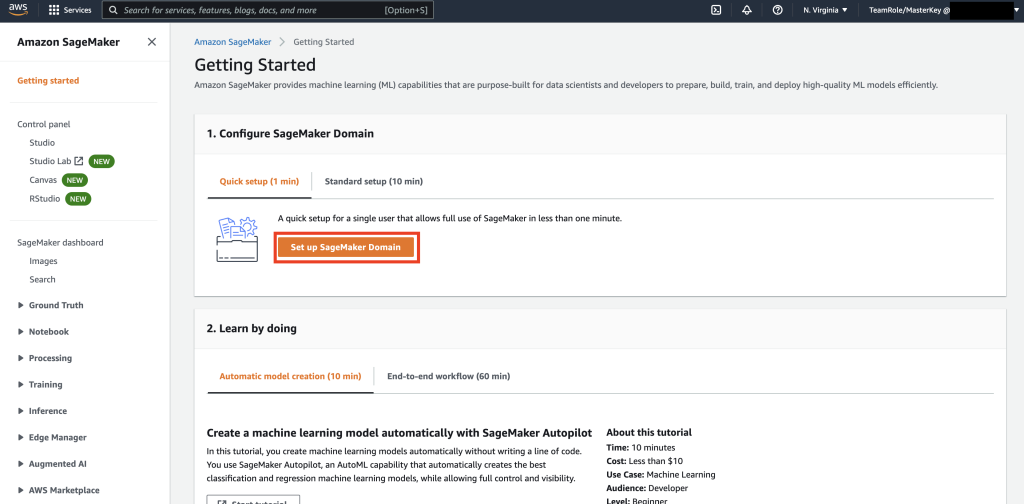

次に、 SageMakerドメインをセットアップする.

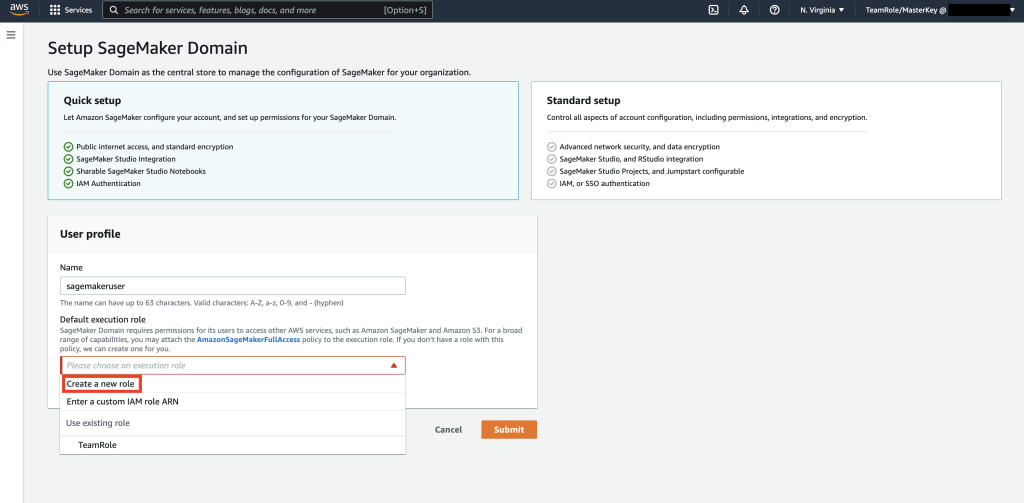

次に、Name –を使用して新しいユーザープロファイルを作成します。 セージメーカーユーザー、および選択 新しい役割を作成します。 セクションに デフォルトの実行ロール サブセクション。

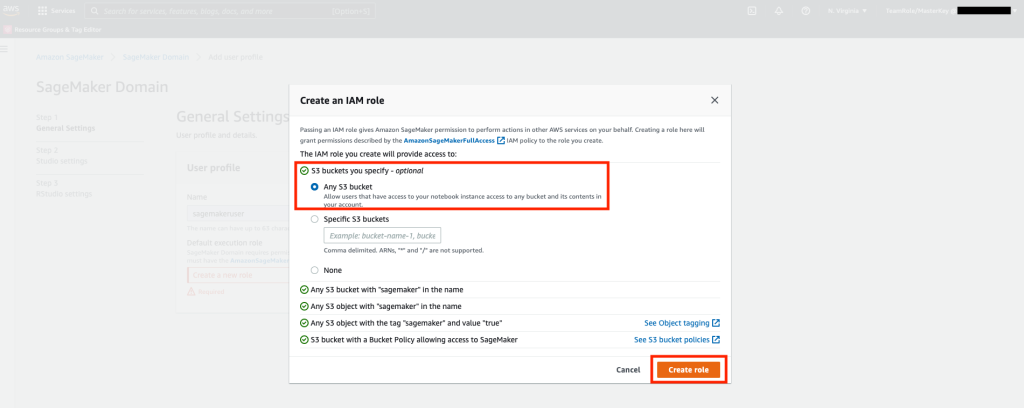

次に、ポップアップする画面で、 Amazon Simple Storage Service(Amazon S3) バケットをクリックし、[役割の作成]を選択します。

このロールは、SageMakerがロールからの一時的なクレデンシャルを使用してキースペーステーブルにアクセスできるようにするために、次の手順で使用されます。 これにより、ユーザー名とパスワードをノートブックに保存する必要がなくなります。

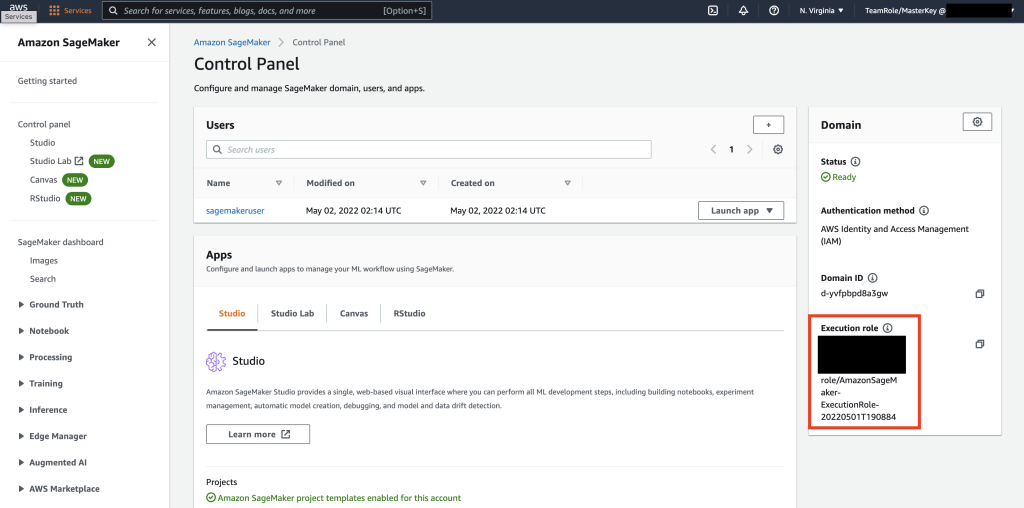

次に、に関連付けられている役割を取得します セージメーカーユーザー これは、前のステップで要約セクションから作成されました。

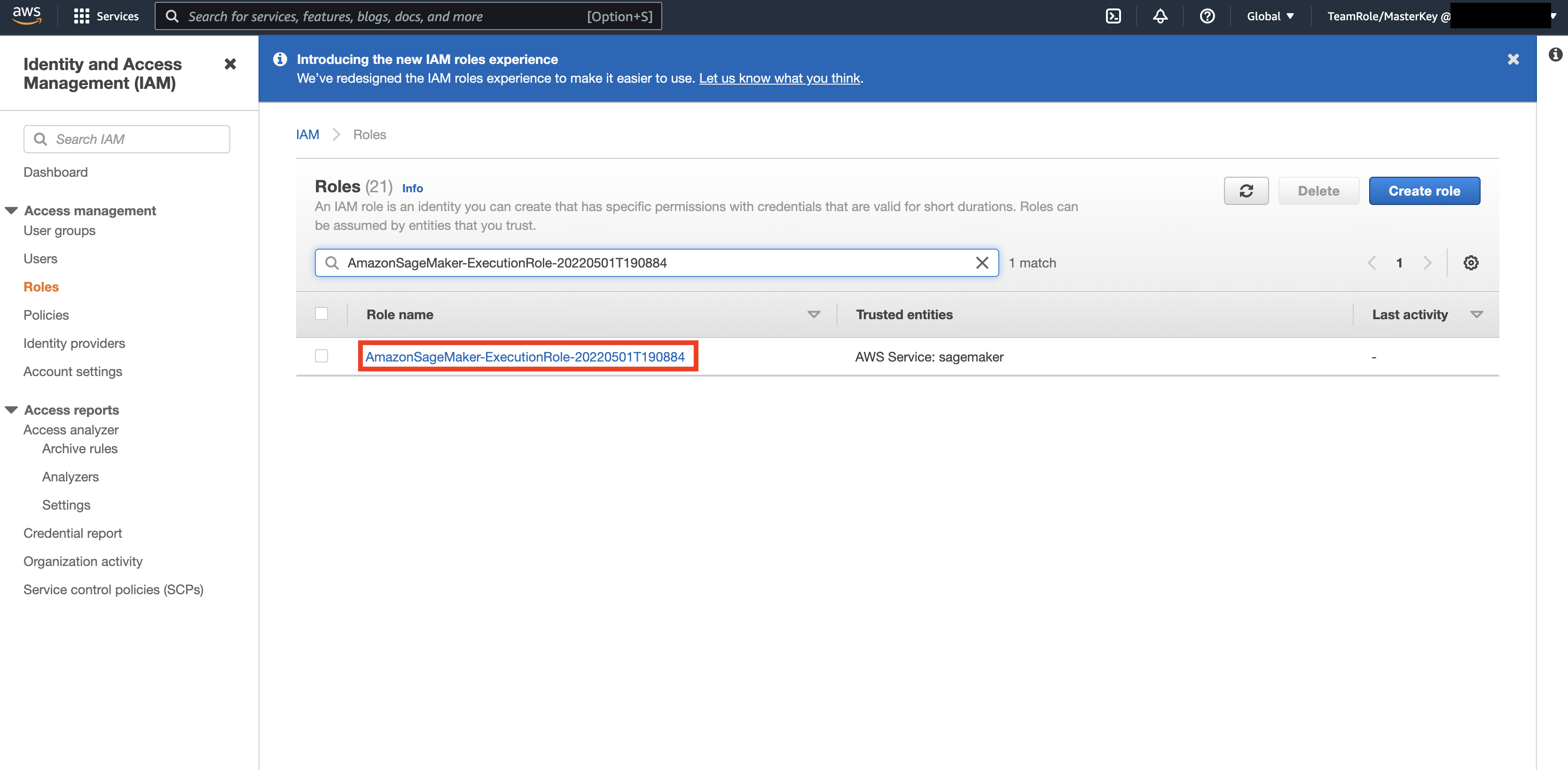

次に、に移動します AWS Console 見上げる AWS Identity and Access Management(IAM)。 IAM内で、[役割]に移動します。 ロール内で、前の手順で特定された実行ロールを検索します。

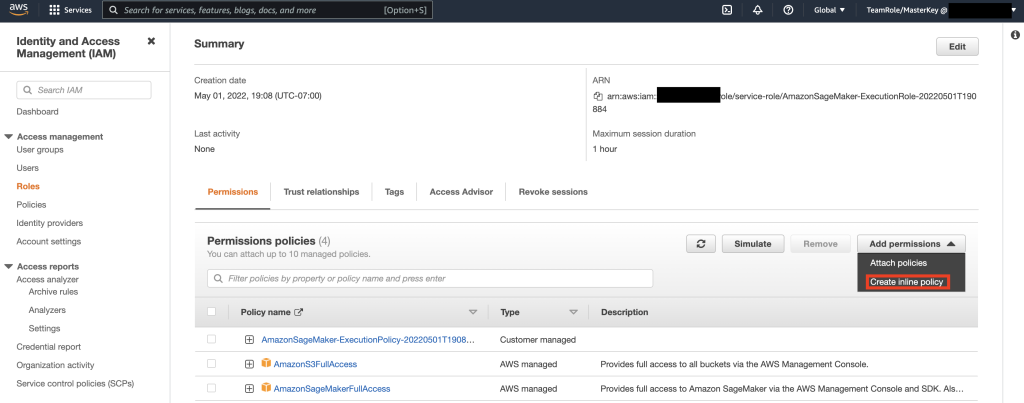

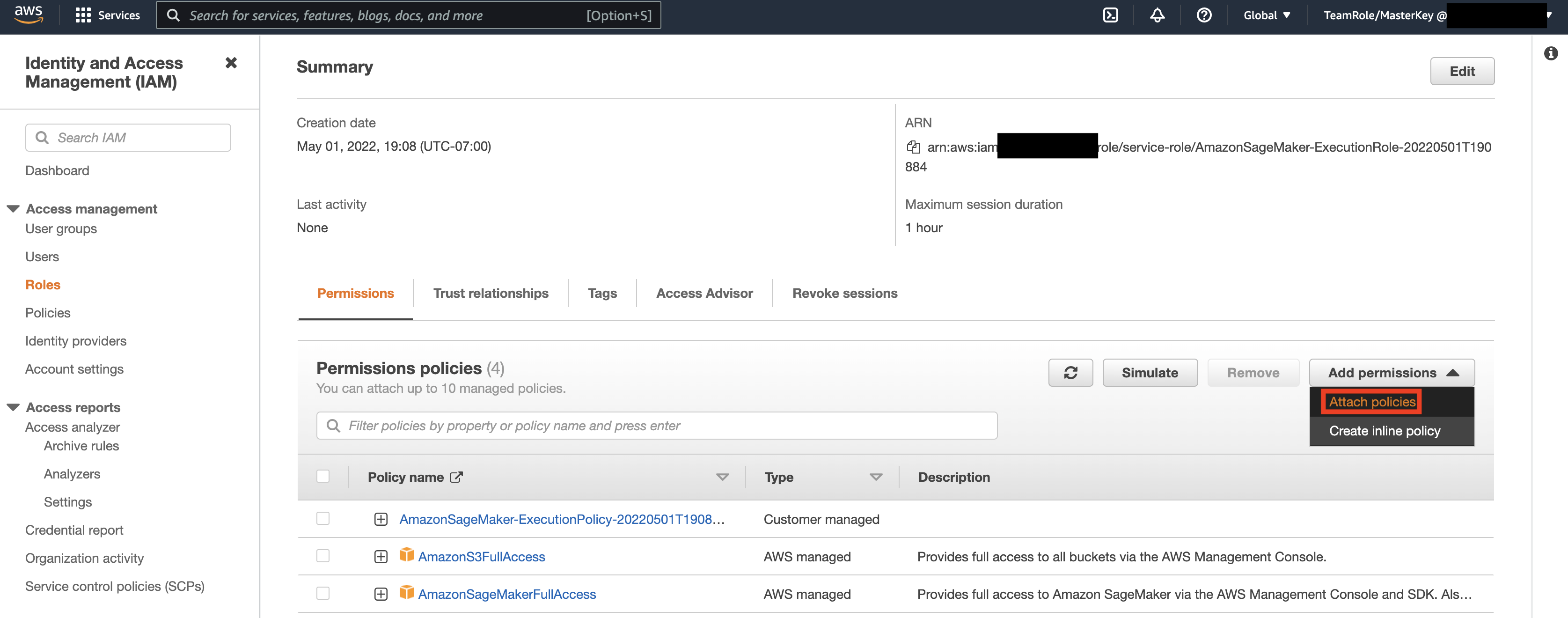

次に、前の手順で特定した役割を選択し、[権限の追加]を選択します。 表示されるドロップダウンで、[インラインポリシーの作成]を選択します。 SageMakerを使用すると、ビジネス要件に基づいてユーザー/アプリケーションが実行できるアクションを制限するきめ細かいレベルのアクセスを提供できます。

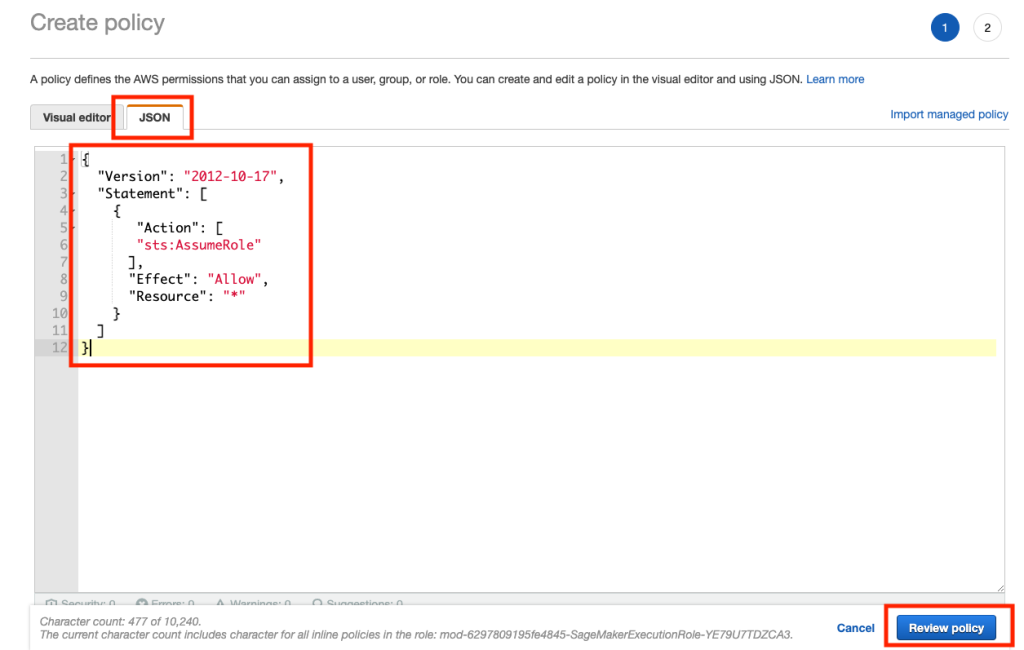

次に、[JSON]タブを選択し、Githubの[メモ]セクションからポリシーをコピーします ページ。 このポリシーにより、SageMakerノートブックはキースペースに接続し、さらに処理するためにデータを取得できます。

次に、ドロップダウンから[権限の追加]を再度選択し、[ポリシーの添付]を選択します。

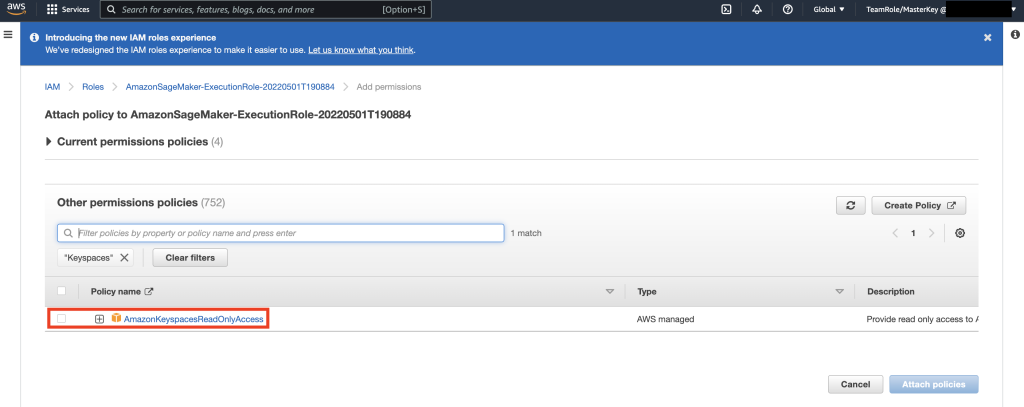

AmazonKeyspacesFullAccessポリシーを検索し、一致する結果の横にあるチェックボックスを選択して、[ポリシーの添付]を選択します。

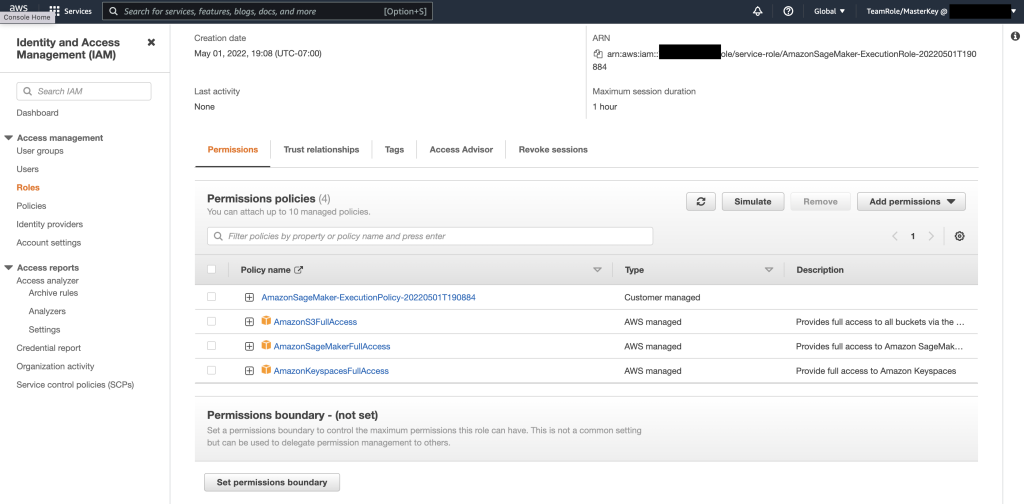

権限ポリシーセクションに含まれていることを確認します AmazonS3FullAccess, AmazonSageMakerFullAccess, AmazonKeyspacesFullAccess、および新しく追加されたインラインポリシー。

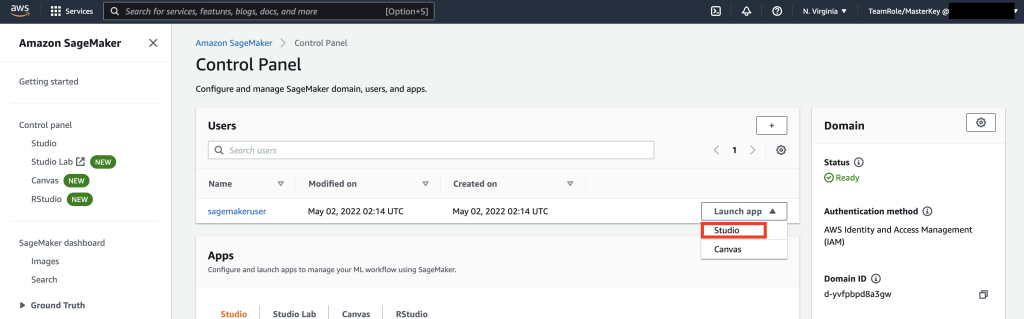

次に、AWSコンソールを使用してSageMaker Studioに移動し、SageMakerStudioを選択します。 そこで、[アプリの起動]を選択し、[スタジオ]を選択します。

ノートブックのウォークスルー

SageMaker Notebookからキースペースに接続するための推奨される方法は、 AWS署名バージョン4プロセス(SigV4) ベース 一時的な資格情報 認証用。 このシナリオでは、キースペースのクレデンシャルを生成または保存する必要はなく、クレデンシャルを使用してSigV4プラグインで認証できます。 一時的なセキュリティクレデンシャルは、アクセスキーIDとシークレットアクセスキーで構成されます。 ただし、資格情報の有効期限が切れる時期を示すセキュリティトークンも含まれています。 この投稿では、IAMロールを作成し、一時的なセキュリティクレデンシャルを生成します。

まず、ドライバー(cassandra-sigv4)をインストールします。 このドライバーを使用すると、AWS署名バージョン4プロセス(SigV4)を使用してAPIリクエストに認証情報を追加できます。 プラグインを使用すると、IAMユーザーとロールを使用してAmazon Keyspaces(Apache Cassandraの場合)にアクセスするための短期的なクレデンシャルをユーザーとアプリケーションに提供できます。 これに続いて、追加のパッケージ依存関係とともに必要な証明書をインポートします。 最後に、ノートブックがキースペースと通信する役割を引き受けることを許可します。

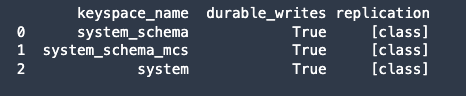

次に、Amazon Keyspacesに接続し、システムデータをKeyspacesからPandas DataFrameに読み込んで、接続を検証します。

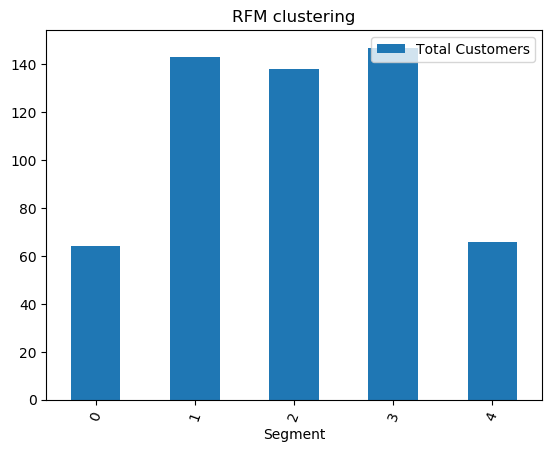

次に、生データセットでトレーニングするためのデータを準備します。 この投稿に関連付けられているPythonノートブックでは、からダウンロードした小売データセットを使用します こちら、そしてそれを処理します。 データセットが与えられた場合の私たちのビジネス目標は、RFMと呼ばれる特定のメトリックを使用して顧客をクラスター化することです。 RFMモデルは、次のXNUMXつの定量的要因に基づいています。

- 最新性:顧客が購入したのはどのくらい最近ですか。

- 頻度:顧客が購入する頻度。

- 金銭的価値:顧客が購入に費やす金額。

RFM分析では、これら1つのカテゴリのそれぞれで、一般に5からXNUMXのスケールで顧客を数値でランク付けします(数値が大きいほど、結果は良くなります)。 「最高の」顧客は、すべてのカテゴリーで最高のスコアを獲得します。 パンダの分位数ベースの離散化関数(qcut)を使用します。 これは、サンプルの分位数に基づいて、またはサンプルの分位数に基づいて、値を同じサイズのバケットに離散化するのに役立ちます。

この例では、CQLを使用してキースペーステーブルからレコードを読み取ります。 一部のMLユースケースでは、同じキースペーステーブルから同じデータを複数回読み取る必要がある場合があります。 この場合、追加のデータが発生しないように、データをAmazonS3バケットに保存することをお勧めします コスト■Amazonキースペースからの読み取り。 シナリオによっては、 アマゾンEMR 〜へ 摂取する 非常に大きなAmazonS3ファイルをSageMakerに入れます。

次に、KMeansアルゴリズムを使用してMLモデルをトレーニングし、クラスターが作成されていることを確認します。 この特定のシナリオでは、作成されたクラスターが印刷され、生データセットの顧客がデータセットのさまざまな属性に基づいてグループ化されていることがわかります。 このクラスター情報は、ターゲットを絞ったマーケティングキャンペーンに使用できます。

(オプション)次に、MLモデルによって識別された顧客セグメントを、ターゲットマーケティングのためにAmazonKeyspacesテーブルに保存します。 バッチジョブはこのデータを読み取り、特定のセグメントの顧客にターゲットを絞ったキャンペーンを実行できます。

最後に、私たちは リソースをクリーンアップします 追加料金の発生を避けるために、このチュートリアル中に作成されました。

キースペースとテーブルの削除が完了するまでに数秒からXNUMX分かかる場合があります。 キースペースを削除すると、キースペースとそのすべてのテーブルが削除され、それらからの料金の発生が停止します。

まとめ

この投稿では、Amazon KeyspacesからSageMakerに顧客データを取り込み、顧客をセグメント化できるクラスタリングモデルをトレーニングする方法を紹介しました。 この情報をターゲットを絞ったマーケティングに使用できるため、ビジネスのKPIが大幅に向上します。 Amazon Keyspacesの詳細については、次のリソースを確認してください。

- Amazon Keyspaces をデータソースとして使用して機械学習モデルをトレーニングする (SageMaker ノートブック)

- IntelliJ、PyCharm、または DataGrip IDE を使用してデスクトップから Amazon Keyspaces に接続します

- Amazon Keyspaces の CQL 言語リファレンス (Apache Cassandra 用)

- 新しい開発者ツールキットの Docker イメージを使用して、Amazon Keyspaces (Apache Cassandra 用) へのコマンドライン アクセスをセットアップする方法

- Amazon Keyspaces の ID とアクセス管理 (Apache Cassandra の場合)

- SageMaker から Amazon Keyspace に接続する サービス固有の認証情報

- 最新性、頻度、金銭的価値 (RFM)

- Kaggle コードリファレンス

著者について

ヴァディム・リャホビッチ サンフランシスコベイエリアにあるAWSのシニアソリューションアーキテクトであり、お客様のAWSへの移行を支援しています。 彼は大企業から小規模の新興企業に至るまでの組織と協力して、彼らの革新をサポートしています。 彼はまた、お客様がAWSでスケーラブルで安全で費用効果の高いソリューションを設計するのを支援しています。

ヴァディム・リャホビッチ サンフランシスコベイエリアにあるAWSのシニアソリューションアーキテクトであり、お客様のAWSへの移行を支援しています。 彼は大企業から小規模の新興企業に至るまでの組織と協力して、彼らの革新をサポートしています。 彼はまた、お客様がAWSでスケーラブルで安全で費用効果の高いソリューションを設計するのを支援しています。

パート・パテル サンフランシスコベイエリアにあるAWSのソリューションアーキテクトです。 Parthは、クラウドへの移行を加速し、AWSクラウドの採用を成功させるためにお客様をガイドします。 彼はMLとアプリケーションのモダナイゼーションに焦点を当てています。

パート・パテル サンフランシスコベイエリアにあるAWSのソリューションアーキテクトです。 Parthは、クラウドへの移行を加速し、AWSクラウドの採用を成功させるためにお客様をガイドします。 彼はMLとアプリケーションのモダナイゼーションに焦点を当てています。

ラム・パタンギ サンフランシスコベイエリアにあるAWSのソリューションアーキテクトです。 彼は、農業、保険、銀行、小売、ヘルスケア&ライフサイエンス、ホスピタリティ、ハイテク業界の顧客がAWSクラウドでビジネスを成功させるのを支援してきました。 彼はデータベース、分析、MLを専門としています。

ラム・パタンギ サンフランシスコベイエリアにあるAWSのソリューションアーキテクトです。 彼は、農業、保険、銀行、小売、ヘルスケア&ライフサイエンス、ホスピタリティ、ハイテク業界の顧客がAWSクラウドでビジネスを成功させるのを支援してきました。 彼はデータベース、分析、MLを専門としています。

- '

- "

- &

- 10

- 100

- 9

- 能力

- 私たちについて

- 加速する

- アクセス

- 正確な

- 達成する

- 行動

- NEW

- 農業

- 先んじて

- アルゴリズム

- すべて

- Amazon

- 分析

- 分析論

- 別の

- API

- API

- アプリ

- 申し込み

- AREA

- 注意

- 属性

- 認証

- 自動的に

- 利用できます

- AWS

- バンキング

- ベイ

- ブログ

- 国境

- ビルド

- ビジネス

- ビジネス

- コール

- キャンペーン

- これ

- 例

- カテゴリー

- 証明書

- 課金

- 選択

- 分類

- クラウド

- コード

- 比べ

- コンピュータ

- お問合せ

- 接続

- 領事

- コスト効率の良い

- 可能性

- 国

- 作ります

- 作成した

- Credentials

- 顧客

- Customers

- データ

- データセット

- データベース

- データベースを追加しました

- 提供します

- 配達

- によっては

- 展開します

- 展開する

- デスクトップ

- 決定する

- Developer

- 開発者

- 異なります

- デッカー

- ダウン

- ドライバー

- Drop

- 間に

- 簡単に

- エンジニア

- 企業

- 装置

- 見積もり

- 例

- 実行

- 要因

- 名

- 初回

- 艦隊

- 焦点を当てて

- フォロー中

- フード

- フランシスコ

- function

- さらに

- 一般に

- 生成する

- 受け

- GitHubの

- 大いに

- グループ

- グループの

- ガイド

- 健康

- ヘルスケア

- 助けます

- 助け

- ハイ

- より高い

- 非常に

- history

- 認定条件

- How To

- しかしながら

- HTTPS

- アイデンティティ

- 画像

- 実装する

- 改善

- 改善

- include

- 含ま

- index

- インダストリアル

- 情報

- インフラ

- イノベーション

- install

- 保険

- 統合された

- IT

- ジョブ

- 旅

- キー

- ラボ

- 言語

- 大

- 起動する

- 層

- LEARN

- 学習

- レベル

- 生命科学

- 見て

- 忠実な

- 機械

- 機械学習

- 製

- 維持する

- 作る

- 管理します

- マネージド

- 管理

- 管理する

- マーケティング

- 大規模な

- マッチング

- メンバー

- ML

- モデル

- 金銭的な

- お金

- モニタリング

- 他には?

- 最も

- の試合に

- 必要

- ノート

- 数

- 操作する

- 最適化

- 組織

- その他

- パッケージ

- 特定の

- パスワード

- パッチ

- 支払う

- プラグイン

- ポリシー

- 方針

- 人気

- 可能

- 潜在的な

- 予測する

- 準備

- 前

- ブランド

- 主要な

- プロセス

- ラボレーション

- 処理

- プロダクト

- 生産性

- プロフィール

- 有望

- 提供します

- は、大阪で

- 購入

- 購入

- すぐに

- 測距

- Raw

- リーディング

- 受け取ります

- 最近

- 推奨する

- 記録

- リクエスト

- の提出が必要です

- 要件

- リソース

- 結果

- 小売

- レビュー

- リスク

- 職種

- ルート

- ラン

- サン

- サンフランシスコ

- SC

- ド電源のデ

- 規模

- 科学

- 科学者たち

- 画面

- を検索

- 秒

- 安全に

- セキュリティ

- セキュリティトークン

- セグメント

- セグメンテーション

- セグメント

- サーバレス

- サービス

- サービス

- セッションに

- shared

- 短期

- 示す

- 同様の

- 簡単な拡張で

- 眠る

- 小さい

- So

- ソフトウェア

- 固体

- ソリューション

- 一部

- 専門にする

- スタック

- 開始

- スタートアップ

- ストレージ利用料

- 店舗

- 研究

- 首尾よく

- サポート

- システム

- Talk

- ターゲット

- 対象となります

- 一時的

- 介して

- 時間

- <font style="vertical-align: inherit;">回数</font>

- 今日

- 一緒に

- トークン

- ツールキット

- 豊富なツール群

- top

- トレード

- トレーニング

- つかいます

- ユースケース

- users

- 値

- さまざまな

- バージョン

- 垂直

- ビジョン

- この試験は

- 以内

- 無し

- ワーキング

- でしょう

- あなたの