Aceasta este o postare pentru oaspeți de AK Roy de la Qualcomm AI.

Amazon Elastic Compute Cloud (Amazon EC2) Instanțele DL2q, alimentate de acceleratoarele Qualcomm AI 100 Standard, pot fi utilizate pentru a implementa în mod eficient sarcinile de lucru de învățare profundă (DL) în cloud. Ele pot fi, de asemenea, utilizate pentru a dezvolta și valida performanța și acuratețea sarcinilor de lucru DL care vor fi implementate pe dispozitivele Qualcomm. Instanțele DL2q sunt primele instanțe care au adus tehnologia inteligentă artificială (AI) Qualcomm în cloud.

Cu opt acceleratoare Qualcomm AI 100 Standard și 128 GiB de memorie totală a acceleratorului, clienții pot folosi, de asemenea, instanțe DL2q pentru a rula aplicații AI generative populare, cum ar fi generarea de conținut, rezumatul textului și asistenții virtuali, precum și aplicațiile AI clasice pentru procesarea limbajului natural. și viziunea computerizată. În plus, acceleratoarele Qualcomm AI 100 dispun de aceeași tehnologie AI folosită pe smartphone-uri, conducere autonomă, computere personale și căști de realitate extinsă, astfel încât instanțe DL2q pot fi folosite pentru a dezvolta și valida aceste sarcini de lucru AI înainte de implementare.

Noi evidențieri ale instanței DL2q

Fiecare instanță DL2q încorporează opt acceleratoare Qualcomm Cloud AI100, cu o performanță agregată de peste 2.8 PetaOps de performanță de inferență Int8 și 1.4 PetaFlops de performanță de inferență FP16. Instanța are un total de 112 de nuclee AI, capacitate de memorie acceleratoare de 128 GB și lățime de bandă de memorie de 1.1 TB pe secundă.

Fiecare instanță DL2q are 96 vCPU-uri, o capacitate de memorie de sistem de 768 GB și acceptă o lățime de bandă de rețea de 100 Gbps, precum și Magazin Amazon Elastic Block (Amazon EBS) stocare de 19 Gbps.

| Numele instanței | vCPU-uri | Acceleratoare Cloud AI100 | Memoria acceleratorului | Memoria acceleratorului BW (agregată) | Memoria de instanță | Rețea de instanță | Lățimea de bandă de stocare (Amazon EBS). |

| DL2q.24xlarg | 96 | 8 | 128 GB | 1.088 TB / s | 768 GB | 100 Gbps | 19 Gbps |

Inovație acceleratoare Qualcomm Cloud AI100

Sistemul pe cip (SoC) accelerator Cloud AI100 este o arhitectură multi-core, scalabilă, construită special, care acceptă o gamă largă de cazuri de utilizare pentru învățare profundă, de la centrul de date până la periferie. SoC folosește nuclee de calcul scalare, vectoriale și tensoare cu o capacitate SRAM on-die de 126 MB de lider în industrie. Miezurile sunt interconectate cu o rețea de rețea pe cip (NoC) cu lățime de bandă mare și latență scăzută.

Acceleratorul AI100 acceptă o gamă largă și cuprinzătoare de modele și cazuri de utilizare. Tabelul de mai jos evidențiază gama de suport pentru model.

| Categoria modelului | Numărul de modele | Exemple |

| NLP | 157 | BERT, BART, FasterTransformer, T5, cod Z MOE |

| AI generativ – NLP | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| AI generativ – imagine | 3 | Difuziune stabilă v1.5 și v2.1, OpenAI CLIP |

| CV – Clasificare imagini | 45 | ViT, ResNet, ResNext, MobileNet, EfficientNet |

| CV – Detectarea obiectelor | 23 | YOLO v2, v3, v4, v5 și v7, SSD-ResNet, RetinaNet |

| CV – Altele | 15 | LPRNet, Super-rezoluție/SRGAN, ByteTrack |

| Rețele auto* | 53 | Percepție și detectarea LIDAR, pietonilor, benzilor și semaforului |

| Total | > 300 | |

* Majoritatea rețelelor de automobile sunt rețele compozite care constau dintr-o fuziune a rețelelor individuale.

SRAM mare pe matriță de pe acceleratorul DL2q permite implementarea eficientă a tehnicilor avansate de performanță, cum ar fi precizia micro-exponentului MX6 pentru stocarea greutăților și precizia micro-exponentului MX9 pentru comunicarea de la accelerator la accelerator. Tehnologia micro-exponent este descrisă în următorul anunț al industriei Open Compute Project (OCP): AMD, Arm, Intel, Meta, Microsoft, NVIDIA și Qualcomm standardizează formatele de date de precizie îngustă de nouă generație pentru AI » Open Compute Project.

Utilizatorul instanței poate folosi următoarea strategie pentru a maximiza performanța-pe-cost:

- Stocați greutăți folosind precizia micro-exponentului MX6 în memoria DDR de pe accelerator. Utilizarea preciziei MX6 maximizează utilizarea capacității de memorie disponibilă și a lățimii de bandă a memoriei pentru a oferi cea mai bună capacitate de transfer și latență din clasă.

- Calculați în FP16 pentru a oferi precizia necesară pentru cazurile de utilizare, folosind în același timp SRAM superioară pe cip și topuri de rezervă de pe card, pentru a implementa nuclee de înaltă performanță, cu latență scăzută, de la MX6 la FP16.

- Utilizați o strategie de loturi optimizată și o dimensiune mai mare a lotului folosind SRAM-ul mare pe cip disponibil pentru a maximiza reutilizarea greutăților, păstrând în același timp activările pe cip la maximum posibil.

DL2q AI Stack și lanț de instrumente

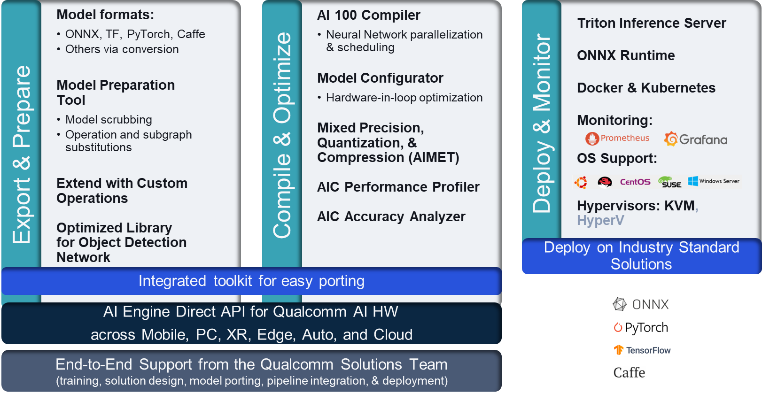

Instanța DL2q este însoțită de Qualcomm AI Stack, care oferă o experiență constantă pentru dezvoltatori în Qualcomm AI în cloud și alte produse Qualcomm. Aceeași tehnologie Qualcomm AI și tehnologie AI de bază rulează pe instanțele DL2q și dispozitivele edge Qualcomm, oferind clienților o experiență de dezvoltator consistentă, cu un API unificat în mediile lor de dezvoltare cloud, auto, computer personal, realitate extinsă și smartphone.

Lanțul de instrumente permite utilizatorului instanței să integreze rapid un model antrenat anterior, să compileze și să optimizeze modelul pentru capacitățile de instanță și, ulterior, să implementeze modelele compilate pentru cazurile de utilizare a inferenței de producție în trei pași prezentati în figura următoare.

Pentru a afla mai multe despre reglarea performanței unui model, consultați Cloud AI 100 parametri cheie de performanță Documentație.

Începeți cu instanțe DL2q

În acest exemplu, compilați și implementați un program pre-antrenat modelul BERT din Fata îmbrățișată pe o instanță EC2 DL2q folosind un AMI DL2q pre-construit, în patru pași.

Puteți folosi fie un pre-construit Qualcomm DLAMI pe instanță sau începeți cu o AMI Amazon Linux2 și creați-vă propriul AMI DL2q cu Cloud AI 100 Platform and Apps SDK disponibil în acest Serviciul Amazon de stocare simplă (Amazon S3) găleată: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

Pașii care urmează folosesc AMI-ul DL2q pre-construit, Qualcomm Base AL2 DLAMI.

Utilizați SSH pentru a vă accesa instanța DL2q cu Qualcomm Base AL2 DLAMI AMI și urmați pașii de la 1 la 4.

Pasul 1. Configurați mediul și instalați pachetele necesare

- Instalați Python 3.8.

- Configurați mediul virtual Python 3.8.

- Activați mediul virtual Python 3.8.

- Instalați pachetele necesare, afișate în documentul cerințe.txt disponibil pe site-ul public Qualcomm Github.

- Importați bibliotecile necesare.

Pasul 2. Importați modelul

- Importați și tokenizați modelul.

- Definiți o intrare de probă și extrageți

inputIdsșiattentionMask. - Convertiți modelul în ONNX, care poate fi apoi transmis compilatorului.

- Veți rula modelul cu precizie FP16. Deci, trebuie să verificați dacă modelul conține constante dincolo de intervalul FP16. Transmite modelul la

fix_onnx_fp16funcția de a genera noul fișier ONNX cu corecțiile necesare.

Pasul 3. Compilați modelul

qaic-exec Instrumentul de compilare a interfeței de linie de comandă (CLI) este utilizat pentru a compila modelul. Intrarea acestui compilator este fișierul ONNX generat la pasul 2. Compilatorul produce un fișier binar (numit QPC, Pentru Container de program Qualcomm) în calea definită de -aic-binary-dir a susținut.

În comanda de compilare de mai jos, utilizați patru nuclee de calcul AI și o dimensiune a lotului de unul pentru a compila modelul.

QPC-ul este generat în bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc dosar.

Pasul 4. Rulați modelul

Configurați o sesiune pentru a rula inferența pe un accelerator Cloud AI100 Qualcomm în instanța DL2q.

Biblioteca Qualcomm qaic Python este un set de API-uri care oferă suport pentru rularea inferenței pe acceleratorul Cloud AI100.

- Utilizați apelul API Session pentru a crea o instanță de sesiune. Apelul Session API este punctul de intrare în utilizarea bibliotecii qaic Python.

- Restructurați datele din bufferul de ieșire cu

output_shapeșioutput_type. - Decodați rezultatul produs.

Iată ieșirile pentru propoziția de intrare „Câinele [MASCA] pe covor.”

Asta este. Cu doar câțiva pași, ați compilat și rulat un model PyTorch pe o instanță Amazon EC2 DL2q. Pentru a afla mai multe despre integrarea și compilarea modelelor pe instanța DL2q, consultați Documentația tutorialului Cloud AI100.

Pentru a afla mai multe despre arhitecturile modelului DL care sunt potrivite pentru instanțe AWS DL2q și matricea actuală de suport pentru model, consultați Documentația Qualcomm Cloud AI100.

Disponibil acum

Puteți lansa instanțe DL2q astăzi în regiunile AWS din vestul SUA (Oregon) și Europa (Frankfurt) ca La cerere, Rezervat, și Instanțe spot, sau ca parte a unui Plan de economii. Ca de obicei cu Amazon EC2, plătești doar pentru ceea ce folosești. Pentru mai multe informații, vezi Prețul Amazon EC2.

Instanțele DL2q pot fi implementate folosind AMI-uri AWS Deep Learning (DLAMI), iar imaginile containerului sunt disponibile prin intermediul serviciilor gestionate, cum ar fi Amazon SageMaker, Serviciul Amazon Elastic Kubernetes (Amazon EKS), Amazon Elastic Container Service (Amazon ECS), și AWS ParallelCluster.

Pentru a afla mai multe, vizitați Instanță Amazon EC2 DL2q pagina și trimiteți feedback la AWS re:Post pentru EC2 sau prin contactele dvs. obișnuite de asistență AWS.

Despre autori

AK Roy este Director de Product Management la Qualcomm, pentru produse și soluții AI pentru Cloud și Datacenter. Are peste 20 de ani de experiență în strategia și dezvoltarea de produse, cu accent actual pe performanță și performanță de cea mai bună calitate/soluții end-to-end pentru inferența AI în cloud, pentru o gamă largă de cazuri de utilizare, inclusiv GenAI, LLMs, Auto și Hybrid AI.

AK Roy este Director de Product Management la Qualcomm, pentru produse și soluții AI pentru Cloud și Datacenter. Are peste 20 de ani de experiență în strategia și dezvoltarea de produse, cu accent actual pe performanță și performanță de cea mai bună calitate/soluții end-to-end pentru inferența AI în cloud, pentru o gamă largă de cazuri de utilizare, inclusiv GenAI, LLMs, Auto și Hybrid AI.

Jianying Lang este arhitect principal de soluții la AWS Worldwide Specialist Organization (WWSO). Ea are peste 15 ani de experiență de lucru în domeniul HPC și AI. La AWS, ea se concentrează pe a ajuta clienții să implementeze, să optimizeze și să-și scaleze sarcinile de lucru AI/ML pe instanțe de calcul accelerate. Este pasionată de combinarea tehnicilor din domeniile HPC și AI. Jianying deține un doctorat în fizică computațională de la Universitatea din Colorado din Boulder.

Jianying Lang este arhitect principal de soluții la AWS Worldwide Specialist Organization (WWSO). Ea are peste 15 ani de experiență de lucru în domeniul HPC și AI. La AWS, ea se concentrează pe a ajuta clienții să implementeze, să optimizeze și să-și scaleze sarcinile de lucru AI/ML pe instanțe de calcul accelerate. Este pasionată de combinarea tehnicilor din domeniile HPC și AI. Jianying deține un doctorat în fizică computațională de la Universitatea din Colorado din Boulder.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :are

- :este

- $UP

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- ani 15

- 15%

- 17

- 19

- 20

- ani 20

- 22

- 23

- 7

- 75

- 8

- 84

- a

- Despre Noi

- mai sus

- accelerat

- accelerator

- acceleratoare

- acces

- însoțit

- precizie

- peste

- activări

- În plus,

- avansat

- agregat

- AI

- AI / ML

- TOATE

- de asemenea

- Amazon

- Amazon EC2

- Amazon Web Services

- an

- și

- Anunț

- Orice

- api

- API-uri

- aplicatii

- Apps

- arhitectură

- SUNT

- argument

- ARM

- artificial

- AS

- asistenți

- At

- Auto

- auto

- autonom

- disponibil

- AWS

- AXE

- Lățime de bandă

- de bază

- BE

- înainte

- de mai jos

- Dincolo de

- BIN

- Bloca

- Floare

- aduce

- larg

- tampon

- construi

- by

- apel

- denumit

- CAN

- capacități

- Capacitate

- card

- caz

- verifica

- clasic

- Cloud

- Colorado

- combinând

- Comunicare

- cuprinzător

- de calcul

- Calcula

- calculator

- Computer Vision

- Calculatoare

- tehnica de calcul

- consistent

- Constând

- contacte

- Recipient

- conține

- conţinut

- Generare de conținut

- crea

- Curent

- clienţii care

- de date

- Datacenter

- adânc

- învățare profundă

- definit

- Grad

- livra

- Oferă

- implementa

- dislocate

- desfășurarea

- descris

- dezvolta

- Dezvoltator

- Dezvoltare

- dispozitiv

- Dispozitive

- difuziune

- Director

- documentaţie

- Câine

- conducere

- dinamic

- Margine

- eficient

- oricare

- angajează

- permite

- un capăt la altul

- intrare

- Mediu inconjurator

- medii

- Europa

- exemplu

- experienţă

- realitate extinsă

- extrage

- fals

- Caracteristică

- feedback-ul

- puțini

- camp

- Domenii

- Figura

- Fișier

- First

- potrivi

- Concentra

- se concentrează

- urma

- următor

- Pentru

- găsit

- patru

- frankfurt

- din

- funcţie

- fuziune

- în general

- genera

- generată

- generaţie

- generativ

- AI generativă

- GitHub

- dat

- bine

- Oaspete

- Vizitator Mesaj

- he

- căști

- ajutor

- aici

- performanta ridicata

- superior

- highlights-uri

- deține

- hpc

- HTML

- HTTPS

- Hibrid

- i

- idx

- if

- imagine

- imagini

- punerea în aplicare a

- implementarea

- import

- in

- Inclusiv

- încorporează

- individ

- industrie

- lider în industrie

- informații

- intrare

- instala

- instanță

- Intel

- Inteligent

- interconectate

- interfaţă

- IT

- jpg

- doar

- Cheie

- Bandă

- limbă

- mare

- Latență

- lansa

- AFLAȚI

- învăţare

- biblioteci

- Bibliotecă

- ușoară

- Linie

- loturile

- gestionate

- administrare

- masca

- Matrice

- max

- Maximaliza

- Maximizează

- maxim

- Memorie

- ochiurilor de plasă

- meta

- Microsoft

- minute

- model

- Modele

- modificată

- mai mult

- cele mai multe

- nume

- îngust

- Natural

- Procesarea limbajului natural

- necesar

- Nevoie

- reţea

- rețele

- rețele

- Nou

- generație următoare

- acum

- NumPy

- Nvidia

- obiect

- of

- on

- bord

- La imbarcare

- ONE

- afară

- deschide

- OpenAI

- Optimizați

- optimizate

- or

- Oregon

- organizație

- OS

- Altele

- afară

- producție

- iesiri

- peste

- propriu

- ofertele

- pagină

- parte

- trece

- Trecut

- pasionat

- cale

- Plătește

- pentru

- performanță

- personal

- PhD

- Fizică

- platformă

- Plato

- Informații despre date Platon

- PlatoData

- Punct

- Popular

- posibil

- Post

- alimentat

- Precizie

- în prealabil

- Principal

- prelucrare

- Produs

- produce

- Produs

- management de produs

- producere

- Produse

- Program

- proiect

- furnizează

- furnizarea

- public

- Piton

- pirtorh

- Qualcomm

- repede

- gamă

- RE

- Citind

- Realitate

- regiuni

- necesar

- Cerinţe

- reținere

- reveni

- reutilizarea

- Roy

- Alerga

- funcţionare

- ruleaza

- acelaşi

- Economisiți

- economisire

- scalabil

- Scară

- sdk

- Al doilea

- vedea

- trimite

- propoziție

- Secvenţă

- serviciu

- Servicii

- sesiune

- set

- ea

- indicat

- simplu

- simplifica

- teren

- Mărimea

- smartphone

- smartphone-uri

- So

- soluţii

- tensiune

- specialist

- stivui

- standard

- Începe

- început

- Pas

- paşi

- depozitare

- stoca

- stocarea

- Strategie

- Ulterior

- astfel de

- superior

- a sustine

- De sprijin

- Sprijină

- SYS

- sistem

- tabel

- tehnici de

- Tehnologia

- a) Sport and Nutrition Awareness Day in Manasia Around XNUMX people from the rural commune Manasia have participated in a sports and healthy nutrition oriented activity in one of the community’s sports ready yards. This activity was meant to gather, mainly, middle-aged people from a Romanian rural community and teach them about the benefits that sports have on both their mental and physical health and on how sporting activities can be used to bring people from a community closer together. Three trainers were made available for this event, so that the participants would get the best possible experience physically and so that they could have the best access possible to correct information and good sports/nutrition practices. b) Sports Awareness Day in Poiana Țapului A group of young participants have taken part in sporting activities meant to teach them about sporting conduct, fairplay, and safe physical activities. The day culminated with a football match.

- acea

- lor

- apoi

- Acestea

- ei

- acest

- trei

- Prin

- debit

- prin

- la

- astăzi

- tokeniza

- instrument

- Bluze

- lanternă

- Total

- trafic

- dresat

- transformatoare

- adevărat

- de reglaj

- tutorial

- unificat

- universitate

- us

- utilizare

- carcasa de utilizare

- utilizare-cazuri

- utilizat

- Utilizator

- folosind

- ca de obicei

- v1

- VALIDA

- valoare

- Virtual

- viziune

- Vizita

- we

- web

- servicii web

- BINE

- Vest

- Ce

- care

- în timp ce

- larg

- Gamă largă

- voi

- cu

- Cuvânt

- de lucru

- la nivel internațional.

- ani

- Tu

- Ta

- zephyrnet