Astăzi, suntem încântați să anunțăm că modelele de fundație Llama 2 dezvoltate de Meta sunt disponibile pentru clienți Amazon SageMaker JumpStart. Familia de modele de limbaj mari (LLM) Llama 2 este o colecție de modele de text generative pre-antrenate și reglate fin, cu o scară cuprinsă între 7 miliarde și 70 de miliarde de parametri. LLM-urile ajustate, numite Llama-2-chat, sunt optimizate pentru cazuri de utilizare a dialogului. Puteți încerca cu ușurință aceste modele și le puteți utiliza cu SageMaker JumpStart, care este un hub de învățare automată (ML) care oferă acces la algoritmi, modele și soluții ML, astfel încât să puteți începe rapid cu ML.

În această postare, vom explica cum să folosiți modelele Llama 2 prin SageMaker JumpStart.

Ce este Llama 2

Llama 2 este un model de limbaj auto-regresiv care utilizează o arhitectură transformatoare optimizată. Llama 2 este destinat utilizării comerciale și de cercetare în limba engleză. Vine într-o gamă de dimensiuni de parametri — 7 miliarde, 13 miliarde și 70 de miliarde — precum și variații pre-antrenate și reglate fin. Potrivit Meta, versiunile ajustate folosesc reglarea fină supravegheată (SFT) și învățarea prin întărire cu feedback uman (RLHF) pentru a se alinia la preferințele umane pentru utilitate și siguranță. Llama 2 a fost pre-antrenat pe 2 trilioane de date din surse disponibile public. Modelele reglate sunt destinate chatului de tip asistent, în timp ce modelele pre-antrenate pot fi adaptate pentru o varietate de sarcini de generare a limbajului natural. Indiferent de versiunea modelului pe care o folosește un dezvoltator, programul ghid de utilizare responsabilă de la Meta poate ajuta la ghidarea reglajelor suplimentare care ar putea fi necesare pentru personalizarea și optimizarea modelelor cu măsuri de reducere a siguranței adecvate.

Ce este SageMaker JumpStart

Cu SageMaker JumpStart, practicienii ML pot alege dintr-o selecție largă de modele de fundații open source. Practicienii ML pot implementa modele de fundație pentru dedicate Amazon SageMaker instanțe dintr-un mediu izolat în rețea și personalizați modelele folosind SageMaker pentru instruirea și implementarea modelelor.

Acum puteți descoperi și implementa Llama 2 cu câteva clicuri Amazon SageMaker Studio sau programatic prin intermediul SDK-ului SageMaker Python, permițându-vă să obțineți performanța modelului și controalele MLOps cu funcții SageMaker, cum ar fi Pipelines Amazon SageMaker, Debugger Amazon SageMaker, sau jurnalele containerului. Modelul este implementat într-un mediu securizat AWS și sub controalele dvs. VPC, contribuind la asigurarea securității datelor. Modelele Llama 2 sunt disponibile astăzi în Amazon SageMaker Studio, inițial în us-east 1 și us-west 2 regiuni.

Descoperă modele

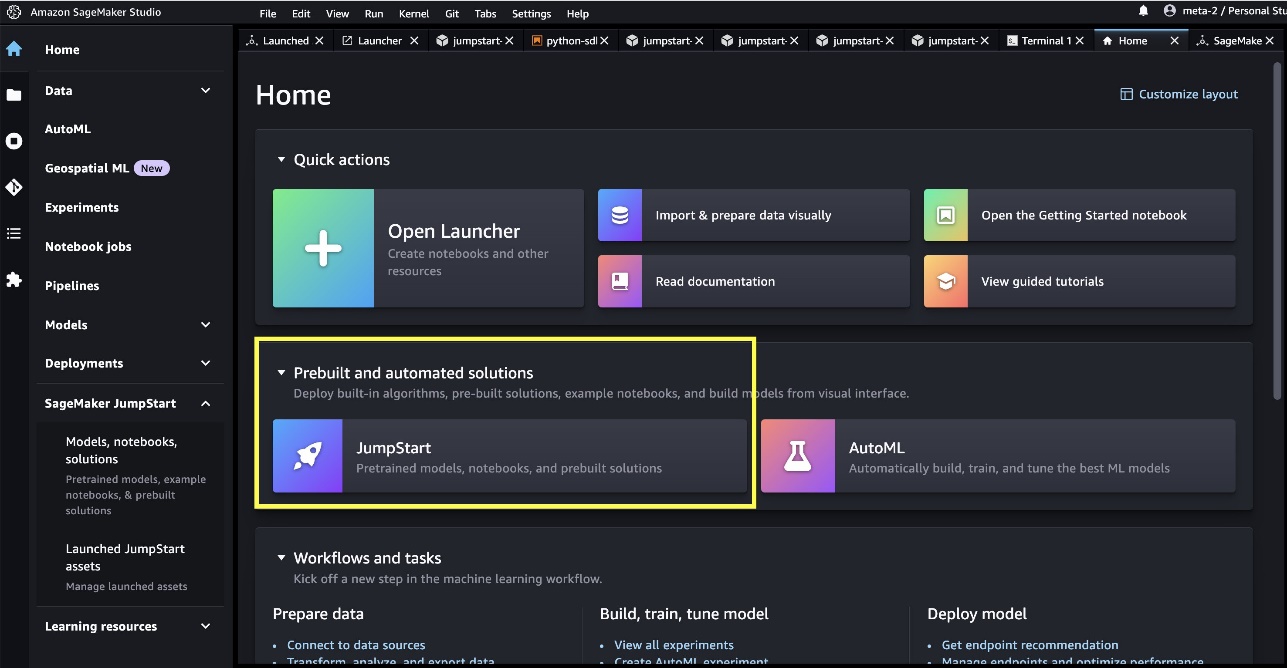

Puteți accesa modelele de fundație prin SageMaker JumpStart în SageMaker Studio UI și SageMaker Python SDK. În această secțiune, vom analiza cum să descoperiți modelele în SageMaker Studio.

SageMaker Studio este un mediu de dezvoltare integrat (IDE) care oferă o interfață vizuală unică bazată pe web, unde puteți accesa instrumente special create pentru a efectua toți pașii de dezvoltare ML, de la pregătirea datelor până la construirea, antrenamentul și implementarea modelelor dvs. ML. Pentru mai multe detalii despre cum să începeți și să configurați SageMaker Studio, consultați Amazon SageMaker Studio.

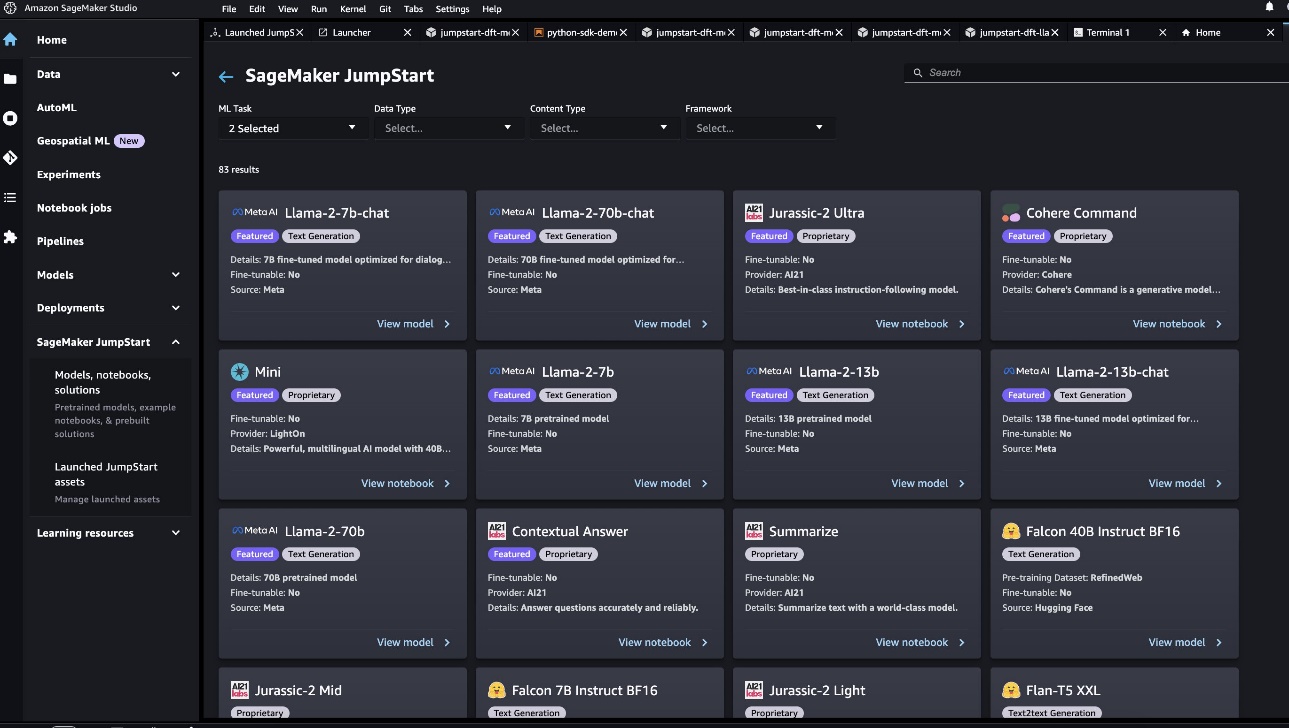

Odată ce sunteți în SageMaker Studio, puteți accesa SageMaker JumpStart, care conține modele pre-antrenate, notebook-uri și soluții prefabricate, sub Soluții preconstruite și automatizate.

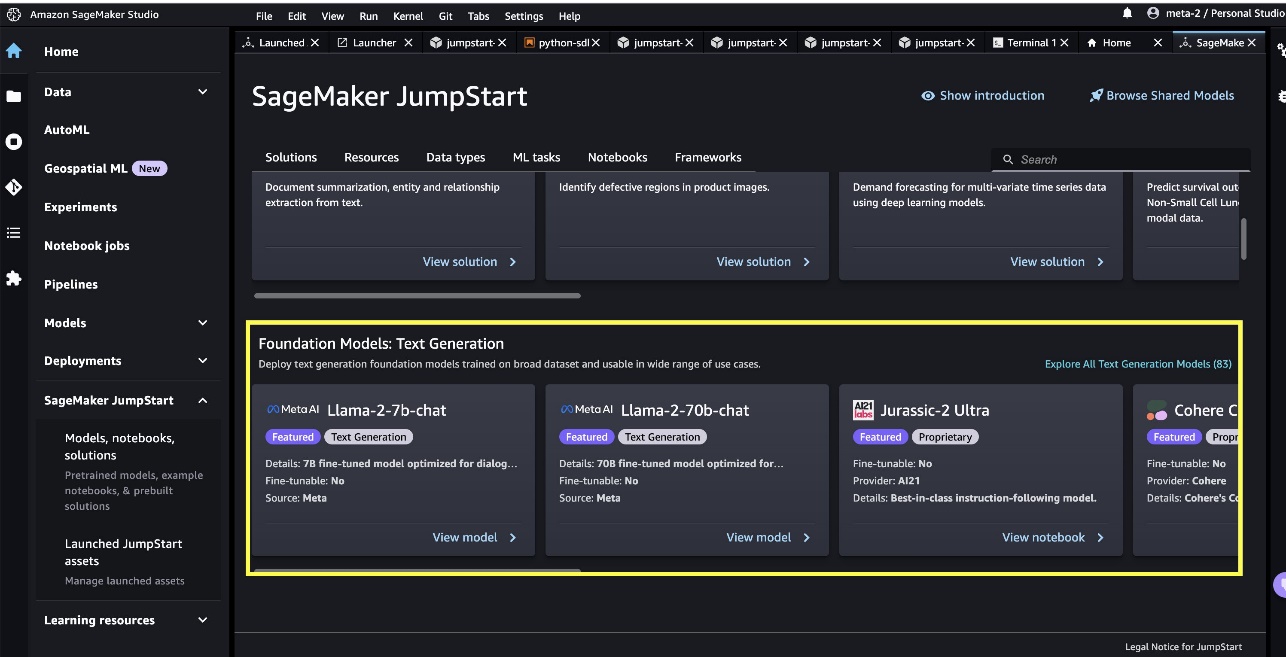

Din pagina de destinație SageMaker JumpStart, puteți căuta soluții, modele, notebook-uri și alte resurse. Puteți găsi două modele emblematice Llama 2 în Modele de fundație: Generarea textului carusel. Dacă nu vedeți modelele Llama 2, actualizați versiunea SageMaker Studio prin închiderea și repornirea. Pentru mai multe informații despre actualizările versiunii, consultați Închideți și actualizați aplicațiile Studio.

Poti gasi si alte patru variante de model alegand Explorați toate modelele de generare de text sau căutarea llama în caseta de căutare.

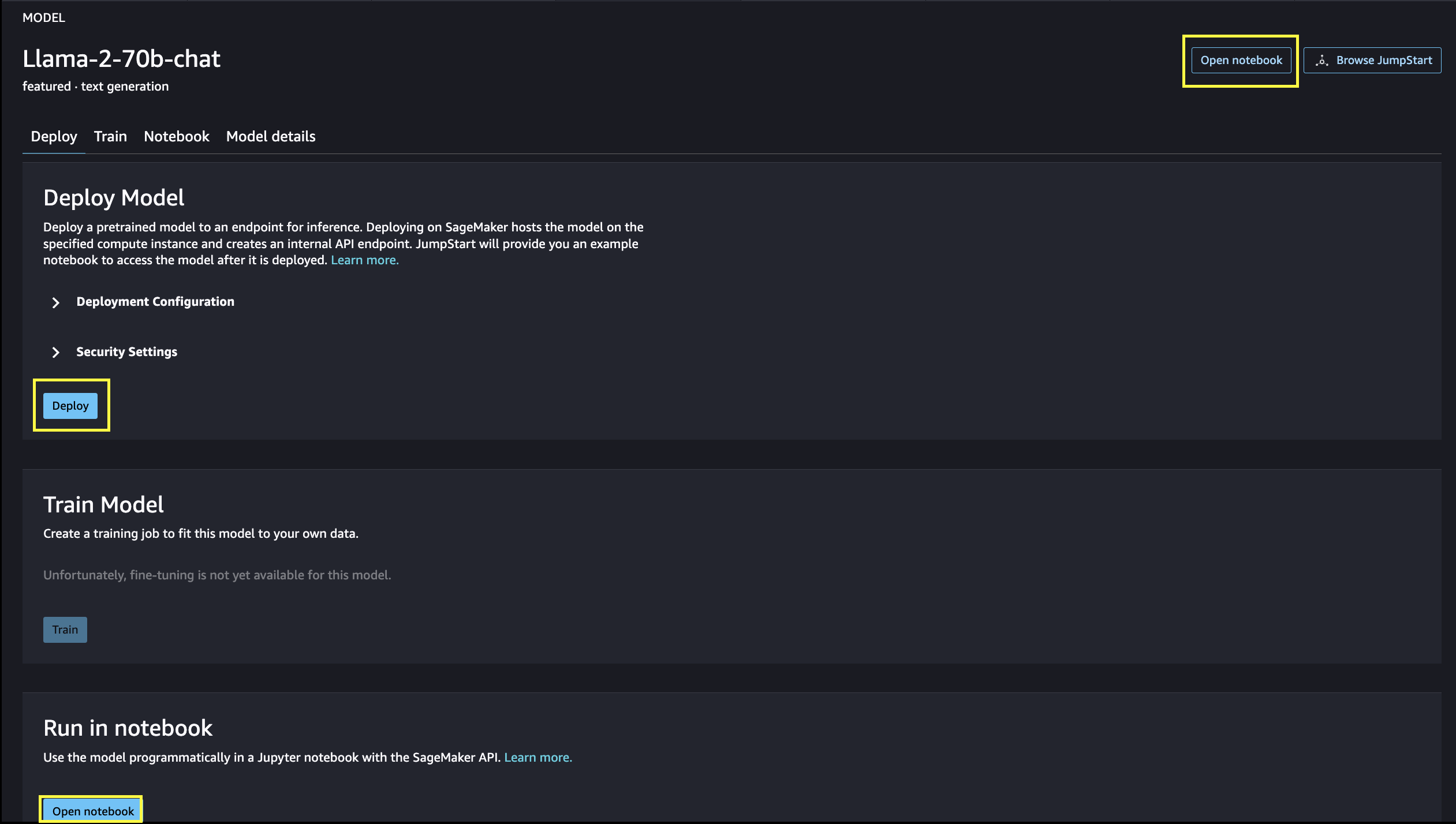

Puteți alege cardul model pentru a vedea detalii despre model, cum ar fi licența, datele utilizate pentru antrenament și modul de utilizare. De asemenea, puteți găsi două butoane, Lansa și Deschide Notebook, care vă ajută să utilizați modelul.

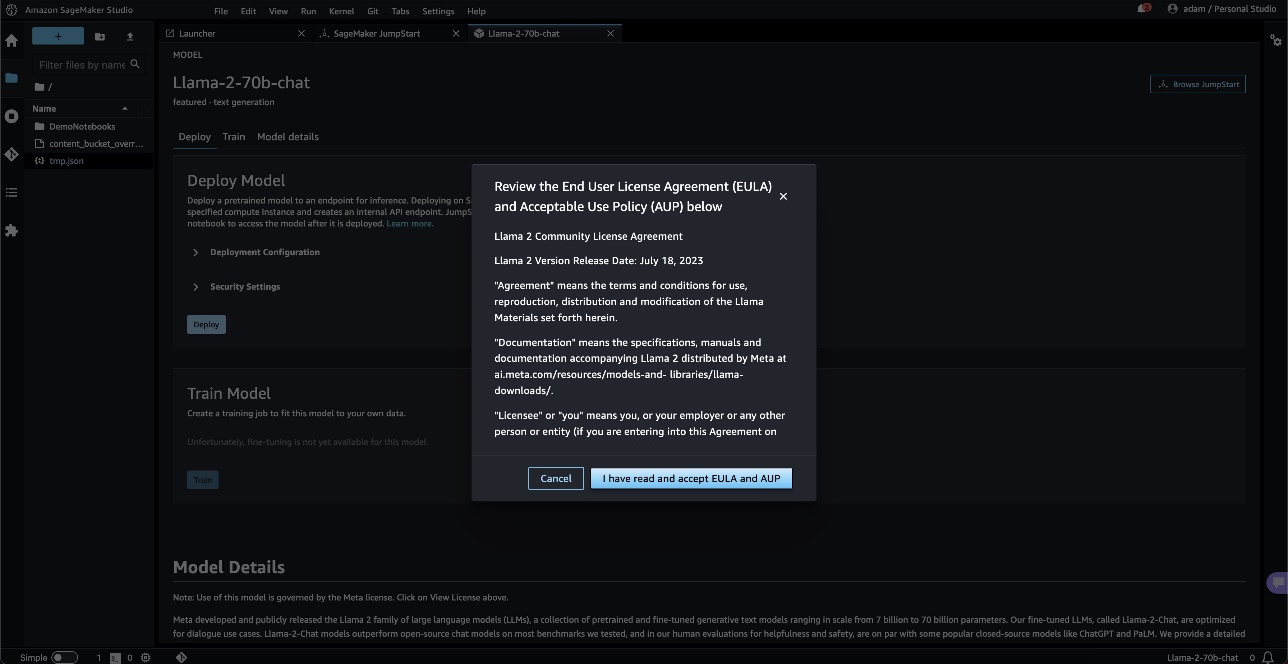

Când alegeți oricare dintre butoane, o fereastră pop-up va afișa acordul de licență pentru utilizatorul final și politica de utilizare acceptabilă pe care să le confirmați.

După ce ați confirmat, veți trece la pasul următor pentru a utiliza modelul.

Implementați un model

Când alegi Lansa și acceptați termenii, va începe implementarea modelului. Alternativ, puteți implementa prin exemplul de blocnotes care apare prin alegere Deschide Notebook. Exemplul de blocnotes oferă îndrumări de la capăt la capăt cu privire la modul de implementare a modelului pentru inferență și curățarea resurselor.

Pentru a implementa folosind un notebook, începem prin a selecta un model adecvat, specificat de model_id. Puteți implementa oricare dintre modelele selectate pe SageMaker cu următorul cod:

Aceasta implementează modelul pe SageMaker cu configurații implicite, inclusiv tipul de instanță implicit și configurațiile VPC implicite. Puteți modifica aceste configurații specificând valori care nu sunt implicite în JumpStartModel. După ce este implementat, puteți rula inferențe împotriva punctului final implementat prin predictorul SageMaker:

Modelele de chat ajustate (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) acceptă un istoric al chat-ului între utilizator și asistentul de chat și generează chatul ulterioar. Modelele pre-antrenate (Llama-2-7b, Llama-2-13b, Llama-2-70b) necesită un prompt de șir și completează textul la promptul furnizat. Vezi următorul cod:

Rețineți că în mod implicit, accept_eula este setat la fals. Trebuie să setați accept_eula=true pentru a invoca punctul final cu succes. Procedând astfel, acceptați acordul de licență de utilizare și politica de utilizare acceptabilă, așa cum sa menționat mai devreme. Poti de asemenea Descarca contractul de licență.

Custom_attributes folosite pentru a trece EULA sunt perechi cheie/valoare. Cheia și valoarea sunt separate prin = iar perechile sunt separate prin ;. Dacă utilizatorul trece aceeași cheie de mai multe ori, ultima valoare este păstrată și transmisă handler-ului de script (adică, în acest caz, folosită pentru logica condiționată). De exemplu, dacă accept_eula=false; accept_eula=true este transmis serverului, atunci accept_eula=true este păstrat și transmis la handler-ul de script.

Parametrii de inferență controlează procesul de generare a textului la punctul final. Controlul maxim al noilor jetoane se referă la dimensiunea rezultatului generat de model. Rețineți că acesta nu este același cu numărul de cuvinte, deoarece vocabularul modelului nu este același cu vocabularul în limba engleză și este posibil ca fiecare simbol să nu fie un cuvânt în limba engleză. Temperatura controlează aleatoritatea în ieșire. O temperatură mai ridicată are ca rezultat rezultate mai creative și halucinate. Toți parametrii de inferență sunt opționali.

Următorul tabel listează toate modelele Llama disponibile în SageMaker JumpStart împreună cu model_ids, tipurile de instanțe implicite și numărul maxim de jetoane totale (suma numărului de jetoane de intrare și numărul de jetoane generate) acceptate pentru fiecare dintre aceste modele.

| Nume model | ID model | Totalul maxim de jetoane | Tip de instanță implicit |

| Lama-2-7b | meta-textgeneration-llama-2-7b | 4096 | ml.g5.2xmare |

| Llama-2-7b-chat | meta-textgeneration-llama-2-7b-f | 4096 | ml.g5.2xmare |

| Lama-2-13b | meta-textgeneration-llama-2-13b | 4096 | ml.g5.12xmare |

| Llama-2-13b-chat | meta-textgeneration-llama-2-13b-f | 4096 | ml.g5.12xmare |

| Lama-2-70b | meta-textgeneration-llama-2-70b | 4096 | ml.g5.48xmare |

| Llama-2-70b-chat | meta-textgeneration-llama-2-70b-f | 4096 | ml.g5.48xmare |

Rețineți că punctele finale SageMaker au o limită de expirare de 60 de secunde. Astfel, chiar dacă modelul poate genera 4096 de jetoane, dacă generarea textului durează mai mult de 60 de secunde, cererea va eșua. Pentru modelele 7B, 13B și 70B, vă recomandăm să setați max_new_tokens nu mai mult de 1500, 1000 și, respectiv, 500, păstrând în același timp numărul total de jetoane mai mic de 4K.

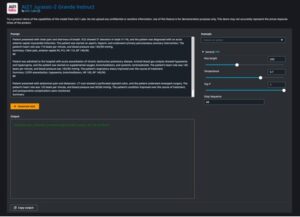

Inferențe și exemple de solicitări pentru Llama-2-70b

Puteți utiliza modele Llama pentru completarea textului pentru orice bucată de text. Prin generarea de text, puteți efectua o varietate de sarcini, cum ar fi răspunsul la întrebări, traducerea limbii, analiza sentimentelor și multe altele. Sarcina utilă de intrare la punctul final arată ca următorul cod:

Următoarele sunt câteva exemple de prompturi și textul generat de model. Toate ieșirile sunt generate cu parametri de inferență {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

În exemplul următor, arătăm cum să folosiți modelele Llama cu învățare în context cu câteva fotografii, unde oferim mostre de antrenament disponibile modelului. Rețineți că facem inferențe doar asupra modelului implementat și în timpul acestui proces, ponderile modelului nu se schimbă.

Inferențe și exemple de solicitări pentru Llama-2-70b-chat

Cu modelele Llama-2-Chat, care sunt optimizate pentru cazuri de utilizare a dialogului, intrarea în punctele finale ale modelului de chat este istoricul anterior dintre asistentul de chat și utilizator. Puteți pune întrebări în contextul conversației care a avut loc până acum. De asemenea, puteți furniza configurația sistemului, cum ar fi personaje care definesc comportamentul asistentului de chat. Sarcina utilă de intrare către punctul final arată ca următorul cod:

Următoarele sunt câteva exemple de prompturi și textul generat de model. Toate ieșirile sunt generate cu parametrii de inferență {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

În exemplul următor, utilizatorul a avut o conversație cu asistentul despre locurile turistice din Paris. În continuare, utilizatorul întreabă despre prima opțiune recomandată de asistentul de chat.

În următoarele exemple, setăm configurația sistemului:

A curăța

După ce ați terminat de rulat blocnotesul, asigurați-vă că ștergeți toate resursele, astfel încât toate resursele pe care le-ați creat în acest proces să fie șterse și facturarea dvs. să fie oprită:

Concluzie

În această postare, v-am arătat cum să începeți cu modelele Llama 2 în SageMaker Studio. Cu aceasta, aveți acces la șase modele de fundație Llama 2 care conțin miliarde de parametri. Deoarece modelele de fundație sunt pregătite în prealabil, ele pot ajuta, de asemenea, la reducerea costurilor de instruire și infrastructură și pot permite personalizarea pentru cazul dvs. de utilizare. Pentru a începe să utilizați SageMaker JumpStart, vizitați următoarele resurse:

Despre autori

June a câștigat este manager de produs cu SageMaker JumpStart. El se concentrează pe a face modele de bază ușor de descoperit și utilizabil pentru a ajuta clienții să construiască aplicații AI generative. Experiența sa la Amazon include, de asemenea, aplicația de cumpărături pe mobil și livrarea ultimului mile.

June a câștigat este manager de produs cu SageMaker JumpStart. El se concentrează pe a face modele de bază ușor de descoperit și utilizabil pentru a ajuta clienții să construiască aplicații AI generative. Experiența sa la Amazon include, de asemenea, aplicația de cumpărături pe mobil și livrarea ultimului mile.

Dr. Vivek Madan este un om de știință aplicat în echipa Amazon SageMaker JumpStart. Și-a luat doctoratul la Universitatea din Illinois la Urbana-Champaign și a fost cercetător post-doctoral la Georgia Tech. Este un cercetător activ în învățarea automată și proiectarea algoritmilor și a publicat lucrări în cadrul conferințelor EMNLP, ICLR, COLT, FOCS și SODA.

Dr. Vivek Madan este un om de știință aplicat în echipa Amazon SageMaker JumpStart. Și-a luat doctoratul la Universitatea din Illinois la Urbana-Champaign și a fost cercetător post-doctoral la Georgia Tech. Este un cercetător activ în învățarea automată și proiectarea algoritmilor și a publicat lucrări în cadrul conferințelor EMNLP, ICLR, COLT, FOCS și SODA.  Dr. Kyle Ulrich este un om de știință aplicat în echipa Amazon SageMaker JumpStart. Interesele sale de cercetare includ algoritmi scalabili de învățare automată, viziunea computerizată, serii temporale, non-parametrice bayesiene și procese gaussiene. Doctoratul său este de la Universitatea Duke și a publicat lucrări în NeurIPS, Cell, and Neuron.

Dr. Kyle Ulrich este un om de știință aplicat în echipa Amazon SageMaker JumpStart. Interesele sale de cercetare includ algoritmi scalabili de învățare automată, viziunea computerizată, serii temporale, non-parametrice bayesiene și procese gaussiene. Doctoratul său este de la Universitatea Duke și a publicat lucrări în NeurIPS, Cell, and Neuron.  Dr. Ashish Khetan este cercetător senior aplicat cu Amazon SageMaker JumpStart și ajută la dezvoltarea algoritmilor de învățare automată. Și-a luat doctoratul la Universitatea din Illinois Urbana-Champaign. Este un cercetător activ în învățarea automată și inferența statistică și a publicat multe lucrări în conferințele NeurIPS, ICML, ICLR, JMLR, ACL și EMNLP.

Dr. Ashish Khetan este cercetător senior aplicat cu Amazon SageMaker JumpStart și ajută la dezvoltarea algoritmilor de învățare automată. Și-a luat doctoratul la Universitatea din Illinois Urbana-Champaign. Este un cercetător activ în învățarea automată și inferența statistică și a publicat multe lucrări în conferințele NeurIPS, ICML, ICLR, JMLR, ACL și EMNLP.  Sundar Ranganathan este șeful global al specialiștilor GenAI/Frameworks GTM la AWS. El se concentrează pe dezvoltarea strategiei GTM pentru modele de limbă mari, GenAI și sarcini de lucru ML la scară largă prin servicii AWS precum Amazon EC2, EKS, EFA, AWS Batch și Amazon SageMaker. Experiența sa include roluri de conducere în managementul și dezvoltarea de produse la NetApp, Micron Technology, Qualcomm și Mentor Graphics.

Sundar Ranganathan este șeful global al specialiștilor GenAI/Frameworks GTM la AWS. El se concentrează pe dezvoltarea strategiei GTM pentru modele de limbă mari, GenAI și sarcini de lucru ML la scară largă prin servicii AWS precum Amazon EC2, EKS, EFA, AWS Batch și Amazon SageMaker. Experiența sa include roluri de conducere în managementul și dezvoltarea de produse la NetApp, Micron Technology, Qualcomm și Mentor Graphics.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. Automobile/VE-uri, carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- BlockOffsets. Modernizarea proprietății de compensare a mediului. Accesați Aici.

- Sursa: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :are

- :este

- :nu

- :Unde

- $UP

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- 360-grade

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- Capabil

- Despre Noi

- Accept

- acceptabil

- acces

- accesibilitate

- accesibil

- Conform

- recunoaște

- peste

- activ

- adăuga

- adăugare

- Suplimentar

- adresa

- După

- din nou

- împotriva

- Acord

- AI

- Algoritmul

- algoritmi

- alinia

- TOATE

- permite

- de-a lungul

- de asemenea

- mereu

- am

- Amazon

- Amazon EC2

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon SageMaker Studio

- Amazon Web Services

- american

- an

- analiză

- și

- și infrastructură

- anunța

- O alta

- răspunde

- Orice

- oricine

- aplicație

- aplicatii

- aplicat

- aprecia

- adecvat

- Arc

- arhitectură

- SUNT

- Artă

- AS

- ajuta

- Asistent

- At

- Atmosfera

- Atracţii

- Automata

- disponibil

- AWS

- Banană

- de bază

- Luptă

- Bayesian

- BE

- frumos

- Frumuseţe

- a devenit

- deoarece

- deveni

- fost

- bere

- înainte

- comportament

- Beijing

- Crede

- credea

- CEL MAI BUN

- între

- facturare

- Miliard

- miliarde

- Negru

- Cutie

- Pauză

- uluitoare

- larg

- construi

- Clădire

- construit

- dar

- buton

- by

- denumit

- CAN

- capital

- mașină

- card

- carusel

- caz

- cazuri

- CAT

- Schimbare

- Ciocolată

- Alege

- alegere

- Oraș

- clasic

- cod

- colectare

- combinate

- combină

- vine

- venire

- comercial

- companie

- completare

- calculator

- Computer Vision

- conferințe

- încrezător

- Configuraţie

- luate în considerare

- constant

- construcţie

- conţine

- Recipient

- conține

- conţinut

- contextual

- continua

- continuu

- Control

- controale

- Convenabil

- Conversație

- Cheltuieli

- ţară

- curaj

- acoperi

- crea

- a creat

- Creator

- cultural

- Cultură

- Ceaşcă

- clienţii care

- personalizare

- personaliza

- de date

- securitatea datelor

- dedicat

- dăruire

- Mod implicit

- defini

- livrare

- implementa

- dislocate

- Implementarea

- desfășurarea

- implementează

- Amenajări

- proiectat

- dorit

- destinație

- destinații

- detalii

- dezvolta

- dezvoltat

- Dezvoltator

- în curs de dezvoltare

- Dezvoltare

- Dialog

- diferenţă

- diferit

- dificil

- descoperi

- distinctiv

- do

- documentare

- face

- făcut

- Dont

- sa dublat

- jos

- Duce

- duke universitate

- în timpul

- e

- fiecare

- Mai devreme

- cu ușurință

- uşor

- Edward

- Einstein

- oricare

- permite

- permițând

- capăt

- un capăt la altul

- Punct final

- Inginerie

- Engleză

- se bucura

- suficient de

- asigura

- Mediu inconjurator

- echipament

- Eter

- Chiar

- evenimente

- toată lumea

- exemplu

- exemple

- excitat

- experienţă

- experiment

- experimente

- expres

- FAIL

- A eșuat

- echitabil

- fals

- familie

- celebru

- departe

- ispravă

- Recomandate

- DESCRIERE

- feedback-ul

- picioare

- puțini

- filme

- final

- În cele din urmă

- Găsi

- First

- pilot

- pluti

- fluxurilor

- se concentrează

- următor

- Pentru

- Înainte

- găsit

- Fundație

- patru

- Franţa

- Franceză

- din

- complet

- mai mult

- viitor

- General

- genera

- generată

- generaţie

- generativ

- AI generativă

- Georgia

- obține

- Da

- de sticlă

- Caritate

- Go

- merge

- grafică

- mare

- mai mare

- inovatoare

- Crește

- îndrumare

- ghida

- HAD

- Mânere

- sa întâmplat

- fericit

- Greu

- greu de lucru

- Avea

- având în

- he

- cap

- ajutor

- ajutor

- ajută

- aici

- hi

- Înalt

- superior

- lui

- istoric

- istorie

- carcasă

- Cum

- Cum Pentru a

- HTML

- HTTPS

- Butuc

- uman

- i

- iconic

- idee

- if

- ii

- Illinois

- Impactul

- import

- important

- impresionant

- in

- include

- include

- Inclusiv

- Incorporated

- informații

- Infrastructură

- inițial

- intrare

- inspirat

- inspirator

- instanță

- imediat

- instrucțiuni

- integrate

- destinate

- interese

- interfaţă

- în

- izolat

- IT

- ESTE

- călătorie

- jpg

- doar

- păstrare

- ținut

- Cheie

- Copil

- Cunoaște

- cunoscut

- aterizare

- reper

- limbă

- mare

- pe scară largă

- cea mai mare

- Nume

- Târziu

- lansa

- legii

- Conducere

- AFLAȚI

- Învață și crește

- învăţare

- cel mai puțin

- mai puțin

- nivelurile de

- Licență

- Viaţă

- ușoară

- ca

- LIMITĂ

- liste

- literatură

- ll

- Lamă

- logică

- Lung

- perioadă lungă de timp

- cautati

- Se pare

- dragoste

- iubit

- LOWER

- maşină

- masina de învățare

- făcut

- face

- FACE

- Efectuarea

- administrare

- manager

- multe

- minune

- materie

- maxim

- Mai..

- sens

- măsura

- Mass-media

- mediu

- menționat

- mesaj

- meta

- micron

- minut

- minute

- amestec

- ML

- MLOps

- Mobil

- model

- Modele

- moment

- luni

- mai mult

- cele mai multe

- Cel mai popular

- mişcare

- film

- mult

- muzeu

- muzee

- Muzică

- nume

- Natural

- necesar

- Nevoie

- necesar

- reţea

- Nou

- New York

- următor

- Nu.

- caiet

- acum

- număr

- numeroși

- NY

- of

- oferi

- oferind

- promoții

- Ulei

- on

- dată

- ONE

- afară

- deschide

- open-source

- Optimizați

- optimizate

- Opțiune

- or

- Altele

- Altele

- in caz contrar

- al nostru

- afară

- producție

- peste

- global

- pagină

- perechi

- Hârtie

- lucrări

- parametru

- parametrii

- Paris

- parte

- trece

- Trecut

- trece

- trecut

- pace

- Efectua

- performanță

- permanent

- telefon

- fotografii

- Fizică

- bucată

- Pizza

- plastic

- Plato

- Informații despre date Platon

- PlatoData

- a jucat

- Politica

- pop-up

- Popular

- Post

- poştal

- Predictor

- preferinţele

- pregătirea

- prezenta

- precedent

- proces

- procese

- Produs

- dezvoltare de produs

- management de produs

- manager de produs

- propuneri

- mândru

- furniza

- prevăzut

- furnizează

- furnizarea

- public

- de transport public

- public

- publicat

- scop

- pune

- Piton

- Qualcomm

- Întrebări

- Rapid

- repede

- rampele

- dezordine

- gamă

- variind

- gata

- motive

- a primi

- reţetă

- recomanda

- recomandat

- se referă

- Fără deosebire

- regiuni

- relativ

- relativitatea

- repetat

- reprezenta

- solicita

- Necesită

- cercetare

- cercetător

- Resurse

- respectiv

- Răspunde

- REST

- rezultat

- REZULTATE

- Râu

- Rol

- rolurile

- Alerga

- funcţionare

- s

- Siguranţă

- sagemaker

- sare

- acelaşi

- scalabil

- Scară

- Om de stiinta

- oamenii de stiinta

- sdk

- SEA

- Caută

- căutare

- Secțiune

- sigur

- securitate

- vedea

- vedere

- părea

- selectate

- selectarea

- selecţie

- trimite

- senior

- sentiment

- serie

- Servicii

- servire

- set

- instalare

- Modela

- Rechin

- Cumpărături

- să

- Arăta

- a arătat

- Emisiuni

- închide

- semnificație

- semnificativ

- simplu

- pur şi simplu

- singur

- teren

- Centre de cercetare

- SIX

- Mărimea

- Încet

- mic

- So

- până acum

- Social

- social media

- soluţii

- unele

- Sursă

- Surse

- special

- specialiști

- specificată

- viteză

- Standuri

- Începe

- început

- Stat

- Statele

- statistic

- Pas

- paşi

- oprit

- Strategie

- Şir

- structura

- studio

- Uluitor

- subiect

- ulterior

- succes

- Reușit

- astfel de

- Suportat

- sigur

- simbol

- sistem

- tabel

- Lua

- ia

- sarcini

- gust

- echipă

- tech

- Tehnologia

- temporar

- termeni

- decât

- mulțumesc

- acea

- Capitala

- Viitorul

- Sursa

- lumea

- lor

- Lor

- teorie

- Acolo.

- Acestea

- ei

- lucruri

- crede

- acest

- deşi?

- Prin

- Tigru

- timp

- Seria de timp

- ori

- Titlu

- la

- astăzi

- împreună

- semn

- indicativele

- Unelte

- top

- Total

- Turn

- Tren

- Pregătire

- transformator

- Traduceți

- Traducere

- transport

- Trilion

- încerca

- Două

- tip

- Tipuri

- ui

- în

- neuitat

- unic

- universitate

- până la

- Actualizează

- actualizări

- utilizabil

- utilizare

- carcasa de utilizare

- utilizat

- Utilizator

- utilizatorii

- utilizări

- folosind

- valoare

- Valori

- varietate

- versiune

- Versiunile

- foarte

- de

- Vizualizare

- vizualizari

- viziune

- Vizita

- vizitatori

- volum

- dorit

- război

- a fost

- we

- web

- servicii web

- bazat pe web

- website

- BINE

- Balenă

- Ce

- Ce este

- cand

- întrucât

- care

- în timp ce

- de ce

- voi

- ferestre

- cu

- Cuvânt

- cuvinte

- Apartamente

- fabrică

- lume

- de renume mondial

- încadra

- ani

- York

- Tu

- Ta

- te

- zephyrnet

- Zip