Beskrivning

Föreställ dig att din granne ringer för att be om en tjänst: Kan du snälla mata deras husdjurskanin med morotsskivor? Lätt nog, skulle man tro. Du kan föreställa dig deras kök, även om du aldrig har varit där - morötter i ett kylskåp, en låda med olika knivar. Det är abstrakt kunskap: Du vet inte exakt hur din grannes morötter och knivar ser ut, men du tar inte en sked till en gurka.

Artificiell intelligens-program kan inte konkurrera. Vad som verkar vara en lätt uppgift är ett stort åtagande för nuvarande algoritmer.

En AI-tränad robot kan hitta en specificerad kniv och morot som gömmer sig i ett välbekant kök, men i ett annat kök kommer den att sakna de abstrakta färdigheterna för att lyckas. "De generaliserar inte till nya miljöer," sa victor zhong, en doktorand i datavetenskap vid University of Washington. Maskinen misslyckas eftersom det helt enkelt finns för mycket att lära sig och för stort utrymme att utforska.

Problemet är att dessa robotar – och AI-agenter i allmänhet – inte har en grund av koncept att bygga på. De vet inte vad en kniv eller en morot egentligen är, än mindre hur man öppnar en låda, väljer en och skär skivor. Denna begränsning beror delvis på det faktum att många avancerade AI-system tränas med en metod som kallas förstärkningsinlärning som i huvudsak är självutbildning genom försök och misstag. AI-agenter som utbildats med förstärkningsinlärning kan utföra jobbet de utbildats för att göra mycket bra, i den miljö de utbildats för att göra det i. Men byt jobb eller miljö, och dessa system kommer ofta att misslyckas.

För att komma runt denna begränsning har datavetare börjat lära maskiner viktiga begrepp innan de släpper loss. Det är som att läsa en manual innan du använder ny programvara: Du kan försöka utforska utan den, men du lär dig mycket snabbare med den. "Människor lär sig genom en kombination av både att göra och läsa," sa Karthik Narasimhan, en datavetare vid Princeton University. "Vi vill att maskiner ska göra detsamma."

Nytt jobb från Zhong och andra visar att en inlärningsmodell på det här sättet kan ladda inlärningen i simulerade miljöer, både online och i den verkliga världen med robotar. Och det gör inte bara att algoritmer lär sig snabbare – det guidar dem mot färdigheter som de annars aldrig skulle lära sig. Forskare vill att dessa medel ska bli generalister, som kan lära sig allt från schack till shopping till städning. Och när demonstrationer blir mer praktiska, tror forskare att detta tillvägagångssätt till och med kan förändra hur människor kan interagera med robotar.

"Det har varit ett ganska stort genombrott", säger Brian Ichter, en forskare inom robotik på Google. "Det är ganska ofattbart hur långt det har kommit på ett och ett halvt år."

Sparsamma belöningar

Vid första anblicken har maskininlärning redan varit anmärkningsvärt framgångsrik. De flesta modeller använder vanligtvis förstärkning lärande, där algoritmer lär sig genom att få belöningar. De börjar helt okunniga, men försök och misstag blir så småningom försök och triumf. Förstärkningsinlärningsagenter kan enkelt bemästra enkla spel.

Tänk på videospelet Snake, där spelarna styr en orm som blir längre när den äter digitala äpplen. Du vill att din orm ska äta mest äpplen, hålla sig inom gränserna och undvika att springa in i dess allt mer skrymmande kropp. Sådana tydliga rätt och fel resultat ger en välbelönad maskinagent positiv feedback, så tillräckligt många försök kan ta det från "noob" till High Score.

Men anta att reglerna ändras. Kanske måste samma agent spela på ett större rutnät och i tre dimensioner. Medan en mänsklig spelare kan anpassa sig snabbt, kan maskinen inte det på grund av två kritiska svagheter. För det första betyder det större utrymmet att det tar längre tid för ormen att snubbla över äpplen, och inlärningen saktar ner exponentiellt när belöningarna blir sparsamma. För det andra ger den nya dimensionen en helt ny erfarenhet, och förstärkande lärande kämpar för att generalisera till nya utmaningar.

Zhong säger att vi inte behöver acceptera dessa hinder. "Varför är det så att när vi vill spela schack" - ett annat spel som förstärkningsinlärning har bemästrat - "tränar vi en förstärkningsinlärningsagent från grunden?" Sådana tillvägagångssätt är ineffektiva. Agenten vandrar omkring planlöst tills den snubblar över en bra situation, som en schackmatt, och Zhong säger att det krävs noggrann mänsklig design för att få agenten att veta vad det betyder att en situation är bra. "Varför måste vi göra det här när vi redan har så många böcker om hur man spelar schack?"

Dels beror det på att maskiner har kämpat för att förstå mänskligt språk och dechiffrera bilder i första hand. För att en robot ska kunna utföra visionsbaserade uppgifter som att hitta och skära morötter, till exempel, måste den veta vad en morot är - bilden av en sak måste vara "grundad" i en mer grundläggande förståelse av vad den saken är. Tills nyligen fanns det inget bra sätt att göra det, men en boom i hastigheten och omfattningen av språk och bildbehandling har gjort de nya framgångarna möjliga.

Nya naturlig språkbehandling modeller tillåter maskiner att i huvudsak lära sig innebörden bakom ord och meningar - att jorda dem i saker i världen - snarare än att bara lagra en enkel (och begränsad) betydelse som en digital ordbok.

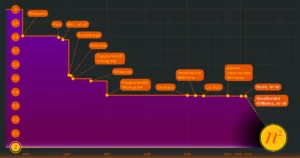

Datorseende har sett en liknande digital explosion. Runt 2009 debuterade ImageNet som en databas med kommenterade bilder för forskning om datorseende. Idag är den värd för över 14 miljoner bilder av föremål och platser. Och program som OpenAIs DALL·E generera nya bilder på kommando som ser människogjorda ut, trots att de inte har någon exakt jämförelse att dra ifrån.

Den visar hur maskiner först nu har tillgång till tillräckligt med onlinedata för att verkligen lära sig om världen, enligt Anima Anandkumar, en datavetare vid California Institute of Technology och Nvidia. Och det är ett tecken på att de kan lära av begrepp som vi gör och använda dem i generationer. "Vi befinner oss i ett så stort ögonblick nu," sa hon. "För att när vi väl kan få generation finns det så mycket mer vi kan göra."

Spelar systemet

Forskare som Zhong beslutade att maskiner inte längre behövde ge sig ut på sina utforskningar helt oinformerade. Beväpnade med sofistikerade språkmodeller kunde forskarna lägga till ett förträningssteg där ett program lärde sig av information online innan de testade och missade.

För att testa idén jämförde han och hans kollegor förträningen med traditionell förstärkningsinlärning i fem olika spelliknande inställningar där maskinagenter tolkade språkkommandon för att lösa problem. Varje simulerad miljö utmanade maskinagenten unikt. En bad agenten att manipulera föremål i ett 3D-kök; en annan behövde läsa text för att lära sig en exakt sekvens av åtgärder för att bekämpa monster. Men den mest komplicerade miljön var ett riktigt spel, det 35-åriga NetHack, där målet är att navigera i en sofistikerad fängelsehåla för att hämta en amulett.

För de enkla inställningarna innebar automatiserad förträning helt enkelt att grunda de viktiga begreppen: Det här är en morot, det vill säga ett monster. För NetHack tränade agenten genom att se människor spela, med hjälp av genomspelningar som laddats upp på internet av mänskliga spelare. Dessa genomspel behövde inte ens vara så bra - agenten behövde bara bygga intuition för hur människor beter sig. Agenten var inte menad att bli en expert, bara en vanlig spelare. Det skulle bygga intuition genom att titta - vad skulle en människa göra i ett givet scenario? Agenten skulle bestämma vilka drag som var framgångsrika, formulera sin egen morot och pinne.

"Genom förträning bildar vi goda föregångare för hur man associerar språkbeskrivningar med saker som händer i världen", sa Zhong. Agenten skulle spela bättre från början och lära sig snabbare under efterföljande förstärkningsinlärning.

Som ett resultat överträffade den förutbildade agenten den traditionellt utbildade. "Vi får vinster över hela linjen i alla fem av dessa miljöer," sa Zhong. Enklare inställningar visade bara en liten fördel, men i NetHacks komplicerade fängelsehålor lärde sig agenten många gånger snabbare och nådde en färdighetsnivå som den klassiska metoden inte kunde. "Du kanske får en 10x prestanda för om du inte gör det här, då lär du dig helt enkelt inte en bra policy," sa han.

"Dessa generalistagenter är ett stort steg från vad standardförstärkningsinlärning gör," sa Anandkumar.

Hennes team förutbildar också agenter för att få dem att lära sig snabbare, vilket gör betydande framsteg med världens bästsäljande videospel, Minecraft. Det är känt som ett "sandlådespel", vilket innebär att det ger spelarna ett praktiskt taget oändligt utrymme för att interagera och skapa nya världar. Det är meningslöst att programmera en belöningsfunktion för tusentals uppgifter individuellt, så istället lagets modell (“MineDojo”) byggde upp sin förståelse för spelet genom att titta på filmade genomspelningsvideor. Inget behov av att kodifiera gott beteende.

"Vi får automatiska belöningsfunktioner," sa Anandkumar. "Detta är det första riktmärket med tusentals uppgifter och förmågan att göra förstärkningsinlärning med öppna uppgifter som specificeras genom textuppmaningar."

Bortom spel

Spel var ett bra sätt att visa att förträningsmodeller kunde fungera, men de är fortfarande förenklade världar. Att träna robotar för att hantera den verkliga världen, där möjligheterna är praktiskt taget oändliga, är mycket svårare. "Vi ställde frågan: Finns det något däremellan?" sa Narasimhan. Så han bestämde sig för att handla lite online.

Hans team skapade WebShop. "Det är i grunden som en shoppingbutler," sa Narasimhan. Användare kan säga något i stil med "Ge mig en Nike-sko som är vit och under 100 $, och jag vill att recensionerna ska säga att de är väldigt bekväma för småbarn", och programmet hittar och köper skon.

Precis som med Zhongs och Anandkumars spel utvecklade WebShop en intuition genom att träna med bilder och text, denna gång från Amazon-sidor. "Med tiden lär den sig att förstå språket och kartlägga det till åtgärder den måste vidta på webbplatsen."

Vid en första anblick kanske en shoppingbutler inte verkar så futuristisk. Men medan en banbrytande chatbot kan länka dig till en önskad sneaker, kräver interaktioner som att lägga beställningen en helt annan färdighetsuppsättning. Och även om dina Alexa- eller Google Home-högtalare vid sängkanten kan göra beställningar, förlitar de sig på proprietär programvara som utför förbestämda uppgifter. WebShop navigerar på webben som människor gör: genom att läsa, skriva och klicka.

"Det är ett steg närmare allmän intelligens," sa Narasimhan.

Beskrivning

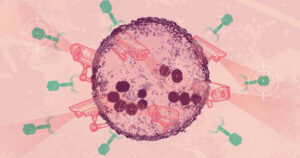

Naturligtvis har det sina egna utmaningar att få robotar att interagera med den verkliga världen. Tänk på en flaska, till exempel. Du kan känna igen en på dess utseende, du vet att den är avsedd att lagra vätskor och du förstår hur du manipulerar den med händerna. Kan riktiga maskiner någonsin förvandla ord och bilder till en komplex rörelseintelligens?

Narasimhan samarbetade med Anirudha Majumdar, en robotist på Princeton, för att ta reda på det. De lärde en robotarm att manipulera verktyg som den aldrig sett förut, och förtränade den med ett beskrivande språk hämtat från framgångsrika språkmodeller. Programmet lärde sig snabbare och presterade bättre med nästan varje verktyg och åtgärd, jämfört med program som lär sig genom traditionell utforskning, enligt resultat lades upp på preprint-servern arxiv.org i juni förra året.

Ingenjörer har byggt upp ett bibliotek med ännu mer komplexa kommandon i Googles robotlabb, också förankrade i kontextbyggande förträning. "Världen av möjligheter som du måste överväga är enorm," sa Karol Hausman, en forskare på Googles robotteknikteam. "Så vi ber språkmodellen att bryta ner det åt oss."

Teamet arbetade med en mobil hjälprobot, med en sju-ledad arm, som de tränade med hjälp av språkkunskaper. För varje givet kommando - som "hjälp mig att rensa min utspillda dryck" - använder programmet en språkmodell för att föreslå åtgärder från ett bibliotek med 700 tränade rörelser, till exempel "ta tag" en pappershandduk, "plocka upp" burken eller " kasta bort” burken. Och Hausman säger att det erkänner sina begränsningar med fraser som "Jag är faktiskt inte kapabel att torka av det. Men jag kan ge dig en svamp." Teamet rapporterade nyligen resultat från detta projekt, kallat SayCan.

En annan fördel med att ge robotar språkmodeller är att det blir trivialt att översätta synonymer och ord på andra språk. En person kan säga "vrid", medan en annan säger "rotera", och roboten förstår båda. "Det galnaste vi har provat är att det också förstår emojis," sa Fei Xia, en forskare på Google.

Botarna lär sig

SayCan är kanske den mest avancerade demonstrationen av språkbaserad inlärning inom robotik hittills. Och språk- och bildmodeller förbättras ständigt och skapar bättre och mer komplexa förträningstekniker.

Men Xia är noga med att dämpa spänningen. "Någon sa halvt på skämt att vi nådde 'robot GPT'-ögonblicket", sa han och syftade på de banbrytande språkmodellerna som förstår ett brett spektrum av mänskliga kommandon. "Vi är inte där än, och det finns mycket mer att utforska."

Till exempel kan dessa modeller ge felaktiga svar eller vidta felaktiga åtgärder, som forskare försöker förstå. Robotar har inte heller bemästrat "utföringsform”: Medan människor har en fysisk intuition som bygger på barndomen som lekte med leksaker, kräver robotar fortfarande verkliga interaktioner för att utveckla denna typ av intuition. "För vissa inställningar finns det många omärkta demonstrationer," sa Zhong - tänk på databaser med videospelsinteraktioner som Minecraft och NetHack. Ingen databas kan snabbt lära robotar intelligent rörelse.

Ändå går framstegen snabbt. Och fler forskare tror att smartare robotteknik kommer att bli slutresultatet. Narasimhan spårar denna människa-robot-utveckling från hålkort till nästa teknik. "Vi hade tangentbord och möss och sedan pekskärmar," sa han. Grundat språk är nästa. Du kommer att prata med din dator för svar och ärenden. "Hela drömmen om att assistenter ska vara riktigt kapabla har inte hänt ännu," sa han. "Men jag tror att det kommer att hända väldigt snart."

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://www.quantamagazine.org/machines-learn-better-if-we-teach-them-the-basics-20230201/

- 3d

- a

- förmåga

- Om Oss

- SAMMANDRAG

- Acceptera

- tillgång

- Enligt

- uppnå

- tvärs

- Handling

- åtgärder

- faktiskt

- anpassa

- avancerat

- Recensioner

- medel

- AI

- alexa

- algoritmer

- Alla

- redan

- amason

- och

- Annan

- svar

- tillvägagångssätt

- tillvägagångssätt

- ARM

- beväpnad

- runt

- array

- Associate

- Försök

- Automatiserad

- I grund och botten

- Grunderna

- därför att

- blir

- blir

- innan

- bakom

- Där vi får lov att vara utan att konstant prestera,

- tro

- riktmärke

- bästsäljare

- Bättre

- mellan

- Stor

- ombord

- kropp

- Böcker

- bom

- botar

- gränser

- Ha sönder

- genombrott

- Brian

- föra

- SLUTRESULTAT

- byggt

- buys

- kalifornien

- kallas

- Samtal

- Kan få

- kapabel

- Kort

- noggrann

- utmanade

- utmaningar

- byta

- chatbot

- schack

- Välja

- klassiska

- Rengöring

- klar

- närmare

- samarbetat

- kollegor

- kombination

- komma

- bekväm

- jämfört

- jämförelse

- konkurrera

- fullborda

- komplex

- komplicerad

- dator

- Datavetenskap

- Datorsyn

- Begreppen

- Tänk

- ständigt

- kontroll

- kunde

- Kurs

- skapa

- skapas

- Skapa

- kritisk

- Aktuella

- Klipp

- allra senaste

- datum

- Databas

- databaser

- Datum

- debuterade

- beslutade

- Dechiffrera

- Designa

- önskas

- Trots

- utveckla

- utvecklade

- DID

- olika

- digital

- Dimensionera

- dimensioner

- inte

- gör

- inte

- ner

- drömmen

- under

- varje

- lätt

- ät

- kant

- gå ombord

- ge

- Endless

- tillräckligt

- Miljö

- miljöer

- fel

- fel

- väsentligen

- Även

- så småningom

- NÅGONSIN

- Varje

- Utvecklingen

- exakt

- exempel

- Spänning

- exekvera

- erfarenhet

- expert

- utforskning

- utforska

- utforskas

- exponentiellt

- MISSLYCKAS

- misslyckas

- bekant

- SNABB

- snabbare

- gynna

- återkoppling

- bekämpa

- hitta

- finna

- fynd

- Förnamn

- formen

- formulering

- fundament

- från

- fungera

- funktioner

- grundläggande

- futuristiska

- resultat

- lek

- Games

- Allmänt

- allmän intelligens

- generera

- generering

- skaffa sig

- få

- GitHub

- Ge

- ges

- ger

- Blick

- Målet

- god

- Googles

- uppgradera

- stor

- Rutnät

- Marken

- banbrytande

- Växer

- Guider

- Hälften

- hantera

- händer

- hända

- hänt

- har

- Hög

- innehav

- Hem

- Hur ser din drömresa ut

- How To

- HTTPS

- stor

- humant

- Människa

- Tanken

- bild

- bilder

- med Esport

- förbättra

- in

- I andra

- alltmer

- Individuellt

- ineffektiv

- Oändlig

- informationen

- exempel

- istället

- Institute

- Intelligens

- Intelligent

- interagera

- interaktioner

- Internet

- IT

- artikel

- Jobb

- Vet

- kunskap

- känd

- Labs

- Brist

- språk

- Språk

- större

- Efternamn

- LÄRA SIG

- lärt

- inlärning

- Nivå

- Bibliotek

- begränsning

- begränsningar

- Begränsad

- LINK

- längre

- se

- ser ut som

- Lot

- Maskinen

- maskininlärning

- Maskiner

- gjord

- göra

- manuell

- många

- karta

- Master

- betyder

- betyder

- metod

- kanske

- miljon

- Minecraft

- Mobil

- modell

- modeller

- ögonblick

- mer

- mest

- rörelse

- förflyttar

- Navigera

- Behöver

- Nya

- Nästa

- NIKE

- Nvidia

- objekt

- hinder

- ONE

- nätet

- E-handel

- öppet

- beställa

- ordrar

- Övriga

- Övrigt

- annat

- Överträffa

- egen

- Papper

- del

- Personer

- prestanda

- kanske

- personen

- fraser

- fysisk

- Plats

- platser

- placering

- plato

- Platon Data Intelligence

- PlatonData

- Spela

- Spelaren

- spelare

- i

- snälla du

- policy

- positiv

- Möjligheterna

- möjlig

- posted

- Praktisk

- praktiskt taget

- pretty

- Problem

- problem

- bearbetning

- Program

- Program

- Framsteg

- projektet

- proprietary

- ge

- ger

- Quantamagazin

- fråga

- snabbt

- kanin

- kommit fram till

- Läsning

- verklig

- verkliga världen

- nyligen

- känner igen

- regelbunden

- Rapporterad

- kräver

- Obligatorisk

- Kräver

- forskning

- forskare

- resultera

- Resultat

- Omdömen

- Belöna

- Belöningar

- Roboten

- robotik

- robotar

- regler

- rinnande

- Nämnda

- Samma

- Skala

- Vetenskap

- Forskare

- vetenskapsmän

- skärmar

- Andra

- verkar

- Sekvens

- in

- inställning

- inställningar

- Gå och Handla

- show

- Visar

- signera

- signifikant

- liknande

- Enkelt

- förenklade

- helt enkelt

- Situationen

- skicklighet

- färdigheter

- saktar

- smartare

- Sneaker

- So

- Mjukvara

- LÖSA

- några

- något

- sofistikerade

- Utrymme

- tala

- högtalare

- specificerade

- fart

- spent

- standard

- starta

- Ange

- bo

- Steg

- Fortfarande

- lagra

- Struggles

- student

- snubblar

- senare

- lyckas

- framgångsrik

- sådana

- Superladdning

- System

- Ta

- tar

- uppgift

- uppgifter

- grupp

- tekniker

- Teknologi

- testa

- Smakämnen

- Grunderna

- världen

- deras

- sak

- saker

- tusentals

- tre

- Genom

- tid

- gånger

- till

- i dag

- alltför

- verktyg

- verktyg

- TOTALT

- Rör

- mot

- traditionell

- traditionellt

- Tåg

- tränad

- Utbildning

- rättegång

- försök

- SVÄNG

- typiskt

- under

- förstå

- förståelse

- förstår

- oinformerad

- universitet

- uppladdad

- us

- användning

- användare

- olika

- Omfattande

- Video

- videospel

- Video

- praktiskt taget

- syn

- washington

- tittar

- webb

- webp

- Webbplats

- Vad

- som

- medan

- vit

- Hela

- helt

- bred

- kommer

- avtorkning

- inom

- utan

- ord

- Arbete

- arbetade

- världen

- Världens

- skulle

- Fel

- år

- Om er

- Din

- zephyrnet

- Zhong