Sammanfattning är tekniken för att kondensera betydande information till en kompakt och meningsfull form, och står som en hörnsten för effektiv kommunikation i vår informationsrika tidsålder. I en värld full av data sparar du tid och hjälper dig fatta välgrundade beslut att sammanfatta långa texter till korta sammanfattningar. Sammanfattning kondenserar innehåll, sparar tid och förbättrar tydlighet genom att presentera information kortfattat och sammanhängande. Sammanfattning är ovärderlig för beslutsfattande och för att hantera stora volymer innehåll.

Sammanfattningsmetoder har ett brett spektrum av tillämpningar som tjänar olika syften, såsom:

- Nyhetsaggregation - Nyhetsaggregation innebär att sammanfatta nyhetsartiklar till ett nyhetsbrev för mediebranschen

- Sammanfattning av juridiska dokument - Sammanfattning av juridiska dokument hjälper jurister att extrahera viktig juridisk information från långa dokument som villkor, villkor och kontrakt

- akademisk forskning – Sammanfattning annoterar, indexerar, kondenserar och förenklar viktig information från akademiska artiklar

- Innehållskuration för bloggar och webbplatser – Du kan skapa engagerande och originella innehållssammanfattningar för läsare, särskilt inom marknadsföring

- Finansiella rapporter och marknadsanalyser – Du kan extrahera ekonomiska insikter från rapporter och skapa sammanfattningar för investerarpresentationer inom finansbranschen

Med framstegen inom naturlig språkbehandling (NLP), språkmodeller och generativ AI, har sammanfattningstexter av varierande längd blivit mer tillgängliga. Verktyg som Langkedja, kombinerat med en stor språkmodell (LLM) som drivs av Amazonas berggrund or Amazon SageMaker JumpStart, förenkla implementeringsprocessen.

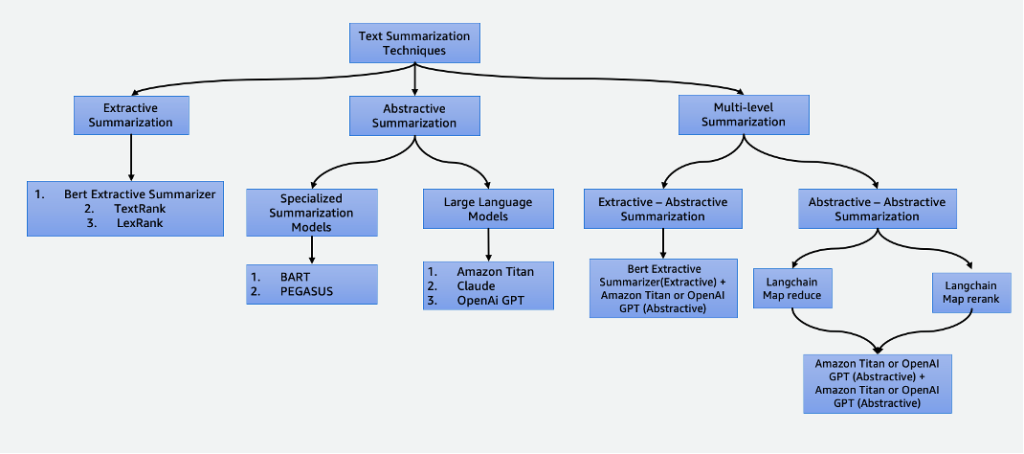

Det här inlägget fördjupar sig i följande sammanfattningstekniker:

- Extraktiv sammanfattning med BERT-extraktiv sammanfattning

- Abstrakt sammanfattning med hjälp av specialiserade sammanfattningsmodeller och LLM

- Två sammanfattningstekniker på flera nivåer:

- Extraktiv-abstraktiv sammanfattning med hjälp av strategin för extraktiv-abstraktiv innehållssammanfattning (EACSS)

- Abstraktiv-abstraktiv sammanfattning med hjälp av Map Reduce och Map ReRank

Det fullständiga kodexemplet finns i GitHub repo. Du kan lansera den här lösningen in Amazon SageMaker Studio.

Klicka här för att öppna AWS-konsolen och följa med.

Typer av sammanfattningar

Det finns flera tekniker för att sammanfatta text, som brett kategoriseras i två huvudsakliga tillvägagångssätt: extraktiv och abstrakt sammanfattning. Dessutom innehåller sammanfattningsmetoder på flera nivåer en serie steg, som kombinerar både extraktiva och abstrakta tekniker. Dessa tillvägagångssätt på flera nivåer är fördelaktiga när man hanterar text med tokens längre än gränsen för en LLM, vilket möjliggör förståelse av komplexa berättelser.

Extraktiv sammanfattning

Extraktiv sammanfattning är en teknik som används i NLP och textanalys för att skapa en sammanfattning genom att extrahera nyckelmeningar. Istället för att generera nya meningar eller innehåll som i abstrakt sammanfattning, bygger extraktiv sammanfattning på att identifiera och dra ut de mest relevanta och informativa delarna av originaltexten för att skapa en komprimerad version.

Extraktiv sammanfattning, även om den är fördelaktig för att bevara det ursprungliga innehållet och säkerställa hög läsbarhet genom att direkt dra viktiga meningar från källtexten, har begränsningar. Den saknar kreativitet, kan inte generera nya meningar och kan förbise nyanserade detaljer, potentiellt sakna viktig information. Dessutom kan den ge långa sammanfattningar, ibland överväldigande läsare med överdriven och oönskad information. Det finns många extraktiva summeringstekniker, som t.ex TextRank och LexRank. I det här inlägget fokuserar vi på BERT-extraktiva summeraren.

BERT extraktiv sammanfattning

Smakämnen BERT extraktiv sammanfattning är en typ av extraktiv summeringsmodell som använder BERT-språkmodellen för att extrahera de viktigaste meningarna från en text. BERTI är en förtränad språkmodell som kan finjusteras för en mängd olika uppgifter, inklusive textsammanfattning. Det fungerar genom att först bädda in meningarna i texten med BERT. Detta ger en vektorrepresentation för varje mening som fångar dess innebörd och sammanhang. Modellen använder sedan en klustringsalgoritm för att gruppera meningarna i kluster. De meningar som ligger närmast mitten av varje kluster väljs ut för att bilda sammanfattningen.

Jämfört med LLM:er är fördelen med BERT-extraktiva summeraren att det är relativt enkelt att träna och distribuera modellen och att den är mer förklarlig. Nackdelen är att sammanfattningen inte är kreativ och genererar inte meningar. Den väljer bara meningar från originaltexten. Detta begränsar dess förmåga att sammanfatta komplexa eller nyanserade texter.

Abstrakt sammanfattning

Abstrakt sammanfattning är en teknik som används i NLP och textanalys för att skapa en sammanfattning som går utöver bara extraktion av meningar eller fraser från källtexten. Istället för att välja ut och omorganisera befintligt innehåll genererar abstrakt sammanfattning nya meningar eller fraser som fångar den ursprungliga textens kärninnebörd och huvudidéer i en mer förtätad och sammanhängande form. Detta förhållningssätt kräver att modellen förstår innehållet i texten och uttrycker det på ett sätt som inte nödvändigtvis finns i källmaterialet.

Specialiserade summeringsmodeller

Dessa förtränade naturliga språkmodeller, som t.ex BART och PEGAS, är speciellt anpassade för textsammanfattningsuppgifter. De använder kodar-avkodararkitekturer och är mindre i parametrar jämfört med sina motsvarigheter. Denna reducerade storlek möjliggör enkel finjustering och distribution på mindre instanser. Det är dock viktigt att notera att dessa sammanfattningsmodeller också kommer med mindre in- och utdatatokenstorlekar. Till skillnad från sina mer generella motsvarigheter är dessa modeller exklusivt utformade för sammanfattningsuppgifter. Som ett resultat är den input som krävs för dessa modeller enbart den text som behöver sammanfattas.

Stora språkmodeller

A stor språkmodell hänvisar till vilken modell som helst som genomgår utbildning i omfattande och olika datauppsättningar, vanligtvis genom självövervakad inlärning i stor skala, och som kan finjusteras för att passa ett brett utbud av specifika nedströmsuppgifter. Dessa modeller är större i parameterstorlek och presterar bättre i uppgifter. Anmärkningsvärt är att de har betydligt större indatatokenstorlekar, vissa går upp till 100,000, såsom Anthropic's Claude. För att använda en av dessa modeller erbjuder AWS den helt hanterade tjänsten Amazon Bedrock. Om du behöver mer kontroll över modellutvecklingens livscykel kan du distribuera LLM:er genom SageMaker.

Med tanke på deras mångsidiga natur kräver dessa modeller specifika uppgiftsinstruktioner som tillhandahålls genom inmatningstext, en praxis som kallas snabb ingenjörskonst. Denna kreativa process ger varierande resultat baserat på modelltyp och inmatad text. Effektiviteten av både modellens prestanda och promptens kvalitet påverkar avsevärt den slutliga kvaliteten på modellens utdata. Följande är några tips när tekniska frågor om sammanfattningar:

- Inkludera texten för att sammanfatta – Mata in texten som behöver sammanfattas. Detta fungerar som källmaterial för sammanfattningen.

- Definiera uppgiften – Ange tydligt att målet är textsammanfattning. Till exempel, "Sammanfatta följande text: [inmatningstext]."

- Ge sammanhang – Erbjud en kort introduktion eller sammanhang för den givna texten som behöver sammanfattas. Detta hjälper modellen att förstå innehållet och sammanhanget. Till exempel, "Du får följande artikel om artificiell intelligens och dess roll i sjukvården: [input text]."

- Fråga efter sammanfattningen – Be modellen att generera en sammanfattning av den tillhandahållna texten. Var tydlig med önskad längd eller format på sammanfattningen. Till exempel, "Skapa en kortfattad sammanfattning av den givna artikeln om artificiell intelligens och dess roll i sjukvården: [inmatningstext]."

- Ställ in begränsningar eller längdriktlinjer – Valfritt kan du styra sammanfattningens längd genom att ange önskat antal ord, meningsantal eller teckengräns. Till exempel, "Skapa en sammanfattning som inte är längre än 50 ord: [inmatad text]."

Effektiv snabbteknik är avgörande för att säkerställa att de genererade sammanfattningarna är korrekta, relevanta och i linje med den avsedda sammanfattningsuppgiften. Förfina uppmaningen för optimalt sammanfattningsresultat med experiment och iterationer. När du har fastställt effektiviteten av uppmaningarna kan du återanvända dem med hjälp av snabbmallar.

Sammanfattning på flera nivåer

Extraktiva och abstrakta sammanfattningar är användbara för kortare texter. Men när den inmatade texten överskrider modellens maximala tokengräns, blir sammanfattning på flera nivåer nödvändig. Sammanfattning på flera nivåer innebär en kombination av olika sammanfattningstekniker, såsom extraktiva och abstrakta metoder, för att effektivt kondensera längre texter genom att tillämpa flera lager av sammanfattningsprocesser. I det här avsnittet diskuterar vi två sammanfattningstekniker på flera nivåer: extraktiv-abstraktiv sammanfattning och abstrakt-abstraktiv sammanfattning.

Extraktiv-abstraktiv sammanfattning

Extraktiv-abstraktiv sammanfattning fungerar genom att först generera en extraktiv sammanfattning av texten. Sedan använder den ett abstrakt sammanfattningssystem för att förfina den extraktiva sammanfattningen, vilket gör den mer koncis och informativ. Detta förbättrar noggrannheten genom att tillhandahålla mer informativa sammanfattningar jämfört med enbart utvinningsmetoder.

Strategi för extraktiv-abstraktiv sammanfattning av innehåll

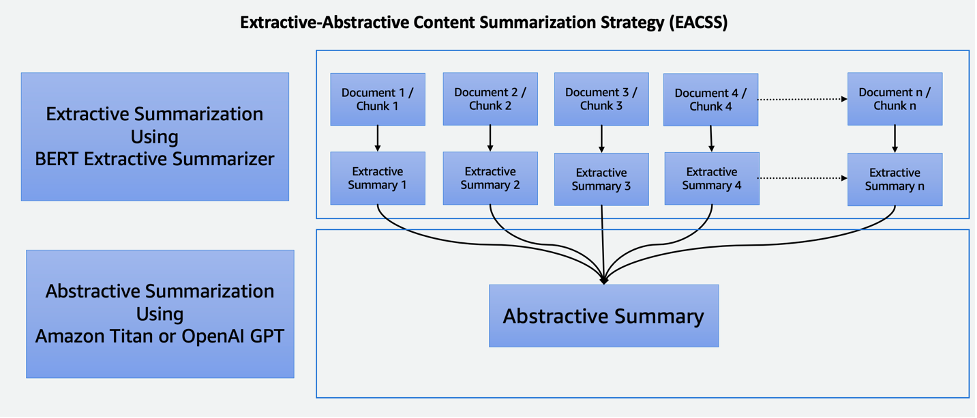

EACSS-tekniken kombinerar styrkorna hos två kraftfulla tekniker: BERT-extraktiva summeraren för den extraktiva fasen och LLMs för den abstrakta fasen, som illustreras i följande diagram.

EACSS erbjuder flera fördelar, inklusive bevarandet av viktig information, förbättrad läsbarhet och anpassningsförmåga. Att implementera EACSS är dock beräkningsmässigt dyrt och komplicerat. Det finns en risk för potentiell informationsförlust, och kvaliteten på sammanfattningen beror mycket på prestandan hos de underliggande modellerna, vilket gör att noggrant val av modell och justering är avgörande för att uppnå optimala resultat. Implementeringen inkluderar följande steg:

- Det första steget är att dela upp det stora dokumentet, till exempel en bok, i mindre sektioner, eller bitar. Dessa bitar definieras som meningar, stycken eller till och med kapitel, beroende på vilken granularitet som önskas för sammanfattningen.

- För den extraktiva fasen använder vi BERT-extraktiva summeraren. Den här komponenten fungerar genom att bädda in meningarna i varje bit och sedan använda en klustringsalgoritm för att identifiera meningar som är närmast klustrets tyngdpunkter. Detta extraherande steg hjälper till att bevara det viktigaste och mest relevanta innehållet från varje del.

- Efter att ha genererat extraktiva sammanfattningar för varje bit går vi vidare till den abstrakta sammanfattningsfasen. Här använder vi LLMs kända för sin förmåga att generera sammanhängande och kontextuellt relevanta sammanfattningar. Dessa modeller tar de extraherade sammanfattningarna som input och producerar abstrakta sammanfattningar som fångar essensen av originaldokumentet samtidigt som de säkerställer läsbarhet och koherens.

Genom att kombinera extraktiv och abstrakt sammanfattningsteknik erbjuder detta tillvägagångssätt ett effektivt och heltäckande sätt att sammanfatta långa dokument som böcker. Det säkerställer att viktig information extraheras samtidigt som det möjliggör generering av kortfattade och läsbara sammanfattningar, vilket gör det till ett värdefullt verktyg för olika tillämpningar inom området dokumentsammanfattning.

Abstraktiv-abstraktiv sammanfattning

Abstraktiv-abstraktiv summering är ett tillvägagångssätt där abstrakta metoder används för att både extrahera och generera sammanfattningar. Det erbjuder anmärkningsvärda fördelar, inklusive förbättrad läsbarhet, koherens och flexibiliteten att justera sammanfattningens längd och detaljer. Det utmärker sig i språkgenerering, vilket möjliggör omskrivning och undviker redundans. Det finns dock nackdelar. Till exempel är det beräkningsmässigt dyrt och resurskrävande, och dess kvalitet beror mycket på effektiviteten hos de underliggande modellerna, som, om de inte är vältränade eller mångsidiga, kan påverka kvaliteten på de genererade sammanfattningarna. Val av modeller är avgörande för att mildra dessa utmaningar och säkerställa abstrakta sammanfattningar av hög kvalitet. För abstrakt-abstraktiv sammanfattning diskuterar vi två strategier: Map Reduce och Map ReRank.

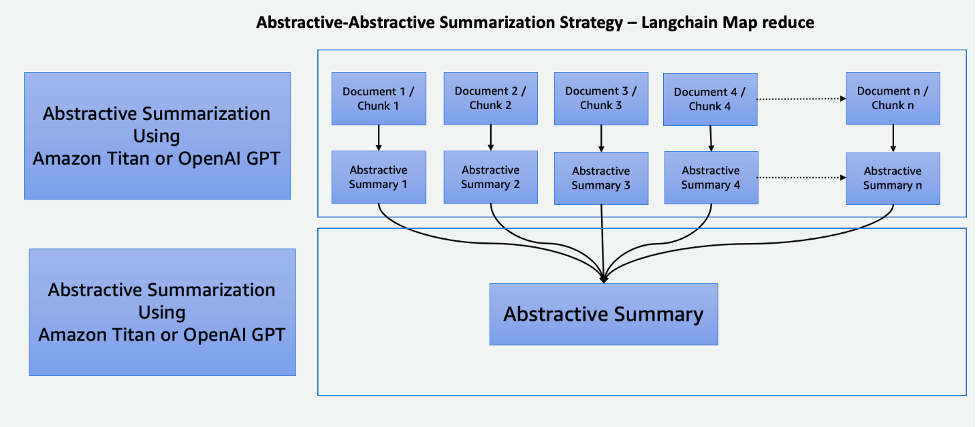

Karta Reducera med LangChain

Denna tvåstegsprocess omfattar en Kartsteg och ett Reducera steg, som illustreras i följande diagram. Den här tekniken gör att du kan sammanfatta en indata som är längre än modellens indatatokengräns.

Processen består av tre huvudsteg:

- Korporna är uppdelade i mindre bitar som passar in i LLM:s token-gräns.

- Vi använder ett kartsteg för att individuellt tillämpa en LLM-kedja som extraherar all viktig information från varje passage, och dess utdata används som en ny passage. Beroende på korpornas storlek och struktur kan detta vara i form av övergripande teman eller korta sammanfattningar.

- Reducera-steget kombinerar utdatapassagerna från kartsteget eller ett reduceringssteg så att det passar tokengränsen och matar in det i LLM. Denna process upprepas tills den slutliga utgången är en singulär passage.

Fördelen med att använda denna teknik är att den är mycket skalbar och parallelliserbar. All bearbetning i varje steg är oberoende av varandra, vilket drar fördel av distribuerade system eller serverlösa tjänster och lägre beräkningstid.

Kartlägg ReRank med LangChain

Den här kedjan kör en första uppmaning på varje dokument som inte bara försöker slutföra en uppgift utan också ger en poäng för hur säker den är i sitt svar. Det högsta poängsvaret returneras.

Denna teknik är mycket lik Map Reduce men med fördelen att den kräver färre övergripande samtal, vilket effektiviserar sammanfattningsprocessen. Men dess begränsning ligger i dess oförmåga att slå samman information över flera dokument. Denna begränsning gör den mest effektiv i scenarier där ett enda, enkelt svar förväntas från ett enskilt dokument, vilket gör det mindre lämpligt för mer komplexa eller mångfacetterade uppgifter för informationsinhämtning som involverar flera källor. Noggrant övervägande av sammanhanget och uppgifternas natur är väsentligt för att avgöra om denna metod är lämplig för specifika sammanfattningsbehov.

Cohere ReRank använder ett semantiskt baserat omrankningssystem som kontextualiserar innebörden av en användares fråga utöver nyckelordsrelevans. Den används med vektorbutikssystem såväl som nyckelordsbaserade sökmotorer, vilket ger den flexibilitet.

Jämföra summeringstekniker

Varje sammanfattningsteknik har sina egna unika fördelar och nackdelar:

- Extraktiv sammanfattning bevarar det ursprungliga innehållet och säkerställer hög läsbarhet men saknar kreativitet och kan ge långa sammanfattningar.

- Abstrakt sammanfattning, samtidigt som den erbjuder kreativitet och genererar kortfattade, flytande sammanfattningar, medför risken för oavsiktlig innehållsändring, utmaningar i språknoggrannhet och resurskrävande utveckling.

- Extraktiv-abstraktiv sammanfattning på flera nivåer sammanfattar effektivt stora dokument och ger bättre flexibilitet i att finjustera den extraktiva delen av modellerna. Det är dock dyrt, tidskrävande och saknar parallellisering, vilket gör parameterinställning utmanande.

- Abstraktiv-abstraktiv sammanfattning på flera nivåer sammanfattar också effektivt stora dokument och utmärker sig i förbättrad läsbarhet och koherens. Det är dock beräkningsmässigt dyrt och resurskrävande, och förlitar sig mycket på effektiviteten hos underliggande modeller.

Noggrant modellval är avgörande för att mildra utmaningar och säkerställa abstrakta sammanfattningar av hög kvalitet i detta tillvägagångssätt. Följande tabell sammanfattar funktionerna för varje typ av sammanfattning.

| Aspect | Extraktiv sammanfattning | Abstrakt sammanfattning | Sammanfattning på flera nivåer |

| Skapa kreativa och engagerande sammanfattningar | Nej | Ja | Ja |

| Bevara originalinnehållet | Ja | Nej | Nej |

| Balansera informationsbevarande och kreativitet | Nej | Ja | Ja |

| Lämplig för kort, objektiv text (inmatad textlängd mindre än modellens maximala tokens) | Ja | Ja | Nej |

| Effektiv för längre, komplexa dokument som böcker (inmatad textlängd som är större än modellens maximala tokens) | Nej | Nej | Ja |

| Kombinerar utvinning och innehållsgenerering | Nej | Nej | Ja |

Sammanfattningstekniker på flera nivåer är lämpliga för långa och komplexa dokument där den inmatade textlängden överskrider modellens symbolgräns. Följande tabell jämför dessa tekniker.

| Teknik | Fördelar | Nackdelar |

| EACSS (extractive-abstractive) | Bevarar avgörande information, ger möjlighet att finjustera den extraktiva delen av modellerna. | Beräkningsmässigt dyr, potentiell informationsförlust och saknar parallellisering. |

| Map Reduce (abstraktiv-abstraktiv) | Skalbar och parallelliserbar, med mindre beräkningstid. Den bästa tekniken för att skapa kreativa och kortfattade sammanfattningar. | Minnesintensiv process. |

| Map ReRank (abstraktiv-abstraktiv) | Strömlinjeformad sammanfattning med semantiskt baserad rankning. | Begränsad informationssammanslagning. |

Tips när du sammanfattar text

Tänk på följande bästa praxis när du sammanfattar text:

- Var medveten om den totala tokenstorleken – Var beredd att dela upp texten om den överskrider modellens token-gränser eller använd flera sammanfattningsnivåer när du använder LLM.

- Var medveten om typerna och antalet datakällor – Att kombinera information från flera källor kan kräva transformationer, tydlig organisation och integrationsstrategier. LangChain grejer har integration på en mängd olika datakällor och dokumenttyper. Det förenklar processen att kombinera text från olika dokument och datakällor med hjälp av denna teknik.

- Var medveten om modellspecialisering – Vissa modeller kan briljera med vissa typer av innehåll men kämpar med andra. Det kan finnas finjusterade modeller som är bättre lämpade för din textdomän.

- Använd sammanfattning på flera nivåer för stora texter – För texter som överskrider tokengränserna, överväg en sammanfattningsmetod på flera nivåer. Börja med en sammanfattning på hög nivå för att fånga huvudidéerna och sammanfatta sedan gradvis underavsnitt eller kapitel för mer detaljerade insikter.

- Sammanfatta text efter ämnen – Detta tillvägagångssätt hjälper till att upprätthålla ett logiskt flöde och minska informationsförlusten, och det prioriterar bevarandet av viktig information. Om du använder LLM:er, skapa tydliga och specifika uppmaningar som vägleder modellen att sammanfatta ett visst ämne istället för hela texten.

Slutsats

Sammanfattning står som ett viktigt verktyg i vår informationsrika era, vilket möjliggör effektiv destillering av omfattande information till kortfattade och meningsfulla former. Det spelar en avgörande roll inom olika domäner och erbjuder många fördelar. Sammanfattning sparar tid genom att snabbt förmedla väsentligt innehåll från långa dokument, underlättar beslutsfattande genom att extrahera viktig information och förbättrar förståelsen av utbildning och innehållskuration.

Det här inlägget gav en omfattande översikt över olika sammanfattningstekniker, inklusive extraktiva, abstraktiva och flernivåmetoder. Med verktyg som LangChain och språkmodeller kan du utnyttja kraften i sammanfattningar för att effektivisera kommunikationen, förbättra beslutsfattandet och frigöra den fulla potentialen hos stora informationsarkiv. Jämförelsetabellen i det här inlägget kan hjälpa dig att identifiera de mest lämpliga sammanfattningsteknikerna för dina projekt. Dessutom fungerar tipsen som delas i inlägget som värdefulla riktlinjer för att undvika upprepade fel när du experimenterar med LLM:er för textsammanfattning. Dessa praktiska råd ger dig möjlighet att tillämpa den kunskap som vunnits, vilket säkerställer framgångsrik och effektiv sammanfattning i projekten.

Referensprojekt

Om författarna

Nick Biso är en maskininlärningsingenjör på AWS Professional Services. Han löser komplexa organisatoriska och tekniska utmaningar med hjälp av datavetenskap och ingenjörskonst. Dessutom bygger och distribuerar han AI/ML-modeller på AWS-molnet. Hans passion sträcker sig till hans benägenhet för resor och olika kulturella upplevelser.

Nick Biso är en maskininlärningsingenjör på AWS Professional Services. Han löser komplexa organisatoriska och tekniska utmaningar med hjälp av datavetenskap och ingenjörskonst. Dessutom bygger och distribuerar han AI/ML-modeller på AWS-molnet. Hans passion sträcker sig till hans benägenhet för resor och olika kulturella upplevelser.

Suhas chowdary Jonnalagadda är en dataforskare på AWS Global Services. Han brinner för att hjälpa företagskunder att lösa sina mest komplexa problem med kraften i AI/ML. Han har hjälpt kunder att omvandla sina affärslösningar inom olika branscher, inklusive finans, hälsovård, bank, e-handel, media, reklam och marknadsföring.

Suhas chowdary Jonnalagadda är en dataforskare på AWS Global Services. Han brinner för att hjälpa företagskunder att lösa sina mest komplexa problem med kraften i AI/ML. Han har hjälpt kunder att omvandla sina affärslösningar inom olika branscher, inklusive finans, hälsovård, bank, e-handel, media, reklam och marknadsföring.

Tabby Ward är en huvudmolnarkitekt/strategisk teknisk rådgivare med lång erfarenhet av att migrera kunder och modernisera deras applikationsarbetsbelastning och tjänster till AWS. Med över 25 års erfarenhet av att utveckla och designa mjukvara, är hon känd för sin djupdykningsförmåga samt att hon på ett skickligt sätt förtjänar kundernas och partners förtroende för att designa arkitekturer och lösningar för flera teknikstacks och molnleverantörer.

Tabby Ward är en huvudmolnarkitekt/strategisk teknisk rådgivare med lång erfarenhet av att migrera kunder och modernisera deras applikationsarbetsbelastning och tjänster till AWS. Med över 25 års erfarenhet av att utveckla och designa mjukvara, är hon känd för sin djupdykningsförmåga samt att hon på ett skickligt sätt förtjänar kundernas och partners förtroende för att designa arkitekturer och lösningar för flera teknikstacks och molnleverantörer.

Shyam Desai är en molningenjör för big data och maskininlärningstjänster på AWS. Han stödjer big data-applikationer och kunder på företagsnivå genom att använda en kombination av expertis inom mjukvaruteknik med datavetenskap. Han har omfattande kunskaper inom datorseende och bildbehandlingsapplikationer för artificiell intelligens, såväl som biomedicinska och bioinformatiska applikationer.

Shyam Desai är en molningenjör för big data och maskininlärningstjänster på AWS. Han stödjer big data-applikationer och kunder på företagsnivå genom att använda en kombination av expertis inom mjukvaruteknik med datavetenskap. Han har omfattande kunskaper inom datorseende och bildbehandlingsapplikationer för artificiell intelligens, såväl som biomedicinska och bioinformatiska applikationer.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/techniques-for-automatic-summarization-of-documents-using-language-models/

- : har

- :är

- :inte

- :var

- 1

- 100

- 11

- 20

- 25

- 50

- 7

- 8

- 9

- a

- förmåga

- Om oss

- akademiska

- tillgänglig

- noggrannhet

- exakt

- uppnå

- tvärs

- Dessutom

- Dessutom

- framsteg

- Fördel

- fördelaktig

- fördelar

- reklam

- rådgivning

- rådgivare

- Efter

- ålder

- aggregation

- AI

- AI / ML

- AIDS

- algoritm

- Justerat

- Alla

- tillåta

- tillåter

- ensam

- längs

- också

- Även

- amason

- Amazon Web Services

- an

- analys

- och

- svara

- Antropisk

- vilken som helst

- Ansökan

- tillämpningar

- Ansök

- Tillämpa

- tillvägagångssätt

- tillvägagångssätt

- ÄR

- array

- Artikeln

- artiklar

- konstgjord

- artificiell intelligens

- AS

- At

- Automat

- undvika

- undvika

- medveten

- AWS

- AWS professionella tjänster

- Banking

- baserat

- BE

- blir

- blir

- Där vi får lov att vara utan att konstant prestera,

- BÄST

- bästa praxis

- Bättre

- Bortom

- Stor

- Stora data

- biomedicinsk

- bloggar

- organ

- kropp

- boken

- Böcker

- båda

- Ha sönder

- bred

- brett

- bygger

- företag

- men

- Knappen

- by

- Samtal

- KAN

- kapacitet

- kapabel

- fånga

- fångar

- noggrann

- Centrum

- vissa

- kedja

- utmaningar

- utmanande

- kapitel

- karaktär

- klarhet

- klar

- klart

- klick

- cloud

- kluster

- klustring

- koda

- SAMMANHÄNGANDE

- kombination

- kombinerad

- kombinerar

- kombinera

- komma

- kommer

- Kommunikation

- kompakt

- jämfört

- jämförelse

- fullborda

- komplex

- komponent

- omfattande

- innefattar

- Compute

- dator

- Datorsyn

- koncis

- villkor

- Tänk

- övervägande

- består

- Konsol

- begränsningar

- tidskrävande

- innehåll

- innehåll curation

- sammanhang

- kontroll

- Kärna

- hörnstenen

- kunde

- motsvarigheter

- farkoster

- skapa

- Kreativ

- kreativitet

- kritisk

- avgörande

- kultur

- curation

- Kunder

- datum

- datavetenskap

- datavetare

- datauppsättningar

- som handlar om

- Beslutsfattande

- beslut

- definierade

- beroende

- beror

- distribuera

- utplacering

- vecklas ut

- Designa

- utformade

- önskas

- detalj

- detaljerad

- detaljer

- Bestämma

- utveckla

- Utveckling

- olika

- direkt

- Nackdel

- diskutera

- distribueras

- distribuerade system

- flera

- dokumentera

- dokument

- inte

- domän

- domäner

- ner

- nackdelar

- varje

- tjänar

- lätta

- e-handel

- Utbildning

- Effektiv

- effektivt

- effektivitet

- effektiv

- inbäddning

- utnyttjande

- bemyndigar

- möjliggör

- möjliggör

- engagerande

- ingenjör

- Teknik

- Motorer

- förbättrad

- Förbättrar

- säkerställa

- säkerställer

- säkerställa

- Företag

- företagsnivå

- Era

- fel

- speciellt

- huvudsak

- väsentlig

- etablerade

- Även

- exempel

- överstiga

- överstiger

- excel

- överdriven

- uteslutande

- verkställande

- befintliga

- förväntat

- dyra

- erfarenhet

- Erfarenheter

- experiment

- expertis

- uttrycker

- sträcker

- omfattande

- Omfattande erfarenhet

- extrahera

- extraktion

- extrakt

- Leverans

- färre

- slutlig

- finansiering

- Förnamn

- passa

- Flexibilitet

- flöda

- Fokus

- följer

- efter

- För

- formen

- format

- former

- hittade

- från

- full

- fullständigt

- Vidare

- vunnits

- generell mening

- generera

- genereras

- genererar

- generera

- generering

- generativ

- Generativ AI

- ges

- ger

- Ge

- Välgörenhet

- Går

- kommer

- större

- Grupp

- styra

- riktlinjer

- sele

- Har

- he

- hälso-och sjukvård

- kraftigt

- hjälpa

- hjälpte

- hjälpa

- hjälper

- här

- här.

- Hög

- högnivå

- hög kvalitet

- högsta

- höggradigt

- hans

- Hur ser din drömresa ut

- Men

- html

- HTTPS

- läsbar

- idéer

- identifiera

- identifiera

- if

- Imaging

- Inverkan

- genomförande

- genomföra

- med Esport

- förbättra

- förbättra

- in

- Oförmågan

- innefattar

- Inklusive

- införliva

- oberoende

- index

- Individuellt

- industrier

- påverka

- informationen

- informativ

- informeras

- inledande

- ingång

- insikter

- istället

- instruktioner

- integrering

- Intelligens

- avsedd

- in

- Beskrivning

- ovärderlig

- investerare

- engagera

- IT

- iterationer

- DESS

- jpg

- Nyckel

- kunskap

- känd

- språk

- Large

- större

- skikt

- inlärning

- Adress

- Längd

- mindre

- nivåer

- ligger

- livscykel

- tycka om

- BEGRÄNSA

- begränsning

- begränsningar

- gränser

- LLM

- logisk

- Lång

- längre

- förlust

- lägre

- Maskinen

- maskininlärning

- Huvudsida

- bibehålla

- göra

- GÖR

- Framställning

- förvaltade

- hantera

- många

- karta

- marknad

- Marknadsföring

- Materialet

- maximal

- Maj..

- betyder

- meningsfull

- Media

- bara

- Sammanfoga

- sammanslagning

- metod

- metoder

- metoder

- migrerande

- saknas

- Mildra

- modell

- modeller

- modernisering

- mer

- Dessutom

- mest

- flytta

- mångfasetterad

- multipel

- berättelser

- Natural

- Naturlig språkbehandling

- Natur

- nödvändigtvis

- nödvändigt för

- Behöver

- behov

- Nya

- nyheter

- Nyhetsbrev

- nlp

- Nej

- anmärkningsvärd

- i synnerhet

- Notera

- roman

- antal

- talrik

- mål

- of

- erbjudanden

- erbjuda

- Erbjudanden

- on

- ONE

- endast

- öppet

- optimala

- or

- organisation

- organisatoriska

- ursprungliga

- Övriga

- Övrigt

- vår

- ut

- utfall

- produktion

- utgångar

- över

- övergripande

- övergripande

- Översikt

- överväldigande

- egen

- parameter

- parametrar

- del

- särskilt

- partner

- passagen

- brinner

- brinner

- Utföra

- prestanda

- fas

- fraser

- svängbara

- plato

- Platon Data Intelligence

- PlatonData

- spelar

- Inlägg

- potentiell

- potentiellt

- kraft

- drivs

- den mäktigaste

- Praktisk

- praktiken

- praxis

- beredd

- presentera

- Presentationer

- konservering

- konservering

- Principal

- prioriterar

- problem

- process

- processer

- bearbetning

- producera

- producerar

- professionell

- yrkesmän/kvinnor

- progressivt

- projekt

- prompter

- förutsatt

- leverantörer

- ger

- tillhandahålla

- dra

- syfte

- kvalitet

- område

- Rankning

- läsare

- erkänt

- minska

- Minskad

- avses

- hänvisar

- förfina

- relativt

- relevans

- relevanta

- förlita

- omorganisera

- upprepade

- repetitiva

- Rapport

- representation

- kräver

- Obligatorisk

- Kräver

- resurs

- Resursintensiv

- respons

- begränsning

- resultera

- Resultat

- retentionstid

- återanvända

- Risk

- Roll

- kör

- sagemaker

- sparande

- skalbar

- Skala

- scenarier

- Vetenskap

- Forskare

- göra

- poäng

- Sök

- Sökmotorer

- §

- sektioner

- vald

- väljer

- Val

- mening

- Serier

- tjänar

- Server

- serverar

- service

- Tjänster

- portion

- flera

- delas

- hon

- Kort

- signifikant

- liknande

- förenklar

- förenkla

- enda

- singularis

- ganska stor

- Storlek

- storlekar

- mindre

- Mjukvara

- mjukvaruutveckling

- enbart

- Lösningar

- LÖSA

- Löser

- några

- ibland

- Källa

- Källor

- specialiserad

- specifik

- specifikt

- delas

- Stacks

- står

- starta

- Ange

- Steg

- Steg

- lagra

- okomplicerad

- strategier

- Strategi

- effektivisera

- rationalisering

- styrkor

- struktur

- Kamp

- väsentligen

- framgångsrik

- sådana

- följer

- lämplig

- sammanfatta

- SAMMANFATTNING

- Stöder

- snabbt

- system

- System

- bord

- skräddarsydd

- Ta

- tar

- uppgift

- uppgifter

- tech

- Teknisk

- Tekniken

- tekniker

- villkor

- text

- än

- den där

- Smakämnen

- Projekten

- källan

- deras

- Dem

- teman

- sedan

- Där.

- Dessa

- de

- detta

- tre

- Genom

- tid

- Tips

- till

- token

- tokens

- verktyg

- verktyg

- ämne

- ämnen

- Totalt

- Tåg

- Utbildning

- transformationer

- omvandla

- färdas

- Litar

- trimma

- två

- Typ

- typer

- typiskt

- oförmögen

- genomgår

- underliggande

- förstå

- förståelse

- unika

- till skillnad från

- låsa

- tills

- oönskade

- användning

- Begagnade

- användningar

- med hjälp av

- utnyttja

- Värdefulla

- mängd

- olika

- varierande

- Omfattande

- mångsidig

- version

- mycket

- syn

- avgörande

- volymer

- Sätt..

- we

- webb

- webbservice

- VÄL

- när

- som

- medan

- Hela

- bred

- wikipedia

- med

- inom

- ord

- ord

- fungerar

- världen

- år

- utbyten

- Om er

- Din

- zephyrnet