Алгоритми штучного інтелекту розроблені таким чином, щоб навчатися уривчасто. Замість постійного оновлення своєї бази знань новою інформацією з часом, як це роблять люди, алгоритми можуть навчатися лише на етапі навчання. Після цього їхні знання залишаються замороженими; вони виконують завдання, для якого їх навчали, не маючи змоги продовжувати вчитися, як це роблять. Щоб навчитися хоча б одній новій речі, алгоритми повинні бути навчені знову з нуля. Це так, наче кожного разу, коли ви зустрічаєте нову людину, єдиний спосіб дізнатися її ім’я – це перезавантажити свій мозок.

Навчання з нуля може призвести до поведінки, відомої як катастрофічне забування, коли машина використовує нові знання ціною забування майже всього, що вона вже вивчила. Така ситуація виникає через те, як найпотужніші сучасні алгоритми штучного інтелекту, які називаються нейронними мережами, вивчають нові речі.

Ці алгоритми частково базуються на нашому мозку, де навчання передбачає зміну міцності зв’язків між нейронами. Але цей процес стає складним. Нейронні зв’язки також представляють минулі знання, тому їх надмірна зміна призведе до забуття.

Біологічні нейронні мережі розробили стратегії протягом сотень мільйонів років, щоб забезпечити стабільність важливої інформації. Але сьогоднішнім штучним нейронним мережам важко знайти хороший баланс між новими та старими знаннями. Їхні з’єднання надто легко перезаписуються, коли мережа бачить нові дані, що може призвести до раптової та серйозної нездатності розпізнати минулу інформацію.

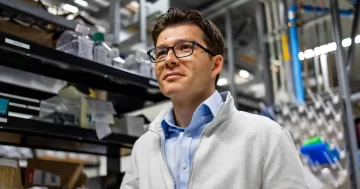

Щоб протистояти цьому, Крістофер Канан41-річний фахівець з інформатики з Університету Рочестера допоміг створити нову галузь досліджень штучного інтелекту, відому як безперервне навчання. Його мета полягає в тому, щоб ШІ продовжував вивчати нові речі з безперервних потоків даних, і робити це, не забуваючи все, що було раніше.

Майже все життя Кенан бавився з машинним інтелектом. Будучи дитиною в сільській місцевості Оклахоми, яка просто хотіла розважитися з машинами, він навчив ботів грати в ранні багатокористувацькі комп’ютерні ігри. Це змусило його задуматися про можливість загального штучного інтелекту — машини, здатної мислити як людина в усіх відношеннях. Це змусило його зацікавитися тим, як працює розум, і він отримав спеціальність філософія та інформатика в Університеті штату Оклахома, перш ніж навчання в аспірантурі привело його до Каліфорнійського університету в Сан-Дієго.

Тепер Кенан знаходить натхнення не лише у відеоіграх, а й у спостереженні за тим, як його майже 2-річна донька пізнає світ, кожне нове навчання спирається на останнє. Завдяки його та роботі інших катастрофічне забування вже не є таким катастрофічним.

Quanta поговорив із Кенаном про машинну пам’ять, порушення правил навчання нейронних мереж і чи зможе штучний інтелект коли-небудь досягти навчання на рівні людини. Інтерв’ю було скорочено та відредаговано для ясності.

Як ваше навчання філософії впливає на те, як ви думаєте про свою роботу?

Це дуже добре послужило мені як академіку. Філософія вчить вас: «Як наводити обґрунтовані аргументи» і «Як аналізувати аргументи інших?» Це багато з того, що ви робите в науці. У мене досі є есе з тих часів про невдачі тесту Тюрінга тощо. І тому я все ще багато думаю про ці речі.

Мою лабораторію надихнуло запитання: якщо ми не можемо зробити X, то як ми зможемо зробити Y? Ми вчимося з часом, але нейронні мережі, як правило, ні. Ви тренуєте їх один раз. Після цього це фіксована сутність. І це фундаментальна річ, яку вам доведеться вирішити, якщо ви захочете одного разу створити загальний штучний інтелект. Якщо він не може вчитися, не перебираючи свій мозок і не починаючи з нуля, ви насправді цього не досягнете, чи не так? Це передумова для мене.

Як дослідники досі справлялися з катастрофічним забуванням?

Найуспішніший метод, який називається відтворенням, зберігає минулий досвід, а потім відтворює його під час навчання з новими прикладами, щоб вони не були втрачені. Це натхненно консолідацією пам’яті в нашому мозку, де під час сну високорівневе кодування денної діяльності «відтворюється», коли нейрони реактивуються.

Іншими словами, для алгоритмів нове навчання не може повністю викорінити минуле навчання, оскільки ми змішуємо збережений минулий досвід.

Є три стилі для цього. Найпоширенішим стилем є «правдиве відтворення», коли дослідники зберігають підмножину необроблених вхідних даних — наприклад, оригінальні зображення для завдання розпізнавання об’єктів — а потім змішують ці збережені зображення з минулого з новими зображеннями, які потрібно вивчати. Другий підхід відтворює стислі представлення зображень. Третій набагато менш поширений метод — «генеративне відтворення». Тут штучна нейронна мережа фактично створює синтетичну версію минулого досвіду, а потім змішує цей синтетичний приклад із новими прикладами. Моя лабораторія зосередилася на двох останніх методах.

На жаль, повторне відтворення не є дуже задовільним рішенням.

Чому ні?

Щоб дізнатися щось нове, нейронна мережа повинна зберігати принаймні деяку інформацію про кожну концепцію, яку вона вивчила в минулому. І з нейронаукової точки зору, гіпотеза полягає в тому, що ми з вами відтворюємо відносно недавній досвід — не те, що сталося в нашому дитинстві — щоб запобігти забуттю цього недавнього досвіду. У той час як ми робимо це в глибоких нейронних мережах, це неправда. Він не обов’язково повинен зберігати все, що він бачив, але він повинен зберігати щось про кожне завдання, яке він дізнався в минулому, щоб використовувати відтворення. І незрозуміло, що там зберігати. Тож відтворення, як це робиться сьогодні, все ще здається, що це ще не все.

Якби ми змогли повністю вирішити проблему катастрофічного забування, чи означало б це, що штучний інтелект міг би постійно вивчати нові речі з часом?

Не зовсім. Я думаю, що великі, великі, великі відкриті питання у сфері безперервного навчання не забуті катастрофічно. Мене справді цікавить: як минуле навчання робить навчання в майбутньому ефективнішим? І як вивчення чогось у майбутньому виправляє знання минулого? Це речі, які не дуже багато людей вимірюють, і я думаю, що це є важливою частиною просування поля вперед, тому що насправді, це не просто забувати речі. Йдеться про те, щоб стати кращим учнем.

Саме там, я думаю, поля дещо не вистачає лісу замість дерев. Значна частина спільноти ставить проблему таким чином, що не відповідає ні цікавим біологічним питанням, ні цікавим інженерним застосуванням. Ми не можемо змусити всіх вічно вирішувати одну і ту ж проблему з іграшками. Ви повинні сказати: яке наше завдання? Як ми просуваємо речі вперед?

Чому тоді, на вашу думку, більшість людей зосереджуються на цих простих проблемах?

Я можу лише припускати. Більшість роботи виконується студентами, які слідкують за минулою роботою. Вони копіюють налаштування того, що зробили інші, і демонструють деякі незначні переваги в продуктивності з тими самими вимірюваннями. Створення нових алгоритмів, швидше за все, призведе до публікації, навіть якщо ці алгоритми насправді не дозволяють нам досягати значного прогресу в постійному навчанні. Що мене дивує, так це те, що така ж робота виробляється великими компаніями, які не мають однакових стимулів, за винятком роботи стажерів.

Крім того, ця робота нетривіальна. Нам потрібно встановити правильний експеримент і алгоритми, щоб визначити, чи допомагає минуле навчання майбутньому. Велика проблема полягає в тому, що зараз у нас немає хороших наборів даних для вивчення безперервного навчання. Я маю на увазі, що ми в основному беремо існуючі набори даних, які використовуються в традиційному машинному навчанні, і перепрофільовуємо їх.

По суті, згідно з догмою машинного навчання (або принаймні коли я починаю викладати машинне навчання), у нас є набір для навчання, у нас є набір для тестування — ми тренуємося на наборі для навчання, ми тестуємо на наборі для тестування. Постійне навчання порушує ці правила. Тоді ваш навчальний набір стає чимось, що розвивається, коли учень навчається. Але ми все ще обмежені наявними наборами даних. Над цим треба працювати. Нам потрібне справді гарне середовище для безперервного навчання, в якому ми можемо справді досягти успіху.

Як би виглядало ідеальне середовище безперервного навчання?

Легше сказати вам, що це не так, ніж те, що це є. Я брав участь у дискусії, де ми визначили це як критичну проблему, але я не думаю, що будь-хто відразу має відповідь.

Я можу сказати вам, які властивості він може мати. Тож поки що припустімо, що алгоритми ШІ ні втілені агенти в моделюваннях. Тоді принаймні, в ідеалі, ми вчимося на відео чи щось подібне, як мультимодальні відеопотоки, і, сподіваюся, робимо більше, ніж просто класифікацію [статичних зображень].

Є багато відкритих питань щодо цього. Кілька років тому я був на семінарі з безперервним навчанням, і деякі люди, як я, казали: «Ми повинні припинити використовувати набір даних під назвою MNIST, це надто просто». А потім хтось сказав: «Добре, давайте поетапно вивчатимемо [стратегічну відеогру] StarCraft». І зараз я теж роблю це з різних причин, але я не думаю, що це справді впливає на це. Життя набагато багатше, ніж навчитися грати в StarCraft.

Як ваша лабораторія намагалася розробити алгоритми, які можуть продовжувати навчатися з часом?

З моїм колишнім учнем Тайлером Хейзом я запровадив завдання постійного навчання для аналогічних міркувань. Ми подумали, що це було б гарною сферою для вивчення ідеї трансферного навчання, де ви отримуєте навички, а тепер вам потрібно використовувати більш складні навички для вирішення складніших проблем. Зокрема, ми виміряли зворотний перехід — наскільки добре навчання чомусь у минулому допоможе вам у майбутньому, і навпаки. І ми знайшли хороші докази для передачі, набагато важливіші, ніж для простого завдання, такого як розпізнавання об’єктів.

Ваша лабораторія також зосереджена на навчанні алгоритмів для постійного навчання з одного прикладу за раз або з дуже маленьких наборів прикладів. Як це допомагає?

Багато налаштувань постійного навчання все ще використовують дуже великі групи прикладів. Тож вони, по суті, скажуть алгоритму: «Ось 100,000 100,000 речей; вивчити їх. Ось наступні XNUMX XNUMX речей; вивчи їх». Це насправді не відповідає тому, що я б сказав, це реальна програма, яка полягає в тому, що «Ось одна нова річ; вивчити це. Ось ще одна нова річ; навчись це».

Якщо ми хочемо, щоб штучний інтелект навчався більше, як ми, чи повинні ми також прагнути відтворити те, як люди навчаються різним речам у різному віці, постійно вдосконалюючи наші знання?

Я вважаю, що це дуже плідний шлях для прогресу в цій галузі. Люди кажуть мені, що зараз, коли у мене є дитина, я просто одержимий розвитком, але я бачу, що моя донька здатна до одномоментного навчання, коли вона бачить, як я щось роблю один раз, і вона може це негайно скопіювати. А алгоритми машинного навчання нічого подібного сьогодні зробити не можуть.

Це дійсно відкрило мені очі. У наших головах має відбуватися набагато більше, ніж у наших сучасних нейронних мережах. Ось чому я вважаю, що галузь має рухатися до цієї ідеї навчання з часом, де алгоритми стають кращими для навчання, спираючись на минулий досвід.

Як ви думаєте, чи зможе штучний інтелект коли-небудь навчатися так само, як люди?

Я думаю, що вони будуть. Безумовно. Сьогодні це набагато перспективніше, тому що в цій сфері працює дуже багато людей. Але нам все одно потрібно більше креативності. Значна частина культури в спільноті машинного навчання полягає в підході слідування за лідером.

Я вважаю нас просто біохімічними машинами, і врешті-решт ми з’ясуємо, як створити наші алгоритми для правильних архітектур, які, я думаю, матимуть більше наших можливостей, ніж сьогодні. Для мене немає переконливих аргументів, які стверджують, що це неможливо.