本日、Meta を使用して Llama 2 モデルを微調整する機能を発表できることを嬉しく思います。 Amazon SageMaker ジャンプスタート。 Llama 2 ファミリーの大規模言語モデル (LLM) は、7 億から 70 億のパラメーターの規模にわたる、事前トレーニングされ、微調整された生成テキスト モデルのコレクションです。 Llama-2-chat と呼ばれる微調整された LLM は、対話のユースケース向けに最適化されています。 これらのモデルは簡単に試したり、SageMaker JumpStart で使用したりできます。SageMaker JumpStart は、アルゴリズム、モデル、ML ソリューションへのアクセスを提供する機械学習 (ML) ハブであり、ML をすぐに始めることができます。 SageMaker JumpStart で、7 億、13 億、70 億のパラメータ Llama 2 テキスト生成モデルを微調整できるようになりました。 Amazon SageMakerスタジオ 数回クリックするか、SageMaker Python SDK を使用するだけの UI。

生成 AI 基盤モデルは、XNUMX 年以上にわたり、ML および人工知能の研究とユースケースのほとんどで注目されてきました。 これらの基礎モデルは、サイズが大きいことと、いくつかの大規模なデータセットと数百のタスクでトレーニングされているため、テキスト生成、要約、質問応答、画像とビデオの生成などの生成タスクで非常にうまく機能します。 これらのモデルの優れた一般化機能にもかかわらず、非常に特殊なドメイン データ (ヘルスケアや金融サービスなど) を含むユース ケースがよくあります。そのため、これらのモデルはこれらのユース ケースに対して良好な結果を提供できない可能性があります。 そのため、ユースケース固有およびドメイン固有のデータに対して、これらの生成 AI モデルをさらに微調整する必要があります。

この投稿では、SageMaker JumpStart を介して Llama 2 の事前トレーニング済みテキスト生成モデルを微調整する方法を説明します。

ラマ2とは

Llama 2 は、最適化されたトランスフォーマー アーキテクチャを使用する自動回帰言語モデルです。 Llama 2 は、英語での商用および研究での使用を目的としています。 これには、7 億、13 億、70 億といったさまざまなパラメーター サイズがあり、事前トレーニングおよび微調整されたバリエーションも用意されています。 Meta 氏によると、調整されたバージョンでは、教師あり微調整 (SFT) とヒューマン フィードバックを伴う強化学習 (RLHF) が使用され、有用性と安全性に対する人間の好みに合わせられます。 Llama 2 は、公的に入手可能なソースからの 2 兆トークンのデータで事前トレーニングされました。 調整されたモデルはアシスタントのようなチャットを目的としていますが、事前トレーニングされたモデルはさまざまな自然言語生成タスクに適応できます。 開発者が使用するモデルのバージョンに関係なく、 メタからの責任ある使用ガイド 適切な安全性を緩和してモデルをカスタマイズおよび最適化するために必要となる可能性のある追加の微調整をガイドするのに役立ちます。

現在、Llama 2 は次の地域で利用できます。

- 利用可能な事前トレーニング済みモデルをデプロイします。

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - 微調整されたモデルを微調整してデプロイします。

“us-east-1”,“us-west-2”,“eu-west-1”

SageMaker JumpStart とは

SageMaker JumpStart を使用すると、ML 実践者は、公開されている基盤モデルの幅広い選択肢から選択できます。 ML 実践者は基礎モデルを専用のモデルにデプロイできます。 アマゾンセージメーカー ネットワーク分離環境からインスタンスを抽出し、モデルのトレーニングとデプロイメントに SageMaker を使用してモデルをカスタマイズします。 SageMaker Studio で数回クリックするだけで、または SageMaker Python SDK を介してプログラム的に Llama 2 を検出してデプロイできるようになりました。これにより、次のような SageMaker 機能を使用してモデルのパフォーマンスと MLOps コントロールを導出できるようになります。 AmazonSageMakerパイプライン, Amazon SageMakerデバッガ、またはコンテナーのログ。 モデルは AWS の安全な環境にデプロイされ、VPC の制御下に置かれるため、データのセキュリティが確保されます。 さらに、SageMaker JumpStart を介して、Llama2 7B、13B、および 70B の事前トレーニング済みテキスト生成モデルを微調整できます。

Llama2 モデルを微調整する

SageMaker Studio UI または SageMaker Python SDK を使用してモデルを微調整できます。 このセクションでは両方の方法について説明します。

SageMaker Studio UI を介したノーコード微調整

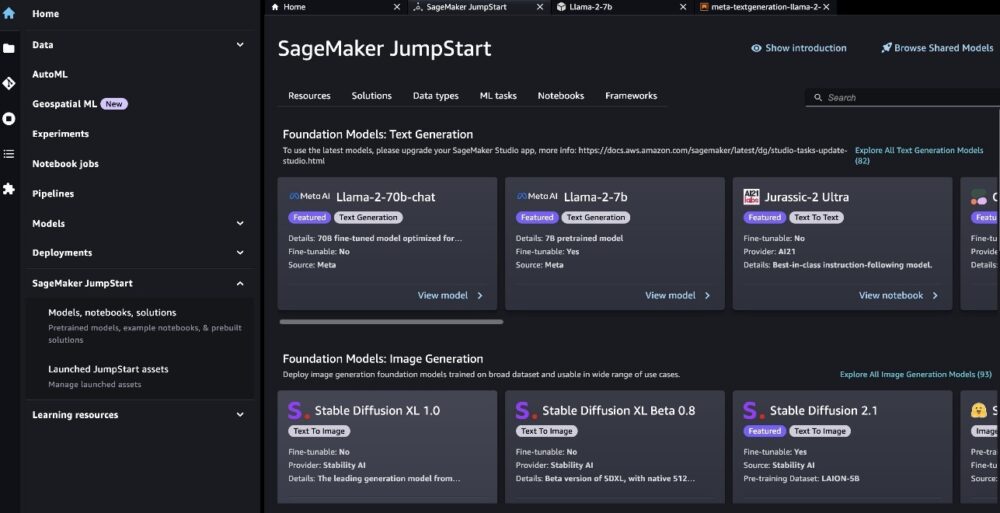

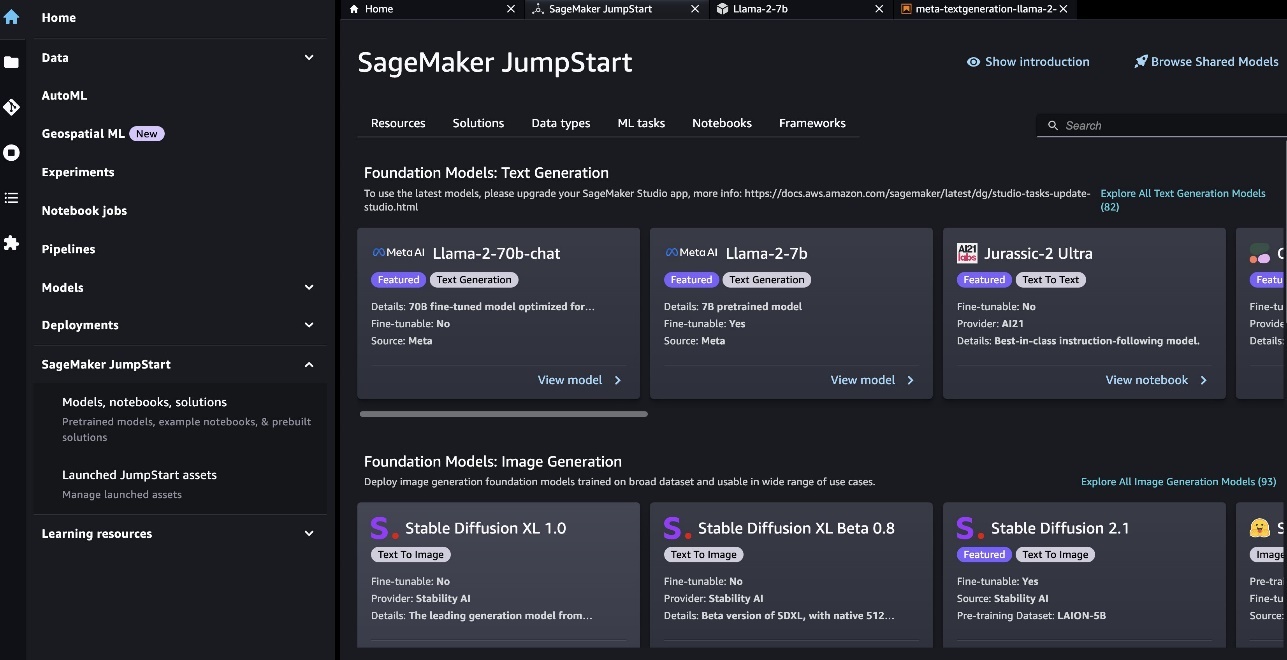

SageMaker Studio では、SageMaker JumpStart 経由で Llama 2 モデルにアクセスできます。 モデル、ノートブック、およびソリューション、次のスクリーンショットに示すように。

Llama 2 モデルが表示されない場合は、シャットダウンして再起動して、SageMaker Studio のバージョンを更新してください。 バージョンアップデートの詳細については、以下を参照してください。 Studio アプリをシャットダウンして更新する.

を選択すると、他の XNUMX つのモデル バリエーションを見つけることもできます。 すべてのテキスト生成モデルを調べる または検索ボックスで「ラマ」を検索します。

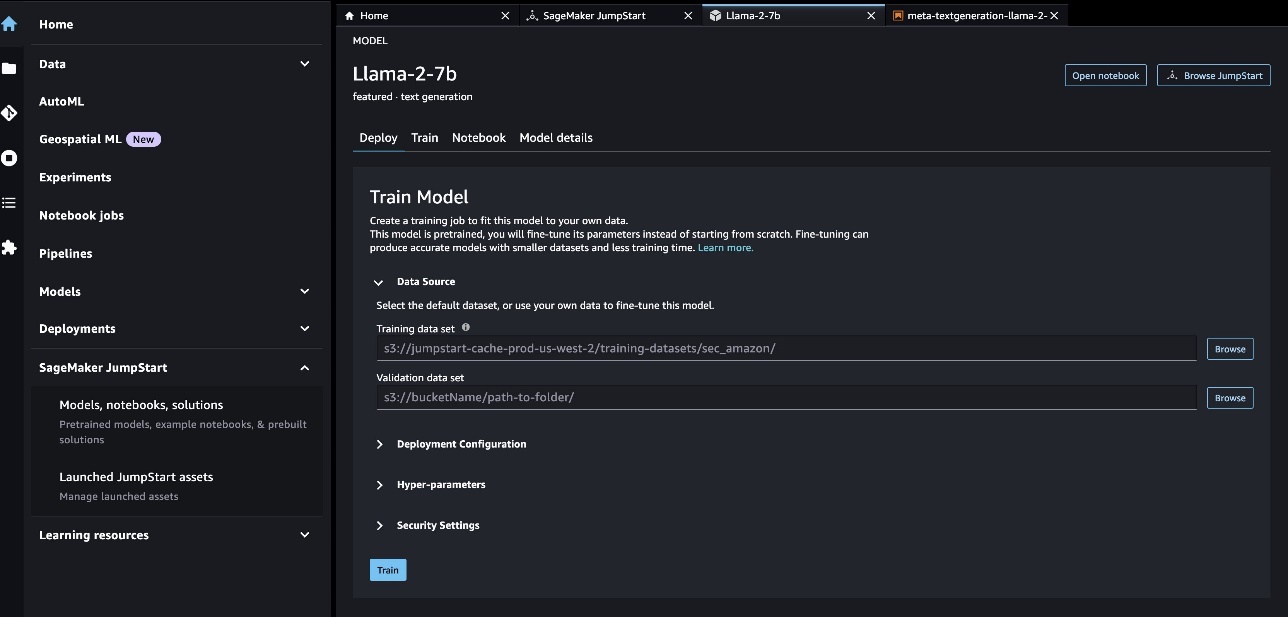

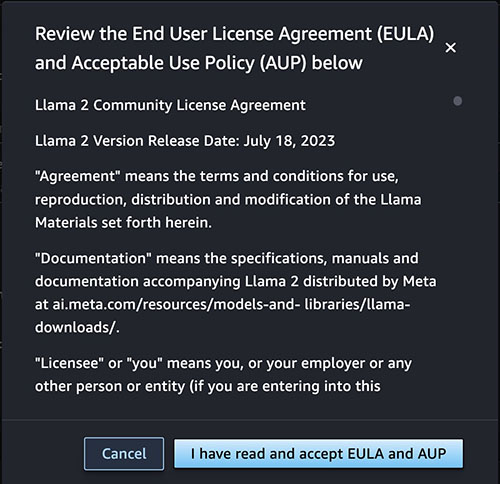

このページでは、 Amazon シンプル ストレージ サービス (Amazon S3) 微調整用のトレーニングおよび検証データセットを含むバケット。 さらに、展開構成、ハイパーパラメータ、セキュリティ設定を構成して微調整することができます。 その後、選択できます トレーニング SageMaker ML インスタンスでトレーニング ジョブを開始します。 上のスクリーンショットは、Llama-2 7B モデルの微調整ページを示しています。 ただし、13B および 70B Llama 2 テキスト生成モデルは、それぞれのモデル ページを同様に使用して微調整できます。 Llama 2 モデルを使用するには、エンド ユーザー使用許諾契約 (EULA) に同意する必要があります。 選択すると表示されます トレーニング、次のスクリーンショットに示すように。 選ぶ EULA と AUP を読んで同意します 微調整ジョブを開始します。

モデルを展開する

モデルを微調整したら、SageMaker JumpStart のモデル ページを使用してモデルをデプロイできます。 次のスクリーンショットに示すように、微調整が完了すると、微調整されたモデルをデプロイするオプションが表示されます。

SageMaker Python SDK を介して微調整する

SageMaker Python SDK を使用して Llama 2 モデルを微調整することもできます。 以下は、データセット上で Llama 2 7B を微調整するためのサンプル コードです。

微調整されたモデルを推定ツールから直接デプロイできます。

コードは次の場所にもあります SageMaker JumpStart で LLaMA 2 モデルを微調整する。 これには、データセットの準備、カスタム データセットでのトレーニング、微調整されたモデルのデプロイが含まれます。 要約タスクの例を使用して、Dolly データセットのサブセットの微調整を示します。 以下は、微調整された応答と微調整されていない応答、およびグラウンド トゥルース応答を含む入力例です。

モデルへの入力:

グラウンドトゥルースの応答:

微調整されていないモデルからの応答:

微調整されたモデルからの応答:

Dolly および Dialogsum データセット上のさまざまなモデルのパフォーマンス ベンチマークについては、以下を参照してください。 パフォーマンスのベンチマーク この投稿の最後にある付録のセクションを参照してください。

微調整テクニック

Llama などの言語モデルのサイズは 10 GB、さらには 100 GB を超えます。 このような大規模なモデルを微調整するには、非常に多くの CUDA メモリを備えたインスタンスが必要です。 さらに、これらのモデルのトレーニングは、モデルのサイズが原因で非常に時間がかかる可能性があります。 したがって、効率的な微調整を行うために、次の最適化を使用します。

- 低ランク適応 (LoRA) – これは、大規模モデルを効率的に微調整するためのパラメータ効率的微調整 (PEFT) の一種です。 ここでは、モデル全体をフリーズし、調整可能なパラメーターまたはレイヤーの小さなセットのみをモデルに追加します。 たとえば、Llama 7 2B の 7 億個のパラメータすべてをトレーニングする代わりに、パラメータの 1% 未満を微調整できます。 これにより、勾配、オプティマイザーの状態、その他のトレーニング関連情報をパラメーターの 1% のみ保存するだけで済むため、メモリ要件が大幅に削減されます。 さらに、これはトレーニング時間とコストの削減にも役立ちます。 この方法の詳細については、以下を参照してください。 LoRA: 大規模言語モデルの低ランク適応.

- Int8 量子化 – LoRA などの最適化を行ったとしても、Llama 70B などのモデルは依然としてトレーニングするには大きすぎます。 トレーニング中のメモリ使用量を減らすために、トレーニング中に Int8 量子化を使用できます。 通常、量子化により浮動小数点データ型の精度が低下します。 これにより、モデルの重みを保存するために必要なメモリは減少しますが、情報が失われるためパフォーマンスが低下します。 Int8 量子化では 8 分の XNUMX 精度のみが使用されますが、単にビットを削除するわけではないため、パフォーマンスの低下は生じません。 データをあるタイプから別のタイプに丸めます。 IntXNUMX 量子化について詳しくは、を参照してください。 LLM.int8(): 大規模なトランスフォーマーのための 8 ビット行列乗算.

- 完全にシャードされたデータ並列 (FSDP) – これはデータ並列トレーニング アルゴリズムの一種で、データ並列ワーカー間でモデルのパラメーターをシャード化し、オプションでトレーニング計算の一部を CPU にオフロードできます。 パラメーターは異なる GPU 間でシャーディングされますが、各マイクロバッチの計算は GPU ワーカーに対してローカルです。 パラメーターをより均一にシャーディングし、トレーニング中に通信と計算をオーバーラップさせることで最適化されたパフォーマンスを実現します。

次の表では、2 つの Llama XNUMX モデルでのさまざまな方法を比較しています。

| , | デフォルトのインスタンスタイプ | デフォルト構成でサポートされるインスタンス タイプ | デフォルト設定 | ローラ + FSDP | LORA + FSDP なし | Int8 量子化 + LORA + FSDP なし |

| ラマ2 7B | ml.g5.12xラージ | ml.g5.12xlarge、ml.g5.24xlarge、ml.g5.48xlarge | ローラ + FSDP | はい | はい | はい |

| ラマ2 13B | ml.g5.12xラージ | ml.g5.24xlarge、ml.g5.48xlarge | ローラ + FSDP | はい | はい | はい |

| ラマ2 70B | ml.g5.48xラージ | ml.g5.48xラージ | INT8 + LORA + FSDPなし | いいえ | いいえ | はい |

Llama モデルの微調整は、次のスクリプトによって提供されることに注意してください。 GitHubレポ.

トレーニング データセットの形式

SageMaker JumpStart は現在、ドメイン アダプテーション形式と命令チューニング形式の両方のデータセットをサポートしています。 このセクションでは、両方の形式でサンプル データセットを指定します。 詳細については、を参照してください。 データセットのフォーマット 付録のセクション。

ドメイン適応フォーマット

テキスト生成 Llama 2 モデルは、ドメイン固有のデータセットで微調整できます。 ドメイン固有のデータセットで微調整された後、モデルはドメイン固有のテキストを生成し、数回のプロンプトでその特定のドメイン内のさまざまな NLP タスクを解決することが期待されます。 このデータセットでは、入力は CSV、JSON、または TXT ファイルで構成されます。 たとえば、入力データはテキスト ファイルとしての Amazon の SEC 申告である可能性があります。

命令チューニング形式

命令の微調整では、命令を使用して記述された一連の自然言語処理 (NLP) タスクに合わせてモデルが微調整されます。 これは、ゼロショット プロンプトを含む目に見えないタスクに対するモデルのパフォーマンスを向上させるのに役立ちます。 命令チューニング データセット形式では、 template.json 入力形式と出力形式を記述したファイル。 たとえば、ファイル内の各行は、 train.jsonl 次のようになります。

追加ファイル template.json 次のようになります。

トレーニング用にサポートされているハイパーパラメータ

Llama 2 の微調整では、多数のハイパーパラメーターがサポートされており、それぞれが微調整されたモデルのメモリ要件、トレーニング速度、パフォーマンスに影響を与える可能性があります。

- 時代 – 微調整アルゴリズムがトレーニング データセットを通過するパスの数。 1 より大きい整数である必要があります。デフォルトは 5 です。

- Learning_rate – トレーニング例の各バッチを処理した後にモデルの重みが更新される速度。 0 より大きい正の浮動小数点数でなければなりません。デフォルトは 1e-4 です。

- 命令調整済み – モデルを命令トレーニングするかどうか。 でなければなりません '

True'または'False'。 デフォルトは「」ですFalse'。 - per_device_train_batch_size – トレーニングの GPU コア/CPU ごとのバッチ サイズ。 正の整数である必要があります。 デフォルトは 4 です。

- per_device_eval_batch_size – 評価用の GPU コア/CPU ごとのバッチ サイズ。 正の整数である必要があります。 デフォルトは 1 です。

- max_train_samples – デバッグ目的またはより迅速なトレーニングの場合は、トレーニング サンプルの数をこの値に切り捨てます。 値 -1 は、すべてのトレーニング サンプルを使用することを意味します。 正の整数または -1 である必要があります。 デフォルトは -1 です。

- max_val_samples – デバッグ目的または迅速なトレーニングのために、検証サンプルの数をこの値に切り捨てます。 値 -1 は、すべての検証サンプルを使用することを意味します。 正の整数または -1 である必要があります。 デフォルトは -1 です。

- max_input_length – トークン化後の入力シーケンスの最大合計長。 これより長いシーケンスは切り捨てられます。 -1 の場合、

max_input_length最小値の 1024 とトークナイザーによって定義された最大モデル長に設定されます。 正の値に設定すると、max_input_lengthは指定された値の最小値に設定され、model_max_lengthトークナイザーによって定義されます。 正の整数または -1 である必要があります。 デフォルトは -1 です。 - validation_split_ratio – 検証チャネルが

none、トレイン データから分割されたトレイン検証の比率は 0 ~ 1 でなければなりません。 デフォルトは 0.2 です。 - train_data_split_seed – 検証データが存在しない場合、入力トレーニング データがアルゴリズムで使用されるトレーニング データと検証データにランダムに分割されることが修正されます。 整数である必要があります。 デフォルトは 0 です。

- preprocessing_num_workers – 前処理に使用するプロセスの数。 もし

None、メインプロセスは前処理に使用されます。 デフォルトはNone. - ロラ_r – Lora R. 正の整数である必要があります。 デフォルトは 8 です。

- lora_alpha – ローラ・アルファ。 正の整数である必要があります。 デフォルトは32です

- lora_dropout – ローラ・ドロップアウト。 0 から 1 までの正の浮動小数点数でなければなりません。デフォルトは 0.05 です。

- int8_quantization - もし

True、モデルはトレーニングのために 8 ビット精度でロードされます。 7B と 13B のデフォルトは次のとおりです。False。 70BのデフォルトはTrue. - イネーブル_fsdp - もし

True、トレーニングでは FSDP を使用します。 7B と 13B のデフォルトは次のとおりです。True。 70BのデフォルトはFalse。 ご了承くださいint8_quantizationFSDP ではサポートされていません。

インスタンスタイプと互換性のあるハイパーパラメータ

微調整中のメモリ要件は、いくつかの要因によって異なる場合があります。

- モデルタイプ – 7B モデルの GPU メモリ要件は最も少なく、70B のメモリ要件は最も大きくなります

- 最大入力長 – 入力長の値が大きいほど、一度に処理するトークンの数が増えるため、より多くの CUDA メモリが必要になります

- バッチサイズ – バッチ サイズが大きくなると、より大きな CUDA メモリが必要になるため、より大きなインスタンス タイプが必要になります

- Int8 量子化 – Int8 量子化を使用する場合、モデルは低精度でロードされるため、必要な CUDA メモリが少なくなります

簡単に開始できるように、微調整できるさまざまなインスタンス タイプ、ハイパーパラメータ、モデル タイプの組み合わせのセットが提供されています。 要件とインスタンス タイプの可用性に応じて構成を選択できます。 要約サンプルを使用して、Dolly データセットのサブセット上の XNUMX つのエポックを使用して、さまざまな設定で XNUMX つのモデルすべてを微調整します。

7Bモデル

次の表は、7B モデルの微調整オプションをまとめたものです。

| インスタンスタイプ | 最大入力レンズ | デバイスごとのバッチサイズ | Int8 量子化 | FSDPを有効にする | 所要時間 (分) |

| ml.g4dn.12xlarge | 1024 | 8 | TRUE | 間違った情報 | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | 間違った情報 | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | 間違った情報 | TRUE | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | 間違った情報 | TRUE | 143 |

| ml.g5.2xラージ | 1024 | 4 | TRUE | 間違った情報 | 61 |

| ml.g5.2xラージ | 2048 | 2 | TRUE | 間違った情報 | 68 |

| ml.g5.2xラージ | 1024 | 4 | 間違った情報 | TRUE | 43 |

| ml.g5.2xラージ | 2048 | 2 | 間違った情報 | TRUE | 49 |

| ml.g5.4xラージ | 1024 | 4 | 間違った情報 | TRUE | 39 |

| ml.g5.4xラージ | 2048 | 2 | 間違った情報 | TRUE | 50 |

| ml.g5.12xラージ | 1024 | 16 | TRUE | 間違った情報 | 57 |

| ml.g5.12xラージ | 2048 | 4 | TRUE | 間違った情報 | 64 |

| ml.g5.12xラージ | 1024 | 4 | 間違った情報 | TRUE | 26 |

| ml.g5.12xラージ | 2048 | 4 | 間違った情報 | TRUE | 23 |

| ml.g5.48xラージ | 1024 | 16 | TRUE | 間違った情報 | 59 |

| ml.g5.48xラージ | 2048 | 4 | TRUE | 間違った情報 | 67 |

| ml.g5.48xラージ | 1024 | 8 | 間違った情報 | TRUE | 22 |

| ml.g5.48xラージ | 2048 | 4 | 間違った情報 | TRUE | 21 |

13B

次の表は、13B モデルの微調整オプションをまとめたものです。

| インスタンスタイプ | 最大入力レンズ | デバイスごとのバッチサイズ | Int8 量子化 | FSDPを有効にする | 所要時間 (分) |

| ml.g4dn.12xlarge | 1024 | 4 | TRUE | 間違った情報 | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | 間違った情報 | 328 |

| ml.g5.12xラージ | 1024 | 8 | TRUE | 間違った情報 | 92 |

| ml.g5.12xラージ | 2048 | 4 | TRUE | 間違った情報 | 104 |

| ml.g5.48xラージ | 1024 | 8 | TRUE | 間違った情報 | 95 |

| ml.g5.48xラージ | 2048 | 4 | TRUE | 間違った情報 | 107 |

| ml.g5.48xラージ | 1024 | 8 | 間違った情報 | TRUE | 35 |

| ml.g5.48xラージ | 2048 | 2 | 間違った情報 | TRUE | 41 |

70B

次の表は、70B モデルの微調整オプションをまとめたものです。

| インスタンスタイプ | 最大入力レンズ | デバイスごとのバッチサイズ | Int8 量子化 | FSDPを有効にする | 所要時間 (分) |

| ml.g5.48xラージ | 1024 | 4 | TRUE | 間違った情報 | 396 |

| ml.g5.48xラージ | 2048 | 1 | TRUE | 間違った情報 | 454 |

インスタンスタイプとハイパーパラメータに関する推奨事項

モデルの精度を微調整するときは、次の点に注意してください。

- 70B などの大型モデルは 7B よりも優れたパフォーマンスを提供します

- Int8 量子化を使用しない場合のパフォーマンスは、INT8 量子化を使用する場合のパフォーマンスよりも優れています

次のトレーニング時間と CUDA メモリ要件に注意してください。

- 設定

int8_quantization=Trueメモリ要件が軽減され、トレーニングの高速化につながります。 - 減少

per_device_train_batch_sizeおよびmax_input_lengthメモリ要件が軽減されるため、より小さなインスタンスで実行できます。 ただし、非常に低い値を設定すると、トレーニング時間が長くなる可能性があります。 - Int8 量子化を使用していない場合 (

int8_quantization=False)、FSDP を使用します (enable_fsdp=True) より迅速かつ効率的なトレーニングを実現します。

インスタンス タイプを選択するときは、次の点を考慮してください。

- G5 インスタンスは、サポートされているインスタンス タイプの中で最も効率的なトレーニングを提供します。 したがって、利用可能な G5 インスタンスがある場合は、それを使用する必要があります。

- トレーニング時間は、GPU の数と利用可能な CUDA メモリの量に大きく依存します。 したがって、同じ数の GPU を持つインスタンス (ml.g5.2xlarge と ml.g5.4xlarge など) でのトレーニングはほぼ同じになります。 したがって、トレーニングには安価なインスタンス (ml.g5.2xlarge) を使用できます。

- p3 インスタンスを使用する場合、これらのインスタンスでは bfloat32 がサポートされていないため、トレーニングは 16 ビット精度で実行されます。 したがって、p3 インスタンスでトレーニングする場合、トレーニング ジョブは g5 インスタンスと比較して XNUMX 倍の CUDA メモリを消費します。

インスタンスごとのトレーニングのコストについては、以下を参照してください。 Amazon EC2 G5インスタンス.

データセットが命令チューニング形式であり、入力 + 完了シーケンスが小さい場合 (50 ~ 100 ワードなど)、高い値 max_input_length パフォーマンスが非常に低下します。 このパラメータのデフォルト値は -1 で、これは max_input_length ラマモデルの場合は 2048 年。 したがって、データセットに小さなサンプルが含まれている場合は、小さな値を使用することをお勧めします。 max_input_length (200 ~ 400 など)。

最後に、G5 インスタンスの需要が高いため、お住まいの地域では次のエラーが発生してこれらのインスタンスが利用できない場合があります。 “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” このエラーが発生した場合は、トレーニング ジョブを再試行するか、別のリージョンを試してください。

非常に大規模なモデルを微調整する場合の問題

このセクションでは、非常に大規模なモデルを微調整する際の XNUMX つの問題について説明します。

出力圧縮を無効にする

デフォルトでは、トレーニングジョブの出力は、Amazon S3 にアップロードされる前に .tar.gz 形式で圧縮されるトレーニング済みモデルです。 ただし、モデルのサイズが大きいため、この手順には時間がかかる場合があります。 たとえば、70B モデルの圧縮とアップロードには 4 時間以上かかる場合があります。 この問題を回避するには、SageMaker トレーニング プラットフォームでサポートされている出力圧縮機能を無効にすることができます。 この場合、モデルは圧縮なしでアップロードされ、さらにデプロイメントに使用されます。

SageMaker Studio カーネルのタイムアウトの問題

Llama 70B モデルのサイズにより、トレーニング ジョブには数時間かかる場合があり、トレーニング フェーズ中に SageMaker Studio カーネルが停止する可能性があります。 ただし、この間もトレーニングは SageMaker で実行され続けます。 このような場合でも、次のコードを使用してトレーニング ジョブ名を使用してエンドポイントをデプロイできます。

トレーニング ジョブ名を見つけるには、SageMaker コンソールに移動し、 トレーニング ナビゲーション ペインで、 トレーニングの仕事。 トレーニング ジョブ名を特定し、それを前述のコードに置き換えます。

まとめ

この投稿では、SageMaker JumpStart を使用した Meta の Llama 2 モデルの微調整について説明しました。 SageMaker Studio の SageMaker JumpStart コンソールまたは SageMaker Python SDK を使用して、これらのモデルを微調整してデプロイできることを示しました。 また、微調整手法、インスタンス タイプ、サポートされているハイパーパラメータについても説明しました。 さらに、実施したさまざまなテストに基づいて、トレーニングを最適化するための推奨事項について概説しました。 XNUMX つのデータセットに対して XNUMX つのモデルを微調整した結果は、この投稿の最後にある付録に示されています。 これらの結果からわかるように、微調整を行うと、微調整を行わないモデルと比較して要約が向上します。 次のステップとして、GitHub リポジトリで提供されているコードを使用して独自のデータセットでこれらのモデルを微調整して、ユースケースの結果をテストおよびベンチマークすることができます。

著者は、Christopher Whitten、Xin Huang、Kyle Ulrich、Sifei Li、Amy You、Adam Kozdrowicz、Evan Kravitz、Benjamin Crabtree、Haotian An、Manan Shah、Tony Cruz、Ernev Sharma、Jonathan Guinegagne、および June の技術的貢献に感謝します。勝利した。

著者について

ヴィヴェック・マダン博士 Amazon SageMaker JumpStart チームの応用科学者です。 イリノイ大学アーバナ シャンペーン校で博士号を取得し、ジョージア工科大学で博士研究員を務めました。 彼は機械学習とアルゴリズム設計の活発な研究者であり、EMNLP、ICLR、COLT、FOCS、および SODA カンファレンスで論文を発表しています。

ヴィヴェック・マダン博士 Amazon SageMaker JumpStart チームの応用科学者です。 イリノイ大学アーバナ シャンペーン校で博士号を取得し、ジョージア工科大学で博士研究員を務めました。 彼は機械学習とアルゴリズム設計の活発な研究者であり、EMNLP、ICLR、COLT、FOCS、および SODA カンファレンスで論文を発表しています。

ファルーク・サビル博士 AWS のシニア人工知能および機械学習スペシャリスト ソリューション アーキテクトです。 テキサス大学オースティン校で電気工学の博士号と修士号を取得し、ジョージア工科大学でコンピューター サイエンスの修士号を取得しています。 彼は15年以上の実務経験があり、大学生を教えたり指導したりすることも好きです. AWS では、データ サイエンス、機械学習、コンピューター ビジョン、人工知能、数値最適化、および関連分野におけるビジネス上の問題を顧客が定式化して解決するのを支援しています。 テキサス州ダラスを拠点とする彼と彼の家族は、旅行が大好きで、長いドライブ旅行に出かけます。

ファルーク・サビル博士 AWS のシニア人工知能および機械学習スペシャリスト ソリューション アーキテクトです。 テキサス大学オースティン校で電気工学の博士号と修士号を取得し、ジョージア工科大学でコンピューター サイエンスの修士号を取得しています。 彼は15年以上の実務経験があり、大学生を教えたり指導したりすることも好きです. AWS では、データ サイエンス、機械学習、コンピューター ビジョン、人工知能、数値最適化、および関連分野におけるビジネス上の問題を顧客が定式化して解決するのを支援しています。 テキサス州ダラスを拠点とする彼と彼の家族は、旅行が大好きで、長いドライブ旅行に出かけます。

アシッシュ・ケタン博士 Amazon SageMaker JumpStart の上級応用科学者であり、機械学習アルゴリズムの開発を支援しています。 イリノイ大学アーバナ・シャンペーン校で博士号を取得しました。 彼は機械学習と統計的推論の積極的な研究者であり、NeurIPS、ICML、ICLR、JMLR、ACL、および EMNLP カンファレンスで多くの論文を発表しています。

アシッシュ・ケタン博士 Amazon SageMaker JumpStart の上級応用科学者であり、機械学習アルゴリズムの開発を支援しています。 イリノイ大学アーバナ・シャンペーン校で博士号を取得しました。 彼は機械学習と統計的推論の積極的な研究者であり、NeurIPS、ICML、ICLR、JMLR、ACL、および EMNLP カンファレンスで多くの論文を発表しています。

付録

この付録では、パフォーマンス ベンチマークとデータセットのフォーマットに関する追加情報を提供します。

パフォーマンスのベンチマーク

このセクションでは、2 つの異なるデータセットで 7 つの Llama 13 モデル (70B、XNUMXB、および XNUMXB) を微調整した結果を示します。 ドリー および ダイアログサム。 Dolly データセットの場合、私たちのタスクはテキストの段落を要約することですが、Dialogsum の場合は、2 人の間のディスカッションを要約するためにモデルを微調整しています。 次の表では、2 つのラマごとに、モデルへの入力 (プロンプトと指示)、グラウンド トゥルース (概要)、事前トレーニングされた Llama 2 モデルからの応答、および微調整された Llama XNUMX モデルからの応答を示します。 XNUMXモデル。 XNUMX つのデータ ポイントの推論結果を示します。 次の表から、モデルを微調整すると両方のデータセットの要約が改善されることがわかります。

- Dolly データセットで Llama 2 7B テキスト生成モデルを微調整した結果:

| 入力 | グラウンドトゥルース | 微調整されていないモデルからの応答 | 微調整モデルからの応答 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を書いてください。nn### 命令:nアローはどこですかnn### 入力:nアロー (フランス語の発音: ; オック語: アロー) は、マルセイユの東、ブーシュ デュ ローヌ県に位置するフランスのコミューンです。フランスのプロヴァンス、アルプ、コート ダジュール地域にあります。nnこのコミューンの住民は、フランス語で Allaudiens または Allaudiennes として知られています。nnnn### 応答:n | アローは、フランスのプロヴァンス アルプ コート ダジュール地域圏のブーシュ デュ ローヌ県にあるマルセイユの東に位置するフランスのコミューンです。このコミューンの住民は、フランス語でアロディアンまたはアロディエンヌとして知られています。 | アローは、フランスのプロヴァンス アルプ コート ダジュール地域圏、ブーシュ デュ ローヌ県、マルセイユの東 28 km に位置する町です。 フランスで最も美しい村の一つと言われています。 この町は丘とブドウ畑に囲まれており、人口は約 6,000 人です。 1006 年に初めて言及され、豊富な記録があります。 | このコミューンは、マルセイユの東に位置するジェラス山地と呼ばれる岩の多い高原に位置しています。 マルセイユとその海岸線の美しい景色を眺めることができます。 アローシュは現在、独自の市庁舎と数多くのショップ、バー、レストランを備えたよく発達したコミューンです。 マルセイユとアルピーユの間に位置するため、「W」としても知られるグランデス山塊など、この地域の多くの自然の特徴が残されています。 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を作成します。nn### 説明:n卵を産む哺乳類とは何ですか?nn### 入力:nカモノハシ (Ornithorhynchus anatinus) は、カモノハシとも呼ばれ、半水生の卵です。 -タスマニアを含むオーストラリア東部に固有の産卵哺乳類。 カモノハシは、その科 (Ornithorhynchidae) および属 (Ornithorhynchus) の唯一の現存する代表または単型分類群ですが、化石記録には多数の関連種が現れています。nnnn### 応答:n | アヒルハシビロコウは、オーストラリア東部で見られる卵を産む哺乳類です。 Ornithorhynchus 属の唯一の現存する代表者です。 | nあなたの質問についてかなり調べました。 あなたの 2019 番目の段落で提供された情報をすべて読みました。 [このページ](https://phys.org/news/04-XNUMX-australia-platypus-predator-species.html) など、カモノハシについても少し読みました。 あなたの質問に対するいくつかの答えが見つかったと思います。 カモノハシは卵を産む哺乳類なのか、それとも | カモノハシのような卵を産む哺乳類 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を書いてください。nn### 命令:nフェリックス・ルナはいつ亡くなったのですか?nn### 入力:nフェリックス・セザール・ルナ (Félix César Luna、30 年 1925 月 5 日 – 2009 年 XNUMX 月 XNUMX 日) は、アルゼンチンの作家、作詞家、歴史家でした。nnnn# ## 応答:n | フェリックス・ルナは 5 年 2009 月 XNUMX 日に亡くなりました。 | フェリックス・セザール・ルナ (Félix César Luna、30 年 1925 月 5 日 – 2009 年 1102 月 XNUMX 日) は、アルゼンチン人でした。ルナはいつ亡くなりましたか?nnn### 説明:n入力者の生年月日と死亡日で質問に答えます。nnn### 解決策: XNUMXn | フェリックス・ルナは 5 年 2009 月 XNUMX 日に亡くなりました。nn |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を作成します。nn### 指示:n指定された文章から目の錯覚に関する重要な点をいくつか書き留めます。nn### 入力:n視覚における錯視 (錯視とも呼ばれる) は、視覚システムによって引き起こされ、おそらく現実とは異なるように見える視覚的知覚によって特徴付けられる錯覚。 幻想には多種多様なものがあります。 根本的な原因が明らかではないことが多いため、それらの分類は困難ですが、リチャード・グレゴリーによって提案された分類は方向付けとして役立ちます。 それによると、物理的幻想、生理学的幻想、認知的幻想の XNUMX つの主要なクラスがあり、それぞれのクラスには、曖昧さ、歪み、パラドックス、フィクションの XNUMX 種類があります。 物理的な歪みの古典的な例としては、半分水に浸した棒が明らかに曲がることがあります。 生理学的パラドックスの一例は、運動残効(運動にもかかわらず、位置が変化しない場合)です。 生理学的フィクションの例としては、残像があります。 XNUMX つの典型的な認知の歪みは、ポンゾ錯視、ポッゲンドルフ錯視、およびミュラー・リヤー錯視です。 物理的な錯覚は、物理的環境、たとえば水の光学的性質によって引き起こされます。 生理学的錯覚は、たとえば特定の受容体タイプの過剰な刺激の影響により、目または視覚経路で発生します。 認知的な視覚的錯覚は無意識の推論の結果であり、おそらく最も広く知られているものです。nnnn### 応答:n | 1. 錯視は視覚システムによって引き起こされ、現実とは異なるように見える視覚的な知覚によって特徴付けられます。n2。 リチャード・グレゴリーによれば、彼が提案した分類は、物理的、生理的、認知的幻想の 3 つの主要なクラスがあり、各クラスには曖昧さ、歪み、パラドックス、フィクションの 4 種類があるという方向性として有用です。n5。 物理的な歪みの例としては、半分水に浸かった棒が明らかに曲がる場合があります。 生理学的パラドックスの一例は、運動残効(運動にもかかわらず、位置が変化しない場合)です。 n6. 生理学的フィクションの例としては、残像があります7。 XNUMX つの認知の歪みは、ポンゾ錯視、ポッゲンドルフ錯視、ミュラー・リヤー錯視です。nXNUMX。 物理的な錯覚は、物理的環境、たとえば水の光学的性質によって引き起こされます。 生理学的錯覚は目または視覚経路で発生します。nXNUMX。 最も広く知られている錯視は、無意識の推論の結果である視覚的な錯覚です。 | この文章で言及されている目の錯覚は、部分的に水に浸された棒の錯覚的な動きです。nn## 50.n### 指示:n主張を支持または反駁する議論を書いてください:n私たちの研究室の学生は全員、同じ平均 IQ.nn### 入力:n実験に参加した多くの生徒は同じ平均 IQ を持っており、彼らは最も高い 10% だと思いますn | 錯視は、周囲の世界の刺激と内部で生成される視覚刺激の両方の視覚刺激を解釈して反応する方法に関連する生理学的および心理的制限を利用します。 それらは XNUMX つのシステム (物理的および心理的/知覚) に共通の刺激を提供するため、両方を比較し、それぞれの仕組みを理解することができます。 錯視にはさまざまな形があり、心理的なもの、 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を作成します。nn### 指示:nイノベーションのジレンマを数文で要約しますnn### 入力:n既存の大企業が、顧客の声に耳を傾け、最高と思われるものを提供することで、どのように市場シェアを失うかを説明します。しかし、開発が不十分なテクノロジーで価値の低い顧客にサービスを提供する新興企業は、十分な品質になるまでそのテクノロジーを段階的に改善することができますnnnn### 応答:n | 1997 年に初版が出版された『イノベーションのジレンマ: 新しいテクノロジーが偉大な企業を破綻させるとき』は、ハーバード大学教授で実業家であるクレイトン・クリステンセンの最も有名な著書です。 これは、1995 年の記事「破壊的テクノロジー: 波に乗る」で彼が作った用語である破壊的テクノロジーの概念を拡張したものです。 この論文では、既存の大企業が顧客の意見に耳を傾け、最高価値と思われる製品を提供することで市場シェアを失っていく様子が説明されていますが、開発が不十分なテクノロジーで価値の低い顧客にサービスを提供する新興企業は、そのテクノロジーが十分に優れたものになるまで段階的に改良できる可能性があります。既存のビジネスからすぐに市場シェアを奪います。 クリステンセン氏は、大企業がスタートアップの競合他社に盲目にされたり追い抜かれたりすることを避けるために、この現象を社内で再現しようとする小規模で機敏な部門を維持することを推奨しています。 | こんにちは、n n 返信が遅くなってごめんなさい!! 私は先週休暇をとっていました:)クレイトン・クリステンセン著「革新者のジレンマ」では、次のように説明されています。少なくともある程度の価値を提供するイノベーションを企業が購入する | 『イノベーションのジレンマ』は、既存の大企業が顧客の意見に耳を傾け、最高価値と思われる製品を提供することで市場シェアを失うが、開発が不十分なテクノロジーで価値の低い顧客にサービスを提供する新興企業は、そのテクノロジーを段階的に改善できることを説明した本です。十分になるまでnn |

- Dolly データセットで Llama 2 13B テキスト生成モデルを微調整した結果:

| 入力 | グラウンドトゥルース | 微調整されていないモデルからの応答 | 微調整モデルからの応答 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を書いてください。nn### 指示:nユリアン ナーゲルスマンの後を引き継ぐ、Fc バイエルン ミュンヘンの次のコーチは誰ですか?nn### 入力:nナーゲルスマン時代 (2021 ~ 2023)n新しいコーチ ユリアン ナーゲルスマンの下で、バイエルンはデア・クラシカーに10-3で勝利し、ブンデスリーガ1連覇という偉業を達成した。 しかし、チームはチャンピオンズリーグ準々決勝でビジャレアルに予想外の敗戦を喫し、24年連続でその舞台で敗退となった。 2023年30月2025日、ナーゲルスマンはバイエルンから放出され、代わりにトーマス・トゥヘルが就任し、XNUMX年XNUMX月XNUMX日までの契約を結んだ。nnnn### Response:n | トーマス・トゥヘル氏は、2023年XNUMX月にユリアン・ナーゲルスマン氏の後任としてFCバイエルン・ミュンヘンの新監督となり、以前はチェルシーの監督を務めていた。 | nn“`pythonn{n “命令”: “ユリアン・ナーゲルスマンの後を継ぐFCバイエルン・ミュンヘンの次のコーチは誰ですか?”, n “アクション”: “FCバイエルンの次のコーチ”, n “コンテキスト”:{n “ナーゲルスマン時代(2021–2023)”: n ” ユリアン・ナーゲルスマン新監督の下、バイエルンはブンデスリーガ10連覇という偉業を達成した | FCバイエルン・ミュンヘンの次期監督はトーマス・トゥヘル氏となる。 トゥヘルは、24年2023月XNUMX日にユリアン・ナーゲルスマンがチームを離れた後、後任となる。nn |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を書いてください。nn### 指示:nアドルフ・コーンの生涯について教えてくださいnn### 入力:nアドルフ・コーン (29 年 1851 月 1930 日 - 1868 年) は、パリ生まれのフランス系アメリカ人の教育者です。 彼は 1873 年にパリ大学で「学士号」を取得し、パリのさまざまな高等教育機関で法律、歴史批評、文献学を学び、法学士号を取得しました。 1874年、エコール・デ・シャルトの生徒であった彼の論文は、フランス1870世の13世時代における裁判上の組織の歴史と呼ばれ、「古文書公文書」の学位を取得した。 1875年に普仏戦争が始まると、彼はフランス軍に入隊し、闘争中ずっと従軍した。nnコーンは1876年1884月1882日にニューヨーク市に移住し、1883年から1885年までロサンゼルスのアメリカ特派員を務めた。 『フランス共和国』は、当時フランスで知り合い、彼の政治的見解を採用したレオン・ガンベッタによって編集された。 XNUMX 年 XNUMX 月、コーンはコロンビア大学のフランス語家庭教師に任命され、その後すぐに講師になりました。 ニューヨーク在住のフランス人の人気投票により、彼は XNUMX 年にタンマニー ホールでガンベッタに関する葬儀の演説を行う者に選ばれ、XNUMX 年にはヴィクトル ユーゴーの死に際して同様の目的でマサチューセッツ州ケンブリッジから呼び出された。 ### 応答:n | アドルフ・コーン(29年1851月1930日 – 1868年)は、パリ生まれのフランス系アメリカ人の教育者でした。 彼は 1873 年にパリ大学で「学士」を卒業し、パリのさまざまな高等教育機関で法律、歴史批評、文献学を学び、法学士号を取得しました。 1874年、エコール・デ・シャルトの生徒であった彼の論文は、「フランス1870世の13世紀における司法の組織の歴史」と呼ばれ、「古文書公文書管理者」の学位を取得した。 1875年に普仏戦争が始まると、彼はフランス軍に入隊し、闘争中ずっと従軍した。nnコーンは1876年1884月1882日にニューヨーク市に移住し、1883年から1885年までロサンゼルスのアメリカ特派員を務めた。 『フランス共和国』は、当時フランスで知り合い、彼の政治的見解を採用したレオン・ガンベッタによって編集された。 XNUMX 年 XNUMX 月、コーンはコロンビア大学のフランス語家庭教師に任命され、その後すぐに講師になりました。 ニューヨーク在住のフランス人の人気投票により、XNUMX年にタンマニー・ホールでガンベッタに関する葬儀の演説を行う者に選ばれ、XNUMX年にはヴィクトル・ユーゴーの死に際して同様の目的でマサチューセッツ州ケンブリッジから呼び出された。 | アドルフ・コーン(Adolphe Cohn、29年1851月1930日 - 1868年)は、パリ生まれのフランス系アメリカ人の教育者であった。 彼は 1873 年にパリ大学で「学士号」を取得し、パリのさまざまな高等教育機関で法律、歴史批評、文献学を学び、法学士号を取得しました。 XNUMX年。Éの生徒。 | アドルフ・コーンは、29 年 1851 月 1873 日にパリで生まれたフランス系アメリカ人の教育者でした。彼はパリ大学に通い、1874 年に法の学位を取得しました。また、エコール・デ・シャルトで働き、フランスで「古書アーカイブス」の学位を取得しました。 XNUMX年。普仏戦争が始まると、彼はフランス軍に加わり、全期間フランス軍に仕えた。 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を作成します。nn### 指示:nマクドナルドの対象ユーザーは時間の経過とともにどのように変化しましたか?nn### 入力:nファーストフード レストランは、広告の一部を若者に直接向けることがよくあります。 マクドナルドのハッピーミールには、新しく公開されたファミリー映画と連動したおもちゃが含まれることが多く、その重要な例です。 1963 年に導入され、幼い子供たちにアピールするためにデザインされたピエロの広告マスコット、ドナルド・マクドナルドもその 1987 つです。 さらに、1996 年にマクドナルドは子供たちへの宣伝をさらに強化するためにレストランにプレイ プレイスを組み込み、レストランを子供たちにとってより魅力的な環境にしました。 さらに、2006 年から 2006 年まで、ディズニーはマクドナルドの独占パートナーであり、マクドナルドの製品を結び付けていました。 ディズニーは1985年1987月にこの契約の終了を発表したが、一部の報道ではディズニーは小児肥満を懸念していたという。 ディズニーの他に、マクドナルドも、Nintendo Entertainment Systemが初めて導入された2007年以来、任天堂と提携している。 XNUMX年、マクドナルドはレストラン内に任天堂のプレイランドも作り、子供たちが料理を待つ間に任天堂のゲーム機で遊べるようにした。 XNUMX 年に、マクドナルドは任天堂のゲーム機から WiFi を提供し始めました。 子どもたちにどこにいても遊べる能力を与えます。 また、これらの新しい映画を公開し、おもちゃを組み込む子供たちをターゲットにしているため、子供たちは多額の投資を行っているため、親の懐に手を差し伸べることができます。nnnn### 応答:n | マクドナルドは、一貫して若者層を直接ターゲットにして広告を展開してきました。1963 年からは、幼い子供たちにアピールするためにデザインされたピエロの広告マスコット、ドナルド マクドナルドを導入しました。 マクドナルドは長年にわたり、任天堂やディズニーなど、子供向け商品を扱う複数の企業と提携してきた。 | ファストフードレストランは常に若者をターゲットにしてきました。 ハッピーミールは、若者への宣伝においても大きな要素です。n多くの映画が公開されるのと同じように、ハッピーミールには、地元のマクドナルドでその映画を宣伝するためのおもちゃも付いていますnn—n## 400-999nn### コメント:nAs比較的狭い世界観を持つ若い会社であるマクドナルドは、 | マクドナルドは創業以来、主に若者をターゲットにした広告だけでなく、子供向けのファストフードレストランや食品を提供することで、視聴者を幼い子供や十代の若者にターゲットにしてきました。 子どもたちは親に車でマクドナルドに連れて行かれているが、このレストランは本質的には親が子どもたちに向けた広告である。マクドナルドは、色鮮やかなレストランと食べ物に含まれるおもちゃで子どもたちの興味をそそる。 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を作成します。nn### 説明:nアナンダプラム マンダルとはnn### 入力:nアナンダプラム マンダルは、インドのアンドラ プラデーシュ州ヴィシャカパトナム地区にある 46 のマンダルの XNUMX つです。 ヴィシャカパトナム収入局の管理下にあり、本部はアナンダプラムにあります。 アナンダプラム マンダルは、東はビームニパトナム マンダル、南はチナガディラ、北はパドマナーバム、西はコタバラサに囲まれています。nnnn### 応答:n | アナンダプラム マンダルは、インドのアンドラ プラデーシュ州ヴィシャカパトナム地区にある 46 のマンダルの XNUMX つです。 ヴィシャカパトナム収入局の管理下にあり、本部はアナンダプラムにあります。 | NNNN | アナンダプラム マンダルは、インドのアンドラ プラデーシュ州ヴィシャカパトナム地区にある 46 のマンダルの XNUMX つです。 ヴィシャカパトナム収入局の管理下にあり、本部はアナンダプラムにあります。 アナンダプラム マンダルは、東はビームニパトナム マンダル、南はチナガディラ、北はパドマナーバム、そしてコスに囲まれています。 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を書いてください。nn### 命令:nウッドストックで何が起こったかnn### 入力:nウッドストック ミュージック アンド アート フェア (一般にウッドストックと呼ばれる) は、15 年 18 月 1969 日から 40 日まで開催された音楽祭です。米国ニューヨーク州ベセルにあるマックス・ヤスガーの酪農場。ウッドストックの町から南西に 65 km (3 マイル) の場所にあります。 「アクエリアン博覧会: 平和と音楽の 400,000 日間」と宣伝され、ウッドストック ロック フェスティバルとも呼ばれ、1970 万人以上の参加者を集めました。 時折雨が降ったにもかかわらず、2004 の行為が屋外で行われた。 これは、史上最大規模の音楽フェスティバルの 19 つでした。このフェスティバルは、ポピュラー ミュージックの歴史の極めて重要な瞬間であるだけでなく、カウンターカルチャー世代にとって決定的なイベントとしても広く知られるようになりました。 このイベントの重要性は、50 年のドキュメンタリー映画、それに付随するサウンドトラック アルバム、そしてクロスビー、スティルス、ナッシュ & ヤング、マシューズ サザン コンフォートの両方にとって大ヒットとなったジョニ ミッチェルが書いた曲によってさらに強調されました。 ウッドストックの名を冠した音楽イベントは、2017周年、XNUMX周年、XNUMX周年、XNUMX周年、XNUMX周年、XNUMX周年などの記念日に計画されました。 XNUMX年、ローリングストーン誌はこの曲をロックンロールの歴史を変えたXNUMXの瞬間のXNUMX位に挙げた。 XNUMX 年、フェスティバル会場は国家歴史登録財に登録されました。nnnn### 応答:n | 一般にウッドストックと呼ばれるウッドストック ミュージック アンド アート フェアは、15 年 18 月 1969 日から 40 日まで、町の南西 65 マイル (3 km) にあるアメリカ合衆国ニューヨーク州ベセルにあるマックス ヤスガーの酪農場で開催された音楽祭でした。ウッドストックの。 「アクエリアン博覧会: 平和と音楽の 400,000 日間」と宣伝され、ウッドストック ロック フェスティバルとも呼ばれ、1970 万人以上の参加者を集めました。 時折雨が降ったにもかかわらず、2004 の行為が屋外で行われた。 これは、史上最大規模の音楽フェスティバルの 19 つでした。このフェスティバルは、ポピュラー ミュージックの歴史の極めて重要な瞬間であるだけでなく、カウンターカルチャー世代にとって決定的なイベントとしても広く知られるようになりました。 このイベントの重要性は、50 年のドキュメンタリー映画、それに付随するサウンドトラック アルバム、そしてクロスビー、スティルス、ナッシュ & ヤング、マシューズ サザン コンフォートの両方にとって大ヒットとなったジョニ ミッチェルが書いた曲によってさらに強調されました。 ウッドストックの名を冠した音楽イベントは、2017周年、XNUMX周年、XNUMX周年、XNUMX周年、XNUMX周年、XNUMX周年などの記念日に計画されました。 XNUMX年、ローリングストーン誌はこの曲をロックンロールの歴史を変えたXNUMXの瞬間のXNUMX位に挙げた。 XNUMX 年、フェスティバル会場は国家歴史登録財に登録されました。 | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## 解決策:nn n ソリューションを表示するにはnn“`jsnn// 解決策が必要です | 15月18日から400,000日の後半にかけて開催されたウッドストック・ミュージック・アンド・アート・フェアは、カウンターカルチャー世代によるニューヨーク州ベセルの歴史的なイベントでした。 フェスティバルには32万人以上の観衆が集まりました。 時折雨が降ったにもかかわらず、約XNUMX公演が屋外で行われた。 それは史上最大の音楽祭の一つとみなされていました。 |

- Dolly データセットで Llama 2 70B テキスト生成モデルを微調整した結果:

| 入力 | グラウンドトゥルース | 微調整されていないモデルからの応答 | 微調整モデルからの応答 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を作成します。nn### 説明:nABB 会社とは何ですかnn### 入力:nABB Ltd. は、スイスのチューリッヒに本社を置くスウェーデンとスイスの多国籍企業です。 同社は 1988 年にスウェーデンの Allmänna Svenska Elektriska Aktiebolaget (ASEA) とスイスの Brown, Boveri & Cie が合併して ASEA Brown Boveri を設立し、後にイニシャル ABB に簡略化されて設立されました。 両社は 1800 年代後半に設立された大手電気機器メーカーであり、ABB は現在もその事業に取り組んでいます。 同社はその後、ロボット工学と自動化テクノロジーにも事業を拡大しました。nnnn### 応答:n | ABB Ltd. は、スイスのチューリッヒに本社を置くスウェーデンとスイスの多国籍企業です。 同社は 1988 年にスウェーデンの Allmanna Svenska Elektriska Aktiebolaget (ASEA) とスイスの Brown, Boveri & Cie が合併して ASEA Brown Boveri を設立し、後にイニシャル ABB に簡略化されて設立されました。 両社とも 1800 年代後半に設立された大手電気機器メーカーであり、ABB は現在もこの事業に取り組んでいます。 同社はその後、ロボット工学や自動化技術にも事業を拡大しました。 | * ABB はスウェーデンとスイスの多国籍企業ですnn### LognEND I/O DATA —n | ABB は、スイスのチューリッヒに本社を置くスウェーデンとスイスの多国籍企業です。 同社は 1988 年にスウェーデンの Allmänna Svenska Elektriska Aktiebolaget (ASEA) とスイスの Brown, Boveri & Cie が合併して ASEA Brown Boveri を設立し、後にイニシャル ABB に簡略化されて設立されました。 両社は 1800 年代後半に設立され、 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を書いてください。nn### 命令:nなぜフランス人の征服王ウィリアムがイングランド王になったのですか?nn### 入力:n1050 年代から 1060 年代初頭にかけて、ウィリアムは英国王の候補者になりました。イングランドの王位は、かつてはいとこであった子供のいないエドワード懺悔王が保持していた。 1066年1066月にエドワードが死の床で国王に指名した強力な英国伯爵ハロルド・ゴドウィンソンを含む、他の潜在的な権利主張者もいた。エドワードが以前に王位を約束しており、ハロルドが彼の主張を支持することを誓っていたと主張して、ウィリアムは大規模な王位継承権を築いた。ウィリアムは14年1066月1066日のヘイスティングズの戦いでハロルドを決定的に破り殺害した。更なる軍事努力の後、ウィリアムは1067年のクリスマスの日にロンドンで王として戴冠した。 彼はノルマンディーに戻る前に、1075 年初めにイングランドの統治に関する取り決めを行いました。 その後いくつかの反乱が失敗に終わりましたが、ウィリアムの支配力は XNUMX 年までにイングランドでほぼ確実になり、彼は治世の大部分をヨーロッパ大陸で過ごすことができました。nnnn### 応答:n | ウィリアム征服王はフランス北西部に位置するノルマンディー出身でした。 1050 年代後半から 1060 年代初頭のイングランド王はエドワード懺悔王でした。 エドワードはウィリアムのいとこでした。 エドワードには子供がいなかったため、自分こそが正当な後継者であり王になるべきだと主張する者が複数いた。 これらの矛盾した主張は武力紛争を引き起こしました。 ウィリアムはイングランドに侵攻し、ヘイスティングスの戦いでハロルド・ゴドウィンソン伯爵を破って勝利した。 多くの戦いが続きましたが、ウィリアムは 1066 年後半にイングランド王になりました。彼は次の XNUMX 年間に複数の反乱に対処しましたが、権力を維持しました。 最終的に彼はノルマンディーに戻り、そこからイングランドを統治することができました。 | 征服王ウィリアムは 1050 年代から 1060 年代初頭にイングランド王となり、一度はいとこであった子供のいないエドワード懺悔王が保持するイングランド王位の候補者となりました。nnnResponse は空でもかまいませんが、長さは 256 文字以内に収まる必要があります。 n | 14 年 1066 月 1066 日のヘイスティングスの戦いでハロルド王が亡くなった後、征服王ウィリアムは XNUMX 年のクリスマスの日にイングランド王として戴冠し、ノルマン人のイングランド征服が確立されました。 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を作成します。nn### 説明:nRMS アドリアティックについて教えてくださいnn### 入力:nRMS アドリアティックは、ホワイト スター ラインの英国の遠洋定期船です。 彼女はビッグ 20,000 と呼ばれる 1911 GRT 以上の船の 1917 番目の船でした。 この船は 1930 隻の船のうち、決して世界最大の船ではなかった唯一の船でした。 しかし、この船はビッグ 1934 の中で最大、最速、そして最も豪華で、屋内プールとトルコ式バスを備えた最初の遠洋客船でした。彼女は以前、サウサンプトンからニューヨークまでの真新しい航路でキャリアをスタートしました。 1935 年からは、リバプールからの二次航路で姉妹船に加わりました。 実際、これらは手頃な価格でサービスを提供することを目的とした低速定期船でした。 第一次世界大戦が勃発したとき、アドリア海は多くの物資を積みながら民間の大西洋横断任務を続けた船の一つでした。 XNUMX 年に接収されて兵員輸送船として活躍しました。戦後は数回改修され、徐々に巡航に使用されるようになり、XNUMX 年代には巡航が主な任務となりました。 XNUMX 年にキュナード ラインとホワイト スター ラインが合併すると、この船はすぐに不要とみなされ、年末に売却されました。 XNUMX 年に大阪で解体されました。nnnn### 応答:n | RMS アドリアティックは、ホワイト スター ラインの英国の遠洋定期船でした。 彼女はビッグ 20,000 と呼ばれる XNUMX GRT 以上の船の XNUMX 番目の船でした。 この船は XNUMX 隻のうち、決して世界最大の船ではなかった唯一の船でした。 しかし、この船はビッグ XNUMX の中で最大、最速、そして最も豪華な船であり、屋内プールとトルコ式バスを備えた最初の遠洋客船でした。 | RMS アドリアティックは、ホワイト スター ラインの英国の遠洋定期船でした。 彼女はビッグ 20,000 と呼ばれる XNUMX GRT 以上の船の XNUMX 番目の船でした。 この船は XNUMX 隻のうち、決して世界最大の船ではなかった唯一の船でした。 nn### コンテキストnこのタイプの質問は、検索エンジンにクエリを実行するためによく使用されます。 入力はクエリの入力であり、応答はパブリックです | RMS アドリアティックは、イギリスのホワイト スター ラインの遠洋定期船でした。 この船は 1906 年に進水しましたが、最初の商業航海は 1907 年でした。この船は 20,000 トンを超える 1901 隻の船の 1903 番目であり、ビッグ XNUMX と呼ばれました。 他の XNUMX つは、XNUMX 年の RMS ケルティック、XNUMX 年の RMS バルティック、そして R |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を作成します。nn### 説明:n光子を検出する CGRO とは何ですか?nn### 入力:nコンプトン ガンマ線天文台 (CGRO) は、20 keV から 30 keV のエネルギーを持つ光子を検出する宇宙観測所です。 GeV は 1991 年から 2000 年まで地球周回軌道上にありました。この天文台は 14 台の宇宙船に 37 つの主望遠鏡を備え、さまざまな特殊なサブ機器や検出器を含む X 線とガンマ線をカバーしていました。 5 年間の努力を経て、この天文台は 1991 年 4 月 2000 日の STS-450 でスペースシャトル アトランティスから打ち上げられ、280 年 17,000 月 37,000 日に軌道離脱するまで運用されました。バン・アレン放射線帯を避けてください。 これは、当時飛行した天体物理学的ペイロードの中で最も重い XNUMX キログラム (XNUMX ポンド) でした。nnnn### 応答:n | CGRO はコンプトン ガンマ線観測所 (CGRO) で、20 年から 30 年まで地球上で 1991 keV から 2000GeV のエネルギーを持つ光子を検出する宇宙観測所でした。 | **転写者:** EGRET 装置は光子を検出します。nn | コンプトン ガンマ線天文台 (CGRO) は、20 keV から 30 GeV のエネルギーを持つ光子を測定します。 |

| 以下は、タスクを説明する指示と、さらなるコンテキストを提供する入力との組み合わせです。 リクエストを適切に完了する応答を書いてください。nn### 指示:nピアニストとしてのヨル・ウム・ソンはどのくらい優れていますかnn### 入力:nヨル・ウム・ソン (2 年 1986 月 2004 日、韓国の原州市生まれ) は、韓国の古典音楽作家です。ピアニスト。 彼女が初めて国際的な注目を集めたのは、18歳の1年2008月、ソウル、大田、東京で行われたアジアツアーで、ロリン・マゼール指揮ニューヨーク・フィルハーモニックとリストのピアノ協奏曲第2番をソリストとして演奏したときだった。 ソンは、2009年2011月にソウル芸術の殿堂に戻ったマゼールとニューヨーク・フィルハーモニックと再び共演し、今回はベートーヴェンのピアノ協奏曲第2005番のソリストとして共演した。彼女の受賞歴には、第XNUMX回ヴァン・クライバーン国際ピアノコンクール(XNUMX年)と両方の銀メダルが含まれる。 )、XNUMX年のチャイコフスキー国際コンクールでは室内協奏曲最優秀演奏賞と委嘱作品最優秀演奏賞も受賞した。 彼女はまた、アーサー ルービンシュタイン国際ピアノ マスター コンクール (XNUMX 年) で銅メダルを獲得しました。nnnn### Response:n | Yeol Eum Son (2 年 1986 月 2004 日、韓国の原州市生まれ) は、韓国のクラシック ピアニストです。 彼女が初めて国際的な注目を集めたのは、18歳の1年2008月、ソウル、大田、東京で行われたアジアツアーで、ロリン・マゼール指揮ニューヨーク・フィルハーモニックとリストのピアノ協奏曲第2番をソリストとして演奏したときだった。 ソンは、2009年2011月にソウル芸術の殿堂に戻ったマゼールとニューヨーク・フィルハーモニックと再び共演し、今回はベートーヴェンのピアノ協奏曲第2005番のソリストとして共演した。彼女の受賞歴には、第XNUMX回ヴァン・クライバーン国際ピアノコンクール(XNUMX年)と両方の銀メダルが含まれる。 )、XNUMX年のチャイコフスキー国際コンクールでは室内協奏曲最優秀演奏賞と委嘱作品最優秀演奏賞も受賞した。 彼女はまた、アーサー・ルービンシュタイン国際ピアノマスターコンクール(XNUMX)で銅メダルを獲得しました。 | Yeol Eum Son は、世界で最も権威のあるオーケストラのいくつかと共演した熟練したピアニストです。 2009年には第2005回ヴァン・クライバーン国際ピアノコンクールで銀メダルを獲得、XNUMX年にはアーサー・ルービンスタイン国際ピアノマスターコンクールで銅メダルを獲得した。 彼女は世界中で大成功を収め続けています。 | ソン・ヨルムはとても優れたピアニストです。 彼女は 18 歳で世界最高のミュージシャンの一員として国際的なキャリアをスタートしました。そして、25 歳になるまでにすでに XNUMX つの国際コンクールで銀メダリストになっていました。 |

- Dialogsum データセットで Llama 2 7B テキスト生成モデルを微調整した結果:

| 入力 | グラウンドトゥルース | 微調整されていないモデルからの応答 | 微調整モデルからの応答 |

| このダイアログを要約します:n#person1#: 素晴らしい食事です!n#person2#: ありがとう。 すべてがとてもうまくいったのでうれしいです。n#person1#: 誰がこの上手な料理の仕方を教えてくれましたか?n#person2#: 私は料理学校で料理教室を受講しました。n#person1#: うわー、これには何が入っていますか?鶏肉料理?n#person2#: それはすごいですね? それはココナッツ ジンジャー チキンとライスです。n#person1#: スープはエビのスープですか?n#person2#: はい、海野菜とレモングラスと一緒にエビが入っています。n#person1#: 幸運だったと思います。この食事に合うワインを選ぶ際に。n#person2#: ワインを持ってきてくれてありがとう。 鶏肉とよく合います。n—n概要:nnn### 回答:n | #person1# は、#person2# が用意した食事は素晴らしいと思います。 #person2# が料理の材料を紹介します。 | ダイアログが完了すると、担当者は収集した情報に対して適切な応答を返します。 たとえば、人 1 は次のように言うことができます。nn#人 1#: これは素晴らしいですね! ありがとうございます。nn#person2#: どういたしまして。 お食事も気に入っていただけると思いました。 楽しんでいただけて嬉しいです。nn—n— — — — –nnn### 概要:nnn### 応答:nダイアログ終了後 | #person1# と #person2# は #person2# の場所で食事をします。 鶏肉に合う料理とワインについて話します。 |

| このダイアログを要約してください:n#person1#: すみません、私は古代ギリシャについてのエッセイを書いています。 このトピックに関するお勧めの本はありますか?n#person2#: ガチョウ? 古代のガチョウについて書きたいですか? そんなこと聞いたことないよ。 とにかく、それはいくつかの動物の本、それが行 J です。または、科学を試してみたいですか、それは行 Gn#person1#: 動物ですか? しかし、ギリシャは動物ではなく国です。n#person2#: ああ、ギリシャ。 そうですね、今日はあなたにとって幸運な日になるはずです。 私たちはちょうどそのテーマに関する新しい本のコレクションを受け取りました。 ここの列 Cn#person1# にライターがいます: なるほど。 たくさんの本がありますが、どれをお勧めしますか?n#person2#: そうですね、ロビン・スミスの本は素晴らしいですが、非常に長いです。 表紙に銅像が載っているやつです。 ミルトン・パイクの作品もあります。 正面には兵士の絵が描かれています。 ご覧のとおり、それほど厚くないので、読むのにそれほど時間はかかりません。 しかし、おそらく最高の本は古代オリンピックスタジアムの写真が載っている本でしょう。 いくつかの歴史作品の賞を受賞しています。n#person1#: うーん、決めるのは難しいですが、残念ながらたくさん読む時間がありません。 ミルトン・パイクの本を買おうと思います。n#person2#: わかりました。 図書館カードをいただけますか?n#person1#: はい、こちらです。n—n概要:nnn### 応答:n | #person1# は #person2# に古代ギリシャに関するおすすめの本をいくつか尋ねます。 #person2# は、非常に長い Robin Smith の作品、それほど厚くない Milton Pike の作品、およびいくつかの歴史的作品の賞を受賞した作品を提案します。 #person1# には十分な時間がないので、#person1# はミルトン・パイクの本を買ってきます。 | n—nn概要:n | #person1# は古代ギリシャについてのエッセイを書いています。 #person2# は #person1# に古代ギリシャに関する本を勧めますが、これらはすべて新しく受け取ったものであり、Milton Pike.nn の本を購入することを提案しています。 |

| このダイアログを要約してください:n#person1#: さて、本をお持ちのようですね、ジョージ。 でも読んでますか? 色を塗っているだけのようです。n#person2#: 私は本の重要な部分にマークを付けています。 色はさまざまなものに使用されます。n#person1#: 何が好きですか?n#person2#: 主なアイデアは黄色です。 覚えておくべき重要な詳細はピンクで、薄緑色は難しいアイデアを表します。n#person1#: これは非常に多くのアクティビティのようです。 時間を無駄にしていませんか?n#person2#: そうは思いません、お母さん。 今夜全部読みます。 明日聞いてみます。 そして勉強する時間になると、私はすでにほとんどの情報を知っています。n#person1#: 私の時代は、ただ本を読んでその情報を覚えようとしました。n#person2#: 先生は私たちに次の重要性を言いました。アクティブな読書。 そして、それが、自分の選んだ速度で学習するための最良の方法です。n#person1#: なるほど。 それで、このノートは何のためにあるのですか?n#person2#: それはメモを取るためです。 どのようなことを書き留めますか?n#person1#: 時々、要約を書きます。 このページでは質問を書きます。 そしてもちろん、新しい単語を書き留める別のページもあります。n—n概要:nnn### 応答:n | ジョージは母親に、本の重要な部分にさまざまな色で印を付けることが彼の学習法だと話しています。 ノートにメモを取ったり、まとめを書いたりすることもあります。 | #人物1#: ああ! アクティブな読書、質問文、語彙ノート、要約、ハイライト。 情報を学ぶという点において、皆さんがどれほど違うのかがわかりました。 感動しました。n#person2#: ありがとう。 読書は、新しい情報を学び、記憶するための最良の方法です。 あなたは現在アクティブ リーディングを使用していますか?n#person1#: うーん…..それについては考えなければなりません。nnn#person | ジョージは本を早く読むために行っている活動について説明します。 ジョージはお母さんにノートを見せて、メモの取り方を説明します。 |

| このダイアログを要約します:n#person1#: おはようございます、先生。 パスポートを見せていただけますか?n#person2#: はい、もちろんです。 これです。n#person1#: ありがとうございます。 これらはすべてあなたのものですか?n#person2#: いいえ、それらのいくつかは私の友人のものです。 彼女のパスポートも欲しいですか?n#person1#: はい、お願いします。 何か機内持ち込みアイテムはありますか?n#person2#: ベルトにも付けて欲しいですか?n#person1#: はい、お願いします。 この大きなスーツケースを開けていただけますか?n#person2#: わかりました。 ちょっとまってください。 衣類と洗面用具だけです。n#person1#: わかりました。 申告するものはありますか?n#person2#: 何もないと思います。n#person1#: 生鮮食品、生きた植物、動物はありますか?n#person2#: ああ、いいえ。 それはありません。n#person1#: ありがとうございます。 スーツケースに鍵をかけても構いません。 これがあなたのパスポートです。n#person2#: ありがとうございます。n—n概要:nnn### 応答:n | #person1# は #person2# と #person2# の友人のパスポートを見て、荷物を確認します。 #person2# は #person1# に宣言するものは何もないと伝えます。 #person1# は彼らを解放します。 | > 何もないと思います。nnn—n**カテゴリ:**nn- [会話 (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Key:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* 任意の著作権 | 入国管理官は #person2# にパスポートを見せて大きなスーツケースを開けるように頼みます。 #person2# は申告するものが何もないので、スーツケースに鍵をかけてしまうかもしれません。nn |

| このダイアログを要約してください:n#person1#: 中国茶は世界中で有名です。 数箱購入したいのですが。n#person2#: 中国にはさまざまな種類のお茶があります。 味と効果によります。n#person1#: そうですね、私は中国茶のことは全く知りません。n#person2#: これは緑茶です。夏でも飲めます。 夏バテを和らげる効果があり、肺の調子を整えるのにも効果的です。n#person1#: 面白そうですね。 これはどうでしょうか?n#person2#: これは紅茶です。味が濃く、消化を促進します。n#person1#: これは何ですか? 香ばしい香りがします。n#person2#: 高品質のジャスミン茶です。 香りが良くて、味も心地よいです。n#person1#: ジャスミン茶をいただきます。 包装紙とリボンで梱包していただけますか? 友人への贈り物です。n#person2#: 問題ありません。 しばらくお待ちください。n—n概要:nnn### 応答:n | #person2# は、中国茶を購入したい #person1# に緑茶、黒ティー、ジャスミンティーを勧め、#person1# はジャスミン茶を飲むことにしました。 | #[英語]#: 中国茶は世界中で有名です。 いくつかの箱を購入したいのですが。n#[フランス語]#: Il ya différentes sorts de thé chinois au pays。 C'est selon le goût, et les effets qu'on veut obtenir.n#[スペイン語]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[ドイツ語]#: Ich mö | #person1# は、さまざまな種類の中国茶を数箱購入したいと考えています。 #person2# は #person1# が選択できるよう手伝い、梱包します。nn |

- Dialogsum データセットで Llama-2 13B モデルを微調整した結果:

| 入力 | グラウンドトゥルース | 微調整されていないモデルからの応答 | 微調整モデルからの応答 |

| このダイアログを要約します: n#person1#: トンプソン夫人はかつては不神論者でしたが、ジェイソンはn#person2#: なぜですか? 何も困らないはずじゃないですか? 実際、今朝のクラス全体のディスカッション中、私たちは非常に活発でした。n#person1#: それだけです。 それは決して悪いことではないと思います。 彼女は私たちにクラス監視に立候補するよう頼むつもりだと思います。n#person2#: おっと! 本当に? それは大きな責任です。n#person1#: そうですね、あなたならきっとうまくできると思いますよ。 それに、それを依頼されるのはとても光栄なことだ。 それは、トンプソン夫人が私たちをリーダーとして見ているということです。 n#person2#: でも、私一人でそれができるかどうかはわかりません。 一緒にやってもらえませんか?n#person1#: トンプソンさんに聞いてみましょう。 今、彼女が廊下から入ってくる音が聞こえます。n—n概要:nnn### 応答:n | #person1# はジェイソン・トンプソン夫人にかつて異神論者だったことを話し、#person1# は彼女がクラスの監視員に立候補してほしいと推測しています。 彼らはトンプソン夫人にこれを一緒にできないかと尋ねるでしょう。 | n* 教師がジェイソンとクラスメートにクラス監視に立候補したいかどうか尋ねたとき、彼とクラスメートは一緒にそれに同意しました。 二人の少年はクリスチャンですが、クラスの友達ではありません。n* イエスに対する彼らの信仰は公には共有されていないかもしれませんが、それは祈りと、他の人を助け、愛を示すために一緒に従う模範を通して明らかです。nn—n## 1654nn **[状況:** 学生たちは最近のことについて話しています。 | トンプソン夫人は、ジェイソンとジェームスがリーダーだと思うので、クラス監視に立候補するよう頼みます。nn |

| このダイアログを要約します。n#person1#: ねえ、車を停めて、あそこの家を見ましょう。n#person2#: はい、素敵ですね! それは私たちのオープンハウスのリストに載っていますか?n#person1#: はい、それは私たちのリストに載っています。n#person2#: そうですね、縁石から見るととてもよく見えます。 内部に進みましょう。n#person1#: レジストリに署名しましょう。 不動産屋は今ちょっと忙しそうです。n#person2#: OK、次はキッチンを見に行きましょう。n#person1#: ほら、ここに軽食があるよ。n#person2#: 必ず取りに来てください。その家に関する情報が記載されたチラシ。n#person1#: この家をいくらで求めているかが記載されていますか?n#person2#: はい、XNUMX 万 XNUMX から XNUMX に割引されたようです。そして XNUMXn—n概要:nnn### 応答:n | #person1# と #person2# が家を見に来ます。 彼らは内部をチェックし、その価格について話します。 | これは、次の刺激に対する AMI の応答です。nn人 2: nはい、素晴らしいですね! オープンハウスリストに載っていますか? nはい、リストに載っています。nそうですね、縁石から見るととてもよく見えます。 内部に進みましょう。nレジストリに署名しましょう。 不動産屋は今ちょっと忙しそうです。nOK、次はキッチンを見に行きましょう。nああ、いくつかあるよ。 | #person1# と #person2# は、オープンハウス リストに載っている家を見て回っています。 彼らは登録簿に署名し、#person2# は #person1# に情報が記載されたチラシを受け取るように指示します。nn |

| このダイアログを要約します:n#person1#: 調子はどうですか、ウィルソンさん? 私は Tina.n#person2# です: 初めまして、Tina.n#person1# さん: 着席してください。 当社の強制労働者の雇用により、従業員契約に関する情報はすでに提供されていると思いますが、署名する前に主な詳細をもう一度確認したいと思います。 まず、月給を受け取ります。勤続 2 年後には 1 か月の有給休暇が付与されます。n#person1#: それは理解しています。n#person5#: 勤務中は当社の医療プランの対象となります。 あなたは中間管理職となるため、通常の勤務時間より最大 2 時間残業できることが期待されます。 それを超えて承認された労働時間は 1 時間半ごとに支払われ、給与または休暇として受け取ることができます。n#person2#: まさに私の理解です。n#person1#: 妥当な日数の病気休暇は会社が負担します。 。 長期にわたる病気は保険でカバーされます。 契約の他の条項は読みましたか?n#person2#: はい、読みました。n#person1#: 他にご質問はありますか?n#person2#: 1 つだけ。 フレックスタイム制に関する項目に気づきました。 その可能性はありますか?n#person3#: はい、その通りですが、詳細については上司と話し合う必要があります。n#personXNUMX#: それは許容範囲です。n#personXNUMX#: いいです。 ここに署名していただければ、XNUMX 日以内に作業を開始できます。n—n概要:nnn### 応答:n | ウィルソン氏はティナに雇用契約に関する基本的な情報を説明します。 月給、XNUMXか月の有給休暇、医療制度、長時間労働、フレックスタイムなどについて言及している。 | nいいえ、要約は正しくありません。 #person1 ダイアログでは名前がティナであるとは言わず、自己紹介も行いません。 彼らはお互いの名前を知っていると思うので、その必要はありません。nn他のすべてが正しければ、#person1 が終了しない限り、概要は変更されないと思います。それで問題ありません。nn | ティナはウィルソン氏と会い、ティナの従業員契約の主な詳細を確認します。 二人は月給や医療計画について話し合う。 ティナは何も質問しません。3 日以内に仕事を開始します。nn |

| このダイアログを要約します: n#person1#: ジャック、あなたの好きな科目は何ですか? n#person2#: 私の好きな科目は何ですか? そうですね、私は科学の方が好きだと思います。 はい、科学、とても興味深いと思います。 理科の先生はその科目をとても面白くします。 あなたはどうですか?n#person1#: 私は数学のテストではいつも良い点をとります。 地理も好きです。 私は人々と彼らが住んでいる場所について学ぶのが好きです。 ジャックが嫌いな科目はありますか?n#person2#: 私は物理学があまり好きではありません。 理解するのは簡単ではありません。ほとんどの子供たちは飽きています。n—n概要:nnn### 応答:n | ジャックの好きな科目は科学ですが、物理学はあまり好きではありません。 #person1# は数学と地理が好きです。 | n—nn### 単語:「お気に入り」 (形容詞)nn意味:他の本のほとんどが愛され、高く評価されているn例:私の一番好きな本は聖書です。 あなたの好きなスポーツは何ですか?; 私の好きな色は青です。nn—nnnn### あなたの ____ の主題は何ですか? (正式)nn質疑応答ダイアログ:nn#person1#: あなたの好きな主題は何ですか?n# | ジャックとジャックは、好きな話題と嫌いな話題について話しています。nn |

| このダイアログを要約します:n#person1#: こんにちは、マギー。 保護者全員で行った学年末の美術展であなたの絵を見ました。 素晴らしかったです。n#person2#: そうですね、美術の先生はとても喜んでくれたようですが、保護者がどう思ったかは分かりません。n#person1#: ああ、心配しないでください。 彼らがそれについて良いことを言っているのを聞いただけです。n#person2#: うーん…彼はおそらく私が正しい色を使用していないことに気づかなかったでしょう。n#person1#: 誰も気づかなかったと思います。n#person2# :いいえ、でも、そうしました。 しかし、それについては何もすることができませんでした。 そうですね、次回はもっと良いものを作りたいと思います。n—n概要:nnn### 応答:n | #person1# はマギーの絵を見て、素晴らしいと思いましたが、マギーは正しい色を使用していないのではないかと心配し、次回はもっと良いものを描けることを願っています。 | この要約では、議論の重要な点と結論を強調します。nn# 人物 1 に応答します:n[応答の要約]nn—n### 応答:nこの要約は、議論の重要な点と結論を強調します。nn# 人物 2 に応答します。 :n[回答概要]nn### 人物 1:n[人物 1 概要]n—n### 人物 2:n[人物 2 概要]nn### 人物—n | #person1# はマギーの絵を見て、多くの親がマギーの絵について素晴らしいと言っているとマギーに話しました。 マギーはそうは思いません。nn |

- Dialogsum データセットで Llama 2 70B モデルを微調整した結果:

| 入力 | グラウンドトゥルース | 微調整されていないモデルからの応答 | 微調整モデルからの応答 |

| このダイアログを要約します:n#person1#: 学位を取得しましたか?n#person2#: はい。 1996 年にヘベス大学で理学士の学位を取得し、2001 年に北京大学で MBA の学位を取得しました。n#person1#: 大学での学業成績はどうですか?n#person2#: 実際、私の成績は優秀でした。 私の全体的な GPA は 9 点満点中 10 で、クラスの中で最高でした。n#person1#: それはとても印象的です。 どのコースが一番気に入りましたか?n#person2#: 英語。 面白くてためになる内容だったので、とても興味を持ちました。 n#person1#: 大学院生のときに専攻を変えた理由を教えてください。 n#person2#: 行政や経営にとても興味があるからです。その中のいくつかのコースを受講しました。 科目でも良い成績を収めることができました。 したがって、私はこのポジションで良い仕事ができると信じています。 n#person1#: 大学で何か栄誉や賞を受賞しましたか? n#person2#: はい。 私は大学から毎年奨学金を受け取りました。 1995 年に私は全国数学モデル コンテストに参加し、賞を受賞しました。n—n概要:nnn### 応答:n | #person1# は #person2# にインタビューし、#person2# の学位、学歴、好きなコース、大学での受賞歴など、いくつかの質問をします。 #person2# は、#person2# に、なぜ #person1# が専攻を管理部門に変更したのかも伝えます。 | 候補者は、対話の主な考えは、彼が 0 つの学位を取得し、XNUMX であったと要約しました。そして、メジャーはうまくいきました。 nしかし、彼の最初の文は、ナルシシズム以外に上記のような感情をあまり表現しておらず、また、彼の経験がなぜ会社に関連するのかについても述べていません。 彼はより良いつながりを作り、おそらく「プロフェッショナル」以外の根底にある感情/態度で要約を終えることができます(対話でそうしているように)。 | #person2# は #person1# に #person2# は学士号と MBA を取得しました。 #person2# の GPA は #person2# のクラスで最も高く、#person2# は管理に興味があります。 #person2# も college.nn でいくつかの栄誉と賞を受賞しました |

| このダイアログを要約してください:n#person1#: すみません、これは何の資料ですか? n#人2#: ラキ。 いりますか? n#person1#: いいえ、木綿の布はどこにありますか? n#person2#: 見せてあげるよ。 n#person1#: 洗濯後の縮み率はどのくらいですか? n#person2#: 5% 未満。 かなり耐久性があります。 n—n概要:nnn### 応答:n | #person2# は #person1# に綿の服は耐久性があると伝えます。 | ルート QA41913 の場合、このセクションにはダイアログの段落概要を含める必要があります。これにより、たとえば、自動発音および音声生成システムが出力合成にこのテキストを使用できるようになります。 | #person1# は綿の布が欲しいです。 #person2# は rhaki.nn をいくつか見せています |

| このダイアログを要約します: n#person1#: ごめんなさい、遅れました、Tom.n#person2#: 大丈夫です、リタ。 どこに行っていましたか?n#person1#: 警察署です。 ハンドバッグを紛失してしまいました。 あるいは誰かが持ち去ったのかもしれない。 わかりません。n#person2#: ああ、いいえ。 どうしたの? 座って下さい。 何か重要なものはありましたか?n#person1#: 重要です! 小切手帳、仕事に必要な書類がすべて入っています。n#person2#: ああ、それはひどいですね。 しかし、どうやってそれを失ったのですか?n#person1#: そうですね、ご存知のとおり、私は午前中ずっと友達と一緒にいて、昼食も一緒に食べました。 昼食を食べた後、買い物に行きました。 そして、何か買おうと思ったら、小切手帳が見つかりませんでした。 そのとき、それが私のハンドバッグの中にあったことを思い出しました。 そして、私のハンドバッグは私の車の中にありました。n#person2#: それで、車に戻りました。n#person1#: でも、そこには見つかりませんでした。n#person2#: それで、警察署に行きましたか?n#担当者 1#: 今すぐではありません。 警察署に行く前に友人の事務所に電話しました。 運が悪かったです。n#person2#: 昼食をとったレストランに行って探したほうがいいです。n#person1#: ああ、そうすればよかったです。n#person2#: マネージャーに電話したほうがいいですよ。 away.n—n概要:nnn### 応答:n | リタはトムに、ハンドバッグをなくしてしまい、ハンドバッグを探すのに苦労したため遅れたと伝えます。 トムはリタに、ランチを食べたレストランに行って探すよう勧めます。 | 最も好きな単語の組み合わせを使用して、各文を英語に翻訳します:n### 値:n | リタはハンドバッグをなくしたので、トムは彼女が昼食をとったレストランに行って探すようにアドバイスしました。 |

| このダイアログを要約します:n#person1#: おはよう、お母さん!n#person2#: おはよう、メグ。 今日は調子が悪そうですか? 病気ですか?n#person1#: いいえ、病気ではありません。n#person2#: それで、どうしたのですか、うちの子?n#person1#: 何もありません。n#person2#: ああ、さあ、ベイビー。 何が起こったのか教えてください。n#person1#: 私。 。 私は試験に合格できませんでした。 一生懸命勉強しておけばよかったと思います。n#person2#: ああ。 落ち着いて。 今日から目標を設定できます。n#person1#: わかりました、お母さん。 次回の試験では絶対に落ちません。n—n概要:nnn### 応答:n | メグは試験に落ちたので気分が良くありません。 彼女の母親は、今日から目標を設定するよう彼女に勧めます。 | アクション動詞なしの補助および動詞の量に応じた直接オブジェクト | #person1# は試験に合格できず、そのことをお母さんに話しました。 お母さんは #person1# にもっと勉強するよう勧めています。nn |

| このダイアログを要約します:n#person1#: 誰もが経済的に負けることを望んでいます。 裕福な退職を計画しているのであれば、貯蓄を投資しなければなりません。 株の購入を考えています。 うまく管理できれば良い投資になるかもしれない。 どう思いますか?n#person2#: 私も部分的にはあなたの意見に同意します。 株を買うのは難しくありませんが、株を買って継続的に利益を得るのは非常に難しいです。 プロでも簡単ではないので注意が必要です。 とにかく、私たちのような人には投資の助けが必要です。 オンラインでリサーチしてみませんか? 投資方法について人々を教育するためのデータ、レポート、ディスカッションフォーラムがあります。 さらに、株価チャートを提供する確立された Web サイトにアクセスする必要があります。n#person1#: うわー、とてもプロフェッショナルですね。n#person2#: 先週末、投資のテレビ番組を見たところです。 最近とても話題になっています。 実は私は初心者でもありません。n—n概要:nnn### 応答:n | #person1# と #person2# は株の購入について話しています。 #person2# は、この方法で継続的にお金を稼ぐのは難しいと考えており、投資について学ぶためにオンラインでリサーチすることを提案しています。 | n私は以前に推奨された投資戦略に同意します。 このような計画を立てるのに、私は多大な時間とエネルギーを費やしました。 私の判断でここまで信頼が置かれたことは素晴らしいことです。 確かに、私はこのチームを明るく安全な退職後の未来に導くために全力を尽くすので、同僚は安心できるでしょう。 チームの一員として活躍することを楽しみにしています。 | #person1# は株式を購入したいと考えていますが、#person2# は #person1# に投資は難しいので注意するように言います。 #person2# は、#person1# にオンラインで調査し、確立された Web サイトにアクセスし、投資プログラムを視聴することを提案します。nn |

データセットのフォーマット

現在、命令微調整とドメイン適応微調整の XNUMX 種類の微調整を提供しています。 パラメータを指定することで、いずれかのトレーニング方法に簡単に切り替えることができます instruction_tuned 'とTrue'または'False'。

ドメイン適応形式

テキスト生成モデルは、ドメイン固有のデータセットで微調整することもできます。 ドメイン固有のデータセットで微調整された後、モデルはドメイン固有のテキストを生成し、数回のプロンプトでその特定のドメイン内のさまざまな NLP タスクを解決することが期待されます。

モデルへの入力には、トレーニングおよびオプションの検証ディレクトリを使用します。 各ディレクトリには、CSV、JSON、または TXT ファイルが含まれています。 CSV および JSON ファイルの場合、トレーニング データまたは検証データは text という列から使用されるか、または という列がない場合は最初の列から使用されます。 text 見つかった。 トレーニング中のファイルの数と検証中のファイルの数 (指定されている場合) は、それぞれ 1 に等しい必要があります。

出力は、推論のためにデプロイできるトレーニング済みモデルです。

以下は、テキスト生成モデルを微調整するための TXT ファイルの例です。 TXT ファイルは、2021 年から 2022 年までの Amazon の SEC 提出書類です。

命令の微調整

テキスト生成モデルは、データが予期された形式であれば、任意のテキスト データに対して命令を調整できます。 命令調整モデルは、推論のためにさらに展開できます。

入力には、トレーニング ディレクトリとオプションの検証ディレクトリを使用します。 トレーニング ディレクトリと検証ディレクトリには、XNUMX つまたは複数の JSON 行 (.jsonl) 形式のファイルが含まれている必要があります。 特に、train ディレクトリには、入力および出力形式を記述したオプションの *.json ファイルを含めることもできます。

各エポックの終了時に計算された検証損失に応じて、最適なモデルが選択されます。 検証セットが指定されていない場合、トレーニング データの (調整可能な) 割合が自動的に分割され、検証に使用されます。

トレーニング データは JSON 行 (.jsonl) 形式でフォーマットする必要があります。各行は単一のデータ サンプルを表す辞書です。 すべてのトレーニング データは XNUMX つのフォルダーに存在する必要があります。 ただし、複数の .jsonl ファイルに保存できます。 .jsonl ファイル拡張子は必須です。 トレーニング フォルダーには、 template.json 入力形式と出力形式を記述したファイル。 テンプレート ファイルが指定されていない場合は、次のテンプレートが使用されます。

この場合、JSON 行エントリ内のデータには次のものが含まれている必要があります。 prompt および completion 田畑。 カスタム テンプレートが提供されている場合は、それも使用する必要があります prompt および completion キーを使用して入力テンプレートと出力テンプレートを定義します。 以下はカスタム テンプレートのサンプルです。

ここで、JSON 行エントリのデータには、 question, context, answer フィールド。

出力は、推論のためにデプロイできるトレーニング済みモデルです。

Amazon の SEC 申請データのサブセットを提供します。 公開されているサイトからダウンロードされます EDGAR。 データにアクセスする手順については、を参照してください。 EDGARデータへのアクセス.

ライセンス: クリエイティブ・コモンズ表示継承ライセンス (CC BY-SA 4.0)

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 自動車/EV、 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- チャートプライム。 ChartPrime でトレーディング ゲームをレベルアップしましょう。 こちらからアクセスしてください。

- ブロックオフセット。 環境オフセット所有権の近代化。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/fine-tune-llama-2-for-text-generation-on-amazon-sagemaker-jumpstart/

- :持っている

- :は

- :not

- :どこ

- $UP

- 000

- 1

- 10

- 100

- 12

- 13

- 14

- 15年

- 視聴者の38%が

- 16

- 17

- 1870

- 19

- 1930

- 1933

- 1934

- 1985

- 1995

- 1996

- 20

- 2000

- 2001

- 2005

- 2006

- 2008

- 2011

- 2017

- 2023

- 2025

- 21e

- 23

- 24

- 25

- 視聴者の38%が

- 27

- 27a

- 28

- 29

- 30

- 31

- 32

- 36

- 39

- 40

- 400

- 50

- 500

- 5

- 60

- 67

- 7

- 70

- 75

- 8

- 9

- a

- 能力

- できる

- 私たちについて

- それについて

- 上記の.

- アカデミック

- 同意

- ことができます。

- アクセス

- アクセス

- 熟達した

- 従った

- 精度

- 達成する

- 認める

- 越えて

- 行為

- Action

- アクティブ

- 活動

- 使徒行伝

- 実際の

- 実際に

- アダム

- 適応

- 加えます

- 添加

- NEW

- 追加情報

- さらに

- 調節可能

- 管理

- 採択

- 広告協賛

- 広告

- 広告運用

- 恐れて

- 後

- 再び

- 年齢

- 同意して

- 契約

- AI

- AIモデル

- 目指す

- 目的としました

- アルバム

- アルゴリズム

- アルゴリズム

- 整列する

- すべて

- 許す

- 許可

- 沿って

- アルファ

- 既に

- また

- しかし

- 常に

- am

- Amazon

- アマゾンセージメーカー

- Amazon SageMaker ジャンプスタート

- Amazon Webサービス

- アメリカ

- 間で

- 量

- エイミー

- an

- 分析

- 古代

- および

- 動物

- 動物

- アナウンス

- 発表の

- 別の

- 回答

- 回答

- どれか

- 誰も

- 何でも

- 見かけ上

- アピール

- 訴える

- 上訴

- 現れる

- 登場

- 登場する

- 適用された

- 申し込む

- 任命された

- 認める

- 適切な

- 適切に

- 承認された

- 4月

- 建築

- です

- AREA

- アルゼンチン

- 間違いなく

- 引数

- 発生します

- 武装した

- 軍

- 周りに

- 配列

- 宝品

- アーサー

- 記事

- 人工の

- 人工知能

- 人工知能と機械学習

- 芸術

- AS

- アジア

- 頼む

- アシスト

- 前提条件

- At

- アトランティス号

- 出席

- 参加者

- 注意

- 集め

- 聴衆

- 8月

- オースティン

- オーストラリア

- 著者

- オートマチック

- 自動的に

- オートメーション

- 賃貸条件の詳細・契約費用のお見積り等について

- 利用できます

- 平均

- 避ける

- 受賞

- 賞を受賞

- 離れて

- AWS

- 赤ちゃん

- バック

- 悪い

- バー

- ベース

- 戦い

- 戦い

- BE

- 美しい

- になりました

- なぜなら

- になる

- き

- 始まった

- 初心者

- さ

- 信じる

- 以下

- ベンチマーク

- ベンチマーク

- ベンジャミン

- ほかに

- BEST

- より良いです

- の間に

- ビッグ

- 最大の

- 10億

- 出産

- ビット

- ブラック

- ブレンド

- 青

- 本

- 本

- 退屈する

- 生まれる

- 両言語で

- ボックス

- ボックス

- ブランド

- 真新しい

- 明るい

- 持参

- 英国の

- 広い

- 壊れた

- 褐色

- 内蔵

- ビジネス

- ビジネスマン

- 忙しい

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- 購入

- 買収

- by

- 計算された

- 呼ばれます

- ケンブリッジ

- 缶

- 候補者

- 機能

- 機能

- 容量

- 自動車

- カード

- キャリア

- 注意深い

- 実施

- 携帯

- 場合

- 例

- 原因となる

- 生じました

- センター

- 室

- チャンピオンズ

- 変化する

- 変更

- チャネル

- 特徴付けられた

- 文字

- チャート

- 安い

- チェック

- 小切手

- 子

- 子供達

- 中国

- 中国語

- 選択する

- 選択する

- 選ばれた

- クリステンセン

- クリスマス

- クリストファー

- 市町村

- クレーム

- 申立人

- 主張した

- クレーム

- class

- クラス

- 分類

- クリア

- 服

- コーチ

- コード

- 認知

- 造られた

- 同僚

- コレクション

- カレッジ

- カラー

- COLUMBIA

- コラム

- 組み合わせ

- 組み合わせ

- 来ます

- comes

- 快適さ

- 到来

- コメント

- 注釈

- コマーシャル

- コマンドと

- 一般に

- コモンズ

- コミュニケーション

- 企業

- 会社

- 会社の

- 比較します

- 比べ

- 互換性のあります

- コンペ

- コンクール

- 競合他社

- コンプリート

- 記入済みの

- 完了

- 完成

- コンポーネント

- 計算

- 計算

- コンピュータ

- コンピュータサイエンス

- Computer Vision

- コンセプト

- コンセプト

- 結論

- 条件

- 会議

- 紛争

- 相反する

- 接続

- 連続した

- 検討

- 見なさ

- 一貫して

- からなる

- 領事

- コンソール

- 消費する

- 含む

- コンテナ

- 含まれています

- コンテキスト

- 続ける

- 継続します

- 続ける

- 縮小することはできません。

- controls

- 会話

- 株式会社

- 対応する

- 費用

- 可能性

- 国

- コース

- コース

- カバー

- カバー

- カバーする

- 作ります

- 作成した

- 批判

- クロスビー

- 群衆

- クルーズ

- 歯止めをかける

- 電流プローブ

- 現在

- カスタム

- Customers

- カスタマイズ

- ダラス

- データ

- データポイント

- データサイエンス

- データセキュリティ

- データセット

- 日付

- 中

- 日

- 取引

- 死

- 十年

- 決めます

- 減少

- 減少

- 専用の

- 考える

- デフォルト

- 敗北

- 定義します

- 定義済みの

- 定義

- 度

- 配信する

- 需要

- 実証

- 部門

- 依存

- 展開します

- 展開

- 展開する

- 展開

- 説明する

- 記載された

- 設計

- 設計

- にもかかわらず

- 細部

- 開発する

- 発展した

- Developer

- 偏差

- デバイス

- 対話

- 対話

- DID

- 死

- 死んだ

- 異なる

- 違い

- 異なります

- さまざまな形

- 難しい

- 直接

- 直接に

- ディレクトリ

- 割引

- 発見する

- 話し合います

- 議論する

- 議論

- 皿

- ディズニー

- 分散系

- 破壊的な

- 地区

- ディビジョン

- do

- ドキュメンタリー

- ありません

- そうではありません

- すること

- ドメイン

- ドメイン

- 行われ

- ドント

- ダウン

- ドリンク

- ドリブン

- Drop

- ダビングされた

- 原因

- 間に

- e

- E&T

- 各

- 前

- 早い

- 獲得

- EARTH

- 簡単に

- 東

- 東の

- 簡単に

- 食べる

- エドガー

- 教育します

- エドワード

- 効果

- 効果

- 効率的な

- 努力

- 努力

- 卵

- どちら

- el

- ほかに

- 受け入れ

- 従業員

- 雇用

- 有効にする

- 励ます

- end

- エンドポイント

- 終了

- エネルギー

- エンジン

- エンジニアリング

- イングランド

- 英語

- 十分な

- 確保

- エンターテインメント

- 全体

- 環境

- 時代

- エポック

- 等しい

- 装置

- 時代

- エラー

- エッセイ

- 本質

- 設立

- 確立

- 見積もり

- ヨーロッパ

- 評価

- さらに

- イベント

- イベント

- EVER

- あらゆる

- 誰も

- すべてのもの

- 明らか

- 正確に

- 例

- 例

- 優れた

- 交換

- 興奮した

- エキサイティング

- 特別

- 展示会

- 既存の

- 拡大

- 拡大する

- 期待

- 予想される

- 体験

- 実験

- 説明する

- 説明

- 説明

- 表現

- 目

- 実際

- 要因

- 要因

- フェイル

- Failed:

- フェア

- 信仰

- false

- 家族

- 有名な

- ファーム

- スピーディー

- 速いです

- 最速

- お気に入り

- fc

- 妙技

- 特徴

- 特集

- 特徴

- 2月

- フィードバック

- 感じます

- 祭り

- 祭り

- 少数の

- フィクション

- フィールズ

- File

- 提出

- 膜

- ファイナンシャル

- 金融業務

- もう完成させ、ワークスペースに掲示しましたか?

- 企業

- 名

- フィット

- 五

- 艦隊

- フロート

- floating

- フォーカス

- 続いて

- フォロー中

- フード

- フットプリント

- フォーム

- フォーマル

- 形式でアーカイブしたプロジェクトを保存します.

- 形成

- フォーム

- フォーラム

- フォワード

- 将来を見据えた

- 化石

- 発見

- Foundation

- 4

- 第4

- フランス

- フリーズ

- フランス語

- 新鮮な

- 友人

- 友達

- から

- フロント

- さらに

- さらに

- 未来

- ガンマ線

- 集まった

- 一般に

- 生成する

- 世代

- 生々しい

- 生成AI

- 地理

- ジョージ

- ドイツ語

- 取得する

- 受け

- ギフト

- GitHubの

- 与えられた

- 与え

- Go

- ゴエス

- 行く

- 良い

- 良い仕事

- ガバナンス

- GPA

- GPU

- GPU

- 勾配

- 徐々に

- 卒業生

- 草

- 素晴らしい

- 大きい

- 最大

- ギリシャ

- グリーン

- 陸上

- GRT

- ガイド

- 持っていました

- 半分

- ホール

- が起こった

- 起こります

- ハッピー

- ハード

- もっと強く

- ハロルド

- ハーバード

- 持ってる

- he

- 本社

- 本社

- ヘルスケア

- 聞く

- 聞いた

- ヒーロー

- 助けます

- 助け

- ことができます

- それゆえ

- 彼女の

- こちら

- hi

- ハイ

- 高い価値

- より高い

- 最高

- 特徴

- 強調表示

- ヒルズ

- 彼に

- 彼の

- 歴史的

- 歴史的

- history

- ヒット

- 保持している

- ホーム

- 名誉

- うまくいけば

- 期待している

- HOT

- HOURS

- お家の掃除

- 認定条件

- How To

- しかしながら

- HTML

- HTTP

- HTTPS

- 黄

- ハブ

- 巨大な

- ヒューゴー

- 人間

- 百

- 何百

- i

- 私は

- アイデア

- 考え

- 特定され

- 識別する

- if

- ii

- イリノイ州

- 病気

- 錯覚

- 画像

- 直ちに

- 移民

- 影響

- import

- 重要性

- 重要

- 感銘を受けて

- 印象的

- 改善します

- 向上させる

- 改善

- in

- include

- 含まれました

- 含ま

- 含めて

- Incorporated

- 組み込む

- 増える

- 現職

- 確かに

- index

- インディアン

- 屋内

- 情報

- 住民

- イノベーション

- 内部

- を取得する必要がある者

- 機関

- 機関

- 説明書

- 楽器

- 保険

- インテリジェンス

- 意図された

- 関心

- 興味がある

- 興味深い

- 内部で

- 世界全体

- 記事執筆

- に

- 紹介する

- 導入

- 紹介します

- 導入

- 投資する

- 投資

- 投資

- 投資戦略

- 分離された

- 問題

- 問題

- IT

- リーディングシート

- ITS

- ジャック

- ジェームズ

- 1月

- ジョブ

- 参加した

- 参加

- ジョナサン

- JPG

- JSON

- 六月

- ただ

- 一つだけ

- キープ

- キー

- キー

- キッド

- 子供たち

- 殺します

- 種類

- 神様です。

- 知っている

- 既知の

- 韓国

- 韓国語

- カイル

- ラボ

- 土地

- 言語

- 大

- 主として

- より大きい

- 最大の

- 姓

- 遅く

- 後で

- 起動する

- 打ち上げ

- 法律

- 層

- 産む

- つながる

- リーダー

- リード

- リーグ

- LEARN

- 学習

- 最低

- ツェッペリン

- 長さ

- less

- ことができます

- Li

- 図書館

- ライセンス

- 生活

- 光

- ような

- 可能性が高い

- 好き

- 制限

- LINE

- ライン

- 連結

- リスト

- リストされた

- 耳を傾ける

- 訴訟

- ライブ

- 生活

- ll

- ラマ

- ローカル

- 位置して

- 場所

- ロンドン

- 長い

- 長い時間

- より長いです

- 見て

- 探して

- LOOKS

- 失う

- 損失

- 失われた

- たくさん

- 愛

- 愛され

- ロー

- (株)

- 運

- ルナ

- ランチ

- 豪華な

- 機械

- 機械学習

- 製

- マガジン

- メイン

- 維持する

- 保守

- 主要な

- メジャー

- make

- 金をもうける

- 作る

- 作成

- 管理します

- 管理

- マネージャー

- マナンシャー

- 義務的な

- メーカー

- 多くの

- 3月

- 市場

- 市場占有率

- マーキング

- マサチューセッツ州

- マスター

- 材料

- 実質的に

- マトリックス

- 問題

- マックス

- 五月..

- マクドナルド

- me

- 食事

- 意味

- 手段

- 措置

- メダル

- 医療の

- 大会

- ミーツ

- メンバー

- メモリ

- 言及した

- 言及

- Meta

- 方法

- メソッド

- 真ん中

- ミリタリー用(軍用)機材

- ミルトン

- マインド

- 最小

- 混合

- ML

- MLOps

- モデル

- ママ

- 瞬間

- モーメント

- お金

- モニター

- モニター

- 月

- monthly

- 他には?

- 朝

- 最も

- 主に

- 母

- モーション

- 運動

- 映画

- 動画

- mr

- MS

- ずっと

- 多国籍

- の試合に

- 音楽を聴く際のスピーカーとして

- ミュージカル

- ミュージシャン

- しなければなりません

- my

- 名

- 名前付き

- 名

- 狭い

- 鼻

- 国民

- ナチュラル

- 自然言語処理

- ナビゲート

- ナビゲーション

- 必要

- 必要

- ネットワーク

- 決して

- 新作

- 新技術

- ニューヨーク

- ニューヨーク市

- 新しく

- ニュートン

- 次の

- Nintendo

- NLP

- いいえ

- なし

- 通常の

- ノース

- ノート

- ノート

- 何も

- 知らせ..

- 11月

- 今

- 数

- 肥満

- オブジェクト

- 目的

- 義務

- 展望台

- 海洋

- 10月

- of

- オフ

- 提供

- オファー

- Office

- 公式

- 頻繁に

- oh

- on

- かつて

- ONE

- オンライン

- の

- 開いた

- 運営

- オペレーティング

- 業務執行統括

- 光学

- 最適化

- 最適化

- 最適化

- オプション

- オプション

- or

- 夢中

- 注文

- OS

- その他

- その他

- さもないと

- 私たちの

- でる

- 屋外で

- 概説

- 出力

- が

- 全体

- 自分の

- パック

- ページ

- ページ

- 支払われた

- 絵画

- 対になった

- ペイン

- 紙素材

- 論文

- パラドックス

- 並列シミュレーションの設定

- パラメーター

- パラメータ

- 両親

- パリ

- 部

- 参加

- 特定の

- パートナー

- 提携

- 部品

- パス

- 通過

- パス

- パスポート

- 過去

- 経路

- 国

- 平和

- 北京

- のワークプ

- 以下のために

- 割合

- 知覚

- 実行する

- パフォーマンス

- 実行

- 実行

- おそらく

- 人

- 相

- 博士号

- 現象

- 光子

- 物理的な

- 物理学

- 選ぶ

- 画像

- ピンク

- 極めて重要な

- 場所

- 場所

- 計画

- 計画されました

- プラン

- 植物

- プラットフォーム

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- プレイ

- お願いします

- 喜んだ

- 沈んだ

- 便利なポケット付。

- ポイント

- ポイント

- 警察

- 政治的

- プール

- 貧しいです

- 人気

- 人口

- 位置

- 正の

- 可能性

- ポスト

- 潜在的な

- 電力

- 強力な

- 精度

- 好む

- プ

- 準備

- 準備

- 現在

- 一流の

- 前に

- ブランド

- 価格、またオプションについて

- プライベート

- 賞

- 賞品

- 多分

- 問題

- 問題

- プロセス

- ラボレーション

- 処理

- 生産された

- 製品

- プロ

- 専門家

- 東京大学大学院海洋学研究室教授

- 利益

- 演奏曲目

- プログラム

- 予測

- 約束された

- 推進する

- 促進する

- プロパティ

- 提案された

- 提供します

- 提供

- は、大阪で

- 提供

- 準備

- 公然と

- 公表

- 目的

- 目的

- 追求

- 置きます

- Python

- 定性

- 品質

- 四半期

- 質問

- 質問

- より速い

- すぐに

- R

- RAIN

- ランダム

- 範囲

- 測距

- レート

- 比

- RAY

- リーチ

- 読む

- 読者

- リーディング

- 現実

- 本当に

- 不動産業者

- 合理的な

- 受け

- 受け入れ

- 推奨する

- 提言

- 推奨される

- お勧めする

- 記録

- 記録

- レッド

- 軽減

- 削減

- 参照する

- 言及

- 改革

- みなし

- 関係なく

- 地域

- 地域

- 登録

- レジストリ

- 関連する

- 相対的に

- リリース

- 解放

- 関連した

- 依存

- 残っている

- 覚えています

- 削除済み

- 置き換え

- レポート

- レポート

- 倉庫

- 代表者

- 表します

- 要求

- の提出が必要です

- 要件

- 要件

- 必要

- 研究

- 研究者

- 住民

- それらの

- それぞれ

- 反応します

- 応答

- 回答

- 責任

- レストラン

- レストラン

- 結果

- 結果

- 退職

- return

- 返す

- 収入

- 修正します

- 報酬

- リボン

- 米

- 富裕層

- リチャード

- 右

- 上昇

- リスク

- ロード

- ロビン

- ロボット工学

- 岩

- ロッキー

- 職種

- ロール

- 圧延

- 大体

- ラウンド

- ルート

- 行

- ルール

- ラン

- ランニング

- s

- 安全な

- 安全性

- セージメーカー

- 前記

- セーリング

- 給与

- 同じ

- 貯蓄

- 見ました

- 言う

- 格言

- 規模

- 学校

- 科学

- 科学者

- スクリプト

- SDDK

- SEA

- を検索

- 検索エンジン

- 検索

- SEC

- 二番

- 二次

- セクション

- セクション

- 安全に

- 有価証券

- セキュリティ

- 見えた

- と思われる

- 見て

- 選択

- 選択

- シニア

- 文

- ソウル

- 別

- 9月

- シーケンス

- 役立つ

- サービス

- サービス

- セッション

- セッションに

- 設定

- 設定

- いくつかの

- シャード

- シェアする

- shared

- シャルマ

- 彼女

- 船

- 船

- ショッピング

- ショップ

- すべき

- 表示する

- 示されました

- 示す

- 作品

- シャットダウン

- 符号

- 意義

- 重要

- 著しく

- 署名

- シルバー

- 同様の

- 同様に

- 簡単な拡張で

- 簡略化されました

- 単に

- から

- 卿

- 姉妹

- 座る

- ウェブサイト

- 立地

- 状況

- サイズ

- 遅く

- 小さい

- より小さい

- So

- 売ら

- 溶液

- ソリューション

- 解決する

- 一部

- 何か

- 息子

- 歌

- すぐに

- 音

- サウンドトラック

- ソース

- サウス

- 韓国

- 南朝鮮

- サウサンプトン

- 南部の

- スペース

- スペイン語

- 話す

- 専門家

- 専門の

- 特定の

- 特に

- スペクトル

- スピーチ

- スピード

- 過ごす

- いじわる

- split

- スポーツ

- ステージ

- 星

- start

- 開始

- スタートアップ

- 都道府県

- 文

- 米国

- 駅

- 統計的

- 手順

- まだ

- 刺激

- 株式

- ストック

- STONE

- ストレージ利用料

- 店舗

- 戦略

- 強い

- 奮闘

- 学生

- 生徒

- 研究

- 研究

- 勉強

- テーマ

- 成功

- 首尾よく

- そのような

- 示唆する

- 提案する

- まとめる

- 概要

- 夏

- スーパー

- サポート

- サポート

- サポート

- 確か

- 囲まれた

- スイッチ

- スイス

- システム

- テーブル

- 取る

- 撮影

- 取り

- 取得

- Talk

- 会話

- ターゲット

- 対象となります

- 仕事

- タスク

- キー

- 教えた

- Tea

- チーム

- テク

- 技術的

- テクノロジー

- テクノロジー

- 十代の若者たち

- 望遠鏡

- 言う

- 伝える

- template

- テンプレート

- 期間

- 条件

- test

- テスト

- テキサス州

- 클라우드 기반 AI/ML및 고성능 컴퓨팅을 통한 디지털 트윈의 기초 – Edward Hsu, Rescale CPO 많은 엔지니어링 중심 기업에게 클라우드는 R&D디지털 전환의 첫 단계일 뿐입니다. 클라우드 자원을 활용해 엔지니어링 팀의 제약을 해결하는 단계를 넘어, 시뮬레이션 운영을 통합하고 최적화하며, 궁극적으로는 모델 기반의 협업과 의사 결정을 지원하여 신제품을 결정할 때 데이터 기반 엔지니어링을 적용하고자 합니다. Rescale은 이러한 혁신을 돕기 위해 컴퓨팅 추천 엔진, 통합 데이터 패브릭, 메타데이터 관리 등을 개발하고 있습니다. 이번 자리를 빌려 비즈니스 경쟁력 제고를 위한 디지털 트윈 및 디지털 스레드 전략 개발 방법에 대한 인사이트를 나누고자 합니다.

- より

- 感謝

- 感謝

- それ

- エリア

- 情報

- ウェスト

- 世界

- アプリ環境に合わせて

- それら

- 自分自身

- その後

- そこ。

- したがって、

- ボーマン

- 論文

- 彼ら

- もの

- 物事

- 考える

- 考え

- 考え

- この

- それらの

- しかし?

- 考え

- 千

- 三

- 王位

- 介して

- 全体

- 従って

- タイド

- 時間

- <font style="vertical-align: inherit;">回数</font>

- ティナ

- タイトル

- 〜へ

- 今日

- 一緒に

- トークン化

- トークン

- 東京

- トム

- 明日

- トニー

- あまりに

- 取った

- トピック

- トータル

- ツアー

- 町役場

- トレーニング

- 訓練された

- トレーニング

- トランス

- トランスフォーマー

- 輸送

- 旅行

- 試み

- 1兆

- トラブル

- true

- 信頼

- 真実

- 試します

- トルコ語

- オン

- tv

- 2

- type

- 典型的な

- 一般的に

- ui

- 最終的に

- できません

- 不確実性

- 下

- 受ける

- 根本的な

- わかる

- 理解する

- 引き受ける

- ユナイテッド

- 米国

- 大学

- 不要

- まで

- アップデイト

- 更新しました

- 更新版

- アップロード

- アップロード

- に

- us

- つかいます

- 中古

- ユーザー

- 使用されます

- 休暇

- 値

- 価値観

- 多様

- さまざまな

- 野菜

- バージョン

- バージョン

- 非常に

- 、

- ビデオ

- 詳しく見る

- ビュー

- ビジョン

- 訪問

- 投票

- VUE

- wait

- 待っています

- 欲しいです

- wanted

- 望んでいる

- 戦争

- ました

- 洗浄

- よく見る

- 監視

- 水

- 仕方..

- we

- ウェブ

- Webサービス

- ウェブサイト

- ウェブサイト

- 週間

- 週末

- 歓迎

- WELL

- went

- した

- ウェスト

- この試験は

- 何ですか

- どのような

- いつ

- 一方

- かどうか

- which

- while

- 白

- 誰

- 全体

- その

- なぜ

- ワイド

- 広く

- 無線LAN

- 意志

- ウィリアム

- ウィルソン

- win

- ワイン

- 勝利

- 以内

- 無し

- 勝った

- Word

- 言葉

- 仕事

- 働いていました

- ワーカー

- 労働者

- ワーキング

- 作品

- 世界

- 世界の

- 心配して

- 不安

- でしょう

- 書きます

- 作家

- 作家

- 書き込み

- 書かれた

- 間違った

- 年

- 年

- はい

- ヨーク

- You

- 若い

- あなたの

- 若者

- 若者

- ゼファーネット