大規模言語モデル (LLM) は、自然言語処理 (NLP) の分野に革命をもたらし、言語翻訳、テキストの要約、感情分析などのタスクを改善しました。ただし、これらのモデルのサイズと複雑さが増大し続けるにつれて、そのパフォーマンスと動作を監視することがますます困難になってきています。

LLM のパフォーマンスと動作を監視することは、LLM の安全性と有効性を確保するために重要なタスクです。私たちが提案するアーキテクチャは、オンライン LLM モニタリングのためのスケーラブルでカスタマイズ可能なソリューションを提供し、チームがモニタリング ソリューションを特定のユースケースや要件に合わせて調整できるようにします。 AWS のサービスを使用することで、当社のアーキテクチャは LLM の動作をリアルタイムで可視化し、チームが問題や異常を迅速に特定して対処できるようにします。

この投稿では、オンライン LLM モニタリングのいくつかのメトリクスと、次のような AWS サービスを使用したスケールに対応したそれぞれのアーキテクチャを示します。 アマゾンクラウドウォッチ および AWSラムダ。これにより、従来の機能を超えたカスタマイズ可能なソリューションが提供されます。 モデル評価 との仕事 アマゾンの岩盤.

ソリューションの概要

まず考慮すべきことは、メトリクスが異なれば計算上の考慮事項も異なるということです。各モジュールがモデル推論データを取り込み、独自のメトリクスを生成できるモジュール式アーキテクチャが必要です。

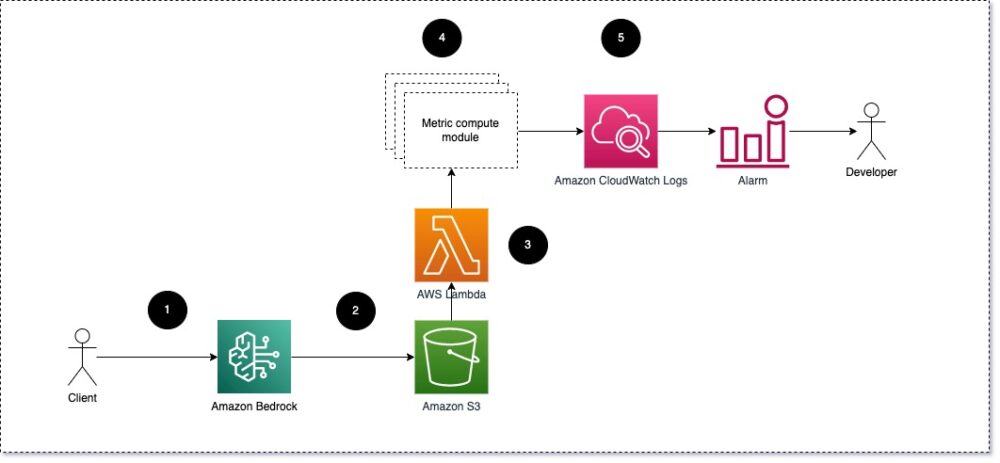

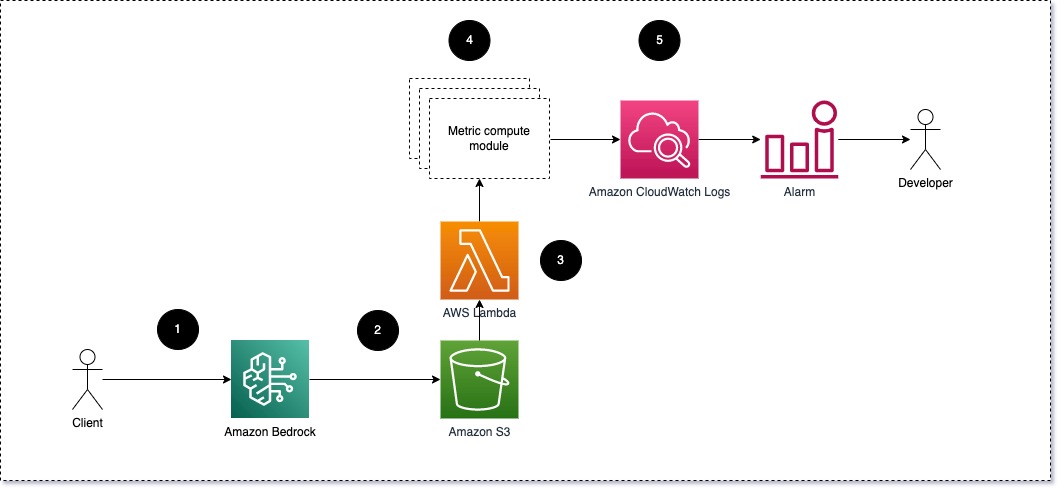

各モジュールが受信した推論リクエストを LLM に受け取り、プロンプトと完了 (応答) のペアをメトリクス計算モジュールに渡すことをお勧めします。各モジュールは、入力プロンプトと完了 (応答) に関する独自のメトリクスを計算する責任があります。これらのメトリクスは CloudWatch に渡され、メトリクスを集約し、CloudWatch アラームと連携して特定の条件で通知を送信できます。次の図は、このアーキテクチャを示しています。

図 1: メトリック計算モジュール – ソリューションの概要

ワークフローには次の手順が含まれます。

- ユーザーは、アプリケーションまたはユーザーインターフェイスの一部として Amazon Bedrock にリクエストを行います。

- Amazon Bedrock はリクエストと完了 (レスポンス) を次の場所に保存します。 Amazon シンプル ストレージ サービス (Amazon S3) の構成に従って 呼び出しログ.

- Amazon S3 に保存されたファイルは、次のイベントを作成します。 トリガされ ラムダ関数。関数はモジュールを呼び出します。

- モジュールはそれぞれのメトリクスを次の場所に投稿します。 CloudWatch メトリクス.

- アラーム 予期しないメトリック値を開発チームに通知することができます。

LLM モニタリングを実装する際に 2 番目に考慮すべきことは、追跡する適切なメトリクスを選択することです。 LLM のパフォーマンスを監視するために使用できる潜在的なメトリクスは数多くありますが、この投稿では最も広範なメトリクスのいくつかについて説明します。

次のセクションでは、関連するモジュール メトリックのいくつかと、それぞれのメトリック計算モジュール アーキテクチャに焦点を当てます。

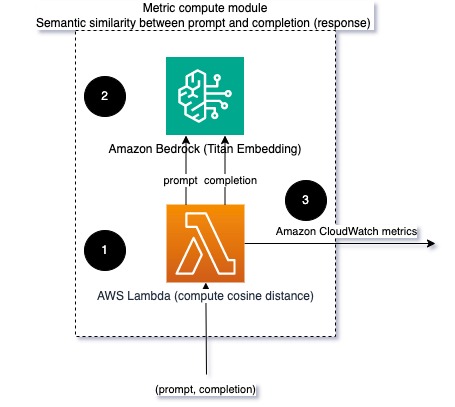

プロンプトと完了 (応答) の意味上の類似性

LLM を実行する場合、各リクエストのプロンプトと完了 (応答) をインターセプトし、埋め込みモデルを使用してそれらを埋め込みに変換できます。埋め込みは、テキストの意味論的な意味を表す高次元ベクトルです。 アマゾンタイタン Titan Embedding を通じてそのようなモデルを提供します。これら 2 つのベクトル間のコサインなどの距離を取ることで、プロンプトと完了 (応答) が意味的にどの程度類似しているかを定量化できます。使用できます SciPy or scikit-学ぶ ベクトル間のコサイン距離を計算します。次の図は、このメトリック計算モジュールのアーキテクチャを示しています。

図 2: メトリック計算モジュール – 意味論的な類似性

このワークフローには、次の主要な手順が含まれています。

- Lambda 関数は、ストリーミング メッセージを次の方法で受信します。 アマゾンキネシス プロンプトと完了 (応答) のペアが含まれます。

- この関数は、プロンプトと完了 (応答) の両方の埋め込みを取得し、2 つのベクトル間のコサイン距離を計算します。

- この関数はその情報を CloudWatch メトリクスに送信します。

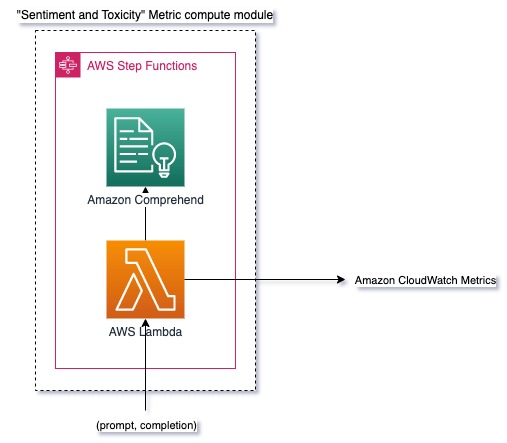

感情と毒性

センチメントをモニタリングすると、全体的なトーンや応答の感情的影響を測定できます。一方、毒性分析は、LLM 出力に攻撃的、無礼、または有害な言葉が存在するかどうかの重要な尺度を提供します。感情や有害性の変化を注意深く監視して、モデルが期待どおりに動作していることを確認する必要があります。次の図は、メトリック計算モジュールを示しています。

図 3: メトリクス計算モジュール – センチメントと有害性

ワークフローには次の手順が含まれます。

- Lambda 関数は、Amazon Kinesis を通じてプロンプトと完了 (応答) のペアを受け取ります。

- AWS Step Functions オーケストレーションを通じて、関数は Amazon Comprehend を検出する 感情 および 毒性.

- この関数は、情報を CloudWatch メトリクスに保存します。

Amazon Comprehend を使用した感情と毒性の検出の詳細については、以下を参照してください。 堅牢なテキストベースの毒性予測因子を構築する および Amazon Comprehend 毒性検出を使用して有害なコンテンツにフラグを立てる.

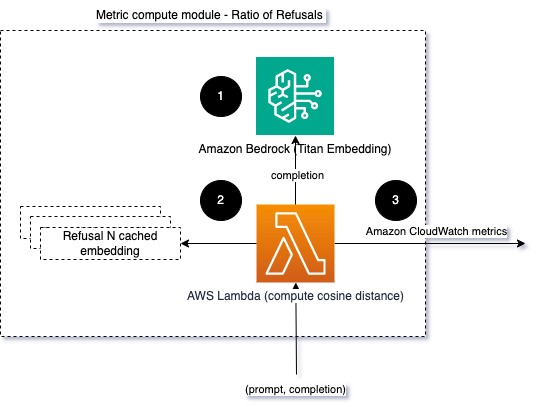

拒否率

情報不足を理由に LLM が完了を拒否する場合など、拒否の増加は、悪意のあるユーザーが脱獄を目的とした方法で LLM を使用しようとしている、またはユーザーの期待が満たされず、ユーザーの要求が満たされていないことを意味している可能性があります。価値の低い応答を取得しています。これがどのくらいの頻度で発生しているかを測定する 2 つの方法は、使用されている LLM モデルからの標準的な拒否と LLM からの実際の応答を比較することです。たとえば、以下は Anthropic の Claude vXNUMX LLM の一般的な拒否フレーズの一部です。

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

固定された一連のプロンプトでは、これらの拒否の増加は、モデルが過度に慎重になっているか、敏感になっている可能性があります。逆の場合も評価する必要があります。これは、モデルが有毒または有害な会話に参加する傾向が高まっていることを示している可能性があります。

整合性のモデル化と拒否率のモデル化を支援するために、応答を LLM からの既知の拒否フレーズのセットと比較できます。これは、モデルがリクエストを拒否した理由を説明できる実際の分類子である可能性があります。応答と、監視対象のモデルからの既知の拒否応答との間のコサイン距離を取得できます。次の図は、このメトリック計算モジュールを示しています。

図 4: メトリクス計算モジュール – 拒否の割合

ワークフローは次の手順で構成されます。

- Lambda 関数はプロンプトと完了 (応答) を受け取り、Amazon Titan を使用して応答から埋め込みを取得します。

- この関数は、応答とメモリにキャッシュされている既存の拒否プロンプトとの間のコサイン距離またはユークリッド距離を計算します。

- この関数は、その平均を CloudWatch メトリクスに送信します。

もう一つの選択肢は、 あいまい一致 既知の拒否を LLM 出力と比較するための単純だが強力ではないアプローチ。を参照してください。 Pythonドキュメント 例として挙げられる。

まとめ

LLM の可観測性は、LLM の信頼できる使用を保証するための重要な実践です。 LLM の精度と信頼性を監視、理解、保証することは、これらの AI モデルに関連するリスクを軽減するのに役立ちます。幻覚、不適切な完了 (応答)、プロンプトを監視することで、LLM が順調に進み、あなたとあなたのユーザーが求めている価値を確実に提供できるようになります。この投稿では、例を紹介するためにいくつかの指標について説明しました。

基礎モデルの評価の詳細については、を参照してください。 SageMaker Clarify を使用して基礎モデルを評価する、追加のブラウズ ノートブックの例 GitHub リポジトリで入手できます。また、LLM 評価を大規模に運用する方法を検討することもできます。 Amazon SageMaker Clear および MLOps サービスを使用して LLM 評価を大規模に運用可能。最後に、以下を参照することをお勧めします。 大規模な言語モデルの品質と責任を評価する LLM の評価について詳しくは、こちらをご覧ください。

著者について

ブルーノクライン は、AWS プロフェッショナル サービス分析プラクティスを担当するシニア機械学習エンジニアです。彼は、顧客がビッグデータと分析ソリューションを実装するのを支援しています。仕事以外では、家族と時間を過ごしたり、旅行したり、新しい食べ物を試したりすることを楽しんでいます。

ブルーノクライン は、AWS プロフェッショナル サービス分析プラクティスを担当するシニア機械学習エンジニアです。彼は、顧客がビッグデータと分析ソリューションを実装するのを支援しています。仕事以外では、家族と時間を過ごしたり、旅行したり、新しい食べ物を試したりすることを楽しんでいます。

ルシャブ・ロカンデ は、AWS プロフェッショナル サービス分析プラクティスを担当するシニア データ & ML エンジニアです。彼は、顧客がビッグデータ、機械学習、分析ソリューションを実装するのを支援しています。仕事以外では、家族と過ごしたり、読書、ランニング、ゴルフを楽しんでいます。

ルシャブ・ロカンデ は、AWS プロフェッショナル サービス分析プラクティスを担当するシニア データ & ML エンジニアです。彼は、顧客がビッグデータ、機械学習、分析ソリューションを実装するのを支援しています。仕事以外では、家族と過ごしたり、読書、ランニング、ゴルフを楽しんでいます。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- :持っている

- :は

- :not

- :どこ

- 1

- 100

- 143

- 32

- 455

- 7

- a

- 私たちについて

- 精度

- 実際の

- NEW

- 住所

- 集計

- AI

- AIアシスタント

- AIモデル

- ことができます

- また

- しかし

- am

- Amazon

- Amazon Comprehend

- アマゾンキネシス

- アマゾンセージメーカー

- Amazon Webサービス

- an

- 分析

- 分析論

- および

- 異常

- 人間原理

- どれか

- 申し込み

- アプローチ

- アプローチ

- 建築

- です

- AS

- アシスタント

- 関連する

- At

- 利用できます

- 平均

- AWS

- AWSプロフェッショナルサービス

- AWSステップ関数

- 悪い

- BE

- になる

- 行動

- さ

- の間に

- 越えて

- ビッグ

- ビッグデータ

- 両言語で

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- コール

- 缶

- 場合

- 例

- 用心深い

- 挑戦

- 選択する

- 分類します

- 密接に

- コマンドと

- 比較します

- 比較

- 完成

- 複雑さ

- 理解する

- 計算

- 計算

- コンピューティング

- 条件

- 検討

- 検討事項

- からなる

- コンテンツ

- コンテキスト

- 続ける

- 会話

- 可能性

- 作成した

- 作成します。

- 重大な

- Customers

- カスタマイズ可能な

- データ

- 提供します

- 実証します

- 検出

- 開発

- 開発チーム

- ダイアグラム

- 異なります

- 議論する

- 距離

- do

- 原因

- 各

- 有効

- どちら

- 埋め込み

- 可能

- 有効にする

- 従事する

- エンジニア

- 十分な

- 確保

- 確保する

- 評価する

- 評価

- 評価します

- 評価

- 評価

- イベント

- 例

- 例

- 既存の

- 期待

- 予想される

- 説明する

- 探る

- 家族

- 少数の

- フィールド

- イチジク

- File

- 最後に

- 名

- 固定の

- フォロー中

- フード

- Foundation

- から

- function

- 機能

- ゲージ

- を取得

- 受け

- GitHubの

- ゴルフ

- 成長する

- 出来事

- 有害な

- 持ってる

- he

- 助けます

- 役立つ

- ことができます

- 特徴

- 正直な

- 認定条件

- しかしながら

- HTML

- HTTP

- HTTPS

- i

- 識別する

- 説明する

- 影響

- 実装する

- 実装

- 重要

- 改善

- in

- 含ま

- 入ってくる

- 増える

- ますます

- 情報

- 整合性

- 意図された

- インタフェース

- に

- 逆の

- 呼び出す

- 問題

- IT

- ITS

- 脱獄

- Jobs > Create New Job

- JPG

- キー

- 既知の

- 欠如

- 言語

- 大

- LEARN

- 学習

- less

- LLM

- 探して

- 機械

- 機械学習

- make

- 作る

- 悪意のある

- 多くの

- 意味する

- 意味

- だけど

- メモリ

- メッセージ

- 会った

- メトリック

- メトリック

- 軽減する

- ML

- MLOps

- モデル

- モジュラー

- モジュール

- モジュール

- モニター

- 監視対象

- モニタリング

- 他には?

- ナチュラル

- 自然言語処理

- 必要

- 新作

- NLP

- 通知

- 今

- of

- 攻撃

- オファー

- 頻繁に

- on

- ONE

- もの

- オンライン

- オプション

- or

- 編成

- 私たちの

- 出力

- outputs

- 外側

- 全体

- 概要

- 自分の

- ペア

- 足

- 部

- 渡された

- 通過

- 以下のために

- パフォーマンス

- フレーズ

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 再生

- 可能

- ポスト

- 潜在的な

- 強力な

- 練習

- プレゼンス

- 処理

- 作り出す

- プロ

- プロンプト

- 提案された

- 提供します

- は、大阪で

- Python

- 品質

- すぐに

- 比

- リーディング

- への

- 受け取り

- 推奨する

- 参照する

- 拒否

- 拒否した

- 関連した

- 信頼性

- 信頼性のある

- 倉庫

- 表す

- 要求

- リクエスト

- 必要とする

- 要件

- 尊重

- それらの

- 応答

- 回答

- 責任

- 革命を起こした

- 右

- リスク

- 堅牢な

- ランニング

- 安全性

- セージメーカー

- 保存されました

- ド電源のデ

- 規模

- 二番

- セクション

- セマンティック

- 送信

- 送る

- シニア

- 敏感な

- 感情

- サービス

- セッションに

- シフト

- すべき

- ショーケース

- シグナル

- 同様の

- 簡単な拡張で

- サイズ

- 溶液

- ソリューション

- 一部

- 空間の

- 特定の

- 支出

- 標準

- 手順

- ステップ

- ストレージ利用料

- 簡単な

- ストリーミング配信

- そのような

- 示唆する

- 確か

- テーラー

- 取る

- 取得

- 仕事

- タスク

- チーム

- チーム

- テクニック

- 클라우드 기반 AI/ML및 고성능 컴퓨팅을 통한 디지털 트윈의 기초 – Edward Hsu, Rescale CPO 많은 엔지니어링 중심 기업에게 클라우드는 R&D디지털 전환의 첫 단계일 뿐입니다. 클라우드 자원을 활용해 엔지니어링 팀의 제약을 해결하는 단계를 넘어, 시뮬레이션 운영을 통합하고 최적화하며, 궁극적으로는 모델 기반의 협업과 의사 결정을 지원하여 신제품을 결정할 때 데이터 기반 엔지니어링을 적용하고자 합니다. Rescale은 이러한 혁신을 돕기 위해 컴퓨팅 추천 엔진, 통합 데이터 패브릭, 메타데이터 관리 등을 개발하고 있습니다. 이번 자리를 빌려 비즈니스 경쟁력 제고를 위한 디지털 트윈 및 디지털 스레드 전략 개발 방법에 대한 인사이트를 나누고자 합니다.

- それ

- 情報

- アプリ環境に合わせて

- それら

- そこ。

- ボーマン

- 彼ら

- もの

- この

- 介して

- 時間

- タイタン

- 〜へ

- TONE

- 追跡する

- 最適化の適用

- インタビュー

- 旅行

- 信頼できる

- しよう

- 2

- 理解する

- 予期しない

- つかいます

- 中古

- ユーザー

- ユーザーインターフェース

- users

- 値

- 価値観

- 、

- 視認性

- 仕方..

- 方法

- we

- ウェブ

- Webサービス

- この試験は

- 何ですか

- いつ

- 一方

- which

- なぜ

- Wikipedia

- 仕事

- ワークフロー

- You

- あなたの

- ゼファーネット