Duże modele językowe (LLM) z miliardami parametrów są obecnie na czele przetwarzania języka naturalnego (NLP). Modele te wstrząsają dziedziną dzięki swoim niesamowitym zdolnościom do generowania tekstu, analizowania nastrojów, tłumaczenia języków i nie tylko. Dzięki dostępowi do ogromnych ilości danych LLM mogą zrewolucjonizować sposób, w jaki wchodzimy w interakcję z językiem. Chociaż LLM są w stanie wykonywać różne zadania NLP, są uważani za ogólnych, a nie za specjalistów. Aby wyszkolić LLM, aby stał się ekspertem w określonej dziedzinie, zwykle wymagane jest dopracowanie.

Jednym z głównych wyzwań w szkoleniu i wdrażaniu LLM z miliardami parametrów jest ich rozmiar, który może utrudniać dopasowanie ich do pojedynczych procesorów graficznych, sprzętu powszechnie używanego do głębokiego uczenia. Sama skala tych modeli wymaga zasobów obliczeniowych o wysokiej wydajności, takich jak wyspecjalizowane procesory graficzne z dużą ilością pamięci. Ponadto rozmiar tych modeli może sprawić, że będą one kosztowne obliczeniowo, co może znacznie wydłużyć czas uczenia i wnioskowania.

W tym poście pokazujemy, jak możemy użyć Amazon SageMaker JumpStart aby łatwo dostroić model generowania tekstu w dużym języku na zbiorze danych specyficznym dla domeny w taki sam sposób, w jaki trenowałbyś i wdrażał dowolny model na Amazon Sage Maker. W szczególności pokazujemy, w jaki sposób można dostroić model językowy GPT-J 6B do generowania tekstów finansowych, używając zarówno pakietu JumpStart SDK, jak i Studio Amazon SageMaker UI w publicznie dostępnym zbiorze danych o zgłoszeniach SEC.

JumpStart pomaga szybko i łatwo rozpocząć pracę z uczeniem maszynowym (ML) i zapewnia zestaw rozwiązań dla najczęstszych przypadków użycia, które można łatwo przeszkolić i wdrożyć w zaledwie kilku krokach. Wszystkie kroki w tej demonstracji są dostępne w dołączonym notatniku Precyzyjne dostrajanie modelu generowania tekstu GPT-J 6B na zbiorze danych specyficznym dla domeny.

Omówienie rozwiązania

W poniższych sekcjach przedstawiamy demonstrację krok po kroku dostrajania LLM do zadań generowania tekstu za pośrednictwem interfejsu użytkownika JumpStart Studio i zestawu Python SDK. W szczególności omawiamy następujące tematy:

- Przegląd danych zgłoszenia SEC w domenie finansowej, na której model jest dopracowany

- Przegląd modelu LLM GPT-J 6B, który wybraliśmy do dopracowania

- Demonstracja dwóch różnych sposobów, w jakie możemy dostroić LLM za pomocą JumpStart:

- Korzystaj programowo z JumpStart z SageMaker Python SDK

- Uzyskaj dostęp do JumpStart za pomocą interfejsu użytkownika Studio

- Ocena modelu dostrojonego poprzez porównanie go z modelem wstępnie wytrenowanym bez dostrajania

Dostrajanie odnosi się do procesu przyjmowania wstępnie wytrenowanego modelu językowego i trenowania go do innego, ale powiązanego zadania przy użyciu określonych danych. To podejście jest również znane jako przenieś naukę, która polega na przenoszeniu zdobytej wiedzy z jednego zadania do drugiego. LLM, takie jak GPT-J 6B, są szkolone na ogromnych ilościach nieoznakowanych danych i mogą być dostrajane na mniejszych zestawach danych, dzięki czemu model działa lepiej w określonej domenie.

Jako przykład poprawy wydajności, gdy model jest dostrajany, rozważ zadanie mu następującego pytania:

„Co napędza wzrost sprzedaży w Amazon?”

Bez dostrajania odpowiedź byłaby następująca:

„Amazon jest największym na świecie sprzedawcą internetowym. Jest to również największy na świecie rynek online. To także świat”

Po dokładnym dostrojeniu odpowiedź brzmi:

„Wzrost sprzedaży w Amazon jest napędzany głównie przez zwiększone wykorzystanie klientów, w tym większy wybór, niższe ceny i większą wygodę, a także zwiększoną sprzedaż innych sprzedawców na naszych stronach internetowych”.

Poprawa wynikająca z precyzyjnego dostrajania jest oczywista.

Używamy tekstu finansowego z dokumentów SEC, aby dostroić GPT-J 6B LLM do zastosowań finansowych. W następnych sekcjach przedstawimy dane i LLM, które zostaną dostrojone.

Zbiór danych zgłoszenia SEC

Dokumenty SEC mają kluczowe znaczenie dla regulacji i ujawniania informacji w finansach. Zgłoszenia powiadamiają społeczność inwestorów o warunkach biznesowych firm i perspektywach spółek na przyszłość. Tekst w dokumentach SEC obejmuje całą gamę operacji i warunków biznesowych firmy. Ze względu na ich potencjalną wartość prognostyczną, zgłoszenia te są dobrym źródłem informacji dla inwestorów. Chociaż te zgłoszenia SEC są publicznie dostępne dla każdego, pobieranie przeanalizowanych plików i tworzenie czystego zestawu danych z dodatkowymi funkcjami jest czasochłonnym zajęciem. Umożliwiamy to w kilku wywołaniach API w JumpStart Branżowe SDK.

Korzystając z interfejsu API SageMaker, pobraliśmy roczne raporty (Opiłki 10-K; widzieć Jak czytać 10-K aby uzyskać więcej informacji) dla wielu firm. Jako dane szkoleniowe do dopracowania modelu GPT-J 2021B wybieramy raporty składane przez Amazon do SEC za lata 2022–6. W szczególności łączymy raporty składane przez SEC firmy w różnych latach w jeden plik tekstowy, z wyjątkiem sekcji „Dyskusja i analiza kierownictwa”, która zawiera stwierdzenia kierownictwa firmy wybiegające w przyszłość i jest wykorzystywana jako dane do walidacji.

Oczekuje się, że po dopracowaniu modelu generowania tekstu GPT-J 6B w finansowych dokumentach SEC, model będzie w stanie generować wnikliwe wyniki tekstowe związane z finansami, a zatem może być używany do rozwiązywania wielu zadań NLP specyficznych dla domeny.

Model dużego języka GPT-J 6B

GPT-J 6B to model typu open source o 6 miliardach parametrów wydany przez Eleuther AI. GPT-J 6B został przeszkolony na dużym zbiorze danych tekstowych i jest w stanie wykonywać różne zadania NLP, takie jak generowanie tekstu, klasyfikacja tekstu i podsumowanie tekstu. Chociaż ten model jest imponujący w przypadku wielu zadań NLP bez potrzeby dostrajania, w wielu przypadkach konieczne będzie dostrojenie modelu do określonego zestawu danych i zadań NLP, które próbujesz rozwiązać. Przypadki użycia obejmują niestandardowe chatboty, generowanie pomysłów, wyodrębnianie jednostek, klasyfikację i analizę nastrojów.

Uzyskaj dostęp do LLM w SageMaker

Teraz, gdy zidentyfikowaliśmy zbiór danych i model, który zamierzamy dopracować, JumpStart zapewnia dwie możliwości rozpoczęcia korzystania z dostrajania generowania tekstu: SageMaker SDK i Studio.

Używaj programu JumpStart z pakietem SDK SageMaker

Omówimy teraz przykład, w jaki sposób możesz użyć SageMaker JumpStart SDK, aby uzyskać dostęp do LLM (GPT-J 6B) i dostosować go do zbioru danych SEC. Po zakończeniu dostrajania wdrożymy dopracowany model i wyciągniemy z niego wnioski. Wszystkie kroki opisane w tym poście są dostępne w załączonym notatniku: Precyzyjne dostrajanie modelu generowania tekstu GPT-J 6B na zbiorze danych specyficznym dla domeny.

W tym przykładzie JumpStart używa Pojemnik do głębokiego uczenia SageMaker przytulający twarz (DLC) i Głęboka prędkość bibliotekę, aby dostroić model. Biblioteka DeepSpeed została zaprojektowana w celu zmniejszenia zużycia mocy obliczeniowej i pamięci oraz szkolenia dużych rozproszonych modeli z lepszą równoległością na istniejącym sprzęcie komputerowym. Obsługuje szkolenie rozproszone w jednym węźle, wykorzystując punkty kontrolne gradientu i równoległość modeli do trenowania dużych modeli w pojedynczej instancji szkoleniowej SageMaker z wieloma procesorami graficznymi. Dzięki JumpStart integrujemy bibliotekę DeepSpeed z DLC SageMaker Hugging Face i zajmujemy się wszystkim pod maską. Możesz łatwo dostosować model do zestawu danych specyficznego dla domeny bez konieczności ręcznego konfigurowania go.

Dostosuj wstępnie wytrenowany model na podstawie danych specyficznych dla domeny

Aby dostroić wybrany model, musimy uzyskać URI tego modelu, a także skrypt szkoleniowy i obraz kontenera używany do szkolenia. Aby to ułatwić, te trzy dane wejściowe zależą wyłącznie od nazwy modelu, wersji (lista dostępnych modeli, patrz Wbudowane algorytmy ze wstępnie wytrenowaną tabelą modeli) oraz typ instancji, na której chcesz trenować. Widać to w następującym fragmencie kodu:

Odzyskujemy model_id odpowiadający temu samemu modelowi, którego chcemy użyć. W tym przypadku dopracowujemy huggingface-textgeneration1-gpt-j-6b.

Definiowanie hiperparametrów polega na ustawianiu wartości dla różnych parametrów używanych podczas procesu uczenia modelu ML. Parametry te mogą wpływać na wydajność i dokładność modelu. W następnym kroku ustalamy hiperparametry, wykorzystując ustawienia domyślne i określając niestandardowe wartości parametrów, takich jak epochs i learning_rate:

JumpStart zapewnia obszerną listę hiperparametrów dostępnych do dostrojenia. Poniższa lista zawiera przegląd części kluczowych hiperparametrów wykorzystywanych do dostrajania modelu. Pełna lista hiperparametrów znajduje się w notatniku Precyzyjne dostrajanie modelu generowania tekstu GPT-J 6B na zbiorze danych specyficznym dla domeny.

- epoki – Określa maksymalnie, ile epok oryginalnego zbioru danych będzie iterowanych.

- wskaźnik_nauczenia – Kontroluje wielkość kroku lub szybkość uczenia się algorytmu optymalizacji podczas treningu.

- ewaluacja_kroków – Określa, ile kroków należy wykonać przed oceną modelu na zbiorze walidacyjnym podczas uczenia. Zestaw sprawdzania poprawności jest podzbiorem danych, który nie jest używany do uczenia, ale służy do sprawdzania wydajności modelu na niewidocznych danych.

- spadek_wagi – Kontroluje siłę regularyzacji podczas treningu modelu. Regularyzacja to technika, która pomaga zapobiegać nadmiernemu dopasowaniu danych szkoleniowych przez model, co może skutkować lepszą wydajnością na niewidocznych danych.

- Fp16 – Kontroluje, czy używać treningu precyzyjnego fp16 16-bitowego (mieszanego) zamiast szkolenia 32-bitowego.

- strategia_oceny – Strategia ewaluacji stosowana podczas szkolenia.

- gradient_akumulacji_kroków – Liczba kroków aktualizacji, dla których należy zgromadzić gradienty, przed wykonaniem przejścia wstecz/aktualizacji.

Więcej informacji na temat hiperparametrów można znaleźć w oficjalnym dokumencie Dokumentacja Trenera Przytulania Twarzy.

Możesz teraz dostroić ten model JumpStart do swojego własnego niestandardowego zestawu danych za pomocą SageMaker SDK. Korzystamy z danych zgłoszenia SEC, które opisaliśmy wcześniej. Dane pociągu i walidacji są hostowane pod train_dataset_s3_path i validation_dataset_s3_path. Obsługiwany format danych obejmuje CSV, JSON i TXT. Dla danych CSV i JSON używane są dane tekstowe z kolumny o nazwie text lub pierwszą kolumnę, jeśli nie zostanie znaleziona żadna kolumna o nazwie tekst. Ponieważ służy to do precyzyjnego dostrajania generowania tekstu, nie są wymagane żadne podstawowe etykiety prawdy. Poniższy kod to przykład zestawu SDK, jak dostroić model:

Po skonfigurowaniu SageMaker Estimator z wymaganymi hiperparametrami, tworzymy instancję estymatora SageMaker i wywołujemy .fit metodę, aby rozpocząć dostrajanie naszego modelu, przekazując go Usługa Amazon Simple Storage (Amazon S3) URI dla naszych danych treningowych. Jak widać, tzw entry_point podany skrypt ma nazwę transfer_learning.py (tak samo dla innych zadań i modeli), a kanał danych wejściowych przekazywany do .fit musi mieć nazwę pociąg i walidacja.

JumpStart obsługuje również optymalizację hiperparametrów za pomocą Automatyczne dostrajanie modelu SageMaker. Aby uzyskać szczegółowe informacje, zobacz przykład notatnik.

Wdróż dostrojony model

Po zakończeniu szkolenia możesz wdrożyć swój dostrojony model. Aby to zrobić, wszystko, co musimy uzyskać, to identyfikator URI skryptu wnioskowania (kod, który określa, w jaki sposób model jest używany do wnioskowania po wdrożeniu) oraz identyfikator URI obrazu kontenera wnioskowania, który zawiera odpowiedni serwer modelu do hostowania wybranego przez nas modelu. Zobacz następujący kod:

Po kilku minutach nasz model zostaje wdrożony i możemy uzyskać z niego prognozy w czasie rzeczywistym!

Uzyskaj dostęp do JumpStart przez interfejs użytkownika Studio

Innym sposobem dostrajania i wdrażania modeli JumpStart jest interfejs użytkownika Studio. Ten interfejs użytkownika zapewnia rozwiązanie z małą ilością kodu/bez kodu do precyzyjnego dostrajania LLM.

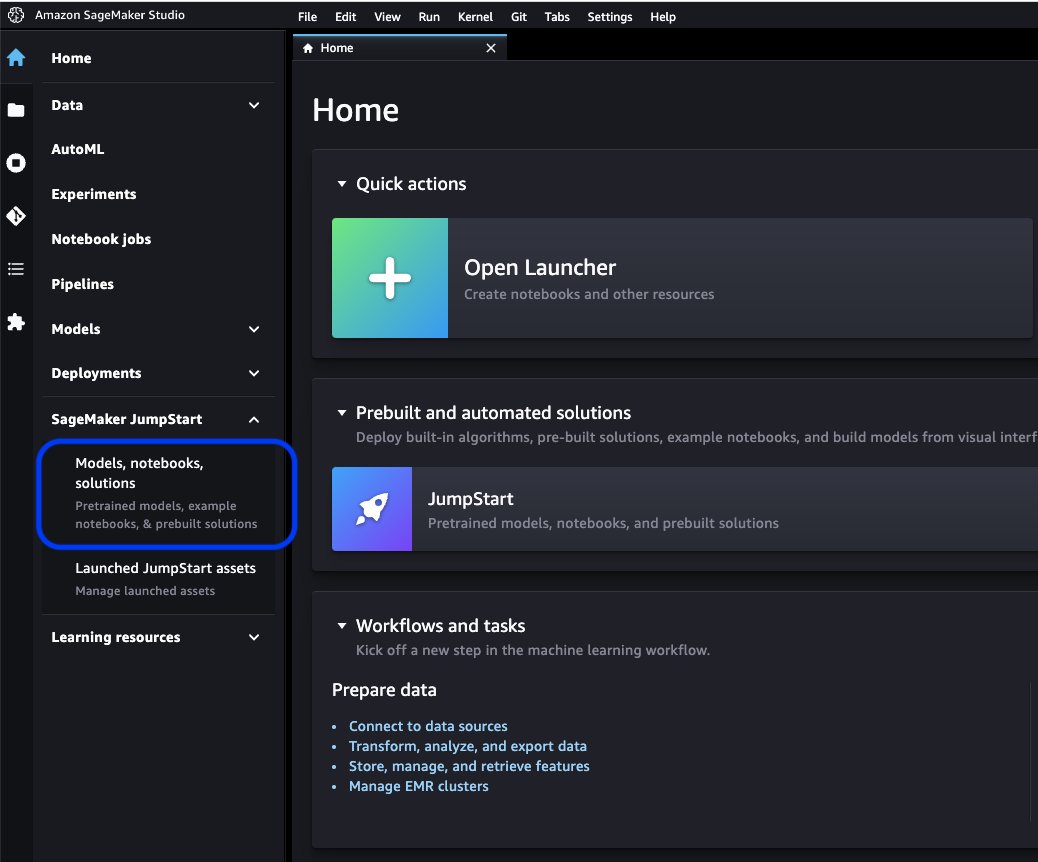

W konsoli Studio wybierz Modele, notebooki, rozwiązania dla SageMaker Szybki start w okienku nawigacji.

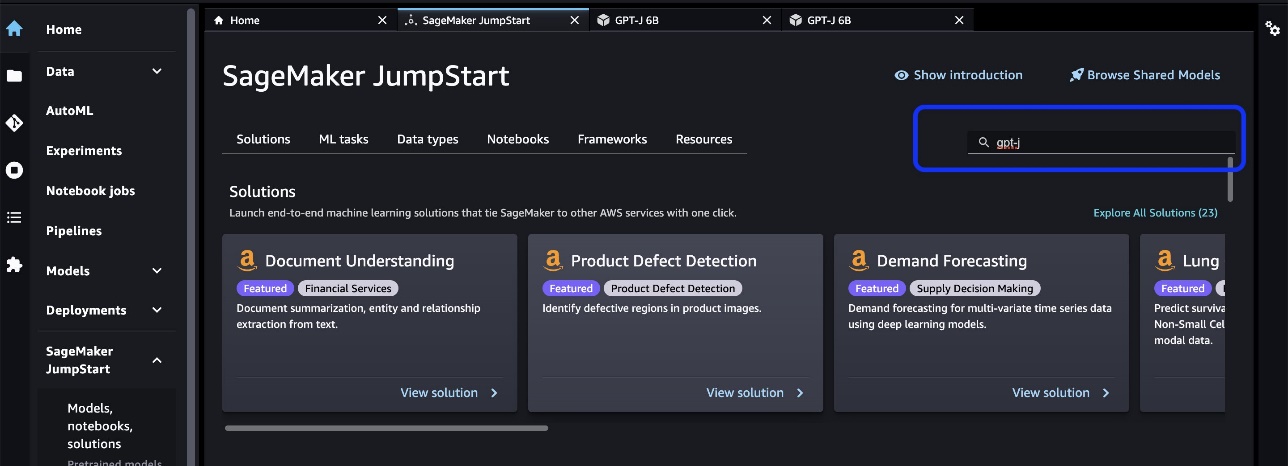

Na pasku wyszukiwania wyszukaj model, który chcesz dostroić i wdrożyć.

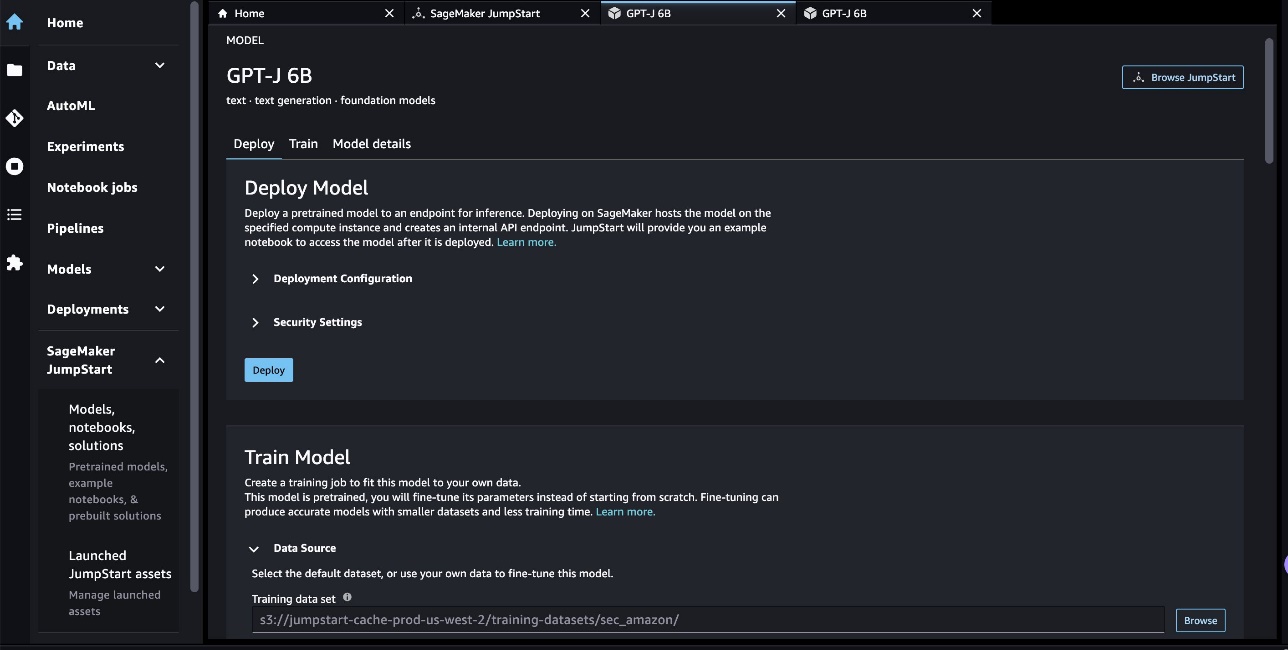

W naszym przypadku wybraliśmy kartę modelu GPT-J 6B. Tutaj możemy bezpośrednio dostroić lub wdrożyć LLM.

Ocena modelu

Podczas oceny LLM możemy użyć zakłopotania (PPL). PPL jest powszechną miarą tego, jak dobrze model językowy jest w stanie przewidzieć następne słowo w sekwencji. Mówiąc prościej, jest to sposób na zmierzenie, jak dobrze model rozumie i generuje język podobny do ludzkiego.

Niższy wynik zakłopotania oznacza, że model lepiej radzi sobie z przewidywaniem następnego słowa. W praktyce możemy wykorzystać zakłopotanie do porównania różnych modeli językowych i określenia, który z nich lepiej radzi sobie z danym zadaniem. Możemy go również użyć do śledzenia wydajności pojedynczego modelu w czasie. Aby uzyskać więcej informacji, patrz Zakłopotanie modeli o stałej długości.

Oceniamy wydajność modelu poprzez porównanie jego wydajności przed i po dostrajaniu. PPL jest emitowany w zadaniach szkoleniowych Amazon Cloud Watch logi. Ponadto przyglądamy się wynikom generowanym przez model w odpowiedzi na określone monity testowe.

| Metryka oceny danych walidacyjnych | Przed dostrojeniem | Po dostrojeniu |

| Zakłopotanie (PPL) | 8.147 | 1.437 |

Zwiększoną wydajność modelu wykazano w dwóch eksperymentach:

- Generowanie tekstu – Pokazujemy, że dane wyjściowe precyzyjnie dostrojonego GPT-J generują tekst przypominający zestaw danych SEC, co wskazuje, że nauczył się naśladować wzorce językowe i konwencje domeny regulacji finansowych

- Uczenie zerowe – Wykazaliśmy, że precyzyjnie dostrojony GPT-J wykazuje znacznie lepszą wydajność niż nieprecyzyjnie dostrojony GPT-J w odpowiedzi na pytanie zero-shot

W eksperymencie generowania tekstu używamy następujących parametrów wnioskowania, aby osiągnąć nasze wyniki: max_length 400 (liczba zwróconych tokenów), num_return_sequences z 1 (liczba przykładów tekstów odpowiedzi), top_k 250 (wybierz jedną z 250 najlepszych możliwych kontynuacji), top_p 0.8 (wybierz tylko z kontynuacji, które są co najmniej w 80% prawdopodobne), do_sample is True (pobieranie próbek) i temperature 1 (wysoka temperatura to większa losowość odpowiedzi). Aby uzyskać więcej informacji na temat parametrów, patrz GeneracjaKonfiguracja. Poniższa tabela porównuje precyzyjnie dostrojony GPT-J i niedopasowany GPT-J w zadaniu uzupełniania tekstu.

| Przykład wnioskowania | Wyjście z GPT-J 6B przed dostrajaniem | Wyjście z GPT-J 6B po dostrojeniu |

| Ten raport na formularzu 10-K to pokazuje |

Ten raport na formularzu 10-K pokazuje, że: Zysk netto Spółki przypadający na Spółkę za rok zakończony 31 grudnia 2016 r. wyniósł 3,923,000 0.21 3,818,000 USD, czyli 0.21 USD na rozwodnioną akcję, w porównaniu do 31 2015 XNUMX USD, czyli XNUMX USD na rozwodnioną akcję, za rok zakończony XNUMX grudnia XNUMX r. Zysk netto Spółki przypadający na Spółkę za rok zakończony 31 grudnia 2016 r. wyniósł 4,816,000 0.28 4,726,000 USD, czyli 0.27 USD na rozwodnioną akcję, w porównaniu do 31 2015 XNUMX USD, czyli XNUMX USD na rozwodnioną akcję, za rok zakończony XNUMX grudnia XNUMX r. Zysk netto Spółki przypadający na Spółkę za rok zakończony 31 grudnia 2016 r. wyniósł 5,828,000 0.34 5,716,000 USD, czyli 0.33 USD na rozwodnioną akcję, w porównaniu do 31 2015 XNUMX USD, czyli XNUMX USD na rozwodnioną akcję, za rok zakończony XNUMX grudnia XNUMX r. W dniu 21 sierpnia 2009 roku Spółka złożyła Formularz 10-Q za kwartał zakończony 31 grudnia 2008 roku. W dniu 21 sierpnia 2009 roku Spółka złożyła Formularz 10-Q za kwartał zakończony 30 września 2008 roku. W dniu 21 sierpnia 2009 roku Spółka złożyła formularz 10-Q za kwartał zakończony 31 marca 2009 roku. |

Ten raport na formularzu 10-K pokazuje, że:(1) Nazwa, adres i numer telefonu rejestrującego są następujące: Amazon.com, Inc. c/o Ernst & Young LLPSeattle, Washington Uwaga: Corporate Secretary (2) Dla zgodnie z art. III Ustawy o obrocie papierami wartościowymi z 1934 r., nazwa i adres rejestrującego są następujące:(3) Okres sprawozdawczy rejestrującego zgodnie z Ustawą o obrocie papierami wartościowymi obejmuje okres od 1 stycznia 2020 r. włącznie do chwili obecnej.(4) Subiektywna ocena rejestrującego: że sprawozdanie finansowe i inne informacje finansowe zawarte w niniejszym raporcie rzetelnie przedstawiają we wszystkich istotnych aspektach sytuację finansową, wyniki działalności i przepływy pieniężne podmiotu rejestrującego na dzień i za okresy przedstawione w niniejszym raporcie.(5) Kierownictwo podmiotu rejestrującego oceniamy, że sprawozdanie finansowe oraz inne informacje finansowe zawarte w niniejszym raporcie rzetelnie przedstawiają we wszystkich istotnych aspektach sytuację finansową, wyniki działalności oraz przepływy pieniężne podmiotu rejestrującego na dzień i za okresy prezentowane w niniejszym raporcie./s/ Ernst & Young LLSeattle, Washington 29 stycznia 2020 r. EX-31.1 5 amzn-20201231xex311.htm Dokument EX-31.1 Dowód 31.1 CERTYFIKATYSI, Andrew R. Jassy, zaświadczam, że:1. Zapoznałem się z tym formularzem 10-K firmy Amazon.com, Inc.;2. Według mojej wiedzy niniejszy raport nie zawiera nieprawdziwych stwierdzeń istotnych faktów ani pominięć istotnych faktów niezbędnych do tego, aby złożone oświadczenia, w świetle okoliczności, w których zostały złożone, nie wprowadzały w błąd co do okresu objętego niniejszym raport; |

| Obsługujemy konsumentów poprzez |

Obsługujemy konsumentów poprzez: Nasz Blog Jesteś właścicielem firmy i chcesz rozwijać swój biznes? Chcesz stworzyć bardziej efektywny i wydajny biznes? Chcesz dowiedzieć się, jak rozwijać swój biznes? Jeśli odpowiedziałeś „tak” na którekolwiek z tych pytań, musisz przeczytać ten artykuł. Pierwszym krokiem do rozwoju firmy jest jej zrozumienie. Musisz być w stanie odpowiedzieć na następujące pytania dotyczące Twojej firmy: Kim są twoi klienci? Jaki jest Twój produkt lub usługa? Jaka jest Twoja wyjątkowa propozycja sprzedaży? Jaka jest Twoja strategia marketingowa? Jaka jest Twoja prognoza sprzedaży? Jaka jest Twoja prognoza sprzedaży? Jaka jest Twoja prognoza sprzedaży? Jaka jest Twoja prognoza sprzedaży? Jaka jest Twoja prognoza sprzedaży? |

Obsługujemy konsumentów poprzez: Amazon.com, sprzedawcę produktów fizycznych i cyfrowych; Amazon Web Services, która świadczy usługi w zakresie infrastruktury technologicznej, które umożliwiają prowadzenie praktycznie każdego rodzaju działalności; Amazon Enterprise Solutions, która zapewnia firmom niestandardowe technologie i usługi umożliwiające usprawnienie procesów biznesowych oraz poprawę wydajności i produktywności; oraz Audible, wydawca cyfrowych audiobooków. Obsługujemy programistów i przedsiębiorstwa każdej wielkości za pośrednictwem platformy AWS, która oferuje szeroki zestaw globalnych rozwiązań obliczeniowych, pamięci masowej, baz danych i innych usług. Zajmujemy się również produkcją i sprzedażą urządzeń elektronicznych. Zorganizowaliśmy naszą działalność w dwóch głównych segmentach: Ameryka Północna i Międzynarodowy. Patrz punkt 8 w Części II, „”Sprawozdania finansowe i dane uzupełniające-Nota 12-informacje o segmentach.” Patrz punkt 7 w Części II, „”Omówienie i analiza kierownictwa na temat sytuacji finansowej i wyników działalności-Wyniki działalności-Informacje uzupełniające” ”, aby uzyskać dodatkowe informacje o naszej sprzedaży netto. Konsumenci Obsługujemy konsumentów za pośrednictwem naszych sklepów internetowych i stacjonarnych, koncentrując się na wyborze, cenie i wygodzie. Projektujemy nasze sklepy tak, aby umożliwić sprzedaż setek milionów unikalnych produktów przez nas i osoby trzecie w dziesiątkach kategorii produktów. Klienci uzyskują dostęp do naszej oferty za pośrednictwem naszych stron internetowych, aplikacji mobilnych, Alexy i fizycznie odwiedzając nasze sklepy. Zajmujemy się również produkcją i sprzedażą Kindledevices. Staramy się oferować naszym klientom najniższe możliwe ceny poprzez codzienne ustalanie cen produktów i oferty wysyłkowe oraz poprawiać naszą efektywność operacyjną, abyśmy mogli nadal obniżać ceny dla naszych klientów. Zapewniamy również łatwą w użyciu funkcjonalność, szybką i niezawodną realizację oraz terminową obsługę klienta. Ponadto oferujemy Amazon Prime, program członkowski, który obejmuje nieograniczoną bezpłatną wysyłkę ponad 100 milionów produktów, dostęp do nieograniczonego przesyłania strumieniowego dziesiątek tysięcy filmów i Odcinki telewizyjne i inne korzyści. |

| W tym roku szczególnie stawiamy na |

W tym roku szczególnie skupiamy się na: Rola systemu ochrony zdrowia w profilaktyce otyłości i cukrzycy Rola systemu ochrony zdrowia w profilaktyce otyłości i cukrzycy Rola systemu ochrony zdrowia w profilaktyce otyłości i cukrzycy Rola systemu ochrony zdrowia w profilaktyce otyłości i cukrzycy Rola systemu ochrony zdrowia w profilaktyce otyłości i cukrzycy Rola systemu ochrony zdrowia w profilaktyce otyłości i cukrzycy Rola systemu ochrony zdrowia w profilaktyce otyłości i cukrzycy |

W tym roku szczególnie koncentrujemy się na: -Kontynuacji ekspansji międzynarodowej, w tym rozwoju nowych biznesów w istniejących międzynarodowych segmentach rynku, jak również rozwoju nowych międzynarodowych segmentów rynku; -Rozszerzanie naszej bazy klientów, w tym zwiększanie sprzedaży do obecnych klientów oraz pozyskiwanie nowych klientów; -Rozwijanie nowych możliwości biznesowych i zawieranie umów handlowych, w tym poprzez licencje i inne porozumienia, z innymi firmami lub poprzez nabywanie innych firm; -Rozwijanie technologii, która zapewnia lepszą obsługę klienta i wydajniejsze dostarczanie naszych produktów i usług; -Opracowywanie nowych ofert produktów i usług oraz włączanie tych istniejących i nowych ofert produktów i usług; -Opracowywanie wydajnych i skutecznych systemów wspierających naszą działalność oraz -Inne inicjatywy biznesowe i strategiczne. Wierzymy, że oferowanie naszym klientom niskich cen ma fundamentalne znaczenie dla naszego przyszłego sukcesu. Jednym ze sposobów oferowania niższych cen są oferty bezpłatnej wysyłki, które skutkują kosztem netto dostarczania produktów, oraz członkostwo w Amazon Prime, które zapewnia bezpłatną wysyłkę milionów produktów oraz dostęp do filmów i innych treści. Oferujemy również inne promocje, które umożliwiają obniżenie kosztu netto sprzedaży. Zorganizowaliśmy naszą działalność w dwóch głównych segmentach: Ameryka Północna i Międzynarodowy. Patrz punkt 8 w Części II, „”Sprawozdania finansowe i dane uzupełniające-Nota 12-Informacje o segmentach.” Patrz punkt 7 w Części II,„Omówienie i analiza kierownictwa na temat sytuacji finansowej i wyników działalności-Wyniki działalności-Informacje uzupełniające”” w celu uzyskania dodatkowych informacji na temat naszej sprzedaży netto. Konsumenci Obsługujemy konsumentów za pośrednictwem naszych witryn detalicznych i sklepów stacjonarnych, koncentrując się na wyborze, cenie i wygodzie. |

W przypadku drugiego eksperymentu z zadaniem odpowiedzi na pytanie typu zero-shot ustawiliśmy max_length być inną wartością (odpowiednio 40, 200 i 40) w oparciu o dane wyjściowe, których oczekujemy od każdego pytania. Parametry top_k, top_p, do_sample, temperature są ustawione na 250, 0.8, Falsei 0, odpowiednio. Ustawiamy temperaturę bliską 0, aby kontrolować losowość danych wyjściowych, podczas gdy w zadaniu generowania tekstu ustawiamy ją blisko 1, aby uczynić model bardziej kreatywnym. Poniższa tabela porównuje wyniki. Dla każdego pytania dane wyjściowe z precyzyjnie dostrojonego GPT-J są dokładniejsze niż te bez precyzyjnego dostrojenia.

| Wkład | Wyjście z GPT-J 6B przed dostrajaniem | Wyjście z GPT-J 6B po dostrojeniu |

| Czego dotyczy punkt 7 zgłoszenia 10-K SEC?: |

Czego dotyczy punkt 7 zgłoszenia 10-K SEC?: Pozycja 7 zgłoszenia 10-K SEC jest następująca: „Spółka nie otrzymała żadnych istotnych negatywnych informacji |

Punkt 7. Omówienie i analiza przez kierownictwo sytuacji finansowej i wyników działalności Stwierdzenia dotyczące przyszłości |

| Jak pandemia COVID-19 wpłynęła na działalność Amazona?: |

Jak pandemia COVID-19 wpłynęła na działalność Amazona?: Pandemia COVID-19 wpływa na działalność Amazona na wiele sposobów. Firma odnotowuje spadek liczby członkostw Prime, które stanowią dużą część jej działalności. Firma odnotowuje również spadek liczby członków Prime. Amazon odnotowuje również spadek liczby zamówień składanych na swojej stronie internetowej. Firma odnotowuje również spadek liczby osób, które robią zakupy na jej stronie internetowej. Amazon odnotowuje również spadek liczby osób, które robią zakupy na jego stronie internetowej. Amazon odnotowuje również spadek liczby osób, które robią zakupy na jego stronie internetowej. Amazon odnotowuje również spadek liczby osób, które robią zakupy na jego stronie internetowej. Amazon odnotowuje również spadek liczby osób, które robią zakupy |

Jak pandemia COVID-19 wpłynęła na działalność Amazon?:Pandemia COVID-19 wpłynęła na naszą działalność na kilka sposobów. Po pierwsze, zakłóciło to nasz łańcuch dostaw i wpłynęło na popyt ze strony klientów, co z kolei wpłynęło na naszą sprzedaż i wyniki operacyjne. Po drugie, zwiększyło nasze wydatki na reklamę i marketing, co na dłuższą metę może nie być skuteczne. Po trzecie, zwiększyło nasze wydatki na infrastrukturę technologiczną i moce obliczeniowe, co na dłuższą metę może nie być efektywne. Po czwarte, zwiększyło nasze wydatki na realizację zamówień i obsługę klienta, co na dłuższą metę może nie być skuteczne. Wreszcie zwiększyło nasze wydatki na treści, które na dłuższą metę mogą nie być skuteczne. Patrz punkt 8 Części II „Sprawozdania finansowe i dane uzupełniające – Nota 1 – Opis zasad prowadzenia działalności i rachunkowości. |

| Co napędza wzrost sprzedaży w Amazon?: | Amazon jest największym na świecie sprzedawcą internetowym. Jest to również największy na świecie rynek online. To także świat | Wzrost sprzedaży w Amazon jest napędzany głównie przez zwiększone wykorzystanie przez klientów, w tym większy wybór, niższe ceny i większą wygodę, a także zwiększoną sprzedaż innych sprzedawców na naszych stronach internetowych. |

Sprzątać

Aby uniknąć bieżących opłat, usuń punkty końcowe wnioskowania SageMaker. Możesz usunąć punkty końcowe za pomocą konsoli SageMaker lub z notebooka za pomocą następujących poleceń:

Wnioski

JumpStart to funkcja w SageMaker, która pozwala szybko rozpocząć pracę z ML. JumpStart wykorzystuje wstępnie wytrenowane modele open source do rozwiązywania typowych problemów uczenia maszynowego, takich jak klasyfikacja obrazów, wykrywanie obiektów, klasyfikacja tekstu, klasyfikacja par zdań i odpowiadanie na pytania.

W tym poście pokazaliśmy, jak dostroić i wdrożyć wstępnie przeszkolony LLM (GPT-J 6B) do generowania tekstu na podstawie zestawu danych wypełniania SEC. Pokazaliśmy, jak model przekształcił się w eksperta w dziedzinie finansów, przechodząc proces dostrajania na zaledwie dwóch raportach rocznych firmy. To precyzyjne dostrojenie umożliwiło modelowi generowanie treści ze zrozumieniem zagadnień finansowych i większą precyzją. Wypróbuj rozwiązanie samodzielnie i daj nam znać, jak poszło w komentarzach.

Ważne: ten wpis służy wyłącznie celom demonstracyjnym. Nie jest to porada finansowa i nie należy traktować jej jako porady finansowej lub inwestycyjnej. W stanowisku wykorzystano modele wstępnie wytrenowane na danych pozyskanych z bazy SEC EDGAR. Jesteś odpowiedzialny za przestrzeganie warunków dostępu EDGAR, jeśli korzystasz z danych SEC.

Aby dowiedzieć się więcej o JumpStart, sprawdź następujące posty:

O autorach

Dr Xin Huang jest starszym naukowcem zajmującym się wbudowanymi algorytmami Amazon SageMaker JumpStart i Amazon SageMaker. Koncentruje się na rozwijaniu skalowalnych algorytmów uczenia maszynowego. Jego zainteresowania badawcze obejmują obszar przetwarzania języka naturalnego, wyjaśnialne głębokie uczenie się na danych tabelarycznych oraz solidną analizę nieparametrycznego grupowania czasoprzestrzennego. Opublikował wiele artykułów na konferencjach ACL, ICDM, KDD i Royal Statistical Society: Series A.

Dr Xin Huang jest starszym naukowcem zajmującym się wbudowanymi algorytmami Amazon SageMaker JumpStart i Amazon SageMaker. Koncentruje się na rozwijaniu skalowalnych algorytmów uczenia maszynowego. Jego zainteresowania badawcze obejmują obszar przetwarzania języka naturalnego, wyjaśnialne głębokie uczenie się na danych tabelarycznych oraz solidną analizę nieparametrycznego grupowania czasoprzestrzennego. Opublikował wiele artykułów na konferencjach ACL, ICDM, KDD i Royal Statistical Society: Series A.

Marek Karp jest architektem ML w zespole Amazon SageMaker Service. Koncentruje się na pomaganiu klientom w projektowaniu, wdrażaniu i zarządzaniu obciążeniami ML na dużą skalę. W wolnym czasie lubi podróżować i odkrywać nowe miejsca.

Marek Karp jest architektem ML w zespole Amazon SageMaker Service. Koncentruje się na pomaganiu klientom w projektowaniu, wdrażaniu i zarządzaniu obciążeniami ML na dużą skalę. W wolnym czasie lubi podróżować i odkrywać nowe miejsca.

Dr Sanjiv Das jest stypendystą Amazon i profesorem Terry w dziedzinie finansów i nauki o danych na Uniwersytecie Santa Clara. Posiada stopnie podyplomowe z finansów (magisterskie i doktoranckie z New York University) i informatyki (magisterskie z UC Berkeley) oraz tytuł MBA z Indian Institute of Management, Ahmedabad. Zanim został naukowcem, pracował w branży instrumentów pochodnych w regionie Azji i Pacyfiku jako wiceprezes Citibank. Zajmuje się multimodalnym uczeniem maszynowym w obszarze aplikacji finansowych.

Dr Sanjiv Das jest stypendystą Amazon i profesorem Terry w dziedzinie finansów i nauki o danych na Uniwersytecie Santa Clara. Posiada stopnie podyplomowe z finansów (magisterskie i doktoranckie z New York University) i informatyki (magisterskie z UC Berkeley) oraz tytuł MBA z Indian Institute of Management, Ahmedabad. Zanim został naukowcem, pracował w branży instrumentów pochodnych w regionie Azji i Pacyfiku jako wiceprezes Citibank. Zajmuje się multimodalnym uczeniem maszynowym w obszarze aplikacji finansowych.

Arun Kumar Lokanatha jest starszym architektem rozwiązań ML w zespole Amazon SageMaker Service. Koncentruje się na pomaganiu klientom w budowaniu, szkoleniu i migracji obciążeń produkcyjnych ML do SageMaker na dużą skalę. Specjalizuje się w deep learningu, szczególnie w obszarze NLP i CV. Poza pracą lubi biegać i spacerować.

Arun Kumar Lokanatha jest starszym architektem rozwiązań ML w zespole Amazon SageMaker Service. Koncentruje się na pomaganiu klientom w budowaniu, szkoleniu i migracji obciążeń produkcyjnych ML do SageMaker na dużą skalę. Specjalizuje się w deep learningu, szczególnie w obszarze NLP i CV. Poza pracą lubi biegać i spacerować.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Wybijanie przyszłości w Adryenn Ashley. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/domain-adaptation-fine-tuning-of-foundation-models-in-amazon-sagemaker-jumpstart-on-financial-data/

- :ma

- :Jest

- :nie

- $3

- $W GÓRĘ

- 000

- 1

- 100

- 11

- 20

- 200

- 2016

- 2020

- 28

- 7

- 8

- 9

- a

- zdolności

- Zdolny

- O nas

- akademicki

- dostęp

- Księgowość

- Gromadź BTC

- precyzja

- dokładny

- Osiągać

- nabycie

- w poprzek

- działać

- w dodatku

- Dodatkowe funkcje

- dodatek

- do tego

- adres

- Reklama

- Rada

- oddziaływać

- Po

- przed

- AI

- Alexa

- algorytm

- Algorytmy

- Wszystkie kategorie

- pozwala

- również

- Chociaż

- Amazonka

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- Amazon.com

- Ameryka

- kwoty

- an

- analiza

- w czasie rzeczywistym sprawiają,

- i

- Andrew

- roczny

- Inne

- odpowiedź

- każdy

- ktoś

- api

- aplikacje

- stosowany

- podejście

- właściwy

- mobilne i webowe

- SĄ

- POWIERZCHNIA

- artykuł

- AS

- oszacowanie

- At

- Uwaga

- przyciąganie

- Sierpnia

- automatycznie

- dostępny

- AWS

- bar

- baza

- na podstawie

- BE

- bo

- stają się

- być

- zanim

- jest

- uwierzyć

- Korzyści

- Berkeley

- Ulepsz Swój

- Duży

- miliardy

- obie

- szeroki

- budować

- wbudowany

- biznes

- ale

- by

- wezwanie

- nazywa

- Połączenia

- CAN

- Może uzyskać

- zdolny

- Pojemność

- karta

- który

- walizka

- Etui

- poświadczać

- łańcuch

- wyzwania

- Kanał

- Opłaty

- nasze chatboty

- ZOBACZ

- Dodaj

- wybrał

- wybrany

- okoliczności

- Citibank

- Clara

- klasyfikacja

- Zamknij

- klastrowanie

- kod

- Kolumna

- COM

- komentarze

- wspólny

- powszechnie

- społeczność

- Firmy

- sukcesy firma

- Firma

- porównać

- w porównaniu

- porównanie

- porównanie

- kompletny

- ukończenia

- obliczać

- komputer

- Computer Science

- computing

- moc obliczeniowa

- warunek

- Warunki

- konferencje

- Rozważać

- za

- Konsola

- budowy

- Konsumenci

- zawierać

- Pojemnik

- zawiera

- zawartość

- kontynuować

- kontrola

- kontroli

- wygoda

- Korporacyjny

- Odpowiedni

- Koszty:

- pokryty

- Okładki

- COVID-19

- Pandemia COVID-19

- Stwórz

- Twórczy

- krytyczny

- Obecnie

- zwyczaj

- klient

- Obsługa klienta

- Klientów

- dane

- nauka danych

- Baza danych

- zbiory danych

- grudzień

- upadek

- głęboko

- głęboka nauka

- Domyślnie

- dostarczanie

- dostarcza

- Kreowanie

- wykazać

- wykazać

- rozwijać

- wdrażane

- wdrażanie

- Pochodne

- opisane

- opis

- Wnętrze

- zaprojektowany

- detale

- Wykrywanie

- Ustalać

- określa

- deweloperzy

- rozwijanie

- oprogramowania

- urządzenia

- ZROBIŁ

- różne

- trudny

- cyfrowy

- bezpośrednio

- ujawnienie

- dyskutować

- dyskusja

- dystrybuowane

- szkolenia rozproszone

- Doker

- dokumenty

- domena

- dziesiątki

- napędzany

- podczas

- każdy

- Wcześniej

- z łatwością

- łatwy w użyciu

- Efektywne

- efektywność

- efektywność

- wydajny

- Elektroniczny

- umożliwiać

- włączony

- Punkt końcowy

- wzmocnione

- Enterprise

- przedsiębiorstwa

- Cały

- jednostka

- epoki

- Ernst & Young

- szczególnie

- zapewniają

- oceniać

- oceny

- ewaluację

- codzienny

- wszystko

- przykład

- przykłady

- Z wyjątkiem

- wymiana

- Ćwiczenie

- Przede wszystkim system został opracowany

- ekspansja

- oczekiwać

- oczekiwanie

- drogi

- eksperyment

- ekspert

- Exploring

- rozległy

- Twarz

- FAST

- Korzyści

- kilka

- pole

- filet

- Złożenie

- W końcu

- finansować

- budżetowy

- Porada finansowa

- dane finansowe

- Informacje finansowe

- w porządku

- i terminów, a

- dopasować

- Skupiać

- koncentruje

- następujący

- następujący sposób

- W razie zamówieenia projektu

- Dla inwestorów

- Prognoza

- czoło

- Nasz formularz

- format

- przyszłościowe

- znaleziono

- Fundacja

- Czwarty

- od

- pełny

- Funkcjonalność

- fundamentalny

- dalej

- przyszłość

- Generować

- wygenerowane

- generuje

- generacja

- otrzymać

- dany

- Globalne

- Go

- Goes

- będzie

- dobry

- GPU

- gradienty

- większy

- Ziemia

- Rosnąć

- Rozwój

- Wzrost

- sprzęt komputerowy

- Have

- he

- Zdrowie

- Opieka zdrowotna

- pomoc

- pomaga

- tutaj

- Wysoki

- wysoka wydajność

- posiada

- kaptur

- gospodarz

- hostowane

- W jaki sposób

- How To

- HTML

- http

- HTTPS

- Przytulanie twarzy

- Setki

- setki milionów

- Optymalizacja hiperparametrów

- i

- pomysł

- zidentyfikowane

- obraz

- Klasyfikacja obrazu

- Rezultat

- wpływ

- importować

- imponujący

- podnieść

- poprawa

- in

- Inc

- zawierać

- włączony

- obejmuje

- Włącznie z

- Dochód

- włączenie

- Zwiększać

- wzrosła

- wzrastający

- niewiarygodny

- Hindusi

- Informacja

- Infrastruktura

- inicjatywy

- wkład

- przykład

- zamiast

- Instytut

- integrować

- interakcji

- zainteresowania

- na świecie

- najnowszych

- przedstawiać

- inwestycja

- Investopedia

- inwestor

- Inwestorzy

- IT

- szt

- JEGO

- Praca

- jpg

- json

- właśnie

- Klawisz

- Wiedzieć

- wiedza

- znany

- Etykiety

- język

- Języki

- duży

- największym

- uruchomić

- UCZYĆ SIĘ

- dowiedziałem

- nauka

- Biblioteka

- Koncesjonowanie

- lekki

- lubić

- Lista

- LLM

- długo

- Popatrz

- poszukuje

- od

- niski

- niskie ceny

- maszyna

- uczenie maszynowe

- zrobiony

- poważny

- robić

- Dokonywanie

- zarządzanie

- i konserwacjami

- ręcznie

- wiele

- March

- rynek

- Marketing

- rynek

- masywny

- materiał

- Może..

- znaczy

- zmierzyć

- członkostwo

- członkostwa

- Pamięć

- metoda

- metryczny

- migrować

- milion

- miliony

- minut

- mieszany

- ML

- Aplikacje mobilne

- aplikacje mobilne

- model

- modele

- jeszcze

- większość

- Kino

- MS

- wielokrotność

- Nazwa

- O imieniu

- Naturalny

- Przetwarzanie języka naturalnego

- Nawigacja

- niezbędny

- Potrzebować

- netto

- Nowości

- nowy produkt

- I Love New York

- Następny

- nlp

- węzeł

- Północ

- Ameryka Północna

- notatnik

- już dziś

- numer

- Otyłość

- przedmiot

- Wykrywanie obiektów

- uzyskać

- uzyskane

- of

- oferta

- oferuje

- Oferty

- Oferty

- on

- ONE

- trwający

- Online

- rynek online

- sklep internetowy

- tylko

- open source

- operacyjny

- operacje

- Szanse

- optymalizacja

- or

- zamówienie

- Zlecenia

- Zorganizowany

- oryginalny

- Inne

- ludzkiej,

- Outlook

- wydajność

- zewnętrzne

- koniec

- Zastąp

- przegląd

- własny

- właściciel

- pandemiczny

- chleb

- Papiery

- parametry

- część

- szczególny

- szczególnie

- strony

- przechodzić

- minęło

- Przechodzący

- ścieżka

- wzory

- Ludzie

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- wykonywania

- wykonuje

- okres

- okresy

- PHIL

- fizyczny

- Fizycznie

- wybierać

- Miejsca

- plato

- Analiza danych Platona

- PlatoDane

- polityka

- możliwy

- Post

- Wiadomości

- potencjał

- power

- Praktyczny

- Detaliczność

- przewidzieć

- przewidywanie

- Przewidywania

- Urządzenie prognozujące

- teraźniejszość

- przedstawione

- prezydent

- zapobiec

- Zapobieganie

- poprzedni

- Cena

- Cennik

- wycena

- głównie

- premia

- Główny

- Wcześniejszy

- problemy

- wygląda tak

- procesów

- przetwarzanie

- Produkt

- Produkcja

- wydajność

- Produkty

- Profesor

- Program

- Promocje

- propozycja

- zapewniać

- pod warunkiem,

- zapewnia

- publicznie

- opublikowany

- wydawca

- cel

- cele

- Python

- Kwartał

- pytanie

- pytania

- szybko

- przypadkowość

- Kurs

- Czytaj

- real

- Odebrane

- zmniejszyć

- odnosi

- w sprawie

- regex

- region

- Regulacja

- regulacyjne

- związane z

- wydany

- raport

- Raporty

- wymagany

- Wymaga

- Badania naukowe

- Zasoby

- poszanowanie

- odpowiedź

- odpowiedzialny

- dalsze

- Efekt

- detaliczny

- detalista

- recenzja

- zrewolucjonizować

- krzepki

- Rola

- królewski

- run

- bieganie

- sagemaker

- Wnioskowanie SageMakera

- sole

- taki sam

- Święty

- skalowalny

- Skala

- nauka

- Naukowiec

- wynik

- Sdk

- Szukaj

- SEK

- Złożenie SEC

- druga

- sekretarz

- Sekcja

- działy

- Papiery wartościowe

- widzenie

- Segmenty

- wybrany

- wybór

- sprzedać

- Sprzedający

- Sprzedawanie

- senior

- wyrok

- sentyment

- wrzesień

- Sekwencja

- Serie

- Seria A

- służyć

- usługa

- Usługi

- zestaw

- ustawienie

- w panelu ustawień

- kilka

- Share

- Wysyłka

- Zakupy

- powinien

- pokazać

- pokazane

- Targi

- znacznie

- Prosty

- pojedynczy

- Rozmiar

- rozmiary

- mniejszy

- So

- Społeczeństwo

- sprzedany

- rozwiązanie

- Rozwiązania

- ROZWIĄZANIA

- Źródła

- Specjaliści

- wyspecjalizowanym

- specjalizuje się

- specyficzny

- Spędzanie

- początek

- rozpoczęty

- Stan

- oświadczenia

- statystyczny

- Ewolucja krok po kroku

- Cel

- przechowywanie

- sklep

- Strategiczny

- Strategia

- Streaming

- jest determinacja.

- starać się

- studio

- sukces

- taki

- Dostawa

- łańcuch dostaw

- Utrzymany

- Wspierający

- podpory

- system

- systemy

- stół

- Brać

- biorąc

- Zadanie

- zadania

- zespół

- Technologia

- REGULAMIN

- Regulamin

- test

- Klasyfikacja tekstu

- niż

- że

- Połączenia

- Strefa

- Przyszłość

- ich

- Im

- w związku z tym

- Te

- one

- rzeczy

- Trzeci

- osoby trzecie

- to

- trzy

- Przez

- czas

- czasochłonne

- czasy

- do

- Żetony

- Top

- tematy

- śledzić

- Pociąg

- przeszkolony

- Trening

- Przesyłanie

- przekształcony

- tłumaczyć

- Podróżowanie

- Prawda

- SKRĘCAĆ

- tv

- ui

- dla

- zrozumieć

- zrozumienie

- wyjątkowy

- uniwersytet

- nieograniczone

- Nowości

- us

- Stosowanie

- posługiwać się

- używany

- za pomocą

- zazwyczaj

- wykorzystany

- Wykorzystując

- uprawomocnienie

- wartość

- Wartości

- różnorodny

- wersja

- przez

- Wiceprezes

- prawie

- była

- Waszyngton

- Droga..

- sposoby

- we

- sieć

- usługi internetowe

- Strona internetowa

- strony internetowe

- DOBRZE

- czy

- który

- KIM

- będzie

- w

- bez

- słowo

- Praca

- pracował

- działa

- świat

- by

- rok

- lat

- You

- młody

- Twój

- zefirnet