Modele dużego języka (LLM) zrewolucjonizowały dziedzinę przetwarzania języka naturalnego (NLP), usprawniając zadania, takie jak tłumaczenie języka, podsumowywanie tekstu i analiza nastrojów. Jednakże w miarę jak modele te stale rosną pod względem wielkości i złożoności, monitorowanie ich wydajności i zachowania staje się coraz większym wyzwaniem.

Monitorowanie wydajności i zachowania LLM jest zadaniem krytycznym dla zapewnienia ich bezpieczeństwa i skuteczności. Proponowana przez nas architektura zapewnia skalowalne i konfigurowalne rozwiązanie do monitorowania LLM online, umożliwiając zespołom dostosowanie rozwiązania monitorującego do konkretnych przypadków użycia i wymagań. Korzystając z usług AWS, nasza architektura zapewnia wgląd w zachowanie LLM w czasie rzeczywistym i umożliwia zespołom szybką identyfikację i rozwiązanie wszelkich problemów lub anomalii.

W tym poście przedstawiamy kilka wskaźników monitorowania LLM online i ich odpowiednią architekturę na potrzeby skali przy użyciu usług AWS, takich jak Amazon Cloud Watch i AWS Lambda. Zapewnia to konfigurowalne rozwiązanie wykraczające poza to, co jest możliwe ocena modelu praca z Amazońska skała macierzysta.

Przegląd rozwiązania

Pierwszą rzeczą do rozważenia jest to, że różne metryki wymagają różnych obliczeń. Niezbędna jest architektura modułowa, w której każdy moduł może pobierać dane z modelu i generować własne metryki.

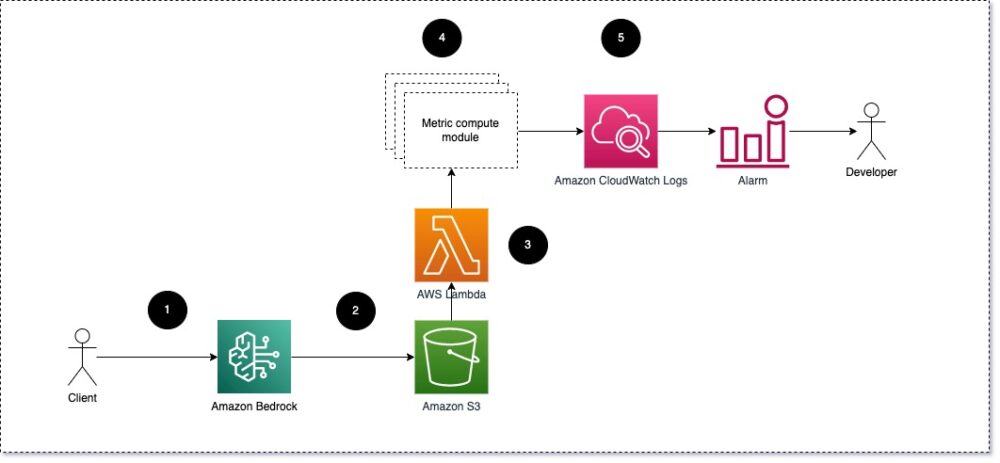

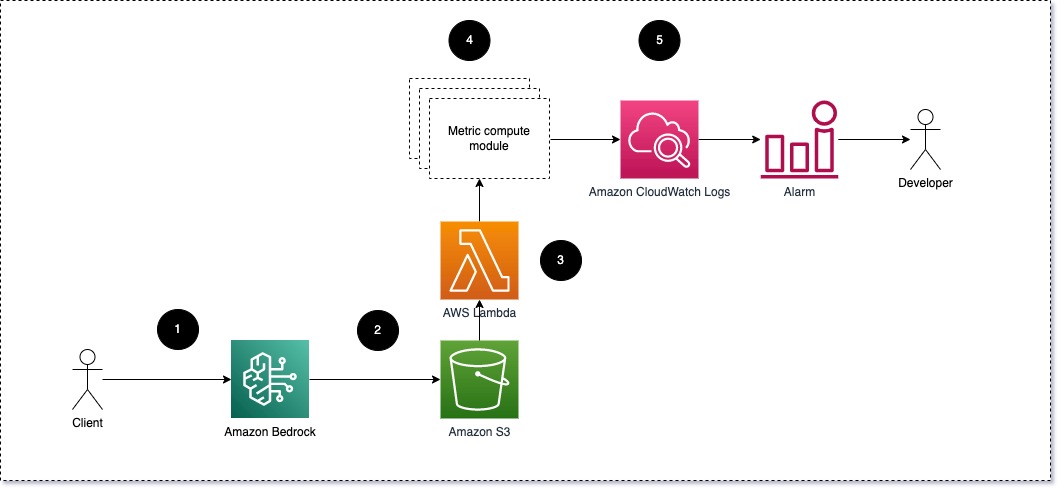

Sugerujemy, aby każdy moduł odbierał przychodzące żądania wnioskowania do LLM, przekazując pary podpowiedzi i uzupełnień (odpowiedzi) do modułów obliczeniowych metrycznych. Każdy moduł jest odpowiedzialny za obliczanie własnych metryk w odniesieniu do monitu wejściowego i zakończenia (odpowiedzi). Te dane są przekazywane do CloudWatch, który może je agregować i współpracować z alarmami CloudWatch w celu wysyłania powiadomień o określonych warunkach. Poniższy diagram ilustruje tę architekturę.

Rys. 1: Moduł obliczeń metrycznych – przegląd rozwiązania

Przepływ pracy obejmuje następujące kroki:

- Użytkownik wysyła żądanie do Amazon Bedrock w ramach aplikacji lub interfejsu użytkownika.

- Amazon Bedrock zapisuje żądanie i zakończenie (odpowiedź) w Usługa Amazon Simple Storage (Amazon S3) zgodnie z konfiguracją rejestrowanie wywołań.

- Plik zapisany na Amazon S3 tworzy wydarzenie, które wyzwalacze funkcję Lambda. Funkcja wywołuje moduły.

- Moduły publikują swoje odpowiednie metryki w Metryki CloudWatch.

- Alarmy może powiadomić zespół programistów o nieoczekiwanych wartościach metryk.

Drugą rzeczą do rozważenia przy wdrażaniu monitorowania LLM jest wybór odpowiednich wskaźników do śledzenia. Chociaż istnieje wiele potencjalnych wskaźników, które można wykorzystać do monitorowania wydajności LLM, w tym poście wyjaśnimy niektóre z najszerszych z nich.

W poniższych sekcjach podkreślamy kilka odpowiednich metryk modułów i odpowiadającą im architekturę modułów obliczeniowych metryki.

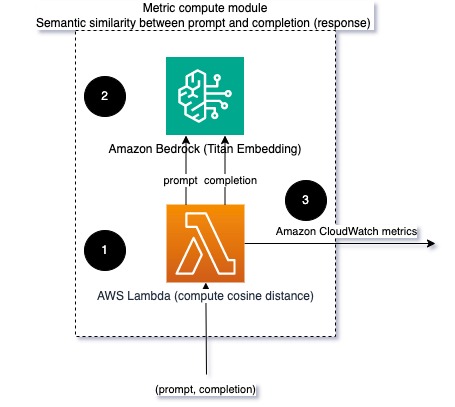

Podobieństwo semantyczne między monitem a zakończeniem (odpowiedzią)

Podczas uruchamiania LLM możesz przechwycić monit i zakończenie (odpowiedź) na każde żądanie i przekształcić je w osadzenie za pomocą modelu osadzania. Osadzenia to wielowymiarowe wektory, które reprezentują semantyczne znaczenie tekstu. Amazon Tytan udostępnia takie modele za pośrednictwem Titan Embeddings. Przyjmując odległość taką jak cosinus między tymi dwoma wektorami, można określić ilościowo, jak semantycznie podobne są zachęta i zakończenie (odpowiedź). Możesz użyć SciPy or nauka-scikit obliczyć odległość cosinus między wektorami. Poniższy diagram ilustruje architekturę tego modułu obliczeniowego metryki.

Rys. 2: Moduł obliczeniowy metryczny – podobieństwo semantyczne

Ten przepływ pracy obejmuje następujące kluczowe kroki:

- Funkcja Lambda odbiera komunikat przesyłany strumieniowo za pośrednictwem Amazonka Kinesis zawierający parę podpowiedzi i zakończenia (odpowiedzi).

- Funkcja osadza zarówno zachętę, jak i zakończenie (odpowiedź) i oblicza odległość cosinus między dwoma wektorami.

- Funkcja wysyła te informacje do metryk CloudWatch.

Sentyment i toksyczność

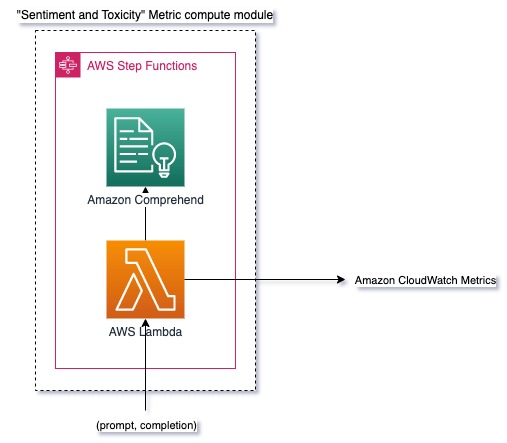

Monitorowanie nastrojów pozwala ocenić ogólny ton i wpływ emocjonalny odpowiedzi, podczas gdy analiza toksyczności stanowi ważną miarę obecności obraźliwego, lekceważącego lub szkodliwego języka w wynikach LLM. Należy ściśle monitorować wszelkie zmiany nastrojów lub toksyczności, aby upewnić się, że model zachowuje się zgodnie z oczekiwaniami. Poniższy diagram ilustruje moduł obliczeniowy metryki.

Ryc. 3: Moduł obliczeniowy metryczny – sentyment i toksyczność

Przepływ pracy obejmuje następujące kroki:

- Funkcja Lambda otrzymuje parę podpowiedzi i zakończenia (odpowiedzi) za pośrednictwem Amazon Kinesis.

- Dzięki orkiestracji AWS Step Functions funkcja wywołuje Amazon Comprehend wykryć sentyment i toksyczność.

- Funkcja zapisuje informacje w metrykach CloudWatch.

Aby uzyskać więcej informacji na temat wykrywania nastrojów i toksyczności za pomocą Amazon Comprehend, zobacz Zbuduj solidny tekstowy predyktor toksyczności i Oznacz szkodliwe treści za pomocą funkcji wykrywania toksyczności Amazon Comrehend.

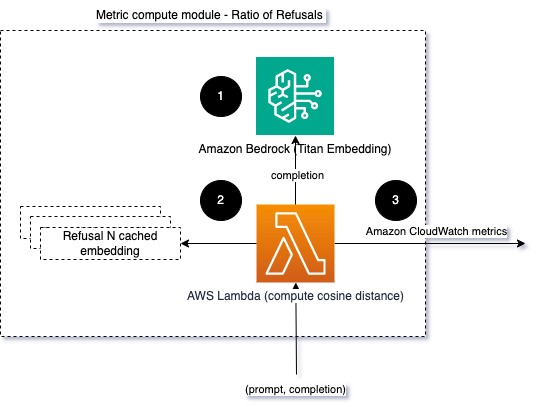

Stosunek odmów

Wzrost liczby odmów, na przykład gdy LLM odmawia ukończenia ze względu na brak informacji, może oznaczać, że albo szkodliwi użytkownicy próbują wykorzystać LLM w sposób mający na celu jego jailbreak, albo że oczekiwania użytkowników nie są spełnione i otrzymują odpowiedzi o niskiej wartości. Jednym ze sposobów sprawdzenia, jak często to się dzieje, jest porównanie standardowych odmów ze stosowanego modelu LLM z rzeczywistymi odpowiedziami z LLM. Na przykład poniżej znajdują się niektóre typowe zwroty odmowy Claude v2 LLM firmy Anthropic:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

W przypadku ustalonego zestawu podpowiedzi wzrost liczby odmów może być sygnałem, że model stał się nadmiernie ostrożny lub wrażliwy. Należy również ocenić przypadek odwrotny. Może to być sygnał, że modelka jest teraz bardziej podatna na toksyczne lub szkodliwe rozmowy.

Aby pomóc w integralności modelu i współczynniku odmów modelu, możemy porównać odpowiedź z zestawem znanych wyrażeń odmownych z LLM. Może to być rzeczywisty klasyfikator, który może wyjaśnić, dlaczego model odrzucił żądanie. Można obliczyć odległość cosinusową między odpowiedzią a znanymi odpowiedziami na odmowę z monitorowanego modelu. Poniższy diagram ilustruje ten moduł obliczeniowy metryki.

Rys. 4: Moduł obliczeniowy metryczny – współczynnik odmów

Przepływ pracy składa się z następujących kroków:

- Funkcja Lambda otrzymuje monit i zakończenie (odpowiedź) oraz osadza się na podstawie odpowiedzi za pomocą Amazon Titan.

- Funkcja oblicza cosinus lub odległość euklidesową pomiędzy odpowiedzią a istniejącymi monitami o odmowę zapisanymi w pamięci podręcznej.

- Funkcja wysyła tę średnią do metryk CloudWatch.

Inną opcją jest użycie rozmyte dopasowanie dla prostego, ale mniej wydajnego podejścia do porównania znanych odmów z wynikami LLM. Patrz Dokumentacja Pythona dla przykładu.

Podsumowanie

Obserwowalność LLM jest kluczową praktyką zapewniającą niezawodne i godne zaufania wykorzystanie LLM. Monitorowanie, zrozumienie i zapewnienie dokładności i niezawodności LLM może pomóc w ograniczeniu ryzyka związanego z tymi modelami sztucznej inteligencji. Monitorując halucynacje, złe zakończenia (odpowiedzi) i podpowiedzi, możesz mieć pewność, że Twój LLM będzie działać prawidłowo i zapewnia wartość, której szukasz Ty i Twoi użytkownicy. W tym poście omówiliśmy kilka wskaźników, aby zaprezentować przykłady.

Aby uzyskać więcej informacji na temat oceny modeli fundamentów, zobacz Użyj SageMaker Clarify, aby ocenić modele fundamentówi przeglądaj dodatkowe przykładowe zeszyty dostępne w naszym repozytorium GitHub. Możesz także zbadać sposoby operacjonalizacji ocen LLM na dużą skalę Zrealizuj ocenę LLM na dużą skalę, korzystając z usług Amazon SageMaker Clarify i MLOps. Na koniec zalecamy odniesienie się do Oceń duże modele językowe pod kątem jakości i odpowiedzialności aby dowiedzieć się więcej o ocenie LLM.

O autorach

Brunona Kleina jest starszym inżynierem uczenia maszynowego w praktyce analityki usług profesjonalnych AWS. Pomaga klientom wdrażać rozwiązania big data i analityki. Poza pracą lubi spędzać czas z rodziną, podróżować i próbować nowych potraw.

Brunona Kleina jest starszym inżynierem uczenia maszynowego w praktyce analityki usług profesjonalnych AWS. Pomaga klientom wdrażać rozwiązania big data i analityki. Poza pracą lubi spędzać czas z rodziną, podróżować i próbować nowych potraw.

Rushabh Lokhande jest starszym inżynierem danych i uczenia maszynowego w praktyce analityki usług profesjonalnych AWS. Pomaga klientom wdrażać rozwiązania typu big data, uczenie maszynowe i rozwiązania analityczne. Poza pracą lubi spędzać czas z rodziną, czytać, biegać i grać w golfa.

Rushabh Lokhande jest starszym inżynierem danych i uczenia maszynowego w praktyce analityki usług profesjonalnych AWS. Pomaga klientom wdrażać rozwiązania typu big data, uczenie maszynowe i rozwiązania analityczne. Poza pracą lubi spędzać czas z rodziną, czytać, biegać i grać w golfa.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- :ma

- :Jest

- :nie

- :Gdzie

- 1

- 100

- 143

- 32

- 455

- 7

- a

- O nas

- precyzja

- rzeczywisty

- Dodatkowy

- adres

- agregat

- AI

- Asystent AI

- Modele AI

- pozwala

- również

- Chociaż

- am

- Amazonka

- Amazon Comprehend

- Amazonka Kinesis

- Amazon Sage Maker

- Amazon Web Services

- an

- analiza

- analityka

- i

- anomalie

- Antropiczny

- każdy

- Zastosowanie

- podejście

- awanse

- architektura

- SĄ

- AS

- Asystent

- powiązany

- At

- dostępny

- średni

- AWS

- Usługi profesjonalne AWS

- Funkcje kroków AWS

- Łazienka

- BE

- stają się

- zachowanie

- jest

- pomiędzy

- Poza

- Duży

- Big Data

- obie

- ale

- by

- Połączenia

- CAN

- nie może

- walizka

- Etui

- ostrożny

- wyzwanie

- Wybierając

- klasyfikator

- dokładnie

- wspólny

- porównać

- porównanie

- ukończenia

- kompleksowość

- zrozumieć

- obliczenia

- obliczać

- computing

- Warunki

- systemu

- Rozważać

- Rozważania

- składa się

- zawartość

- kontekst

- kontynuować

- rozmowy

- mógłby

- stworzony

- tworzy

- krytyczny

- Klientów

- konfigurowalny

- dane

- dostarcza

- wykazać

- wykryć

- oprogramowania

- zespół programistów

- schemat

- różne

- omówione

- dystans

- do

- z powodu

- każdy

- skuteczność

- bądź

- osadzanie

- Umożliwia

- umożliwiając

- zobowiązany

- inżynier

- dość

- zapewnić

- zapewnienie

- oceniać

- oceniane

- oceny

- ewaluację

- oceny

- wydarzenie

- przykład

- przykłady

- Przede wszystkim system został opracowany

- oczekiwania

- spodziewany

- Wyjaśniać

- odkryj

- członków Twojej rodziny

- kilka

- pole

- figa

- filet

- W końcu

- i terminów, a

- ustalony

- następujący

- jedzenie

- W razie zamówieenia projektu

- Fundacja

- od

- funkcjonować

- Funkcje

- wskaźnik

- dostaje

- miejsce

- GitHub

- golf

- Rosnąć

- Wydarzenie

- szkodliwy

- Have

- he

- pomoc

- pomocny

- pomaga

- Atrakcja

- uczciwy

- W jaki sposób

- Jednak

- HTML

- http

- HTTPS

- i

- zidentyfikować

- ilustruje

- Rezultat

- wdrożenia

- wykonawczych

- ważny

- poprawy

- in

- obejmuje

- Przybywający

- Zwiększać

- coraz bardziej

- Informacja

- wkład

- integralność

- zamierzony

- Interfejs

- najnowszych

- odwrotność

- inwokuje

- problemy

- IT

- JEGO

- jailbreak

- Oferty pracy

- jpg

- Klawisz

- znany

- Brak

- język

- duży

- UCZYĆ SIĘ

- nauka

- mniej

- LLM

- poszukuje

- maszyna

- uczenie maszynowe

- robić

- WYKONUJE

- złośliwy

- wiele

- oznaczać

- znaczenie

- zmierzyć

- Pamięć

- wiadomość

- spełnione

- metryczny

- Metryka

- Złagodzić

- ML

- MLOps

- model

- modele

- Modułowa

- Moduł

- Moduły

- monitor

- monitorowane

- monitorowanie

- jeszcze

- Naturalny

- Przetwarzanie języka naturalnego

- niezbędny

- Nowości

- nlp

- Powiadomienia

- już dziś

- of

- obraźliwy

- Oferty

- często

- on

- ONE

- te

- Online

- Option

- or

- orkiestracja

- ludzkiej,

- wydajność

- Wyjścia

- zewnętrzne

- ogólny

- przegląd

- własny

- đôi

- par

- część

- minęło

- Przechodzący

- dla

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- Zwroty

- plato

- Analiza danych Platona

- PlatoDane

- gra

- możliwy

- Post

- potencjał

- mocny

- praktyka

- obecność

- przetwarzanie

- produkować

- profesjonalny

- monity

- zaproponowane

- zapewniać

- zapewnia

- Python

- jakość

- szybko

- stosunek

- Czytający

- w czasie rzeczywistym

- otrzymuje

- polecić

- odnosić się

- odmowa

- odrzucony

- niezawodność

- rzetelny

- składnica

- reprezentować

- zażądać

- wywołań

- wymagać

- wymagania

- poszanowanie

- osób

- odpowiedź

- Odpowiedzi

- odpowiedzialny

- zrewolucjonizował

- prawo

- ryzyko

- krzepki

- bieganie

- Bezpieczeństwo

- sagemaker

- zapisywane

- skalowalny

- Skala

- druga

- działy

- semantyczny

- wysłać

- wysyła

- senior

- wrażliwy

- sentyment

- Usługi

- zestaw

- Przesunięcia

- powinien

- prezentacja

- Signal

- podobny

- Prosty

- Rozmiar

- rozwiązanie

- Rozwiązania

- kilka

- Przestrzenne

- specyficzny

- Spędzanie

- standard

- Ewolucja krok po kroku

- Cel

- przechowywanie

- bezpośredni

- strumieniowo

- taki

- sugerować

- pewnie

- krawiec

- Brać

- biorąc

- Zadanie

- zadania

- zespół

- Zespoły

- Techniki

- XNUMX

- że

- Połączenia

- Informacje

- ich

- Im

- Tam.

- Te

- one

- rzecz

- to

- Przez

- czas

- tytan

- do

- TON

- śledzić

- Przekształcać

- Tłumaczenie

- Podróżowanie

- godny zaufania

- stara

- drugiej

- zrozumienie

- Nieoczekiwany

- posługiwać się

- używany

- Użytkownik

- Interfejs użytkownika

- Użytkownicy

- za pomocą

- wartość

- Wartości

- przez

- widoczność

- Droga..

- sposoby

- we

- sieć

- usługi internetowe

- Co

- Co to jest

- jeśli chodzi o komunikację i motywację

- natomiast

- który

- dlaczego

- Wikipedia

- w

- Praca

- workflow

- You

- Twój

- zefirnet