Astăzi, suntem încântați să anunțăm capacitatea de a ajusta modelele Llama 2 folosind Meta Amazon SageMaker JumpStart. Familia de modele de limbaj mari (LLM) Llama 2 este o colecție de modele de text generative pre-antrenate și reglate fin, cu o scară cuprinsă între 7 miliarde și 70 de miliarde de parametri. LLM-urile ajustate, numite Llama-2-chat, sunt optimizate pentru cazuri de utilizare a dialogului. Puteți încerca cu ușurință aceste modele și le puteți utiliza cu SageMaker JumpStart, care este un hub de învățare automată (ML) care oferă acces la algoritmi, modele și soluții ML, astfel încât să puteți începe rapid cu ML. Acum puteți, de asemenea, să reglați fin modelele de generare de text Llama 7 pentru 13 miliarde, 70 miliarde și 2 de miliarde de parametri pe SageMaker JumpStart folosind Amazon SageMaker Studio Interfața de utilizare cu câteva clicuri sau folosind SDK-ul SageMaker Python.

Modelele de bază ale AI generative au fost centrul majorității cercetării și cazurilor de utilizare în ML și inteligență artificială de peste un an. Aceste modele de bază funcționează foarte bine cu sarcini generative, cum ar fi generarea de text, rezumatul, răspunsul la întrebări, generarea de imagini și videoclipuri și multe altele, datorită dimensiunii lor mari și, de asemenea, pentru că sunt instruiți pe mai multe seturi mari de date și sute de sarcini. În ciuda capacităților mari de generalizare ale acestor modele, există adesea cazuri de utilizare care au date de domeniu foarte specifice (cum ar fi asistența medicală sau serviciile financiare), din cauza cărora aceste modele ar putea să nu poată oferi rezultate bune pentru aceste cazuri de utilizare. Acest lucru are ca rezultat o nevoie de ajustare suplimentară a acestor modele generative de IA asupra datelor specifice cazului de utilizare și specifice domeniului.

În această postare, vom parcurge modul de ajustare a modelelor de generare de text pre-antrenate Llama 2 prin SageMaker JumpStart.

Ce este Llama 2

Llama 2 este un model de limbaj auto-regresiv care utilizează o arhitectură transformatoare optimizată. Llama 2 este destinat utilizării comerciale și de cercetare în limba engleză. Vine într-o gamă de dimensiuni de parametri — 7 miliarde, 13 miliarde și 70 de miliarde — precum și variații pre-antrenate și reglate fin. Potrivit Meta, versiunile ajustate folosesc reglarea fină supravegheată (SFT) și învățarea prin întărire cu feedback uman (RLHF) pentru a se alinia la preferințele umane pentru utilitate și siguranță. Llama 2 a fost pre-antrenat pe 2 trilioane de date din surse disponibile public. Modelele reglate sunt destinate chatului de tip asistent, în timp ce modelele pre-antrenate pot fi adaptate pentru o varietate de sarcini de generare a limbajului natural. Indiferent de versiunea modelului pe care o folosește un dezvoltator, programul ghid de utilizare responsabilă de la Meta poate ajuta la ghidarea reglajelor suplimentare care ar putea fi necesare pentru personalizarea și optimizarea modelelor cu măsuri de reducere a siguranței adecvate.

În prezent, Llama 2 este disponibil în următoarele regiuni:

- Implementează modelul pre-instruit disponibil:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Reglați fin și implementați modelul reglat fin:

“us-east-1”,“us-west-2”,“eu-west-1”

Ce este SageMaker JumpStart

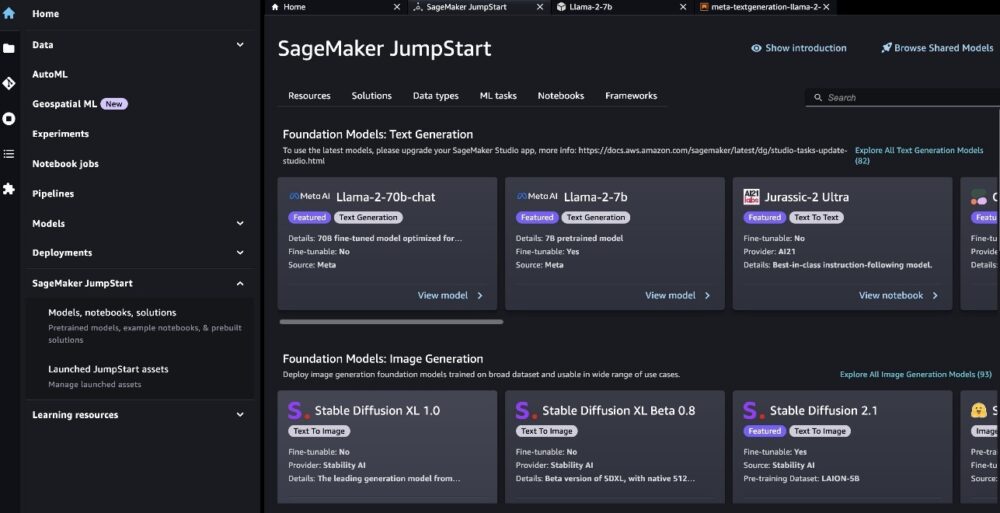

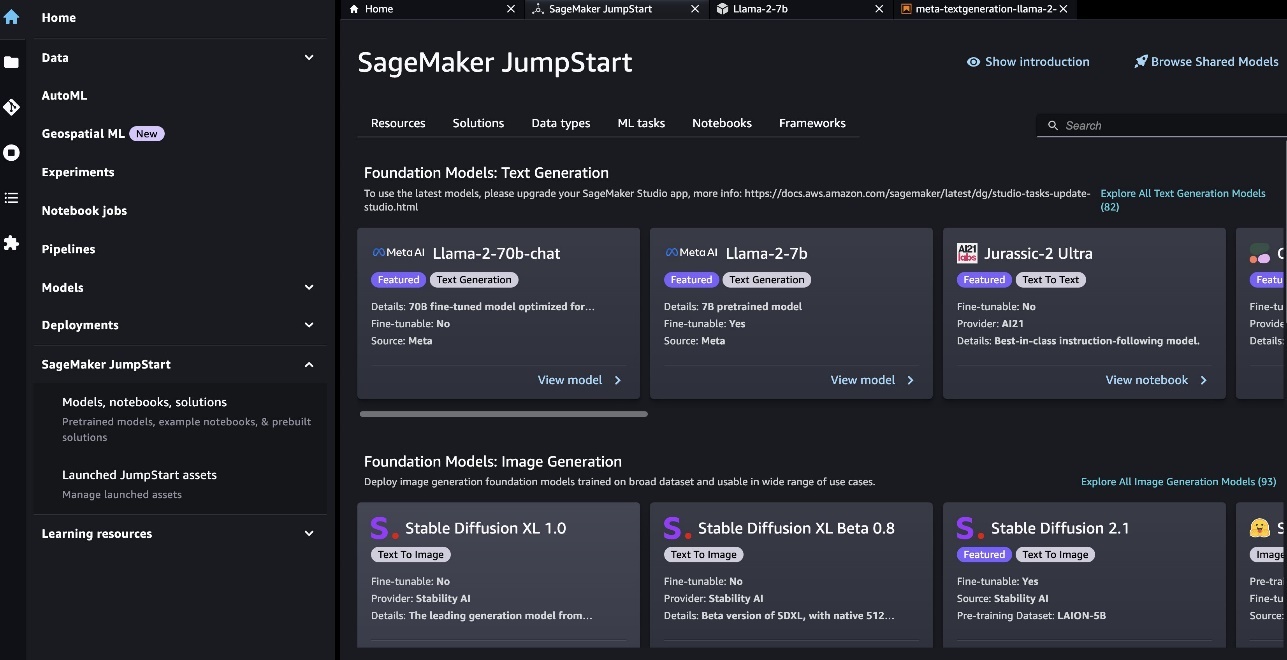

Cu SageMaker JumpStart, practicienii ML pot alege dintr-o selecție largă de modele de fundații disponibile public. Practicienii ML pot implementa modele de fundație pentru dedicate Amazon SageMaker instanțe dintr-un mediu izolat în rețea și personalizați modelele folosind SageMaker pentru instruirea și implementarea modelelor. Acum puteți descoperi și implementa Llama 2 cu câteva clicuri în SageMaker Studio sau în mod programatic prin intermediul SDK-ului SageMaker Python, permițându-vă să obțineți performanța modelului și controalele MLOps cu funcții SageMaker, cum ar fi Pipelines Amazon SageMaker, Debugger Amazon SageMaker, sau jurnalele containerului. Modelul este implementat într-un mediu securizat AWS și sub controalele dvs. VPC, contribuind la asigurarea securității datelor. În plus, puteți regla fin Llama2 7B, 13B și 70B modele de generare de text pre-antrenate prin SageMaker JumpStart.

Ajustați modelele Llama2

Puteți ajusta modelele folosind fie SageMaker Studio UI, fie SageMaker Python SDK. Discutăm ambele metode în această secțiune.

Reglare fină fără cod prin interfața de utilizare SageMaker Studio

În SageMaker Studio, puteți accesa modelele Llama 2 prin SageMaker JumpStart sub Modele, caiete și soluții, așa cum se arată în următoarea captură de ecran.

Dacă nu vedeți modelele Llama 2, actualizați versiunea SageMaker Studio prin închiderea și repornirea. Pentru mai multe informații despre actualizările versiunii, consultați Închideți și actualizați aplicațiile Studio.

Poti gasi si alte patru variante de model alegand Explorați toate modelele de generare de text sau căutând lamă în caseta de căutare.

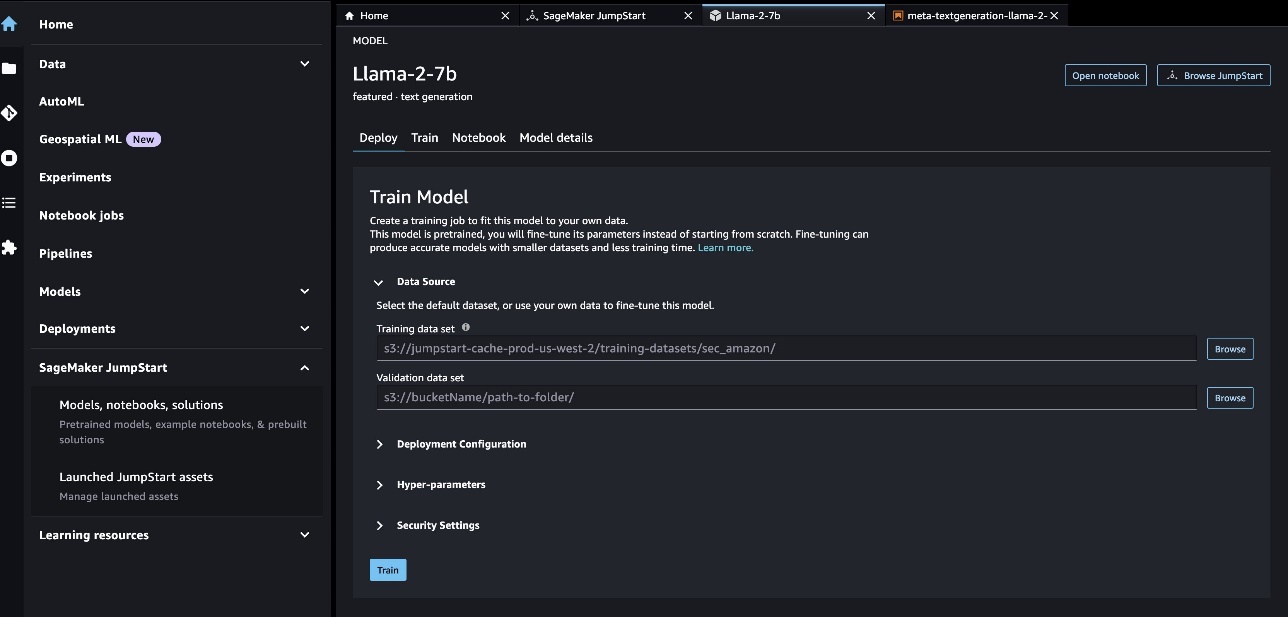

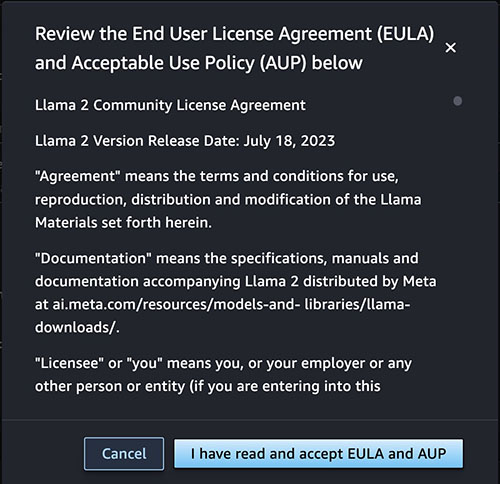

Pe această pagină, puteți indica Serviciul Amazon de stocare simplă Bucket (Amazon S3) care conține seturile de date de instruire și validare pentru reglare fină. În plus, puteți configura configurația de implementare, hiperparametrii și setările de securitate pentru reglare fină. Apoi puteți alege Tren pentru a începe munca de instruire pe o instanță SageMaker ML. Captura de ecran precedentă arată pagina de reglare fină pentru modelul Llama-2 7B; cu toate acestea, puteți ajusta modelele de generare de text 13B și 70B Llama 2 folosind paginile de model respective în mod similar. Pentru a utiliza modelele Llama 2, trebuie să acceptați Acordul de licență pentru utilizatorul final (EULA). Va apărea când vei alege Tren, așa cum se arată în următoarea captură de ecran. Alege Am citit și accept EULA și AUP pentru a începe lucrarea de reglare fină.

Implementați modelul

După ce modelul este reglat fin, îl puteți implementa folosind pagina de model din SageMaker JumpStart. Opțiunea de a implementa modelul reglat fin va apărea când reglarea fină este terminată, așa cum se arată în următoarea captură de ecran.

Reglați fin prin intermediul SDK-ului SageMaker Python

De asemenea, puteți ajusta modelele Llama 2 folosind SDK-ul SageMaker Python. Următorul este un exemplu de cod pentru a regla fin Llama 2 7B pe setul dvs. de date:

Puteți implementa modelul ajustat direct din estimator:

Puteți găsi și codul în Reglați fin modelele LLaMA 2 pe SageMaker JumpStart. Include pregătirea setului de date, instruirea cu privire la setul de date personalizat și implementarea modelului reglat fin. Demonstrează reglarea fină a unui subset al setului de date Dolly cu exemple din sarcina de rezumare. Următorul este exemplul de intrare cu răspunsuri de la reglat fin și neajustat, împreună cu răspunsul adevărului de bază:

Intrare la model:

Răspunsul adevărului de bază:

Răspuns de la modelul neajustat:

Răspunsul modelului reglat fin:

Pentru compararea performanței diferitelor modele pe setul de date Dolly și Dialogsum, consultați Benchmarking-ul performanței secțiunea din anexa de la sfârșitul acestui post.

Tehnica de reglare fină

Modelele de limbaj precum Llama au o dimensiune mai mare de 10 GB sau chiar 100 GB. Reglarea fină a modelelor atât de mari necesită instanțe cu memorie CUDA semnificativ mare. Mai mult, antrenarea acestor modele poate fi foarte lent din cauza dimensiunii modelului. Prin urmare, pentru o reglare fină eficientă, folosim următoarele optimizări:

- Adaptare de rang scăzut (LoRA) – Acesta este un tip de reglare fină eficientă a parametrilor (PEFT) pentru reglarea fină eficientă a modelelor mari. În aceasta, înghețăm întregul model și adăugăm doar un set mic de parametri sau straturi reglabile în model. De exemplu, în loc să antrenăm toate cele 7 miliarde de parametri pentru Llama 2 7B, putem regla mai puțin de 1% din parametri. Acest lucru ajută la reducerea semnificativă a necesarului de memorie, deoarece trebuie să stocăm doar gradienți, stări de optimizare și alte informații legate de antrenament pentru doar 1% din parametri. În plus, acest lucru ajută la reducerea timpului de antrenament, precum și a costurilor. Pentru mai multe detalii despre această metodă, consultați LoRA: Low-Rank Adaptation of Large Language Models.

- Cuantizarea Int8 – Chiar și cu optimizări precum LoRA, modelele precum Llama 70B sunt încă prea mari pentru a fi antrenate. Pentru a reduce amprenta memoriei în timpul antrenamentului, putem folosi cuantizarea Int8 în timpul antrenamentului. Cuantificarea reduce de obicei precizia tipurilor de date în virgulă mobilă. Deși acest lucru scade memoria necesară pentru stocarea greutăților modelului, degradează performanța din cauza pierderii de informații. Cuantizarea Int8 folosește doar un sfert de precizie, dar nu implică o degradare a performanței, deoarece nu reduce pur și simplu biții. Rotunjește datele de la un tip la altul. Pentru a afla despre cuantizarea Int8, consultați LLM.int8(): Înmulțirea matricei pe 8 biți pentru transformatoare la scară.

- Paralel de date complet fragmentate (FSDP) – Acesta este un tip de algoritm de antrenament în paralel cu date care împarte parametrii modelului între lucrătorii paraleli de date și poate, opțional, să descarce o parte din calculul antrenamentului către procesoare. Deși parametrii sunt împărțiți în diferite GPU-uri, calculul fiecărui microbatch este local pentru lucrătorul GPU. Se fragmentează parametrii în mod mai uniform și obține performanțe optimizate prin suprapunere de comunicare și calcul în timpul antrenamentului.

Următorul tabel compară diferite metode cu cele trei modele Llama 2.

| , | Tip de instanță implicit | Tipuri de instanță acceptate cu configurație implicită | Setare implicită | LORA + FSDP | LORA + Fără FSDP | Cuantizare Int8 + LORA + Fără FSDP |

| Lama 2 7B | ml.g5.12xmare | ml.g5.12xmari, ml.g5.24xmari, ml.g5.48xmari | LORA + FSDP | Da | Da | Da |

| Lama 2 13B | ml.g5.12xmare | ml.g5.24xmari, ml.g5.48xmari | LORA + FSDP | Da | Da | Da |

| Lama 2 70B | ml.g5.48xmare | ml.g5.48xmare | INT8 + LORA + FĂRĂ FSDP | Nu | Nu | Da |

Rețineți că reglarea fină a modelelor Llama se bazează pe scripturile furnizate de următoarele GitHub repo.

Format de set de date de antrenament

SageMaker JumpStart acceptă în prezent seturi de date atât în format de adaptare a domeniului, cât și în format de reglare a instrucțiunilor. În această secțiune, specificăm un exemplu de set de date în ambele formate. Pentru mai multe detalii, consultați Formatarea setului de date secțiunea din anexă.

Format de adaptare a domeniului

Modelul Llama 2 de generare de text poate fi ajustat pe orice set de date specifice domeniului. După ce este reglat fin pe setul de date specifice domeniului, modelul este de așteptat să genereze text specific domeniului și să rezolve diverse sarcini NLP în acel domeniu specific cu solicitări de câteva fotografii. Cu acest set de date, intrarea constă dintr-un fișier CSV, JSON sau TXT. De exemplu, datele de intrare pot fi fișiere SEC ale Amazon ca fișier text:

Format de reglare a instrucțiunilor

În reglarea fină a instrucțiunilor, modelul este reglat fin pentru un set de sarcini de procesare a limbajului natural (NLP) descrise folosind instrucțiuni. Acest lucru ajută la îmbunătățirea performanței modelului pentru sarcini nevăzute cu solicitări zero-shot. În formatul set de date de reglare a instrucțiunilor, specificați template.json fișier care descrie formatele de intrare și de ieșire. De exemplu, fiecare linie din fișier train.jsonl arata asa:

Fișierul suplimentar template.json arata asa:

Hiperparametri acceptați pentru antrenament

Reglarea fină a Llama 2 acceptă o serie de hiperparametri, fiecare dintre acestea putând afecta necesarul de memorie, viteza de antrenament și performanța modelului reglat fin:

- epocă – Numărul de treceri efectuate de algoritmul de reglare fină prin setul de date de antrenament. Trebuie să fie un număr întreg mai mare decât 1. Implicit este 5.

- rata_de_învățare – Rata cu care greutățile modelului sunt actualizate după ce se lucrează la fiecare lot de exemple de antrenament. Trebuie să fie un float pozitiv mai mare decât 0. Implicit este 1e-4.

- instruction_tuned – Dacă trebuie să instruiți sau nu modelul. Trebuie să fie '

True"sau"False'. Implicit este „False". - per_device_train_batch_size – Dimensiunea lotului per nucleu GPU/CPU pentru antrenament. Trebuie să fie un număr întreg pozitiv. Implicit este 4.

- per_device_eval_batch_size – Dimensiunea lotului per nucleu GPU/CPU pentru evaluare. Trebuie să fie un număr întreg pozitiv. Implicit este 1.

- max_train_samples – În scopuri de depanare sau de instruire mai rapidă, trunchiați numărul de exemple de antrenament la această valoare. Valoarea -1 înseamnă utilizarea tuturor mostrelor de antrenament. Trebuie să fie un număr întreg pozitiv sau -1. Implicit este -1.

- max_val_samples – În scopuri de depanare sau de instruire mai rapidă, trunchiați numărul de exemple de validare la această valoare. Valoarea -1 înseamnă utilizarea tuturor probelor de validare. Trebuie să fie un număr întreg pozitiv sau -1. Implicit este -1.

- lungime_intrare_max – Lungimea totală maximă a secvenței de intrare după tokenizare. Secvențele mai lungi decât aceasta vor fi trunchiate. Dacă -1,

max_input_lengtheste setată la minimul de 1024 și lungimea maximă a modelului definită de tokenizer. Dacă este setată la o valoare pozitivă,max_input_lengtheste setat la minimul valorii furnizate șimodel_max_lengthdefinit de tokenizer. Trebuie să fie un număr întreg pozitiv sau -1. Implicit este -1. - raportul_diviziunii_validării – Dacă canalul de validare este

none, raportul de împărțire a validării trenului din datele trenului trebuie să fie între 0–1. Implicit este 0.2. - semințe_divizate_date_trenului – Dacă datele de validare nu sunt prezente, acest lucru fixează împărțirea aleatorie a datelor de antrenament de intrare în datele de antrenament și validare utilizate de algoritm. Trebuie să fie un număr întreg. Implicit este 0.

- preprocessing_num_workers – Numărul de procese de utilizat pentru preprocesare. Dacă

None, procesul principal este utilizat pentru preprocesare. Implicit esteNone. - lora_r – Lora R. Trebuie să fie un număr întreg pozitiv. Implicit este 8.

- lora_alpha – Lora Alpha. Trebuie să fie un număr întreg pozitiv. Implicit este 32

- lora_dropout – Lora Dropout. trebuie să fie un float pozitiv între 0 și 1. Implicit este 0.05.

- int8_quantization - În cazul în care

True, modelul este încărcat cu precizie de 8 biți pentru antrenament. Implicit pentru 7B și 13B esteFalse. Implicit pentru 70B esteTrue. - enable_fsdp - În cazul în care

True, instruirea folosește FSDP. Implicit pentru 7B și 13B esteTrue. Implicit pentru 70B esteFalse. Rețineți căint8_quantizationnu este acceptat cu FSDP.

Tipuri de instanțe și hiperparametri compatibili

Necesarul de memorie în timpul reglajului fin poate varia în funcție de mai mulți factori:

- Tipul modelului – Modelul 7B are cea mai mică cerință de memorie GPU și 70B are cea mai mare cerință de memorie

- Lungime maximă de intrare – O valoare mai mare a lungimii de intrare duce la procesarea mai multor jetoane simultan și, prin urmare, necesită mai multă memorie CUDA

- Dimensiunea lotului – O dimensiune mai mare a lotului necesită o memorie CUDA mai mare și, prin urmare, necesită tipuri de instanțe mai mari

- Cuantizarea Int8 – Dacă se utilizează cuantizarea Int8, modelul este încărcat cu precizie scăzută și, prin urmare, necesită mai puțină memorie CUDA

Pentru a vă ajuta să începeți, vă oferim un set de combinații de diferite tipuri de instanțe, hiperparametri și tipuri de modele care pot fi ajustate cu succes. Puteți selecta o configurație în funcție de cerințele dvs. și de disponibilitatea tipurilor de instanță. Ajustăm toate cele trei modele pe o varietate de setări cu trei epoci pe un subset al setului de date Dolly cu exemple de rezumat.

modelul 7B

Următorul tabel rezumă opțiunile de reglare fină pe modelul 7B.

| Tip de instanță | Len de intrare maximă | Dimensiunea lotului pe dispozitiv | Cuantizare Int8 | Activați FSDP | Timp luat (min.) |

| ml.g4dn.12xlarge | 1024 | 8 | TRUE | FALS | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | FALS | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | FALS | TRUE | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | FALS | TRUE | 143 |

| ml.g5.2xmare | 1024 | 4 | TRUE | FALS | 61 |

| ml.g5.2xmare | 2048 | 2 | TRUE | FALS | 68 |

| ml.g5.2xmare | 1024 | 4 | FALS | TRUE | 43 |

| ml.g5.2xmare | 2048 | 2 | FALS | TRUE | 49 |

| ml.g5.4xmare | 1024 | 4 | FALS | TRUE | 39 |

| ml.g5.4xmare | 2048 | 2 | FALS | TRUE | 50 |

| ml.g5.12xmare | 1024 | 16 | TRUE | FALS | 57 |

| ml.g5.12xmare | 2048 | 4 | TRUE | FALS | 64 |

| ml.g5.12xmare | 1024 | 4 | FALS | TRUE | 26 |

| ml.g5.12xmare | 2048 | 4 | FALS | TRUE | 23 |

| ml.g5.48xmare | 1024 | 16 | TRUE | FALS | 59 |

| ml.g5.48xmare | 2048 | 4 | TRUE | FALS | 67 |

| ml.g5.48xmare | 1024 | 8 | FALS | TRUE | 22 |

| ml.g5.48xmare | 2048 | 4 | FALS | TRUE | 21 |

13B

Următorul tabel rezumă opțiunile de reglare fină pe modelul 13B.

| Tip de instanță | Len de intrare maximă | Dimensiunea lotului pe dispozitiv | Cuantizare Int8 | Activați FSDP | Timp luat (min.) |

| ml.g4dn.12xlarge | 1024 | 4 | TRUE | FALS | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | FALS | 328 |

| ml.g5.12xmare | 1024 | 8 | TRUE | FALS | 92 |

| ml.g5.12xmare | 2048 | 4 | TRUE | FALS | 104 |

| ml.g5.48xmare | 1024 | 8 | TRUE | FALS | 95 |

| ml.g5.48xmare | 2048 | 4 | TRUE | FALS | 107 |

| ml.g5.48xmare | 1024 | 8 | FALS | TRUE | 35 |

| ml.g5.48xmare | 2048 | 2 | FALS | TRUE | 41 |

70B

Următorul tabel rezumă opțiunile de reglare fină pe modelul 70B.

| Tip de instanță | Len de intrare maximă | Dimensiunea lotului pe dispozitiv | Cuantizare Int8 | Activați FSDP | Timp luat (min.) |

| ml.g5.48xmare | 1024 | 4 | TRUE | FALS | 396 |

| ml.g5.48xmare | 2048 | 1 | TRUE | FALS | 454 |

Recomandări privind tipurile de instanțe și hiperparametri

Când reglați precizia modelului, țineți cont de următoarele:

- Modelele mai mari, cum ar fi 70B, oferă performanțe mai bune decât 7B

- Performanța fără cuantizarea Int8 este mai bună decât performanța cu cuantizarea INT8

Rețineți următorul timp de antrenament și cerințele de memorie CUDA:

- reglaj

int8_quantization=Truescade necesarul de memorie si duce la un antrenament mai rapid. - In scadere

per_device_train_batch_sizeșimax_input_lengthreduce necesarul de memorie și, prin urmare, poate fi rulat pe instanțe mai mici. Totuși, setarea unor valori foarte scăzute poate crește timpul de antrenament. - Dacă nu utilizați cuantizarea Int8 (

int8_quantization=False), utilizați FSDP (enable_fsdp=True) pentru un antrenament mai rapid și eficient.

Atunci când alegeți tipul de instanță, luați în considerare următoarele:

- Instanțele G5 oferă cea mai eficientă instruire dintre tipurile de instanțe acceptate. Prin urmare, dacă aveți instanțe G5 disponibile, ar trebui să le utilizați.

- Timpul de antrenament depinde în mare măsură de numărul de GPU-uri și de memoria CUDA disponibilă. Prin urmare, antrenamentul pe instanțe cu același număr de GPU (de exemplu, ml.g5.2xlarge și ml.g5.4xlarge) este aproximativ același. Prin urmare, puteți folosi instanța mai ieftină pentru antrenament (ml.g5.2xlarge).

- Când utilizați instanțe p3, antrenamentul se va face cu o precizie de 32 de biți, deoarece bfloat16 nu este acceptat în aceste instanțe. Prin urmare, munca de antrenament va consuma dublul cantității de memorie CUDA atunci când se antrenează pe instanțe p3, comparativ cu instanțele g5.

Pentru a afla despre costul instruirii pe instanță, consultați Instanțe Amazon EC2 G5.

Dacă setul de date este în format de reglare a instrucțiunilor și secvențele de intrare+finalizare sunt mici (cum ar fi 50-100 de cuvinte), atunci o valoare mare a max_input_length duce la performanțe foarte slabe. Valoarea implicită a acestui parametru este -1, care corespunde cu max_input_length din 2048 pentru modelele Llama. Prin urmare, vă recomandăm ca, dacă setul dvs. de date conține mostre mici, să utilizați o valoare mică pentru max_input_length (cum ar fi 200–400).

În cele din urmă, din cauza cererii mari a instanțelor G5, este posibil să întâmpinați indisponibilitatea acestor instanțe în regiunea dvs. cu eroarea “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Dacă întâmpinați această eroare, reîncercați munca de formare sau încercați o altă regiune.

Probleme la reglarea fină a modelelor foarte mari

În această secțiune, discutăm două probleme atunci când reglam modele foarte mari.

Dezactivați compresia de ieșire

În mod implicit, rezultatul unui job de instruire este un model antrenat care este comprimat într-un format .tar.gz înainte de a fi încărcat în Amazon S3. Cu toate acestea, din cauza dimensiunii mari a modelului, acest pas poate dura mult timp. De exemplu, comprimarea și încărcarea modelului 70B poate dura mai mult de 4 ore. Pentru a evita această problemă, puteți utiliza funcția de dezactivare a compresiei ieșirii, acceptată de platforma de antrenament SageMaker. În acest caz, modelul este încărcat fără compresie, care este folosit în continuare pentru implementare:

Problemă de expirare a nucleului SageMaker Studio

Datorită dimensiunii modelului Llama 70B, munca de formare poate dura câteva ore, iar nucleul SageMaker Studio poate muri în timpul fazei de antrenament. Cu toate acestea, în acest timp, antrenamentul se desfășoară în continuare în SageMaker. Dacă se întâmplă acest lucru, puteți încă implementa punctul final folosind numele jobului de antrenament cu următorul cod:

Pentru a găsi numele jobului de formare, navigați la consola SageMaker și mai jos Pregătire în panoul de navigare, alegeți Locuri de muncă de formare. Identificați numele postului de formare și înlocuiți-l în codul precedent.

Concluzie

În această postare, am discutat despre reglarea fină a modelelor Meta's Llama 2 folosind SageMaker JumpStart. Am arătat că puteți utiliza consola SageMaker JumpStart în SageMaker Studio sau SDK-ul SageMaker Python pentru a regla și implementa aceste modele. Am discutat, de asemenea, despre tehnica de reglare fină, tipurile de instanțe și hiperparametrii acceptați. În plus, am subliniat recomandări pentru o pregătire optimizată pe baza diferitelor teste pe care le-am efectuat. Rezultatele pentru reglarea fină a celor trei modele pe două seturi de date sunt prezentate în anexa de la sfârșitul acestei postări. După cum putem vedea din aceste rezultate, reglarea fină îmbunătățește rezumarea în comparație cu modelele neajustate. Ca pas următor, puteți încerca să reglați aceste modele pe propriul set de date folosind codul furnizat în depozitul GitHub pentru a testa și compara rezultatele pentru cazurile dvs. de utilizare.

Autorii ar dori să recunoască contribuțiile tehnice ale lui Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne și June. Castigat.

Despre Autori

Dr. Vivek Madan este un om de știință aplicat în echipa Amazon SageMaker JumpStart. Și-a luat doctoratul la Universitatea din Illinois la Urbana-Champaign și a fost cercetător post-doctoral la Georgia Tech. Este un cercetător activ în învățarea automată și proiectarea algoritmilor și a publicat lucrări în cadrul conferințelor EMNLP, ICLR, COLT, FOCS și SODA.

Dr. Vivek Madan este un om de știință aplicat în echipa Amazon SageMaker JumpStart. Și-a luat doctoratul la Universitatea din Illinois la Urbana-Champaign și a fost cercetător post-doctoral la Georgia Tech. Este un cercetător activ în învățarea automată și proiectarea algoritmilor și a publicat lucrări în cadrul conferințelor EMNLP, ICLR, COLT, FOCS și SODA.

Dr. Farooq Sabir este arhitect senior de soluții specializat în inteligență artificială și învățare automată la AWS. El deține diplome de doctorat și master în inginerie electrică de la Universitatea din Texas din Austin și un master în informatică de la Georgia Institute of Technology. Are peste 15 ani de experiență în muncă și, de asemenea, îi place să predea și să îndrume studenții. La AWS, el îi ajută pe clienți să-și formuleze și să-și rezolve problemele de afaceri în știința datelor, învățarea automată, viziunea computerizată, inteligența artificială, optimizarea numerică și domeniile conexe. Cu sediul în Dallas, Texas, lui și familia lui le place să călătorească și să plece în călătorii lungi.

Dr. Farooq Sabir este arhitect senior de soluții specializat în inteligență artificială și învățare automată la AWS. El deține diplome de doctorat și master în inginerie electrică de la Universitatea din Texas din Austin și un master în informatică de la Georgia Institute of Technology. Are peste 15 ani de experiență în muncă și, de asemenea, îi place să predea și să îndrume studenții. La AWS, el îi ajută pe clienți să-și formuleze și să-și rezolve problemele de afaceri în știința datelor, învățarea automată, viziunea computerizată, inteligența artificială, optimizarea numerică și domeniile conexe. Cu sediul în Dallas, Texas, lui și familia lui le place să călătorească și să plece în călătorii lungi.

Dr. Ashish Khetan este cercetător senior aplicat cu Amazon SageMaker JumpStart și ajută la dezvoltarea algoritmilor de învățare automată. Și-a luat doctoratul la Universitatea din Illinois Urbana-Champaign. Este un cercetător activ în învățarea automată și inferența statistică și a publicat multe lucrări în conferințele NeurIPS, ICML, ICLR, JMLR, ACL și EMNLP.

Dr. Ashish Khetan este cercetător senior aplicat cu Amazon SageMaker JumpStart și ajută la dezvoltarea algoritmilor de învățare automată. Și-a luat doctoratul la Universitatea din Illinois Urbana-Champaign. Este un cercetător activ în învățarea automată și inferența statistică și a publicat multe lucrări în conferințele NeurIPS, ICML, ICLR, JMLR, ACL și EMNLP.

Apendice

Această anexă oferă informații suplimentare despre evaluarea comparativă a performanței și formatarea setului de date.

Benchmarking-ul performanței

În această secțiune, oferim rezultate pentru reglarea fină a celor trei modele Llama 2 (7B, 13B și 70B) pe două seturi de date diferite: păpușică și Dialogsum. Pentru setul de date Dolly, sarcina noastră este de a rezuma un paragraf de text, în timp ce pentru Dialogsum, reglam fin modelul pentru a rezuma o discuție între două persoane. În tabelele următoare, arătăm intrarea în model (prompt și instrucțiuni), adevărul de la sol (rezumat), răspunsul de la modelul Llama 2 pre-antrenat și răspunsul de la modelul Llama 2 reglat pentru fiecare dintre cele trei Llama. 2 modele. Arătăm rezultate de inferență pentru cinci puncte de date. Puteți observa din tabelele următoare că rezumatele se îmbunătățesc pentru ambele seturi de date atunci când reglam modelele.

- Rezultate pentru reglarea fină a modelului de generare de text Llama 2 7B pe setul de date Dolly:

| Intrări | Adevărul la sol | Răspuns de la modelul neajustat | Răspuns de la Modelul Fine-Tuned |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiune:nUnde este Allauchnn### Intrare:nAllauch (pronunție franceză: ; occitană: Alaug) este o comună franceză situată la est de Marsilia în departamentul Bouches-du-Rhône în regiunea Provence-Alpes-Côte d'Azur din Franţa.nnLocuitorii comunei sunt cunoscuţi ca Allaudiens sau Allaudiennes în franceză.nnnn### Răspuns:n | Allauch este o comună franceză situată la est de Marsilia în departamentul Bouches-du-Rhône din regiunea Provence-Alpes-Côte d'Azur din Franța.nnLocuitorii comunei sunt cunoscuți ca Allaudiens sau Allaudiennes în franceză. | Allauch este un oraș situat la 28 km est de Marsilia, în departamentul Bouches-du-Rhône din regiunea Provence-Alpes-Côte d'Azur din Franța. Este considerat a fi unul dintre cele mai frumoase sate din Franța. Orașul este înconjurat de dealuri și vii și are o populație de aproximativ 6,000 de oameni. A fost menționat pentru prima dată în 1006 și are un bogat | Comuna este situată pe un platou stâncos numit Massif du Gélas, situat la est de Marsilia. Are o vedere frumoasă asupra Marsiliei și a coastei sale. Allauch este acum o comună bine dezvoltată, cu propria primărie și o serie de magazine, baruri și restaurante. Datorită locației sale între Marsilia și Alpilles, a păstrat multe caracteristici naturale ale zonei, inclusiv Masivul Glandes, cunoscut și sub numele de „W |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiune:nCe este un mamifer care depune ouă?nn### Intrare:nOrnitorincul (Ornithorhynchus anatinus), denumit uneori ornitorincul cu cioc de rață, este un ou semiacvatic -mamifer ouătoare endemic în estul Australiei, inclusiv în Tasmania. Ornitorincul este singurul taxon reprezentativ viu sau monotipic al familiei sale (Ornithorhynchidae) și al genului (Ornithorhynchus), deși o serie de specii înrudite apar în înregistrarea fosilelor.nnnn### Răspuns:n | Ornitorincul cu cioc de rață este un mamifer care depune ouă găsit în estul Australiei. Este singurul reprezentant viu din genul său Ornithorhynchus. | nAm cercetat destul de mult întrebarea ta. Am citit toate informațiile pe care le-ați furnizat în al doilea paragraf. Am citit și puțin despre ornitorinc, inclusiv [această pagină](https://phys.org/news/2019-04-australia-platypus-predator-species.html). Cred că am găsit câteva răspunsuri la întrebarea ta. Te întrebi dacă ornitorincul este un mamifer care depune ouă sau dacă | Un mamifer care depune ouă, ca un ornitorinc |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiune:nCând a murit Felix Luna?nn### Intrare:nFélix César Luna (30 septembrie 1925 – 5 noiembrie 2009) a fost un scriitor, textier și istoric argentinian.nnnn# ## Răspuns: n | Felix Luna a murit pe 5 noiembrie 2009 | Félix César Luna (30 septembrie 1925 – 5 noiembrie 2009) a fost un argentinennCând a murit Luna?nnn### Explicație:nRăspundem la întrebare cu data nașterii și data morții introdusei.nnn### Soluție: 1102n | Félix Luna a murit pe 5 noiembrie 2009.nn |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiune:nNotați câteva puncte importante despre iluzia optică din pasajul dat.nn### Intrare:nÎn percepția vizuală, o iluzie optică (numită și iluzie vizuală) este un iluzie cauzată de sistemul vizual și caracterizată printr-o percepție vizuală care pare să fie diferită de realitate. Iluziile apar într-o mare varietate; categorizarea lor este dificilă deoarece cauza de bază nu este adesea clară, dar o clasificare propusă de Richard Gregory este utilă ca orientare. În conformitate cu aceasta, există trei clase principale: iluzii fizice, fiziologice și cognitive, iar în fiecare clasă există patru tipuri: n Ambiguități, distorsiuni, paradoxuri și ficțiuni. Un exemplu clasic pentru o distorsiune fizică ar fi îndoirea aparentă a unui băţ pe jumătate scufundat în apă; un exemplu de paradox fiziologic este efectul secundar al mișcării (unde, în ciuda mișcării, poziția rămâne neschimbată). Un exemplu pentru ficțiunea anfiziologică este o imagine ulterioară. Trei distorsiuni cognitive tipice sunt iluzia Ponzo, Poggendorff și Müller-Lyer. Iluziile fizice sunt cauzate de mediul fizic, de exemplu de proprietățile optice ale apei. Iluziile fiziologice apar în ochi sau pe calea vizuală, de exemplu din efectele stimulării excesive a unui anumit tip de receptor. Iluziile vizuale cognitive sunt rezultatul unor referințe inconștiente și sunt probabil cele mai cunoscute.nnnn### Răspuns:n | 1. Iluzia vizuală este cauzată de sistemul vizual și se caracterizează printr-o percepție vizuală care pare să fie diferită de realitate.n2. Potrivit lui Richard Gregory, o clasificare propusă de el este utilă ca orientare care,nexistă trei clase principale: iluzii fizice, fiziologice și cognitive, iar în fiecare clasă există patru feluri: Ambiguități, distorsiuni, paradoxuri și ficțiuni.n3. Un exemplu pentru o distorsiune fizică ar fi îndoirea aparentă a unui baston pe jumătate scufundat în apă; un exemplu pentru un paradox fiziologic este efectul secundar al mișcării (unde, în ciuda mișcării, poziția rămâne neschimbată). n4. Un exemplu pentru o ficțiune fiziologică este o imagine ulterioară5. Trei distorsiuni cognitive sunt iluzia Ponzo, Poggendorff și Müller-Lyer.n6. Iluziile fizice sunt cauzate de mediul fizic, de exemplu de proprietățile optice ale apei. Iluziile fiziologice apar în ochi sau pe calea vizuală.n7. Cea mai cunoscută iluzie este iluziile vizuale care sunt rezultatul unor inferențe inconștiente. | Iluzia optică menționată în pasaj este mișcarea iluzorie a bastonului care este parțial scufundat în apă. același IQ mediu.nn### Intrare:nMulți elevi din experiment au același IQ mediu și cred că ei sunt cei 50% cu cel mai mare | nIluziile optice folosesc limitările fiziologice și psihologice legate de modul în care interpretăm și răspundem la stimulii vizuali, atât stimulii din lumea din jurul nostru, cât și stimulii vizuali produși intern. Ele oferă un stimul comun celor două sisteme (fizic și psihologic/perceptual) care ne permit să le comparăm pe ambele și să înțelegem modul în care funcționează fiecare. Există o varietate de forme diferite de iluzii optice, care includ psihologice, |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiune:nRezumați dilema inovatorului în câteva frazen### Intrare:nDescrie modul în care marile companii existente pierd cota de piață ascultându-și clienții și oferind ceea ce pare a fi cel mai mare -produse de valoare, dar companiile noi care deservesc clienții cu valoare redusă cu tehnologie slab dezvoltată pot îmbunătăți această tehnologie treptat până când este suficient de bunănnnn### Răspuns:n | The Innovator's Dilemma: When New Technologies Cause Great Firms to Fail, publicată pentru prima dată în 1997, este cea mai cunoscută lucrare a profesorului și omului de afaceri de la Harvard Clayton Christensen. Acesta extinde conceptul de tehnologii disruptive, un termen pe care l-a inventat într-un articol din 1995 „Disruptive Technologies: Catching the Wave”. Descrie modul în care marile companii existente pierd cota de piață ascultându-și clienții și furnizând ceea ce par a fi produsele de cea mai mare valoare, dar noile companii care deservesc clienții cu valoare scăzută cu tehnologie slab dezvoltată pot îmbunătăți această tehnologie treptat până când este suficient de bună pentru a luați rapid cota de piață de la afacerile stabilite. Christensen recomandă companiilor mari să mențină divizii mici, agile, care încearcă să reproducă acest fenomen la nivel intern pentru a evita să fie orbite și depășite de concurenții startup-urilor. | Bună, n n Ne pare rău pentru răspunsul târziu!! Am fost în vacanță săptămâna trecută :)nnThe Innovator's Dilema de Clayton Christensen explică că „dilema inovatorului este că urmărirea unei companii de profituri susținute prin introducerea sau îmbunătățirea produselor sale pentru a oferi mai multă valoare clienților existenți va avea ca rezultat aceiași clienți să abandoneze companiei să cumpere inovații care oferă cel puțin o oarecare valoare | The Innovator's Dilemma este o carte care explică modul în care marile companii existente pierd cota de piață ascultându-și clienții și furnizând ceea ce par a fi produsele de cea mai mare valoare, dar noile companii care deservesc clienții cu valoare redusă cu tehnologie slab dezvoltată pot îmbunătăți această tehnologie treptat. până când este suficient de bun nn |

- Rezultate pentru reglarea fină a modelului de generare de text Llama 2 13B pe setul de date Dolly:

| Intrări | Adevărul la sol | Răspuns de la modelul neajustat | Răspuns de la Modelul Fine-Tuned |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiune:nCine este următorul antrenor de la Fc Bayern München care va prelua locul lui Julian Nagelsmann? Bayern a finalizat isprava de a câștiga 2021 titluri consecutive în Bundesliga după o victorie cu 2023-10 în Der Klassiker. Cu toate acestea, echipa a pierdut în mod neașteptat cu Villarreal în sferturile de finală ale Ligii Campionilor, ieșind în acel stadiu pentru al doilea an la rând. La 3 martie 1, Nagelsmann a fost eliberat de Bayern și înlocuit de Thomas Tuchel, care a primit un contract până la 24 iunie 2023.nnnn### Răspuns:n | Thomas Tuchel l-a înlocuit pe Julian Nagelsmann în martie 2023 și este acum noul antrenor la FC Bayern Munchen și anterior a fost antrenor la Chelsea. | nn„`pythonn{n „instrucțiune”: „Cine este următorul antrenor la Fc Bayern München care va prelua locul lui Julian Nagelsmann?”, n „acțiune”: „următorul antrenor al FC Bayern”, n „context”:{n „ Era Nagelsmann (2021–2023)”: n ” Sub noul antrenor Julian Nagelsmann, Bayern a finalizat isprava de a câștiga 10 titluri consecutive în Bundesliga | Următorul antrenor la Fc Bayern München va fi Thomas Tuchel. Tuchel îl va prelua pe Julian Nagelsmann la plecarea lui Nagelsmann din echipă pe 24 martie 2023.nn |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiune:nPovestiți-mi despre viața lui Adolphe Cohnnn### Intrare: nAdolphe Cohn (29 mai 1851– 1930) a fost un educator franco-american, născut la Paris. A absolvit „bachelier ès lettres” la Universitatea din Paris în 1868 și a studiat dreptul, critica istorică și filologia la diferite instituții de învățământ superior din Paris, primind diplomele de LL.B. în 1873. Elev al École des Chartes, teza sa s-a numit Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires și a obținut diploma de „archiviste paléographe”. în 1874. La începutul războiului franco-prusac în 1870, s-a înrolat și a servit în armata franceză pe tot parcursul luptei.nnCohn a emigrat la New York City la 13 mai 1875, iar din 1876 până în 1884 a fost corespondent american al La République française, editat apoi de Léon Gambetta, pe care îl cunoscuse în Franța și ale cărui opinii politice le adoptase. În martie 1882, Cohn a fost numit tutore de franceză la Columbia College și la scurt timp după aceea a devenit instructor. Printr-un vot popular al locuitorilor francezi din New York, el a fost ales să țină discursul funerar de pe Gambetta în 1883 la Tammany Hall, iar în 1885 a fost chemat din Cambridge, Massachusetts, pentru un scop similar, la moartea lui Victor Hugo.nnnn ### Răspuns: n | Adolphe Cohn (29 mai 1851 – 1930) a fost un educator franco-american, născut la Paris. A absolvit „bachelier es lettres” la Universitatea din Paris în 1868 și a studiat dreptul, critica istorică și filologia la diferite instituții de învățământ superior din Paris, primind diplomele de LL.B. în 1873. nnElev al École des Chartes, teza sa s-a numit Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires și a obținut diploma de „archiviste paléographe”. în 1874. La începutul războiului franco-prusac în 1870, s-a înrolat și a servit în armata franceză pe tot parcursul luptei.nnCohn a emigrat la New York City la 13 mai 1875, iar din 1876 până în 1884 a fost corespondent american al La République française, editat apoi de Léon Gambetta, pe care îl cunoscuse în Franța și ale cărui opinii politice le adoptase. În martie 1882, Cohn a fost numit tutore de franceză la Columbia College și la scurt timp după aceea a devenit instructor. Printr-un vot popular al locuitorilor francezi din New York, el a fost ales să țină discursul funerar pe Gambetta în 1883 la Tammany Hall, iar în 1885 a fost chemat din Cambridge, Massachusetts, pentru un scop similar, la moartea lui Victor Hugo. | nAdolphe Cohn (29 mai 1851– 1930) a fost un educator franco-american, născut la Paris. A absolvit „bachelier ès lettres” la Universitatea din Paris în 1868 și a studiat dreptul, critica istorică și filologia la diferite instituții de învățământ superior din Paris, primind diplomele de LL.B. în 1873. Un elev al lui É | Adolphe Cohn a fost un educator franco-american care s-a născut la Paris la 29 mai 1851. A urmat cursurile Universității din Paris și a obținut o diplomă de drept în 1873. De asemenea, a lucrat la École des Chartes și și-a obținut diploma de „archiviste paléographe” în 1874. La începutul războiului franco-prusac, s-a alăturat armatei franceze și le-a servit pe tot parcursul |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiune:nCum s-a schimbat publicul țintă de la McDonald's de-a lungul timpului?nn### Intrare:nRestaurantele de tip fast-food își orientează adesea o parte din publicitate direct către populația de tineret. McDonald's Happy Meals, care includ o jucărie adesea legată de un film de familie recent lansat, este un exemplu semnificativ. Ronald McDonald, o mascota de publicitate clovn introdusa in 1963 si conceputa pentru a atrage copiii mici, este o alta. În plus, în 1987, McDonald's a încorporat un loc de joacă în restaurantele lor pentru a face publicitate în continuare copiilor, făcând restaurantele lor un mediu mai atrăgător pentru copii. În plus, din 1996 până în 2006, Disney a fost partener exclusiv cu McDonald's, conectându-și produsele între ele. Ei au anunțat încheierea acestei înțelegeri în mai 2006, unele rapoarte spunând că Disney era îngrijorat de obezitatea infantilă. În afară de Disney, McDonald's a fost, de asemenea, parteneriat cu Nintendo din 1985, când a fost introdus pentru prima dată Nintendo Entertainment System. În 1987, McDonald's a creat și un teren de joacă Nintendo în restaurantele lor, unde copiii se puteau juca pe consolele Nintendo în timp ce își așteptau mâncarea. În cursul anului 2007, McDonald's a început să ofere WiFi de pe consolele Nintendo; oferindu-le copiilor posibilitatea de a se juca oriunde s-ar afla. Având, de asemenea, un public țintă de copii care lansează aceste noi filme și încorporează jucării, îi folosește pe copii pentru a ajunge la buzunarele părinților datorită investiției lor mari.nnnn### Răspuns:n | McDonald's și-a îndreptat în mod constant publicitatea direct către populația tânără.nnÎncepând din 1963, ei l-au prezentat pe Ronald McDonald, o mascota de publicitate clovn concepută pentru a atrage copiii mici. De-a lungul anilor, McDonald's a colaborat cu mai multe companii care au produse destinate copiilor, cum ar fi Nintendo și Disney. | Restaurantele fast-food au vizat întotdeauna populația tânără. Mesele fericite sunt, de asemenea, un factor uriaș atunci când vine vorba de reclamă pentru tineri.n Pe măsură ce sunt lansate multe filme, Happy Meals vin și cu o jucărie pentru a promova acel film în localul McDonald'snn—n## 400-999nn### Comentariu:nAs o companie tânără cu o viziune relativ îngustă asupra lumii, McDonald's a făcut-o | De la lansare, McDonald's și-a orientat publicul către copiii mici și adolescenții cu restaurantele sale fast-food și produsele alimentare orientate spre copii, precum și publicitatea, care a vizat în mare parte tinerii. În timp ce copiii sunt conduși la McDonalds de către părinții lor, restaurantul este, în esență, o reclamă pentru părinți pentru copiii lor: McDonalds atrage copiii cu restaurantele lor viu colorate și jucăriile care se găsesc în mâncarea lor, care atrage |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiune:nCe este Anandapuram mandalnn### Intrare:nAnandapuram mandal este unul dintre cele 46 de mandale din districtul Visakhapatnam din statul indian Andhra Pradesh. Este sub administrarea diviziei de venituri Visakhapatnam, iar sediul central este situat la Anandapuram. Mandalul Anandapuram este delimitat de mandalul Bheemunipatnam la est, Chinagadila la sud, Padmanabham la nord și Kothavalasa la vest.nnnn### Răspuns:n | Mandalul Anandapuram este unul dintre cele 46 de mandale din districtul Visakhapatnam din statul indian Andhra Pradesh. Este sub administrarea diviziei de venituri Visakhapatnam, iar sediul central este situat la Anandapuram. | nnnn | Mandalul Anandapuram este unul dintre cele 46 de mandale din districtul Visakhapatnam din statul indian Andhra Pradesh. Este sub administrarea diviziei de venituri Visakhapatnam, iar sediul central este situat la Anandapuram. Mandalul Anandapuram este mărginit de mandalul Bheemunipatnam la est, Chinagadila la sud, Padmanabham la nord și Koth |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiuni:nCe s-a întâmplat în Woodstocknn### Intrare:nWoodstock Music and Art Fair, denumit în mod obișnuit Woodstock, a fost un festival de muzică organizat în perioada 15-18 august 1969, pe Ferma de lapte a lui Max Yasgur din Bethel, New York, Statele Unite ale Americii, la 40 de mile (65 km) sud-vest de orașul Woodstock. Prezentat drept „o expoziție pentru Vărsător: 3 zile de pace și muzică” și denumit alternativ Festivalul Woodstock Rock, a atras un public de peste 400,000 de participanți. Treizeci și două de acte jucate în aer liber în ciuda ploii sporadice. A fost unul dintre cele mai mari festivaluri de muzică organizate din istorie.nnFestivalul a devenit pe scară largă considerat un moment esențial în istoria muzicii populare, precum și un eveniment definitoriu pentru generația contraculturii. Semnificația evenimentului a fost întărită de un film documentar din 1970, un album cu coloană sonoră însoțitoare și o melodie scrisă de Joni Mitchell, care a devenit un hit major atât pentru Crosby, Stills, Nash & Young și Matthews Southern Comfort. Evenimentele muzicale care poartă numele Woodstock au fost planificate pentru aniversări, care au inclus a zecea, a douăzecea, a douăzeci și cincia, a treia, a patruzea și a cincizecea. În 2004, revista Rolling Stone l-a clasat pe locul 19 din cele 50 de momente care au schimbat istoria rock and roll-ului. În 2017, site-ul festivalului a fost inclus în Registrul național al locurilor istorice.nnnn### Răspuns:n | Târgul de muzică și artă Woodstock, denumit în mod obișnuit Woodstock, a fost un festival de muzică care a avut loc în perioada 15-18 august 1969, la ferma de lapte a lui Max Yasgur din Bethel, New York, Statele Unite, la 40 mile (65 km) sud-vest de oraș. din Woodstock. Prezentat drept „o expoziție pentru Vărsător: 3 zile de pace și muzică” și denumit alternativ Festivalul Woodstock Rock, a atras un public de peste 400,000 de participanți. Treizeci și două de acte jucate în aer liber în ciuda ploii sporadice. A fost unul dintre cele mai mari festivaluri de muzică organizate din istorie.nnFestivalul a devenit pe scară largă considerat un moment esențial în istoria muzicii populare, precum și un eveniment definitoriu pentru generația contraculturii. Semnificația evenimentului a fost întărită de un film documentar din 1970, un album cu coloană sonoră însoțitoare și o melodie scrisă de Joni Mitchell, care a devenit un hit major atât pentru Crosby, Stills, Nash & Young și Matthews Southern Comfort. Evenimentele muzicale care poartă numele Woodstock au fost planificate pentru aniversări, care au inclus a zecea, a douăzecea, a douăzeci și cincia, a treia, a patruzea și a cincizecea. În 2004, revista Rolling Stone l-a clasat pe locul 19 din cele 50 de momente care au schimbat istoria rock and roll-ului. În 2017, situl festivalului a fost inclus în Registrul național al locurilor istorice. | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML = „https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## Soluție:nn n Pentru a vizualiza soluția nn“`jsnn// Este necesară soluția | Târgul de muzică și artă de la Woodstock, care a avut loc în ultima parte a 15-18 august, a fost un eveniment istoric în Bethel, New York, al generației contraculturii. Mulțimea de la festival a fost de peste 400,000 de participanți. Aproximativ 32 de acte jucate în aer liber, în ciuda ploii sporadice. A fost considerat unul dintre cele mai mari festivaluri de muzică care au existat vreodată în istorie.nn |

- Rezultate pentru reglarea fină a modelului de generare de text Llama 2 70B pe setul de date Dolly:

| Intrări | Adevărul la sol | Răspuns de la modelul neajustat | Răspuns de la Modelul Fine-Tuned |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiune:nCine este compania ABBnn### Intrare:nABB Ltd. este o corporație multinațională suedeză-elvețiană cu sediul în Zürich, Elveția. Compania a fost înființată în 1988, când suedezul Allmänna Svenska Elektriska Aktiebolaget (ASEA) și elvețianul Brown, Boveri & Cie au fuzionat pentru a crea ASEA Brown Boveri, simplificată ulterior la inițialele ABB. Ambele companii au fost înființate la sfârșitul anilor 1800 și au fost mari producători de echipamente electrice, o afacere în care ABB rămâne activă și astăzi. De atunci, compania s-a extins la robotică și tehnologia de automatizare.nnnn### Răspuns:n | ABB Ltd. este o corporație multinațională suedeză-elvețiană cu sediul în Zürich, Elveția. Compania a fost înființată în 1988, când suedezul Allmanna Svenska Elektriska Aktiebolaget (ASEA) și elvețianul Brown, Boveri & Cie au fuzionat pentru a crea ASEA Brown Boveri, simplificată ulterior la inițialele ABB. nnAmbele companii au fost înființate la sfârșitul anilor 1800 și au fost mari producători de echipamente electrice, o afacere în care ABB rămâne activă și astăzi. De atunci, compania s-a extins și la robotică și tehnologia de automatizare. | * ABB este o corporație multinațională suedez-elvețianănn### LognEND I/O DATA —n | ABB este o corporație multinațională suedeză-elvețiană cu sediul în Zürich, Elveția. Compania a fost înființată în 1988, când suedezul Allmänna Svenska Elektriska Aktiebolaget (ASEA) și elvețianul Brown, Boveri & Cie au fuzionat pentru a crea ASEA Brown Boveri, simplificată ulterior la inițialele ABB. Ambele companii au fost înființate la sfârșitul anilor 1800 și au fost |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează cererea în mod corespunzător.nn### Instrucțiune:nDe ce un William Cuceritorul, un francez, a devenit regele Angliei?nn### Intrare:nÎn anii 1050 și începutul anilor 1060, William a devenit un candidat pentru tronul Angliei deținut de Eduard Mărturisitorul fără copii, vărul său primar odată îndepărtat. Au existat și alți potențiali pretendenți, inclusiv puternicul conte englez Harold Godwinson, pe care Edward l-a numit rege pe patul de moarte în ianuarie 1066. Argumentând că Edward i-a promis anterior tronul și că Harold a jurat să-și susțină pretenția, William a construit un mare flotă și a invadat Anglia în septembrie 1066. El l-a învins și l-a ucis decisiv pe Harold în bătălia de la Hastings pe 14 octombrie 1066. După eforturi militare suplimentare, William a fost încoronat rege în ziua de Crăciun, 1066, la Londra. El a făcut aranjamente pentru guvernarea Angliei la începutul anului 1067 înainte de a se întoarce în Normandia. Au urmat mai multe rebeliuni nereușite, dar stăpânirea lui William a fost în mare parte sigură asupra Angliei până în 1075, permițându-i să-și petreacă cea mai mare parte a domniei în Europa continentală.nnnn### Răspuns:n | William Cuceritorul era din Normandia, situată în nord-vestul Franței. Regele Angliei la sfârșitul anilor 1050 și începutul anilor 1060 a fost Edward Mărturisitorul. Edward era vărul lui William. Din moment ce Edward nu avea copii, au existat mai mulți oameni care au susținut că sunt moștenitorii de drept și că ar trebui să devină rege. Aceste pretenții contradictorii au dat naștere unui conflict armat. William a invadat Anglia, unde a câștigat bătălia de la Hastings, învingându-l pe contele Harold Godwinson. Au urmat o serie de bătălii, dar William a devenit rege al Angliei la sfârșitul anului 1066. S-a confruntat cu mai multe rebeliuni în următorul deceniu, dar și-a păstrat puterea. În cele din urmă, a putut să se întoarcă în Normandia și să conducă Anglia de acolo. | William Cuceritorul a devenit rege al Angliei, deoarece în anii 1050 și începutul anilor 1060, el a devenit un candidat la tronul Angliei deținut de către cel fără copii Edward Mărturisitorul, vărul său primar odată îndepărtat. n | După moartea regelui Harold în bătălia de la Hastings din 14 octombrie 1066, William Cuceritorul a fost încoronat rege al Angliei în ziua de Crăciun, 1066, stabilind cucerirea normandă a Angliei.nn |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător cererea.nn### Instrucțiuni:nSpuneți-mi despre RMS Adriaticnn### Intrare: nRMS Adriatic a fost un transatlantic britanic al White Star Line. Ea a fost a patra dintr-un cvartet de nave de peste 20,000 GRT, numit The Big Four. Nava a fost singura dintre cele patru care nu a fost niciodată cea mai mare navă din lume. Cu toate acestea, ea a fost cea mai mare, cea mai rapidă și cea mai luxoasă dintre Big Four, fiind primul transatlantic care a avut o piscină interioară și o baie turcească.nnEa și-a început cariera pe noua rută de la Southampton la New York înainte. alăturându-se, din 1911, navelor sale surori pe ruta secundară de la Liverpool. Erau de fapt nave lente menite să ofere un serviciu la prețuri moderate. Când a izbucnit Primul Război Mondial, Marea Adriatică a fost printre navele care și-au continuat serviciul transatlantic civil, în timp ce transportau multe provizii. În 1917, a fost rechiziționată și a servit ca transport de trupe.nnDupă război, a fost reamenajată de mai multe ori și a fost folosită treptat pentru croaziere, care au devenit serviciile sale principale în anii 1930. Când Cunard Line și White Star Line au fuzionat în 1934, ea a fost rapid considerată inutilă și vândută la sfârșitul anului. A fost casată la Osaka în 1935.nnnn### Răspuns:n | RMS Adriatic a fost un transatlantic britanic al White Star Line. Ea a fost a patra dintr-un cvartet de nave de peste 20,000 GRT, numit The Big Four. Nava a fost singura dintre cele patru care nu a fost niciodată cea mai mare navă din lume. Cu toate acestea, ea a fost cea mai mare, cea mai rapidă și cea mai luxoasă dintre Big Four, fiind primul transatlantic care a avut o piscină interioară și o baie turcească. | RMS Adriatic a fost un transatlantic britanic al White Star Line. Ea a fost a patra dintr-un cvartet de nave de peste 20,000 GRT, numit The Big Four. Nava a fost singura dintre cele patru care nu a fost niciodată cea mai mare navă din lume. nn### ContextnO întrebare de acest tip este folosită în mod obișnuit pentru a interoga un motor de căutare. Intrarea este o intrare a interogării, iar răspunsul este public | RMS Adriatic a fost un transatlantic britanic al liniei stelare albe. Ea a fost lansată în 1906, dar prima ei navigație comercială a fost în 1907. A fost a patra dintr-un cvartet de nave de peste 20,000 de tone și a numit Big Four. Celelalte trei au fost RMS Celtic în 1901, RMS Baltic în 1903 și R. |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiune:nCare este CGRO care detectează fotonii?nn### Intrare:nCompton Gamma Ray Observatory (CGRO) a fost un observator spațial care detecta fotoni cu energii de la 20 keV la 30 keV GeV, pe orbita Pământului din 1991 până în 2000. Observatorul a prezentat patru telescoape principale într-o navă spațială, acoperind razele X și razele gamma, inclusiv diferite subinstrumente și detectoare specializate. După 14 ani de efort, observatorul a fost lansat de la naveta spațială Atlantis în timpul STS-37 pe 5 aprilie 1991 și a funcționat până la deorbită pe 4 iunie 2000. A fost desfășurat pe orbita joasă a Pământului la 450 km (280 mi) pentru evita centura de radiații Van Allen. A fost cea mai grea sarcină utilă astrofizică zburată vreodată la acel moment, cu 17,000 de kilograme (37,000 de lb).nnnn### Răspuns:n | CGRO este Observatorul Compton Gamma Ray (CGRO) și a fost un observator spațial care detectează fotoni cu energii de la 20 keV la 30 GeV pe pământ din 1991 până în 2000. | **Transcriptor:** Instrumentul EGRET detectează fotonii.nn | Observatorul Compton Gamma Ray (CGRO) măsoară fotonii cu energii de la 20 keV la 30 GeV.nn |

| Mai jos este o instrucțiune care descrie o sarcină, asociată cu o intrare care oferă context suplimentar. Scrieți un răspuns care completează în mod corespunzător solicitarea.nn### Instrucțiuni:nCât de bun este un pianist Yeol Eum Sonnn### Intrare:nYeol Eum Son (născut la 2 mai 1986, în Wonju, Coreea de Sud) este un clasic sud-coreean pianist. Ea a atras prima dată atenția internațională în octombrie 2004, la vârsta de 18 ani, când a apărut ca solist interpretând Concertul Liszt pentru pian nr. 1 cu Filarmonica din New York, sub bagheta lui Lorin Maazel, în turneul lor din Asia la Seul, Daejeon și Tokyo. Son a cântat din nou cu Maazel și Filarmonica din New York când s-au întors la Centrul de Arte din Seul în februarie 2008, de data aceasta ca solist pentru Concertul pentru pian nr. 2 al Beethoven. ) și Concursul Internațional Ceaikovski 2009, unde a primit, de asemenea, premiile pentru cel mai bun concert de cameră și pentru cea mai bună interpretare a lucrării comandate. De asemenea, a câștigat medalia de bronz la Concursul Internațional de Maestru de Pian Arthur Rubinstein (2011) nnnn### Răspuns:n | Yeol Eum Son (născut pe 2 mai 1986, în Wonju, Coreea de Sud) este un pianist clasic sud-coreean. Ea a atras prima dată atenția internațională în octombrie 2004, la vârsta de 18 ani, când a apărut ca solist interpretând Concertul Liszt pentru pian nr. 1 cu Filarmonica din New York, sub bagheta lui Lorin Maazel, în turneul lor din Asia la Seul, Daejeon și Tokyo. Son a cântat din nou cu Maazel și Filarmonica din New York când s-au întors la Centrul de Arte din Seul în februarie 2008, de data aceasta ca solist pentru Concertul pentru pian nr. 2 al Beethoven. ) și Concursul Internațional Ceaikovski 2009, unde a primit, de asemenea, premiile pentru cel mai bun concert de cameră și pentru cea mai bună interpretare a lucrării comandate. De asemenea, a câștigat medalia de bronz la Concursul Internațional de Maestru de Pian Arthur Rubinstein (2011) | Yeol Eum Son este un pianist desăvârșit, care a cântat cu unele dintre cele mai prestigioase orchestre din lume. În 2009, a câștigat argintul la al treisprezecelea Concurs Internațional de Pian Van Cliburn, iar în 2005 a câștigat bronzul la Concursul Internațional de Maestru de Pian Arthur Rubinstein. Ea continuă să cânte cu mare succes în toată lumea. | Yeol Eum Son este un pianist foarte bun. Ea și-a început cariera internațională alăturându-se unora dintre cei mai mari muzicieni din lume la vârsta de 18 ani. Și era deja medaliată de argint la două competiții internaționale când a împlinit 25 de ani.nn |

- Rezultate pentru reglarea fină a modelului de generare de text Llama 2 7B pe setul de date Dialogsum:

| Intrări | Adevărul la sol | Răspuns de la modelul neajustat | Răspuns de la Modelul Fine-Tuned |

| Rezumați acest dialog:n#Person1#: Aceasta este o masă grozavă!n#Person2#: Vă mulțumesc. Mă bucur că totul a ieșit atât de bine.n#Persoana1#: Cine te-a învățat cum să gătești așa bine?n#Persoana2#: Am luat un curs de gătit la Institutul Culinar.n#Persoana1#: Uau, ce este în asta fel de mâncare cu pui?n#Person2#: Nu este grozav? Acesta este pui cu ghimbir cu nucă de cocos și orez.n#Persoana1#: Supa este o supă de creveți?n#Persoana2#: Da, există creveți acolo împreună cu legume de mare și iarbă de lămâie.n#Persoana1#: Cred că am avut noroc în alegerea unui vin care se îmbină cu această masă.n#Persoana2#: Apreciez că ai adus vinul. Merge bine cu puiul.n—nRezumat:nnn### Răspuns:n | #Persoana1# consideră că masa pregătită de #Persoana2# este grozavă. #Person2# prezintă ingredientele preparatelor. | După ce dialogul este complet, persoana va oferi un răspuns adecvat la informațiile adunate. De exemplu, persoana 1 poate spune,nn#Person1#: Este grozav! Mulțumesc.nn#Person2#: Sunteți foarte binevenit. M-am gândit că ți-ar plăcea masa. Mă bucur că ți-a plăcut.nn—n— — — — –nnn### Rezumat:nnn### Răspuns:nDupă dialog | #Persoana1# și #Persoana2# mănâncă la #Persoana2#. Ei vorbesc despre mâncarea și vinul care se amestecă cu puiul.nn |

| Rezumați acest dialog:n#Person1#: Scuzați-mă, scriu un eseu despre Grecia antică. Există cărți pe acest subiect pe care le puteți recomanda?n#Person2#: Gâște? Vrei să scrii despre gâștele antice? Nu am auzit niciodată de așa ceva. Oricum, ar fi cu o carte cu niște animale, asta e rândul J. Sau vrei să încerci știința, asta e în Rândul Gn#Person1#: Animals? Dar Grecia este o țară, nu un animal.n#Person2#: Oh, Grecia. Ei bine, știi, astăzi trebuie să fie ziua ta norocoasă. Tocmai am primit o nouă colecție de cărți chiar pe această temă. Sunt scriitori aici în rândul Cn#Person1#: Înțeleg. Sunt o mulțime de cărți, care sugerați?n#Person2#: Ei bine, cea de Robin Smith este excelentă, dar este foarte lungă. Este cel cu statuia pe coperta. Există și unul de Milton Pike. Are un tablou cu un soldat pe front. După cum puteți vedea, nu este foarte gros, așa că nu ar trebui să ia prea mult timp pentru a citi. Dar, probabil, cea mai bună carte este cea cu imaginea vechiului Stadion Olimpic. A câștigat mai multe recompense pentru lucrări de istorie.n#Persoana1#: Ei bine, este greu să te decizi, dar mă tem că nu am timp suficient pentru multă lectură. Cred că voi primi cartea lui Milton Pike.n#Person2#: OK. Aș putea avea cardul dvs. de bibliotecă, vă rog?n#Person1#: Sigur, aici sunteți.n—nSummary:nnn### Răspuns:n | #Person1# îi cere #Person2# să recomande câteva cărți despre Grecia antică. #Person2# o sugerează pe cea a lui Robin Smith care este foarte lungă, cea a lui Milton Pike care nu este foarte groasă, iar cea care a câștigat mai multe recompense pentru lucrări de istorie. Deoarece #Person1# nu are suficient timp, #Person1# va primi cartea lui Milton Pike. | n—nnRezumat:n | #Person1# scrie un eseu despre Grecia antică. #Person2# recomandă lui #Person1# cărțile despre Grecia antică, care sunt toate recent primite și sugerează să obțineți cartea lui Milton Pike.nn |

| Rezumați acest dialog:n#Person1#: Ei bine, văd că ai cărțile tale, George. Dar tu citești? Se pare că doar colorezi.n#Persoana2#: Marcez părțile importante ale cărții. Culorile sunt pentru lucruri diferite.n#Persoana1#: Ce anume?n#Persoana2#: Ideile principale sunt galbene. Detaliile importante de reținut sunt roz, iar verdele deschis este pentru idei dificile.n#Person1#: Pare o mulțime de activități. Nu-ți pierzi timpul?n#Persoana2#: Nu cred, mamă. O să citesc totul în seara asta. O sa ascult maine. Și atunci când va fi timpul să studiez, voi cunoaște deja majoritatea informațiilor.n#Persoana1#: Pe vremea mea, am citit cartea și am încercat să ne amintim informațiile.n#Persoana2#: Profesorul ne-a spus importanța lectură activă. Și este cel mai bun mod de a învăța cu orice viteză ai alege.n#Person1#: Înțeleg. Și pentru ce este acest caiet? n#Person2#: Este pentru a lua notițe. Ce fel de lucruri notezi?n#Persoana1#: Uneori scriu un rezumat. Pe această pagină notez întrebări. Și bineînțeles că mai am o pagină în care notez cuvintele noi.n—nRezumat:nnn### Răspuns:n | George îi spune mamei sale că marcarea părților importante ale cărții în diferite culori este modul lui de a învăța. De asemenea, ia notițe pe caiet și uneori scrie un rezumat. | #Persoana1#: Ohhh! Lectură activă, întrebări de citire, note de vocabular, rezumate și evidențiere. Văd acum ce diferență aveți când vine vorba de a învăța informații. Sunt impresionat.n#Person2#: Mulțumesc. Cititul este cel mai bun mod de a învăța și a-ți aminti informații noi. Folosiți lectura activă chiar acum?n#Person1#: Hmmm….. Va trebui să mă gândesc la asta.nnn#Person | George descrie activitățile pe care le face pentru a-și citi cărțile rapid. George îi arată mamei caietul și îi explică cum să iei notițe.nn |

| Rezumați acest dialog:n#Person1#: Bună dimineața, domnule. Pot să văd pașaportul?n#Person2#: Da, desigur. Aici este.n#Person1#: Mulțumesc. Toate acestea sunt ale tale?n#Person2#: Nu, unele dintre ele sunt ale prietenului meu. Vrei și tu pașaportul ei?n#Person1#: Da, te rog. Aveți obiecte de mână?n#Person2#: Vrei să-l pun și eu pe curea?n#Person1#: Da, te rog. Vrei să deschizi această valiză mare?n#Persoana2#: OK. O clipă. Sunt doar niște haine și articole de toaletă.n#Person1#: OK. Ai ceva de declarat?n#Person2#: Cred că nu există nimic.n#Person1#: Orice hrană proaspătă, plante vii sau animale?n#Person2#: Oh, nu. Nimic din toate astea.n#Person1#: Mulțumesc. Îți poți încuia valiza. Iată pașapoartele tale.n#Persoana2#: Mulțumesc mult.n—nRezumat:nnn### Răspuns:n | #Person1# vede pașaportul prietenului #Person2# și #Person2# și le verifică bagajele. #Person2# îi spune #Person1# că nu au nimic de declarat. #Persoana1# le dă drumul. | > Cred că nu există nimic.nnn—n**Categorii:**nn- [Conversație (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Cheie:nn :source_information: 31 (TSA)n:information_source: 32 (TSA)nn—-n* Orice drept de autor | Oficialul de imigrare îi cere #Person2# să-și arate pașaportul și să-și deschidă valiza mare. #Persoana2# nu are nimic de declarat și își poate încuia valiza.nn |

| Rezumați acest dialog:n#Person1#: Ceaiul chinezesc este faimos în întreaga lume. Vreau să cumpăr mai multe cutii.n#Person2#: Există diferite tipuri de ceai în China. Depinde de gust și efect.n#Person1#: Ei bine, nu știu deloc ceaiul chinezesc.n#Person2#: Acesta este ceai verde, îl poți bea vara. Poate ameliora căldura verii și este bun pentru menținerea plămânilor.n#Person1#: Sună interesant. Ce zici de asta?n#Persoana2#: Este ceai negru, are un gust puternic și favorizează digestia.n#Persoana1#: Ce este asta? Miroase parfumat.n#Person2#: Este un ceai de iasomie de înaltă calitate. Este parfumat și are un gust plăcut.n#Persoana1#: Voi lua ceaiul de iasomie. Ați putea să-l împachetați cu hârtie de împachetat și panglică? Este un cadou pentru prietenul meu.n#Person2#: Nicio problemă. Așteptați un moment.n—nRezumat:nnn### Răspuns:n | #Persoana2# recomandă ceai verde, tricou negru și tricou de iasomie #Persoanei1# care dorește să cumpere ceai chinezesc, iar #Persoana1# decide să ia ceaiul de iasomie. | #[Engleză]#: Ceaiul chinezesc este faimos în întreaga lume. Vreau să cumpăr mai multe cutii.n#[franceză]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[spaniolă]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[germană]#: Ich mö | #Person1# dorește să cumpere mai multe cutii de ceai chinezesc, cu diferite tipuri de ceai. #Person2# îl ajută pe #Person1# să selecteze și îl va împacheta.nn |

- Rezultate pentru reglarea fină a modelului Llama-2 13B pe setul de date Dialogsum:

| Intrări | Adevărul la sol | Răspuns de la modelul neajustat | Răspuns de la Modelul Fine-Tuned |

| Rezumați acest dialog:n#Person1#: Doamna Thompson cândva diteistă, Jason.n#Person2#: De ce? Nu ar trebui să avem probleme sau altceva? De fapt, am fost super activi pe parcursul întregii discuții în clasă de azi dimineață.n#Person1#: Doar atât. Nu cred că este deloc un lucru rău. Cred că ne va cere să candidam pentru monitorul clasei.n#Persoana2#: Uau! Într-adevăr? Asta înseamnă multă responsabilitate.n#Person1#: Ei bine, cred că ai fi grozav la asta. În plus, este o mare onoare să fiu rugat să o facă. Înseamnă că doamna Thompson ne vede ca lideri.n#Persoana2#: Nu sunt sigur dacă o pot face singură, totuși. Am putea să o facem împreună?n#Person1#: Să o întrebăm pe doamna Thompson. O aud venind de pe hol acum.n—nRezumat:nnn### Răspuns:n | #Person1# îi spune lui Jason doamnei Thompson cândva diteist și #Person1# ghicește că vrea ca ei să candideze pentru monitorii clasei. O vor întreba pe doamna Thompson dacă pot face asta împreună. | n* Când profesorul i-a întrebat pe Jason și colegul său de clasă dacă vor să candideze pentru monitorul clasei, el și colegul lui au fost de acord împreună. Ambii băieți sunt creștini, dar nu sunt prieteni în clasă.n* Credința lor în Isus poate să nu fie împărtășită public, dar este evidentă prin rugăciune și prin exemplul pe care îl urmează împreună pentru a-i ajuta pe alții și pentru a arăta dragoste.nn—n## 1654nn **[Situație:** Studenții vorbesc despre cele recente | Doamna Thompson îi cere lui Jason și James să candideze pentru monitorul clasei pentru că ea crede că sunt lideri.nn |

| Rezumați acest dialog:n#Person1#: Hei, hai să ne oprim și să ne uităm la casa aceea de acolo.n#Person2#: Da, arată grozav! Este pe lista noastră de case deschise?n#Person1#: Da, este pe lista noastră.n#Person2#: Ei bine, arată grozav din bordură. Să continuăm înăuntru.n#Person1#: Să semnăm registrul. Agentul imobiliar pare cam ocupat acum.n#Persoana2#: OK, haideți să vedem bucătăria în continuare.n#Persoana1#: Uite, au niște băuturi răcoritoare aici.n#Persoana2#: Asigurați-vă că ridicați un fluturaș cu informații despre locuință.n#Persoana1#: Spune cât de mult cer pentru această casă?n#Persoana2#: Da, se pare că a fost redus de la două sute treizeci și cinci de mii la două sute și douăzeci și cinci de mii—nRezumat:nnn### Răspuns:n | #Person1# și #Person2# vin să vadă o casă. Ei verifică interiorul și vorbesc despre prețul lui. | Acesta este un răspuns AMI la următorul stimul.nnPersoana 2: nDa, arată grozav! Este pe lista noastră de Open House? nDa, este pe lista noastră. nEi bine, arată grozav de pe bordură. Să continuăm înăuntru.n Să semnăm registrul. Agentul imobiliar pare cam ocupat în acest moment.nOK, hai să mergem mai departe să verificăm bucătăria.nOh uite, au niște | #Person1# și #Person2# caută în jur o casă care se află pe lista lor Open House. Ei semnează un registru și #Person2# îi spune #Person1# să ia un fluturaș cu informațiile.nn |

| Rezumați acest dialog:n#Person1#: Ce mai faceți, domnule Wilson? Sunt Tina.n#Persoana2#: Mă bucur să vă cunosc, doamnă Tina.n#Persoana1#: Vă rugăm să luați loc. Știu că angajarea noastră de forțar ți-a oferit deja informații despre contractul tău de angajat, dar aș dori să trec din nou peste detaliile principale înainte de a semna. În primul rând, vei primi un salariu lunar, cu o lună de vacanță plătită după un an de serviciu. Deoarece vei fi manager de mijloc, se așteaptă să fii disponibil cu până la 2 ore dincolo de orele normale de lucru. Orice perioadă aprobată peste aceasta va fi plătită la timp și jumătate, pe care o puteți lua drept salariu sau timp liber.n#Persoana1#: Exact înțelegerea mea.n#Persoana1#: Un număr rezonabil de zile de boală va fi acoperit de companie. . Orice boală prelungită va fi acoperită de asigurare. Ați citit ceilalți termeni ai contractului?n#Person5#: Da, am.n#Person2#: Aveți alte întrebări?n#Person1#: Doar una. Am observat un articol despre flex-time. Este aceasta o posibilitate pentru mine?n#Persoana2#: Da, este, dar va trebui să discutați detaliile cu managerul dumneavoastră.n#Persoana1#: Este acceptabil.n#Persoana2#: Bine. Acum, dacă doar semnați aici, puteți începe lucrul în 1 zile.n—nRezumat:nnn### Răspuns:n | Domnul Wilson îi descrie Tinei informațiile elementare despre contractul de muncă. Menționează salariul lunar, o lună de concediu plătit, planurile medicale, programul de lucru prelungit și programul flexibil. | nNu, rezumatele nu sunt corecte. Dialogurile #Person1 nu spun că numele este Tina, nu se prezintă. Cred că amândoi se cunosc numele celuilalt, deci nu este necesar.nnCred că dacă totul este corect, Rezumatul nu se va schimba, cu excepția cazului în care #Person1 se termină și e ok.nn | Tina se întâlnește cu domnul Wilson pentru a discuta principalele detalii ale contractului de angajat al Tinei. Cei doi discută despre salariul lunar și planul medical. Tina nu are întrebări și va începe lucrul în 3 zile.nn |

| Rezumați acest dialog:n#Person1#: Jack, care este subiectul tău preferat?n#Person2#: Subiectul meu preferat? Ei bine, cred că prefer știința. Da, știință, mi se pare foarte interesant. Profesorul de științe face subiectul foarte interesant. Ce zici de tine?n#Person1#: Întotdeauna mă descurc foarte bine la testele de matematică. Îmi place și geografia. Îmi place să învăț despre oameni și locurile în care trăiesc. Există subiecte care să nu-ți placă Jack?n#Person2#: Nu-mi place fizica foarte mult. Nu este ușor de înțeles, majoritatea copiilor se plictisesc de asta.n—nRezumat:nnn### Răspuns:n | Materia preferată a lui Jack este știința, în timp ce lui nu-i place foarte mult fizica. #Persoanei1# îi plac matematica și geografia. | n—nn### Cuvântul: „favorit” (adj)nnSens: Iubit, apreciat pe majoritatea celorlalți nExemple: Cartea mea preferată este Biblia; Care este sportul tau favorit?; Culoarea mea preferată este albastrul.nn—nnnn### Care este subiectul tău ____? (formal)nnDialog Întrebări și răspunsuri:nn#Person1#: Care este subiectul tău preferat?n# | Jack și Jack vorbesc despre subiectele lor preferate și cele mai puțin plăcute.nn |

| Rezumați acest dialog:n#Person1#: Bună, Maggie. Ți-am văzut pictura la expoziția de artă de la sfârșitul anului la care au fost toți părinții. A fost grozav.n#Persoana2#: Ei bine, profesorul nostru de artă părea foarte mulțumit de asta, dar nu sunt sigur la ce s-au gândit părinții.n#Persoana1#: Oh, nu-ți face griji. I-am auzit doar spunând lucruri bune despre asta.n#Persoana2#: Hmm… Probabil că nu a observat că nu am folosit culorile potrivite.n#Persoana1#: Nu cred că a observat nimeni.n#Persoana2# : Nu, dar am făcut-o. Dar era prea târziu pentru a face ceva în privința asta. Ei bine, data viitoare voi face ceva mai bine sperăm.n—nRezumat:nnn### Răspuns:n | #Person1# a văzut pictura lui Maggie și crede că a fost grozav, dar Maggie își face griji că nu a folosit culorile potrivite și speră că va face ceva mai bun data viitoare. | Acest rezumat ar trebui să evidențieze punctele-cheie și concluziile din discuție.nn# Răspunde la Persoana1:n[Rezumatul răspunsului]nn—n### Răspuns:nAcest rezumat ar trebui să evidențieze punctele-cheie și concluziile discuției.nn# Răspunde la Persoana2 :n[Rezumatul răspunsului]nn### Persoana1:n[Rezumatul Persoana1]n—n### Persoana2:n[Rezumatul Persoana2]nn### Persoana—n | #Person1# a văzut pictura lui Maggie și i-a spus lui Maggie că mulți părinți au spus lucruri grozave despre pictura lui Maggie. Maggie nu crede.nn |

- Rezultate pentru reglarea fină a modelului Llama 2 70B pe setul de date Dialogsum:

| Intrări | Adevărul la sol | Răspuns de la modelul neajustat | Răspuns de la Modelul Fine-Tuned |

| Rezumați acest dialog:n#Person1#: Ați primit vreo diplomă?n#Person2#: Da. În 1996 am primit diploma de licență de la Universitatea Hebes, iar în 2001 am primit diploma de MBA de la Universitatea Peking. Media mea generală a fost 1 pe o scară 2, care a fost cea mai mare din clasa mea.n#Person9#: Este foarte impresionant. Care curs ți-a plăcut cel mai mult?n#Person10#: engleză. A fost atât interesant, cât și util, așa că mi-am arătat un mare interes față de ea.n#Person1#: Îmi puteți spune de ce ți-ai schimbat specializarea când erai student absolvent?n#Person2#: Pentru că sunt foarte interesat de administrație și Am urmat niște cursuri în el. Am avut rezultate bune si la subiecte. Prin urmare, cred că pot face o treabă bună în această poziție.n#Persoana1#: Ați primit vreo onoare și premii la facultate?n#Persoana2#: Da. Mi s-a acordat o bursă de la universitate în fiecare an. În 1 am participat la Concursul Național de Modele Matematice și am câștigat premiul.n—nRezumat:nnn### Răspuns:n | #Person1# intervievează #Person2# și îi adresează #Person2# câteva întrebări, inclusiv diplomele lui #Person2#, dosarele academice, cursul preferat și premiile la facultate. #Person2# îi spune, de asemenea, #Person1# de ce #Person2# a schimbat principalul în administrație. | Candidatul a rezumat că ideea principală a dialogului a fost că a primit două grade, 0. Iar specializările au făcut bine. nCu toate acestea, prima sa propoziție nu oferă prea multă emoție mai sus în afară de narcisism și nici nu precizează de ce experiența sa este relevantă pentru companie. El ar putea face o conexiune mai bună și poate încheia rezumatul cu o emoție/atitudine subiacentă, alta decât „profesională” (cum face el în dialog). | #Person2# spune că #Person1# #Person2# a primit o diplomă de licență și un MBA. GPA-ul #Person2# este cel mai mare din clasa lui #Person2# și #Person2# este interesat de administrare. #Person2# a primit și câteva onoruri și premii la colegiu.nn |

| Rezumați acest dialog:n#Person1#: Scuzați-mă, ce material este? n#Persoana2#: Rhaki. Vrei niste? n#Persoana1#: Nu, unde sunt cârpele de bumbac? n#Person2#: Îți voi arăta. n#Person1#: Care este rata de contracție după spălare? n#Person2#: mai puțin de 5%. Este destul de durabil. n—nRezumat:nnn### Răspuns:n | #Persoana2# îi spune #Persoanei1# că hainele din bumbac sunt rezistente. | Pentru ruta QA41913, această secțiune ar trebui să conțină un rezumat al dialogului, astfel încât, de exemplu, un sistem automat de pronunție și generare a vorbirii să poată utiliza acest text pentru sinteza de ieșire. | #Persoana1# vrea niște cârpă de bumbac. #Person2# arată unele rhaki.nn |