大規模言語モデル (LLM) を使用して高品質で関連性の高いテキストを生成する人にとって、迅速なエンジニアリングは不可欠なスキルとなっています。 テキスト プロンプト エンジニアリングは広く議論されてきましたが、ビジュアル プロンプト エンジニアリングは注目を必要とする新興分野です。 視覚的なプロンプトには、視覚モデルが関連性のある正確な出力を生成するようガイドする境界ボックスまたはマスクを含めることができます。 この投稿では、ビジュアル プロンプト エンジニアリングの基本とその利点、そして自動運転のための画像セグメンテーションという特定のユースケースを解決するためにビジュアル プロンプト エンジニアリングをどのように使用できるかを探ります。

近年、コンピュータ ビジョンの分野では、画像セグメンテーションの分野で大きな進歩が見られます。 そのような画期的な進歩の XNUMX つが、 セグメント エニシング モデル (SAM) Meta AI は、ゼロショットまたは少数ショットのトレーニングでオブジェクトレベルのセグメンテーションに革命を起こす可能性を秘めています。 この投稿では、SAM モデルを基盤ビジョン モデルの例として使用し、そのアプリケーションへの応用を検討します。 BDD100K データセット、異種マルチタスク学習のための多様な自動運転データセット。 SAM の強みと BDD100K が提供する豊富なデータを組み合わせることで、さまざまなバージョンの SAM を使用したビジュアル プロンプト エンジニアリングの可能性を示します。 にインスピレーションを受けて、 ラングチェーン 言語モデルのフレームワークでは、物体検出モデルと SAM を組み合わせて視覚的なプロンプトを実行するビジュアル チェーンを提案します。

この投稿では自動運転に焦点を当てていますが、ここで説明する概念は、ヘルスケアやライフ サイエンス、メディアやエンターテイメントなど、豊富なビジョンベースのアプリケーションを持つ分野に広く適用できます。 まずは、SAM のような基本的なビジョン モデルの内部にあるものについてもう少し詳しく学んでみましょう。 私たちが使用した Amazon SageMakerスタジオ この投稿の ml.g5.16xlarge インスタンス上で。

セグメント エニシング モデル (SAM)

基盤モデルは、膨大な量のデータでトレーニングされた大規模な機械学習 (ML) モデルであり、タスク固有のユースケースに合わせてプロンプトを表示したり、微調整したりできます。 ここでは、視覚、特に画像セグメンテーションの基礎モデルであるセグメント エニシング モデル (SAM) について調べます。 11 万枚の画像と 1.1 億枚のマスクからなる大規模なデータセットで事前トレーニングされており、執筆時点では最大のセグメンテーション データセットとなっています。 この広範なデータセットは幅広いオブジェクトとカテゴリをカバーしており、SAM に多様で大規模なトレーニング データ ソースを提供します。

SAM モデルはオブジェクトを理解するようにトレーニングされており、画像またはビデオ フレーム内の任意のオブジェクトのセグメンテーション マスクを出力できます。 このモデルでは、視覚的なプロンプト エンジニアリングが可能で、テキスト、ポイント、境界ボックス、マスクなどの入力を提供して、元の画像を変更せずにラベルを生成できます。 SAM には、ベース (ViT-B、91 万パラメータ)、ラージ (ViT-L、308 億 636 万パラメータ)、およびヒュージ (ViT-H、XNUMX 億 XNUMX 万パラメータ) の XNUMX つのサイズがあり、さまざまな計算要件とユースケースに対応します。

SAM の背後にある主な動機は、対象オブジェクトのトレーニング サンプルとエポックを最小限にしてオブジェクト レベルのセグメンテーションを改善することです。 SAM の威力は、事前知識がなくても新しい画像の配布やタスクに適応できる能力にあります。この機能は、 ゼロショット転送。 この適応性は、広大な SA-1B データセットでのトレーニングを通じて達成され、これまでの完全に監視された多くの結果を上回る、印象的なゼロショット パフォーマンスを実証しました。

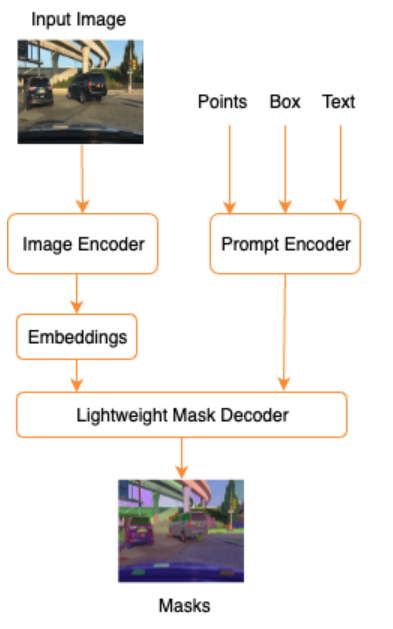

次の SAM のアーキテクチャに示されているように、セグメンテーション マスクを生成するプロセスには XNUMX つのステップが含まれます。

- 画像エンコーダは、画像の XNUMX 回限りの埋め込みを生成します。

- プロンプト エンコーダは、任意のプロンプトをプロンプトの埋め込みベクトルに変換します。

- 軽量デコーダーは、イメージ エンコーダーとプロンプト エンコーダーからの情報を組み合わせて、セグメンテーション マスクを予測します。

例として、画像とその画像内の対象オブジェクト (シルバーカーや走行車線など) の周囲の境界ボックスを入力に提供すると、SAM モデルがそのオブジェクトのセグメンテーション マスクを生成します。

ビジュアルプロンプトエンジニアリング

プロンプトエンジニアリングとは、モデルに意図を理解させ、望ましい結果を生み出すモデルへの入力を構造化することを指します。 テキスト プロンプト エンジニアリングを使用すると、単語の選択、書式設定、順序などの変更を通じて入力テキストを構造化し、目的の出力を得ることができます。 ビジュアル プロンプト エンジニアリングでは、ユーザーがビジュアル モダリティ (画像またはビデオ) で作業していることを想定し、入力を提供します。 以下は、ビジュアル ドメインの生成 AI モデルに入力を提供する可能性のある方法の非網羅的なリストです。

- ポイント – 画像平面内の特異な (x, y) 座標点

- 点 – 複数の (x, y) 座標点。必ずしも互いに関連しているわけではありません。

- 境界ボックス – 画像平面内の長方形の領域を定義する XNUMX つの値 (x、y、w、h) のセット

- 輪郭 – 閉じた形状を形成する画像平面内の (x, y) 座標点のセット

- マスク – 対象オブジェクトの部分マスクを含む画像と同じサイズの配列

ビジュアル プロンプト エンジニアリング手法を念頭に置いて、これを SAM 事前トレーニング モデルにどのように適用できるかを検討してみましょう。 事前トレーニングされたモデルの基本バージョンを使用しました。

事前トレーニングされた SAM モデルによるゼロショット プロンプト

まず、ゼロショットアプローチを見てみましょう。 以下は、車両のフロント カメラから撮影されたトレーニング データセットのサンプル画像です。

明示的な視覚的なプロンプトを必要とせずに、画像からすべてのオブジェクトのセグメンテーション マスクを取得できます。 マスクを自動生成する 入力画像だけで。 次の画像では、車、道路、交通標識、ナンバー プレート、高架橋、柱、標識などがセグメント化されていることがわかります。

ただし、次の理由により、この出力はすぐには役に立ちません。

- 車は全体としてではなく、部分的に分割されています。 たとえば、ほとんどの知覚モデルでは、各タイヤが個別の出力マスクを持つことはあまり気にしません。 これは、道路、植生、標識など、他の既知の対象オブジェクトを探す場合にも当てはまります。

- 走行可能領域などの下流タスクに役立つ画像の部分は、説明なしで分割されています。 一方、類似したインスタンスは個別に識別されるため、類似したオブジェクトをグループ化することに興味があるかもしれません (パノプティックとインスタンスのセグメンテーション)。

事前トレーニングされた SAM モデルを使用したビジュアル プロンプト エンジニアリング

幸いなことに、SAM は入力プロンプトの提供をサポートしており、点、点配列、および境界ボックスを入力として使用できます。 これらの具体的な指示により、SAM は特定の点または領域に焦点を当てたセグメンテーションでより適切に機能することが期待されます。 これは言語プロンプト テンプレートと比較できます。"What is a good name for a company that makes {product}?"

ここで、ユーザーからのこのプロンプト テンプレートを伴う入力は、 {product}. {product} 入力スロットです。 視覚的なプロンプトでは、境界ボックス、ポイント、またはマスクが入力スロットです。

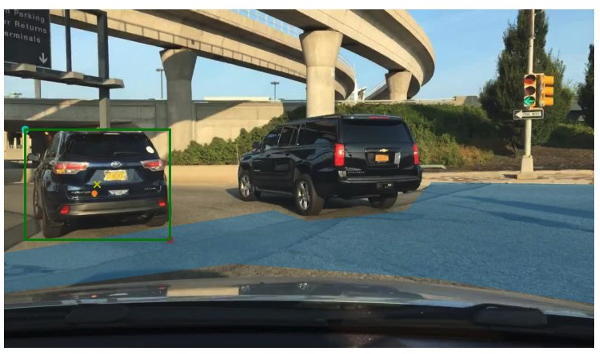

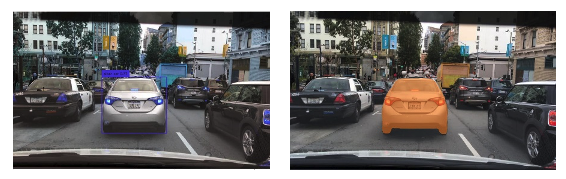

次の画像は、車両周囲の元のグラウンド トゥルース バウンディング ボックスと、BDD100K グラウンド トゥルース データからの走行可能エリア パッチを示しています。 このイメージには、緑色の境界ボックスの中心にある入力ポイント (黄色の X) も示されています。これについては、次のいくつかのセクションで参照します。

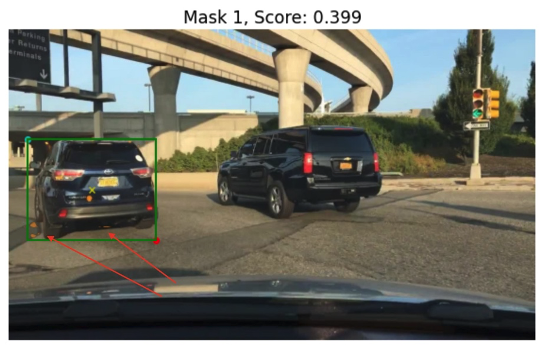

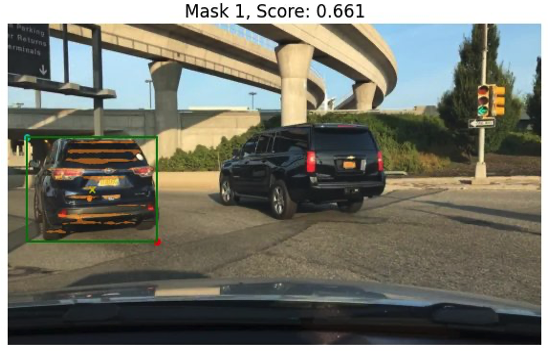

SAM への入力として緑色の境界ボックスを使用して、左側の車のマスクを生成してみます。 次の例に示すように、SAM の基本モデルでは実際には何も見つかりません。 これは、低いセグメンテーション スコアにも見られます。 セグメンテーション マスクをさらに詳しく見ると、下流のアプリケーションでは実際には使用できない小さな領域がマスクとして返されていることがわかります (赤い矢印で示されています)。

視覚的な入力プロンプトとして、境界ボックスと点の組み合わせを試してみましょう。 上の画像の黄色の十字は、境界ボックスの中心です。 この点の (x,y) 座標を境界ボックス制約とともにプロンプトとして指定すると、次のマスクとわずかに高いスコアが得られます。 これではまだどうやっても使えません。

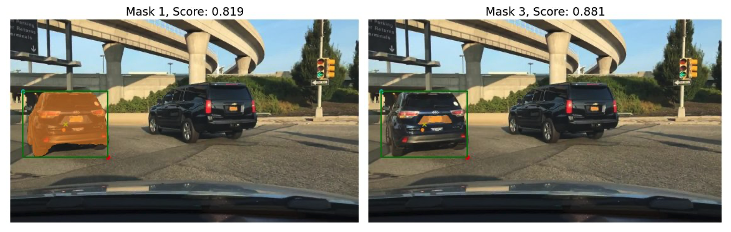

最後に、ベースの事前トレーニング済みモデルを使用すると、(境界ボックスなしで) プロンプトとして入力ポイントのみを提供できます。 次の画像は、興味深いと思われた上位 XNUMX つのマスクのうちの XNUMX つを示しています。

マスク 1 は車全体をセグメント化するのに対し、マスク 3 は車のナンバー プレートが黄色の十字に近い領域をセグメント化します (入力プロンプト)。 マスク 1 はまだ車の周りにぴったりと清潔なマスクではありません。 これはモデルの品質を示しており、モデルのサイズに応じて品質が向上すると考えられます。

同じ入力プロンプトを使用して、より大きな事前トレーニング済みモデルを試すことができます。 次の画像は結果を示しています。 巨大な SAM 事前トレーニング済みモデルを使用する場合、マスク 3 は車全体ですが、マスク 1 と 2 はナンバー プレートを抽出するために使用できます。

SAM モデルの大規模バージョンも同様の出力を提供します。

ここで行ったプロセスは、すでによく知られているテキスト プロンプトの手動プロンプト エンジニアリングに似ています。 SAM モデルの最近の改良により、あらゆるものを高品質でセグメント化することで、オブジェクト固有およびコンテキスト固有の出力がはるかに向上していることに注意してください。 私たちの場合、テキストと視覚的なプロンプト (ポイント、ボックス、およびポイントとボックスの入力) によるゼロショット プロンプトでは、上で見たように結果が大幅に改善されないことがわかりました。

プロンプトテンプレートとビジュアルチェーン

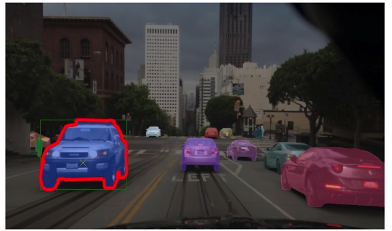

前述のゼロショットの例からわかるように、SAM はシーン内のすべてのオブジェクトを識別するのに苦労しています。 これは、プロンプト テンプレートとビジュアル チェーンを活用できる良い例です。 ビジュアル チェーンは、言語アプリケーション用の人気のある LangChain フレームワークのチェーン概念からインスピレーションを得ています。 これは、データ ソースと LLM をチェーンして出力を生成するのに役立ちます。 たとえば、API チェーンを使用して API を呼び出し、LLM を呼び出して API 応答に基づいて質問に答えることができます。

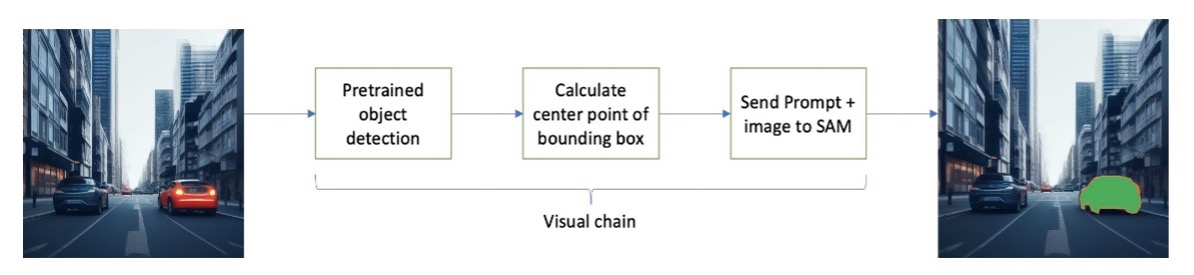

LangChain からインスピレーションを得て、次の図のようなシーケンシャルなビジュアル チェーンを提案します。 ツール (事前トレーニングされた物体検出モデルなど) を使用して初期境界ボックスを取得し、境界ボックスの中心の点を計算し、これを使用して SAM モデルに入力画像を要求します。

たとえば、次の画像は、このチェーンを実行した結果のセグメンテーション マスクを示しています。

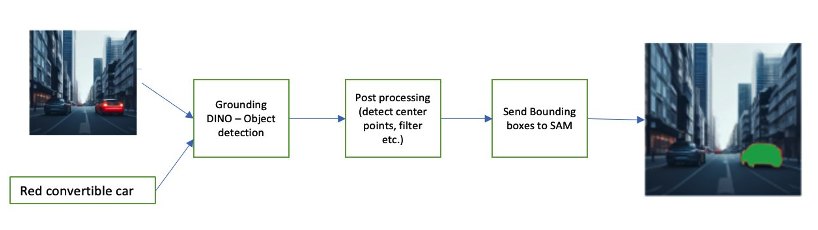

チェーンの別の例には、ユーザーが識別したいオブジェクトのテキスト入力が含まれる場合があります。 これを実装するために、次を使用してパイプラインを構築しました。 グランディングDINO、SAM にセグメンテーションを促すオブジェクト検出モデル。

Grounding DINO は、カテゴリ名 (「信号機」や「トラック」など) と表現 (「黄色いトラック」など) を提供するテキストを使用してオブジェクト検出を実行できるゼロショットオブジェクト検出モデルです。 オブジェクト検出を実行するためにテキストと画像のペアを受け入れます。 これはトランスフォーマー アーキテクチャに基づいており、テキスト データと画像データのクロスモダリティを可能にします。 Grounding DINO について詳しくは、「Grounding DINO」を参照してください。 グラウンディング DINO: オープンセット オブジェクト検出のためのグラウンディング事前トレーニングと DINO を組み合わせる。 これにより、境界ボックスとラベルが生成され、さらに処理して中心点を生成したり、ラベルやしきい値に基づいてフィルターしたりすることができます。 これは、マスクを出力するセグメンテーションのための SAM へのプロンプトとして (ボックスまたはポイント) 使用されます。

以下は、入力テキスト、DINO 出力 (境界ボックス)、および最終的な SAM 出力 (セグメンテーション マスク) を示すいくつかの例です。

次の画像は、「黄色いトラック」の出力を示しています。

次の画像は、「シルバーカー」の出力を示しています。

次の画像は、「走行車線」の出力を示しています。

このパイプラインを使用してビジュアル チェーンを構築できます。 次のコード スニペットは、この概念を説明しています。

pipeline = [object_predictor, segment_predictor]

image_chain = ImageChain.from_visual_pipeline(pipeline, image_store, verbose=True)

image_chain.run('All silver cars', image_id='5X3349')これは単純な例ですが、この概念を拡張して、車両のカメラからのフィードを処理して、物体追跡、個人識別情報 (PII) データの編集などを実行できます。 より小さなモデルから境界ボックスを取得したり、場合によっては標準のコンピューター ビジョン ツールを使用したりすることもできます。 事前トレーニングされたモデルまたは Amazon Rekognition などのサービスを使用して、プロンプトの最初の (視覚的な) ラベルを取得するのは非常に簡単です。 これを書いている時点では、Amazon SageMaker Jumpstart でオブジェクト検出用に 70 を超えるモデルが利用可能です。 Amazonの再認識 は、車、歩行者、その他の乗り物など、画像内のオブジェクトのいくつかの有用なカテゴリをすでに識別しています。

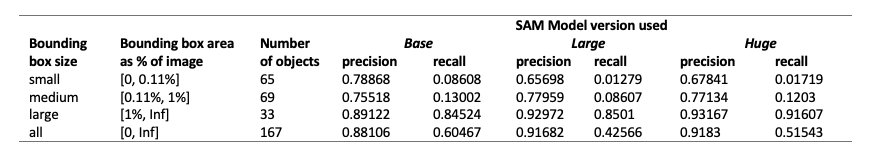

次に、BDD100K データのサブセットを使用した SAM モデルのパフォーマンスに関連する定量的な結果をいくつか見ていきます。

定量的結果

私たちの目的は、同じ視覚的なプロンプトを与えた場合の 0.11 つの事前トレーニング済みモデルのパフォーマンスを比較することです。 この場合、オブジェクトの位置の中心点を視覚入力として使用します。 オブジェクト サイズ (画像サイズに比例)、小 (面積 <0.11%)、中 (1% < 面積 < 1%)、および大 (面積 > XNUMX%) に関するパフォーマンスを比較します。 境界ボックス領域のしきい値は、Common Objects in Context (COCO) によって定義されます。 評価指標 [リン他、2014]。

評価はピクセル レベルで行われ、次の評価指標が使用されます。

- 精度 = (関連するインスタンスと取得されたインスタンスの数) / (取得されたインスタンスの総数)

- Recall = (関連インスタンスと取得インスタンスの数) / (関連インスタンスの合計数)

- ここでのインスタンスは、対象オブジェクトの境界ボックス内の各ピクセルです。

次の表は、SAM モデルの XNUMX つの異なるバージョン (ベース、ラージ、および巨大) のパフォーマンスを報告します。 これらのバージョンには、ViT-B (ベース)、ViT-L (ラージ)、ViT-H (巨大) の XNUMX つの異なるエンコーダーがあります。 エンコーダには異なるパラメータ数があり、基本モデルのパラメータは大よりも少なく、大は大よりも少ないです。 パラメータの数を増やすと、オブジェクトが大きい場合はパフォーマンスが向上しますが、オブジェクトが小さい場合はそうではありません。

ユースケースに合わせて SAM を微調整する

多くの場合、事前トレーニングされた SAM モデルを直接使用することはあまり役に立たない可能性があります。 たとえば、交通の典型的なシーンを見てみましょう。次の図は、左側が入力としてランダムにサンプリングされたプロンプト ポイントを使用した SAM モデルからの出力、右側が BDD100K のセマンティック セグメンテーション タスクからの実際のラベルです。 これらは明らかに大きく異なります。

AV の認識スタックは 500 番目のイメージを簡単に使用できますが、最初のイメージは使用できません。 一方で、最初の画像からは使用できる有用な出力がいくつかあり、モデルは、たとえば、車線区分線、歩道のセグメンテーション、ナンバー プレート マスクなどに関して明示的にトレーニングされていません。 SAM モデルを微調整して、セグメンテーションの結果を改善できます。 この微調整を実行するために、BDD10K データセットのインスタンス セグメンテーション サブセット (XNUMX 枚の画像) を使用してトレーニング データセットを作成しました。 これは非常に小さな画像のサブセットですが、私たちの目的は、基本的なビジョン モデル (LLM とよく似た) が、驚くほど少数の画像でもユースケースで適切に機能できることを証明することです。 次の画像は、入力イメージ、出力マスク (青、左側の車の赤い境界線)、および考えられるプロンプト (境界ボックスは緑、中心点 X は黄色) を示しています。

Hugging Face ライブラリを使用して微調整を行いました。 Amazon SageMakerスタジオ。 SAM 基本モデルのテストには ml.g4dn.xlarge インスタンスを使用し、SAM 巨大モデルのテストには ml.g4dn.2xlarge インスタンスを使用しました。 最初の実験では、境界ボックスだけを使用して基本モデルを微調整しても成功しないことがわかりました。 微調整され事前トレーニングされたモデルは、元のデータセットから自動車固有のグラウンド トゥルース マスクを学習できませんでした。 微調整にクエリ ポイントを追加してもトレーニングは改善されませんでした。

次に、非常に小さなデータセット (30 枚の画像) を使用して、SAM の巨大なモデルを 500 エポックにわたって微調整してみることができます。 元のグラウンド トゥルース マスクは、ラベル タイプの車の次の画像のようになります。

次の図に示すように、特定の境界ボックス プロンプト (緑色) を持つ巨大なモデルの元の事前トレーニング済みバージョンでは出力が得られませんが、微調整バージョンでは出力が得られます (まだ正確ではありませんが、微調整はカットされています) 40 エポック後にオフ、500 画像の非常に小さなトレーニング データセットを使用)。 元の事前トレーニングされた巨大なモデルは、テストしたどの画像のマスクも予測できませんでした。 ダウンストリーム アプリケーションの例として、微調整モデルは、次のような事前ラベル付けワークフローで使用できます。 AWS 上の深層学習ベースの高度運転支援システム用の自動ラベル付けモジュール.

まとめ

この投稿では、セグメント エニシング モデル (SAM) として知られる基本的なビジョン モデルとそのアーキテクチャについて説明しました。 私たちは SAM モデルを使用して、ビジュアル プロンプトとビジュアル プロンプト エンジニアリングへのさまざまな入力について説明しました。 さまざまなビジュアル プロンプトがどのように実行されるか、およびその制限について調査しました。 また、LangChain API と同様に、ビジュアル チェーンが XNUMX つのプロンプトのみを使用する場合に比べてパフォーマンスを向上させる方法についても説明しました。 次に、XNUMX つの事前トレーニングされたモデルの定量的評価を提供しました。 最後に、微調整された SAM モデルとその結果を元の基本モデルと比較して説明しました。 基礎モデルを微調整すると、セグメンテーションなどの特定のタスクのモデルのパフォーマンスを向上させることができます。 SAM モデルはリソース要件により、現在の状態ではリアルタイムのユースケースとエッジでの推論の使用が制限されることに注意してください。 今後の反復と技術の改善により、コンピューティング要件が軽減され、レイテンシーが改善されることを期待しています。

この投稿が、ユースケースに合わせた視覚的なプロンプトを検討するきっかけとなることを願っています。 これはプロンプト エンジニアリングのまだ発展途上の形式であるため、視覚的なプロンプト、視覚的なチェーン、およびこれらのツールのパフォーマンスに関して発見すべきことがたくさんあります。 アマゾンセージメーカー は、ビルダーが大規模な言語およびビジュアル モデルを探索し、生成 AI アプリケーションを構築できるようにするフルマネージド ML プラットフォームです。 今すぐ AWS で未来の構築を始めましょう。

著者について

ゴピ・クリシュナムルシー ニューヨーク市を拠点とするアマゾン ウェブ サービスのシニア AI/ML ソリューション アーキテクトです。 彼は、機械学習ワークロードを変換し、クラウドに移行するための信頼できるアドバイザーとして、大規模な自動車の顧客と協力しています。 彼の主な関心事は、深層学習とサーバーレス テクノロジです。 仕事以外では、家族と過ごしたり、幅広い音楽を探求したりするのが好きです。

ゴピ・クリシュナムルシー ニューヨーク市を拠点とするアマゾン ウェブ サービスのシニア AI/ML ソリューション アーキテクトです。 彼は、機械学習ワークロードを変換し、クラウドに移行するための信頼できるアドバイザーとして、大規模な自動車の顧客と協力しています。 彼の主な関心事は、深層学習とサーバーレス テクノロジです。 仕事以外では、家族と過ごしたり、幅広い音楽を探求したりするのが好きです。

シュレヤスサブラマニアン プリンシパル AI/ML スペシャリストのソリューション アーキテクトであり、AWS プラットフォームを使用して機械学習を使用してビジネス上の課題を解決することで、お客様を支援します。 Shreyas は、大規模な最適化と機械学習、および最適化タスクを加速するための機械学習と強化学習の使用に関するバックグラウンドを持っています。

シュレヤスサブラマニアン プリンシパル AI/ML スペシャリストのソリューション アーキテクトであり、AWS プラットフォームを使用して機械学習を使用してビジネス上の課題を解決することで、お客様を支援します。 Shreyas は、大規模な最適化と機械学習、および最適化タスクを加速するための機械学習と強化学習の使用に関するバックグラウンドを持っています。

スジタ・マーティン ジェネレーティブ AI イノベーション センター (GAIIC) の応用科学者です。 彼女の専門知識は、さまざまな業界向けのコンピューター ビジョンと自然言語処理を含む機械学習ソリューションの構築です。 特に、人間中心の状況認識と高度自律システム向けの知識注入学習に取り組んだ豊富な経験があります。

スジタ・マーティン ジェネレーティブ AI イノベーション センター (GAIIC) の応用科学者です。 彼女の専門知識は、さまざまな業界向けのコンピューター ビジョンと自然言語処理を含む機械学習ソリューションの構築です。 特に、人間中心の状況認識と高度自律システム向けの知識注入学習に取り組んだ豊富な経験があります。

フランシスコ・カルデロン ジェネレーティブ AI イノベーション センター (GAIIC) のデータ サイエンティストです。 GAIIC のメンバーとして、彼は生成 AI テクノロジーを使用して AWS の顧客との可能性の発見を支援しています。 余暇には、フランシスコは音楽やギターを演奏したり、娘たちとサッカーをしたり、家族との時間を楽しんだりするのが好きです。

フランシスコ・カルデロン ジェネレーティブ AI イノベーション センター (GAIIC) のデータ サイエンティストです。 GAIIC のメンバーとして、彼は生成 AI テクノロジーを使用して AWS の顧客との可能性の発見を支援しています。 余暇には、フランシスコは音楽やギターを演奏したり、娘たちとサッカーをしたり、家族との時間を楽しんだりするのが好きです。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/foundational-vision-models-and-visual-prompt-engineering-for-autonomous-driving-applications/

- :持っている

- :は

- :not

- :どこ

- $UP

- 1

- 100

- 11

- 179

- 2014

- 214

- 225

- 30

- 40

- 500

- 7

- 70

- 804

- 91

- 97

- a

- 能力

- できる

- 私たちについて

- 上記の.

- 加速している

- 受け入れる

- 正確な

- 達成

- 実際の

- 適応する

- 追加

- 高度な

- 進歩

- 利点

- 顧問

- 後

- AI

- AI / ML

- AL

- すべて

- ことができます

- 沿って

- 既に

- また

- しかし

- Amazon

- Amazonの再認識

- アマゾンセージメーカー

- Amazon SageMaker ジャンプスタート

- Amazon Webサービス

- an

- および

- 回答

- どれか

- 誰も

- 何でも

- API

- 適用可能な

- 申し込み

- 適用された

- アプローチ

- 建築

- です

- AREA

- エリア

- 周りに

- 配列

- 宝品

- AS

- 援助

- 引き受けます

- と仮定する

- At

- 注意

- 自動車

- 自律的

- 利用できます

- 認知度

- AWS

- 背景

- ベース

- ベース

- の基礎

- BE

- なぜなら

- になる

- き

- 始まる

- 背後に

- 利点

- より良いです

- 10億

- 青

- 国境

- ボックス

- ボックス

- 画期的な

- 広く

- ビルド

- ビルダー

- 建物

- 内蔵

- ビジネス

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- 計算する

- コール

- カメラ

- カメラ

- 缶

- 取得することができます

- 自動車

- これ

- 自動車

- 場合

- 例

- カテゴリ

- カテゴリー

- ケータリング

- センター

- チェーン

- チェーン

- 課題

- 選択

- 市町村

- 閉じる

- 閉まっている

- 密接に

- クラウド

- ココ

- コード

- 組み合わせ

- 組み合わせ

- 結合

- コマンドと

- 会社

- 比較します

- 比べ

- 計算的

- 計算

- コンピュータ

- Computer Vision

- コンセプト

- コンセプト

- コンテキスト

- 調整する

- 基本

- カバー

- 作成した

- Cross

- 電流プローブ

- 現在の状態

- Customers

- カット

- データ

- データサイエンティスト

- データセット

- 深いです

- 深い学習

- 定義します

- 定義済みの

- 実証

- 記載された

- 希望

- 検出

- 異なります

- 恐竜

- 直接に

- 発見する

- 話し合います

- 議論する

- ディストリビューション

- 異なる

- do

- そうではありません

- ドメイン

- ドメイン

- ドント

- 劇的に

- ドライバー

- 運転

- 原因

- e

- E&T

- 各

- 簡単に

- エッジ(Edge)

- 埋め込み

- 新興の

- 可能

- 有効にする

- 励ます

- エンジニアリング

- エンターテインメント

- 全体

- エポック

- 本質的な

- 評価

- 例

- 例

- 広大な

- 期待する

- 体験

- 実験

- 専門知識

- 説明

- 説明

- 明示的

- 探る

- 調査済み

- 表現

- 広範囲

- 豊富な経験

- エキス

- 顔

- かなり

- おなじみの

- 家族

- 特徴

- 少数の

- フィールド

- フィギュア

- filter

- ファイナル

- もう完成させ、ワークスペースに掲示しましたか?

- 名

- 焦点を当てて

- 焦点

- フォロー中

- フォーム

- Foundation

- 基礎的な

- 4

- フレームワーク

- フランシスコ

- から

- フロント

- フル

- 完全に

- さらに

- 未来

- 生成する

- 生成

- 生成

- 生々しい

- 生成AI

- 取得する

- 与えられた

- 与える

- 良い

- グリーン

- 陸上

- ガイド

- ハンド

- 持ってる

- 持って

- he

- ヘルスケア

- ことができます

- 彼女の

- こちら

- ハイ

- 高品質

- より高い

- 非常に

- 彼の

- 保持している

- フード

- 希望

- 認定条件

- HTML

- HTTPS

- 巨大な

- 特定され

- 識別する

- 識別する

- 識別

- 画像

- 画像

- 直ちに

- 実装する

- 印象的

- 改善します

- 改善されました

- 改善

- in

- include

- 含めて

- 増える

- 増加

- の増加

- 産業を変えます

- 情報

- 注入された

- 初期

- 革新的手法

- 入力

- インスピレーションある

- インスタンスのセグメンテーション

- 説明書

- 意図

- 関心

- 興味がある

- 興味深い

- 利益

- に

- 巻き込む

- 関与

- IT

- 繰り返し

- ITS

- JPG

- ただ

- 一つだけ

- 知識

- 既知の

- ラベル

- ラベル

- レーン

- 言語

- 大

- 大規模

- より大きい

- 最大の

- 最後に

- レイテンシ

- LEARN

- 学習

- 左

- less

- レベル

- 図書館

- ライセンス

- ある

- 生活

- 生命科学

- 軽量

- ような

- 好き

- 制限

- 制限

- LIN

- リスト

- 少し

- LLM

- 場所

- 見て

- 探して

- LOOKS

- ロー

- 機械

- 機械学習

- 作る

- 作成

- マネージド

- マニュアル

- 多くの

- 結婚

- mask

- マスク

- 大規模な

- 五月..

- 手段

- メディア

- ミディアム

- メンバー

- Meta

- メトリック

- 移動します

- 百万

- マインド

- 最小限の

- ML

- モデル

- 修正

- モジュール

- 他には?

- 最も

- 動機

- ずっと

- の試合に

- 音楽を聴く際のスピーカーとして

- 名

- 名

- ナチュラル

- 自然言語処理

- 必ずしも

- 新作

- ニューヨーク

- ニューヨーク市

- 次の

- いいえ

- 注意

- 数

- オブジェクト

- オブジェクト検出

- 客観

- オブジェクト

- of

- オフ

- on

- ONE

- 最適化

- or

- オリジナル

- その他

- 私たちの

- でる

- 結果

- 出力

- outputs

- 外側

- が

- 足

- パラメーター

- パラメータ

- 特定の

- 部品

- パッチ

- 知覚

- 実行する

- パフォーマンス

- 実行

- 個人的に

- 画像

- 柱

- パイプライン

- ピクセル

- 飛行機

- プラットフォーム

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- プレイ

- 再生

- ポイント

- ポイント

- 人気

- 可能

- ポスト

- 潜在的な

- 電力

- 予測する

- 主要な

- 校長

- 事前の

- プロセス

- 処理済み

- 処理

- 作り出す

- 生産する

- 割合

- 提案する

- 受験する

- 提供します

- 提供

- は、大阪で

- 提供

- 目的

- 品質

- 量

- 質問

- 範囲

- への

- 本当に

- 理由は

- 最近

- レッド

- 減らします

- 参照する

- 指し

- 地域

- 地域

- 関連する

- 関連した

- レポート

- 要件

- 必要

- リソースを追加する。

- 尊重

- 応答

- 結果

- 結果

- 革命を起こす

- 富裕層

- 右

- ロード

- ランニング

- セージメーカー

- サム

- 同じ

- 見ました

- 規模

- シーン

- 科学

- 科学者

- スコア

- 二番

- セクション

- 見て

- セグメント

- セグメンテーション

- セグメント

- シニア

- 別

- サーバレス

- サービス

- サービス

- セッションに

- いくつかの

- 彼女

- すべき

- 表示する

- ショーケース

- 示す

- 作品

- 符号

- 重要

- サイン

- シルバー

- 同様の

- 簡単な拡張で

- 単数

- サイズ

- サイズ

- 技能

- スロット

- スロット

- 小さい

- より小さい

- スニペット

- So

- サッカー

- ソリューション

- 解決する

- 一部

- ソース

- ソース

- 専門家

- 特定の

- 特に

- 過ごす

- split

- スタック

- 標準

- start

- 都道府県

- ステップ

- まだ

- 簡単な

- 強み

- 構造

- 構造化

- 闘争

- 成功した

- そのような

- サポート

- 凌駕する

- システム

- テーブル

- 取る

- 撮影

- 仕事

- タスク

- テクニック

- テクノロジー

- template

- テンプレート

- 条件

- テスト

- テスト

- 클라우드 기반 AI/ML및 고성능 컴퓨팅을 통한 디지털 트윈의 기초 – Edward Hsu, Rescale CPO 많은 엔지니어링 중심 기업에게 클라우드는 R&D디지털 전환의 첫 단계일 뿐입니다. 클라우드 자원을 활용해 엔지니어링 팀의 제약을 해결하는 단계를 넘어, 시뮬레이션 운영을 통합하고 최적화하며, 궁극적으로는 모델 기반의 협업과 의사 결정을 지원하여 신제품을 결정할 때 데이터 기반 엔지니어링을 적용하고자 합니다. Rescale은 이러한 혁신을 돕기 위해 컴퓨팅 추천 엔진, 통합 데이터 패브릭, 메타데이터 관리 등을 개발하고 있습니다. 이번 자리를 빌려 비즈니스 경쟁력 제고를 위한 디지털 트윈 및 디지털 스레드 전략 개발 방법에 대한 인사이트를 나누고자 합니다.

- テキスト

- より

- それ

- エリア

- 基礎

- 未来

- 情報

- アプリ環境に合わせて

- そこ。

- ボーマン

- この

- 考え

- 三

- 介して

- 時間

- タイヤ

- 〜へ

- 今日

- ツール

- 豊富なツール群

- top

- トータル

- 追跡

- トラフィック

- 訓練された

- トレーニング

- 最適化の適用

- トランス

- トラック

- true

- 信頼されている

- 真実

- 試します

- 2

- type

- 典型的な

- 下

- わかる

- us

- 使用可能な

- 使用法

- つかいます

- 使用事例

- ユースケース

- 中古

- ユーザー

- 価値観

- さまざまな

- 広大な

- 植生

- 車

- バージョン

- バージョン

- 垂直

- 非常に

- ビデオ

- ビジョン

- ビジュアル

- vs

- W

- ました

- 方法

- we

- ウェブ

- Webサービス

- WELL

- went

- した

- この試験は

- 何ですか

- いつ

- 一方

- which

- 全体

- ワイド

- 広い範囲

- 広く

- 意志

- 以内

- 無し

- 目撃

- 言葉

- 仕事

- ワークフロー

- ワーキング

- 作品

- でしょう

- 書き込み

- X

- 年

- ヨーク

- You

- あなたの

- ゼファーネット